LLM的發展為情感分析任務帶來的新的解決方案。有研究人員使用LLM,在上下文學習(in-contex....

幻覺被描述為無意義或不忠實于所提供源內容的生成內容。根據與源內容的矛盾,這些幻覺又進一步分為內在幻覺....

縱軸是"Bits for words", 這也是交叉熵的一個單位。在計算交叉熵時,如果使用以 2 為....

對以ChatGPT為代表的LLMs在共情回復生成上的表現進行了全面的實證研究,LLMs在現有的基準數....

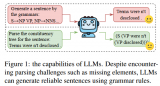

最近,上下文學習策略已被證明在沒有訓練的情況下顯示出顯著的結果。很少有研究利用上下文學習進行zero....

LLM的訓練分為預訓練和安全訓練。預訓練是指在大規模語料庫上進行訓練,因此LLM獲得了各種強大的能力....

經典 Transformer 使用不可學習的余弦編碼,加在模型底層的詞向量輸入上。GPT、BERT將....

沒得商量,不做RL了,選擇性保留RM:比如RRHF、DPO,這類方法可以直接在RM數據上優化語言模型....

MFTCoder具備高效訓練特征,包括提供高效的數據Tokenization模式和支持PEFT微調,....

同行評審對于確保科學的高質量至關重要:作者提交研究成果,而審稿人則辯論應不應該接受其發表。通常評審后....

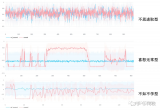

盡管魯迅先生曾言:真的強化敢于直面慘淡的結果,敢于正視崩壞的曲線。但日復一復地開盲盒難免會讓人心臟承....

簡介章節講的是比較基礎的,主要介紹了本次要介紹的概念,即檢索(Retrieval)和大語言模型(LL....

傳統的計算系統是圍繞計算機程序中表達的指令的執行來設計的。相反,語言模型可以遵循用自然語言表達的指令....

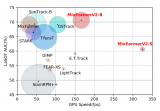

我們通過簡潔有效的模型結構設計和高效的基于知識蒸餾的模型壓縮,對于現有的 MixFormer 模型進....

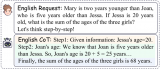

采用伯克利神經解析器(Berkeley Neural Parser)作為方法的基礎。該解析器是一種基....

進一步地,提出了Cross-Lingual Self-consistent Prompting (C....

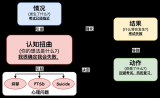

可以看出認知扭曲本身雖然往往和負面情緒相關,但其更多是強調不合理的負面情緒,這些負面情緒的形成和加強....

在大模型時代,向量模型的重要性進一步增強。尤其是在檢索增強生成(RAG)場景中,它成為了一個核心組件....

我們參加了 DSTC11-track5 并在所有 14 個參賽隊伍中排名第三(客觀指標),其中 Tu....

大模型混合多種能力項數據進行微調時,會呈現高資源沖突,低資源增益的現象。我們提出的DMT策略通過在第....

但LLEMMA的出現改變了這一局面。它不僅在MATH基準測試上創下了新高,甚至超越了某些還未對外公開....

今年,以 ChatGPT 為首的大語言模型(Large Language Models, LLMs)....

目前的Transformer位置編碼方法,有絕對位置編碼(將位置信息融入到輸入)、相對位置編碼(將位....

DISC-LawLLM是基于我們構建的高質量數據集DISC-Law-SFT在通用領域中文大模型Bai....

模型壓縮涉及將大型資源密集型模型轉化為適合在受限移動設備上存儲的緊湊版本。此外,它還可以優化模型以實....

語音和圖像為用戶在生活中使用 ChatGPT 提供了更多方式。旅行時,拍下地標性建筑的照片,然后就它....

其中最后一個表示監督信號是從圖像本身中挖掘出來的,流行的方法包括對比學習、非對比學習和masked ....

而這一切的背后,是一項名為Sorted Fine-Tuning(SoFT)的新訓練技術。SoFT讓我....

a16z是硅谷一家有名的投資機構,近期發布了他們根據月瀏覽量統計的TOP50 GenAI產品,并給出....

由于固有的模態缺口,如CLIP語義主要關注模態共享信息,往往忽略了可以增強多模態理解的模態特定知識。....