本文來(lái)源:Coggle數(shù)據(jù)科學(xué)

AI需要可解釋性

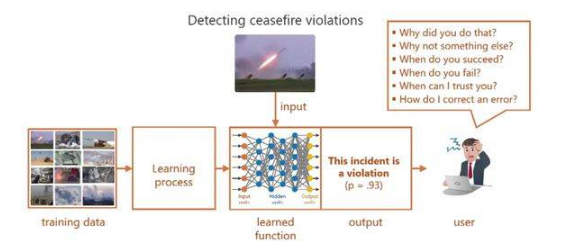

人工智能的崛起,尤其是深度學(xué)習(xí)的發(fā)展,在眾多領(lǐng)域帶來(lái)了令人矚目的進(jìn)步。然而,伴隨這些進(jìn)步而來(lái)的是一個(gè)關(guān)鍵問(wèn)題——“黑箱”問(wèn)題。許多人工智能模型,特別是復(fù)雜的模型,如神經(jīng)網(wǎng)絡(luò)和大型語(yǔ)言模型(LLMs),常被視為“黑箱”,因?yàn)樗鼈兊臎Q策過(guò)程是不透明的。

這些模型可能以高精度預(yù)測(cè)結(jié)果,但其決策背后的邏輯卻難以捉摸。這種缺乏可解釋性的情況引發(fā)了諸多重大問(wèn)題:

信任與責(zé)任:如果一個(gè)AI模型做出改變?nèi)松臎Q策,比如診斷醫(yī)療狀況或批準(zhǔn)貸款,用戶需要理解背后的邏輯。沒有這種理解,用戶就無(wú)法信任或驗(yàn)證結(jié)果。

調(diào)試與改進(jìn)模型:開發(fā)者需要深入了解決策過(guò)程,以便診斷錯(cuò)誤或提升模型性能。如果無(wú)法解釋模型,尋找錯(cuò)誤根源就只能靠猜測(cè)。

- 監(jiān)管合規(guī):在金融和醫(yī)療等領(lǐng)域,監(jiān)管機(jī)構(gòu)要求AI決策必須可解釋。例如,歐盟的《通用數(shù)據(jù)保護(hù)條例》(GDPR)中就包含了“解釋權(quán)”,要求組織為自動(dòng)化決策提供清晰的理由。

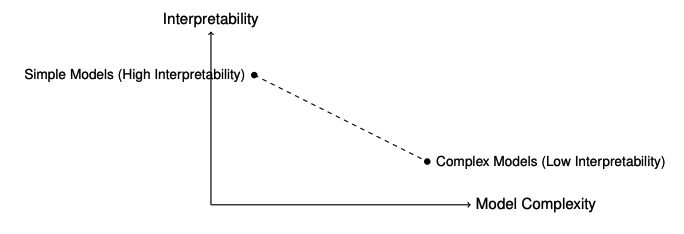

可解釋性與模型復(fù)雜度之間的權(quán)衡

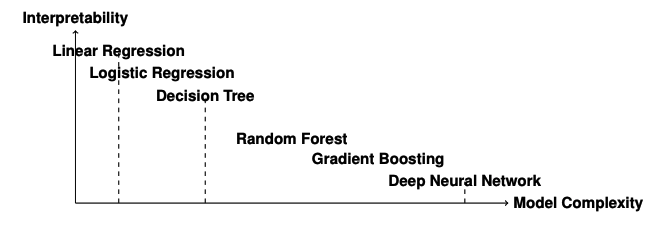

在人工智能中,可解釋性與模型復(fù)雜度之間常常存在權(quán)衡。像決策樹和線性回歸這樣的模型天生具有可解釋性,但往往缺乏捕捉數(shù)據(jù)中復(fù)雜模式的靈活性。而深度學(xué)習(xí)模型和LLMs雖然具有卓越的預(yù)測(cè)能力,但解釋起來(lái)卻非常困難。

來(lái)看一些例子:

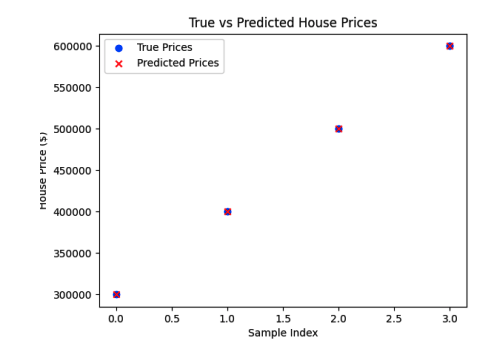

線性回歸:這是一種簡(jiǎn)單且可解釋的模型,其系數(shù)直接表明特征與目標(biāo)變量之間的關(guān)系。然而,在復(fù)雜非線性數(shù)據(jù)集上,它的表現(xiàn)可能不盡如人意。

神經(jīng)網(wǎng)絡(luò):這些模型能夠近似復(fù)雜函數(shù),并在圖像識(shí)別和自然語(yǔ)言處理等任務(wù)中展現(xiàn)出最先進(jìn)的性能。但理解每個(gè)神經(jīng)元或?qū)釉跊Q策過(guò)程中的作用卻極具挑戰(zhàn)性。

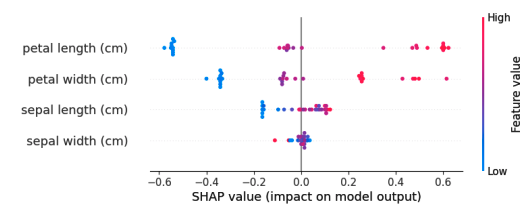

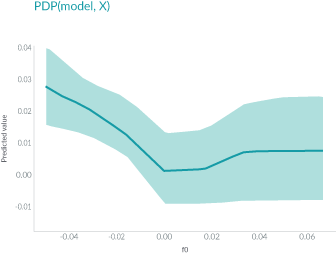

可解釋性的不同層次與類型可解釋性不應(yīng)與可視化混淆。可視化是一種技術(shù)手段,例如繪制特征重要性圖或激活圖,這些可以幫助我們理解模型,但它們本身并不是解釋。

特征重要性圖確實(shí)為我們提供了關(guān)于每個(gè)特征相對(duì)重要性的寶貴見解。然而,它并沒有完全解釋模型為何對(duì)某個(gè)特定樣本做出這樣的決策。

白盒模型 vs 黑盒模型

白盒模型包括以下幾種:

- 線性回歸:通過(guò)系數(shù)直接反映特征與目標(biāo)變量之間的線性關(guān)系。

- 邏輯回歸:通過(guò)系數(shù)反映特征對(duì)結(jié)果概率的影響。

- 決策樹:通過(guò)樹狀結(jié)構(gòu)展示決策路徑,易于理解和解釋。

- 基于規(guī)則的系統(tǒng):通過(guò)預(yù)定義的規(guī)則進(jìn)行決策,規(guī)則透明且易于理解。

- K-最近鄰(KNN):通過(guò)查找最近的訓(xùn)練樣本進(jìn)行預(yù)測(cè),決策過(guò)程直觀。

- 樸素貝葉斯分類器:基于貝葉斯定理和特征的獨(dú)立性假設(shè)進(jìn)行分類,模型簡(jiǎn)單且易于解釋。

- 廣義相加模型(GAMs):通過(guò)加性函數(shù)捕捉特征與目標(biāo)變量之間的關(guān)系,支持對(duì)每個(gè)特征的獨(dú)立解釋。

黑盒模型包括以下幾種:

- 神經(jīng)網(wǎng)絡(luò)(例如,深度學(xué)習(xí)模型):由于其復(fù)雜的結(jié)構(gòu)和大量的參數(shù),難以直接解釋。

- 支持向量機(jī)(SVMs):雖然線性核的SVM具有一定的可解釋性,但非線性核的SVM通常被視為黑盒模型。

- 集成方法(例如,隨機(jī)森林、梯度提升機(jī)):雖然基于決策樹,但其集成結(jié)構(gòu)增加了復(fù)雜性,難以直接解釋。

- Transformer模型(例如,BERT、GPT):由于其復(fù)雜的自注意力機(jī)制和大量的參數(shù),難以直接解釋。

圖神經(jīng)網(wǎng)絡(luò)(GNNs):通過(guò)圖結(jié)構(gòu)處理數(shù)據(jù),內(nèi)部工作機(jī)制復(fù)雜,難以直接解釋。

傳統(tǒng)機(jī)器學(xué)習(xí)的可解釋性

可解釋模型與不可解釋模型的區(qū)別

當(dāng)我們討論機(jī)器學(xué)習(xí)中的可解釋性時(shí),我們指的是能夠清晰地理解和追溯模型是如何得出其預(yù)測(cè)結(jié)果的能力。可解釋的模型是指人類觀察者可以跟隨決策過(guò)程,并直接將輸入特征與輸出預(yù)測(cè)聯(lián)系起來(lái)的模型。相比之下,不可解釋的模型,通常被稱為“黑箱”模型,由于其結(jié)構(gòu)復(fù)雜,很難理解其預(yù)測(cè)背后的邏輯。

一個(gè)常見的區(qū)分方法是:

可解釋模型:決策樹和線性模型被認(rèn)為是可解釋的。它們的結(jié)構(gòu)設(shè)計(jì)使得每一個(gè)決策或系數(shù)都可以被解釋,并追溯回輸入特征。

- 不可解釋模型:神經(jīng)網(wǎng)絡(luò)和集成方法(例如隨機(jī)森林和梯度提升)通常是不可解釋的。由于它們的復(fù)雜性,包含眾多的層、節(jié)點(diǎn)和參數(shù),很難追溯單個(gè)預(yù)測(cè)。

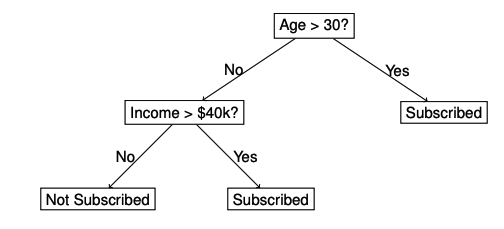

決策樹決策樹在機(jī)器學(xué)習(xí)中被廣泛認(rèn)為是最具可解釋性的模型之一。它們具有簡(jiǎn)單直觀的流程圖結(jié)構(gòu),其中內(nèi)部節(jié)點(diǎn)代表基于特征值的決策規(guī)則,分支表示這些決策的結(jié)果,而葉節(jié)點(diǎn)則包含最終預(yù)測(cè)。從根節(jié)點(diǎn)到葉節(jié)點(diǎn)的路徑提供了一個(gè)清晰且易于理解的決策過(guò)程。

決策樹通過(guò)輸入特征的值將數(shù)據(jù)劃分為子集,目標(biāo)是減少不確定性或“不純度”。常見的節(jié)點(diǎn)分裂標(biāo)準(zhǔn)包括:

- 基尼不純度(Gini Impurity)

- 信息增益(Information Gain)

這種結(jié)構(gòu)突顯了為什么決策樹被認(rèn)為是可解釋的:每個(gè)決策都可以用輸入特征來(lái)解釋,從而便于為模型的預(yù)測(cè)提供依據(jù)。盡管決策樹本身具有可解釋性,但它們很容易生長(zhǎng)得過(guò)深,變得過(guò)于復(fù)雜,從而捕捉數(shù)據(jù)中的噪聲并導(dǎo)致過(guò)擬合。為了應(yīng)對(duì)這一問(wèn)題,我們采用剪枝技術(shù),通過(guò)移除那些對(duì)預(yù)測(cè)能力貢獻(xiàn)微乎其微的節(jié)點(diǎn)來(lái)簡(jiǎn)化樹。主要的剪枝策略有兩種:

- 預(yù)剪枝(Pre-pruning,早期停止):根據(jù)預(yù)定義的標(biāo)準(zhǔn)(如最大深度或每個(gè)葉節(jié)點(diǎn)的最小樣本數(shù))限制樹的生長(zhǎng)。這降低了過(guò)擬合的風(fēng)險(xiǎn),同時(shí)保持了樹結(jié)構(gòu)的簡(jiǎn)單性。

- 后剪枝(Post-pruning):首先讓樹生長(zhǎng)到最大深度,然后剪掉那些對(duì)模型性能提升不顯著的節(jié)點(diǎn)。這種方法通常能夠得到一個(gè)更平衡的模型,具有更強(qiáng)的泛化能力。

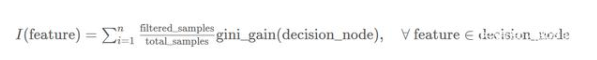

決策樹中的特征重要性是通過(guò)評(píng)估每個(gè)特征在分裂過(guò)程中減少節(jié)點(diǎn)不純度的作用來(lái)確定的。不純度是衡量節(jié)點(diǎn)內(nèi)無(wú)序或隨機(jī)性的指標(biāo),通常使用基尼不純度或熵來(lái)評(píng)估。當(dāng)一個(gè)特征顯著減少不純度時(shí),它會(huì)獲得更高的重要性分?jǐn)?shù)。

本質(zhì)上,一個(gè)特征在樹分裂中減少不純度的貢獻(xiàn)越大,它就越重要。高特征重要性表明模型在做預(yù)測(cè)時(shí)高度依賴該特征,使其成為理解模型決策過(guò)程的關(guān)鍵因素。

線性模型

線性模型,包括線性回歸和邏輯回歸,是機(jī)器學(xué)習(xí)中最具可解釋性的模型之一。它們假設(shè)輸入特征與輸出之間存在線性關(guān)系,這使得理解每個(gè)特征對(duì)預(yù)測(cè)結(jié)果的影響變得非常直觀。盡管線性模型結(jié)構(gòu)簡(jiǎn)單,但在數(shù)據(jù)關(guān)系近似線性的情況下,它們依然非常強(qiáng)大。在對(duì)可解釋性要求極高的領(lǐng)域,如金融和醫(yī)療保健,線性模型通常是首選。

線性假設(shè):線性回歸假設(shè)特征與目標(biāo)之間存在線性關(guān)系。這一假設(shè)在復(fù)雜數(shù)據(jù)集中可能不成立。

對(duì)異常值敏感:異常值可能會(huì)嚴(yán)重影響擬合線,導(dǎo)致預(yù)測(cè)結(jié)果不佳。

- 多重共線性:當(dāng)特征之間高度相關(guān)時(shí),很難確定每個(gè)特征對(duì)輸出的獨(dú)立影響。

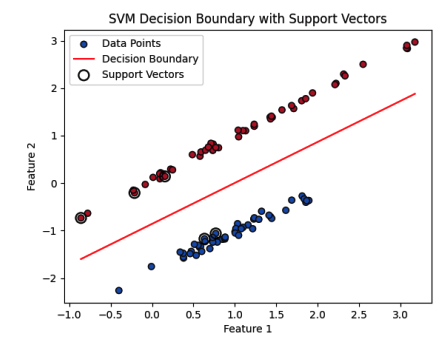

支持向量機(jī)(SVM)支持向量機(jī)(SVM)因其魯棒性以及能夠處理線性和非線性可分?jǐn)?shù)據(jù)而備受推崇。盡管通常被視為“黑箱”模型,但使用線性核的SVM可以通過(guò)其決策邊界和支持向量提供一定程度的可解釋性。SVM的目標(biāo)是找到一個(gè)超平面,能夠最好地將數(shù)據(jù)劃分為不同的類別。最優(yōu)超平面會(huì)最大化邊界(即超平面與每個(gè)類別最近數(shù)據(jù)點(diǎn)之間的距離)。這些最近的數(shù)據(jù)點(diǎn)被稱為支持向量,它們是SVM決策過(guò)程的核心。

決策邊界:紅線表示將兩個(gè)類別分開的超平面。這條線由權(quán)重向量w和偏置項(xiàng)b決定。決策邊界將特征空間劃分為兩個(gè)區(qū)域,每個(gè)區(qū)域?qū)?yīng)一個(gè)類別標(biāo)簽(藍(lán)色和紅色點(diǎn))。

支持向量:支持向量用較大的空心圓突出顯示。這些是離決策邊界最近的數(shù)據(jù)點(diǎn),位于邊界邊界上。它們?cè)诙x邊界和超平面的方向上起著關(guān)鍵作用。如圖所示,來(lái)自兩個(gè)類別的幾個(gè)支持向量正好位于邊界上。

- 邊界:邊界是穿過(guò)支持向量的兩條平行線之間的區(qū)域。SVM算法的目標(biāo)是最大化這個(gè)邊界,這提高了模型的泛化能力。較大的邊界表示一個(gè)更魯棒的分類器,對(duì)數(shù)據(jù)的小變化不那么敏感。

深度學(xué)習(xí)模型的可解釋性

深度學(xué)習(xí)模型,如卷積神經(jīng)網(wǎng)絡(luò)(CNNs)和循環(huán)神經(jīng)網(wǎng)絡(luò)(RNNs),包含多層神經(jīng)元、非線性激活函數(shù)以及大量的參數(shù)。例如,一個(gè)簡(jiǎn)單的用于圖像分類的CNN可能已經(jīng)包含數(shù)百萬(wàn)個(gè)參數(shù)。隨著網(wǎng)絡(luò)深度和復(fù)雜性的增加,理解每個(gè)單獨(dú)參數(shù)的貢獻(xiàn)變得不可行。

在深度學(xué)習(xí)中,高維數(shù)據(jù)通過(guò)層進(jìn)行處理,這些層可能會(huì)減少或增加維度,使得直接將輸入特征映射到學(xué)習(xí)的表示變得困難。這種抽象阻礙了我們直接解釋學(xué)習(xí)到的特征。

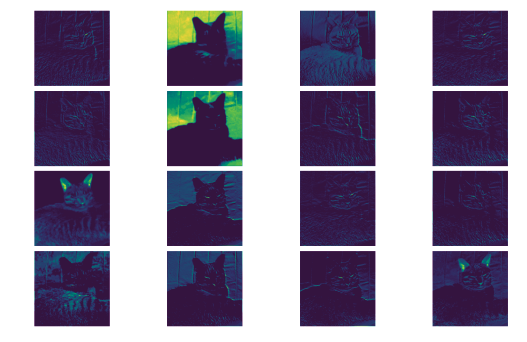

卷積神經(jīng)網(wǎng)絡(luò)(CNNs)的可解釋性

CNNs通過(guò)一系列卷積層和池化層從輸入圖像中提取特征。早期層通常捕獲簡(jiǎn)單的模式,如邊緣和紋理,而深層則學(xué)習(xí)更抽象、高級(jí)的表示,例如物體部件。解釋CNNs最直觀的方法之一是通過(guò)可視化這些學(xué)習(xí)到的特征。特征可視化涉及檢查卷積濾波器生成的特征圖,使我們能夠了解輸入圖像的哪些部分激活了特定的濾波器。

特征圖提供了一個(gè)視覺上的窺視,讓我們能夠了解模型在不同網(wǎng)絡(luò)階段如何感知輸入圖像。雖然這種類型的可視化有助于理解網(wǎng)絡(luò)的早期層,但由于學(xué)習(xí)到的特征的復(fù)雜性和抽象性,解釋深層的特征圖變得越來(lái)越具有挑戰(zhàn)性。

- 缺乏直接可解釋性:并非所有特征圖都對(duì)應(yīng)于人類可識(shí)別的模式。許多濾波器可能檢測(cè)到難以視覺解釋的抽象特征。

- 依賴輸入數(shù)據(jù):可視化的特征高度依賴于輸入圖像。不同的圖像可能會(huì)激活不同的濾波器,這使得很難將解釋推廣到各種輸入。

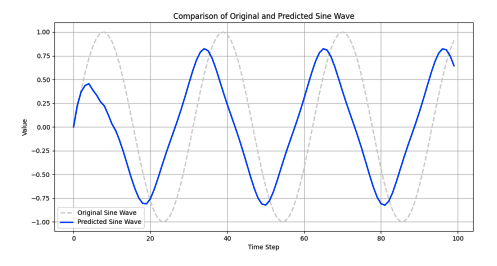

循環(huán)神經(jīng)網(wǎng)絡(luò)(RNNs)的可解釋性

RNN的核心能力在于其隱藏狀態(tài),這些狀態(tài)隨每個(gè)時(shí)間步長(zhǎng)演變。隱藏狀態(tài)作為記憶單元,存儲(chǔ)序列中以前輸入的信息。然而,解釋隱藏狀態(tài)中編碼的信息是具有挑戰(zhàn)性的,因?yàn)樗鼈兇砹诉^(guò)去輸入的復(fù)雜非線性組合。

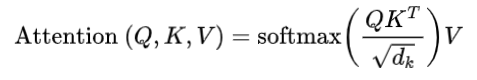

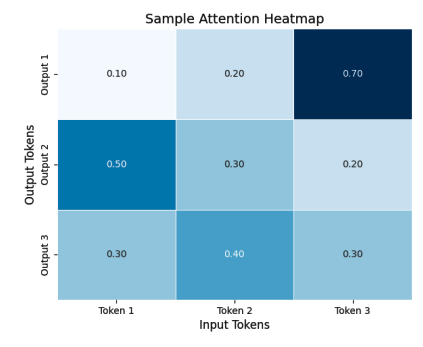

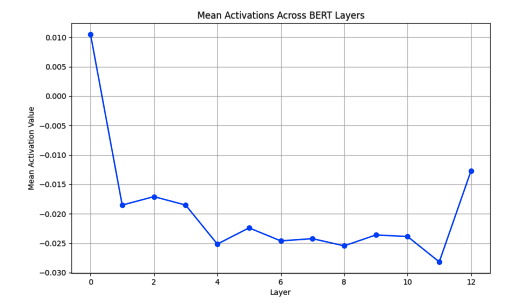

為了深入了解隱藏狀態(tài),一種常見的方法是可視化它們隨時(shí)間的變化。例如,繪制不同時(shí)間步長(zhǎng)的隱藏狀態(tài)激活可以揭示模式,例如對(duì)輸入序列某些部分的注意力增加或敏感性增強(qiáng)。自注意力機(jī)制與Transformer模型的可解釋性自注意力機(jī)制允許模型根據(jù)每個(gè)輸入標(biāo)記相對(duì)于其他所有標(biāo)記的重要性進(jìn)行加權(quán)。該機(jī)制涉及的關(guān)鍵組件是查詢(query)、鍵(key)和值(value)向量,這些向量是為每個(gè)標(biāo)記計(jì)算的。

- is the query matrix.

- is the key matrix.

- is the value matrix.

- is the dimension of the key vectors.

在這個(gè)例子中,熱力圖可視化了一個(gè)小的注意力權(quán)重矩陣,其中每個(gè)單元格代表輸入標(biāo)記和輸出標(biāo)記之間的注意力分?jǐn)?shù)。每個(gè)單元格的顏色強(qiáng)度表示注意力分?jǐn)?shù)的強(qiáng)度,便于識(shí)別對(duì)輸出標(biāo)記最有影響力的輸入標(biāo)記。

大型語(yǔ)言模型(LLMs)的可解釋性

大型語(yǔ)言模型(LLMs)是一類變革性的深度學(xué)習(xí)模型,旨在理解和生成人類語(yǔ)言。這些模型利用大量的訓(xùn)練數(shù)據(jù)和Transformer架構(gòu),徹底改變了自然語(yǔ)言處理(NLP),在文本分類、翻譯、摘要、對(duì)話系統(tǒng)甚至代碼生成等廣泛任務(wù)中達(dá)到了最先進(jìn)的性能。

嵌入分析和探測(cè)LLMs中的嵌入是高維表示,編碼了關(guān)于單詞、短語(yǔ)和句子的豐富語(yǔ)義信息。嵌入分析幫助我們理解模型學(xué)到了哪些語(yǔ)言屬性以及這些屬性在嵌入空間中的組織方式。

降維技術(shù)如t-SNE(t分布隨機(jī)鄰域嵌入)和PCA(主成分分析)常用于可視化嵌入。通過(guò)將嵌入投影到二維或三維空間,我們可以觀察到揭示單詞之間語(yǔ)義關(guān)系的聚類模式。

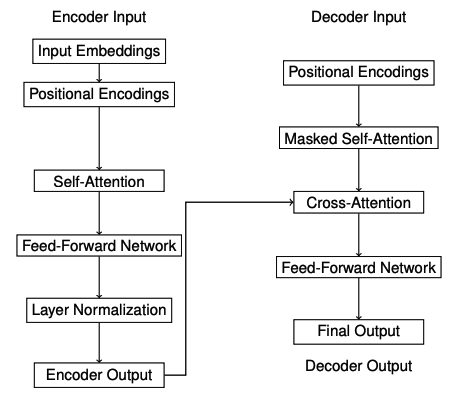

神經(jīng)逐層可解釋性神經(jīng)逐層可解釋性專注于理解Transformer架構(gòu)中各個(gè)層的作用。在像BERT這樣的大型語(yǔ)言模型(LLMs)中,每一層都捕捉了不同層次的語(yǔ)言信息,共同構(gòu)成了模型對(duì)輸入文本的整體理解。

早期層:這些層傾向于捕捉表面級(jí)特征,如標(biāo)記身份和基本的句法模式。模型在這個(gè)階段專注于理解單個(gè)單詞及其基本關(guān)系。

- 中間層:中間層負(fù)責(zé)捕捉更抽象的句法結(jié)構(gòu)和依賴關(guān)系,如主謂一致和語(yǔ)法關(guān)系。這些層幫助模型理解句子結(jié)構(gòu)。

- 晚期層:這些層編碼高級(jí)語(yǔ)義信息和特定于任務(wù)的表示。它們直接貢獻(xiàn)于最終預(yù)測(cè),通常包含輸入文本中最抽象和上下文感知的特征。

探測(cè)嵌入中的知識(shí)

句法探測(cè):評(píng)估模型對(duì)句法屬性的理解。例如,它檢查嵌入是否能夠區(qū)分句子中的主語(yǔ)和賓語(yǔ),捕捉單詞的句法角色。

語(yǔ)義探測(cè):檢查模型是否捕捉了語(yǔ)義關(guān)系,如單詞相似性或蘊(yùn)含關(guān)系。它旨在了解嵌入是否反映了更深層次的語(yǔ)義特征,如同義詞或反義詞。

-

AI

+關(guān)注

關(guān)注

87文章

33034瀏覽量

273007 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8469瀏覽量

133655 -

大模型

+關(guān)注

關(guān)注

2文章

2857瀏覽量

3559

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

機(jī)器學(xué)習(xí)模型可解釋性的結(jié)果分析

什么是“可解釋的”? 可解釋性AI不能解釋什么

機(jī)器學(xué)習(xí)模型的“可解釋性”的概念及其重要意義

神經(jīng)網(wǎng)絡(luò)可解釋性研究的重要性日益凸顯

Explainable AI旨在提高機(jī)器學(xué)習(xí)模型的可解釋性

詳談機(jī)器學(xué)習(xí)的決策樹模型

淺談機(jī)器學(xué)習(xí)模型的可解釋性和透明性

機(jī)器學(xué)習(xí)模型可解釋性的介紹

圖神經(jīng)網(wǎng)絡(luò)的解釋性綜述

《計(jì)算機(jī)研究與發(fā)展》—機(jī)器學(xué)習(xí)的可解釋性

機(jī)器學(xué)習(xí)模型的可解釋性算法詳解

使用RAPIDS加速實(shí)現(xiàn)SHAP的模型可解釋性

機(jī)器學(xué)習(xí)模型的可解釋性算法匯總

評(píng)論