人們對深度學習模型的真正運行機制還遠遠沒有完全了解,如何提高預測模型的“可解釋性”成了一個日益重要的話題。近來的一篇論文討論了機器學習模型的“可解釋性”的概念及其重要意義。

7月17日,加州大學圣迭戈分校(UCSD)博士、卡內(nèi)基梅隆大學(CMU)計算機科學助理教授Zachary C. Lipton在ACM Queue上發(fā)表了題為《The Mythos of Model Interpretability》的文章,討論了監(jiān)督式機器學習預測模型的可解釋性問題。Lipton在文中試圖明確“可解釋性”的定義,并對“可解釋性”進行分類,并提出了一個重要觀點,認為線性模型的可解釋性并不一定高于深度神經(jīng)網(wǎng)絡(DNN)模型。

以下是新智元對論文內(nèi)容的簡編。

監(jiān)督式的機器學習模型具有卓越的預測能力。不過,機器學習模型不僅應該可用,而且應該是可解釋的,但“解釋機器學習模型”的任務定義似乎不夠明確。學術文獻中提出了為模型尋求可解釋性的許多動機,并提供了無數(shù)的技術來提供可解釋的模型。盡管存在這種模棱兩可的情況,但許多作者宣稱他們的模型在公理上是可解釋的,然而對此卻缺乏進一步的論證。問題是,目前尚不清楚這些技術的共同特性是什么。

本文旨在完善關于可解釋性的表述。首先,文章回顧了以前論文中解決可解釋性的目標,發(fā)現(xiàn)這些目標多種多樣,偶爾還有相互矛盾。接著討論了研究可解釋性的模型屬性和技術思路,以及模型對人而言的識別透明度,并引入了“事后可解釋性”的概念作為對比。文章討論了關于模型可解釋性概念的不同觀點的可行性和合理之處,對“線性模型可解釋,深度神經(jīng)網(wǎng)絡不可解釋”這一常見的觀點提出了質(zhì)疑。

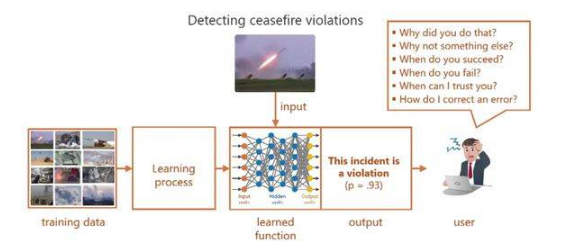

在過去的20年中,機器學習的快速發(fā)展產(chǎn)生了自動決策。在實際應用中,大多數(shù)基于機器學習的決策的運作方式是這樣的:用輸入數(shù)據(jù)訓練機器學習算法,然后由算法預測相應的輸出。例如,給定一組關于金融交易的屬性信息,機器學習算法可以預測長期的投資回報。給定來自CT掃描的圖像,算法可以該圖像的掃描對象罹患癌性腫瘤的概率。

機器學習算法接收大量成對數(shù)據(jù)(輸入和輸出),然后輸出一個模型,能夠預測之前未見過的輸入。研究人員將這個模式稱為“監(jiān)督式學習”。然后,為了讓決策過程完全自動化,可以將模型的輸出提供給某個決策規(guī)則。例如,垃圾郵件過濾器可以通過程序舍棄被預測為垃圾郵件(置信度超過某閾值)的電郵。

什么是可解釋性,它為什么如此重要?

目前機器學習在醫(yī)學、刑事司法系統(tǒng)和金融市場等關鍵領域的應用越來越廣泛,但人類無法真正理解這些模型,這是個問題。一些人提出了模型的“可解釋性”作為一種補救措施,但在學術文獻中,很少有作者準確地闡明了“可解釋性”的含義,也沒有準確解釋他們提出的解決方案為何是有用的。

盡管缺乏定義,但越來越多的文獻提出了據(jù)稱可解釋的算法。這樣來看我們似乎可以得出以下結論:要么是(1)人們對可解釋性的定義是普遍認同的,但沒人愿意費心以書面表達出來,要么就是(2)對“可解釋性”的定義是不明確的,所以關于機器學習模型的可解釋性的觀點都顯得科學性不足。對相關文獻的研究表明,后者與實際情況相符合。關于模型可解釋性的文獻中提出的目標和方法多種多樣,這表明可解釋性不是一個單一概念,而是一些彼此迥然不同的觀點,有必要將這些觀點分開來討論。

本文側(cè)重討論監(jiān)督式學習,而非強化學習和互動學習等其他機器學習范式。這是因為當前在實際應用中,監(jiān)督式學習居于首要地位。同時給出了對“線性模型可解釋,而深層神經(jīng)網(wǎng)絡不可解釋”這個常見觀點的分析。首先需要明確的是,什么是可解釋性?可解釋性為什么如此重要?

許多人提出,可解釋性就是對模型產(chǎn)生信任的方式。這又導致了另一個關于認識論的問題:什么是信任?是指對模型能夠表現(xiàn)良好的信心嗎?還是說“可解釋性”只是意味著對模型的低層級機制的理解?信任是否是一種主觀的定義?

還有人認為,可解釋的模型就是可取的,因為它可能有助于揭示觀察數(shù)據(jù)中的因果結構。而關于解釋權的法律概念為可解釋性一詞提供了另一個視角。有時,尋求可解釋性的目的,可能只是為了從模型中獲取更多有用的信息。

本文討論了模型的哪些屬性可以讓它們變得可解釋。有些論文將可解釋性與可理解性或可理解性等同起來,在這些論文中,可理解的模型有時被稱為“透明”的,而難以理解的模型被稱為黑盒子。但是透明度是什么?算法本身會收斂嗎?有唯一解嗎?人們是否了解每個參數(shù)代表什么?或者考慮模型的復雜性:是否足夠簡單?

其他內(nèi)容包括“事后可解釋”的概念。這種解釋可能解釋了預測結果,但沒有闡明預測模型運作的機制。比如由人類生成的口頭解釋,或者用于分析深度神經(jīng)網(wǎng)絡的顯著性圖。因此,人類做出的決定可能會滿足“事后可解釋”,不過人類大腦的運作機制仍是個黑盒子,這表明兩種常見的可解釋性概念之間的矛盾。

本論文的作者Zachary C. Lipton

線性模型和深度網(wǎng)絡模型的取舍

可解釋性的概念很重要、也很棘手。本文分析了可解釋性的動機和研究界提出的一些嘗試。現(xiàn)在讓我們考慮一下這種分析的含義并提供一些內(nèi)容。

線性模型并不比深度神經(jīng)網(wǎng)絡具有更高的可解釋性。盡管這種說法很流行,但其真實價值取決于采用哪種可解釋性的概念。如果可解釋性指的是算法透明度,那么這種說法似乎沒有什么爭議,但對高維特征或經(jīng)大幅修正的特征而言,線性模型就分別不具備可模擬性和可分解性。

在線性模型和深度模型之間進行選擇時,我們時常要在算法透明度和可分解性之間進行權衡。這是因為深度神經(jīng)網(wǎng)絡模型一般面向原始特征或輕度處理的特征。所以如果不出意外,這些特征都具有直觀的意義,因而采用“事后可解釋性”的概念是可以接受的。而線性模型則不同,為了獲得足夠的性能,通常必須面向大量經(jīng)人工設計的特征。Zachary Lipton曾與他人合作撰文指出,線性模型要想接近遞歸神經(jīng)網(wǎng)絡(RNN)的性能,就必須以舍棄可分解性為代價。

如果考察某些類型的“事后可解釋性”(post-hoc interpretable),深度神經(jīng)網(wǎng)絡具有明顯的優(yōu)勢。深度神經(jīng)網(wǎng)絡能夠?qū)W習豐富的表示,這些表示能夠可視化、用語言表達或用于聚類。如果考慮對可解釋性的需求,似乎線性模型在研究自然世界上的表現(xiàn)更好,但這似乎沒有理論上的原因。

關于可解釋性的聲明必須是合格的。可解釋性一詞并沒有一個整體概念。關于可解釋性的任何觀點都應該首先為“可解釋性”確定一個特定的定義。如果模型滿足透明度的形式,則可解釋性可以直接體現(xiàn)出來。對于“事后可解釋性”,則應確定一個明確的目標,并證明所提供的解釋形式能夠?qū)崿F(xiàn)這一目標。

事后解釋可能會有誤導性。不能一味接受“事后可解釋”的概念,特別是在基于主觀目標對模型做特定優(yōu)化時。因為在這種情況下,人們可能會在有意無意間優(yōu)化算法,以提供誤導性、但貌似合理的解釋。就像在招聘活動和大學錄取中的一些行為一樣。我們在努力推廣機器學習模型的應用,模仿人類智能的過程中,更應該小心不要重現(xiàn)大規(guī)模的不正常行為。

未來方向

未來有幾個有前途的方向。首先,對于某些問題,可以開發(fā)更豐富的損失函數(shù)和性能指標,降低現(xiàn)實與機器學習目標之間的差異。包括對稀疏誘導正則化因子(sparsity-inducing regularizers)和成本敏感學習(cost-sensitive learning)的研究。其次,這種分析可以擴展到其他機器學習范式中,比如強化學習。強化學習模型可通過直接對模型與環(huán)境的交互進行建模,從而解決模型可解釋性研究中的一些問題。

值得注意的是,強化學習模型能夠?qū)W習自身行為與現(xiàn)實世界的影響之間的因果關系。然而,與監(jiān)督式學習一樣,強化學習同樣依賴于明確定義的標量目標。對于公平性(fairness)問題,這個我們正在努力精確定義的指標,機器學習范式可解釋度的提升則不大可能解決。

觀點爭鳴

不過,關于這個問題也有人提出了一些異議,谷歌大腦軟件工程師、斯坦福大學計算機科學碩士Akshay Agrawal就對Lipton論文中的主要觀點進行了歸納,并提出了不少不同意見。

對此文提出不同意見的Akshay Agrawal

Agrawal認為Lipton的論文對模型可解釋性的定義分為三個方面:

第一是透明度,其表現(xiàn)形式是“可模擬性”,即人類應該可以手動模擬機器學習模型。第二是“可分解性”,即模型的每個部分都有直觀的解釋。第三是算法,算法應該有獨一無二的解。

Agrawal認為:第一點有些問題,因為計算機的目的是自動完成人類在合理的時間內(nèi)無法完成的任務。第二點講得很好。第三點也有問題,因為即使在凸面上甚至都不能保證有唯一解。而算法的確定性問題已經(jīng)不屬于機器學習的范圍。

Agrawal表示,在可解釋性問題上,重要問題的有兩點:

1. 這個模型是否能推廣用在未見過的數(shù)據(jù)上面?如果在對某個推廣假設試圖證偽之后,該假設仍然成立,那么這個模型就是可解釋的。我認為這與Lipton在此文中說的“可轉(zhuǎn)移性”的概念差不多。

2. 該模型是否足夠安全,比如是否能夠防止欺騙?確定模型的安全性是一個懸而未決的問題。也許可以通過使用Lipton在他的論文中調(diào)查的一些工具來研究這個問題。不過我很清楚,驗證神經(jīng)網(wǎng)絡模型的安全性要比對線性模型進行驗證要困難得多。

-

神經(jīng)網(wǎng)絡

+關注

關注

42文章

4793瀏覽量

102006 -

機器學習

+關注

關注

66文章

8471瀏覽量

133726

原文標題:線性模型可解釋一定比DNN高?UCSD科學家:大錯特錯!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關推薦

什么是“可解釋的”? 可解釋性AI不能解釋什么

神經(jīng)網(wǎng)絡可解釋性研究的重要性日益凸顯

Explainable AI旨在提高機器學習模型的可解釋性

機器學習模型可解釋性的介紹

使用RAPIDS加速實現(xiàn)SHAP的模型可解釋性

文獻綜述:確保人工智能可解釋性和可信度的來源記錄

小白學解釋性AI:從機器學習到大模型

評論