在計算機視覺中,我方視角就是相機鏡頭的視角。那么在當前時刻下,如何正確的估計出相機中目標物體的6D姿態(三維空間位置和三維朝向),將是一個重要的問題,這就是物體的6D姿態估計任務。

01摘要最近,基于RGBD的類別級6D物體姿態估計在性能上取得了很大的進步,然而,對于深度信息的需求阻礙了其更廣泛的應用。為了解決這一問題,本文提出了一種 "物體深度重建網絡"(OLD-Net)的新方法。該方法僅輸入RGB圖像進行類別級6D物體姿態估計。我們通過將類別級形狀先驗變形為物體級深度和規范的NOCS表示,從而實現由單目RGB圖像中直接預測物體級深度。我們引入了兩個新的模塊,即歸一化全局位置提示(NGPH)和形狀感知解耦深度重建(SDDR)模塊,以學習高精度的物體級深度和形狀表示。最后,通過將預測的規范表征與反向投影的物體級深度對齊,解決了6D物體的姿態問題。在CAMERA25和REAL275數據集上進行的廣泛實驗表明,雖然我們的模型,但達到了最先進的性能。02本文主要工作

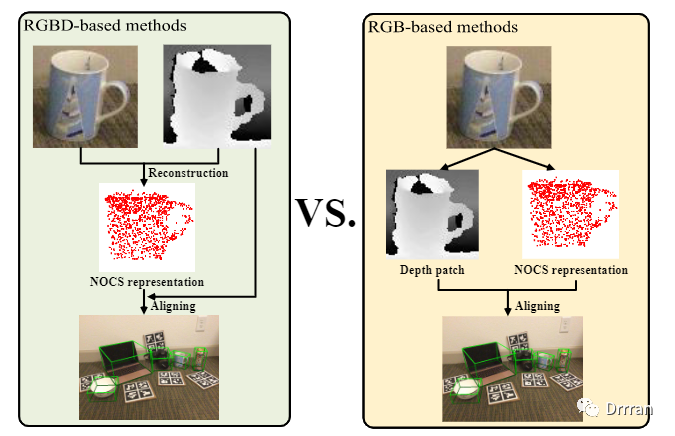

本文提出了一種基于RGB的類別級6D物體姿態估計新方法——Object Level Depth reconstruction Network(OLD-Net)。上圖右示為OLD-Net的主要管道。具體而言,從輸入的RGB圖像中同時預測物體級深度和NOCS表示,并將兩者對齊預測6D物體的姿態。與以往通過重構網格預測物體區域深度的方法不同,本文采用端到端方式直接從RGB圖像中預測物體的觀測深度。 要獲得物體區域的深度,一種直接的方法是預測場景級深度。然而,由于視場的多樣性,通常預測的景深較粗,導致物體形狀細節的丟失。姿態估計性能也會受到影響。為了解決這一問題,我們通過直接學習變形類別級形狀先驗重構物體級深度。與預測場景級深度圖相比,重建對象級深度圖計算方便,能夠更好地保存形狀細節,有利于后續的物體級深度和NOCS表示對齊過程。 為了更好地重構物體級深度,在OLD-Net中提出了一種新的模塊——歸一化全局位置提示(NGPH),以平衡場景級全局信息和局部特征級形狀細節。NGPH是帶相機本征的歸一化二維檢測結果,提供物體在場景中的絕對深度的全局位置線索,以及對不同相機捕捉到的圖像的泛化能力。此外,利用形狀感知解耦深度重建(SDDR)方法預測形狀細節和絕對深度。SDDR利用兩個獨立的深度網絡將絕對深度解耦預測為形狀點和深度平移。直觀上,形狀點是為了保留形狀細節,而深度平移是為了預測絕對物體中心。 除深度外,我們進一步采用基于RGBD的方法預測目標對象的NOCS表示。在訓練過程中使用鑒別器提高重建質量。在NOCS表示和觀測到的物體級深度都被預測之后,我們將物體級深度逆向投影到點云中。通過Umeyama算法對它們進行對齊,求解出6D物體姿態。我們在CAMERA25數據集和REAL275數據集上進行了大量的實驗。實驗結果表明,該方法具有先進的性能。03網絡主要結構

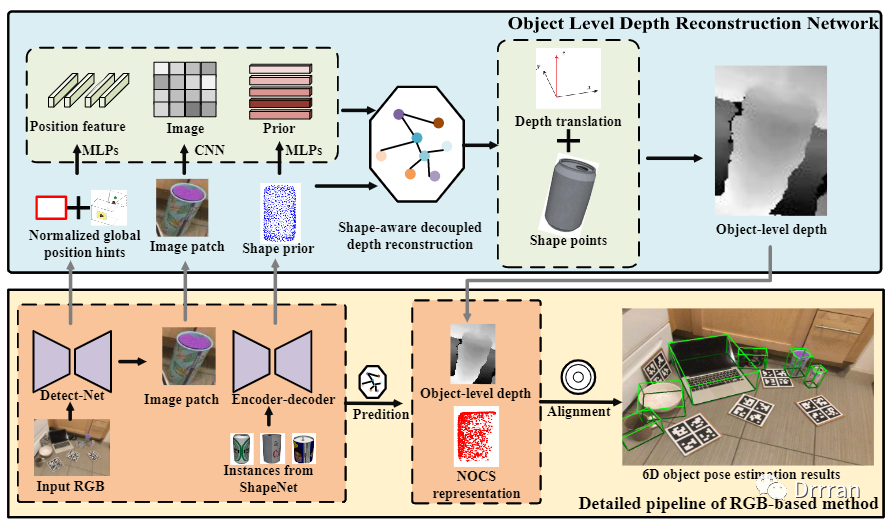

主要的OLD-Net的網絡架構如上圖所示。 我們的pipeline以圖像和一個形狀先驗作為輸入。圖像由一個訓練過的檢測器(Detect-Net)裁剪,用以表示物體特定的信息。采用均值嵌入的編碼器-解碼器網絡物體類別的形狀先驗進行預測,來解決類別差異的問題。 然后,將圖像和形狀先驗輸入到OLD-Net中,重建上圖頂部所示的物體級深度。此外,OLD-Net還將來自(Detect-Net的二維檢測結果和攝像機本征信息作為輸入,并將其歸一化為NGPH。在OLD-Net中采用一種形狀感知的解耦深度重建方案來保持物體的形狀細節和絕對中心。 最后,利用深度網絡對NOCS表示進行預測。然后,我們將對象級深度反向投影到點云中,采用Umeyama算法恢復物體姿態。 如上圖圖OLD-Net的網絡結構所示,OLD-Net以圖像、形狀先驗和NGPH為輸入,首先使用兩個MLP和一個CNN學習圖像特征圖,先驗特征,位置特征。然后,利用這些特征,利用形狀感知解耦深度重構(SDDR)方案同時預測形狀點和深度平移。最后,將形狀點和深度平移重新組合在一起,得到物體級深度。接下來,我們詳細介紹NGPH和SDDR。

規范化全局位置提示

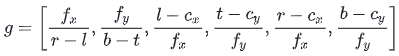

我們的旨在直接從高質量的圖像中預測物體層次的深度。實現這一目標的最直接方法是預測場景級深度圖。然而,從原始圖像預測場景級深度圖的計算成本很高。此外,它還可能導致物體形狀細節的丟失。而形狀細節對于我們的管道非常重要,因為我們需要對齊兩個3D表示來恢復物體的姿態。因此,我們選擇以特定物體的圖像作為輸入來預測物體級深度。然而,由于裁剪和調整大小的操作,圖像失去了目標的絕對全局位置信息,導致預測深度存在尺度模糊。為此,我們提出了NGPH,通過提供絕對全局位置信息和解決尺度模糊,很好地解決了這一問題。 我們選擇Detect-Net輸出的2D邊界框(l, t, r, b)的參數組成NGPH,它代表左、上、右,下二維邊界框的坐標。這些信息足夠有效,可以提供給網絡來推斷尺度線索。例如,如果所有的圖像都是由同一臺相機捕獲的,則恢復物體的絕對深度。然而,圖像通常會被不同的相機收集。從單目RGB圖像中推斷出物體的絕對深度會受到相機本身的影響,這是一個常識。因此,我們提出將相機本征注入NGPH中。因此,經過訓練的網絡也可以被推廣到其他由不同相機捕捉到的圖像。我們通過將2D邊界框和攝像機intrinsic歸一化到規范坐標中來使用它們:

其中表示我們使用的最終NGPH。和表示相機光學中心坐標,和表示焦距。前兩個術語將對象的邊界框大小與焦距歸一化,消除了對象大小引起的尺度模糊。后四個術語使用邊界框的焦距和大小對物體的中心進行歸一化,消除了模糊性,但保留了位置信息。該方法雖然簡單,但在對象級深度重構中是必不可少的。實驗結果表明,NGPH雖然簡單,但在物體層次深度重建中不可或缺。

形狀感知解耦深度重建

OLD-Net中使用的特征是重塑后的圖像特征矩陣(其中為像素數),位置特征,先驗特征。我們還應用MLPs和自適應池化,得到全局圖像特征集和全局先驗特征集。形狀點預測:我們采用了形狀先驗變形(SPD)的思想重構形狀點,這將為模型提供更多的物體形狀約束。具體來說,利用上述特征,網絡將學習一個形變場,一個,并將先前的形狀先驗反向投影到對象級深度的點云中:  為了學習??,我們重復??,??,??共??次并將它們與??連接。將連接的特征輸入到MLP中以學習??。類似地,為了學習??,我們重復??,??,??共??次,并將它們與??連接。另一個MLP用于學習??。在本文中,我們使用形狀先驗來預測對象級深度,為未來基于RGB的工作提供指導。深度變換預測:為了學習物體中心的絕對位置,我們建議使用一個獨立的MLP來學習深度平移。我們連接??和??作為輸入。輸出是表示對象中心絕對深度的單個值。我們把它命名為??。 SDDR方案主要從三個方面來保留對象形狀細節。首先,由于我們只使用圖像塊來重建物體層深度,模型可以專注于物體的形狀而不是整個場景的幾何形狀。其次,形狀先驗對物體的形狀提供了強大的約束,使其更容易恢復形狀細節。第三,分別學習絕對物體中心和物體形狀,并給予不同的注意。 在??和??被預測后,對象級深度可以表示為??,其中??為??的第三分量。注意,我們選擇監督Z而不是反向投影的點云。因為一方面,網絡在訓練過程中更容易學習Z,另一方面,將Z逆向投影到點云上進行對齊,物體的2D坐標將為全局位置提供額外的約束,這也有利于最后的物體姿態的恢復步驟。04? NOCS預測我們還預測管道中目標對象的NOCS表示,這是一種規范表示,用于與物體級深度對齊,以恢復6D對象姿勢。為了預測NOCS表示,我們將Z反投影到點云中,并將其輸入到MLP中,以獲得深度特征??。取??,??,??輸入,類似于重建對象級深度,我們使用SPD來預測NOCS表示:?

為了學習??,我們重復??,??,??共??次并將它們與??連接。將連接的特征輸入到MLP中以學習??。類似地,為了學習??,我們重復??,??,??共??次,并將它們與??連接。另一個MLP用于學習??。在本文中,我們使用形狀先驗來預測對象級深度,為未來基于RGB的工作提供指導。深度變換預測:為了學習物體中心的絕對位置,我們建議使用一個獨立的MLP來學習深度平移。我們連接??和??作為輸入。輸出是表示對象中心絕對深度的單個值。我們把它命名為??。 SDDR方案主要從三個方面來保留對象形狀細節。首先,由于我們只使用圖像塊來重建物體層深度,模型可以專注于物體的形狀而不是整個場景的幾何形狀。其次,形狀先驗對物體的形狀提供了強大的約束,使其更容易恢復形狀細節。第三,分別學習絕對物體中心和物體形狀,并給予不同的注意。 在??和??被預測后,對象級深度可以表示為??,其中??為??的第三分量。注意,我們選擇監督Z而不是反向投影的點云。因為一方面,網絡在訓練過程中更容易學習Z,另一方面,將Z逆向投影到點云上進行對齊,物體的2D坐標將為全局位置提供額外的約束,這也有利于最后的物體姿態的恢復步驟。04? NOCS預測我們還預測管道中目標對象的NOCS表示,這是一種規范表示,用于與物體級深度對齊,以恢復6D對象姿勢。為了預測NOCS表示,我們將Z反投影到點云中,并將其輸入到MLP中,以獲得深度特征??。取??,??,??輸入,類似于重建對象級深度,我們使用SPD來預測NOCS表示:?  然而,我們發現在某些情況下,??不夠真實,這將影響最終的6D目標姿態估計精度。因此我們采用對抗訓練策略訓練網絡。具體來說,我們設計了一個判別器來判斷預測的NOCS表示是否足夠真實。判別器的優化目標可表示為:?

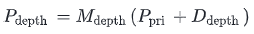

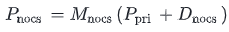

然而,我們發現在某些情況下,??不夠真實,這將影響最終的6D目標姿態估計精度。因此我們采用對抗訓練策略訓練網絡。具體來說,我們設計了一個判別器來判斷預測的NOCS表示是否足夠真實。判別器的優化目標可表示為:?  同樣,NOCS預測網絡的優化目標??:??在訓練過程中,對判別器和NOCS預測網絡的參數進行迭代更新。兩個網絡都將通過對抗變得越來越強大。因此,預測的NOCS表現也會變得越來越現實。05??損失函數對于物體級深度重建,我們使用Z和真實值的L1損失:?對于NOCS表示預測,我們使用損失函數包括重建的NOCS表示和真實值之間的平滑L1 loss ??,倒角距離損失??,交叉熵損失??,以鼓勵分配矩陣xmnocs的峰值分布,L2正則化損失。我們使用的總損失函數為:?

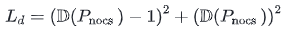

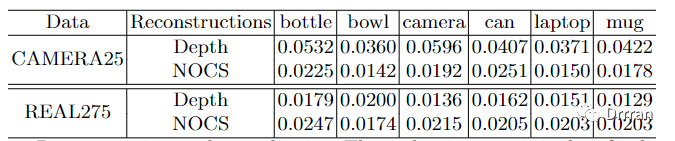

同樣,NOCS預測網絡的優化目標??:??在訓練過程中,對判別器和NOCS預測網絡的參數進行迭代更新。兩個網絡都將通過對抗變得越來越強大。因此,預測的NOCS表現也會變得越來越現實。05??損失函數對于物體級深度重建,我們使用Z和真實值的L1損失:?對于NOCS表示預測,我們使用損失函數包括重建的NOCS表示和真實值之間的平滑L1 loss ??,倒角距離損失??,交叉熵損失??,以鼓勵分配矩陣xmnocs的峰值分布,L2正則化損失。我們使用的總損失函數為:?  06??實驗我們通過PyTorch實現我們的方法,并使用Adam優化器對其進行優化。我們在訓練過程中隨機選擇1024像素來預測深度。Detect-Net是Mask-RCNN。使用帶有ResNet-18骨干的PSPNet來學習圖像特征。形狀先驗點數為1024。我們設C = 64, ???= 1024。該模型訓練50個epoch,批次大小為96。主網絡的初始學習率為0.0001,第40個epoch的衰減率為0.1。我們在CAMERA25數據集和REAL275數據集上進行了實驗。重建質量評價:在我們的工作中,主要思想是重建物體級深度和NOCS表示。因此,我們首先在表1中評估我們方法的重構質量。計算反向投影深度與地面真實值之間的倒角距離,驗證深度重建的質量。我們也計算預測的NOCS值與真實NOCS值之間的倒角距離評價NOCS預測質量。

06??實驗我們通過PyTorch實現我們的方法,并使用Adam優化器對其進行優化。我們在訓練過程中隨機選擇1024像素來預測深度。Detect-Net是Mask-RCNN。使用帶有ResNet-18骨干的PSPNet來學習圖像特征。形狀先驗點數為1024。我們設C = 64, ???= 1024。該模型訓練50個epoch,批次大小為96。主網絡的初始學習率為0.0001,第40個epoch的衰減率為0.1。我們在CAMERA25數據集和REAL275數據集上進行了實驗。重建質量評價:在我們的工作中,主要思想是重建物體級深度和NOCS表示。因此,我們首先在表1中評估我們方法的重構質量。計算反向投影深度與地面真實值之間的倒角距離,驗證深度重建的質量。我們也計算預測的NOCS值與真實NOCS值之間的倒角距離評價NOCS預測質量。

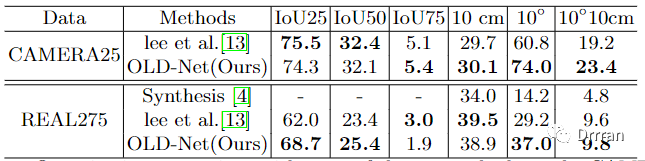

如上表所示對于物體級深度重構,REAL275數據集的誤差小于2cm。對于NOCS預測,REAL275數據集的誤差也接近2cm。與我們的大物體尺寸和景深相比,2厘米是一個相對較小的尺度誤差。因此,我們可以得出結論,我們的方法確實具有良好的物體級深度重構質量和NOCS表示預測質量。在CAMERA25數據集上,大多數類別的NOCS表示預測誤差仍在2cm以下。然而,物體級深度構造誤差增加到3cm到5cm。其原因可能是在較大的合成數據集中存在較大的深度分布方差。這一觀察結果還表明,重構物體級深度比預測NOCS表示更難。6D位姿估計的定量結果:我們將我們的方法與下表中最先進的方法進行定量比較。

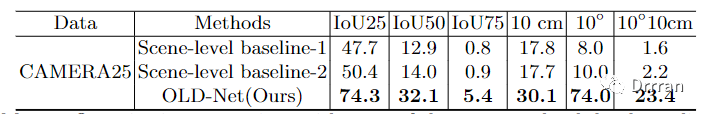

我們首先將我們的方法與Lee et al.在CAMERA25數據集上進行比較。Lee等人通過首先重建網格,然后將網格渲染成深度圖來預測深度。相比之下,我們選擇直接重構對象級深度,這更簡單,也更有效。我們可以看到,我們的方法在6個指標中的4個指標上優于Lee et al.。在最嚴格的10?10cm度量,我們的方法超過Lee等人4.2分,這是一個顯著的改進。在IoU25和IoU50指標上,盡管我們的結果略低于Lee等人,但我們仍然實現了相當的性能。這些結果表明,使用我們的SDDR方案和NGPH重構對象級深度是比重構對象網格更好的選擇。主要原因可能是,如果深度平移和形狀點解耦,網絡更容易學習有用的信息,如物體的形狀細節或物體的絕對中心。 為了進一步驗證我們重構物體級深度比估計場景級深度的動機和好處,我們將我們的方法與下表中的兩個場景級深度估計基線進行比較。場景級基線-1和場景級基線-2共享相同的編碼器-解碼器網絡架構。不同的是,在訓練時,場景級基線-1與NOCS重構分支共享編碼器,而場景級基線-2獨立訓練深度估計器。這兩個網絡都經過精心調優,以實現最佳性能。下表顯示了OLD-Net顯著優于兩個場景級基線。原因可能是由預測的物體級深度OLD-Net在保存形狀細節方面比粗糙的場景級深度要好得多,而形狀細節對于NOCS深度對齊過程至關重要。

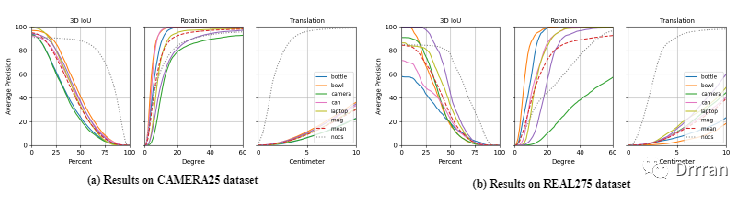

所有這些結果都證明了我們的方法的優越性。此外,我們還在下圖中展示了3D IoU、旋轉誤差和平移誤差的不同閾值下的平均精度(AP)圖。我們將我們的方法與基于rgbd的NOCS方法進行比較。從圖中可以看出,我們的方法在所有類別的IoU和旋轉方面都表現出色。旋轉預測的優異性能很大程度上是由于我們將形狀點解耦到深度之外,以保留形狀細節。在對準中,旋轉是否準確主要取決于物體形狀的質量。因此,我們的模型在旋轉預測方面甚至達到了與基于rgbd的方法相當的性能。相比之下,基于rgbd的預測結果相對較低。這是因為從單目RGB圖像中恢復物體的絕對全局位置是一個問題。因此,今后的工作應更加重視獲得更精確的絕對深度預測。

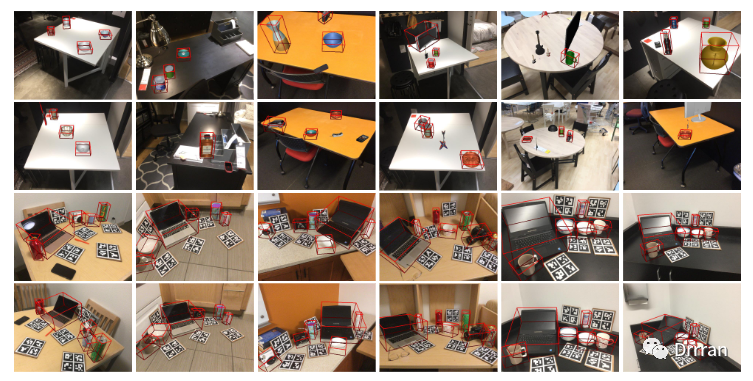

6D位姿估計的定性結果:為了定性分析我們方法的有效性,我們將估計的邊界框可視化,如下圖所示。給出了綜合數據和實際數據的計算結果。可以看出,OLD-Net可以預測的物體邊界框,這對于增強現實產品來說是足夠準確的。在下圖中我們還展示了一些失敗案例。OLDNet有時可能會漏掉物體。我們把解決它作為我們未來的工作。

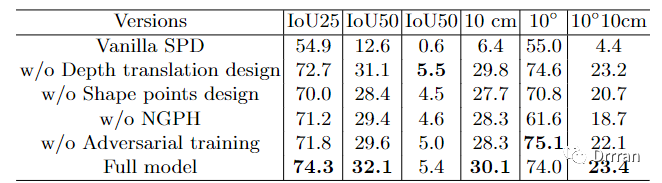

07消融實驗VanillaSPD:我們采用SPD來學習SDDR中的形狀點。人們可能會想,我們的模型的良好性能是否來自于SPD,而不是我們設計的其他模塊。因此,我們展示了僅使用普通SPD模塊(不使用OLD-Net,不使用SDDR,僅使用SPD直接預測對象級深度的反向投影點云)時的性能。沒有我們的其他設計,Vanilla SPD的性能很差。SDDR方案的影響:在本文中,SDDR被引入,將物體級深度解耦為深度轉換和形狀點。與Vanilla SPD相比,我們在下表中的所有模型版本都采用了SDDR方案,因此,它們的性能在很大程度上得到了改善。

表中的第3行,我們沒有使用兩個單獨的模塊來獨立學習深度轉換和形狀點,而是使用一個單一的模塊直接預測絕對的物體級深度。我們發現,IoU25指標和IoU50指標下降了很多。這可能是因為如果不把深度解耦出來,網絡可能會丟失物體的細節,如物體的長寬高比例或一些特定的物體成分。此外,在第4行,我們顯示了用MLP代替SPD來預測形狀點的結果,即直接回歸NOCS和物體級深度。很明顯,所有的指標都有明顯的下降。這個結果證明了在SDDR中采用SPD是非常必要的。SPD為模型提供了關于物體形狀的強大約束。請注意表的第3行和第4行,雖然我們刪除了一些設計,但屬于物體的像素的二維坐標仍被用于反向投影(它也是SDDR的一部分),這將為絕對深度提供額外的約束。否則,性能會更差,如表第2行所示,它直接預測了物體點云。總之,SDDR方案在OLD-Net中對物體形狀細節的保存和絕對物體中心的預測都起著重要的作用。NGPH的影響:由于我們的模型只采取RGB圖像來預測深度以保存形狀細節,全局位置信息將被丟失。為了彌補這一缺陷,我們將NGPH注入到我們的網絡中。在表的第5行中,我們將NGPH從我們的網絡中移除,以研究其影響。當它被移除后,所有的指標都下降了很多。這是因為,沒有NGPH,網絡就很難預測絕對深度。盡管三維點之間的相對位置可以從圖像中推斷出來,但錯誤的絕對深度會使我們很難通過對齊來準確恢復物體的姿勢。 我們采用對抗性訓練策略來提高預測的NOCS表示的質量。當它被移除時,如表的倒數第二行所示,除了10?指標外,所有指標都下降了。這一結果證明了對抗性訓練對于提高性能是必要的。它還表明,NOCS表示的質量和對象層面的深度都很重要。兩者都不能被忽視。08總結本文提出了一種新的基于rgb的類別級6D目標位姿估計網絡OLD-Net。利用形狀先驗直接預測物體層次深度是我們研究的關鍵。在OLD-Net中引入了歸一化全局位置提示和形狀感知解耦深度重構方案。我們還使用對抗性訓練預測管道中對象的規范NOCS表示。在真實數據集和合成數據集上的大量實驗表明,我們的方法可以實現新的最先進的性能。

審核編輯 :李倩

-

RGB

+關注

關注

4文章

801瀏覽量

58626 -

網絡

+關注

關注

14文章

7594瀏覽量

89078 -

數據集

+關注

關注

4文章

1209瀏覽量

24773

原文標題:ECCV 2022 | 從單目RGB圖像中進行類別級6D物體姿態估計

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一種降低VIO/VSLAM系統漂移的新方法

江西薩瑞微榮獲&amp;quot;2024全國第三代半導體制造最佳新銳企業&amp;quot;稱號

OCTC發布&quot;算力工廠&quot;!力促智算中心高效規劃建設投運

軟通動力攜手華為啟動&quot;智鏈險界&quot;計劃,強化生態鏈接共啟保險AI新時代

亞馬遜云科技啟動&quot;智能家居與智能產品創新加速計劃&quot;

一種無透鏡成像的新方法

一種利用光電容積描記(PPG)信號和深度學習模型對高血壓分類的新方法

晶科能源榮獲EUPD Research授予的六項&quot;頂級光伏品牌&quot;稱號

九聯科技推出一款&quot;射手座&quot;UMA502-T7物聯網模組

2024CCLTA | &quot;智&quot;領檢驗,&quot;慧&quot;聚山城

科沃斯掃地機器人通過TüV萊茵&quot;防纏繞&quot;和&quot;高效邊角清潔&quot;認證

Quanterix宣布Tau217血液檢測被美國FDA授予 &quot;突破性器械 &quot;認證

電池&quot;無&quot;隔膜?SEI新&quot;膜&quot;法!

一種 "物體深度重建網絡"(OLD-Net)的新方法

一種 "物體深度重建網絡"(OLD-Net)的新方法

評論