完善資料讓更多小伙伴認(rèn)識(shí)你,還能領(lǐng)取20積分哦,立即完善>

電子發(fā)燒友網(wǎng)技術(shù)文庫(kù)為您提供最新技術(shù)文章,最實(shí)用的電子技術(shù)文章,是您了解電子技術(shù)動(dòng)態(tài)的最佳平臺(tái)。

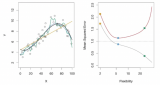

數(shù)據(jù)集的任何變化都將提供一個(gè)不同的估計(jì)值,若使用統(tǒng)計(jì)方法過(guò)度匹配訓(xùn)練數(shù)據(jù)集時(shí),這些估計(jì)值非常準(zhǔn)確。一個(gè)一般規(guī)則是,當(dāng)統(tǒng)計(jì)方法試圖更緊密地匹配數(shù)據(jù)點(diǎn),或者使用更靈活的方法時(shí),偏差會(huì)減少,但方差會(huì)增加。...

最快的存儲(chǔ)器類型是SRAM,但每個(gè)SRAM單元需要六個(gè)晶體管,因此SRAM在SoC內(nèi)部很少使用,因?yàn)樗鼤?huì)消耗大量的空間和功率。...

使用卷積神經(jīng)網(wǎng)絡(luò)(CNN)、支持向量機(jī)(SVM)、K近鄰(KNN)和長(zhǎng)短期記憶(LSTM)神經(jīng)網(wǎng)絡(luò)等四種不同的分類方法對(duì)三種步態(tài)模式進(jìn)行自動(dòng)分類。...

這些偏見(jiàn)特征可能導(dǎo)致模型在沒(méi)有明確提及這些偏見(jiàn)的情況下,系統(tǒng)性地歪曲其推理過(guò)程,從而產(chǎn)生不忠實(shí)(unfaithful)的推理。...

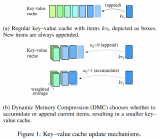

DMC通過(guò)一個(gè)決策變量(α)來(lái)有效地對(duì)輸入序列進(jìn)行分段,每個(gè)段落可以獨(dú)立地決定是繼續(xù)追加還是進(jìn)行累積。這允許模型在不同段落之間動(dòng)態(tài)調(diào)整內(nèi)存使用。...

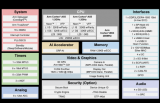

RZ/V2L還與RZ/G2L封裝和引腳兼容。這使得RZ/G2L用戶可輕松升級(jí)至RZ/V2L,以獲得額外的人工智能功能,而無(wú)需修改系統(tǒng)配置,從而保持低遷移成本。...

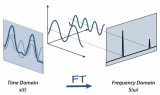

連續(xù)傅里葉變換(CFT)和離散傅里葉變換(DFT)是兩個(gè)常見(jiàn)的變體。CFT用于連續(xù)信號(hào),而DFT應(yīng)用于離散信號(hào),使其與數(shù)字?jǐn)?shù)據(jù)和機(jī)器學(xué)習(xí)任務(wù)更加相關(guān)。...

訓(xùn)練經(jīng)過(guò)約50次左右迭代,在訓(xùn)練集上已經(jīng)能達(dá)到99%的正確率,在測(cè)試集上的正確率為90.03%,單純的BP神經(jīng)網(wǎng)絡(luò)能夠提升的空間不大了,但kaggle上已經(jīng)有人有卷積神經(jīng)網(wǎng)絡(luò)在測(cè)試集達(dá)到了99.3%的準(zhǔn)確率。...

通用大型語(yǔ)言模型(LLM)推理基準(zhǔn):研究者們介紹了多種基于文本的推理任務(wù)和基準(zhǔn),用于評(píng)估LLMs在不同領(lǐng)域(如常識(shí)、數(shù)學(xué)推理、常識(shí)推理、事實(shí)推理和編程)的性能。這些研究包括BIG-bench、HELM、SuperGLUE和LAMA等。...

基于神經(jīng)網(wǎng)絡(luò)技術(shù),僅利用相對(duì)于傳統(tǒng)態(tài)層析方法50%的測(cè)量基數(shù)目,即可實(shí)現(xiàn)平均保真度高達(dá)97.5%的開(kāi)放光量子行走的完整混合量子態(tài)表征。...

GEAR框架通過(guò)結(jié)合三種互補(bǔ)的技術(shù)來(lái)解決這一挑戰(zhàn):首先對(duì)大多數(shù)相似幅度的條目應(yīng)用超低精度量化;然后使用低秩矩陣來(lái)近似量化誤差。...

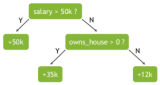

隨機(jī)森林使用名為“bagging”的技術(shù),通過(guò)數(shù)據(jù)集和特征的隨機(jī)自助抽樣樣本并行構(gòu)建完整的決策樹(shù)。雖然決策樹(shù)基于一組固定的特征,而且經(jīng)常過(guò)擬合,但隨機(jī)性對(duì)森林的成功至關(guān)重要。...

一對(duì)其余其實(shí)更加好理解,每次將一個(gè)類別作為正類,其余類別作為負(fù)類。此時(shí)共有(N個(gè)分類器)。在測(cè)試的時(shí)候若僅有一個(gè)分類器預(yù)測(cè)為正類,則對(duì)應(yīng)的類別標(biāo)記為最終的分類結(jié)果。...

深度學(xué)習(xí)的效果在某種意義上是靠大量數(shù)據(jù)喂出來(lái)的,小目標(biāo)檢測(cè)的性能同樣也可以通過(guò)增加訓(xùn)練集中小目標(biāo)樣本的種類和數(shù)量來(lái)提升。...

不同于上述工作從待干預(yù)模型自身抽取引導(dǎo)向量,我們意在從LLMs預(yù)訓(xùn)練過(guò)程的切片中構(gòu)建引導(dǎo)向量來(lái)干預(yù)指令微調(diào)模型(SFT Model),試圖提升指令微調(diào)模型的可信能力。...

在大模型的發(fā)展史上,Scaling Law(規(guī)模律)發(fā)揮了核心作用,它是推動(dòng)模型性能持續(xù)提升的主要?jiǎng)恿Αcaling Law揭示了這樣一個(gè)現(xiàn)象:較小的語(yǔ)言模型只能解決自然語(yǔ)言處理(NLP)中的部分問(wèn)題,但隨著模型規(guī)模擴(kuò)大——參數(shù)數(shù)量增加至數(shù)十億甚至數(shù)百億,曾經(jīng)在NLP領(lǐng)域中的棘手難題往往能得到有效...

首先看吞吐量,看起來(lái)沒(méi)有什么違和的,在單卡能放下模型的情況下,確實(shí)是 H100 的吞吐量最高,達(dá)到 4090 的兩倍。...

Nvidia是一個(gè)同時(shí)擁有 GPU、CPU和DPU的計(jì)算芯片和系統(tǒng)公司。Nvidia通過(guò)NVLink、NVSwitch和NVLink C2C技術(shù)將CPU、GPU進(jìn)行靈活連接組合形成統(tǒng)一的硬件架構(gòu),并于CUDA一起形成完整的軟硬件生態(tài)。...

人工智能在早期誕生了一個(gè)“不甚成功”的流派,叫做“人工神經(jīng)網(wǎng)絡(luò)”。這個(gè)技術(shù)的思路是,人腦的智慧無(wú)與倫比,要實(shí)現(xiàn)高級(jí)的人工智能,模仿人腦就是不二法門。...

人工神經(jīng)網(wǎng)絡(luò)模型 AI芯片的核心原理基于人工神經(jīng)網(wǎng)絡(luò),其中芯片內(nèi)部的處理單元模擬了生物神經(jīng)元的工作機(jī)制。每一個(gè)處理單元能夠獨(dú)立進(jìn)行復(fù)雜的數(shù)學(xué)運(yùn)算,例如權(quán)重乘以輸入信號(hào)并累加,形成神經(jīng)元的激活輸出。...