斯坦福大學(xué)和Adobe研究院的研究者們提出了全新的通用深度網(wǎng)絡(luò)架構(gòu)CPNet,用于學(xué)習(xí)視頻中圖片之間的長程對應(yīng)關(guān)系,來解決現(xiàn)有方法在處理視頻長程運(yùn)動中的局限性。在三大視頻分類數(shù)據(jù)集上取得了優(yōu)于之前結(jié)果的性能。相關(guān)論文獲CVPR 2019 oral。

這是一款全新的通用深度網(wǎng)絡(luò)架構(gòu)。

現(xiàn)有的視頻深度學(xué)習(xí)架構(gòu)通常依賴于三維卷積、自相關(guān)、非局部模塊等運(yùn)算,這些運(yùn)算難以捕捉視頻中幀間的長程運(yùn)動/相關(guān)性。

近日,來自斯坦福和Adobe的研究人員,受到點(diǎn)云上深度學(xué)習(xí)方法的啟發(fā),提出了一個通用的深度網(wǎng)絡(luò)架構(gòu)CPNet,用于學(xué)習(xí)視頻中圖片之間的長程對應(yīng)關(guān)系,來解決上述問題。

arXiv地址:

https://arxiv.org/abs/1905.07853

研究人員們所提出的CPNet是一個全新的通用的視頻深度學(xué)習(xí)框架。該網(wǎng)絡(luò)通過尋找對應(yīng)的表征來學(xué)習(xí)視頻中圖片之間稀疏且不規(guī)則的對應(yīng)模式,并且可以融合進(jìn)現(xiàn)有的卷積神經(jīng)網(wǎng)絡(luò)架構(gòu)中。

研究人員在三個視頻分類數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn),結(jié)果表明,CPNet在性能上取得了較大的突破。

CPNet:對應(yīng)提議網(wǎng)絡(luò)

視頻是由一串圖片組成。然而,視頻并不是任意圖片隨機(jī)的堆砌,其前后幀有強(qiáng)烈的相關(guān)性,表現(xiàn)為一幀圖片中的物體通常會在其它幀中出現(xiàn)。

相比于單張靜態(tài)的圖片,這樣的對應(yīng)關(guān)系構(gòu)成了視頻中動態(tài)的部分。我們總結(jié)視頻中圖片之間的對應(yīng)關(guān)系有如下三大特點(diǎn):

對應(yīng)位置有相似的視覺或語義特征。這也是我們?nèi)祟惻卸▋蓭械南袼厥欠駥儆谕晃矬w的標(biāo)準(zhǔn)之一。

對應(yīng)位置在空間維和時(shí)間維上都可以有任意長的距離。空間維上,物體可以很快從圖片的一端運(yùn)動到另一端;時(shí)間維上,物體可以在視頻中存在任意長的時(shí)間。

潛在的對應(yīng)位置所占比例為少數(shù)。對于一個像素/表征,在其它幀中通常只有極少的相似像素/表征是可能的對應(yīng),其它明顯不相似的像素/表征則可以忽略掉。換言之,對應(yīng)關(guān)系存在不規(guī)則性和稀疏性。

那么什么樣的網(wǎng)絡(luò)架構(gòu)可以滿足上述特點(diǎn)呢?

三維卷積無法檢測相似性;自相關(guān)是局部操作,無法勝任長程對應(yīng);非局部模塊側(cè)重于注意力機(jī)制,無法適應(yīng)稀疏性和不規(guī)則性,也無法學(xué)到長程運(yùn)動的方向。因此我們需要全新的網(wǎng)絡(luò)架構(gòu)。

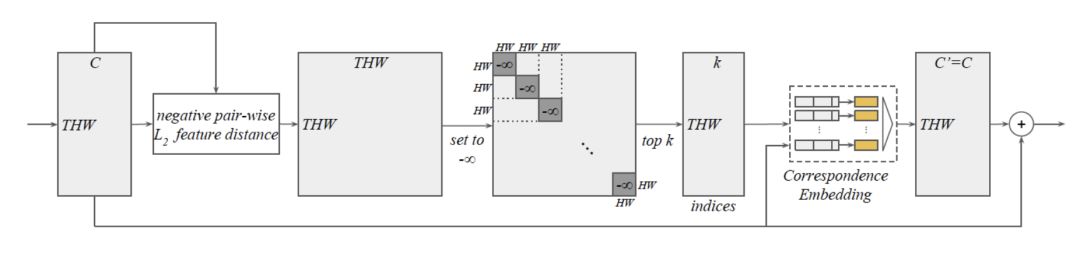

圖1

我們提出了對應(yīng)提議網(wǎng)絡(luò)CPNet(Correspondence Proposal Network),其架構(gòu)能同時(shí)滿足上述三種特點(diǎn)。

核心思想如圖1所示:深度網(wǎng)絡(luò)架構(gòu)中,我們將視頻表征張量視為一個點(diǎn)云,在語義特征空間中(而非一般的時(shí)空空間),對于表征張量中的每一個表征即“點(diǎn)”,我們尋找其在其它幀里最近的k個“點(diǎn)”,并將其視為該表征的潛在對應(yīng)。然后類似于點(diǎn)云上的深度學(xué)習(xí),對于這k對“點(diǎn)”中的每一對,我們使用相同且互相獨(dú)立的神經(jīng)網(wǎng)絡(luò)處理他們的特征向量和位置,然后用最大池化操作從k個輸出中提取出最強(qiáng)的響應(yīng)。本質(zhì)上,我們的網(wǎng)絡(luò)架構(gòu)可以學(xué)到從這k對潛在對應(yīng)中選擇出最有趣的信息。如此一來,最后的輸出表征向量就包含了視頻中的動態(tài)信息。

CPNet的架構(gòu)

我們將網(wǎng)絡(luò)的核心命名為”CP模塊“,其結(jié)構(gòu)如下,大致分為兩個部分。輸入和輸出都是一個THW x C的視頻表征張量,我們將這兩者都視為一個THW個點(diǎn)的帶C維特征向量的點(diǎn)云。

第一個部分為語義特征空間k最近鄰算法,如圖2所示。我們先求出所有表征對之間的負(fù)L2語義距離得到THW x THW形狀的矩陣;然后將對角線上的T個HW x HW子矩陣的元素置為負(fù)無窮,這樣位于同一幀的表征就可以排除在潛在對應(yīng)表征之外了。之后對每一行進(jìn)行arg top k操作就可以得到潛在對應(yīng)表征的下標(biāo)。

圖2

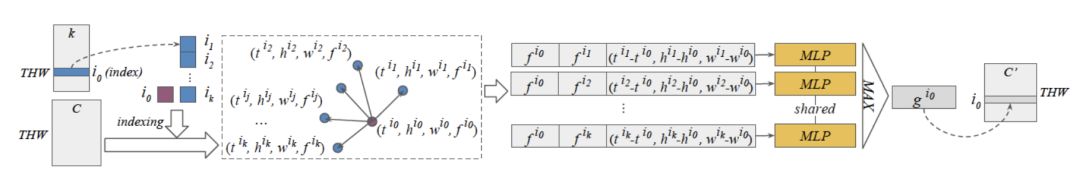

第二個部分為對應(yīng)關(guān)系的學(xué)習(xí)。我們用上一步得到的下標(biāo)從輸入視頻表征張量中提取出表征。對于每一個輸入表征和其k個最近鄰表征組成的k對表征對中的一對,我們將這一對表征的語義特征向量以及其之間的時(shí)空相對位置連在一起,得到k個長向量。然后我們將這k個長向量送入相同且互相獨(dú)立的多層感知器(MLP),然后再用元素級的最大池化操作(element-wise max-pooling)得到輸出向量,也就是輸出視頻表征張量該表征位置的語義特征向量。

圖3

為了防止訓(xùn)練時(shí)梯度爆炸或消失,類似于ResNet中的跳躍連接,我們將上一步的輸出表征張量加回到了輸入表征張量中。可以看到,該模塊可以無縫銜接進(jìn)現(xiàn)有的卷積神經(jīng)網(wǎng)絡(luò)架構(gòu)如ResNet中。在實(shí)驗(yàn)中,所有CP模塊一開始初始化為全等操作,這樣我們就可以使用ImageNet預(yù)訓(xùn)練模型來初始化網(wǎng)絡(luò)其它部分的參數(shù)。

實(shí)驗(yàn)結(jié)果

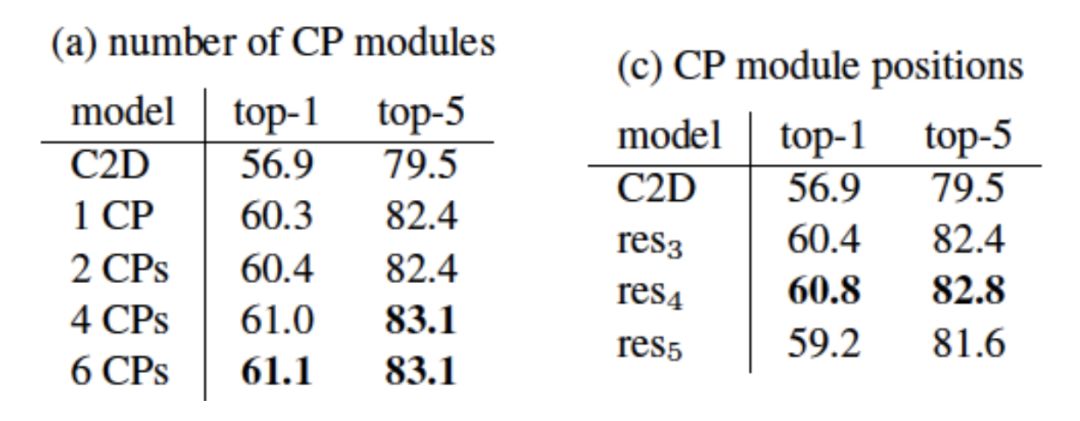

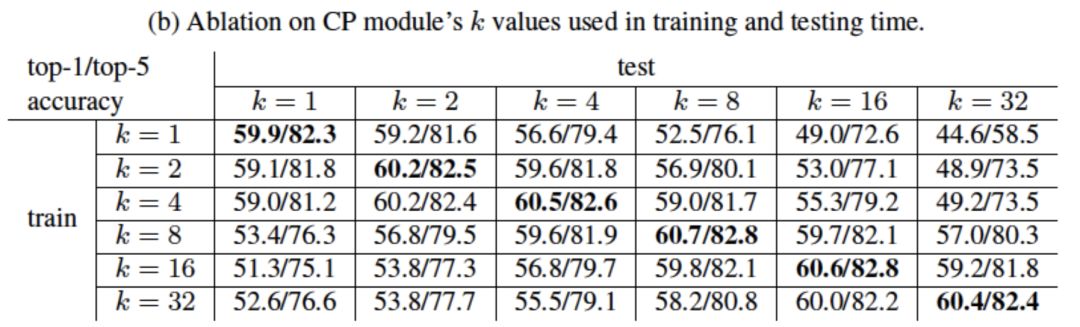

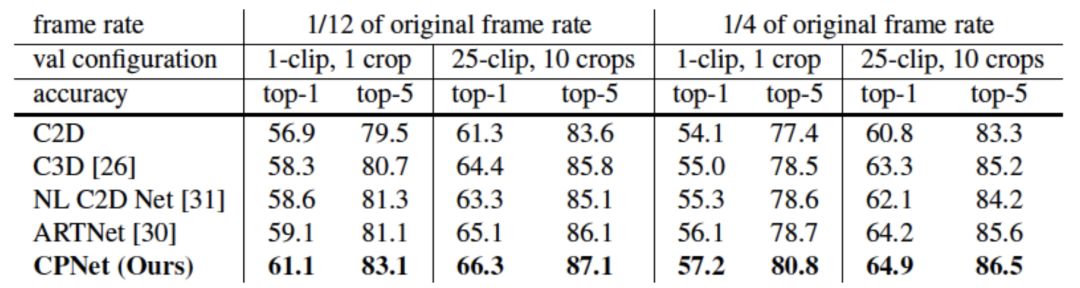

我們在大規(guī)模視頻分類數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn)。首先,我們在Kinetics數(shù)據(jù)集上進(jìn)行了小規(guī)模模型的實(shí)驗(yàn)來研究CP模塊的數(shù)量、位置以及k值的大小對視頻分類結(jié)果的影響。由結(jié)果可知,模型的性能隨CP模塊數(shù)量增多而提高并趨于飽和;CP模塊放置的位置對性能有影響;k值在訓(xùn)練時(shí)和推理時(shí)保持一致且合適的值可以得到最佳性能。

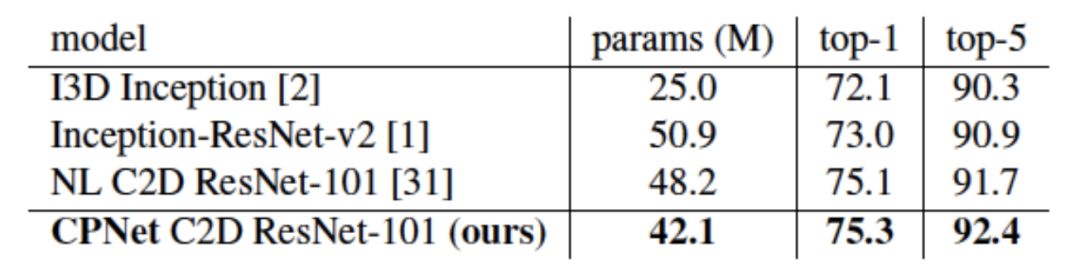

我們在Kinetics數(shù)據(jù)集上與其它已發(fā)表結(jié)果進(jìn)行了比較。我們同時(shí)比較了小規(guī)模和大規(guī)模模型。CPNet在參數(shù)數(shù)量更少的情況下取得優(yōu)于之前結(jié)果的性能。

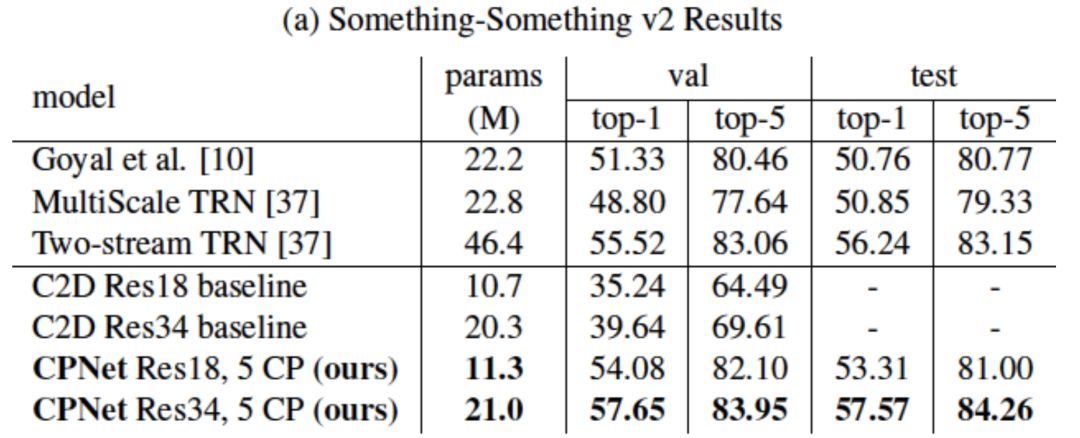

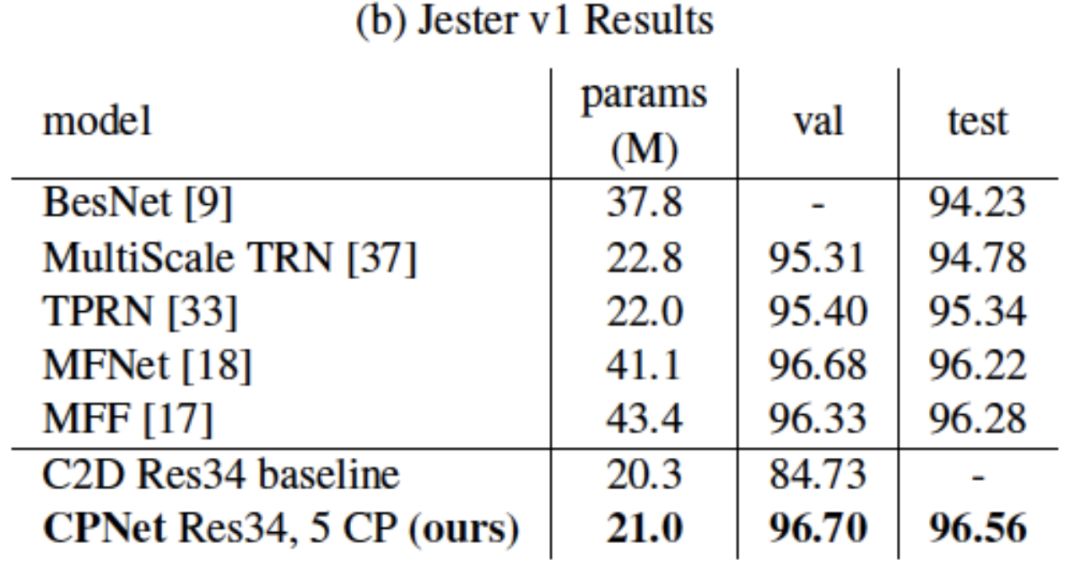

我們也在Something-Something和Jester數(shù)據(jù)集上與其它已發(fā)表結(jié)果進(jìn)行了比較。相比于Kinetics,這兩個數(shù)據(jù)集更偏重動態(tài)信息對分類的影響。CPNet同樣在參數(shù)數(shù)量更少的情況下取得優(yōu)于之前結(jié)果。

值得注意的是,相比于沒有CP模塊的基準(zhǔn)二維卷積ResNet,CPNet僅僅額外加入了極少的參數(shù),就在這兩個數(shù)據(jù)集上得到了極大的性能提升,進(jìn)一步證明了其學(xué)習(xí)視頻中動態(tài)信息的強(qiáng)大能力。

模型的可視化

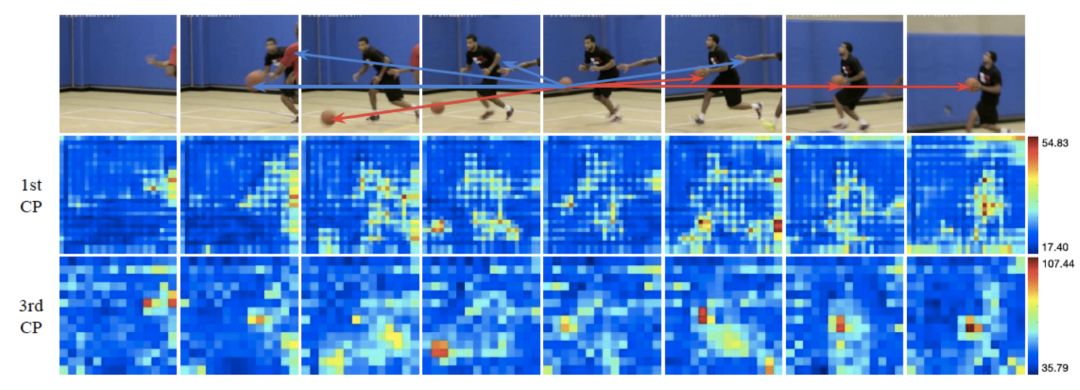

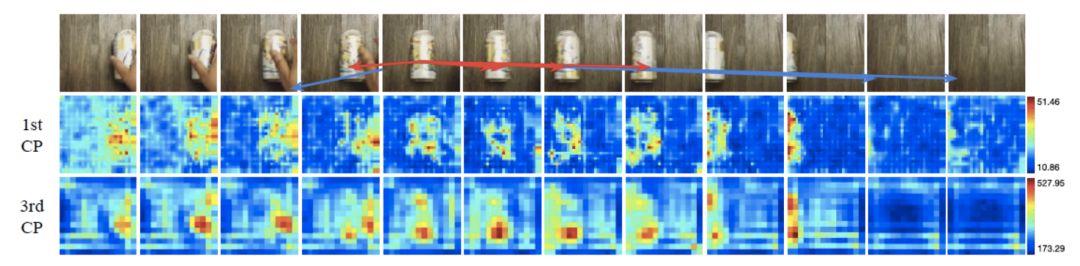

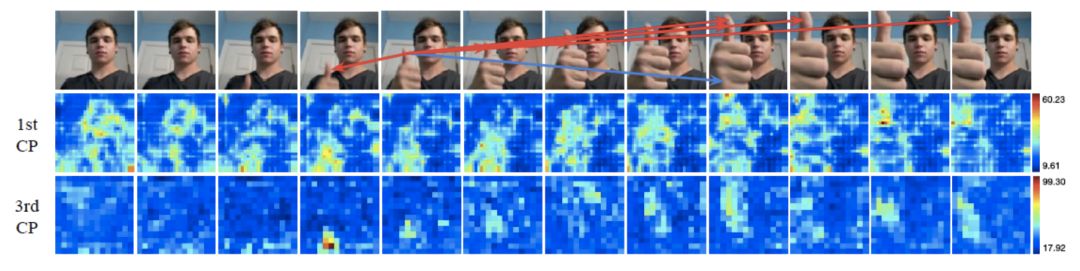

我們對訓(xùn)練好的模型進(jìn)行了可視化來理解其工作原理。

我們選取了一個表征的位置,然后在圖片中用箭頭標(biāo)注出其k個最近鄰表征的位置。特別地,我們用紅色箭頭標(biāo)注出哪些最近鄰表征在最大池化過程中被選中。我們同時(shí)用熱圖來顯示表征圖在經(jīng)過CP模塊后的變化。

可以看到,通過語義特征的距離,CP模塊可以大致找到正確的潛在對應(yīng)位置,例如上圖中的籃球、易拉罐和大拇指。

在上述例子中,對于錯誤的對應(yīng)提議,CP模塊也能在最大池化過程中忽略掉它們。同時(shí),熱圖顯示CP模塊對于處于運(yùn)動狀態(tài)的圖片部分更加敏感。

-

矩陣

+關(guān)注

關(guān)注

0文章

425瀏覽量

34609 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1209瀏覽量

24793 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5512瀏覽量

121426

原文標(biāo)題:斯坦福&Adobe CVPR 19 Oral:全新通用深度網(wǎng)絡(luò)架構(gòu)CPNet

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

Adobe研究院的研究者們提出了全新的通用深度網(wǎng)絡(luò)架構(gòu)CPNet

Adobe研究院的研究者們提出了全新的通用深度網(wǎng)絡(luò)架構(gòu)CPNet

評論