編者按:深度學習的發展推動了很多大型神經網絡模型的誕生,這些模型在多個領域中都取得了當前最優的性能,基于Transformer的預訓練模型也在自然語言理解(NLU)和自然語言生成(NLG)領域中成為主流。然而,這些模型所包含的參數量巨大,計算成本高昂,極大地阻礙了此類模型在生產環境中的應用。為了解決該問題,來自微軟亞洲研究院自然語言計算組的研究員們提出了一種模型壓縮的新思路。

隨著深度學習的流行,很多大型神經網絡模型誕生,并在多個領域中取得當前最優的性能。尤其是在自然語言處理(NLP)領域中,預訓練和調參已經成為其中大多數任務的新范式。基于 Transformer 的預訓練模型在自然語言理解(NLU)和自然語言生成(NLG)領域中成為主流。盡管這些模型從“過參數化”的特性中獲益,但它們往往包含數百萬甚至數十億個參數,這就使得此類模型的計算成本高昂,且從內存消耗和高延遲的角度來看計算低效。這一缺陷極大地阻礙了此類模型在生產環境中的應用。

為了解決該問題,研究人員提出了很多神經網絡壓縮技術。一般而言,這些技術可以分為三類:量化、權重剪枝和知識蒸餾(Knowledge Distillation)。其中,由于知識蒸餾能夠壓縮預訓練語言模型,所以得到了極大關注。知識蒸餾利用大型教師模型“教”緊湊的學生模型模仿教師的行為,從而將教師模型中嵌入的知識遷移到較小的模型中。但是,學生模型的性能狀況取決于設計良好的蒸餾損失函數,正是這個函數使得學生模型可以模仿教師的行為。近期關于知識蒸餾的研究甚至利用更復雜的模型特定蒸餾損失函數,以實現更好的性能。

近日,來自微軟亞洲研究院自然語言計算組的研究員們提出了一種與顯式地利用蒸餾損失函數來最小化教師模型與學生模型距離的知識蒸餾不同的模型壓縮新方法。受到著名哲學思想實驗“忒修斯之船”的啟發(即如果船上的木頭逐漸被替換,直到所有的木頭都不是原來的木頭,那這艘船還是原來的那艘船嗎?),研究員們在 EMNLP 2020 上發表了 Theseus Compression for BERT (BERT-of-Theseus),該方法逐步將 BERT 的原始模塊替換成參數更少的替代模塊(點擊文末閱讀原文,了解論文詳情)。研究員們將原始模型叫做“前輩”(predecessor),將壓縮后的模型叫做“接替者”(successor),分別對應知識蒸餾中的教師和學生。

該方法的工作流程如下圖所示。首先為每個前輩模塊指定一個接替者模塊,然后在訓練階段中以一定的概率(如拋硬幣)決定是否用替代模塊隨機替換對應的前輩模塊,并按照新舊模塊組合的方式繼續訓練。在模型收斂后,將所有接替者模塊組合成接替者模型,進而執行推斷。這樣就可以將大型前輩模型壓縮成緊湊的接替者模型了。

舉例來說,假設現在有兩支籃球隊每支各五人,一支是經驗老道的全明星球隊,另一支則是年輕球員組成的青訓隊。為了提高青訓隊的水平,所以隨機選派青訓隊員去替換掉全明星隊中的球員,然后讓這個混合的球隊不斷地練習、比賽。通過向前輩學習經驗,新加入成員的實力會有所提升,也能學會和其他隊員的配合,逐漸的這個混合球隊就擁有了接近全明星球隊的實力。之后重復這個過程,直到青訓隊員都被充分訓練,最終青訓隊員也能自己組成一支實力突出的球隊。相比之下,如果沒有“老司機”來帶一帶,青訓隊無論如何訓練,水平也不會達到全明星隊的實力。

事實上,Theseus 壓縮與知識蒸餾的思路有些類似,都是鼓勵壓縮模型模仿原始模型的行為,但 Theseus 壓縮有很多獨特的優勢。

首先,Theseus 壓縮在壓縮過程中僅使用任務特定的損失函數。而基于知識蒸餾的方法除了使用任務特定的損失函數外,還需加入繁瑣的蒸餾損失函數作為優化目標。

其次,與近期研究 TinyBERT 等不同,Theseus 壓縮不使用Transformer 特定特征進行壓縮,這就為壓縮廣泛模型提供了可能性。與知識蒸餾僅使用原始模型執行推斷不同,該方法允許前輩模型與壓縮后的接替者模型共同訓練,從而實現更深層次的梯度級交互,并簡化訓練過程。

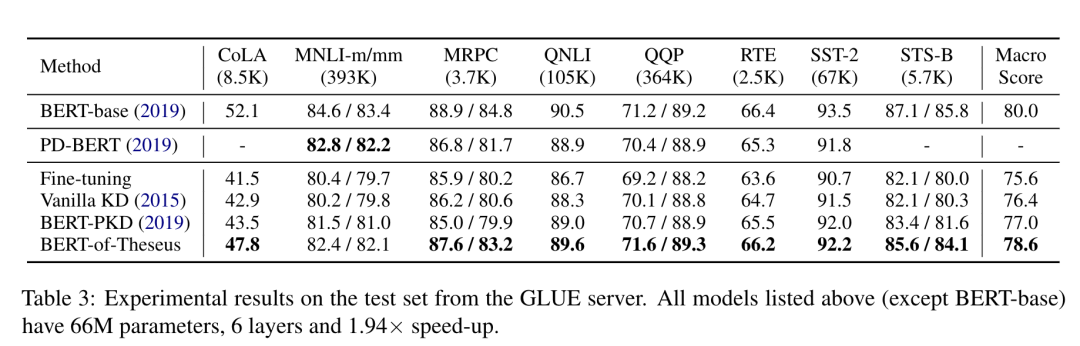

此外,混合了前輩模塊和接替者模塊的不同模塊組合還添加了額外的正則化項(類似于 Dropout)。該方法基于課程學習(Curriculum Learning)方法來驅動模塊替換,將模塊替換概率從低到高逐漸增加,從而實現優異的 BERT 壓縮性能。利用Theseus 壓縮方法壓縮得到的 BERT 模型運算速度是之前的1.94 倍,并且保留了原始模型超過98% 的性能,優于其它基于知識蒸餾的壓縮的基線方法。

通過在預訓練語言模型 BERT 上的成功實驗,微軟亞洲研究院的研究員們希望可以為模型壓縮打開一種全新的思路,并希望看到這一方法在計算機視覺等領域的更廣泛應用。

責任編輯:lq

-

微軟

+關注

關注

4文章

6627瀏覽量

104332 -

神經網絡

+關注

關注

42文章

4779瀏覽量

101052 -

函數

+關注

關注

3文章

4345瀏覽量

62880

原文標題:【EMNLP2020】忒修斯之船啟發下的知識蒸餾新思路 - 微軟研究院

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

胡瀚接棒騰訊多模態大模型研發

浪潮信息與智源研究院攜手共建大模型多元算力生態

安謀科技與智源研究院達成戰略合作,共建開源AI“芯”生態

藍思科技將新增昆山創新研究院,重點服務蘋果

中國電信人工智能研究院完成首個全國產化萬卡萬參大模型訓練

摩爾線程攜手智源研究院完成基于Triton的大模型算子庫適配

香港城市大學與富士康鴻海研究院成立聯合研究中心

長沙北斗研究院總部基地正式奠基

微軟亞洲研究院發布VASA-1模型,實現圖片人物自動言語表達

本源入榜胡潤研究院2024全球獨角獸榜單!

微軟亞洲研究院的研究員們提出了一種模型壓縮的新思路

微軟亞洲研究院的研究員們提出了一種模型壓縮的新思路

評論