圖像目標(biāo)檢測(cè)是圖像處理領(lǐng)域的基礎(chǔ)。自從2012年CNN的崛起,深度學(xué)習(xí)在Detection的持續(xù)發(fā)力,為這個(gè)領(lǐng)域帶來(lái)了變革式的發(fā)展:一個(gè)是基于RPN的two-stage,RCNN/Fast RCNN/Faster RCNN、RetinaNet、Mask RCNN等,致力于檢測(cè)精度的提高。一類是基于SSD和YOLOv1/v2/3的one-stage,致力于提高檢測(cè)速度。

視頻目標(biāo)檢測(cè)要解決的問(wèn)題是對(duì)于視頻中每一幀目標(biāo)的正確識(shí)別和定位。相對(duì)于圖像目標(biāo)檢測(cè),視頻是高度冗余的,包含了大量時(shí)間局部性(temporal locality,即在不同的時(shí)間是相似的)和空間局部性(spatial locality,即在不同場(chǎng)景中看起來(lái)是相似的),既Temporal Context(時(shí)間上下文)的信息。充分利用好時(shí)序上下文關(guān)系,可以解決視頻中連續(xù)幀之間的大量冗余的情況,提高檢測(cè)速度;還可以提高檢測(cè)質(zhì)量,解決視頻相對(duì)于圖像存在的運(yùn)動(dòng)模糊、視頻失焦、部分遮擋以及形變等問(wèn)題。

視頻目標(biāo)檢測(cè)和視頻跟蹤不同。兩個(gè)領(lǐng)域解決相同點(diǎn)在于都需要對(duì)每幀圖像中的目標(biāo)精準(zhǔn)定位,不同點(diǎn)在于視頻目標(biāo)檢測(cè)不考慮目標(biāo)的識(shí)別問(wèn)題,而跟蹤需要對(duì)初始幀的目標(biāo)精確定位和識(shí)別。

圖1 高德地圖車載AR導(dǎo)航可識(shí)別前方車輛并提醒

視頻目標(biāo)檢測(cè)應(yīng)用廣泛,如自動(dòng)駕駛,無(wú)人值守監(jiān)控,安防等領(lǐng)域。如圖1所示,高德地圖車載AR導(dǎo)航利用視頻目標(biāo)檢測(cè),能夠?qū)^(guò)往車輛、行人、車道線、紅綠燈位置以及顏色、限速牌等周邊環(huán)境,進(jìn)行智能的圖像識(shí)別,從而為駕駛員提供跟車距離預(yù)警、壓線預(yù)警、紅綠燈監(jiān)測(cè)與提醒、前車啟動(dòng)提醒、提前變道提醒等一系列駕駛安全輔助。

視頻目標(biāo)檢測(cè)算法一般包括單幀目標(biāo)檢測(cè)、多幀圖像處理、光流算法、自適應(yīng)關(guān)鍵幀選擇。Google提出基于Slownetwork 和Fast network分別提取不同特征,基于ConvLSTM特征融合后生成檢測(cè)框,實(shí)現(xiàn)實(shí)時(shí)性的state-of-art。

論文地址:https://arxiv.org/abs/1903.10172

1 Motivation

物體在快速運(yùn)動(dòng)時(shí),當(dāng)人眼所看到的影像消失后,人眼仍能繼續(xù)保留其影像,約0.1-0.4秒左右的圖像,這種現(xiàn)象被稱為視覺(jué)暫留現(xiàn)象。人類在觀看視頻時(shí),利用視覺(jué)暫留機(jī)制和記憶能力,可以快速處理視頻流。借助于存儲(chǔ)功能,CNN同樣可以實(shí)現(xiàn)減少視頻目標(biāo)檢測(cè)的計(jì)算量。

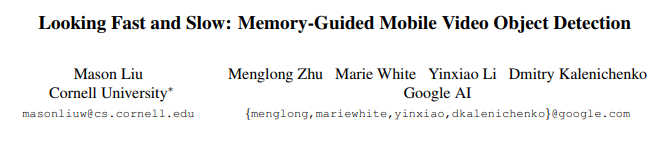

視頻幀具有較高的時(shí)序冗余。如圖2所示,模型[1]提出使用兩個(gè)特征提取子網(wǎng)絡(luò):Slow network 和Fast network。Slow network負(fù)責(zé)提取視頻幀的精確特征,速度較慢,F(xiàn)ast network負(fù)責(zé)快速提取視頻幀的特征提取,準(zhǔn)確率較差,兩者交替處理視頻幀圖像。Fast network和Slow network特征經(jīng)過(guò)ConvLSTM層融合并保存特征。檢測(cè)器在當(dāng)前幀特征和上下文特征融合基礎(chǔ)上生成檢測(cè)框。論文提取基于強(qiáng)化學(xué)習(xí)策略的特征提取調(diào)度機(jī)制和需要保存特征的更新機(jī)制。

論文提出的算法模型在Pixel 3達(dá)到72.3 FPS,在VID 2015數(shù)據(jù)集state-of-art性能。

論文創(chuàng)新點(diǎn):

1、提出基于存儲(chǔ)引導(dǎo)的交替模型框架,使用兩個(gè)特征提取網(wǎng)絡(luò)分別提取不同幀特征,減少計(jì)算冗余。

2、提出基于Q-learning學(xué)習(xí)自適應(yīng)交替策略,取得速度和準(zhǔn)確率的平衡。

3、在手機(jī)設(shè)備實(shí)現(xiàn)迄今為止已知視頻目標(biāo)檢測(cè)的最高速度。

圖2 存儲(chǔ)引導(dǎo)的交錯(cuò)模型

2網(wǎng)絡(luò)架構(gòu)

2.1交錯(cuò)模型

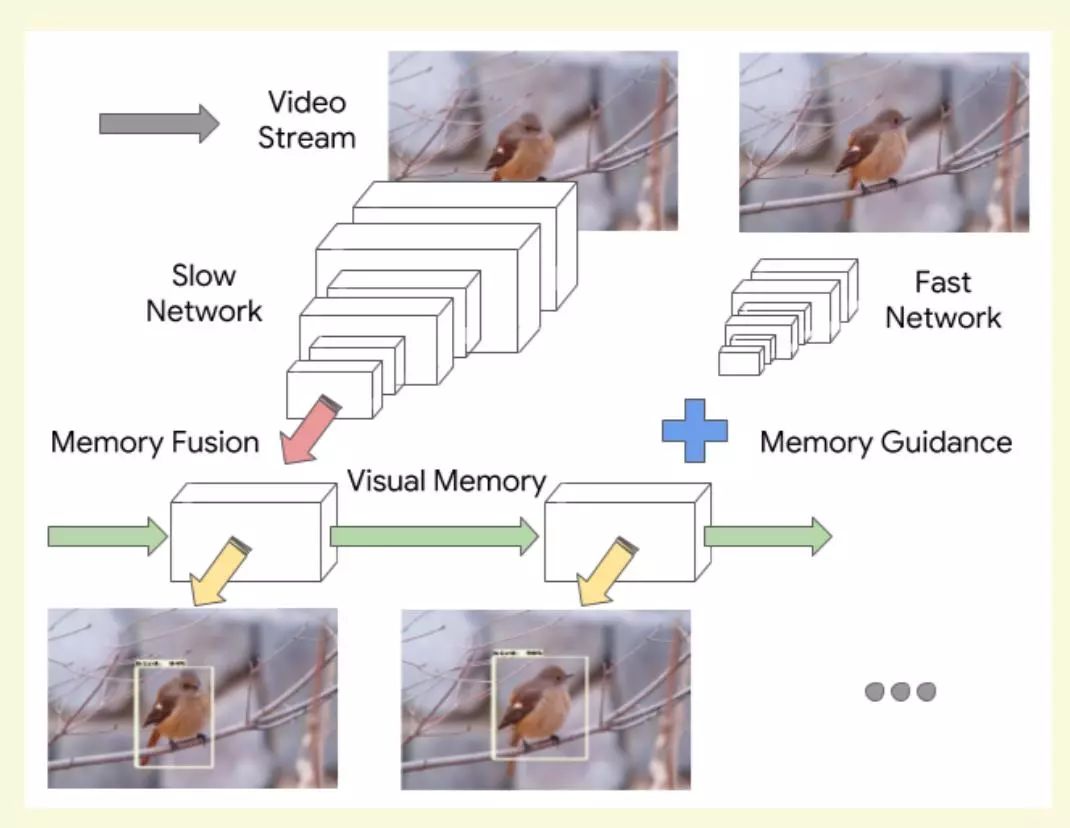

圖3交錯(cuò)模型

如圖3所示論文提出的交錯(cuò)模型(τ = 2),Slow network(Large featureextractor)和Fastnetwork(Small feature extractor)均由MobileNetV2構(gòu)成(兩個(gè)模型的depth multiplier不同,前者為1.4,后者為0.35),anchors比率限制為{1.0,0.5,2.0}。

2.2存儲(chǔ)模型

LSTM可以高效處理時(shí)序信息,但是卷積運(yùn)算量較大,并且需要處理所有視頻幀特征。論文提出改進(jìn)的ConvLSTM模型加速視頻幀序列的特征處理。

ConvLSTM是一種將CNN與LSTM在模型底層結(jié)合,專門為時(shí)空序列設(shè)計(jì)的深度學(xué)習(xí)模塊。ConvLSTM核心本質(zhì)還是和LSTM一樣,將上一層的輸出作下一層的輸入。不同的地方在于加上卷積操作之后,為不僅能夠得到時(shí)序關(guān)系,還能夠像卷積層一樣提取特征,提取空間特征。這樣就能夠得到時(shí)空特征。并且將狀態(tài)與狀態(tài)之間的切換也換成了卷積計(jì)算。

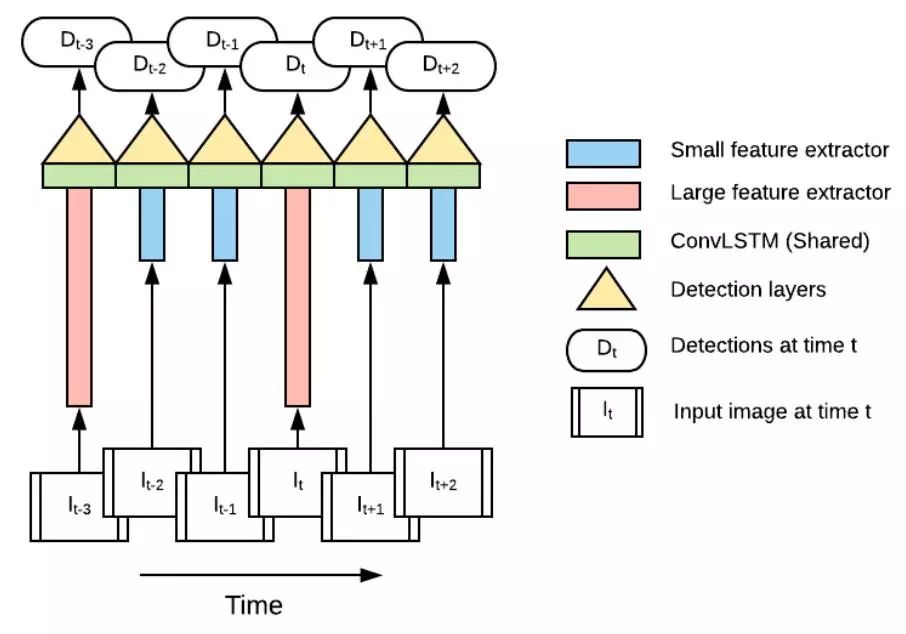

圖4 存儲(chǔ)模型LSTM單元

如所示,論文的ConvLSTM有一下改進(jìn):

1、增加Bottleneck Gate和output跳躍連接。

2、LSTM單元分組卷積。特征圖HxWxN分為G組,每個(gè)LSTM僅處理HxWxN/G的特征,加速ConvLSTM計(jì)算。論文中G = 4。

3、LSTM有一固有弱點(diǎn),sigmoid激活輸入和忘記門很少完全飽和,導(dǎo)致緩慢的狀態(tài)衰減,長(zhǎng)期依賴逐漸喪失,更新中無(wú)法保留完整的前期狀態(tài)。導(dǎo)致Fast network運(yùn)行中,Slownetwork特征緩慢消失。論文使用簡(jiǎn)單的跳躍連接,既第一個(gè)Fast network輸出特征重復(fù)使用。

2.3推斷優(yōu)化

論文提出基于異步模式和量化模型,提高系統(tǒng)的計(jì)算效率。

1、異步模式。交錯(cuò)模型的短板來(lái)自于Slow network。論文采用Fastnetwork提取每幀圖像特征,τ = 2幀采用Slow network計(jì)算特征和更新存儲(chǔ)特征。Slownetwork和Fast network異步進(jìn)行,提高計(jì)算效率。

2、在有限資源的硬件設(shè)備上布置性能良好的網(wǎng)絡(luò),就需要對(duì)網(wǎng)絡(luò)模型進(jìn)行壓縮和加速,其中量化模型是一種高效手段。基于[2]算法,論文的ConvLSTM單元在數(shù)學(xué)運(yùn)算(addition,multiplication, sigmoid and ReLU6)后插入量化計(jì)算,確保拼接操作的輸入范圍相同,消除重新縮放的需求。

3 實(shí)驗(yàn)

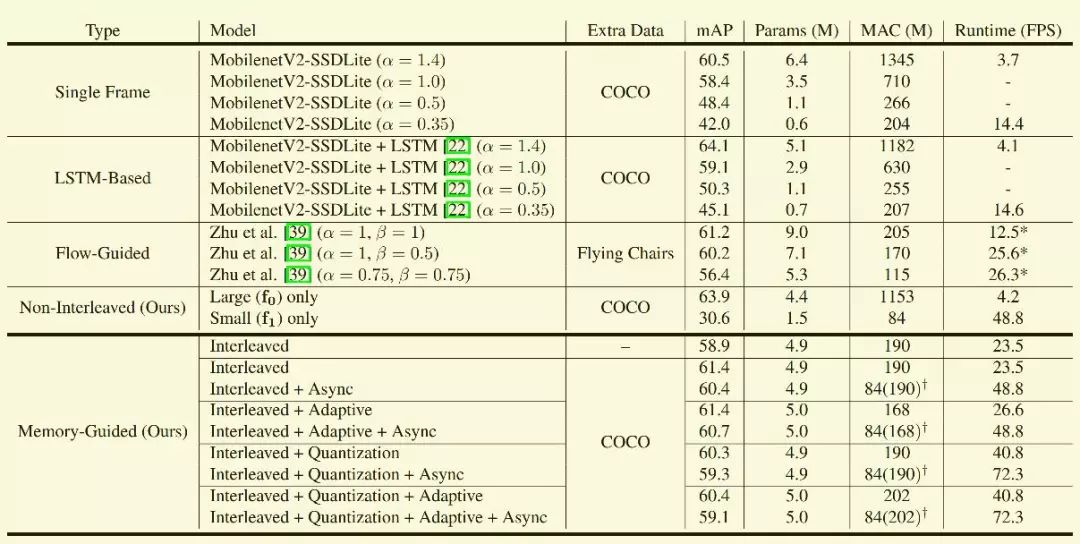

模型在Imagenet DET 和COCO訓(xùn)練,在Imagenet VID 2015測(cè)試結(jié)果如圖5所示。

從測(cè)試結(jié)果看,系統(tǒng)只有Slow network模塊時(shí)準(zhǔn)確率最高, 只有Fast network模塊時(shí)準(zhǔn)確率最低,但是速度沒(méi)有交錯(cuò)模型快,比較詫異。另外基于強(qiáng)化學(xué)習(xí)的adaptive對(duì)精度和速度幾乎沒(méi)有影響,而異步模式和模型量化提高系統(tǒng)的實(shí)時(shí)性。

圖5 Imagenet VID 2015測(cè)試結(jié)果

4 優(yōu)缺點(diǎn)分析

視頻處理策略

1、基于強(qiáng)化學(xué)習(xí)的交錯(cuò)模型調(diào)度是偽命題。論文的Slow network提取強(qiáng)特征,F(xiàn)astnetwork提取弱特征,交錯(cuò)模型的τ越大,模型性能越差。理論上τ=2時(shí)模型的準(zhǔn)確率越高。綜合考慮準(zhǔn)確率和實(shí)時(shí)性,論文中τ=9。

2、視頻具有很強(qiáng)的上下文相關(guān)性。視頻理解領(lǐng)域的目標(biāo)檢測(cè)、分割、識(shí)別,跟蹤,等領(lǐng)域,都需要提取前后幀的運(yùn)動(dòng)信息,而傳統(tǒng)采用光流方式,無(wú)法保證實(shí)時(shí)性。本文提出的分組ConvLSTM,可加速計(jì)算,量化模型保持準(zhǔn)確率,具有借鑒意義。

以上僅為個(gè)人閱讀論文后的理解、總結(jié)和思考。觀點(diǎn)難免偏差,望讀者以懷疑批判態(tài)度閱讀,歡迎交流指正。

參考文獻(xiàn)

[1] MasonLiu, Menglong Zhu, Marie White, Yinxiao Li, Dmitry Kalenichenko.Looking Fastand Slow: Memory-Guided Mobile Video Object Detection.arXivpreprint arXiv:1903.10172,2019.

[2] B.Jacob, S. Kligys, B. Chen, M. Zhu, M. Tang, A. Howard,H. Adam, and D.Kalenichenko. Quantization and training of neural networks for efficientinteger-arithmetic-only inference. In CVPR, 2018.

-

Google

+關(guān)注

關(guān)注

5文章

1762瀏覽量

57506 -

目標(biāo)檢測(cè)

+關(guān)注

關(guān)注

0文章

209瀏覽量

15605

原文標(biāo)題:Google又發(fā)大招:高效實(shí)時(shí)實(shí)現(xiàn)視頻目標(biāo)檢測(cè)

文章出處:【微信號(hào):IV_Technology,微信公眾號(hào):智車科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI模型部署邊緣設(shè)備的奇妙之旅:目標(biāo)檢測(cè)模型

案例分享 ▏基于HZ-EVM-RK3576開發(fā)板實(shí)現(xiàn)YOLOv5目標(biāo)檢測(cè)應(yīng)用

在樹莓派上部署YOLOv5進(jìn)行動(dòng)物目標(biāo)檢測(cè)的完整流程

使用OpenVINO C# API部署YOLO-World實(shí)現(xiàn)實(shí)時(shí)開放詞匯對(duì)象檢測(cè)

目標(biāo)檢測(cè)與圖像識(shí)別的區(qū)別在哪

目標(biāo)檢測(cè)與識(shí)別技術(shù)有哪些

目標(biāo)檢測(cè)與識(shí)別技術(shù)的關(guān)系是什么

目標(biāo)檢測(cè)識(shí)別主要應(yīng)用于哪些方面

基于深度學(xué)習(xí)的小目標(biāo)檢測(cè)

基于FPGA的實(shí)時(shí)邊緣檢測(cè)系統(tǒng)設(shè)計(jì),Sobel圖像邊緣檢測(cè),F(xiàn)PGA圖像處理

在控道AI盒子上基于YOLOv9實(shí)現(xiàn)實(shí)時(shí)目標(biāo)檢測(cè)實(shí)戰(zhàn)

OpenVINO工具包部署YOLO9模型實(shí)現(xiàn)實(shí)時(shí)目標(biāo)檢測(cè)

百度開源DETRs在實(shí)時(shí)目標(biāo)檢測(cè)中勝過(guò)YOLOs

AI驅(qū)動(dòng)的雷達(dá)目標(biāo)檢測(cè):前沿技術(shù)與實(shí)現(xiàn)策略

在ELF 1 開發(fā)板上實(shí)現(xiàn)讀取攝像頭視頻進(jìn)行目標(biāo)檢測(cè)

Google又放大招,高效實(shí)時(shí)實(shí)現(xiàn)視頻目標(biāo)檢測(cè)

Google又放大招,高效實(shí)時(shí)實(shí)現(xiàn)視頻目標(biāo)檢測(cè)

評(píng)論