2024年12月26日,DeepSeek-V3橫空出世,以其卓越性能備受矚目。該模型發布即支持昇騰,用戶可在昇騰硬件和MindIE推理引擎上實現高效推理,但在實際操作中,部署流程與常見問題困擾著不少開發者。

本文將為你詳細闡述昇騰DeepSeek模型部署的優秀實踐。

昇騰DeepSeek模型部署的常見問題及解決方案見:

DeepSeek在昇騰上的模型部署 - 常見問題及解決方案

https://modelers.cn/updates/zh/modelers/20250226-deepseek-bestpractice-acend-deploy-part2/

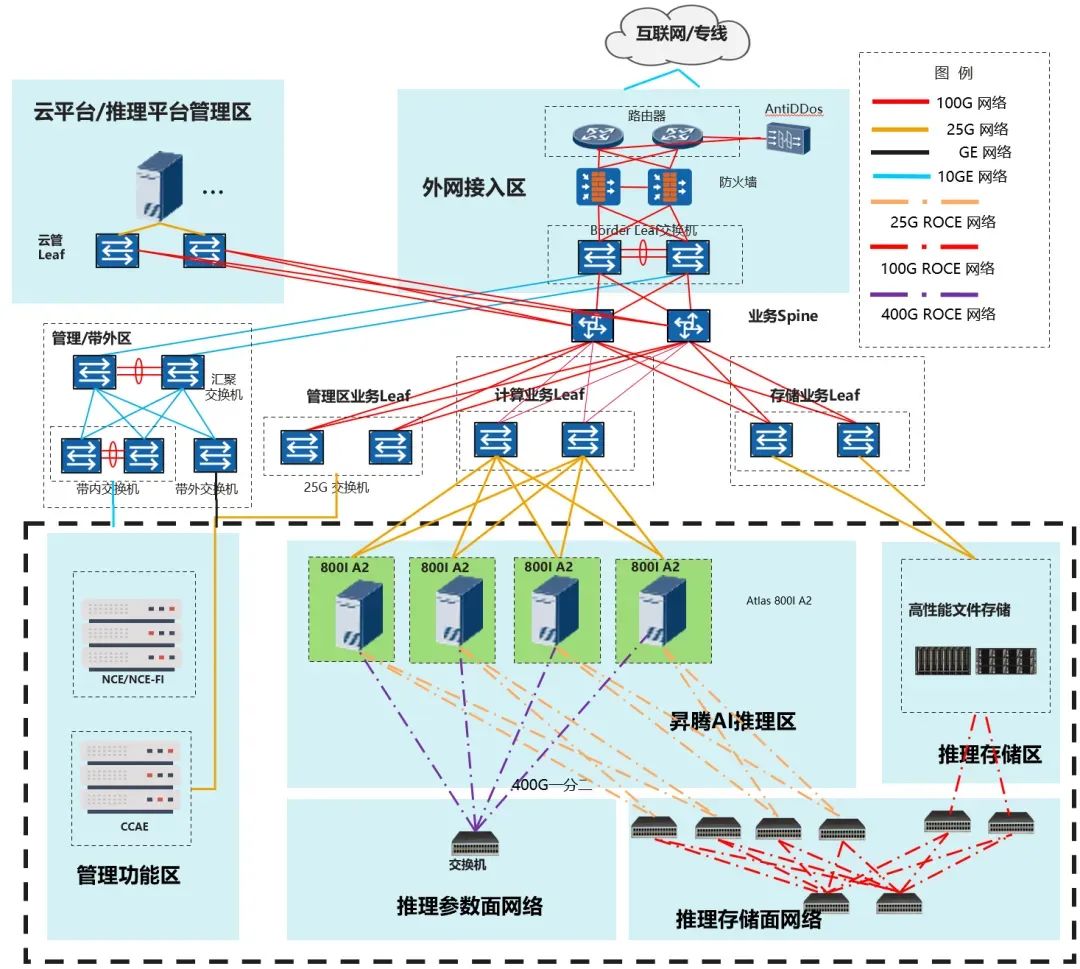

01 硬件要求及組網

推薦參考配置如下,部署DeepSeek-V3/R1量化模型至少需要多節點Atlas 800I A2(8*64G)服務器。

本方案以DeepSeek-R1為主進行介紹,DeepSeek-V3與R1的模型結構和參數量一致,部署方式與R1相同。

02 運行環境準備

推薦使用鏡像部署

1、鏡像部署

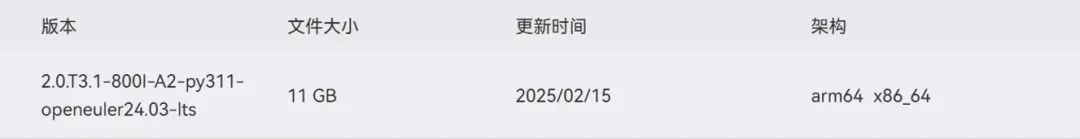

昇騰官方在Ascend hub提供環境示例鏡像,含推理部署配套軟件以及模型運行腳本,用戶可參考構建運行環境鏡像進行部署。

鏡像部署及啟動參照ModelZoo指南中“加載鏡像”章節,該指南中還包含“容器啟動”等指引:

https://gitee.com/ascend/ModelZoo-PyTorch/tree/master/MindIE/LLM/DeepSeek/DeepSeek-R1#加載鏡像

鏡像申請/下載(含于上述指南):

https://www.hiascend.com/developer/ascendhub/detail/af85b724a7e5469ebd7ea13c3439d48f

2、裸機部署

根據MindIE安裝指南安裝軟件包和運行依賴軟件。

安裝指南:

根據指南安裝全部軟件包和環境

https://www.hiascend.com/document/detail/zh/mindie/100/envdeployment/instg/mindie_instg_0001.html

模型獲取:

https://modelers.cn/models/MindIE/DeepSeek-R1

03 權重文件準備

BF16權重下載:https://modelers.cn/models/State_Cloud/DeepSeek-V3-BF16

INT8量化后權重下載:https://modelers.cn/models/State_Cloud/DeepSeek-R1-W8A8/tree/main

如已下載BF16模型,也可采用以下步驟進行模型量化,權重BF16->INT8轉換預計7~8小時。

Step1:安裝ModelSlim

git clone https://gitee.com/ascend/msit.git

cd msit/msmodelslim

bash install.sh

Step2: 運行量化命令

cd msit/msmodelslim/example/DeepSeek/

python3 quant_deepseek_w8a8.py

--model_path {浮點權重路徑}

--save_path {W8A8量化權重路徑}

更多詳細量化教程請參考 DeepSeek量化文檔 https://gitee.com/ascend/msit/tree/br_noncom_MindStudio_8.0.0_POC_20251231/msmodelslim/example/DeepSeek

Msmodelslim代碼倉 https://gitee.com/ascend/msit/tree/br_noncom_MindStudio_8.0.0_POC_20251231/msmodelslim

04 運行前檢查

服務器檢查:https://gitee.com/ascend/ModelZoo-PyTorch/tree/master/MindIE/LLM/DeepSeek/DeepSeek-R1#前置準備 軟件版本配套檢查,含:HDK、CANN、PTA、MindIE、MindStudio 1、檢查組網鏈接狀態 a)檢查物理鏈接for i in {0..7}; do hccn_tool -i $i -lldp -g | grep Ifname; done b)檢查鏈接情況for i in {0..7}; do hccn_tool -i $i -link -g ; done c)檢查網絡健康情況for i in {0..7}; do hccn_tool -i $i -net_health -g ; done d)查看偵測ip的配置是否正確for i in {0..7}; do hccn_tool -i $i -netdetect -g ; done e)查看網關是否配置正確for i in {0..7}; do hccn_tool -i $i -gateway -g ; done f)檢查NPU底層tls校驗行為一致性,建議全0for i in {0..7}; do hccn_tool -i $i -tls -g ; done | grep switch g)# NPU底層tls校驗行為置0操作for i in {0..7};do hccn_tool -i $i -tls -s enable 0;done

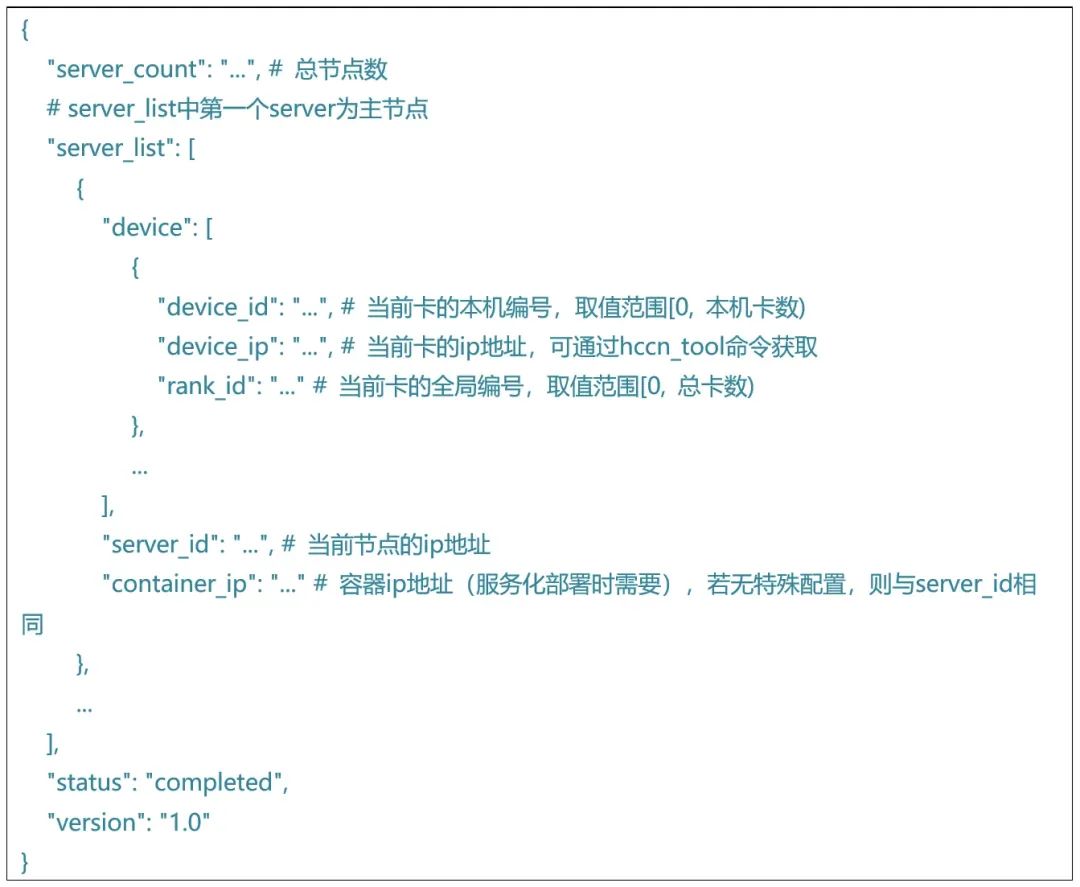

2、根據組網設置準備rank_table_file.json

使用多節點推理時,需要將包含設備ip,服務器ip等信息的json文件地址傳遞給底層通信算子。參考如下格式,配置rank_table_file.json:

05 模型部署與配置

獨立模型: https://modelers.cn/models/MindIE/DeepSeek-R1

服務化部署:

1、運行指南 https://modelers.cn/models/MindIE/DeepSeek-R1/blob/main/README.md(服務化測試)

2、服務啟動 https://www.hiascend.com/document/detail/zh/mindie/100/mindieservice/servicedev/mindie_service0004.html

3、接口指引 https://www.hiascend.com/document/detail/zh/mindie/100/mindieservice/servicedev/mindie_service0062.html

?

06 模型運行

??

?

1、純模型測試

模型腳本已預制在鏡像中,參照以下鏈接即可拉起精度測試及模型測試https://modelers.cn/models/MindIE/DeepSeek-R1/blob/main/README.md (純模型測試部分)

2、服務化測試

1. 運行指南 https://gitee.com/ascend/ModelZoo-PyTorch/tree/master/MindIE/LLM/DeepSeek/DeepSeek-R1#服務化測試

2. 服務啟動 https://www.hiascend.com/document/detail/zh/mindie/100/mindieservice/servicedev/mindie_service0004.html

3. 常用接口指引 https://www.hiascend.com/document/detail/zh/mindie/100/mindieservice/servicedev/mindie_service0062.html

-

昇騰

+關注

關注

1文章

150瀏覽量

6758 -

DeepSeek

+關注

關注

1文章

698瀏覽量

579

原文標題:DeepSeek在昇騰上的模型部署-優秀實踐

文章出處:【微信號:OSC開源社區,微信公眾號:OSC開源社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

RK3588開發板上部署DeepSeek-R1大模型的完整指南

【幸狐Omni3576邊緣計算套件試用體驗】DeepSeek 部署及測試

研華邊緣AI Box MIC-ATL3S部署Deepseek R1模型

華為推出昇騰DeepSeek大模型一體機

云軸科技ZStack智塔攜手昇騰AI實現DeepSeek模型部署

研華發布昇騰AI Box及Deepseek R1模型部署流程

中軟國際發布基于昇騰計算架構的“DeepSeek社保基金監管大模型一體機”解決方案

評論