上周,全志生態的小伙伴們成功在全志A733和T527的SoC平臺上實現了DeepSeek-R1-Distill-Qwen-1.5B模型的部署,充分驗證了高算力平臺在端側部署AI推理上的潛力。今天我們帶來一款全志新的視覺芯片V821,通過網絡接入的方式打通DeepSeek-R1滿血版模型和豆包視覺大模型,并展示其語言和視覺交互的能力和多樣性。

相較于大模型的端側部署,云端大模型對端側硬件算力、存儲資源等要求較低,以極佳的成本代價就可以體驗到模型最佳的性能表現,覆蓋更多的場景形態。本地設備將文字,語音,圖像等相關數據通過網絡上傳,憑借云端大模型對數據的分析和推理海量數據的分析和推理能力,并結合網絡搜索的信息,更好地,更加準確地,更加快速地做出判斷和反饋,大幅提升應答速度和輸出的準確率。

全志本次在V821平臺上基于豆包視覺大模型和DeepSeek語言大模型API實現了完整的大模型接入套件,讓V821具備了語言交互及圖像識別等豐富能力,讓開發者更容易實現大模型的應用,極大的方便了基于V821的智能產品的開發與拓展。

V821豆包視覺大模型實時采集圖像進行物品識別示例:

下面的視頻展示V821接入DeepSeek語言大模型,支持多輪對話+流式輸出功能:

通過以上的兩段演示可以發現,在有了接入套件所提供的便利后,云端部署的大模型的運行達到了“滿血”狀態,無論是物品識別還是多輪持續對話都有很快的輸出,確保在微型化設備算力資源受限的情況下,也能流暢自然地使用大模型,實現本地設備與云端AI結合。

V821是一顆高集成度的低功耗WiFi視覺SOC,集成了高性能ISP和H.264、JPEG編碼單元,同時內置了WiFi,因此可以很方便的接入AI視覺大模型,快速實現微型化、高清視頻、云端AI結合、低功耗一體化的視覺產品落地。

V821簡要規格如下:

通用算力:CPU RISC-V 1GHz + MCU RISC-V 600MHz

視頻輸入:1x2lane/2x1lane MIPI-CSI + 支持一路并口CSI

視頻引擎:支持H.264最大3072x3072;MJPEG最大8192x8192;支持雙目1920x1080@15fps + 640x480@15fps

WiFi(內置):WiFi4 單頻2.4GHz + 低功耗版本保活功耗180uA(DTIM10)

其他接口:支持一路音頻輸出/一路音頻輸入 + 3xSPI / 3xTWI / 4xUART / 12xPWM / 2xSDIO

全志推出的最新大模型套件,可以無縫切換各種主流大模型。各大模型官方提供的接入示例多是python、java等語言實現,而全志的套件使用純C語言實現,內存資源占用少,可方便應用在全志平臺Tina Linux系統和Tina RTOS系統上。目前,該套件已集成到V821 SDK中,會于2月底隨V821 SDK V1.1發出,屆時歡迎各位開發者升級體驗。

使用全志提供的大模型接入套件,只需要簡單的2個步驟即可接入豆包視覺大模型。

步驟1:調用lm_init函數進行初始化大模型

typedef struct {

const char *url;

const char *model;

const char *api_key;

} lm_config;

int lm_init(lm_config *config, lm_handle *handle);

初始化需要填充大模型的URL、模型、API key參數。參數的獲取可在各大模型官網進行注冊賬號后獲得,具體可參考各大模型官方的說明文檔,本文接入的是豆包視覺大模型,可參考以下鏈接獲取參數信息:

https://www.volcengine.com/docs/82379/1362931

步驟2:調用lm_generate函數訪問大模型。

typedef int (*lm_outputcallback)(char* token, void* user_data); typedef struct { char *content; prompt_image *img; } lm_prompt; int lm_generate(lm_handle handle, lm_prompt *prompt, lm_outputcallback cb, void *user_data);

prompt為輸入的提示詞,其帶有兩個參數,content表示輸入的文本,img為輸入的圖片數據;cb為用戶注冊的回調函數,當接收到云端大模型返回數據時會回調該函數將token信息輸出。

按照以上部署方式使用該套件到V821上,還可以支持DeepSeek的多輪對話和流式輸出。所謂“多輪對話”(Multi-turn Dialogue)是指大模型在與用戶交互時,能夠理解并記住對話歷史,并根據上下文信息持續生成符合邏輯的連貫回復的能力,而流式輸出是在云端大模型生成token回應時能夠實時輸出,支持多輪對話與流式輸出的能力使得對話不再是孤立的“一問一答”,而是更接近人類自然交流的連續互動。

全方位擁抱大模型生態,已成為多產品線全面革新的主旋律。AI大模型的普及為產品落地帶來了更多元的玩法,全志將針對各產品線不同應用場景的獨特需求,深度挖掘本地算力潛能,巧妙融合先進云端技術方案,為用戶帶來更智能便捷的交互體驗,提升工作效率,營造智慧生活,逐步推動AI從前沿科技走向大眾生活,用智能硬件助力AI惠民愿景的落地生根。

-

視覺芯片

+關注

關注

1文章

45瀏覽量

11560 -

全志

+關注

關注

24文章

256瀏覽量

53433 -

大模型

+關注

關注

2文章

2804瀏覽量

3455 -

DeepSeek

+關注

關注

1文章

638瀏覽量

437

原文標題:輕算力也能玩大模型,V821成功對接DeepSeek和豆包視覺大模型

文章出處:【微信號:gh_79acfa3aa3e3,微信公眾號:全志在線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

聆思CSK6大模型語音開發板接入DeepSeek資料匯總(包含深度求索/火山引擎/硅基流動華為昇騰滿血版)

機智云推出集成Deepseek和豆包大模型的AIoT開發平臺

惠倫晶體全面接入DeepSeek等大模型技術

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

【實測】用全志A733平板搭建一個端側Deepseek算力平臺

deepin UOS AI接入DeepSeek-R1模型

字節跳動發布豆包大模型1.5 Pro

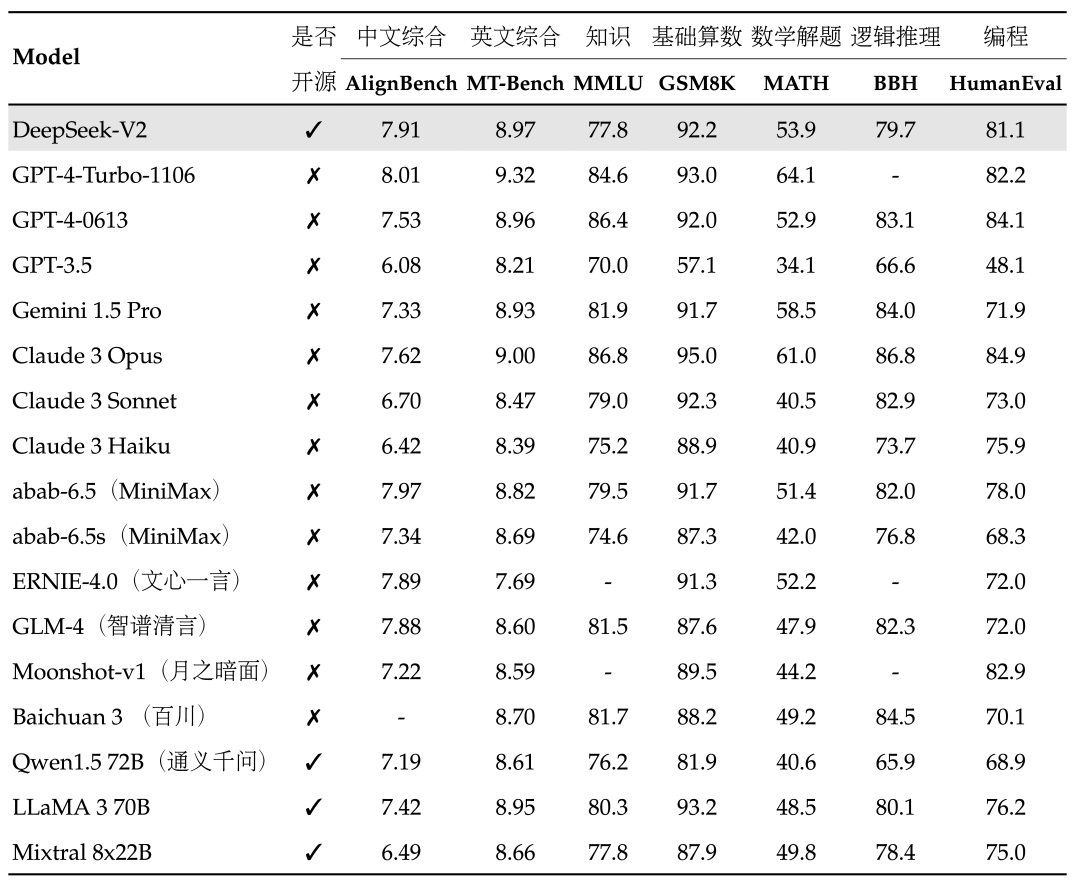

PerfXCloud順利接入MOE大模型DeepSeek-V2

評論