一、HBM 是什么?

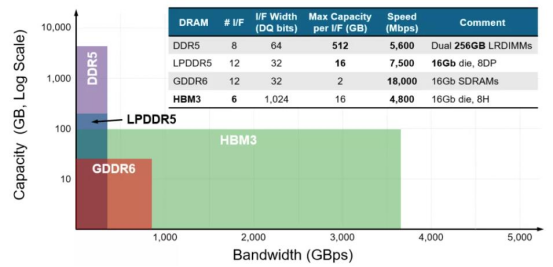

1、HBM 是 AI 時(shí)代的必需品作為行業(yè)主流存儲(chǔ)產(chǎn)品的動(dòng)態(tài)隨機(jī)存取存儲(chǔ)器 DRAM 針對(duì)不同的應(yīng)用領(lǐng)域定義了不同的產(chǎn) 品,幾個(gè)主要大類包括 LPDDR、DDR、GDDR 和 HBM 等,他們雖然均使用相同的 DRAM 存儲(chǔ)單 元(DRAM Die),但其組成架構(gòu)功能不同,導(dǎo)致對(duì)應(yīng)的性能不同。手機(jī)、汽車、消費(fèi)類等 對(duì)低功耗要求高主要使用 LPDDR,服務(wù)器和 PC 端等有高傳輸、高密度要求則使用 DDR,圖 形處理及高算力領(lǐng)域?qū)Ω咄掏铝俊⒏邘挕⒌凸牡染C合性要求極高則使用 GDDR 和 HBM。 HBM(High Bandwidth Memory),意為高帶寬存儲(chǔ)器,是一種面向需要極高吞吐量的數(shù)據(jù)密集型應(yīng)用程序的 DRAM,常被用于高性能計(jì)算、網(wǎng)絡(luò)交換及轉(zhuǎn)發(fā)設(shè)備等需要高存儲(chǔ)器帶寬的領(lǐng)域。那么 HBM 到底優(yōu)勢(shì)在哪呢?通過(guò) TSV 技術(shù),堆疊方案解決內(nèi)存墻的問(wèn)題。基于馮·諾依曼理論的傳統(tǒng)計(jì)算機(jī)系統(tǒng)架構(gòu)一直存在“內(nèi)存墻”的問(wèn)題。

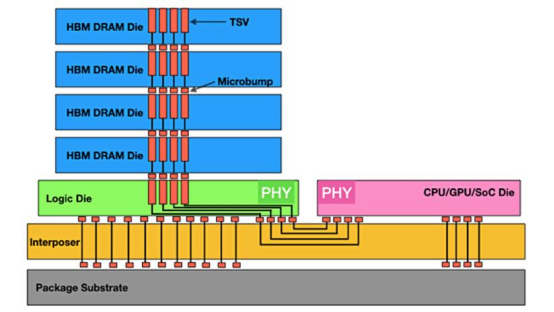

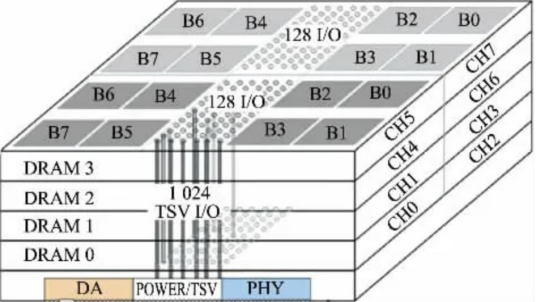

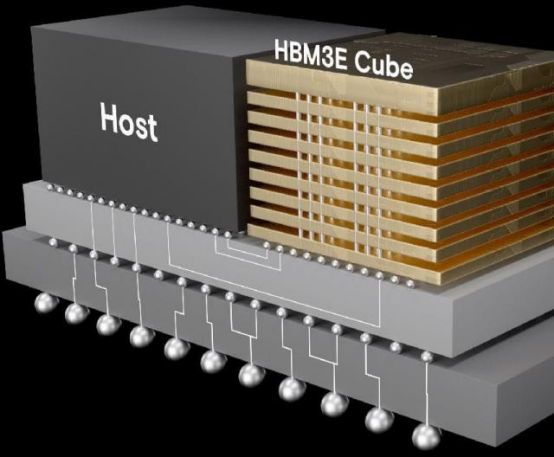

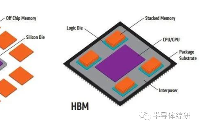

HBM 通過(guò)硅中介層和 TSV 來(lái)運(yùn)行

主要?dú)w因于:第一存儲(chǔ)與計(jì)算單元分離,存儲(chǔ)與處理器之間通過(guò)總線傳輸數(shù)據(jù),這容易導(dǎo)致存儲(chǔ)的帶寬計(jì)算單元的帶寬,從而導(dǎo)致 AI 算力升級(jí)較慢;

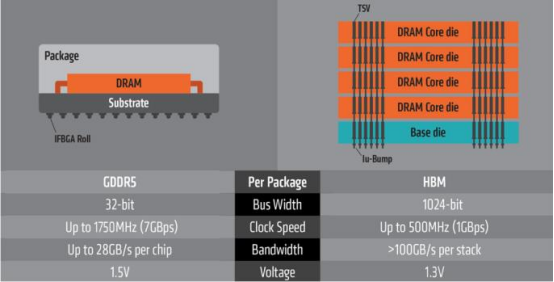

第二,是高功耗,在處理器和存儲(chǔ)之間頻繁傳輸數(shù)據(jù),會(huì)產(chǎn)生較多的能耗,也會(huì)使傳輸速率下降。相較于傳統(tǒng) GDDR,HBM 具有更高速,更低耗,更輕薄等諸多優(yōu)點(diǎn)。HBM 憑借獨(dú)特的 TSV 信號(hào)縱向連接技術(shù),其內(nèi)部將數(shù)個(gè) DRAM 芯片在緩沖芯片上進(jìn)行立體 堆疊,其內(nèi)部堆疊的 DDR 層數(shù)可達(dá) 4 層、8 層以至 12 層,從而形成大容量、高位寬的 DDR 組合陣列。

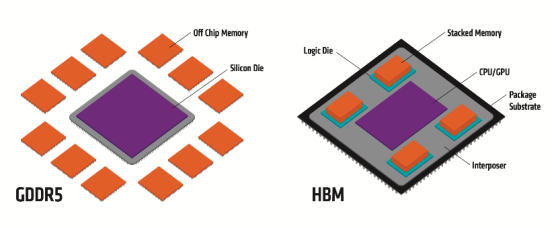

GDDR 與 HBM 結(jié)構(gòu)分布

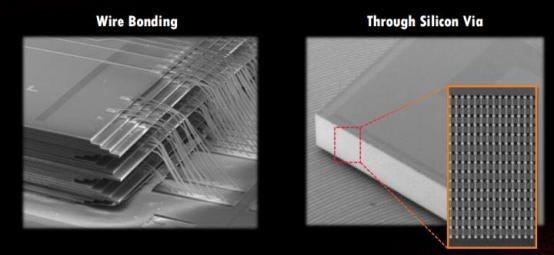

TSV 是在 DRAM 芯片上搭上數(shù)千個(gè)細(xì)微孔并通過(guò)垂直貫通的電極連接上下芯片的技術(shù)。該技術(shù)在緩沖芯片上將數(shù)個(gè) DRAM 芯片堆疊起來(lái),并通過(guò)貫通所有芯片層的柱狀 通道傳輸信號(hào)、指令、電流。相較傳統(tǒng)封裝方式,該技術(shù)能夠縮減 30%體積,并降低 50% 能耗。

憑借 TSV 方式,HBM 大幅提高了容量和位寬(I/O 數(shù)量)。與傳統(tǒng)內(nèi)存技術(shù)相比,HBM 具有更高帶寬、更多 I/O 數(shù)量、更低功耗、更小尺寸等特征。

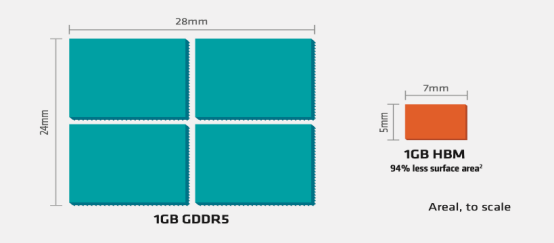

具體來(lái)看:(1)存儲(chǔ)帶寬問(wèn)題:由于存儲(chǔ)的制成與封裝工藝與 CPU 的制成封裝工藝不同,CPU 使用的是 SRAM 寄存器,速度快,雙穩(wěn)態(tài)電路,而存儲(chǔ)器使用的是 DRAM 寄存器,速度慢,單穩(wěn)態(tài)電路。這樣的工藝不同拉大了兩者間的差距,在過(guò)去 20 年內(nèi),CPU 的峰值計(jì)算能力增加了 90000 倍,內(nèi)存/硬件互存寬帶卻只是提高了 30 倍。存儲(chǔ)的帶寬通過(guò)總線一直限制著計(jì)算單位的帶寬,最新型的 GDDR6 單顆帶寬上限在 96GB/s,而最新型的單棧HBM3E 帶寬上限近 1.2TB/s,在 AI 應(yīng)用中,每個(gè) SoC 的帶寬需求都會(huì)超過(guò)幾 TB/s,上百倍的數(shù)據(jù)傳輸差距使得傳統(tǒng) DRAM 遠(yuǎn)不能滿足 AI 訓(xùn)練所需的算力缺口。(2)傳輸效能問(wèn)題:由于分離距離問(wèn)題,數(shù)據(jù)存算間(I/O)會(huì)有很大的延誤,一步數(shù)據(jù)計(jì)算過(guò)后的大部分時(shí)間都在讀取內(nèi)存,查詢所用的大量時(shí)間與吞吐量影響用戶體驗(yàn),數(shù)據(jù)傳輸能量消耗占總數(shù)據(jù)存算的 60-90%,嚴(yán)重浪費(fèi)效能。(3)占用空間問(wèn)題:傳統(tǒng) GDDR 由于是 2D 平面分布,占用空間大,無(wú)法滿足目前消費(fèi)電子輕量化與便攜化的需求。

傳統(tǒng)打線與 TSV 穿孔區(qū)別

GDDR 與 HBM 占用空間對(duì)比

HBM 包括多層 DRAM 芯片和一層基本邏輯芯片,不同 DRAM 以及邏輯芯片之間用 TSV 與微凸 塊技術(shù)實(shí)現(xiàn)通道連接,每個(gè) HBM 芯片可與多達(dá) 8 條通道與外部連接,每個(gè)通道可單獨(dú)訪問(wèn) 1 組 DRAM 陣列,通道間訪存相互獨(dú)立。邏輯芯片可以控制 DRAM 芯片,并提供與處理器芯 片連接的接口,主要包括測(cè)試邏輯模塊與物理層(PHY)接口模塊,其中 PHY 接口通過(guò)中 間介質(zhì)層與處理器直接連通,直接存取(DA)端口提供 HBM 中多層 DRAM 芯片的測(cè)試通道。

中間介質(zhì)層通過(guò)微凸塊連接到封裝基板,從而形成 SiP 系統(tǒng)。

HBM 架構(gòu)詳解

HBM3 在 NVIDIA Hopper 架構(gòu)的應(yīng)用AI 時(shí)代存力的首選自 ChatGPT 爆火之后,國(guó)內(nèi)外大廠爭(zhēng)相競(jìng)逐 AI 大模型。而 AI 大模型的基礎(chǔ),就是靠海量 數(shù)據(jù)和強(qiáng)大算力來(lái)支撐訓(xùn)練和推理過(guò)程。其中一些模型有 1000 億字節(jié)的數(shù)據(jù),參數(shù)量越 大,AI 模型越智能,以 GPT-4 模型為例有近 1.76 萬(wàn)億參數(shù)量。

對(duì)于每次重新訓(xùn)練的迭代, 都必須從數(shù)據(jù)中心背板的磁盤上取出 1000 億字節(jié)的數(shù)據(jù)并進(jìn)入計(jì)算盒,在為期兩個(gè)月的訓(xùn)練中,必須來(lái)回調(diào)取數(shù)百萬(wàn)次如此龐大的數(shù)據(jù)。如果能縮短數(shù)據(jù)存取,就會(huì)大大簡(jiǎn)化訓(xùn) 練過(guò)程。但在過(guò)去 20 年中,存儲(chǔ)和計(jì)算并沒(méi)有同步發(fā)展,硬件的峰值計(jì)算能力增加了 90000 倍,而內(nèi)存/硬件互連帶寬卻只是提高了 30 倍。

當(dāng)存儲(chǔ)的性能跟不上處理器,對(duì)指令和數(shù) 據(jù)的搬運(yùn)(寫入和讀出)的時(shí)間將是處理器運(yùn)算所消耗時(shí)間的幾十倍乃至幾百倍,這就要 打破“內(nèi)存墻”。此時(shí),高帶寬內(nèi)存 HBM 應(yīng)運(yùn)而生,被認(rèn)為是 AI 計(jì)算的首選內(nèi)存。

GDDR 與 HBM 性能對(duì)比

不同內(nèi)存類型之間 DRAM 容量和帶寬的差異 HBM 解決了傳統(tǒng) GDDR 遇到的“內(nèi)存墻”問(wèn)題,采用了存算一體的近存計(jì)算架構(gòu),不通過(guò)外部連線的方式與 GPU/CPU/Soc 連接,而是通過(guò)中間介質(zhì)層緊湊快速地連接信號(hào)處理器芯片,極大的節(jié)省了數(shù)據(jù)傳輸所使用的時(shí)間與耗能。 而在空間占用上,HBM 采用的堆 棧技術(shù)會(huì)使得在空間占用要比同比傳統(tǒng) GDDR 節(jié)省 94%。在應(yīng)對(duì)目前云端 AI 的多用戶, 高吞吐,低延遲,高密度部署需求所帶來(lái)的計(jì)算單位需求,I/O 數(shù)量也需要不斷突破滿足 計(jì)算單位的需求。使用 GDDR 所適配的 PCB 技術(shù)并不能突破 I/O 數(shù)量瓶頸,而 HBM 的 TSV 技術(shù)帶來(lái)的存儲(chǔ)器集成度極大提升,使得帶寬不再受制于芯片引腳的互聯(lián)數(shù)量,在一定程度上解決了 I/O 瓶頸,成為高算力芯片的首選。

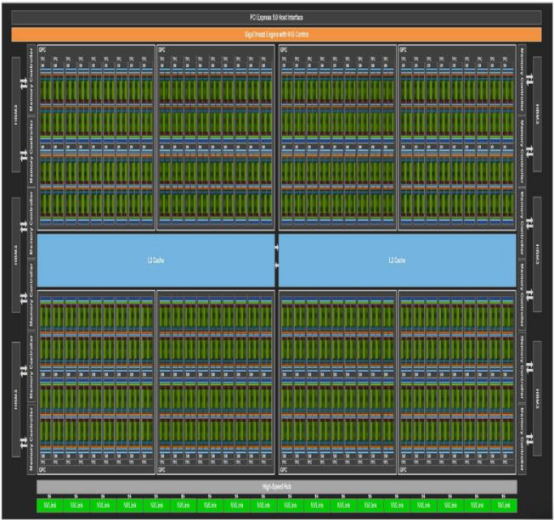

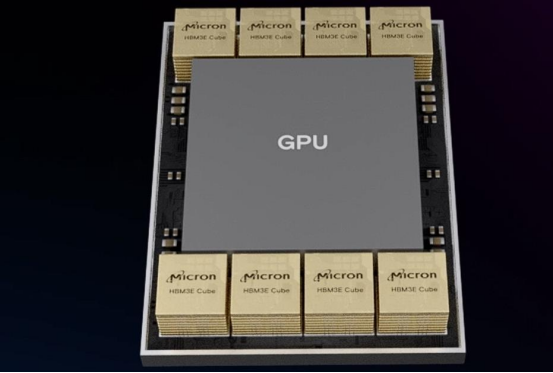

HBM 在 GPU 中搭配

HBM 與 GPU 集成在一起2 NVIDIA 和 AMD 依靠 HBM 持續(xù)提升 GPU 性能HBM 新型存儲(chǔ)器較傳統(tǒng) GDDR 具有更高的帶寬,更低的延遲和更好的等效比。隨著 AI 對(duì)算 力的高要求,高帶寬內(nèi)存顯然是高性能 GPU 的最佳搭配,AMD 和 NVIDIA 兩家尖端的 GPU 都陸續(xù)配備了 HBM。

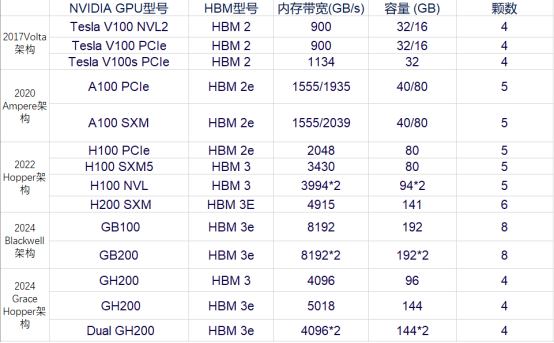

NVIDIA 不同 GPU 型號(hào)搭載 HBM 情況

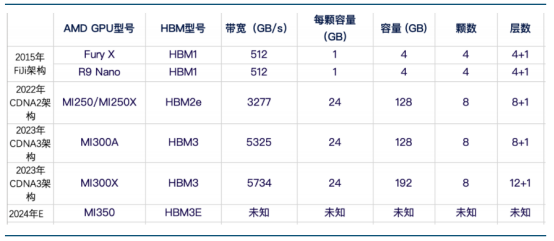

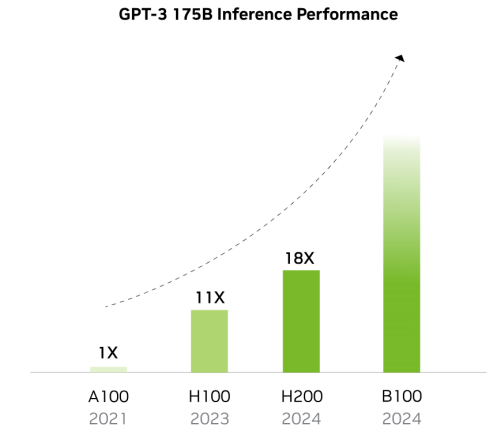

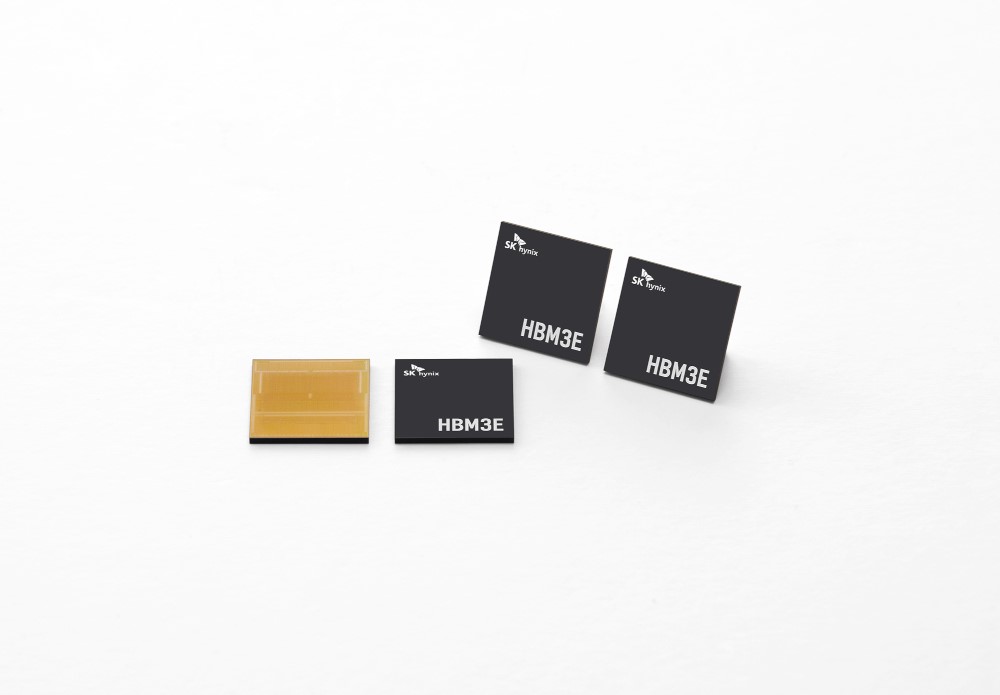

AMD 不同 GPU 型號(hào)搭載 HBM 情況 NVIDIA 已在搭載 HBM 的 GPU 型號(hào)上迭代 5 次,性能也在不斷跟進(jìn)以適配 AI 模型與訓(xùn)練的 需求。在 7 年時(shí)間內(nèi),從 V100 架構(gòu)時(shí)代搭載的 HBM2 已經(jīng)演化到了 GB200 的 HBM3E,而內(nèi) 存寬帶與容量則是在這幾年內(nèi)翻了數(shù)倍。

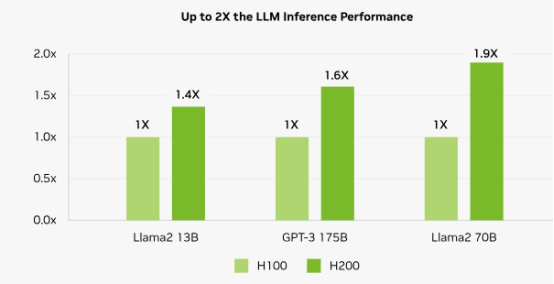

以同一 Hopper 架構(gòu)下的 H100 SXM 和 H200 SXM 為例,在其他硬件條件與接口協(xié)議相同的情況下,搭載了 HBM3E 的 H200 SXM 要比搭載了 HBM3 的 H100 SXM 在帶寬速率上提升了 43%,在容量上也是擴(kuò)增了 76%。而對(duì)比落后了一 整代,搭載了 HBM 2E 的 A100 SXM,帶寬速率更是提高了 141%,所有的這一切提升都是 HBM 性能迭代帶來(lái)的優(yōu)勢(shì)。

隨著搭載 HBM 容量提升 GPU 效能倍數(shù)提升

H200 較 H100 在大模型領(lǐng)域性能提升情況 歸因于 AI 大模型的逐步迭代,GPU 迭代速度加快。核心供應(yīng)商 NVIDIA 和 AMD 新品性能競(jìng) 爭(zhēng),預(yù)計(jì) 2025 年加速 HBM 規(guī)格需求大幅轉(zhuǎn)向 HBM3e,且將會(huì)有更多 12hi 的產(chǎn)品出現(xiàn),帶 動(dòng)單芯片搭載 HBM 的容量提升。根據(jù) TrendForce 集邦咨詢預(yù)估,2024 年的 HBM 需求位元 年成長(zhǎng)率近 200%,2025 年可望將再翻倍。

-

DRAM

+關(guān)注

關(guān)注

40文章

2316瀏覽量

183589 -

存儲(chǔ)

+關(guān)注

關(guān)注

13文章

4323瀏覽量

85927 -

HBM

+關(guān)注

關(guān)注

0文章

381瀏覽量

14774

原文標(biāo)題:AI時(shí)代核心存力 HBM(上)

文章出處:【微信號(hào):閃德半導(dǎo)體,微信公眾號(hào):閃德半導(dǎo)體】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI算力需求的暴增,HBM和GDDR SDRAM成為AI芯片新的內(nèi)存方案

HBM搶單大戰(zhàn),才剛剛拉開帷幕

被稱為“小號(hào)HBM”,華邦電子CUBE進(jìn)階邊緣AI存儲(chǔ)

大模型時(shí)代的算力需求

【AD新聞】AI時(shí)代,一美元能夠買到多強(qiáng)的算力?

AI的核心是什么?

嵌入式系統(tǒng)的核心競(jìng)爭(zhēng)力是什么

英偉達(dá)全球首發(fā)HBM3e 專為生成式AI時(shí)代打造

全面分析服務(wù)器/AI計(jì)算的算力框架

算力需求催生存力風(fēng)口,HBM競(jìng)爭(zhēng)從先進(jìn)封裝開始

大算力芯片里的HBM,你了解多少?

大模型時(shí)代必備存儲(chǔ)之HBM進(jìn)入汽車領(lǐng)域

中國(guó)AI芯片和HBM市場(chǎng)的未來(lái)

億鑄科技熊大鵬探討AI大算力芯片的挑戰(zhàn)與解決策略

AI時(shí)代核心存力HBM(中)

AI時(shí)代核心存力HBM(上)

AI時(shí)代核心存力HBM(上)

評(píng)論