轉載自:量子位(QbitAI)

惡劣天氣下,自動駕駛汽車也能準確識別周圍物體了?!

西安電子科大、上海AI Lab等提出多模態融合檢測算法E2E-MFD,將圖像融合和目標檢測整合到一個單階段、端到端框架中,簡化訓練的同時,提升目標解析性能。

相關論文已入選頂會NeurlPS 2024 Oral,代碼、模型均已開源。

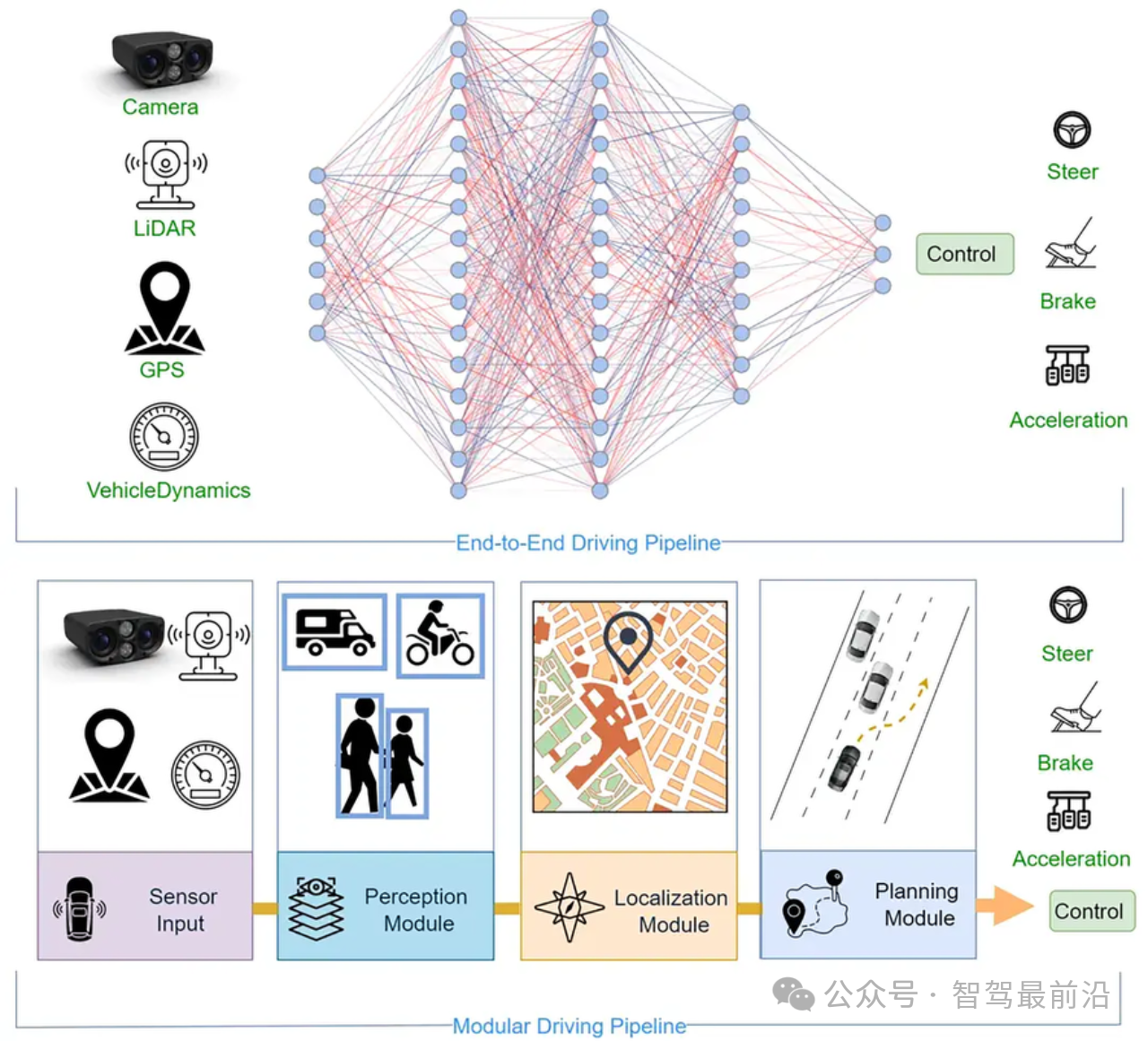

其中圖像融合是指,把不同來源(比如可見光和紅外相機)的圖像合并成一張,這樣就能在一張圖像中同時看到不同相機捕捉到的信息;目標檢測即找出并識別圖像中的物體。

端到端意味著,E2E-MFD算法可以一次性處理這兩個任務,簡化訓練過程。

而且,通過一種特殊的梯度矩陣任務對齊(GMTA)技術,這兩個任務還能互幫互助,互相優化。

最終實驗結果顯示,E2E-MFD在信息傳遞、圖像質量、訓練時間和目標檢測方面均優于現有方法。

E2E-MFD:多模態融合檢測端到端算法

眾所周知,精確可靠的目標解析在自動駕駛和遙感監測等領域至關重要。

僅依賴可見光傳感器可能會導致在惡劣天氣等復雜環境中的目標識別不準確。

可見光-紅外圖像融合作為一種典型的多模態融合(MF)任務,通過利用不同模態的信息互補來解決這些挑戰,從而促進了多種多模態圖像融合技術的快速發展。

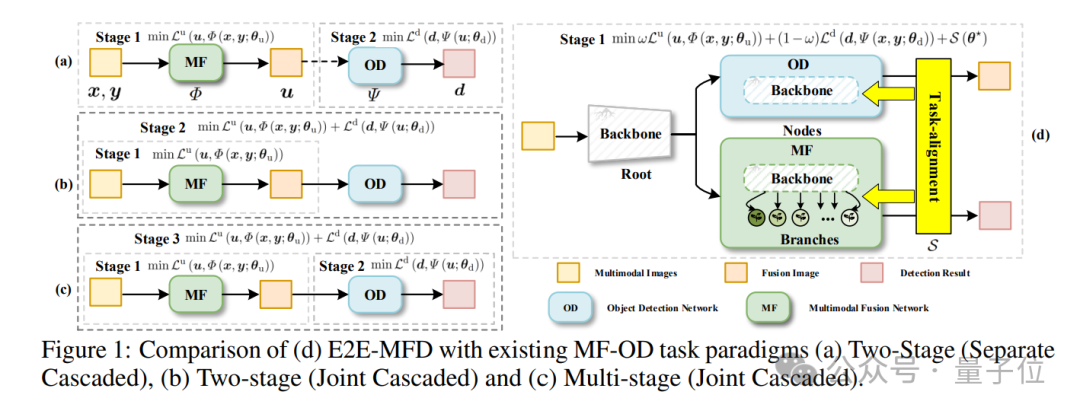

諸如CDDFuse和DIDFuse方法采用兩步流程:

首先訓練多模態融合網絡(MF),然后再訓練目標檢測(OD)網絡,用來分別評估融合效果。

盡管深度神經網絡在學習跨模態表征能力上取得了顯著進展,并帶來了多模態融合的良好結果,但大多數研究主要集中在生成視覺上吸引人的圖像,而往往忽略了改進下游高級視覺任務的能力,如增強的目標解析。

最近的研究開始設計聯合學習方法,將融合網絡與目標檢測和圖像分割等高級任務結合在一起。

其中,多模態融合檢測(MFD)方法中MF與OD的協同已成為一個活躍的研究領域。

這種協同作用使得MF能夠生成更豐富、更有信息量的圖像,從而提升OD的性能,而OD則為MF提供了有價值的目標語義信息,從而準確地定位和識別場景中的物體。

通常,MFD網絡采用一種級聯設計,其中聯合優化技術使用OD網絡來引導MF網絡創建便于目標檢測的圖像。

但是依舊存在以下問題:

1)當前的優化方法依賴于多步驟、漸進的聯合方法,影響訓練效率;

2)這些方法過于依賴目標檢測(OD)信息來增強融合,導致參數平衡困難并易于陷入單個任務的局部最優解。

因此,尋求一個統一的特征集,同時滿足每個任務的需求,仍然是一項艱巨的任務。

為此,研究提出了一種名為E2E-MFD的端到端多模態融合檢測算法。

(1)這是一種高效同步聯合學習的方法,將圖像融合和目標檢測創新性地整合到一個單階段、端到端的框架中,這種方法顯著提升了這兩項任務的成果。

(2)引入了一種新的GMTA技術,用于評估和量化圖像融合與目標檢測任務的影響,幫助優化訓練過程的穩定性,并確保收斂到最佳的融合檢測權重配置。

(3)通過對圖像融合和目標檢測的全面實驗驗證,展示了所提出方法的有效性和穩健性。在水平目標檢測數據集M3FD和有向目標檢測數據集DroneVehicle上與最先進的融合檢測算法相比,E2E-MFD表現出強大的競爭力。

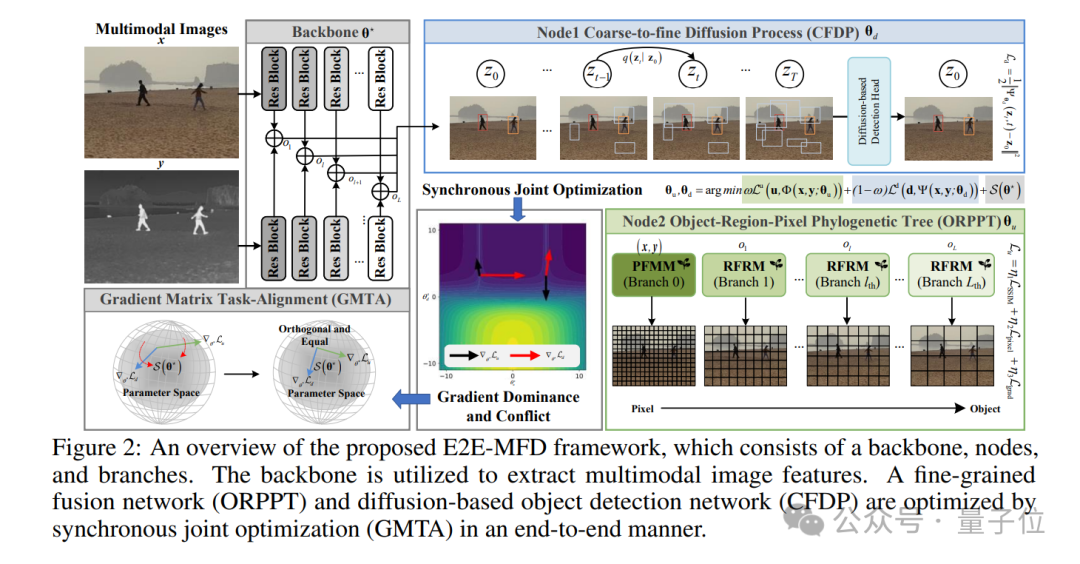

其整體架構如下:

展開來說,E2E-MFD通過同步聯合優化,促進來自兩個領域的內在特征的交互,從而實現簡化的單階段處理。

為了協調細粒度的細節與語義信息,又提出了一種全新的對象-區域-像素系統發育樹(ORPPT)概念,并結合粗到細擴散處理(CFDP)機制。

該方法受視覺感知自然過程的啟發,專為滿足多模態融合(MF)和目標檢測(OD)的具體需求而設計。

此外,研究引入了梯度矩陣任務對齊(GMTA)技術,以微調共享組件的優化,減少傳統優化過程中固有的挑戰。

這確保了融合檢測權重的最優收斂,增強了多模態融合檢測任務的準確性和有效性。

實驗

實驗細節

E2E-MFD在多個常用數據集(TNO、RoadScene、M3FD 和 DroneVehicle)上進行了實驗,實驗運行在一張 GeForce RTX 3090 GPU上。

模型基于PyTorch框架實現,部分代碼在M3FD數據集上使用了Detectron2框架,并通過預訓練的DiffusionDet初始化目標檢測網絡。

優化器采用AdamW,批量大小為1,學習率設為2.5×10??,權重衰減為1e-4。

模型共訓練了15,000次迭代。

在DroneVehicle數據集上,實驗基于MMRotate 0.3.4框架,使用預訓練的LSKNet模型進行初始化,并通過12個 epoch的微調進行優化,批量大小為4。

實驗結果

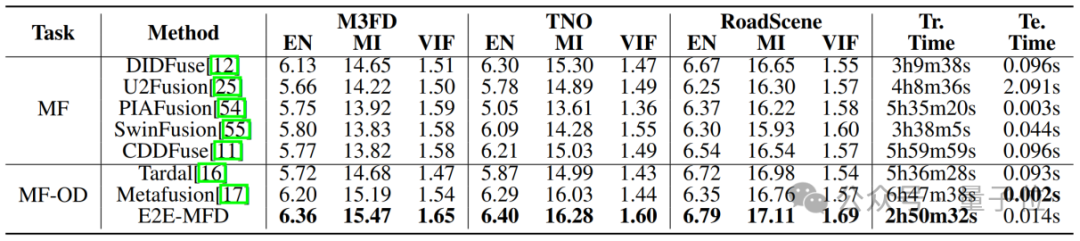

研究提供了不同融合方法在TNO、RoadScene和M3FD數據集上的定量結果。

模型的訓練(Tr.)和測試(Te.)時間均在NVIDIA GeForce RTX 3090上統計。

可以看出,E2E-MFD在MI指標上普遍獲得了最佳度量值,表明其在信息傳遞方面比其他方法從兩個源圖像中提取了更多有用的信息。

EN值進一步顯示,E2E-MFD能夠生成包含清晰邊緣細節且對象與背景對比度最高的圖像。

較高的VIF值則表明,E2E-MFD的融合結果不僅具有高質量的視覺效果,同時在失真度方面較低。

此外,該方法的訓練時間最快,表明在新的數據集上能夠實現更快速的迭代更新。

生成融合圖像的測試時間在所有方法中排名第三。

定性結果如下圖所示,所有融合方法均在一定程度上融合了紅外和可見光圖像的主要特征,但E2E-MFD具備兩個顯著優勢。

首先,它能夠有效突出紅外圖像的顯著特征,例如在M3FD數據集中,E2E-MFD捕捉到了騎摩托車的人員。

與其他方法相比,E2E-MFD展示了更高的物體對比度和識別能力。

其次,它保留了可見圖像中的豐富細節,包括顏色和紋理。

在M3FD數據集中,E2E-MFD的優勢尤為明顯,比如能夠清晰顯示白色汽車的后部以及騎摩托車的人。

E2E-MFD在保留大量細節的同時,保持了圖像的高分辨率,并且沒有引入模糊現象。而其他方法則未能同時實現這些優勢。

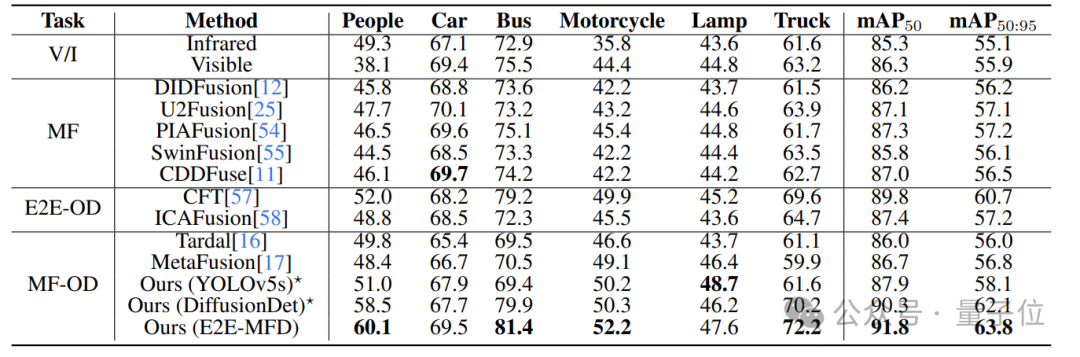

為了更有效地評估融合圖像對下游檢測任務的影響,研究在M3FD數據集上使用了YOLOv5s檢測器對所有SOTA方法進行了測試,結果如表所示。

與單模態檢測相比,SOTA方法在融合圖像上的表現明顯提升,表明良好融合的圖像能夠有效地支持下游檢測任務。

E2E-MFD生成的融合圖像在YOLOv5s檢測器上表現最佳,同時在DiffusionDet檢測器上也取得了出色的成績。

即使與端到端目標檢測方法(E2E-OD)相比,E2E-MFD的方法仍顯示出了顯著的性能提升,充分證明了其訓練范式和方法的有效性。

檢測結果的可視化如下圖所示。

當僅使用單模態圖像作為輸入時,檢測結果較差,常常漏檢諸如摩托車和騎手等目標,尤其是在圖像右側靠近汽車和行人的區域。

幾乎所有的融合方法都通過融合兩種模態的信息,減少了漏檢現象并提升了檢測的置信度。

通過設計端到端的融合檢測同步優化策略,E2E-MFD生成了在視覺上和檢測上都非常友好的融合圖像,尤其在處理遮擋和重疊的目標時表現出色,比如圖像右側藍色橢圓中的摩托車和重疊的行人。

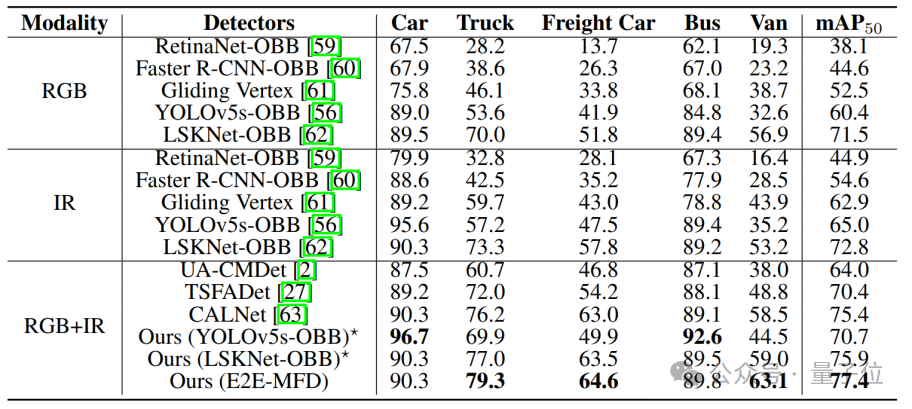

在DroneVehicle數據集上的目標檢測定量結果多模態如表所示,E2E-MFD達到了最高的精度。

此外,使用生成的融合圖像在YOLOv5s-OBB和LSKNet上進行檢測時,較單一模態至少提高了5.7%和3.1%的AP值,驗證了方法的魯棒性。

這證明了融合圖像的優異質量,表明它們不僅在視覺上令人滿意,還為檢測任務提供了豐富的信息。

小結

研究提出了多模態融合檢測算法E2E-MFD,僅以單步訓練過程同時完成融合和檢測任務。

引入了一個系統發育樹結構和粗到細擴散處理機制,來模擬在不同任務需求下,不同視覺感知中需要完成的這兩項任務。

此外,研究對融合檢測聯合優化系統中的任務梯度進行了對齊,消除聯合優化過程中兩個任務的梯度優化沖突。

通過將模型展開到一個設計良好的融合網絡和檢測網絡,可以以高效的方式生成融合與目標檢測的視覺友好結果,而無需繁瑣的訓練步驟和固有的優化障礙。

-

算法

+關注

關注

23文章

4626瀏覽量

93161 -

目標檢測

+關注

關注

0文章

211瀏覽量

15643 -

自動駕駛

+關注

關注

784文章

13915瀏覽量

166773

原文標題:NeurlPS 2024 Oral | 多模態融合檢測端到端算法E2E-MFD來了!

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

堅果Pro PK 魅藍E2,誰能制霸中端機市場

物聯網轉向E2E解決方案

羅德與施瓦茨成功驗證10Gbps端到端(E2E)峰值下行鏈路IP數據吞吐量

端到端的無人機導航模擬演示

Autosar E2E介紹及其實現

端到端InfiniBand網絡解決LLM訓練瓶頸

端到端讓智駕強者愈強時代來臨?

黑芝麻智能端到端算法參考模型公布

端到端在自動泊車的應用

詳解E2E-MFD多模態融合檢測端到端算法

詳解E2E-MFD多模態融合檢測端到端算法

評論