隨著在線視頻數(shù)量的爆炸式增長,想從茫茫網(wǎng)絡世界中找到自己想要的視頻可是要費一番功夫。于是有人就想到,何不也給視頻創(chuàng)作一份摘要呢?就像書的簡介一樣,觀眾只需要看看摘要,就了解視頻的大概內(nèi)容了。

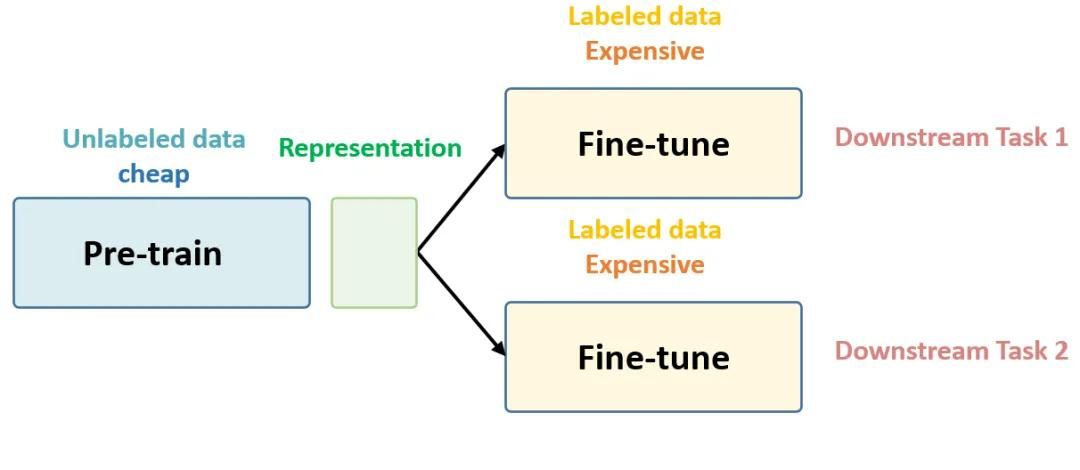

這的確是個好方法,不過面對如此龐大的視頻庫,如何大批量處理它們呢?在此之前,許多研究者提出了不同的方法為視頻大規(guī)模創(chuàng)建摘要,例如循環(huán)神經(jīng)網(wǎng)絡(RNN)、長短期記憶(LSTM)、雙向長短期記憶網(wǎng)絡(bidirectional LSTM)和行列式點處理(DPP)模塊結(jié)合的方式等等。但都是需要監(jiān)督的總結(jié)方式,其中并沒有一個針對所有視頻的標準答案(ground truth)。所以仍然需要無監(jiān)督的摘要生成方式。

中科院和英國倫敦大學瑪麗女王學院的研究人員就生成視頻摘要提出了一種新方法,采用無監(jiān)督學習的方法,用深度摘要網(wǎng)絡(Deep Summarization Network,DSN)總結(jié)視頻。整個過程為連續(xù)決策過程(sequential decision-making process),DSN為編碼-解碼結(jié)構(gòu),其中編碼器是一個能夠提取視頻幀特征的卷積神經(jīng)網(wǎng)絡,解碼器是一個雙向LSTM網(wǎng)絡,能夠基于被選中的動作生成概率。在訓練過程中,研究人員設計了新穎的多樣性-代表性獎勵(diversity-representativeness reward)函數(shù),可以直接判斷生成視頻摘要的多樣化和代表化。下圖是該模型學習過程的圖示:

深度摘要網(wǎng)絡(DSN)

DSN的編碼器是一個卷積神經(jīng)網(wǎng)絡,它從輸入的長度為T的視頻框架{vt}t=1T中提取視覺特征{xt}t=1T。解碼器是一個雙向循環(huán)神經(jīng)網(wǎng)絡(BiRNN),最上面是完全連接層。將提取的{xt}t=1T輸入到解碼器后,生成相應的隱藏狀態(tài){ht}t=1T。每個ht都是前隱藏狀態(tài)htf和后隱藏狀態(tài)htb的連接。在實踐中,研究人員采用GoogLeNet當做CNN模型,并且用LSTM訓練提升RNN的性能。

多樣性-代表性獎勵函數(shù)

在訓練時,DSN會接收到一個獎勵R(S),來評估生成的摘要。而DSN的目標是不斷生成高質(zhì)量的視頻摘要,讓獎勵最大化。通常,高質(zhì)量的視頻摘要必須既有代表性,又豐富多彩。為了達到這一目的,研究人員提出了一種新穎的獎勵方式,它由多樣性獎勵Rdiv和代表性獎勵Rrep組成。

在多樣性獎勵中,Rdiv可以用以下公式表示:

y表示已選中的幀,d(xt,xt')是多樣化公式,如下表示:

選出的視頻幀越多樣(越不相像),agent收到的多樣性獎勵越高。

而代表性獎勵函數(shù)主要是測量生成的摘要是否能總結(jié)原始視頻,研究人員將其看成k中心點問題,將Rrep定義為:

在這個獎勵之下,agent能夠選出最接近特征空間聚類中心的幀。

最后,Rdiv和Rrep共同工作,指導DSN學習:

R(S)=Rdiv+Rrep

實驗測試

該模型在SumMe和TVSum兩個數(shù)據(jù)集上進行測試。SumMe有25個用戶視頻,涵蓋了假期和運動等多種話題。其中的視頻長度約為1至6分鐘,都經(jīng)過了15至18人進行標注,所以每段視頻都有多個標準摘要(ground truth)。TVSum中有50段視頻,包括新聞、紀錄片等,長度2到10分鐘不等,每段都有20人標注。除此之外還有另外兩個數(shù)據(jù)集,OVP和YouTube,用來測試強化后的模型。

在進行比較時,研究人員分了好幾種情況進行對比:只用多樣性獎勵函數(shù)進行訓練(用D-DSN表示)、只用代表性獎勵函數(shù)進行訓練(用R-DSN表示)、兩種函數(shù)都有的(用DR-DSN表示)。另外,還將模型擴展到監(jiān)督學習的實驗中,用DR-DSNsup表示。在SumMe和TVSum上不同版本的結(jié)果如下表所示:

可以看到,DR-DSN的結(jié)果明顯優(yōu)于D-DSN和R-DSN,同時與DSNsup相比,DR-DSN的結(jié)果也非常出色。

接著,研究人員將DR-DSN與其他無監(jiān)督方法進行比較,可以看到,DR-DSN在兩個數(shù)據(jù)集上比其它方法表現(xiàn)得都好,并且差距非常明顯。如下圖所示:

另外,在與其他監(jiān)督式方法的比較中,DR-DSNsup也是完勝:

這些結(jié)果有力地證明了DSN框架的有效性。

質(zhì)量評估

研究人員挑選了一段一個男人自制辣香腸三明治的視頻作為質(zhì)量評估的素材。

上圖中可以看到,四種方法都生成了高質(zhì)量的視頻摘要,它們都均勻選取了視頻的每一過程。不過最接近完整故事線的是DR-DSNsup,因為它展示了從準備食材到制作的全過程。

接著研究人員對原始預測(raw prediction)進行可視化,通過比較預測和原視頻,我們可以更深入地了解DSN學習的情況。

可以看到,無監(jiān)督模型預測的重要性曲線與監(jiān)督模型預測的有幾處相似,并且這些地方與之前人們標注認為重要的地方相吻合。這充分表明,通過多樣性-代表性獎勵函數(shù)訓練過的強化學習能很好地模仿人類學習過程,并有效地教DSN認出視頻中重要的幀。

-

視頻

+關(guān)注

關(guān)注

6文章

1966瀏覽量

73474 -

DSN

+關(guān)注

關(guān)注

0文章

8瀏覽量

4740 -

無監(jiān)督學習

+關(guān)注

關(guān)注

1文章

16瀏覽量

2796

原文標題:DSN:基于深度強化學習,無監(jiān)督生成視頻摘要

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

深非監(jiān)督學習-Hierarchical clustering 層次聚類python的實現(xiàn)

如何用卷積神經(jīng)網(wǎng)絡方法去解決機器監(jiān)督學習下面的分類問題?

利用機器學習來捕捉內(nèi)部漏洞的工具運用無監(jiān)督學習方法可發(fā)現(xiàn)入侵者

你想要的機器學習課程筆記在這:主要討論監(jiān)督學習和無監(jiān)督學習

如何用Python進行無監(jiān)督學習

機器學習算法中有監(jiān)督和無監(jiān)督學習的區(qū)別

最基礎(chǔ)的半監(jiān)督學習

半監(jiān)督學習最基礎(chǔ)的3個概念

為什么半監(jiān)督學習是機器學習的未來?

半監(jiān)督學習:比監(jiān)督學習做的更好

分析總結(jié)基于深度神經(jīng)網(wǎng)絡的圖像語義分割方法

機器學習中的無監(jiān)督學習應用在哪些領(lǐng)域

評論