★AI,人工智能;大數據;L40S;H100;H800;A100;A800;Gaudi 2;Gaudi 3;MI250X;MI300;L40;Ascend 910;美光;DRAM;DUV;芯片禁令;數據湖;數據倉庫;通用大模型;行業大模型;CV大模型;多模態大模型;臺積電;TSMC

在當今時代,人工智能技術正以前所未有的速度發展,推動著各個領域的創新與變革。作為人工智能技術的核心引擎之一,高性能GPU扮演著至關重要的角色。在這個領域,英偉達的H100無疑是一款備受矚目的高端產品。它針對高性能計算和人工智能應用而設計,具備強大的計算能力和高內存容量,以及先進的互連技術,可以有效提升集群中的計算效率,加速深度學習、計算機視覺、自然語言處理等領域的AI訓練和推理任務。

然而,最近美國政府宣布的對半導體制造和人工智能技術的限制措施,特別是針對中國的嚴格限制,給中國半導體產業和人工智能技術的應用帶來了重大影響。為了應對這些限制,中國需要采取一系列對策,包括加強自主研發、推動產業升級、拓展市場空間等。

藍海大腦大模型訓練平臺是一款基于高性能計算技術的AI訓練平臺,幫助用戶快速構建和訓練大型AI模型。該平臺采用先進的計算和存儲技術,提供高達數十TB的內存容量和數千個計算核心,顯著提高訓練效率。此外,還提供豐富的工具和庫,以幫助用戶更好地管理和優化訓練過程。

英偉達顯卡是如何制造?

英偉達H100是一款針對高性能計算和人工智能應用的高端GPU產品,具有強大的計算能力和高內存容量,以及先進的互連技術,可以提升集群中的計算效率,加速深度學習、計算機視覺、自然語言處理等領域的AI訓練和推理等計算密集型任務。

H100采用全新的Hopper架構,擁有高達800億個晶體管,相比上一代A100,其SM數量從108個提升到132個,帶來2倍的性能增益。每個SM配備128個FP32 CUDA Core,并配備第四代Tensor Core,相比于A100的稠密或稀疏運算的原始性能提升2倍。內存容量高達40GB,支持第四代NVIDIA NVLink和PCIe 5.0,具備更高的數據傳輸帶寬和更快的計算速度,可以實現快速的GPU到GPU通信,提升大型模型的訓練速度。相比上一代A100,H100的FP8算力提升4倍,高達4000TFlops(每秒4000萬億次)。

那么H100是如何制造的呢?讓我們一起探究H100顯卡的制造過程和它如何成為全球熱門的商品。

一、H100顯卡的基本構成

H100顯卡主要由四個部分組成:邏輯芯片、HBM儲存芯片、供電模塊和散熱模塊。

邏輯芯片是H100顯卡的核心部分。814平方毫米,比一個眼鏡片略小。主要負責處理圖形運算和計算任務。這個小小的芯片集成了數十億個晶體管,是現代科技的結晶。

圍繞著邏輯芯片的是六塊HBM儲存芯片(由韓國廠商SK海力士獨家提供),每塊儲存芯片的大小跟指甲蓋差不多,共同為顯卡提供大量的存儲空間和數據傳輸速度。

除此之外,供電模塊和散熱模塊也是H100顯卡不可或缺的部分。高效的供電模塊能夠確保顯卡在運行時擁有穩定的電力供應,而強大的散熱模塊則能夠確保顯卡在長時間高負荷運行時不會過熱,從而保持良好的性能。

二、H100顯卡是如何被制造的?

H100顯卡的核心部分是邏輯芯片,由英偉達位于美國加利福尼亞州圣克拉拉的總部設計和制造。這座科技感十足的大樓占地約125萬平方英尺,造價高達9.2億美元。在這里,平均年薪20萬美元的軟硬件工程師負責設計英偉達的所有GPU,從Tesla到Hopper架構,從V100到H100。

在完成核心邏輯芯片的設計和制造后,英偉達將接力棒交給位于臺灣的臺積電。臺積電是全球最大的半導體制造公司之一,負責制造H100的核心邏輯芯片。臺積電的制造工藝非常先進,采用5nm制程工藝,由位于臺南科學園區北園二路的臺積電18號工廠生產。

臺積電使用CoWoS技術將一顆核心邏輯芯片和六顆HBM芯片編成一組,然后將它們封裝到一張12寸的硅片上。這個過程非常復雜,需要高超的工藝技巧和精密的操作。

臺積電將封裝好的一大六小的芯片交給另一家公司富士康,由富士康把外圍的電路和芯片裝好后,一塊價值堪比等重量黃金的H100板卡就出爐了。根據上面的流程,我們可以計算一下H100的純物料成本:核心邏輯芯片200美元,HBM內存芯片1500美元,CoWoS封裝700美元,其他物料大概500美元,加起來大概在3000美元左右。現在一張H100官方售價是35000美元,黑市上一度可以賣到5萬美金,加價十幾倍,毛利率超過了90%。

三、H100顯卡為何如此受歡迎?

英偉達憑借其精湛的技術和卓越的制造能力,成為全球領先的芯片制造商之一。H100顯卡是英偉達最先進的顯卡之一,同時也是目前市場上最熱門的顯卡之一。其高昂的價格和稀缺性使得其成為一種硬通貨。

在2023年8月3日,美國初創公司Coreweave宣布了一項令人矚目的融資,他們通過抵押手中的H100顯卡向華爾街獲得了23億美元的債務融資。Coreweave這家公司,自2017年由三位大宗商品交易員創立以來,便在挖礦領域表現出色,后轉型為自建數據中心,為客戶提供算力服務。他們與英偉達建立了深厚的合作關系,并能夠獲取H100的供貨。

令人矚目的是,居然可以用H100這種本質上是電子產品的抵押物來借到資金,這無疑凸顯了H100的硬通貨屬性。不止如此,Coreweave之前通過股權融資累計融到5.8億美元。然而,他們的賬上不可能有價值23億美金的H100顯卡來做抵押。但華爾街敢于放貸的原因在于他們手上有英偉達的H100承諾供貨合同,憑借此合同便能從銀行套出巨額貸款,不禁讓人聯想到當年通過拿地合同就能套出銀行資金的房地產開發商。

從貨幣經濟學的角度來看,H100不僅具備硬通貨屬性,還具備貨幣創造屬性。英偉達通過扶持像Coreweave這樣的GPU云服務商,通過供貨合同讓他們從銀行套取資金,進而購買更多的H100顯卡,鎖定未來的顯卡需求量。這種模式已經超越傳統硬件公司的商業模式,馬克思曾言:“貨幣天然不是H100,但H100天然是貨幣”,一款科技硬件竟能達到如此高度,可以說是前無古人,后無來者。

在AI財富的分配中,黃仁勛獨占八斗。英偉達的巨大財富無人能撼動。唯一可能讓黃仁勛感到憂慮的地方是一個客戶需求眾多、愿意花錢,但由于種種原因,H100無法進入的市場。這個市場在哪里呢?

解讀人工智能和半導體制造

最新限制及中國對策

10月17日,美國推出新一輪針對21世紀中美技術冷戰的舉措,主要集中在限制對中國芯片和芯片制造設備的出口。下面主要來談談這些舉措的影響,包括美國具體設置哪些出口管制措施,中國又采取哪些應對手段來化解這些限制。

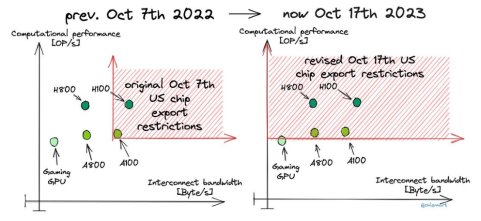

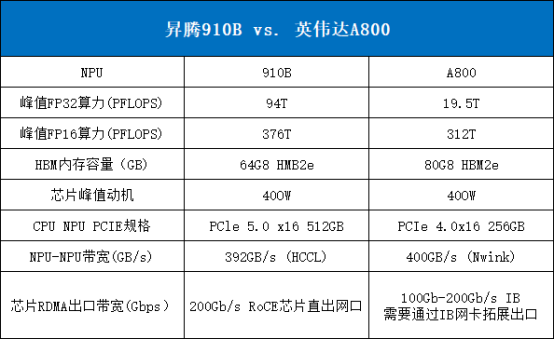

一、AI半導體限制

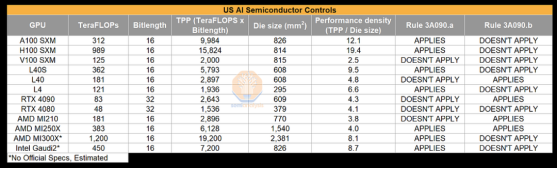

美國最近針對中國的人工智能芯片出口管制措施已經相當嚴格,充分填補之前政策可能存在的漏洞。此前的測試顯示,當前人工智能芯片的聚合雙向傳輸速率可以達到600GB/s,聚合運算吞吐量超過4800TOPs。這意味著芯片公司可以通過稍微降低芯片的雙向帶寬來規避管制,而實際應用于人工智能任務時,性能下降幾乎可以忽略。例如英偉達在其H100和A100芯片基礎上進行改進后的H800和A800系列芯片,就采用這種方式設計(已經大量出口到中國,單臺出貨量達到數十萬顆)。

Lennart Heim

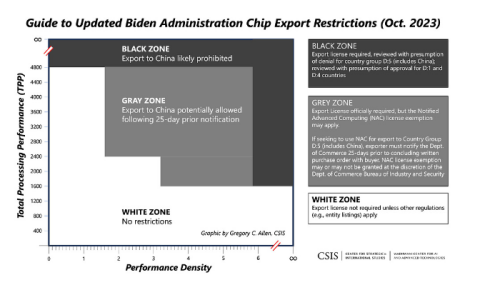

填補先前政策中的漏洞意味著需要完全取消對芯片雙向帶寬的限制,直接影響像A800、H800這樣的芯片發揮最大效能,也意味著英特爾的Gaudi 2、Gaudi 3、以及AMD的MI250X、MI300等芯片都會被管制禁止出口。在運算吞吐量達到4800TOPs時,人工智能計算需求大致保持不變,這被稱為“總處理性能”(TPP)。

盡管對芯片總體性能的限制非常重要,但政府意識到這仍然存在多個漏洞。例如,可以很容易設計出單個芯片性能低于閾值,但當大量芯片在高帶寬互聯時,整體系統輕松超過性能閾值。

因此,新增一個性能密度(TPP除以芯片面積)閾值的限制,防止芯片面積較小、絕對計算能力較低但計算密度、效率仍高的芯片出口。絕對限制性能密度為5.92,允許的密度為3.2。并設置多級的性能密度控制級別。

CSIS

對GPU芯片施加的嚴格限制新規完全出乎市場和芯片廠商(如英偉達)的意料。諸如L40S之類的芯片被完全禁止,這些芯片原本利用買家只關注頂級規格的心理。幾個月前的預測顯示,CPO、HBM和英偉達的部分芯片將在第四季度被禁止。令人驚訝的是,限制還包括L4GPU。對于4090、L40和AMD MI210等GPU,設置一個較低的標準需要申請許可證。據觀察,4090有可能獲得許可。

此外,新規定要求FP8 matmul+ FP16達到320 TFLOPS的累積浮點運算量已經超過RTX 4080的限制標準,因此需要申請許可證。根據密度規則,英偉達需要回退到2017年基于12nm工藝的V100芯片。不能靠填充一堆空白硅片來規避密度規則,因為法規對此有規定。它從根本上禁止了人們目前正在開發的所有高性能ASIC,這意味著大型Transformer模型無法在任何法規允許的硬件上高效運行。

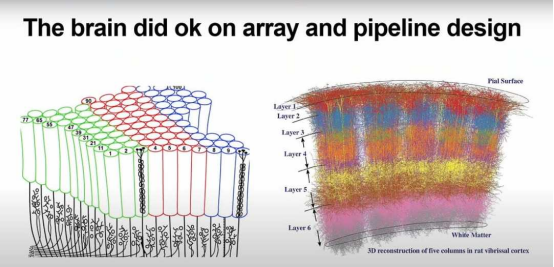

業界已經適應在現有芯片上運行人工智能技術,如英偉達GPU和谷歌TPU。然而,隨著對華制裁的實施,一個有趣的結果可能是中國將探索不同于世界其他國家的人工智能技術思路。畢竟,大腦和其中傳遞的信號也與當前的硬件/軟件架構不同。

Jim Keller – TensTorrent, interesting talk he gave, even if we don’t agree with the premise

中國將加強對內存計算、神經形態計算等模擬計算方法的投資。盡管這些方法在Transformer或擴散模型上尚未取得突破,但新的模型架構仍值得期待。短期內,華為將發揮關鍵作用。華為已在中芯國際的N+2工藝節點上推出一款7nm的ASIC芯片,該芯片繼承2019年發布的Ascend 910。據傳,這款芯片采用分散的小芯片配備HBM存儲。

華為的Ascend 910已經超出當前規定的范圍,因此國產后續產品也將超越英偉達合法進入中國的任何產品。盡管有人認為中芯國際不具備相應能力,但其14nm工藝已經用于百億億級超級計算機的制造。新的N+2工藝(7nm)產能接近每月20,000片,足以在50%產量下用于數百萬個AI加速器。此外,中國正在迅速獲得國內生產HBM的能力。

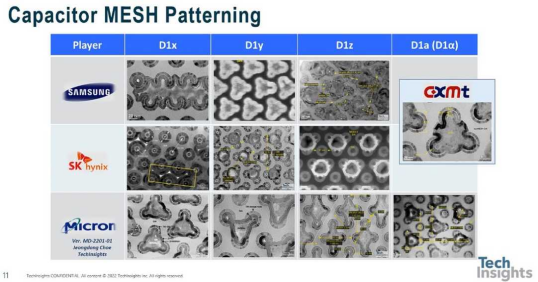

二、晶圓制造設備控制

美國對半導體設備出口管制的調整對人工智能芯片的影響相對較小。盡管在某些方面加強管制,但仍存在一些漏洞,使得應用材料、藍富利、東京電子、國際集成電路、KLA、安拓、Screen、ASML等設備供應商能夠繼續向中國出口數百億美元的設備,其中包括超過70億美元的DRAM制造設備將運往長江存儲。這一數字甚至超過了總部在美國的美光公司在同一制程技術上的投入。長江存儲顯然也在開發被美國視為受限制的技術。

美光D1 Beta是最密集的出貨DRAM,它采用DUV SAQP。CXMT在他們的路線圖上有D1 Beta

美國的新規定進一步將限制擴大到2.4納米及以下的覆蓋層工具,這影響到ASML用于臺積電、英特爾和中芯國際7納米工藝的1980-i系列機型。美國通過不設最小含量要求的方式,將這些工具的卡盤覆蓋層限制在1.5納米到2.4納米之間。這意味著如果工具中含有任何美國內容,都將受到限制。通常美國內容的標準是25%,但在這種情況下,只要有任何美國內容就受限。即使ASML試圖重新設計工具,也需要多年時間才能擺脫與覆蓋、光源相關的美國技術。此規定僅適用于用于“開發”或“生產”“先進節點集成電路”的情況。

三、僅適用于“高級”晶圓廠

這些限制主要針對“先進晶圓廠”,存在漏洞,因為大多數晶圓廠不會被歸類為“先進”。因此,晶圓廠可以先表面上建成“成熟”工藝的車間,然后轉變為“先進晶圓廠”,如長江存儲。這意味著ASML最新型的TWINSCAN NXT:1980Di和Fi系列浸沒式***等仍可以出貨給成熟工藝的客戶。此外,像中芯國際這樣的公司可以在SN1和SN2以外的所有晶圓廠接收這些工具,用于7nm制造。未來兩年內,中國應當能夠實現這些工具的國內維修。除針對“先進晶圓廠”的限制外,一些關鍵技術如混合鍵合、封裝光學器件、TSV形成和DRAM制造仍處于開放狀態。

四、規則協調

許多新規定與荷蘭和日本的關鍵制造設備出口管制相配合。使得美國的出口管制與這些規定保持一致,同時也擴大了對符合最低要求的美國公司或產品的覆蓋范圍。荷蘭開始管制覆蓋層小于1.5納米和多重曝光的***,而美國規定將覆蓋層擴大到2.4納米。荷蘭法規還控制其他生產設備,如EUV薄膜和制膜設備、ALD工具;日本的管制措施針對與日本企業相關的工具,如光刻膠/顯影劑、掩模檢查、蝕刻機、沉積設備、外延生長、清洗工具以及***。美國的新限制已與日本規則保持一致。

藍海大腦大模型訓練平臺

藍海大腦大模型訓練平臺提供強大的算力支持,包括基于開放加速模組高速互聯的AI加速器。配置高速內存且支持全互聯拓撲,滿足大模型訓練中張量并行的通信需求。支持高性能I/O擴展,同時可以擴展至萬卡AI集群,滿足大模型流水線和數據并行的通信需求。強大的液冷系統熱插拔及智能電源管理技術,當BMC收到PSU故障或錯誤警告(如斷電、電涌,過熱),自動強制系統的CPU進入ULFM(超低頻模式,以實現最低功耗)。致力于通過“低碳節能”為客戶提供環保綠色的高性能計算解決方案。主要應用于深度學習、學術教育、生物醫藥、地球勘探、氣象海洋、超算中心、AI及大數據等領域。

在最底層,構建基于英偉達GPU的全場景AI基礎設施方案,適用于“端、邊、云”等各種應用環境。幫助開發者更快速、更高效地構建和部署AI應用。

一、為什么需要大模型?

1、模型效果更優

大模型在各場景上的效果均優于普通模型。

2、創造能力更強

大模型能夠進行內容生成(AIGC),助力內容規模化生產。

3、靈活定制場景

通過舉例子的方式,定制大模型海量的應用場景。

4、標注數據更少

通過學習少量行業數據,大模型就能夠應對特定業務場景的需求。

二、平臺特點

1、異構計算資源調度

一種基于通用服務器和專用硬件的綜合解決方案,用于調度和管理多種異構計算資源,包括CPU、GPU等。通過強大的虛擬化管理功能,能夠輕松部署底層計算資源,并高效運行各種模型。同時充分發揮不同異構資源的硬件加速能力,以加快模型的運行速度和生成速度。

2、穩定可靠的數據存儲

支持多存儲類型協議,包括塊、文件和對象存儲服務。將存儲資源池化實現模型和生成數據的自由流通,提高數據的利用率。同時采用多副本、多級故障域和故障自恢復等數據保護機制,確保模型和數據的安全穩定運行。

3、高性能分布式網絡

提供算力資源的網絡和存儲,并通過分布式網絡機制進行轉發,透傳物理網絡性能,顯著提高模型算力的效率和性能。

4、全方位安全保障

在模型托管方面,采用嚴格的權限管理機制,確保模型倉庫的安全性。在數據存儲方面,提供私有化部署和數據磁盤加密等措施,保證數據的安全可控性。同時,在模型分發和運行過程中,提供全面的賬號認證和日志審計功能,全方位保障模型和數據的安全性。

三、常用配置

1、CPU:

Intel Xeon Gold 8358P 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8350C 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8458P 28C/56T 2.7GHz 38.5MB,DDR4 2933,Turbo,HT 205W

Intel Xeon Platinum 8468 Processor 48C/64T 2.1GHz 105M Cache 350W

AMD EPYC? 7742 64C/128T,2.25GHz to 3.4GHz,256MB,DDR4 3200MT/s,225W

AMD EPYC? 9654 96C/192T,2.4GHz to 3.55GHz to 3.7GHz,384MB,DDR5 4800MT/s,360W

2、GPU:

NVIDIA L40S GPU 48GB

NVIDIA NVLink-A100-SXM640GB

NVIDIA HGX A800 80GB

NVIDIA Tesla H800 80GB HBM2

NVIDIA A800-80GB-400Wx8-NvlinkSW×8

審核編輯 黃宇

-

gpu

+關注

關注

28文章

4767瀏覽量

129202 -

顯卡

+關注

關注

16文章

2447瀏覽量

67983 -

英偉達

+關注

關注

22文章

3836瀏覽量

91654 -

大模型

+關注

關注

2文章

2529瀏覽量

2999 -

H100

+關注

關注

0文章

31瀏覽量

297

發布評論請先 登錄

相關推薦

挑戰英偉達:聚焦本土GPU領軍企業崛起

探秘英偉達顯卡的制造之路 | 英偉達斷供GPU,中國大模型何去何從?

探秘英偉達顯卡的制造之路 | 英偉達斷供GPU,中國大模型何去何從?

評論