GPU | COMPUTEX| 算力| GPU服務(wù)器

英偉達(dá) | GH200| 一體化算力算網(wǎng)調(diào)度平臺(tái)

近年來(lái),人工智能硬件、軟件算法以及應(yīng)用場(chǎng)景的豐富度不斷增加,算法模型參數(shù)也不斷增加,這帶動(dòng)了對(duì)數(shù)據(jù)中心并行計(jì)算算力的需求。因此,AI、高性能計(jì)算、圖形渲染、大模型訓(xùn)練、AIGC、ChatGPT等推動(dòng)GPU大算力并行計(jì)算芯片的需求。

2023年6月5日,由工業(yè)和信息化部主辦,中國(guó)信息通信研究院(以下簡(jiǎn)稱(chēng)“中國(guó)信通院”)等承辦的“算力創(chuàng)新發(fā)展高峰論壇”在京順利召開(kāi)。工業(yè)和信息化部信息通信發(fā)展司副司長(zhǎng)趙策,中國(guó)信通院副院長(zhǎng)王志勤等領(lǐng)導(dǎo)出席會(huì)議并致辭。會(huì)上,中國(guó)信通院聯(lián)合中國(guó)電信共同發(fā)布我國(guó)首個(gè)實(shí)現(xiàn)多元異構(gòu)算力調(diào)度的全國(guó)性平臺(tái)——“全國(guó)一體化算力算網(wǎng)調(diào)度平臺(tái)(1.0版)”

該平臺(tái)匯聚通用算力、智能算力、高性能算力、邊緣算力等多元算力資源,針對(duì)通用、智算、超算等不同客戶的不同需求,設(shè)計(jì)異構(gòu)資源池調(diào)度引擎,實(shí)現(xiàn)不同廠商的異構(gòu)資源池的算力動(dòng)態(tài)感知與作業(yè)智能分發(fā)調(diào)度。特別在AI訓(xùn)練作業(yè)調(diào)度流程中,作業(yè)可在智算資源池上進(jìn)行訓(xùn)練推理,在通用算力資源池部署,從而實(shí)現(xiàn)跨資源池/跨架構(gòu)/跨廠商的異構(gòu)算力資源調(diào)度,目前已接入天翼云、華為云、阿里云等。

算力是 AI 芯片底層土壤,未來(lái)算力需求將呈爆發(fā)式增長(zhǎng)。根據(jù) IDC 數(shù)據(jù),未來(lái) 5 年我國(guó)智能算力規(guī)模 CAGR 將達(dá) 52.3%。AI 芯片中,GPU 占據(jù)主要市場(chǎng)規(guī)模。根據(jù) IDC 數(shù)據(jù),2022 年國(guó)內(nèi)人工智能芯片市場(chǎng)中,GPU 芯片所占市場(chǎng)份額達(dá) 89.0%。

研發(fā)實(shí)力是一家芯片設(shè)計(jì)公司的核心競(jìng)爭(zhēng)力,英偉達(dá)從發(fā)展初期就重視研發(fā)生產(chǎn)力,以高投入換取高回報(bào)不斷提升產(chǎn)品競(jìng)爭(zhēng)力。2005 年,AMD 的研發(fā)費(fèi)用為 11 億美元,是英偉達(dá)的 3.2 倍左右。而到了 2022 年,英偉達(dá)的研發(fā)費(fèi)用達(dá)到 73.4 億美元,是 AMD 的 1.47 倍。

國(guó)產(chǎn)廠商加速布局,看好 AI 發(fā)展推動(dòng)國(guó)產(chǎn)替代進(jìn)程提速。在 ChatGPT 等概念影響下, AIGC 關(guān)注度火熱。未來(lái) AI 應(yīng)用的落地離不開(kāi)龐大算力的支撐,也將推動(dòng)算力產(chǎn)業(yè)鏈快速增長(zhǎng)。據(jù) IDC數(shù)據(jù)顯示,2021 年中國(guó) AI 投資規(guī)模超 100 億美元,2026 年將有望達(dá)到 267 億美元,全球占比約 8.9%,排名第二,其中 AI 底層硬件市場(chǎng)占比將超過(guò) AI 總投資規(guī)模的半數(shù)。

AI、高性能計(jì)算、圖形渲染推動(dòng)GPU芯片需求

隨著人工智能、高性能計(jì)算、大規(guī)模圖形渲染等應(yīng)用場(chǎng)景的不斷拓展和豐富,市場(chǎng)對(duì)大算力并行計(jì)算芯片的需求快速增長(zhǎng)。截止目前,全球數(shù)據(jù)中心領(lǐng)域邏輯芯片市場(chǎng)規(guī)模已經(jīng)超過(guò)400億美元。同時(shí),近期市場(chǎng)對(duì)國(guó)產(chǎn)GPU領(lǐng)域的關(guān)注度提升。基于英偉達(dá)的歷史復(fù)盤(pán),可以看出英偉達(dá)在圖形渲染和數(shù)據(jù)中心領(lǐng)域保持較高的市場(chǎng)占有率,并實(shí)現(xiàn)產(chǎn)業(yè)引領(lǐng)。

一、AI 訓(xùn)練推理、復(fù)雜科學(xué)計(jì)算、大規(guī)模圖形渲染等,持續(xù)推動(dòng)并行計(jì)算芯片需求

由于GPU(圖形處理器)是由成百上千個(gè)陣列排布的運(yùn)算單元ALU組成,使得GPU更適用于大規(guī)模并發(fā)運(yùn)算,其在圖形處理、計(jì)算加速等領(lǐng)域有著廣泛的運(yùn)用。由于GPU加速器強(qiáng)大的并行處理能力,超算中心工作人員可以更好地設(shè)計(jì)深度網(wǎng)絡(luò)結(jié)構(gòu),使得其在超算領(lǐng)域和數(shù)據(jù)中心領(lǐng)域更具經(jīng)濟(jì)效益,導(dǎo)致GPU在AI訓(xùn)練和推理、科學(xué)計(jì)算等領(lǐng)域有著廣泛的應(yīng)用。

在典型AI模型卷積網(wǎng)絡(luò)中,大量數(shù)據(jù)以圖片形式導(dǎo)入,在進(jìn)行運(yùn)算過(guò)程中,數(shù)據(jù)均為矩陣形式,而矩陣運(yùn)算通常適合并行,因此AI算法的特性,使得GPU的運(yùn)算速度明顯大于CPU。科學(xué)計(jì)算將物理、化學(xué)、生物、航空航天等領(lǐng)域的問(wèn)題轉(zhuǎn)化為數(shù)學(xué)模型,通過(guò)計(jì)算和求解模型用于實(shí)際產(chǎn)業(yè)。從計(jì)算數(shù)據(jù)來(lái)看,由于科學(xué)計(jì)算中所用數(shù)據(jù)多數(shù)以矩陣為形式,同時(shí)由于科學(xué)計(jì)算對(duì)誤差有強(qiáng)制要求,因此在運(yùn)算中需要在并行運(yùn)算基礎(chǔ)上保證一定的精度。

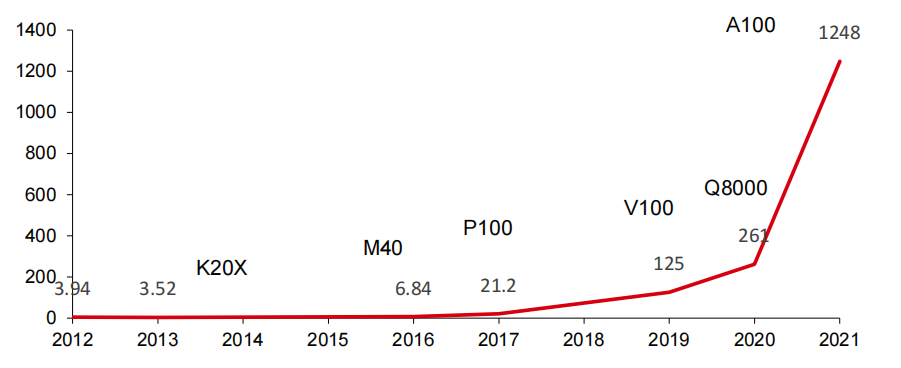

而現(xiàn)代GPU在并行和矩陣運(yùn)算的基礎(chǔ)上,已經(jīng)能夠滿足科學(xué)計(jì)算所需的精度要求。近些年來(lái),隨著人工智能軟件算法的發(fā)展,復(fù)雜科學(xué)計(jì)算的進(jìn)步,以及圖形渲染功能的增加,帶動(dòng)底層芯片并行計(jì)算能力需求的快速提升。以全球AI芯片領(lǐng)軍者英偉達(dá)的發(fā)展?fàn)顩r來(lái)看,公司AI芯片算力由2012年的4Tops提升至2021年的1248Tops,9年時(shí)間提升了約315倍。

英偉達(dá)單芯片推理性能(Int8 Tops)

二、AI 框架、并行計(jì)算框架等引入豐富,不斷推動(dòng)針對(duì)并行計(jì)算芯片軟件開(kāi)發(fā)門(mén)檻降低

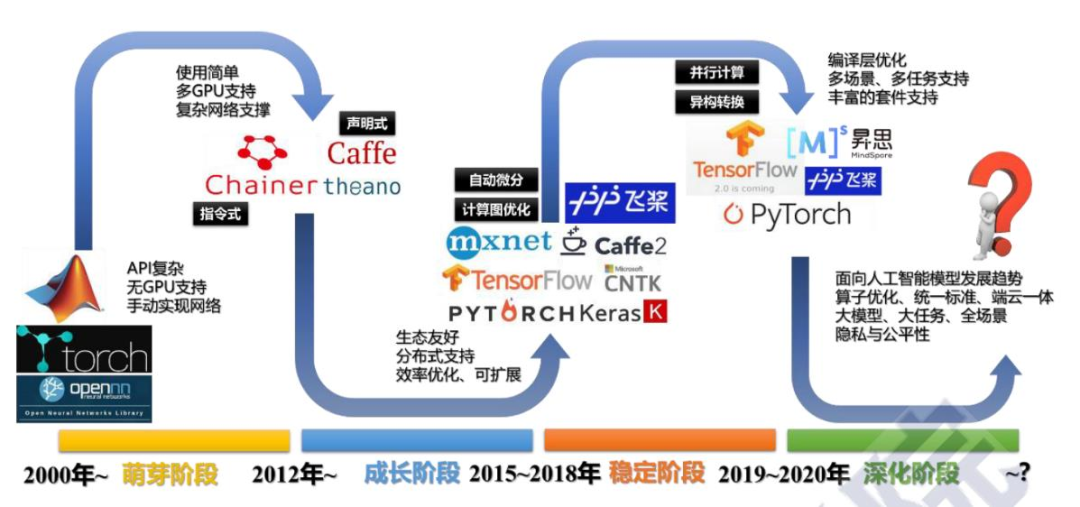

隨著AI框架和并行計(jì)算框架的引入和豐富,針對(duì)并行計(jì)算芯片軟件開(kāi)發(fā)門(mén)檻不斷降低。從人工智能軟件算法框架的發(fā)展歷史來(lái)看,2015年谷歌宣布開(kāi)源TensorFlow,2019年P(guān)FN宣布將研究方向由Chainer轉(zhuǎn)向PyTorch。

目前,AI框架形成了TensorFlow和PyTorch雙寡頭壟斷的競(jìng)爭(zhēng)格局。其中,谷歌開(kāi)源TensorFlow項(xiàng)目,在很大程度上降低了人工智能的開(kāi)發(fā)門(mén)檻和難度。TensorFlow主要用于處理機(jī)器學(xué)習(xí)中的計(jì)算機(jī)視覺(jué)、推薦系統(tǒng)和自然語(yǔ)言處理(NLP)的模型訓(xùn)練和推理,涉及模型隱藏層相對(duì)較多,模型量相對(duì)較大,基本上均需要CUDA的加速處理。隨著TensorFlow的開(kāi)源,涉及到的開(kāi)發(fā)者快速增加,CUDA軟件下載量也呈現(xiàn)陡增趨勢(shì)。據(jù)英偉達(dá)在2021GTC大會(huì)上宣布,截至2020年底,CUDA累計(jì)下載量超過(guò)2000萬(wàn)次,其中2020年下載量超過(guò)600萬(wàn)次。涉及到的開(kāi)發(fā)人員約230萬(wàn)人(2020年新增超過(guò)60萬(wàn)人)。

人工智能框架發(fā)展史

三、算法豐富、算法復(fù)雜度提升等,亦成為市場(chǎng)需求的重要驅(qū)動(dòng)力

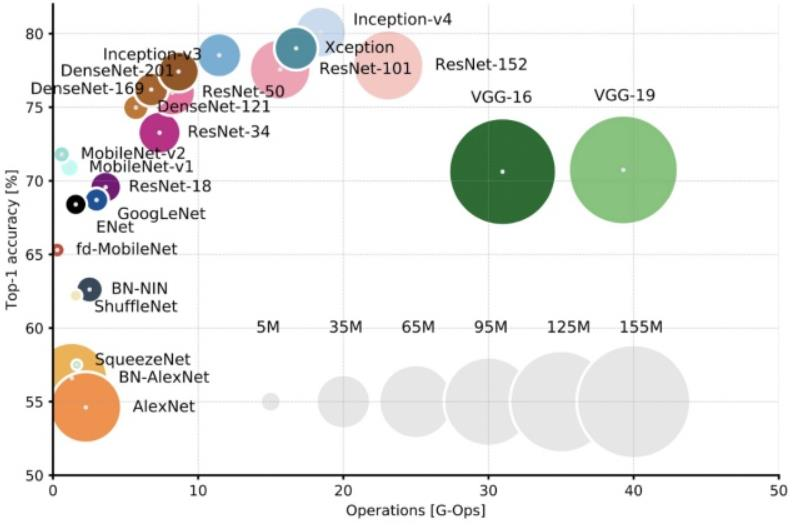

近年來(lái),隨著人工智能芯片的不斷發(fā)展,算法的豐富和復(fù)雜度的提升成為市場(chǎng)需求的重要驅(qū)動(dòng)力。從Alexnet、ResNet到BERT網(wǎng)絡(luò)模型,參數(shù)量已經(jīng)超過(guò)了3億規(guī)模,而GPT-3模型更是超過(guò)了百億規(guī)模,Switch Transformer的問(wèn)世更是一舉突破了萬(wàn)億規(guī)模。此外,英偉達(dá)在2020年發(fā)布的Megatron-LM模型,參數(shù)量達(dá)到了83億,相比2018年震驚世界的BERT模型又提升了5倍。這種模型體積幾何倍數(shù)的增長(zhǎng)也帶來(lái)了更多數(shù)據(jù)中心側(cè)的需求,只有依靠上千塊GPU并行運(yùn)算才能在以天為單位的訓(xùn)練時(shí)長(zhǎng)中完成對(duì)Transformer模型的訓(xùn)練。

深度學(xué)習(xí)初期模型越來(lái)越大

英偉達(dá)布局算力的成功之道

目前,全球GPU市場(chǎng)競(jìng)爭(zhēng)格局主要由英偉達(dá)、AMD、英特爾等幾家巨頭廠商主導(dǎo)。英偉達(dá)是GPU市場(chǎng)的領(lǐng)導(dǎo)者,其市場(chǎng)份額在游戲領(lǐng)域高達(dá)80%以上,數(shù)據(jù)中心和人工智能領(lǐng)域也占據(jù)著重要地位。AMD是英偉達(dá)的主要競(jìng)爭(zhēng)對(duì)手,其市場(chǎng)份額在游戲領(lǐng)域約為20%。英特爾則主要競(jìng)爭(zhēng)于集成顯卡和移動(dòng)設(shè)備領(lǐng)域。這里以英偉達(dá)為例為大家展開(kāi)詳細(xì)介紹。

GPU 逐步成為全球大算力并行計(jì)算領(lǐng)域的主導(dǎo)者,這得益于 GPU 本身的優(yōu)異特性以及英偉達(dá)等企業(yè)在芯片架構(gòu)、軟件生態(tài)等層面的不斷努力,疊加 AI、高性能計(jì)算、大規(guī)模圖形渲染等應(yīng)用場(chǎng)景的快速崛起。在產(chǎn)品端,GPU 廠商亦結(jié)合下游的應(yīng)用場(chǎng)景,在一個(gè)大的體系結(jié)構(gòu)下,針對(duì)計(jì)算單元、緩存、總線帶寬等技術(shù)點(diǎn)的優(yōu)化和組合。目前最主流的應(yīng)用場(chǎng)景產(chǎn)品是用于游戲等場(chǎng)景中圖形渲染的顯卡,以及用于數(shù)據(jù)中心 AI、高性能計(jì)算等場(chǎng)景的 GPGPU(通用計(jì)算 GPU)。

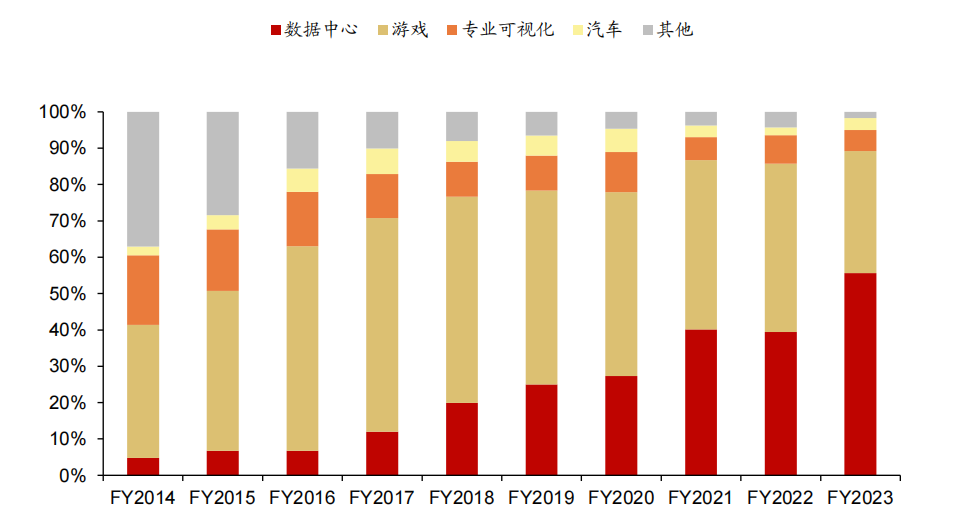

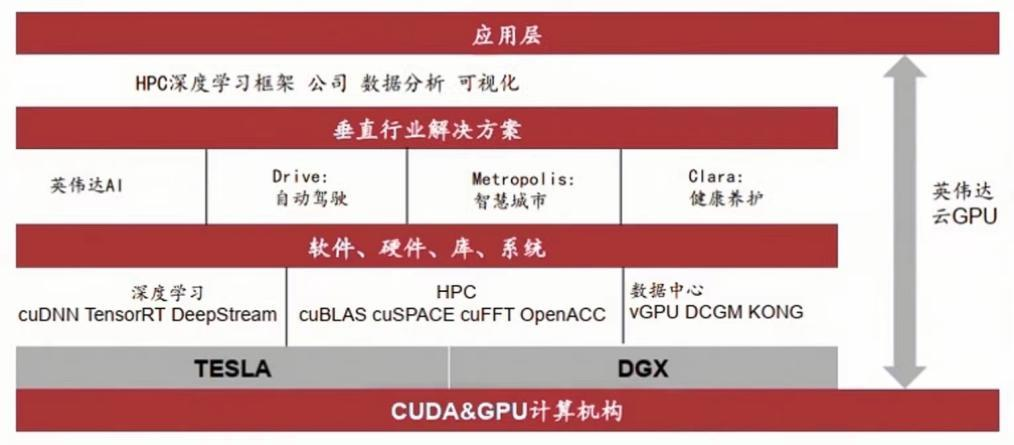

英偉達(dá)逐漸發(fā)展成為一家全球領(lǐng)先的高性能計(jì)算、AI 和游戲平臺(tái)解決方案提供商。基于處理器、互連、軟件、算法、系統(tǒng)和服務(wù)構(gòu)建而成的計(jì)算平臺(tái),英偉達(dá)形成了數(shù)據(jù)中心、游戲、專(zhuān)業(yè)可視化、汽車(chē)四大類(lèi)業(yè)務(wù)。

其中,數(shù)據(jù)中心業(yè)務(wù)主要指 NVIDIA 計(jì)算平臺(tái),覆蓋超大規(guī)模、云、企業(yè)、公共部門(mén)和邊緣數(shù)據(jù)中心,聚焦于加速最具計(jì)算密集型的工作負(fù)載(如人工智能、數(shù)據(jù)分析、圖形和科學(xué)計(jì)算等)。游戲業(yè)務(wù)利用 GPU 和復(fù)雜的軟件來(lái)增強(qiáng)游戲體驗(yàn),使圖形更加流暢、高質(zhì)量。專(zhuān)業(yè)可視化業(yè)務(wù)主要通過(guò) GPU 計(jì)算平臺(tái)提高視覺(jué)設(shè)計(jì)領(lǐng)域的生產(chǎn)效率,主要包括設(shè)計(jì)和制造(包括計(jì)算機(jī)輔助設(shè)計(jì)、建筑設(shè)計(jì)、消費(fèi)品制造、醫(yī)療儀器和航空航天)以及數(shù)字內(nèi)容創(chuàng)作(包括專(zhuān)業(yè)視頻編輯和后期制作、電影特效以及廣播電視圖形)兩大應(yīng)用場(chǎng)景。汽車(chē)業(yè)務(wù)主要包括自動(dòng)駕駛、AI 駕駛艙、電動(dòng)車(chē)計(jì)算平臺(tái)和信息娛樂(lè)平臺(tái)解決方案。公司推出的 DRIVE Hyperion 是一個(gè)完整的自動(dòng)駕駛市場(chǎng)端到端解決方案,包含高性能、能效高的 DRIVE AGX 計(jì)算硬件、支持全自動(dòng)駕駛能力的參考傳感器組以及開(kāi)放的模塊化 DRIVE 軟件平臺(tái),可在車(chē)輛內(nèi)運(yùn)行完整的感知、融合、規(guī)劃和控制堆棧。

英偉達(dá)業(yè)務(wù)架構(gòu)

一、快速崛起的數(shù)據(jù)中心業(yè)務(wù)

英偉達(dá)數(shù)據(jù)中心業(yè)務(wù)的核心是 NVIDIA 加速計(jì)算平臺(tái),該平臺(tái)的建立始于 2006 年通用并行計(jì)算架構(gòu) CUDA 以及 2007 年 Tesla GPU 的推出。CUDA 提供并行計(jì)算平臺(tái)和編程模型,使得 GPU 的并行計(jì)算能力能夠被應(yīng)用于商業(yè)、工業(yè)以及科學(xué)方面的復(fù)雜計(jì)算問(wèn)題,加速計(jì)算任務(wù)的執(zhí)行速度。

Tesla GPU 是專(zhuān)門(mén)為科學(xué)計(jì)算、工程計(jì)算、數(shù)據(jù)分析等計(jì)算密集型應(yīng)用設(shè)計(jì)的高性能計(jì)算 CPU,通過(guò)與 CUDA 能力的結(jié)合,可被廣泛應(yīng)用于藥物研發(fā)、醫(yī)學(xué)成像和天氣建模等領(lǐng)域,并在后續(xù)年份持續(xù)為全球超算中心提供基于 GPU 的算力支撐。受到多方面因素共同推動(dòng),英偉達(dá)數(shù)據(jù)中心業(yè)務(wù)快速增長(zhǎng),在整體收入中的占比持續(xù)提升,并于 2023 財(cái)年(對(duì)應(yīng) 2022 自然年)占比達(dá)到 56%。我們認(rèn)為英偉達(dá)數(shù)據(jù)中心業(yè)務(wù)崛起受到的推動(dòng)因素有:深度學(xué)習(xí)開(kāi)啟新一輪 AI 技術(shù)蓬勃發(fā)展;數(shù)據(jù)量增加激發(fā)大規(guī)模數(shù)據(jù)處理和分析的需求;復(fù)雜計(jì)算任務(wù)需求增加;云計(jì)算技術(shù)的發(fā)展提升算力使用的便捷性。

英偉達(dá) 2014-2023 財(cái)年收入結(jié)構(gòu)拆分

英偉達(dá)在數(shù)據(jù)業(yè)務(wù)上的成功,不僅僅依靠于 GPU 的銷(xiāo)售和使用。GPU 是 NVIDIA 加速計(jì)算平臺(tái)的基礎(chǔ),能夠高效完成以神經(jīng)網(wǎng)絡(luò)訓(xùn)練和推斷為代表的并行工作負(fù)載任務(wù)。但是,英偉達(dá)數(shù)據(jù)中心的核心業(yè)務(wù)壁壘是端到端的硬件+軟件集成方案,構(gòu)成從實(shí)施開(kāi)發(fā)到部署的全鏈路基礎(chǔ)設(shè)施支撐。從幾個(gè)維度拆解來(lái)看:

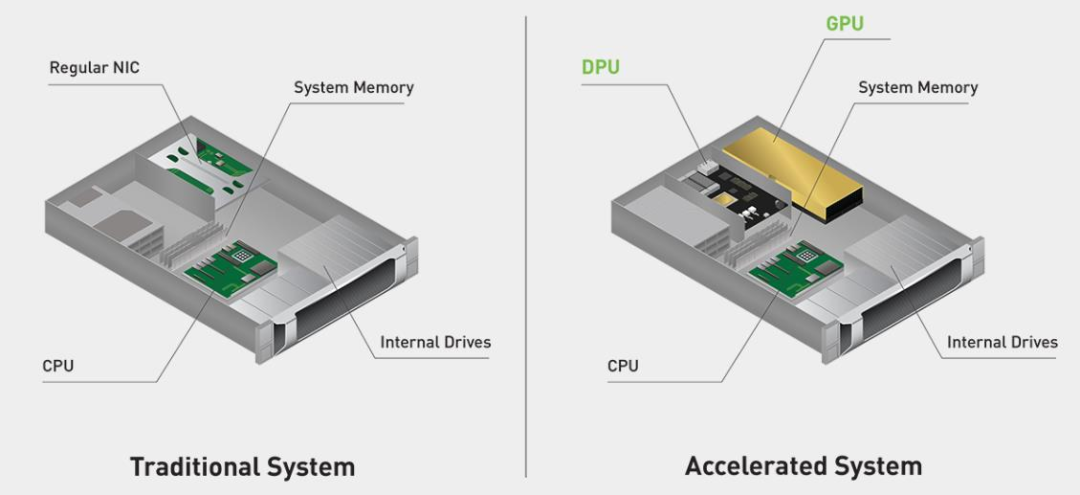

1、硬件

硬件部分由三個(gè)部分組成,包括 GPU(Hopper GPU)、DPU(BlueField DPU)和CPU(Grace CPU)。這些架構(gòu)涵蓋了性能、安全性和網(wǎng)絡(luò)等領(lǐng)域的前沿技術(shù)。CPU和DPU可以與GPU架構(gòu)緊密融合,對(duì)網(wǎng)絡(luò)、存儲(chǔ)和安全服務(wù)進(jìn)行加速,提供高性能、高能效和高可靠性的加速計(jì)算解決方案。

英偉達(dá)加速系統(tǒng)與傳統(tǒng)加速系統(tǒng)對(duì)比

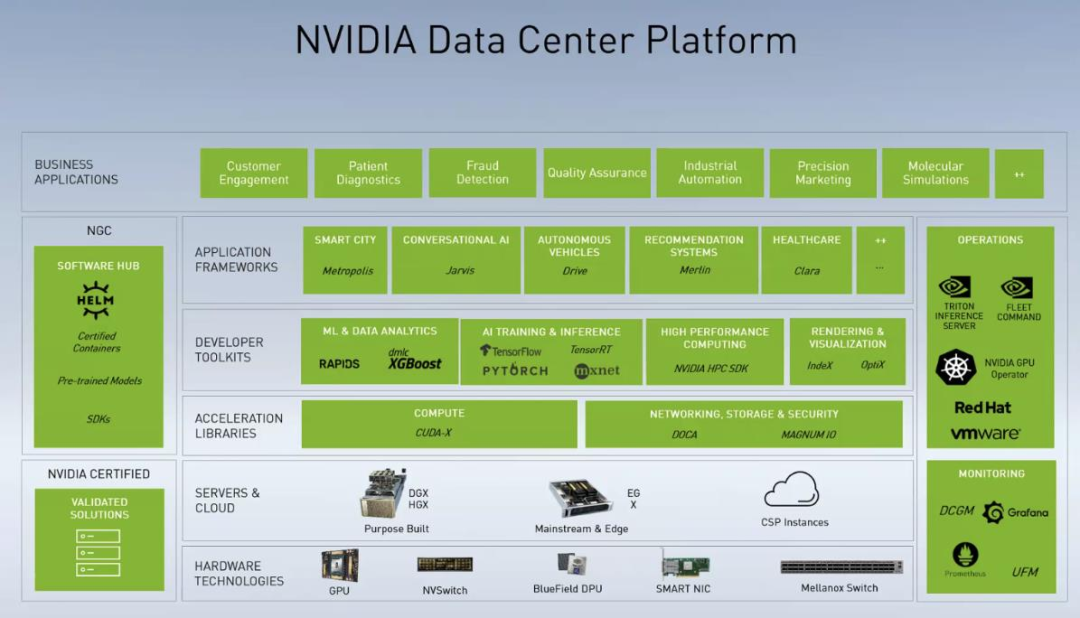

2、軟件

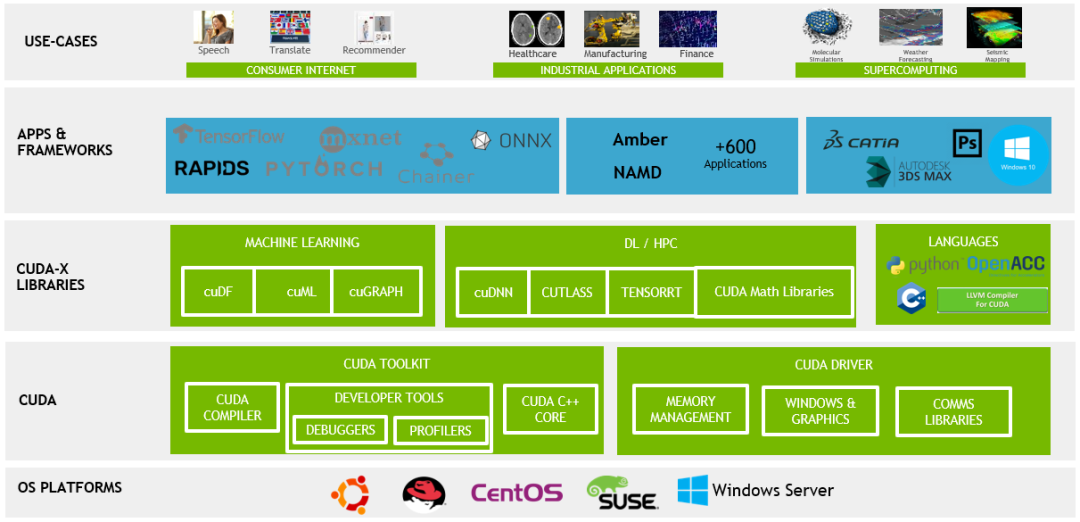

擁有龐大的軟件體系,包括CUDA并行編程模型、CUDA-X應(yīng)用加速庫(kù)集合、應(yīng)用程序接口(API)、軟件開(kāi)發(fā)工具包(SDK)和工具,以及特定領(lǐng)域的應(yīng)用框架。這些框架包括對(duì)話式AI框架NVIDIA Riva、推薦系統(tǒng)框架NVIDIA Merlin、計(jì)算機(jī)視覺(jué)NVIDIA Metropolis等。這些軟件工具和框架可以幫助用戶更高效地利用英偉達(dá)的加速計(jì)算平臺(tái),提升數(shù)據(jù)處理和分析的能力。

3、場(chǎng)景

適用于多種工作負(fù)載需求,包括分析、訓(xùn)練、推理、高性能計(jì)算、渲染和虛擬化等領(lǐng)域。這一平臺(tái)的多樣性和靈活性,可以為用戶提供更加全面和高效的數(shù)據(jù)處理和分析能力。

4、NGC

NVIDIA GPU Cloud(NGC)提供一系列完全托管的云服務(wù),將硬件、軟件以及不同場(chǎng)景的工作負(fù)載需求進(jìn)行融合,是數(shù)據(jù)中心業(yè)務(wù)的理想終極形態(tài)。NGC的服務(wù)包括用于NLU和語(yǔ)音AI解決方案的NeMo LLM、BioNemo和Riva Studio。AI從業(yè)者可以利用NVIDIA Base Command進(jìn)行模型訓(xùn)練,利用NVIDIA Fleet Command進(jìn)行模型管理,并利用NGC專(zhuān)用注冊(cè)表安全共享專(zhuān)有AI軟件。此外,NGC還擁有一個(gè)GPU優(yōu)化的AI軟件、SDK和Jupyter Notebook的目錄,可幫助加速AI工作流,并通過(guò)NVIDIA AI Enterprise提供支持。

英偉達(dá)數(shù)據(jù)中心業(yè)務(wù)版圖

二、NVIDIA DGX GH200

DGX計(jì)算機(jī)系列采用英偉達(dá)自主研發(fā)的GPU加速技術(shù),配備高性能的CPU、GPU、內(nèi)存和存儲(chǔ)系統(tǒng),能夠快速處理大規(guī)模的數(shù)據(jù)和復(fù)雜的深度學(xué)習(xí)算法。此外,DGX計(jì)算機(jī)還配備了英偉達(dá)的深度學(xué)習(xí)軟件堆棧,包括CUDA、cuDNN和TensorRT等,可幫助用戶更輕松地構(gòu)建、訓(xùn)練和部署深度學(xué)習(xí)模型。

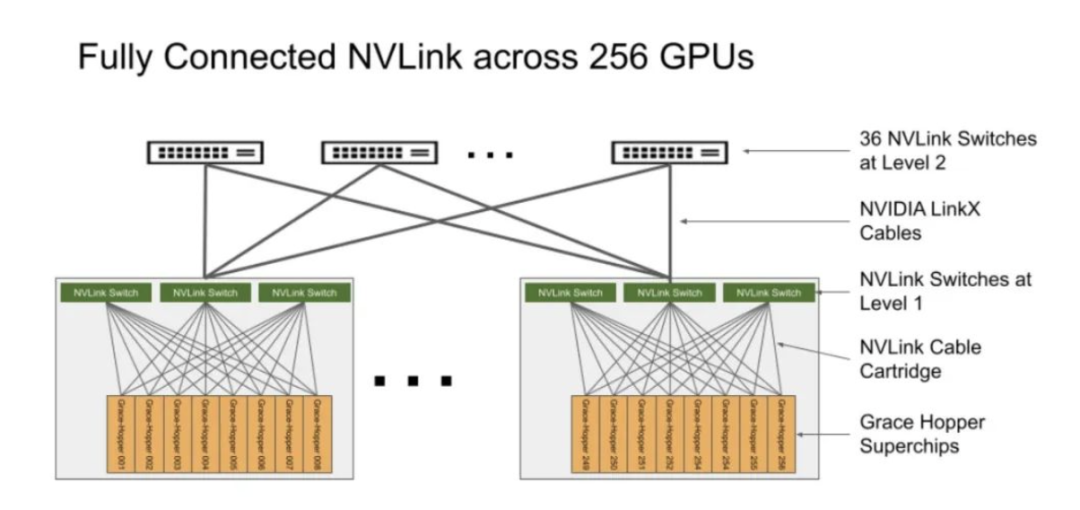

GH200是英偉達(dá)在 COMPUTEX 2023展會(huì)上推出的最新超級(jí)計(jì)算機(jī),最多可以放置256個(gè)GPU,適用于超大型AI模型的部署。相比之前的DGX服務(wù)器,GH200提供線性拓展方式和更高的GPU共享內(nèi)存編程模型,可通過(guò)NVLink高速訪問(wèn)144TB內(nèi)存,是上一代DGX的500倍。其架構(gòu)提供的NVLink帶寬是上一代的48倍,使得千億或萬(wàn)億參數(shù)以上的大模型能夠在一臺(tái)DGX內(nèi)放置,進(jìn)一步提高模型效率和多模態(tài)模型的開(kāi)發(fā)進(jìn)程。

GPU的統(tǒng)一內(nèi)存編程模型一直是復(fù)雜加速計(jì)算應(yīng)用取得突破的基石。NVIDIA Grace Hopper Superchip與NVLink開(kāi)關(guān)系統(tǒng)配對(duì),在NVIDIA DGX GH200系統(tǒng)中整合了256個(gè)GPU,通過(guò)NVLink高速訪問(wèn)144TB內(nèi)存。與單個(gè)NVIDIA DGX A100 320 GB系統(tǒng)相比,NVIDIA DGX GH200為GPU共享內(nèi)存編程模型提供了近500倍的內(nèi)存,是突破GPU通過(guò)NVLink訪問(wèn)內(nèi)存的100TB障礙的第一臺(tái)超級(jí)計(jì)算機(jī)。NVIDIA Base Command的快速部署和簡(jiǎn)化系統(tǒng)管理使用戶能夠更快地進(jìn)行加速計(jì)算。

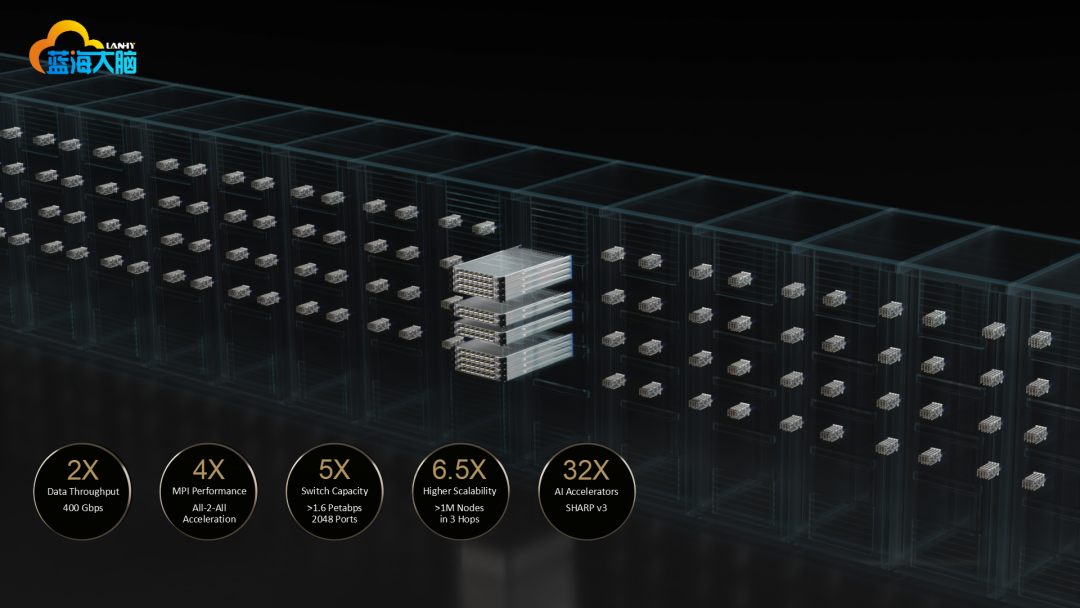

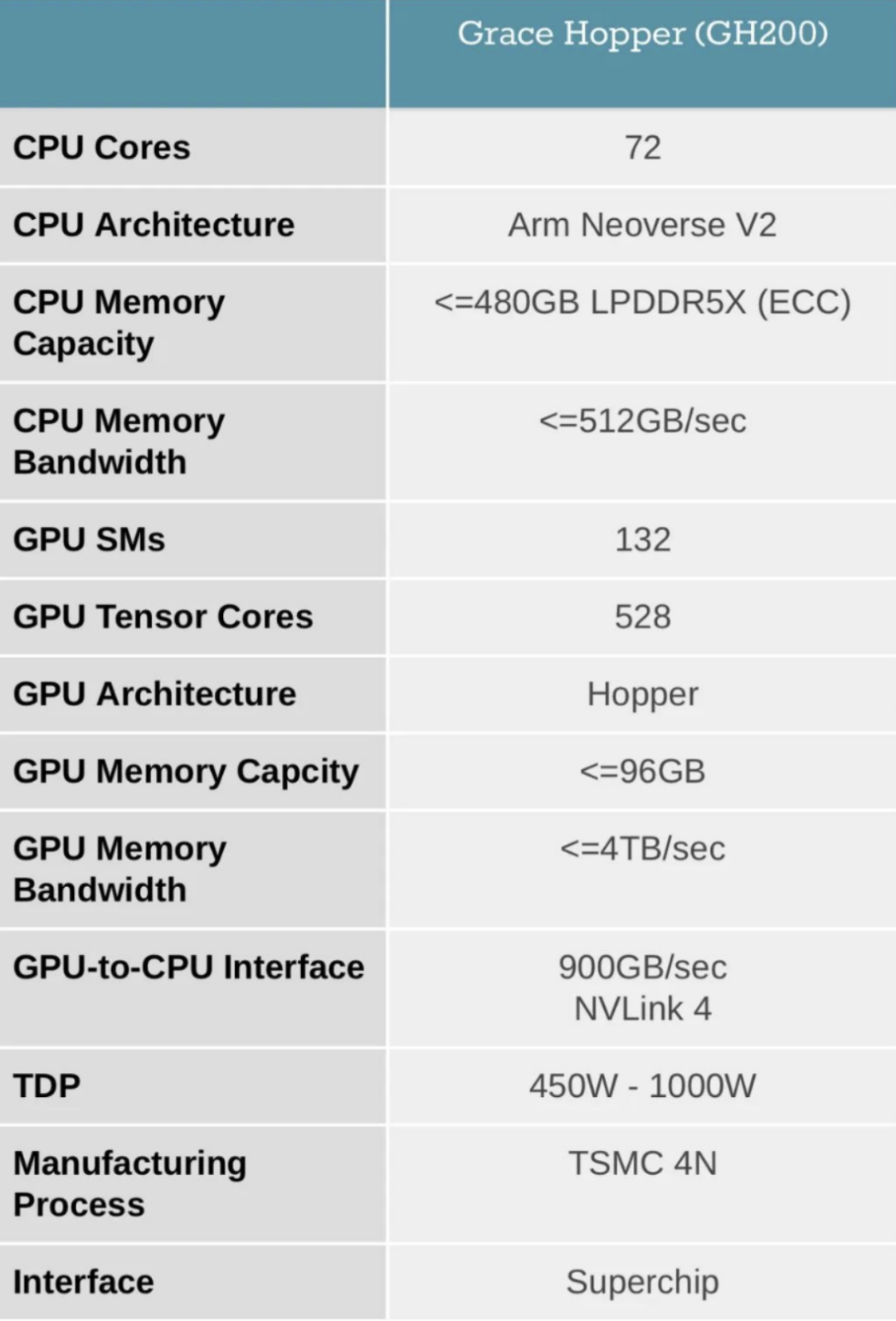

NVIDIA DGX GH200系統(tǒng)采用了NVIDIA Grace Hopper Superchip和NVLink Switch System作為其構(gòu)建塊。NVIDIA Grace Hopper Superchip將CPU和GPU結(jié)合在一起,使用NVIDIA NVLink-C2C技術(shù)提供一致性內(nèi)存模型,并提供高帶寬和無(wú)縫的多GPU系統(tǒng)。每個(gè)Grace Hopper超級(jí)芯片都擁有480GB的LPDDR5 CPU內(nèi)存和96GB的快速HBM3,提供比PCIe Gen5多7倍的帶寬,與NVLink-C2C互連。

NVLink開(kāi)關(guān)系統(tǒng)使用第四代NVLink技術(shù),將NVLink連接擴(kuò)展到超級(jí)芯片,以創(chuàng)建一個(gè)兩級(jí)、無(wú)阻塞、NVLink結(jié)構(gòu),可完全連接256個(gè)Grace Hopper超級(jí)芯片。這種結(jié)構(gòu)提供900GBps的內(nèi)存訪問(wèn)速度,托管Grace Hopper Superchips的計(jì)算底板使用定制線束連接到第一層NVLink結(jié)構(gòu),并由LinkX電纜擴(kuò)展第二層NVLink結(jié)構(gòu)的連接性。

在DGX GH200系統(tǒng)中,GPU線程可以使用NVLink頁(yè)表來(lái)訪問(wèn)來(lái)自其他Grace Hopper超級(jí)芯片的內(nèi)存,并通過(guò)NVIDIA Magnum IO加速庫(kù)來(lái)優(yōu)化GPU通信以提高效率。該系統(tǒng)擁有128 TBps的對(duì)分帶寬和230.4 TFLOPS的NVIDIA SHARP網(wǎng)內(nèi)計(jì)算,可加速AI常用的集體運(yùn)算,并將NVLink網(wǎng)絡(luò)系統(tǒng)的實(shí)際帶寬提高一倍。每個(gè)Grace Hopper Superchip都配備一個(gè)NVIDIA ConnectX-7網(wǎng)絡(luò)適配器和一個(gè)NVIDIA BlueField-3 NIC,以擴(kuò)展到超過(guò)256個(gè)GPU,可以互連多個(gè)DGX GH200系統(tǒng),并利用BlueField-3 DPU的功能將任何企業(yè)計(jì)算環(huán)境轉(zhuǎn)變?yōu)榘踩壹铀俚奶摂M私有云。

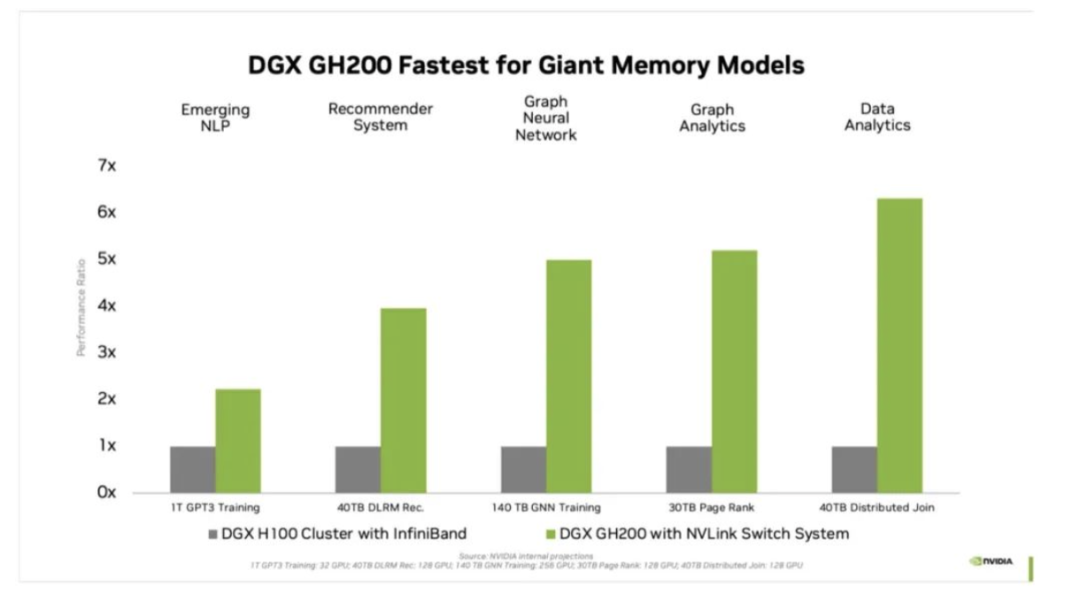

對(duì)于受GPU內(nèi)存大小瓶頸的AI和HPC應(yīng)用程序,GPU內(nèi)存的代際飛躍可以顯著提高性能。對(duì)于許多主流AI和HPC工作負(fù)載,單個(gè)NVIDIA DGX H100的聚合GPU內(nèi)存可以完全支持。對(duì)于其他工作負(fù)載,例如具有TB級(jí)嵌入式表的深度學(xué)習(xí)推薦模型(DLRM)、TB級(jí)圖形神經(jīng)網(wǎng)絡(luò)訓(xùn)練模型或大型數(shù)據(jù)分析工作負(fù)載,使用DGX GH200可實(shí)現(xiàn)4至7倍的加速。這表明DGX GH200是更高級(jí)的AI和HPC模型的更好解決方案,這些模型需要海量?jī)?nèi)存來(lái)進(jìn)行GPU共享內(nèi)存編程。

DGX GH200是專(zhuān)為最嚴(yán)苛的工作負(fù)載而設(shè)計(jì)的系統(tǒng),每個(gè)組件都經(jīng)過(guò)精心挑選,以最大限度地減少瓶頸,同時(shí)最大限度地提高關(guān)鍵工作負(fù)載的網(wǎng)絡(luò)性能,并充分利用所有擴(kuò)展硬件功能。這使得該系統(tǒng)具有高度的線性可擴(kuò)展性和海量共享內(nèi)存空間的高利用率。

為了充分利用這個(gè)先進(jìn)的系統(tǒng),NVIDIA還構(gòu)建了一個(gè)極高速的存儲(chǔ)結(jié)構(gòu),以峰值容量運(yùn)行并處理各種數(shù)據(jù)類(lèi)型(文本、表格數(shù)據(jù)、音頻和視頻),并且表現(xiàn)穩(wěn)定且并行。

DGX GH200附帶NVIDIA Base Command,其中包括針對(duì)AI工作負(fù)載優(yōu)化的操作系統(tǒng)、集群管理器、加速計(jì)算的庫(kù)、存儲(chǔ)和網(wǎng)絡(luò)基礎(chǔ)設(shè)施,這些都針對(duì)DGX GH200系統(tǒng)架構(gòu)進(jìn)行了優(yōu)化。此外,DGX GH200還包括NVIDIA AI Enterprise,提供一套經(jīng)過(guò)優(yōu)化的軟件和框架,可簡(jiǎn)化AI開(kāi)發(fā)和部署。這種全堆棧解決方案使客戶能夠?qū)W⒂趧?chuàng)新,而不必?fù)?dān)心管理其IT基礎(chǔ)架構(gòu)。

三、大模型時(shí)代涌現(xiàn)的算力需求

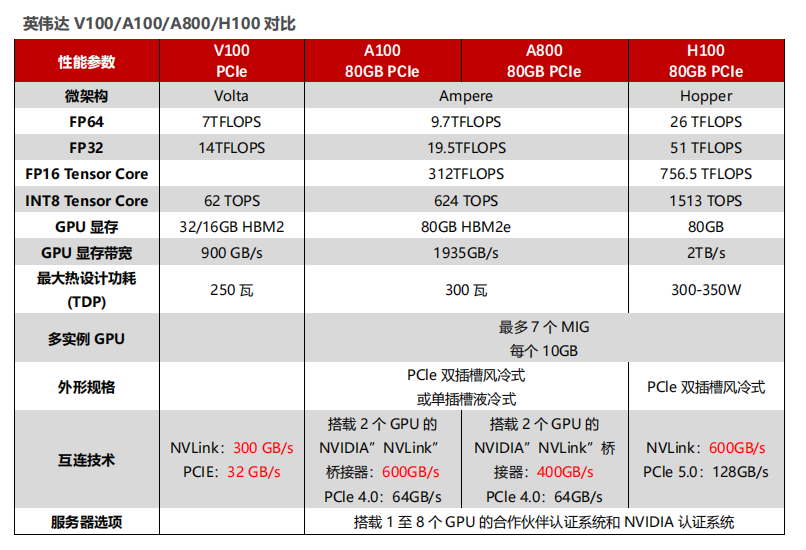

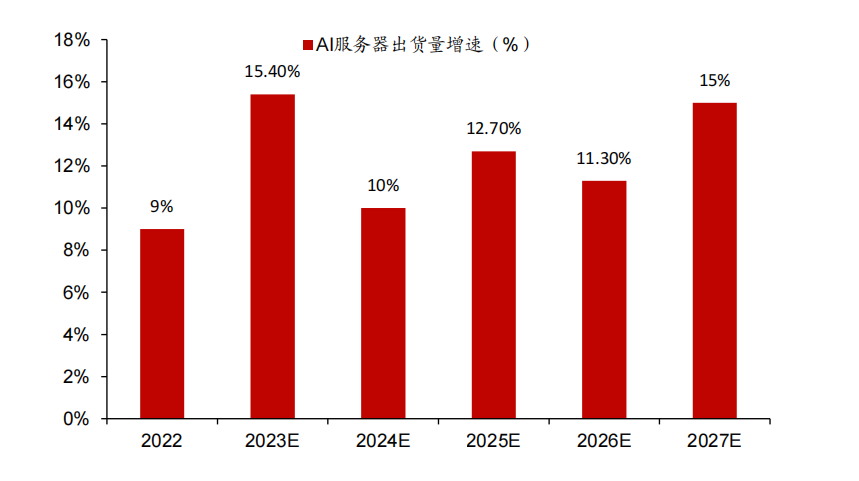

自ChatGPT發(fā)布以來(lái),越來(lái)越多的科技公司投入大模型研發(fā),帶動(dòng)AI服務(wù)器出貨量和價(jià)格的量?jī)r(jià)齊升。根據(jù)TrendForce,2022年高端GPGPU服務(wù)器出貨量有望增長(zhǎng)9%左右,2023年人工智能服務(wù)器出貨量有望增長(zhǎng)15.4%,2023年至2027年人工智能服務(wù)器出貨量復(fù)合年增長(zhǎng)率為12.2%。同時(shí),據(jù)IDC在5月17日發(fā)布的數(shù)據(jù),A100 GPU市場(chǎng)單價(jià)已達(dá)15萬(wàn)元,兩個(gè)月前為10萬(wàn)元,漲幅50%;A800價(jià)格漲幅相對(duì)更小,價(jià)格在9.5萬(wàn)元左右,上月價(jià)格為8.9萬(wàn)元左右。考慮到目前全球GPU產(chǎn)能有限,市場(chǎng)GPU供應(yīng)持續(xù)緊缺,IDC預(yù)計(jì)未來(lái)AI服務(wù)器價(jià)格仍將保持上漲趨勢(shì)。

2023-2027 年 AI 服務(wù)器出貨量增速預(yù)測(cè)(截至 2023 年 4 月)

大模型對(duì)于算力的需求體現(xiàn)在模型訓(xùn)練和推理應(yīng)用兩個(gè)階段。模型訓(xùn)練階段的總計(jì)算量取決于模型的規(guī)模(參數(shù)數(shù)量)、訓(xùn)練數(shù)據(jù)集的大小、訓(xùn)練輪次、批次大小,而單一GPU的運(yùn)算能力以及訓(xùn)練時(shí)間決定了訓(xùn)練階段對(duì)于GPU(或AI服務(wù)器)的需求量;推理應(yīng)用階段的總計(jì)算量取決于模型規(guī)模(參數(shù)數(shù)量)、輸入文本長(zhǎng)度(問(wèn)題長(zhǎng)度)、輸出文本長(zhǎng)度(回復(fù)長(zhǎng)度)、模型的計(jì)算復(fù)雜性(取決于模型維度和模型層數(shù)),而在同一時(shí)間的用戶訪問(wèn)量以及單一GPU的運(yùn)算能力決定了推理階段對(duì)于GPU(或AI服務(wù)器)的需求量。具體而言:

根據(jù)OpenAI的論文《Scaling Laws for Neural Language Models》(2020年發(fā)表),訓(xùn)練階段算力需求為3×前向傳遞操作數(shù)×模型參數(shù)數(shù)量×訓(xùn)練集規(guī)模。同時(shí),我們可得到訓(xùn)練所需GPU數(shù)量為總算力需求/(每個(gè)GPU每秒運(yùn)算能力×訓(xùn)練時(shí)間×有效算力比率)。以GPT-3模型為例,GPT-3模型參數(shù)量為1750億個(gè),訓(xùn)練集約為3000億tokens,對(duì)應(yīng)訓(xùn)練階段總算力需求為:GPT-3總算力需求=6×1.75×1011×3×1011=3.15×1023 FLOPS=3.15×108 PFLOPS。若假設(shè)全部采用英偉達(dá)A100 GPU進(jìn)行運(yùn)算,每張GPU運(yùn)算能力為624 TFLOPS(即0.624 PFLOPS,對(duì)應(yīng)FP16稀疏運(yùn)算),訓(xùn)練時(shí)間為20天(1.73×106秒),有效算力比率為30%,對(duì)應(yīng)所需GPU數(shù)量為:GPT-3訓(xùn)練所需A100 GPU數(shù)量(20天)=3.15×108 PFLOPS/(0.624 PFLOPS/s×1.73×106 s×30%)=973個(gè)GPU=122臺(tái)DGX-3。若我們假設(shè)訓(xùn)練20個(gè)對(duì)標(biāo)GPT-3參數(shù)量和訓(xùn)練集規(guī)模的大模型,則需要近2萬(wàn)個(gè)A100 GPU或2432臺(tái)DGX-3。參考IDC最新公布的A100 GPU單價(jià),僅GPU采購(gòu)對(duì)應(yīng)的市場(chǎng)空間約為29億元;若全部采用DGX-3進(jìn)行訓(xùn)練,則對(duì)應(yīng)市場(chǎng)空間可達(dá)到48.6億元。

推理階段算力需求同樣根據(jù)OpenAI論文,推理階段單次訪問(wèn)算力需求為2×模型參數(shù)數(shù)量×訓(xùn)練及規(guī)模。從而我們可以得到推理應(yīng)用所需GPU數(shù)量=訪問(wèn)量×單次訪問(wèn)算力需求/(每個(gè)GPU每日運(yùn)算能力×有效算力比率)。同樣以GPT-3模型為例,參考天翼智庫(kù)的測(cè)算,我們假設(shè)每次訪問(wèn)發(fā)生10輪對(duì)話,每輪對(duì)話產(chǎn)生500個(gè)tokens(約350個(gè)單詞),則對(duì)應(yīng)單次訪問(wèn)推理的算力需求為:?jiǎn)未卧L問(wèn)算力需求=2×1.75×1011×500×10=1.75×1015 FLOPS=1.75 PFLOPS。我們同樣假設(shè)全部采用英偉達(dá)A100 GPU進(jìn)行運(yùn)算,參考2023年4月ChatGPT的訪問(wèn)量17.6億次,對(duì)應(yīng)日均訪問(wèn)量約0.6億次,則為了支撐每日的訪問(wèn)量推理所需GPU數(shù)量為:GPT-3每日推理所需A100 GPU數(shù)量=0.59×108×1.75 PFLOPS/(0.624 PFLOPS/s×8.64×104 s×30%)=6384個(gè)GPU=798臺(tái)DGX-3。由以上計(jì)算結(jié)果可知推理階段對(duì)于算力的需求遠(yuǎn)超訓(xùn)練階段對(duì)于的算力需求。若我們假設(shè)每日需應(yīng)對(duì)2億次訪問(wèn)量,則需要約2.2萬(wàn)個(gè)A100 GPU或2720臺(tái)DGX-3。

研究英偉達(dá)的快速發(fā)展給我國(guó)帶來(lái)什么借鑒意義

一、深耕GPU算力領(lǐng)域,研發(fā)為導(dǎo)向不斷提升產(chǎn)品競(jìng)爭(zhēng)力

1、采用主流 API,借助微軟推廣產(chǎn)品

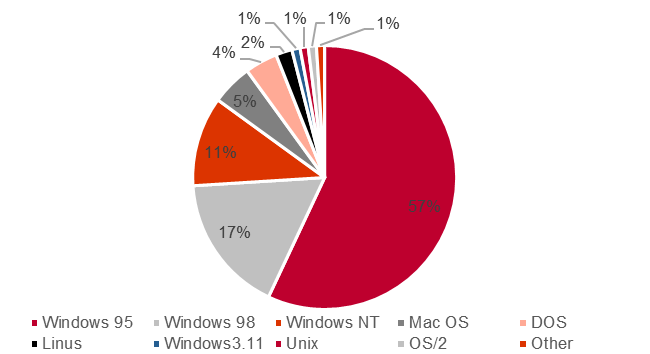

NVIDIA公司自創(chuàng)立之初便以市場(chǎng)需求為導(dǎo)向,通過(guò)匹配主流API并不斷更新技術(shù),逐漸降低產(chǎn)品價(jià)格以滿足消費(fèi)者需求,從而占領(lǐng)市場(chǎng)。在設(shè)計(jì)NV2及后續(xù)產(chǎn)品時(shí),NVIDIA公司都采用微軟推出的DirectX作為API,得益于微軟Windows系列操作系統(tǒng)在市場(chǎng)上占有大量份額,同時(shí)對(duì)DirectX和OpenGL進(jìn)行加速優(yōu)化,使得NVIDIA公司的產(chǎn)品得到了廣泛的歡迎。

1998 年操作系統(tǒng)占比

2、壓縮開(kāi)發(fā)周期領(lǐng)先市場(chǎng),為下游廠商提供更好的產(chǎn)品

英偉達(dá)公司抓住了從2D到3D的轉(zhuǎn)型趨勢(shì),通過(guò)成熟的研發(fā)體系,以快速的速度甩開(kāi)了2D圖形廠商。該公司圖形業(yè)務(wù)的快速產(chǎn)品周期得益于其獨(dú)特的運(yùn)營(yíng)模式。一般圖形市場(chǎng)產(chǎn)品有兩個(gè)開(kāi)發(fā)周期:6-9個(gè)月和12-18個(gè)月,而英偉達(dá)公司則采用了“三團(tuán)隊(duì)-兩季度”的運(yùn)營(yíng)模式,即三個(gè)并行開(kāi)發(fā)團(tuán)隊(duì)分別專(zhuān)注于三個(gè)獨(dú)立的分階段產(chǎn)品開(kāi)發(fā),分別在第一年秋季、第二年春季和第二年秋季推出新產(chǎn)品,每6個(gè)月推出一次新產(chǎn)品,與圖形市場(chǎng)產(chǎn)品周期一致,領(lǐng)先市場(chǎng)1-2個(gè)研發(fā)周期。此外,為解決芯片硬件開(kāi)發(fā)比軟件開(kāi)發(fā)慢的問(wèn)題,英偉達(dá)公司大力投資了仿真技術(shù),從而提升了效率。

3、在產(chǎn)品布局多元化初期,用產(chǎn)品交叉服務(wù)市場(chǎng)

盡管英偉達(dá)在手機(jī)芯片市場(chǎng)開(kāi)拓中遭遇失敗,但并未停止Tegra處理器的研發(fā),而是改變了產(chǎn)品定位,將Tegra處理器應(yīng)用于智能汽車(chē)、智慧城市和云端服務(wù)。因此,英偉達(dá)初步確立了“兩產(chǎn)品條線-四市場(chǎng)”的商業(yè)模式,其中兩個(gè)產(chǎn)品條線分別為傳統(tǒng)產(chǎn)品GPU和Tegra處理器,而四個(gè)市場(chǎng)則分別為游戲、企業(yè)級(jí)、移動(dòng)端和云端。

英偉達(dá)商業(yè)布局

4、英偉達(dá)的商業(yè)模式戰(zhàn)略很好的應(yīng)對(duì)了圖像處理器市場(chǎng)的發(fā)展趨勢(shì)

英偉達(dá)的商業(yè)模式戰(zhàn)略很好地應(yīng)對(duì)了圖像處理器市場(chǎng)的發(fā)展趨勢(shì)。當(dāng)時(shí)的圖像處理器市場(chǎng)產(chǎn)品細(xì)化,主要分布在游戲玩家、企業(yè)級(jí)、平板電腦和移動(dòng)端用戶,不同客戶的需求差異化明顯,針對(duì)不同下游英偉達(dá)推出了對(duì)應(yīng)的產(chǎn)品方案。

1)游戲市場(chǎng)

針對(duì)玩家希望能夠在不同平臺(tái)無(wú)縫進(jìn)行游戲體驗(yàn)的需求,英偉達(dá)推出了端到端的服務(wù),使游戲能夠在云端運(yùn)行,不需要玩家擁有高性能的電腦,大大提高了玩家碎片時(shí)間的利用率和娛樂(lè)的靈活性。

2)企業(yè)級(jí)

英偉達(dá)為汽車(chē)、電影、天然氣等行業(yè)提供可視化解決方案,目的是提高行業(yè)生產(chǎn)力。英偉達(dá)面向企業(yè)市場(chǎng)的產(chǎn)品包括用于工作站的Quadro,用于高性能計(jì)算服務(wù)器的Tesla和用于企業(yè)VDI應(yīng)用程序的GRID。

3)移動(dòng)端

英偉達(dá)將移動(dòng)端擴(kuò)展到移動(dòng)智能設(shè)備市場(chǎng),比如智能汽車(chē)、智能家居行業(yè)。英偉達(dá)的移動(dòng)戰(zhàn)略轉(zhuǎn)變?yōu)閷egra應(yīng)用到需要視覺(jué)設(shè)計(jì)的設(shè)備中。

4)云端服務(wù)

英偉達(dá)將GPU的應(yīng)用從PC端拓展到服務(wù)器和數(shù)據(jù)中心,使得更多的用戶可以使用。英偉達(dá)開(kāi)發(fā)的GRID使Adobe Photoshop遠(yuǎn)程運(yùn)行,并與應(yīng)用程序交互。

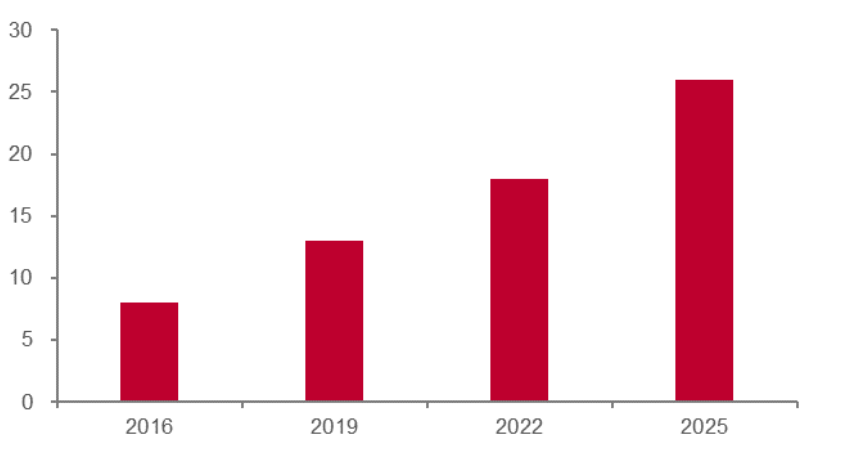

2016-2025 年自動(dòng)駕駛規(guī)模(十億美元)

5、研發(fā)投入帶給英偉達(dá)高回報(bào),在主流游戲和顯卡天梯測(cè)評(píng)上,AMD 落后于英偉達(dá)

英偉達(dá)在2018年推出的Titan RTX和RTX 2080 Ti全面超過(guò)當(dāng)時(shí)的Radeon VII,其采取的策略是推出比AMD稍高的性能和價(jià)格。即使技術(shù)比AMD領(lǐng)先,也會(huì)等到AMD推出更高性能的產(chǎn)品之后,才會(huì)推出,以此來(lái)獲得比AMD更高的收益。

6、專(zhuān)利數(shù)量方面英偉達(dá)逐步反超 AMD

AMD此前在專(zhuān)利數(shù)量上一直多于英偉達(dá),但申請(qǐng)的數(shù)量呈現(xiàn)下降趨勢(shì)。英偉達(dá)在2011年之后申請(qǐng)專(zhuān)利數(shù)量開(kāi)始爆發(fā),主要因其在2007年之后開(kāi)始研發(fā)移動(dòng)端GPU和深度學(xué)習(xí)領(lǐng)域,最終給GPU市場(chǎng)帶來(lái)了新的框架和更高性能的芯片。

二、CUDA 自成體系:從單一產(chǎn)業(yè)到生態(tài)鏈,構(gòu)建強(qiáng)護(hù)城河

1、CUDA 助力英偉達(dá)成長(zhǎng)為 AI 產(chǎn)業(yè)龍頭,構(gòu)建強(qiáng)大生態(tài)護(hù)城河壁壘

CUDA是英偉達(dá)基于其生產(chǎn)的GPU的一個(gè)并行計(jì)算平臺(tái)和編程模型,目的是便于更多的技術(shù)人員參與開(kāi)發(fā)。開(kāi)發(fā)人員可以通過(guò)C/C++、Fortran等高級(jí)語(yǔ)言來(lái)調(diào)用CUDA的API,來(lái)進(jìn)行并行編程,達(dá)到高性能計(jì)算目的。CUDA平臺(tái)的出現(xiàn)使得利用GPU來(lái)訓(xùn)練神經(jīng)網(wǎng)絡(luò)等高算力模型的難度大大降低,將GPU的應(yīng)用從3D游戲和圖像處理拓展到科學(xué)計(jì)算、大數(shù)據(jù)處理、機(jī)器學(xué)習(xí)等領(lǐng)域。這種生態(tài)系統(tǒng)的建立讓很多開(kāi)發(fā)者依賴(lài)于CUDA,進(jìn)一步增加了英偉達(dá)的競(jìng)爭(zhēng)優(yōu)勢(shì)。

CUDA 加速計(jì)算解決方案

2、CUDA 的低成本和兼容性成為其最重要的吸引點(diǎn)之一

英偉達(dá)的CUDA是一個(gè)免費(fèi)、強(qiáng)大的并行計(jì)算平臺(tái)和編程模型。安裝過(guò)程簡(jiǎn)單且明確,讓開(kāi)發(fā)者能夠輕松快速地啟動(dòng)并行編程。CUDA對(duì)新手極其友好,特別是對(duì)C語(yǔ)言、C++和Fortran的開(kāi)發(fā)者。同時(shí)為支持其他編程語(yǔ)言,如Java、Python等,CUDA還提供第三方包裝器進(jìn)行擴(kuò)展。為廣大開(kāi)發(fā)者提供了極大的便利和高效的編程體驗(yàn)。操作系統(tǒng)方面,CUDA在多種操作系統(tǒng)上也都有良好的兼容性,包括Windows、Linux和macOS。

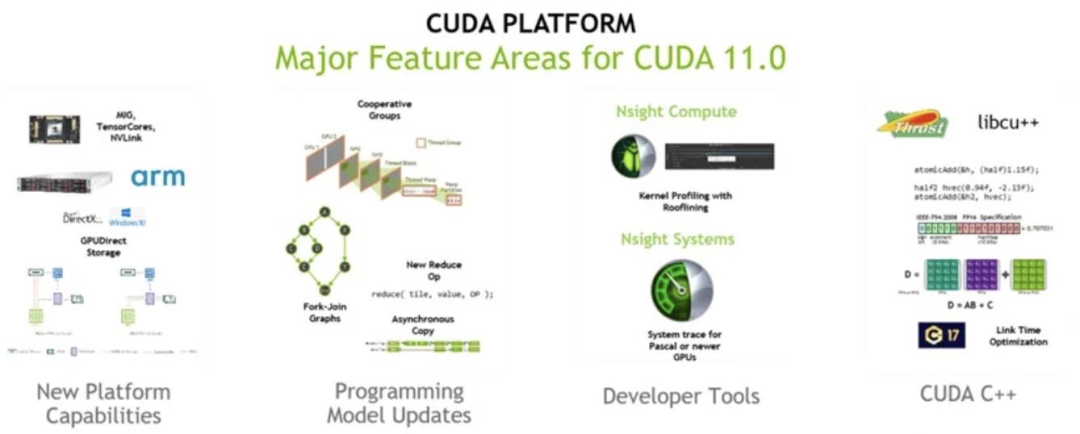

3、CUDA 有著豐富的社區(qū)資源和代碼庫(kù),為編程提供良好的支持

英偉達(dá)的CUDA享有強(qiáng)大的社區(qū)資源,這個(gè)社區(qū)由專(zhuān)業(yè)的開(kāi)發(fā)者和領(lǐng)域?qū)<医M成,他們通過(guò)分享經(jīng)驗(yàn)和解答疑難問(wèn)題,為CUDA的學(xué)習(xí)和應(yīng)用提供了豐富的支持。另外,CUDA的代碼庫(kù)資源涵蓋各種計(jì)算應(yīng)用,具有極高的參考價(jià)值,為開(kāi)發(fā)者在并行計(jì)算領(lǐng)域的創(chuàng)新和實(shí)踐提供了寶貴的資源。這兩大特點(diǎn)共同推動(dòng)了CUDA在并行計(jì)算領(lǐng)域的領(lǐng)先地位。

CUDA 11.0 主要特點(diǎn)

4、CUDA 借助燕尾服效應(yīng),搭配 GeForce 覆蓋多元市場(chǎng)

CUDA技術(shù)最初是為了配合GeForce系列芯片而推出的,利用GeForce在游戲市場(chǎng)的廣泛覆蓋率,作為一個(gè)技術(shù)杠桿,推動(dòng)CUDA的普及和發(fā)展。作為一項(xiàng)可以幫助GeForce拓展新的市場(chǎng)的重要技術(shù),CUDA極大地提高了視頻和圖像應(yīng)用(如CyberLink、Motion DSP和Nero)的性能,實(shí)現(xiàn)了多倍的效率提升。

5、創(chuàng)業(yè)公司的大量采用使得 CUDA 應(yīng)用場(chǎng)景進(jìn)一步得到拓展,游戲不再是唯一應(yīng)用領(lǐng)域

隨著時(shí)間的推移,超過(guò)一百家創(chuàng)業(yè)公司開(kāi)始利用CUDA的強(qiáng)大計(jì)算能力,使其應(yīng)用領(lǐng)域得以擴(kuò)展,不再局限于游戲方面。在視頻編碼領(lǐng)域,英偉達(dá)與Elemental公司合作,利用并行計(jì)算技術(shù)加速了高清視頻的壓縮、上傳和存儲(chǔ)速度。這一成功的合作不僅體現(xiàn)了CUDA在各種場(chǎng)景下的適用性,也進(jìn)一步推動(dòng)了CUDA技術(shù)的發(fā)展。當(dāng)Elemental公司后被亞馬遜收購(gòu),其基于CUDA的視頻處理技術(shù)也成為AWS的服務(wù)組成部分,這一過(guò)程也讓CUDA的使用場(chǎng)景得到了進(jìn)一步的豐富和拓寬。

6、CUDA 形成完整生態(tài)鏈,通過(guò)大學(xué)普及學(xué)習(xí)以推廣 CUDA

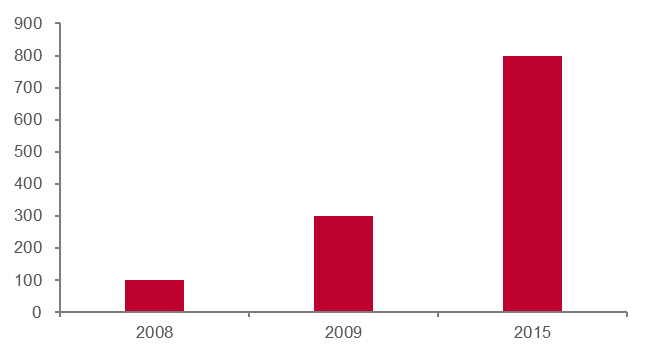

英偉達(dá)將 CUDA 引入了大學(xué)的課堂中,從源頭上擴(kuò)大了 CUDA 的使用范圍和受眾 群體。早在 2010 年,已經(jīng)有關(guān)于 CUDA 數(shù)千篇論文,超過(guò) 350 所大學(xué) 進(jìn)行 CUDA 教學(xué)課程。在此基礎(chǔ)之上,英偉達(dá)建立了 CUDA 認(rèn)證計(jì)劃、 研究中心、教學(xué)中心,不斷完善 CUDA 的生態(tài)鏈。從結(jié)果看:2008 年 僅有 100 所大學(xué)教學(xué) CUDA 課程,在 2010 年英偉達(dá)全球建立了 20 個(gè) CUDA 研發(fā)中心后,2015 年已有 800 所大學(xué)開(kāi)放 CUDA 課程。

大學(xué)教授 CUDA 數(shù)量(所)

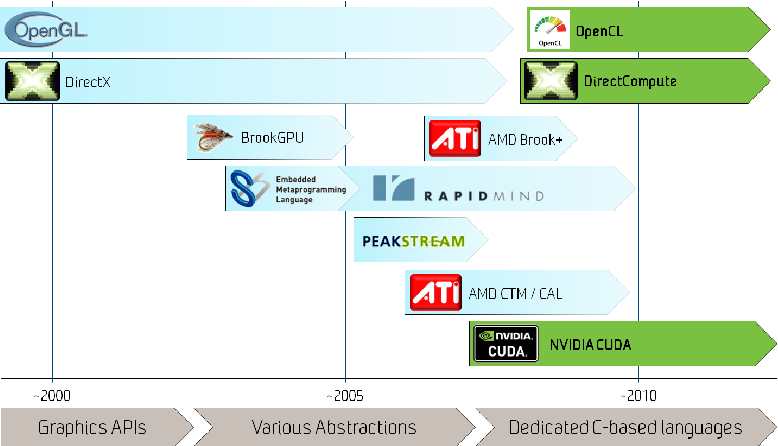

7、對(duì)比 OpenCL,CUDA 是英偉達(dá) GPU 編程的更優(yōu)解

雖然OpenCL具有更廣泛的兼容性,但CUDA與英偉達(dá)的GPU硬件緊密結(jié)合,可以更有效地利用其性能。此外,CUDA的編程模型更加簡(jiǎn)潔易用,提供完整的開(kāi)發(fā)工具鏈,并且擁有豐富的社區(qū)資源和多樣的代碼庫(kù),使得在科學(xué)計(jì)算、深度學(xué)習(xí)等領(lǐng)域的應(yīng)用更加方便。因此,對(duì)于英偉達(dá)GPU的開(kāi)發(fā)者來(lái)說(shuō),CUDA通常是更好的選擇。

CUDA 成為英偉達(dá)生態(tài)基礎(chǔ)

8、對(duì)比 ADM 的 CTM 編程模型,CUDA 擁有更廣泛的應(yīng)用和更高的操作性

操作性方面,CTM更接近硬件,因此開(kāi)發(fā)者需要具備更深入的硬件知識(shí)才能進(jìn)行開(kāi)發(fā)。但這也意味著CTM可以提供更精細(xì)的控制和優(yōu)化。相比之下,CUDA提供了一套完整的開(kāi)發(fā)工具鏈,包括編譯器、調(diào)試器和性能分析工具,以及豐富的庫(kù)函數(shù),為開(kāi)發(fā)者提供了極大的便利。在應(yīng)用方面,CUDA已經(jīng)在各種領(lǐng)域廣泛應(yīng)用,尤其是在科學(xué)計(jì)算和深度學(xué)習(xí)等領(lǐng)域,CUDA擁有大量的優(yōu)化庫(kù)和開(kāi)發(fā)工具。而CTM的應(yīng)用相對(duì)較少,但由于其提供了對(duì)硬件的低級(jí)別控制,因此在一些特定的應(yīng)用場(chǎng)景中具有優(yōu)勢(shì)。

GPU 編程平臺(tái)發(fā)展歷史

9、對(duì)比微軟的 DirectCompute, CUDA 勝在配套設(shè)施的支持

與DirectCompute相比,CUDA具有豐富的功能庫(kù)、完善的開(kāi)發(fā)工具和廣泛的應(yīng)用支持,尤其在科學(xué)計(jì)算和深度學(xué)習(xí)領(lǐng)域具有明顯優(yōu)勢(shì)。CUDA在英偉達(dá)GPU上的性能優(yōu)化也更為出色。而DirectCompute作為跨平臺(tái)工具,其優(yōu)勢(shì)在于與DirectX的兼容性以及對(duì)多種硬件的支持。但從英偉達(dá)GPU的應(yīng)用廣泛度來(lái)看,使用CUDA才是開(kāi)發(fā)者的首選。總的來(lái)說(shuō),雖然DirectCompute的通用性更強(qiáng),但英偉達(dá)的CUDA在功能、性能和應(yīng)用范圍上提供了更強(qiáng)大的支持,對(duì)于使用英偉達(dá)硬件的開(kāi)發(fā)者來(lái)說(shuō)是更優(yōu)的選擇。

三、抓住人工智能發(fā)展浪潮,順利轉(zhuǎn)型切入算力芯片領(lǐng)域

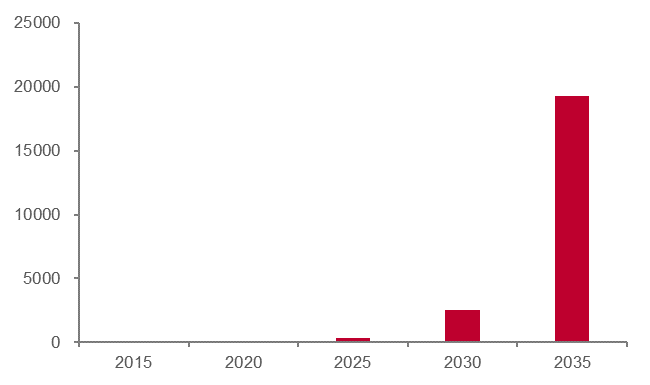

IDC的測(cè)算顯示,全球數(shù)據(jù)總量每年將以50%的增速不斷增長(zhǎng)。到2025年,數(shù)據(jù)量將增加至334ZB,到2035年則將達(dá)到19267ZB。隨著5G技術(shù)的落地,應(yīng)用方案將變得更加具象化,未來(lái)數(shù)據(jù)總量和數(shù)據(jù)分析需求將持續(xù)增加。數(shù)據(jù)增長(zhǎng)的主要來(lái)源包括IoT、移動(dòng)互聯(lián)網(wǎng)、智慧城市和自動(dòng)駕駛等領(lǐng)域。大數(shù)據(jù)的應(yīng)用將從商業(yè)分析向工業(yè)、交通、政府管理、醫(yī)療、教育等行業(yè)滲透,并成為產(chǎn)業(yè)供應(yīng)鏈中不可或缺的重要組成部分。

全球數(shù)據(jù)總量(ZB)

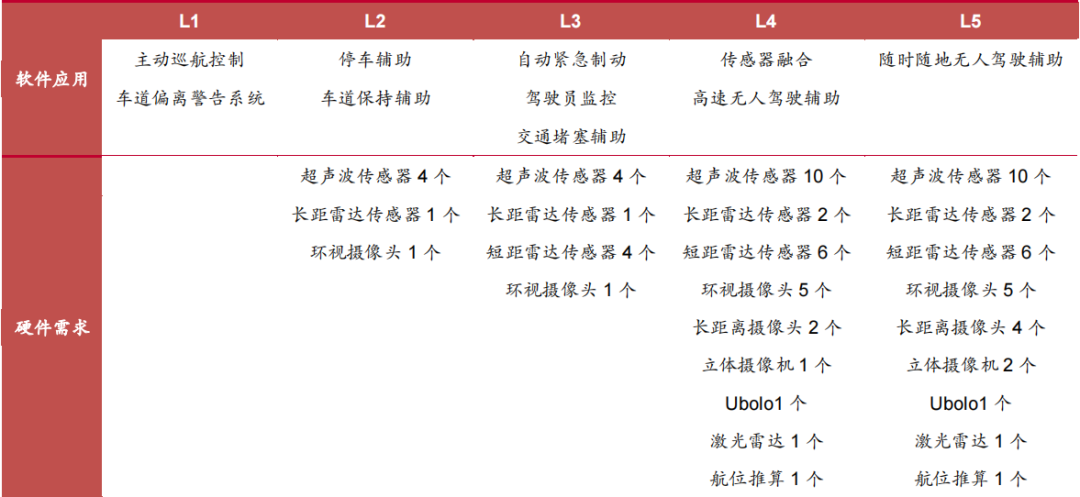

據(jù)目前的測(cè)算,智能駕駛將是對(duì)算力要求最高的應(yīng)用領(lǐng)域。一方面,汽車(chē)駕駛對(duì)于安全可靠性要求極高;另一方面,L5級(jí)別的自動(dòng)駕駛汽車(chē)將搭載32個(gè)傳感器,據(jù)麥肯錫估算,一輛自動(dòng)駕駛汽車(chē)的數(shù)據(jù)量將達(dá)到4TB/h,而Intel測(cè)算出的一天數(shù)據(jù)量將達(dá)到4000GB。然而,英偉達(dá)的Xavier目前只有1.3TFlops的處理能力,無(wú)法滿足處理L5級(jí)別數(shù)據(jù)的要求。智能駕駛和ADAS市場(chǎng)在未來(lái)的10年內(nèi)有望保持高速增長(zhǎng),因此智能駕駛以及ADAS領(lǐng)域存在著巨大的算力缺口。

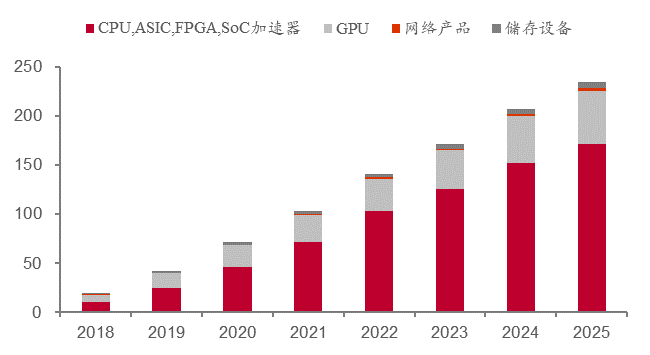

智能駕駛層級(jí)越高所需傳感器越多

根據(jù)Tractica的數(shù)據(jù),2018年全球AI硬件市場(chǎng)的收入為196億美元,其中GPU的收入占36.2%,即71億美元。預(yù)計(jì)到2025年,全球AI硬件市場(chǎng)的收入將達(dá)到2349億美元,其中GPU的收入占23.2%,即545億美元。盡管GPU市場(chǎng)占比會(huì)出現(xiàn)下滑,但全球AI硬件市場(chǎng)仍在不斷上升,為GPU市場(chǎng)帶來(lái)更多的增長(zhǎng)空間。

2018-2025 年 AI 硬件市場(chǎng)收入(十億美元)

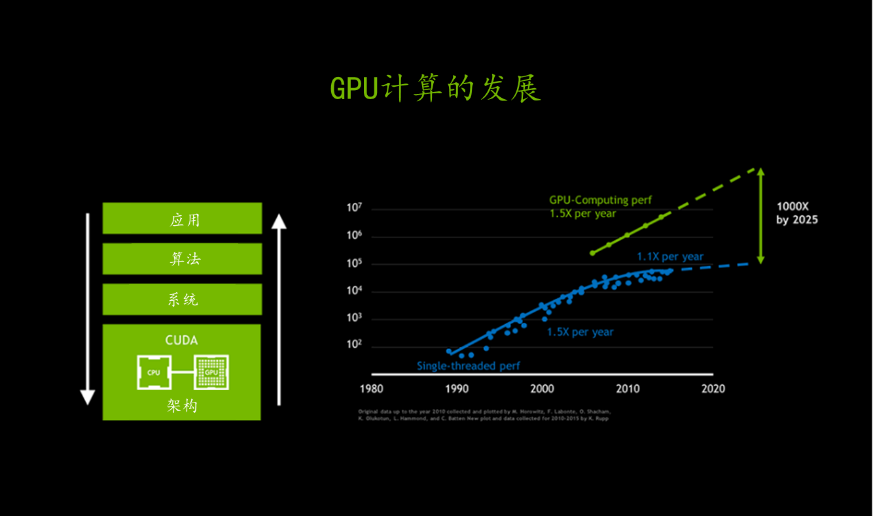

由于摩爾定律的放緩,CPU的應(yīng)用性能增幅已經(jīng)開(kāi)始下降。然而,人工智能的到來(lái)并沒(méi)有因此而停止。登納德定律通過(guò)縮小晶體管的尺寸和電壓,讓設(shè)計(jì)師在保持功率密度的同時(shí)提高晶體管的密度和速度。但是,由于物理?xiàng)l件的限制,CPU架構(gòu)師需要增加大量電路和能量,才能獲得有限的指令級(jí)并行性(ILP)。因此,在后摩爾定律時(shí)代,CPU晶體管需要消耗更多的性能,才能實(shí)現(xiàn)應(yīng)用性能的小幅提高。最近幾年,CPU的性能增長(zhǎng)速度僅為每年10%,而過(guò)去是每年50%。

GPU 打破摩爾定律

英偉達(dá)作為全球GPU市場(chǎng)的領(lǐng)導(dǎo)者,憑借其創(chuàng)新力和高市場(chǎng)份額,在行業(yè)中擁有龍頭地位。其持續(xù)的技術(shù)創(chuàng)新和強(qiáng)大的研發(fā)實(shí)力,尤其是CUDA并行計(jì)算平臺(tái)的推出,進(jìn)一步鞏固了其在市場(chǎng)中的優(yōu)越地位。英偉達(dá)的GPU已成為人工智能和機(jī)器學(xué)習(xí)加速應(yīng)用的首選解決方案,廣泛應(yīng)用于各個(gè)領(lǐng)域,從游戲和專(zhuān)業(yè)視覺(jué)應(yīng)用到數(shù)據(jù)中心和自動(dòng)駕駛汽車(chē)。英偉達(dá)成功的經(jīng)驗(yàn)在于持續(xù)深耕GPU高性能計(jì)算潛力,構(gòu)建強(qiáng)大的軟件護(hù)城河壁壘,加大研發(fā)投入,實(shí)施創(chuàng)新技術(shù),不斷更新GPU架構(gòu),拓展業(yè)務(wù)范圍,擴(kuò)大GPU市場(chǎng),提高營(yíng)收和利潤(rùn)率,達(dá)成產(chǎn)業(yè)鏈的良性循環(huán)。

國(guó)內(nèi)算力公司梳理

全球 AI 芯片市場(chǎng)被英偉達(dá)壟斷,然而國(guó)產(chǎn) AI 算力芯片正起星星之火。目前,國(guó)內(nèi)已涌現(xiàn)出了如寒武紀(jì)、海光信息等優(yōu)質(zhì)的 AI 算力芯片上市公司,非上市 AI 算力芯片公司如藍(lán)海大腦、沐曦、天數(shù)智芯、壁仞科技等亦在產(chǎn)品端有持續(xù)突破。

一、龍芯中科:國(guó)產(chǎn) CPU 設(shè)計(jì)標(biāo)桿,自主研發(fā) GPGPU

公司主要從事處理器(CPU)及配套芯片的研制、銷(xiāo)售及服務(wù),主要產(chǎn)品包括龍芯1號(hào)、龍芯2號(hào)、龍芯3號(hào)三大系列處理器芯片及橋片等配套芯片。這些系列產(chǎn)品已在電子政務(wù)、能源、交通、金融、電信、教育等行業(yè)領(lǐng)域廣泛應(yīng)用。龍芯通過(guò)自主指令系統(tǒng)構(gòu)建獨(dú)立于Wintel和AA體系的開(kāi)放信息技術(shù)體系的CPU,不斷推出基于LoongArch架構(gòu)的芯片,成功建立了自己的指令系統(tǒng)架構(gòu)LoongArch。在2021年和2022年,公司相繼推出了多款基于LA架構(gòu)的芯片產(chǎn)品,目前已擁有9顆基于LA架構(gòu)的芯片產(chǎn)品。

龍架構(gòu)

龍芯中科堅(jiān)持自主研發(fā)指令系統(tǒng)、IP核等核心技術(shù),掌握指令系統(tǒng)、處理器核微結(jié)構(gòu)、GPU以及各種接口IP等芯片核心技術(shù),在關(guān)鍵技術(shù)上進(jìn)行自主研發(fā),已取得專(zhuān)利400余項(xiàng)。GPU產(chǎn)品進(jìn)展順利,正研制新一代圖形及計(jì)算加速GPGPU核。據(jù)公司在2022年半年度業(yè)績(jī)交流會(huì)信息,第一代GPU核(LG100)已經(jīng)集成在7A2000中,新一代GPGPU核(LG200)的研制也取得了積極進(jìn)展。目前,公司正在啟動(dòng)第二代龍芯圖形處理器架構(gòu)LG200系列圖形處理器核的研制。龍芯中科在核心技術(shù)自主研發(fā)方面取得了顯著成果,為公司未來(lái)的發(fā)展奠定了堅(jiān)實(shí)的基礎(chǔ)。

二、海光信息:國(guó)產(chǎn)高端處理器龍頭,CPU+DCU 雙輪驅(qū)動(dòng)

公司主營(yíng)產(chǎn)品為海光通用處理器(CPU)和海光協(xié)處理器(DCU)。海光CPU分為7000、5000、3000三個(gè)系列,可應(yīng)用于高端服務(wù)器、中低端服務(wù)器和邊緣計(jì)算服務(wù)器。海光DCU是基于GPGPU架構(gòu)設(shè)計(jì)的協(xié)處理器,以8000系列為主,適用于服務(wù)器集群或數(shù)據(jù)中心。該產(chǎn)品全面兼容ROCm GPU計(jì)算生態(tài),能夠適配國(guó)際主流商業(yè)計(jì)算軟件,解決了產(chǎn)品推廣過(guò)程中的軟件生態(tài)兼容性問(wèn)題。

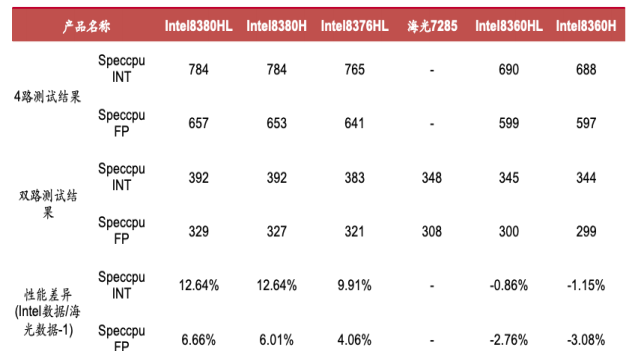

海光產(chǎn)品持續(xù)迭代,CPU方面海光一號(hào)和海光二號(hào)已實(shí)現(xiàn)量產(chǎn),海光三號(hào)已正式發(fā)布,海光四號(hào)進(jìn)入研發(fā)階段。雖然海光CPU性能在國(guó)內(nèi)處于領(lǐng)先地位,但在高端產(chǎn)品性能上與國(guó)際廠商有所差距,接近Intel中端產(chǎn)品水平。DCU方面,深算一號(hào)已實(shí)現(xiàn)商業(yè)化應(yīng)用,深算二號(hào)已于2020年1月啟動(dòng)研發(fā),在典型應(yīng)用場(chǎng)景下指標(biāo)達(dá)到國(guó)際上同類(lèi)型高端產(chǎn)品水平。高研發(fā)力度成為海光產(chǎn)品快速迭代的基石,從2019到2021年,海光信息的研發(fā)投入增長(zhǎng)83.3%,擁有千人級(jí)高端處理器研發(fā)團(tuán)隊(duì),且90.2%的員工是研發(fā)人員。公司已取得多項(xiàng)處理器核心技術(shù)突破,擁有179項(xiàng)專(zhuān)利、154項(xiàng)軟件著作權(quán)和81項(xiàng)集成電路布圖設(shè)計(jì)專(zhuān)有權(quán),構(gòu)建了全面的知識(shí)產(chǎn)權(quán)布局,CPU與DPU的持續(xù)迭代使性能比肩國(guó)際主流廠商。

海光 CPU 與 Intel 產(chǎn)品性能對(duì)比

三、寒武紀(jì):國(guó)產(chǎn) AI 芯片領(lǐng)先者

寒武紀(jì)是一家專(zhuān)注于人工智能芯片產(chǎn)品研發(fā)與技術(shù)創(chuàng)新的獨(dú)角獸公司,成立于2016年。公司的產(chǎn)品廣泛應(yīng)用于消費(fèi)電子、數(shù)據(jù)中心、云計(jì)算等多個(gè)場(chǎng)景。為了支持人工智能的各種應(yīng)用場(chǎng)景,公司推出了面向云端、邊緣端和終端的三個(gè)系列不同品類(lèi)的通用型智能芯片與處理器產(chǎn)品,包括終端智能處理器IP、云端智能芯片及加速卡、邊緣智能芯片及加速卡。寒武紀(jì)的產(chǎn)品線豐富,應(yīng)用場(chǎng)景廣泛,能夠滿足在云、邊、端各個(gè)尺度的人工智能計(jì)算需求。

在2022年3月,公司推出了新的訓(xùn)練加速卡MLU370-X8,該加速卡配備了雙芯片四核思元370,并整合了寒武紀(jì)MLU-Link多核互聯(lián)技術(shù),主要針對(duì)訓(xùn)練任務(wù)。在廣泛應(yīng)用于各個(gè)領(lǐng)域的YOLOv3、Transformer等訓(xùn)練任務(wù)中,8卡計(jì)算系統(tǒng)的并行性能平均超過(guò)了350WRTXGPU的155%。

高性能通用圖形處理器芯片及系統(tǒng)研發(fā)項(xiàng)目情況及進(jìn)程安排

藍(lán)海大腦高性能計(jì)算機(jī)是一款功能強(qiáng)大的GPU服務(wù)器,它具備開(kāi)放融合、超能運(yùn)算、高效運(yùn)維、液冷設(shè)計(jì)等多項(xiàng)特點(diǎn)。在開(kāi)放融合方面,該計(jì)算機(jī)系統(tǒng)融合了計(jì)算、網(wǎng)絡(luò)、存儲(chǔ)、GPU、虛擬化等多種技術(shù),支持主流虛擬化平臺(tái),同時(shí)也支持在線壓縮、重復(fù)數(shù)據(jù)自動(dòng)刪除、數(shù)據(jù)保護(hù)、容災(zāi)備份以及雙活等功能。

在超能運(yùn)算方面,該計(jì)算機(jī)系統(tǒng)支持主流GPU顯卡虛擬化,支持2、8、16塊全高全長(zhǎng)卡,提高計(jì)算性能和圖像渲染能力,同時(shí)也可以快速實(shí)現(xiàn)系統(tǒng)擴(kuò)展,支持大規(guī)模并發(fā)運(yùn)行。在高效運(yùn)維方面,該計(jì)算機(jī)系統(tǒng)提供一站式部署,開(kāi)箱即用,同時(shí)也具備強(qiáng)大的數(shù)據(jù)、網(wǎng)絡(luò)、虛擬化及管理安全保障。

此外,該計(jì)算機(jī)系統(tǒng)還采用了液冷設(shè)計(jì),可以連續(xù)安靜熱轉(zhuǎn)換,停機(jī)時(shí)間少,所有顯卡不會(huì)因過(guò)熱而縮短跳動(dòng)周期,顯著減少體積和熱量的產(chǎn)生,液冷系統(tǒng)密度更高、更節(jié)能、防噪音效果更好。此外,該計(jì)算機(jī)系統(tǒng)還支持2顆英特爾? 至強(qiáng)? 可擴(kuò)展處理器家族CPU,提供16-56物理核心龍芯、飛騰、申威(可選)、英偉達(dá)A100、H100、A6000等多種顯卡多種選擇,可為用戶提供更加靈活、高效的計(jì)算服務(wù)。

總結(jié)

總之,隨著人工智能技術(shù)的不斷發(fā)展,對(duì)高性能計(jì)算的需求也在不斷增長(zhǎng)。英偉達(dá)作為計(jì)算機(jī)芯片制造商之一,通過(guò)技術(shù)進(jìn)步和產(chǎn)品創(chuàng)新不斷提高自身競(jìng)爭(zhēng)力。未來(lái),國(guó)產(chǎn)AI供應(yīng)商也有望在產(chǎn)業(yè)創(chuàng)新趨勢(shì)和國(guó)產(chǎn)替代背景下進(jìn)入快速增長(zhǎng)通道。可以預(yù)見(jiàn)的是,算力產(chǎn)業(yè)鏈將會(huì)快速增長(zhǎng),為人工智能應(yīng)用的落地提供強(qiáng)大的支撐。

審核編輯黃宇

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5072瀏覽量

103509 -

AI

+關(guān)注

關(guān)注

87文章

31442瀏覽量

269836 -

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3835瀏覽量

91652 -

算力

+關(guān)注

關(guān)注

1文章

1009瀏覽量

14903

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

一文看懂5G通感一體化

算力調(diào)度的基礎(chǔ)知識(shí)

存算一體化與邊緣計(jì)算:重新定義智能計(jì)算的未來(lái)

存算一體架構(gòu)創(chuàng)新助力國(guó)產(chǎn)大算力AI芯片騰飛

青云科技強(qiáng)化AI算力架構(gòu),升級(jí)產(chǎn)品與服務(wù)體系

燧弘華創(chuàng)助力慶陽(yáng)構(gòu)建算力產(chǎn)業(yè)生態(tài)

中科曙光入選2024算力服務(wù)產(chǎn)業(yè)圖譜及算力服務(wù)產(chǎn)品名錄

曙光攜手“算力互聯(lián)公共服務(wù)平臺(tái)”提高全國(guó)算力匹配效率

助力全國(guó)一體化算力網(wǎng)建設(shè),神州鯤泰以算力構(gòu)建新質(zhì)生產(chǎn)力

天翼云發(fā)布智算平臺(tái)能力體系

工信部:算力驅(qū)動(dòng)經(jīng)濟(jì)社會(huì)高質(zhì)量發(fā)展

聚焦全國(guó)一體化算力體系構(gòu)建,憶聯(lián)以強(qiáng)大存力“引擎”釋放算力潛能

研發(fā)為底、生態(tài)為徑、AI為翼——全國(guó)一體化算力算網(wǎng)調(diào)度平臺(tái)正式發(fā)布

研發(fā)為底、生態(tài)為徑、AI為翼——全國(guó)一體化算力算網(wǎng)調(diào)度平臺(tái)正式發(fā)布

評(píng)論