?請先下載本文的范例代碼倉,并搭建好YOLOv8的OpenVINO推理程序開發環境。

git clone https://gitee.com/ppov-nuc/yolov8_openvino.git

導出YOLOv8-seg實例分割OpenVINO IR模型

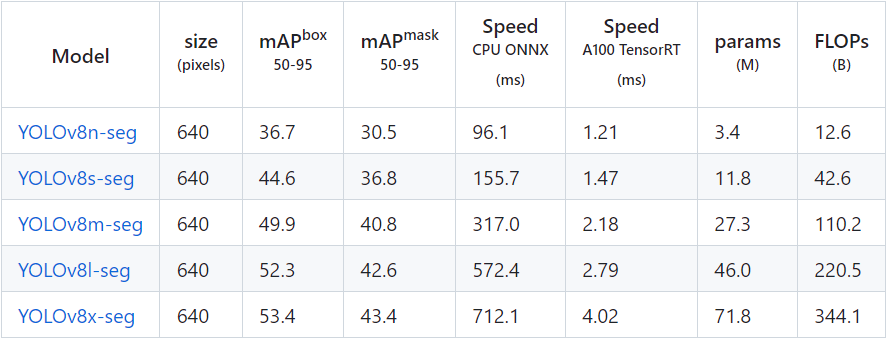

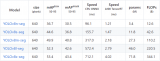

YOLOv8-seg的實例分割模型有5種,在COCO數據集完成訓練,如下表所示。

?請先下載本文的范例代碼倉,并搭建好YOLOv8的OpenVINO推理程序開發環境。

git clone https://gitee.com/ppov-nuc/yolov8_openvino.git

導出YOLOv8-seg實例分割OpenVINO IR模型

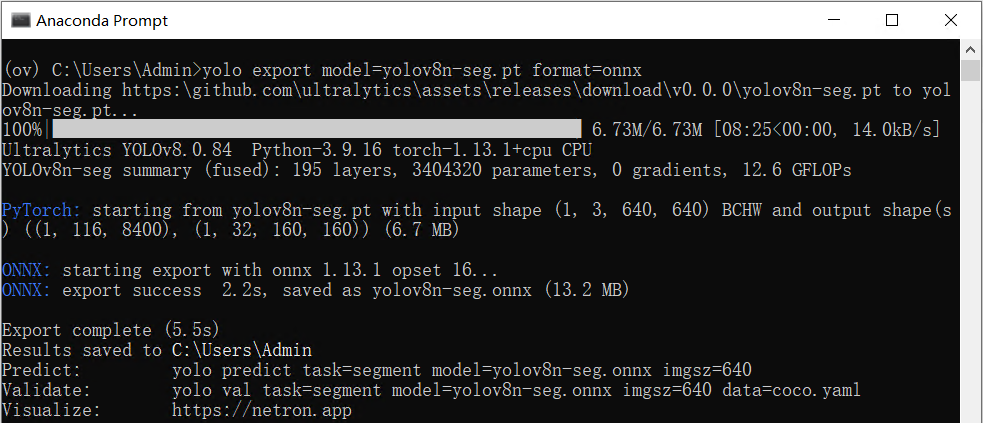

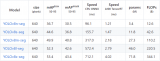

YOLOv8-seg的實例分割模型有5種,在COCO數據集完成訓練,如下表所示。 ?首先使用命令:yolo export model=yolov8n-seg.pt format=onnx,完成yolov8n-seg.onnx模型導出,如下圖所示。

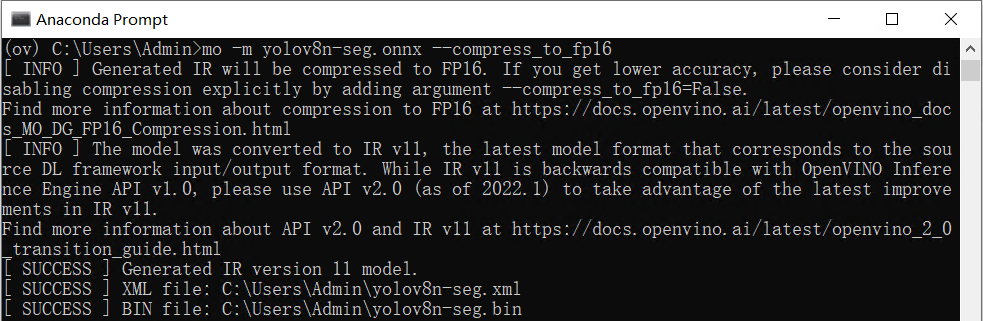

?首先使用命令:yolo export model=yolov8n-seg.pt format=onnx,完成yolov8n-seg.onnx模型導出,如下圖所示。 ?然后使用命令:mo -m yolov8n-seg.onnx --compress_to_fp16,優化并導出FP16精度的OpenVINO IR格式模型,如下圖所示。

?然后使用命令:mo -m yolov8n-seg.onnx --compress_to_fp16,優化并導出FP16精度的OpenVINO IR格式模型,如下圖所示。 ?

?用benchmark_app測試YOLOv8-seg實例分割模型的推理計算性能

benchmark_app是OpenVINOTM工具套件自帶的AI模型推理計算性能測試工具,可以指定在不同的計算設備上,在同步或異步模式下,測試出不帶前后處理的純AI模型推理計算性能。

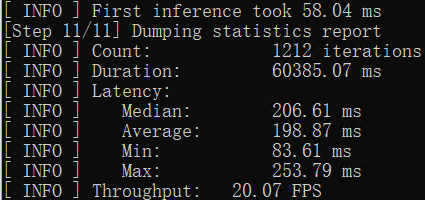

使用命令:benchmark_app -m yolov8n-seg.xml -d GPU,獲得yolov8n-seg.xml模型在AI愛克斯開發板的集成顯卡上的異步推理計算性能,如下圖所示。

?

?用benchmark_app測試YOLOv8-seg實例分割模型的推理計算性能

benchmark_app是OpenVINOTM工具套件自帶的AI模型推理計算性能測試工具,可以指定在不同的計算設備上,在同步或異步模式下,測試出不帶前后處理的純AI模型推理計算性能。

使用命令:benchmark_app -m yolov8n-seg.xml -d GPU,獲得yolov8n-seg.xml模型在AI愛克斯開發板的集成顯卡上的異步推理計算性能,如下圖所示。 ?

?使用OpenVINO Python API編寫YOLOv8-seg實例分割模型推理程序

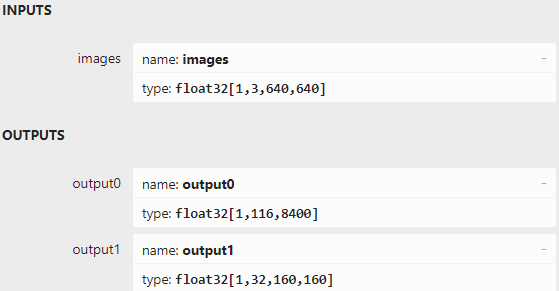

用Netron打開yolov8n-seg.onnx可以看到模型的輸入和輸出,跟YOLOv5-seg模型的輸入輸出定義很類似:

?

?使用OpenVINO Python API編寫YOLOv8-seg實例分割模型推理程序

用Netron打開yolov8n-seg.onnx可以看到模型的輸入和輸出,跟YOLOv5-seg模型的輸入輸出定義很類似:-

輸入節點名字:“images”;數據:float32[1,3,640,640]。

-

輸出節點1的名字:“output0”;數據:float32[1,116,8400]。其中116的前84個字段跟 YOLOv8目標檢測模型輸出定義完全一致,即cx,cy,w,h和80類的分數;后32個字段用于計算掩膜數據。

-

輸出節點2的名字:“output1”;數據:float32[1,32,160,160]。output0后32個字段與output1的數據做矩陣乘法后得到的結果,即為對應目標的掩膜數據。

基于OpenVINO Python API的YOLOv8-seg實例分割模型范例程序yolov8_seg_ov_sync_infer_demo.py的核心源代碼,如下所示:

基于OpenVINO Python API的YOLOv8-seg實例分割模型范例程序yolov8_seg_ov_sync_infer_demo.py的核心源代碼,如下所示:# Initialize the VideoCapture

cap =cv2.VideoCapture("store-aisle-detection.mp4")

# Initialize YOLOv5 Instance Segmentator

model_path ="yolov8n-seg.xml"

device_name ="GPU"

yoloseg =YOLOSeg(model_path, device_name, conf_thres=0.3, iou_thres=0.3)

whilecap.isOpened():

# Read frame from the video

ret, frame =cap.read()

ifnotret:

break

# Update object localizer

start =time.time()

boxes, scores, class_ids, masks =yoloseg(frame)

# postprocess and draw masks

combined_img =yoloseg.draw_masks(frame)

end =time.time()

# show FPS

fps =(1/(end -start))

fps_label ="Throughput: %.2fFPS"%fps

cv2.putText(combined_img, fps_label, (10, 25), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 0, 255), 2)

# show ALL

cv2.imshow("YOLOv8 Segmentation OpenVINO inference Demo", combined_img)

# Press Any key stop

ifcv2.waitKey(1) >-1:

print("finished by user")

break

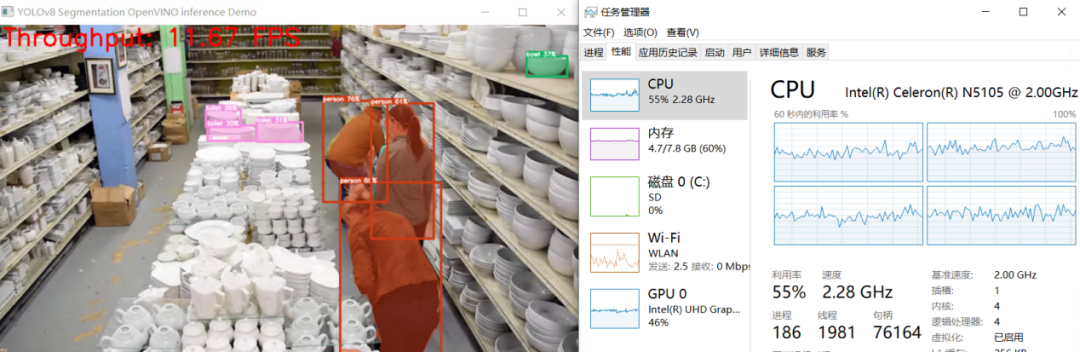

運行結果,如下圖所示: 結 論

AI愛克斯開發板借助N5105處理器的集成顯卡(24個執行單元)和OpenVINO,可以在YOLOv8-seg的實例分割模型上獲得相當不錯的性能。通過異步處理和AsyncInferQueue,還能進一步提升計算設備的利用率,提高AI推理程序的吞吐量。下一篇將繼續介紹在《在AI愛克斯開發板上用OpenVINO加速YOLOv8-pose姿態檢測模型》。

審核編輯 :李倩

結 論

AI愛克斯開發板借助N5105處理器的集成顯卡(24個執行單元)和OpenVINO,可以在YOLOv8-seg的實例分割模型上獲得相當不錯的性能。通過異步處理和AsyncInferQueue,還能進一步提升計算設備的利用率,提高AI推理程序的吞吐量。下一篇將繼續介紹在《在AI愛克斯開發板上用OpenVINO加速YOLOv8-pose姿態檢測模型》。

審核編輯 :李倩-

開發板

+關注

關注

25文章

5119瀏覽量

97949 -

模型

+關注

關注

1文章

3294瀏覽量

49038 -

目標檢測

+關注

關注

0文章

211瀏覽量

15646

原文標題:?在AI愛克斯開發板上用OpenVINO加速YOLOv8-seg實例分割模型

文章出處:【微信號:SDNLAB,微信公眾號:SDNLAB】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

在C++中使用OpenVINO工具包部署YOLOv5-Seg模型

【愛芯派 Pro 開發板試用體驗】yolov8模型轉換

在英特爾獨立顯卡上部署YOLOv5 v7.0版實時實例分割模型

在C++中使用OpenVINO工具包部署YOLOv5模型

自訓練Pytorch模型使用OpenVINO?優化并部署在AI愛克斯開發板

在英特爾開發者套件上用OpenVINO? 2023.0加速YOLOv8-Pose姿態估計模型

用OpenVINO? C++ API編寫YOLOv8-Seg實例分割模型推理程序

基于OpenVINO在英特爾開發套件上實現眼部追蹤

基于哪吒開發板部署YOLOv8模型

?在AI愛克斯開發板上用OpenVINO加速YOLOv8-seg實例分割模型

?在AI愛克斯開發板上用OpenVINO加速YOLOv8-seg實例分割模型

評論