問題

卷積神經(jīng)網(wǎng)絡是一類包含卷積計算且具有深度結(jié)構(gòu)的前饋神經(jīng)網(wǎng)絡,是深度學習。卷積神經(jīng)網(wǎng)絡具有表征學習能力,能夠按其階層結(jié)構(gòu)對輸入信息進行平移不變分類,因此也被稱為“平移不變?nèi)斯ど窠?jīng)網(wǎng)絡。

全連接神經(jīng)網(wǎng)絡是具有多層感知器的的網(wǎng)絡,也就是多層神經(jīng)元的網(wǎng)絡。層與層之間需要包括一個非線性激活函數(shù),需要有一個對輸入和輸出都隱藏的層,還需要保持高度的連通性,由網(wǎng)絡的突觸權(quán)重決定。那兩者的區(qū)別是什么呢?

方法

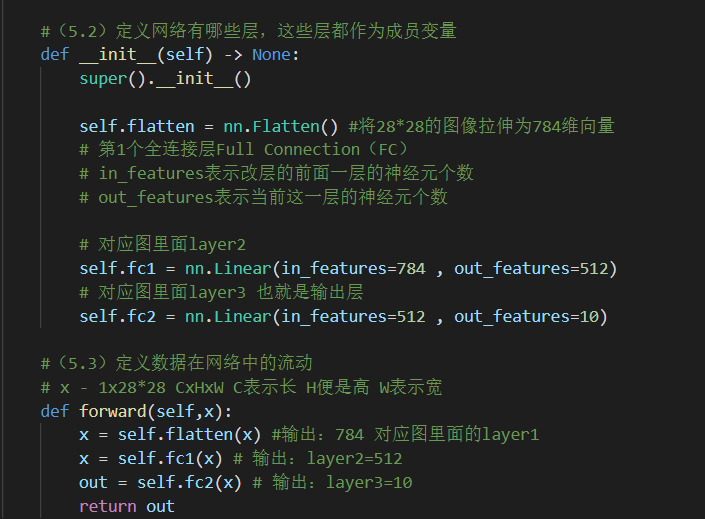

卷積神經(jīng)網(wǎng)絡也是通過一層一層的節(jié)點組織起來的。和全連接神經(jīng)網(wǎng)絡一樣,卷積神經(jīng)網(wǎng)絡中的每一個節(jié)點就是一個神經(jīng)元。在全連接神經(jīng)網(wǎng)絡中,每相鄰兩層之間的節(jié)點都有邊相連,于是會將每一層的全連接層中的節(jié)點組織成一列,這樣方便顯示連接結(jié)構(gòu)。而對于卷積神經(jīng)網(wǎng)絡,相鄰兩層之間只有部分節(jié)點相連,為了展示每一層神經(jīng)元的維度,一般會將每一層卷積層的節(jié)點組織成一個三維矩陣。

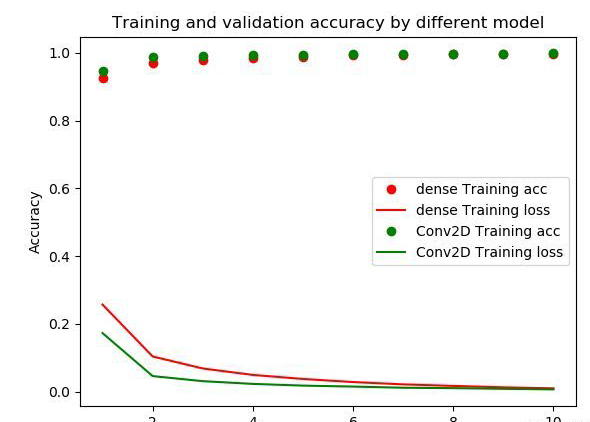

除了結(jié)構(gòu)相似,卷積神經(jīng)網(wǎng)絡的輸入輸出以及訓練的流程和全連接神經(jīng)網(wǎng)絡也基本一致,以圖像分類為列,卷積神經(jīng)網(wǎng)絡的輸入層就是圖像的原始圖像,而輸出層中的每一個節(jié)點代表了不同類別的可信度。這和全連接神經(jīng)網(wǎng)絡的輸入輸出是一致的。類似的,全連接神經(jīng)網(wǎng)絡的損失函數(shù)以及參數(shù)的優(yōu)化過程也都適用于卷積神經(jīng)網(wǎng)絡。因此,全連接神經(jīng)網(wǎng)絡和卷積神經(jīng)網(wǎng)絡的唯一區(qū)別就是神經(jīng)網(wǎng)絡相鄰兩層的連接方式。

但是全神經(jīng)網(wǎng)絡無法很好地處理好圖像數(shù)據(jù),然而卷積神經(jīng)網(wǎng)絡卻很好地客服了這個缺點,使用全連接神經(jīng)網(wǎng)絡處理圖像的最大問題就是:全連接層的參數(shù)太多,對于MNIST數(shù)據(jù),每一張圖片的大小是28*28*1,其中28*28代表的是圖片的大小,*1表示圖像是黑白的,有一個色彩通道。假設第一層隱藏層的節(jié)點數(shù)為500個,那么一個全連接層的神經(jīng)網(wǎng)絡有28*28*500+500=392500個參數(shù),而且有的圖片會更大或者是彩色的圖片,這時候參數(shù)將會更多。參數(shù)增多除了導致計算速度減慢,還很容易導致過擬合的問題。所以需要一個合理的神經(jīng)網(wǎng)絡結(jié)構(gòu)來有效的減少神經(jīng)網(wǎng)絡中參數(shù)的個數(shù)。卷積神經(jīng)網(wǎng)絡就可以更好的達到這個目的。

|

from keras import layers  |

結(jié)語

全連接網(wǎng)絡沒有卷積層,只使用全連接層(以及非線性層)。

以關(guān)鍵是理解卷積層和全連接層的區(qū)別。

全連接層有三個特點:

關(guān)注全局信息(每個點都和前后層的所有點鏈接)

參數(shù)量巨大,計算耗時

輸入維度需要匹配(因為是矩陣運算,維度不一致無法計算)

卷積層

這個卷積和信號系統(tǒng)中的卷積不太一樣,其實就是一個簡單的乘加運算,

局部鏈接:當前層的神經(jīng)元只和下一層神經(jīng)元的局部鏈接(并不是全連接層的全局鏈接)

權(quán)重共享:神經(jīng)元的參數(shù)(如上圖的3*3卷積核),在整個特征圖上都是共享的,而不是每個滑動窗口都不同

也正是因為這兩個特性,所以卷積層相比于全連接層有如下優(yōu)點:

需要學習的參數(shù)更少,從而降低了過度擬合的可能性,因為該模型不如完全連接的網(wǎng)絡復雜。

只需要考慮中的上下文/共享信息。這個未來在許多應用中非常重要,例如圖像、視頻、文本和語音處理/挖掘,因為相鄰輸入(例如像素、幀、單詞等)通常攜帶相關(guān)信息。

但需要注意的是,無論是全連接層,還是卷積層,都是線性層,只能擬合線性函數(shù),所以都需要通過ReLU等引入非線性,以增加模型的表達能力。比如ReLU函數(shù)接受一個輸入x,并返回{0, x}的最大值。ReLU(x) = argmax(x, 0)。

-

神經(jīng)網(wǎng)絡

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101063 -

深度學習

+關(guān)注

關(guān)注

73文章

5512瀏覽量

121431 -

卷積神經(jīng)網(wǎng)絡

+關(guān)注

關(guān)注

4文章

367瀏覽量

11894

發(fā)布評論請先 登錄

相關(guān)推薦

全連接神經(jīng)網(wǎng)絡和卷積神經(jīng)網(wǎng)絡有什么區(qū)別

全卷積網(wǎng)絡FCN進行圖像分割

卷積神經(jīng)網(wǎng)絡中全連接層作用理解總結(jié)

卷積網(wǎng)絡和全連接網(wǎng)絡的比較

PyTorch教程14.11之全卷積網(wǎng)絡

如何區(qū)分卷積網(wǎng)絡與全連接網(wǎng)絡

如何區(qū)分卷積網(wǎng)絡與全連接網(wǎng)絡

評論