今年來溫哥華參加的siggraph也是第二次參加這種檔次的會議,我比較關(guān)注計算影像學(xué)。

1. Centimeter-Wave Free-Space Time-of-Flight Imaging

深度相機(jī)正在成為一種基石模式,具有直接或間接依賴于測量深度的多種應(yīng)用,包括個人設(shè)備、機(jī)器人和自動駕駛汽車。盡管飛行時間 (ToF) 方法推動了這些應(yīng)用,但 ToF 方法的精度和魯棒性受到依賴于光子時間標(biāo)記或光轉(zhuǎn)換后調(diào)制的限制。成功的光調(diào)制方法有大耦合損耗的受限光纖耦合調(diào)制或亞厘米范圍的干涉調(diào)制,干涉方法與ToF方法之間的精度差距超過三個數(shù)量級。在這項(xiàng)工作中,我們縮小了這一差距,并提出了一種用于光轉(zhuǎn)換前的全光學(xué)自由空間相關(guān)的計算成像方法,該方法通過傳統(tǒng)的硅強(qiáng)度傳感器實(shí)現(xiàn)了微米級深度分辨率,并對表面反射率和環(huán)境光具有魯棒性。為此,我們解決了兩個技術(shù)挑戰(zhàn):以 GHz 速率調(diào)制和計算相位展開。我們提出了一種具有諧振偏振調(diào)制器的成像方法,并設(shè)計了一種新穎的光學(xué)雙通倍頻,可在超過 10GHz 時實(shí)現(xiàn)高調(diào)制對比度。同時,厘米波調(diào)制以及較小的調(diào)制帶寬使現(xiàn)有的相位展開方法無效。我們使用一種神經(jīng)相位展開方法來解決這個問題,該方法利用相鄰的包裹通常高度相關(guān)。我們在模擬和實(shí)驗(yàn)中驗(yàn)證了所提出的方法,它達(dá)到了微米級的深度精度。我們展示了獨(dú)立于表面紋理和環(huán)境光的精確深度感應(yīng),并與現(xiàn)有的模擬解調(diào)方法進(jìn)行了比較,我們在所有測試場景中都表現(xiàn)出色。

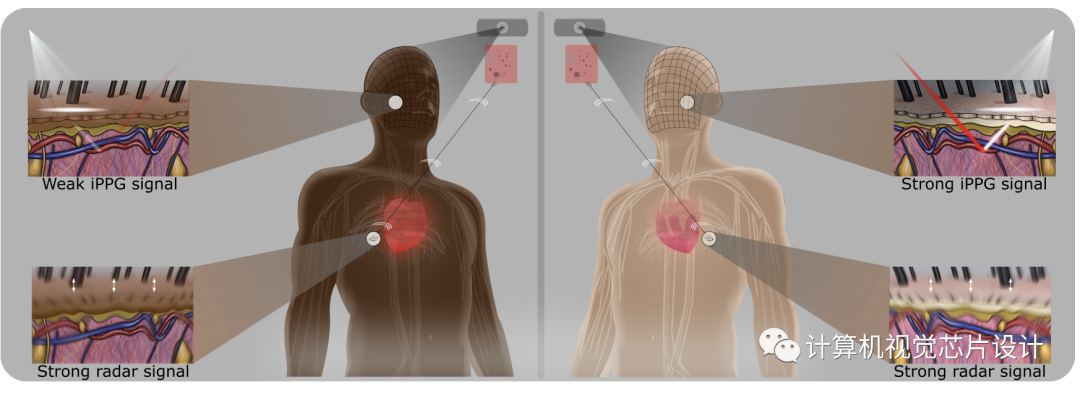

2. Blending Camera and 77 GHz Radar Sensing for Equitable, Robust Plethysmography.

隨著因 COVID-19 大流行而導(dǎo)致的非接觸式生命體征傳感的復(fù)蘇,遠(yuǎn)程心率監(jiān)測已獲得顯著的重視。許多現(xiàn)有方法使用相機(jī);然而,之前的工作顯示較深膚色的性能損失。在本文中,我們通過光傳輸分析表明,相機(jī)模式從根本上偏向于較深的膚色。我們建議通過多模態(tài)融合與互補(bǔ)和更公平的模態(tài)——雷達(dá)來減少這種偏差。通過一種新穎的面向去偏的融合框架,我們在所有測試基線上實(shí)現(xiàn)了性能提升,并在 RGB 模態(tài)上實(shí)現(xiàn)了膚色公平性改進(jìn)。此外,與基于雷達(dá)的方法相比,性能得到了改進(jìn),但公平性方面的權(quán)衡很小。我們還開源了最大的多模式遠(yuǎn)程心率估計數(shù)據(jù)集,其中包括配對相機(jī)和雷達(dá)測量,重點(diǎn)是膚色表示。

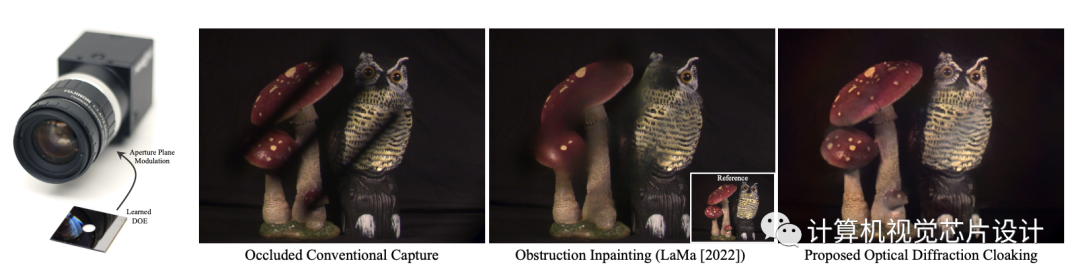

3. Seeing Through Obstructions With Diffractive Cloaking

我們提出了一種計算單目相機(jī),它可以在光學(xué)上隱藏不需要的障礙物,例如鏡頭蓋玻璃上的雨滴或污漬,或相機(jī)附近的柵欄。我們沒有在捕獲后修復(fù)被遮擋的信息,而是學(xué)習(xí)了一個定制的衍射光學(xué)元件,當(dāng)它放置在相機(jī)鏡頭前時,它充當(dāng)了一個與深度相關(guān)的散射體。學(xué)習(xí)到的光學(xué)元件位于現(xiàn)有相機(jī)設(shè)置的孔徑平面上,并產(chǎn)生一個點(diǎn)擴(kuò)散函數(shù),為近距離物體提供大空間支持,將光線從焦點(diǎn)處散射出去。同時在不增加相機(jī)占用空間的情況下保持長距離的空間分辨率。結(jié)合光學(xué)元件,我們共同優(yōu)化了一個基于特征的深度學(xué)習(xí)重建網(wǎng)絡(luò)來恢復(fù)通暢的圖像。

4. Optical Aberrations Correction in Postprocessing Using Imaging Simulation

隨著移動攝影的不斷普及,人們正在投入大量精力來重建退化的圖像。由于在鏡頭設(shè)計過程中無法避免的光學(xué)像差的空間變化,最近的商用相機(jī)已將其中一些校正任務(wù)從光學(xué)設(shè)計轉(zhuǎn)移到后處理系統(tǒng)。然而,在不涉及光學(xué)參數(shù)的情況下,這些系統(tǒng)只能實(shí)現(xiàn)有限的像差校正。

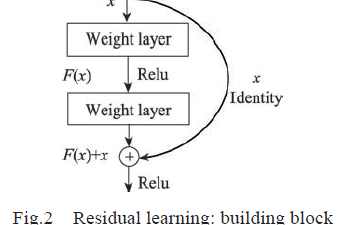

在這項(xiàng)工作中,我們提出了一種實(shí)用的方法來恢復(fù)由光學(xué)像差引起的退化。具體來說,我們建立了基于我們提出的光學(xué)點(diǎn)擴(kuò)散函數(shù)模型的成像模擬系統(tǒng)。給定相機(jī)的光學(xué)參數(shù),它會生成這些特定設(shè)備的成像結(jié)果。為了進(jìn)行恢復(fù),我們在成像模擬系統(tǒng)生成的合成數(shù)據(jù)對上設(shè)計了一個空間自適應(yīng)網(wǎng)絡(luò)模型,消除了通過大量拍攝和配準(zhǔn)捕獲訓(xùn)練數(shù)據(jù)的開銷。

此外,我們分別使用定制的數(shù)字單鏡頭反光相機(jī)鏡頭和 HUAWEI HONOR 20 在模擬和實(shí)驗(yàn)中全面評估了所提出的方法。實(shí)驗(yàn)表明,我們的解決方案成功地消除了空間變化的模糊和色散。與最先進(jìn)的去模糊方法相比,所提出的方法以更低的計算開銷實(shí)現(xiàn)了更好的結(jié)果。此外,重建技術(shù)沒有引入人工紋理,便于移植到當(dāng)前的商用相機(jī)中。

-

網(wǎng)絡(luò)

+關(guān)注

關(guān)注

14文章

7597瀏覽量

89110 -

影像

+關(guān)注

關(guān)注

0文章

131瀏覽量

14528 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5512瀏覽量

121413

原文標(biāo)題:2022 Siggraph:計算影像學(xué)(1)

文章出處:【微信號:計算機(jī)視覺芯片設(shè)計,微信公眾號:計算機(jī)視覺芯片設(shè)計】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

通過深度學(xué)習(xí)的圖像三維物體重建研究方案

深度學(xué)習(xí)介紹

基于深度學(xué)習(xí)的多尺幅深度網(wǎng)絡(luò)監(jiān)督模型

數(shù)據(jù)外補(bǔ)償?shù)?b class='flag-5'>深度網(wǎng)絡(luò)超分辨率重建

基于鄰域特征學(xué)習(xí)的單幅圖像超分辨重建

一種新的目標(biāo)分類特征深度學(xué)習(xí)模型

基于深度學(xué)習(xí)的圖像塊型超分辨重建的經(jīng)典論文進(jìn)行關(guān)鍵技術(shù)點(diǎn)分析

圖像恢復(fù)這個任務(wù),如何使用深度圖像先驗(yàn)來解決此任務(wù)

深度學(xué)習(xí)不是萬靈藥 神經(jīng)網(wǎng)絡(luò)3D建模其實(shí)只是圖像識別

深度學(xué)習(xí)時代的來為基于圖像的三維重建提供了新的可能

一種多層級特征融合就的深度卷積網(wǎng)絡(luò)

基于特征圖注意力機(jī)制的圖像超分辨重建網(wǎng)絡(luò)模型

基于復(fù)合的深度神經(jīng)網(wǎng)絡(luò)的圖像超分辨率重建

基于特征深度學(xué)習(xí)重建網(wǎng)絡(luò)來恢復(fù)通暢的圖像

基于特征深度學(xué)習(xí)重建網(wǎng)絡(luò)來恢復(fù)通暢的圖像

評論