相機標定在計算機視覺和機器人等領域中占據舉足輕重的地位,它為后續場景理解及決策推斷提供了標準化的成像空間和精準的幾何先驗。然而,傳統的相機標定技術常常依賴于繁瑣的人工干預和特定的場景假設,因此難以靈活拓展至不同的相機模型和標定場景。近年來,基于深度學習的解決方案展現出代替手動操作、擺脫場景假設的潛力,實現了全自動化的相機標定技術。在這些方案中,各種各樣的學習機制、網絡架構、先驗知識、優化函數、數據集等方面均得到了廣泛的研究。

本綜述首次系統性地概述了深度學習驅動下的相機標定技術,涵蓋了深度學習時代以來(8年時間跨度)各類相機模型標定及其應用的最新研究進展。主要探索的標定類別包括標準針孔相機模型、畸變相機模型、跨視角模型和跨傳感器模型等。該路線緊密契合了基于深度學習的相機標定的研究趨勢和實際市場需求。在每個類別中,相應技術發展的貢獻點、優勢、局限性得到了充分論述,具體的未來研究技術點也進行了一定展望。此外,本文還整合、構建了一個公開且全面的評測基準數據集,可作為開放平臺用于不同研究方法的性能評測。該數據集包括了不同仿真環境下生成的合成數據,以及不同場景下由各類真實相機采集到的圖像和視頻序列。每一個數據樣本均提供了準確的標定結果、相機參數、或視覺線索。最后,我們討論了整個基于深度學習的相機標定領域仍然存在的挑戰以及未來可能的研究方向。

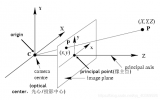

一、相機模型及標定目標

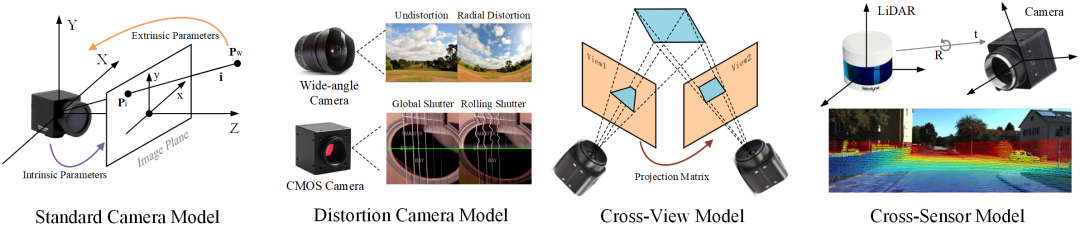

相機模型描述了從三維世界坐標中的點到其在二維圖像平面上投影的成像過程。其中,不同的相機和傳感器系統對應不同類型的參數模型。在本綜述中,我們首先回顧了標準的針孔相機模型涉及的內外相機參數以及幾何表征。隨后,我們根據基于深度學習的相機標定技術發展和市場需求回顧了更加復雜的模型,如廣角/魚眼相機模型、卷簾門模型、跨視角模型和相機-雷達聯合模型。特別地,考慮到傳統相機標定中部分標定目標的隱式性和異質性,我們還歸納總結了該領域利于神經網絡學習的新標定目標。這些新目標能夠加速訓練損失收斂并有助于提高標定性能。更多細節詳見本綜述補充材料的第二部分。

本綜述涵蓋了目前市場主流的相機模型、標定目標及其拓展應用

二、基于深度學習的相機標定范式及策略

在工業界和學術界中,有一些標準的相機標定技術可供選擇(如OpenCV、Kalibr),因此這個過程通常在計算機視覺的最新發展中被忽視。然而,使用傳統方法對單個或自然圖像和序列(in the wild)進行標定仍然極具挑戰,特別是當待標定數據來自互聯網或未知的相機模型。近年來,深度學習為相機標定技術帶來了新的靈感,實現了無需人工干預的全自動標定過程。本綜述首先從學習范式和學習策略這兩個方面對基于深度學習的相機標定進行分類總結。

學習范式

受不同神經網絡架構的啟發,研究人員開發出了兩種主流的深度學習相機標定范式。

第一種稱為回歸范式,使用具有卷積和全連接層的神經網絡從輸入中回歸標定目標。隨后,回歸得到的相機參數用于進行后續任務,如畸變矯正、相機定位、三維重建等。這種學習范式在該領域內最早得到研究,各類標定模型的第一個深度學習工作均屬于回歸范式,如內參標定(Deepfocal[21]),外參標定(PoseNet[22]),廣角相機標定(Rong[23]),卷簾門標定(URS-CNN[23]),相機-雷達聯合標定(RegNet[27])等。

第二種稱為重建范式,它拋棄了傳統的參數回歸思想,使用全卷積網絡直接從初始輸入學習像素級的映射函數,將待標定域映射到標定域上。這種方式專注于像素級重建并與后續任務聯合學習,可以實現無參數、一階段標定。該范式下經典的標定算法有:針孔相機(MisCaliDet[108]),廣角相機(DR-GAN[31]),卷簾門模型(DeepUnrollNet[46]),相機-雷達模型(CFNet[153])等。

學習策略

在基于深度學習的相機標定發展中,多種學習策略得以探索,其中有監督學習占絕大多數(超過90%)。考慮到標記工作費時費力,越來越多的研究者探索使用半監督學習、弱監督學習、無監督學習和自監督學習來降低神經網絡對參數標簽的訓練需求。這些學習策略的研究重心也從數據量、網絡層數的堆疊等逐漸轉變為對數據本身先驗知識的挖掘。

在相機標定技術中,幾何先驗具有高效利用數據的特點,因為它們消除了從數據中學習這些信息的必要性,這使得網絡框架易于解釋,并且更好地適用于相近的數據分布。此外,強化學習也被用于動態解決相機標定問題。我們注意到,該領域仍然有很多學習策略尚未被開發研究,如主動學習、少樣本學習、零樣本學習等。這些學習策略可以進一步提高標定算法的效率和魯棒性,從而擴展相機標定的應用場景,例如在醫療圖像處理、軍事偵察和自動駕駛等領域。

三、具體研究進展及討論

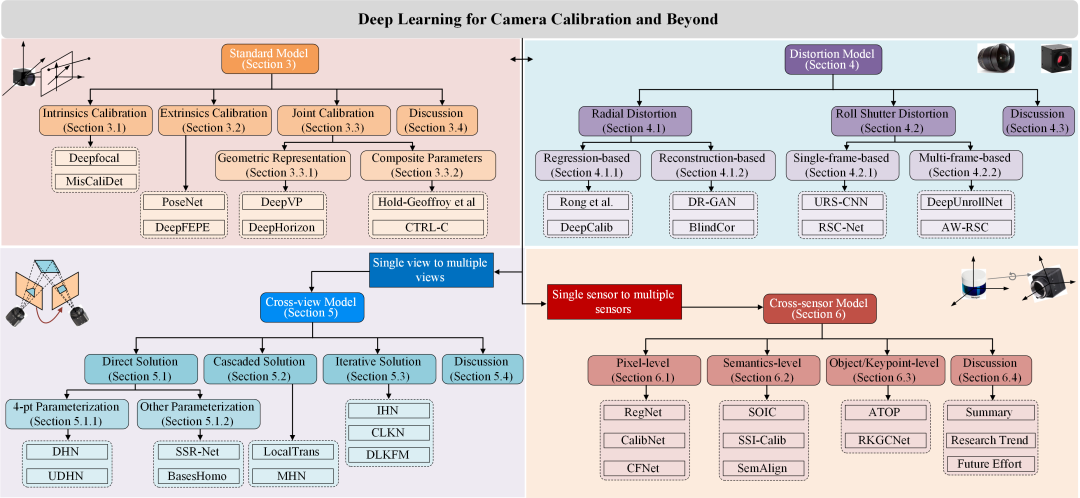

本綜述的結構和層次分類如下圖所示,其中每個部分對應標定不同的相機模型或拓展模型的研究進展。在第三章中,我們介紹了標準針孔相機標定,其中按標定目標分為內參標定、外參標定、內外參聯合標定。在第四章中,我們介紹了畸變相機模型標定,其中按畸變類型分為徑向畸變和卷簾門畸變。對于徑向畸變,我們按學習范式進行分類概述;對于卷簾門畸變,我們按數據類型進行逐一分析。在第五章中,我們介紹了跨視角模型應用,其中按算法流程分為直接方案、級聯方案和迭代方案。在第六章中,我們介紹了跨傳感器模型標定,特別是相機-雷達聯合標定,其中按標定目標分為像素級、語義級和物體/關鍵點級標定。在每一章節中,我們還歸納了對應標定模型下的深度學習研究趨勢,并展望了未來研究的技術路徑。

有趣的是,我們發現雖然不同模型標定算法之間的發展鮮有關聯,但是它們的研究趨勢均呈現出從回歸范式到重建范式的拓展。新的標定目標的發展也不謀而合。此外,部分方案根據傳統標定的流程重新設定了每個學習模塊的結構和功能,在靈活整合幾何求解算法的同時大大提高了網絡的可解釋性。更多分析和討論詳見綜述的第三章至第六章。

本綜述的結構和層次分類,其中每個類別下列出了一些經典的方法

四、評測基準

由于在基于深度學習的相機標定領域中還沒有公開且統一的評測基準,因此我們整合、構建了一個數據集,以用于評估不同方法的泛化性能。在這個數據集中,圖像和視頻是由不同的相機在各種場景下拍攝的,包括模擬環境和真實世界的場景。此外,我們基于不同的條件提供了標定的真實結果、參數標簽和視覺線索等,如下圖所示。特別地,對于畸變相機模型,我們使用大約40種廣角相機采集室內的原始數據。其中每個數據均配有標定獲得的內參、外參和畸變系數。為了豐富場景多樣性,我們還用一輛配備了不同標定相機的車載系統來采集街景環境下的視頻序列,涵蓋了白天、黑夜以及不同的天氣。

五、未來研究展望

相機標定是計算機視覺和機器人領域中一個基礎但具有挑戰性的研究課題。從以上的技術回顧和趨勢洞察,我們發現目前的深度學習方案仍有很大的提升空間。從第三章到第六章,本綜述討論了各類相機模型未來研究的技術路徑。在本節中,我們將提出整個研究社區可能關心的一些更為宏觀的未來研究方向。

· 序列標定的拓展

現有的深度學習研究側重于單個圖像的標定,而忽略了采集序列中的時空相關性。將現有方法應用于第一幀并傳播到后續幀是一種直接的解決方法,但是無法確保完美標定每個輸入,因此標定誤差將貫穿整個序列。學習時空相關性可以為網絡提供運動結構相關的知識,同時在一定程度契合了傳統相機標定的思想。

· 標定目標的革新

傳統的標定目標由于與圖像特征之間的隱式關系,很難通過神經網絡準確學習。為此,一些研究開發了新穎的學習目標來替代傳統的標定目標,為神經網絡提供了更加友好的學習表征。此外,一些中間的幾何表示方法也被提出,以彌合圖像特征和標定目標之間的差距,例如反射振幅系數圖、矯正流、表面幾何和法向流等。展望未來,我們認為仍有很大的潛力設計更明確和合理的標定目標學習方法。

· 預訓練策略的探索

在深度學習中,使用ImageNet數據集進行預訓練已成為一種廣泛使用的策略。然而,近期研究表明,這種方法對于特定的相機標定任務(如廣角相機標定)會起到負面作用。這主要由兩個原因造成:數據差距和任務差距。此外,據我們所知,對于超過單個圖像和單個模態的標定預訓練策略,相關領域尚未進行深入研究。因此,我們認為探索面向相機標定的深度學習預訓練策略是一個有趣且有價值的研究方向。

· 隱式、統一模型的構建

基于深度學習的相機標定方法大多使用傳統的參數化相機模型,這種模型缺乏適應復雜情況的靈活性。非參數化相機模型將每個像素與其對應的三維入射光線相關聯,克服了參數化模型的限制。此外,它們允許隱式和統一的標定,通過像素級回歸適配所有相機類型,避免了顯式特征提取和幾何求解等過程。深度學習方法顯示出對重建式標定任務的潛力,使得非參數化模型值得重新審視,并有可能在未來代替參數化模型。

另一方面,研究人員將隱式、統一表示的優勢與神經輻射場(NeRF)相結合,用于重建三維結構和合成新視角。其中,自標定NeRF方法可用于具有任意非線性畸變的通用相機,探索了無需標定目標學習深度和自運動的端到端流程。

本綜述認為,隱式和統一相機模型在未來可以用于優化基于學習的標定算法,也可集成到下游的三維視覺任務中。同時,該領域中精心設計的幾何先驗、標定策略、優化方式、學習表征等也可用于啟發NeRF等領域的發展,以進一步擺脫對相機參數和相機模型的依賴。

更多的未來研究方向,特別是相機標定的實際應用研究點,詳見本綜述補充材料的第三章。

六、總結

我們提供了一份深度學習驅動的相機標定技術綜述,涵蓋了傳統相機模型、新的學習范式和學習策略、現有方法的詳細回顧、公開的基準測試以及未來研究方向。為了展示發展過程和現有工作之間的聯系,我們提供了一種新的精細分類法,通過同時考慮相機模型和拓展應用來對文獻進行分類。此外,在每個類別中,我們都對研究方法的貢獻點、優勢和局限性進行了深入地討論。我們將維護一個開放的github倉庫并定期更新最新的工作和數據集。我們希望本綜述能夠為相關研究和從業者提供一個重要參考,并推動這個領域未來的研究發展。

作者:廖康@MePro-BJTU、林春雨@MePro-BJTU、張敬@USYD

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論