ChatGPT 是 OpenAI 發(fā)布的最新語(yǔ)言模型,比其前身 GPT-3 有顯著提升。與許多大型語(yǔ)言模型類(lèi)似,ChatGPT 能以不同樣式、不同目的生成文本,并且在準(zhǔn)確度、敘述細(xì)節(jié)和上下文連貫性上具有更優(yōu)的表現(xiàn)。

2023-03-10 09:41:50 629

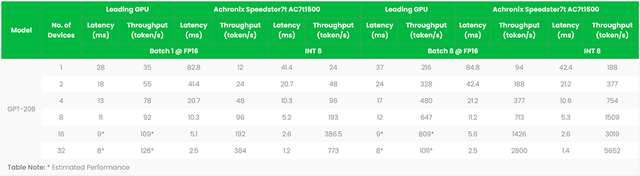

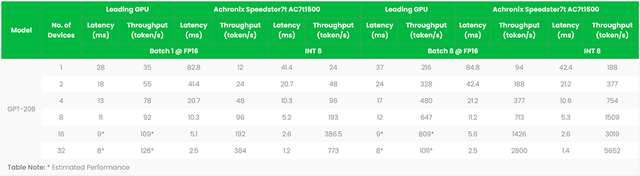

629 參數(shù)規(guī)模大,訓(xùn)練數(shù)據(jù)規(guī)模大。以GPT3為例,GPT3的參數(shù)量為1750億,訓(xùn)練數(shù)據(jù)量達(dá)到了570GB。進(jìn)而,訓(xùn)練大規(guī)模語(yǔ)言模型面臨兩個(gè)主要挑戰(zhàn):顯存效率和計(jì)算效率。 現(xiàn)在業(yè)界的大語(yǔ)言模型都是

2023-07-10 09:13:57 5737

5737

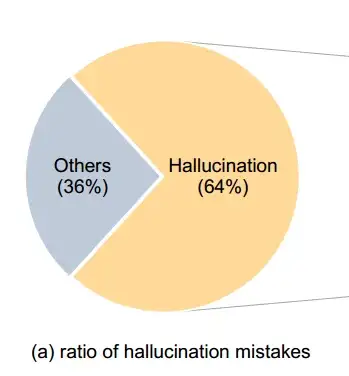

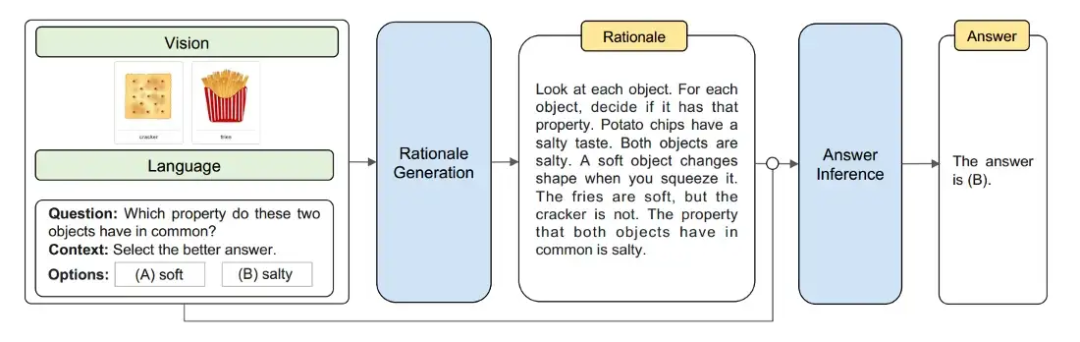

隨著人工智能技術(shù)的不斷發(fā)展,多模態(tài)大模型成為越來(lái)越重要的發(fā)展趨勢(shì)。GPT-4V(GPT-4 近日開(kāi)放的視覺(jué)模態(tài))大型多模型(LMMs)擴(kuò)展大型語(yǔ)言模型(LLMs)以增強(qiáng)多感知技能(如視覺(jué)理解等)從而

2023-10-19 10:45:45 982

982

的資源,得到更多的信息,對(duì)軟件工具的發(fā)展起到了更大的促進(jìn)作用。1、嵌入式Linux C語(yǔ)言開(kāi)發(fā)概述C語(yǔ)言的特點(diǎn):C語(yǔ)言具有出色的可移植性,能夠在不同體系結(jié)構(gòu)的軟硬件平臺(tái)上運(yùn)行。C語(yǔ)言具有簡(jiǎn)潔...

2021-11-04 07:21:14

上海電機(jī)學(xué)院第1章_C語(yǔ)言概述第一章本章要點(diǎn)C語(yǔ)言的特點(diǎn)C程序的結(jié)構(gòu)在計(jì)算機(jī)上運(yùn)行C程序的方法主要內(nèi)容 1.1 計(jì)算機(jī)與程序、程序設(shè)計(jì)語(yǔ)言1.2 C語(yǔ)言出現(xiàn)的歷史背景 1.3 C語(yǔ)言的特點(diǎn) 1.4

2021-09-01 06:41:39

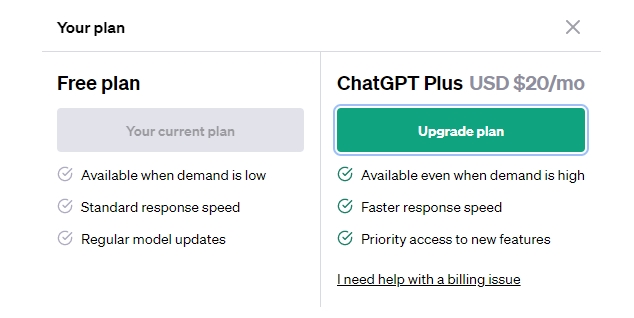

) model:使用那個(gè)模型,目前免費(fèi)版最高的是gpt-3.5-turbo模型 2.相應(yīng)參數(shù)示例 {\"msgtype\": \"text\",\"

2023-05-18 10:16:50

、計(jì)算機(jī)時(shí)代、互聯(lián)網(wǎng)時(shí)代,而這個(gè)時(shí)代叫做 ——人工智能時(shí)代

想象 GPT 是一位語(yǔ)言天才,她擅長(zhǎng)制作一種特殊的串聯(lián)詞語(yǔ)游戲。這個(gè)游戲的目標(biāo)是在給定的起始詞匯后,找到一系列相關(guān)的詞匯,每個(gè)詞匯之間都有

2023-12-22 10:18:11

文章目錄概述函數(shù)關(guān)系圖模型分析資源層->設(shè)備層設(shè)備層->驅(qū)動(dòng)層總結(jié)概述今天看了《韋東山升級(jí)版全系列嵌入式視頻之總線設(shè)備驅(qū)動(dòng)模型》這一節(jié)的視頻,看完之后感覺(jué)有一種似懂非懂的感覺(jué),因此我

2021-12-23 06:27:26

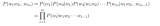

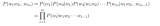

自然語(yǔ)言處理——53 語(yǔ)言模型(數(shù)據(jù)平滑)

2020-04-16 11:11:25

Matlab PSB是什么?Matlab PSB主要由哪幾個(gè)子模塊庫(kù)組成?怎樣去設(shè)計(jì)一種基于MATLAB的小型電力系統(tǒng)模型?如何對(duì)基于MATLAB的小型電力系統(tǒng)模型進(jìn)行仿真?仿真結(jié)果怎樣?

2021-07-11 07:11:42

C語(yǔ)言概述本章主要介紹C語(yǔ)言程序的結(jié)構(gòu)和書(shū)寫(xiě)規(guī)則,以及Turbo C V2.0的基本操作。1.1 C語(yǔ)言的發(fā)展簡(jiǎn)史和特點(diǎn)1.2 C語(yǔ)言程序的結(jié)構(gòu)與書(shū)寫(xiě)規(guī)則1.3 C語(yǔ)言的語(yǔ)句和關(guān)鍵字1.4 Turbo C V2.0的基本操作

2009-03-10 15:04:28

VHDL語(yǔ)言概述:本章主要內(nèi)容:硬件描述語(yǔ)言(HDL)VHDL語(yǔ)言的特點(diǎn)VHDL語(yǔ)言的開(kāi)發(fā)流程

1.1 1.1 硬件描述語(yǔ)言( 硬件描述語(yǔ)言(HDL HDL)H

2009-08-09 23:13:20 47

47 BASIC語(yǔ)言概述及

2010-08-11 18:09:52 4373

4373 在談GPT 2.0之前,先回顧下它哥GPT 1.0,這個(gè)之前我在介紹Bert模型的時(shí)候介紹過(guò),過(guò)程參考上圖,簡(jiǎn)述如下:GPT 1.0采取預(yù)訓(xùn)練+FineTuning兩個(gè)階段,它采取

2019-02-18 08:55:25 7474

7474 在談GPT 2.0之前,先回顧下它哥GPT 1.0,這個(gè)之前我在介紹Bert模型的時(shí)候介紹過(guò),過(guò)程參考上圖,簡(jiǎn)述如下:GPT 1.0采取預(yù)訓(xùn)練+FineTuning兩個(gè)階段,它采取

2019-02-18 09:56:20 9668

9668 能有這樣出色的表現(xiàn),不是沒(méi)有原因的,GPT-2各種特定領(lǐng)域的語(yǔ)言建模任務(wù)中都取得了很好的分?jǐn)?shù)。作為一個(gè)沒(méi)有經(jīng)過(guò)任何領(lǐng)域數(shù)據(jù)專(zhuān)門(mén)訓(xùn)練的模型,它的表現(xiàn),比那些專(zhuān)為特定領(lǐng)域數(shù)據(jù)集(例如維基百科,新聞,書(shū)籍)上訓(xùn)練的模型。有圖有真相:

2019-03-07 14:45:20 7921

7921 今年2月,OpenAI發(fā)布了一款令人印象深刻的語(yǔ)言模型GPT-2,它可以寫(xiě)短篇小說(shuō)、詩(shī)歌,甚至輕松辨別《哈利波特》和《指環(huán)王》中的角色。最近,一位加拿大工程師用它創(chuàng)建了一個(gè)向公眾開(kāi)放的文本生成器,只需提供一個(gè)句子,機(jī)器便能自動(dòng)生成一則完整的新聞、故事、歌詞、詩(shī)歌、食譜和代碼等文本。

2019-05-17 18:48:17 4127

4127 本模型的實(shí)現(xiàn)基于Grover模型,并修改其代碼庫(kù)以匹配GPT-2的語(yǔ)言建模訓(xùn)練目標(biāo)。由于他們的模型是在類(lèi)似的大型語(yǔ)料庫(kù)上進(jìn)行訓(xùn)練的,因此大部分代碼和超參數(shù)都可以重復(fù)使用。本模型沒(méi)有從Grover中大幅改變超參數(shù)。

2019-09-01 07:11:00 3231

3231 就在本周,OpenAI宣布,發(fā)布了7.74億參數(shù)GPT-2語(yǔ)言模型,15.58億的完整模型也有望于幾個(gè)月內(nèi)發(fā)布,并將GPT-2這6個(gè)月的進(jìn)展情況在博客上和大家做了介紹,本文將為大家梳理。

2019-09-01 09:10:44 2704

2704 最近的兩篇論文,BERT和GPT-2,展示了大規(guī)模語(yǔ)言建模的好處。這兩篇論文都利用了計(jì)算機(jī)和可用文本語(yǔ)料庫(kù)的進(jìn)步,在自然語(yǔ)言理解、建模和生成方面顯著超越了當(dāng)前的最優(yōu)水平。

2019-09-13 17:12:00 3398

3398

OpenAI的一組研究人員最近發(fā)表了一篇論文,描述了GPT-3,這是一種具有1,750億個(gè)參數(shù)的自然語(yǔ)言深度學(xué)習(xí)模型,比以前的版本GPT-2高100倍。該模型經(jīng)過(guò)了將近0.5萬(wàn)億個(gè)單詞的預(yù)訓(xùn)練,并且在不進(jìn)行微調(diào)的情況下,可以在多個(gè)NLP基準(zhǔn)上達(dá)到最先進(jìn)的性能。

2020-07-08 17:36:55 2131

2131 還記得前不久被捧上天的GPT-3么?那個(gè)只有被邀請(qǐng)的用戶(hù)才能測(cè)試使用的,號(hào)稱(chēng)史上最大AI模型。 OpenAI的1,750億參數(shù)語(yǔ)言模型GPT-3在6月份發(fā)布的時(shí)候就備受關(guān)注,當(dāng)時(shí),猿妹還和大家

2020-09-25 11:38:31 2696

2696

在這篇文章中,我會(huì)介紹一篇最新的預(yù)訓(xùn)練語(yǔ)言模型的論文,出自MASS的同一作者。這篇文章的亮點(diǎn)是:將兩種經(jīng)典的預(yù)訓(xùn)練語(yǔ)言模型(MaskedLanguage Model, Permuted

2020-11-02 15:09:36 2334

2334 GPT-3 自動(dòng)生成的語(yǔ)言竟然能和人類(lèi)差不多,堪稱(chēng)奇跡。但在很大程度上,GPT-3 也不過(guò)是個(gè)噱頭。判斷方法也很簡(jiǎn)單。若提問(wèn) GPT-3:羊是什么顏色?它會(huì)說(shuō) 白色 ,還會(huì)說(shuō) 黑色 , 頻次一樣

2022-07-10 15:25:08 1366

1366 Stroudsburg……” 自然語(yǔ)言模型 GPT-2就像是收到了某種暗號(hào),立刻“送出”一套 個(gè)人信息:姓名、電話號(hào)碼,還有地址、郵箱和傳真 (部分信息已打碼)。 這可不是GPT-2瞎編的,而是真實(shí)存在的個(gè)人信息!這些個(gè)人信息,全部來(lái)自于網(wǎng)上。 ? 原來(lái)是因?yàn)?b class="flag-6" style="color: red">GPT-2靠網(wǎng)上扒取的數(shù)據(jù)來(lái)訓(xùn)練。 本以為

2021-01-02 09:22:00 2138

2138 最近,GPT-3火了!相信你已經(jīng)在網(wǎng)上看到各種有關(guān)GPT-3的演示。這個(gè)由OpenAI創(chuàng)建的大型機(jī)器學(xué)習(xí)模型,它不僅可以自己寫(xiě)論文,還會(huì)寫(xiě)詩(shī)歌,就連你寫(xiě)的代碼都能幫你寫(xiě)了。 ? 下面還是先讓你看看

2021-01-06 17:06:16 2148

2148 景中落地,難度著實(shí)不小。 現(xiàn)在,針對(duì)這個(gè)問(wèn)題,普林斯頓的陳丹琦、高天宇師徒和MIT博士生Adam Fisch在最新論文中提出,使用較小的語(yǔ)言模型,并用少量樣本來(lái)微調(diào)語(yǔ)言模型的權(quán)重。 并且,實(shí)驗(yàn)證明,這一

2021-01-07 14:27:36 1850

1850 參數(shù)是機(jī)器學(xué)習(xí)算法的關(guān)鍵。它們是從歷史訓(xùn)練數(shù)據(jù)中學(xué)到的模型的一部分。一般來(lái)說(shuō),在語(yǔ)言領(lǐng)域,參數(shù)的數(shù)量和復(fù)雜性之間的相關(guān)性非常好。例如,OpenAI的GPT-3是有史以來(lái)訓(xùn)練了1750億個(gè)參數(shù)的最大語(yǔ)言模型之一,它可以進(jìn)行原始類(lèi)比、生成配方,甚至完成基本代碼。

2021-01-18 16:19:54 1630

1630 ? 古諺道:“熟讀唐詩(shī)三百首,不會(huì)作詩(shī)也會(huì)吟。” 這句話放在目前的人工智能語(yǔ)言模型中也非常適用。 此前,OpenAI 的研究人員開(kāi)發(fā)出 “GPT-3”,這是一個(gè)由 1750 億個(gè)參數(shù)組成的 AI

2021-01-18 17:16:07 2111

2111 最近開(kāi)發(fā)了一種新的圖像編碼對(duì)象屬性檢測(cè)模型,稱(chēng)為VinVL(Visual features in Vision-Language),有著顯著超越人類(lèi)的表現(xiàn)。

2021-01-19 14:32:09 1476

1476 的AI模型GPT-3。GPT-3就是在570 GB的文本數(shù)據(jù)上訓(xùn)練的語(yǔ)言模型,因此,就訓(xùn)練數(shù)據(jù)和生成能力而言,GPT-3截至2020年都是最龐大的公開(kāi)發(fā)布的語(yǔ)言模型。 此外,OpenAI的GPT-3一反之前死守基礎(chǔ)研究的思路,將 GPT-3 做成了一個(gè)服務(wù),提供可以調(diào)用的 OpenAI API,并且

2021-01-19 15:29:31 1719

1719 版GPT-3的DALL·E模型剛出,來(lái)自康奈爾大學(xué)的 Philip Wang就開(kāi)始復(fù)現(xiàn) 了。 但此前,還沒(méi)人能復(fù)現(xiàn)出GPT-3大小的大語(yǔ)言模型來(lái)。 不過(guò),已經(jīng)有人開(kāi)始嘗試了。這是一個(gè)名為 GPT-Neo的項(xiàng)目

2021-02-13 09:24:00 2646

2646 繼GPT-3問(wèn)世僅僅不到一年的時(shí)間,Google重磅推出Switch Transformer,直接將參數(shù)量從GPT-3的1750億拉高到1.6萬(wàn)億,并比之前最大的、由google開(kāi)發(fā)的語(yǔ)言模型

2021-01-27 16:26:56 1857

1857

GPT3終于開(kāi)源!不過(guò),不是官方開(kāi)的(別打我 Eleuther AI推出的名為GPT-Neo的開(kāi)源項(xiàng)目,于晨4點(diǎn)于twitter正式宣布:已經(jīng)開(kāi)源了復(fù)現(xiàn)版GPT-3的模型參數(shù)(1.3B和2.7B級(jí)別

2021-03-31 17:46:28 2871

2871 大模型的預(yù)訓(xùn)練計(jì)算。 大模型是大勢(shì)所趨 近年來(lái),NLP 模型的發(fā)展十分迅速,模型的大小每年以1-2個(gè)數(shù)量級(jí)的速度在提升,背后的推動(dòng)力當(dāng)然是大模型可以帶來(lái)更強(qiáng)大更精準(zhǔn)的語(yǔ)言語(yǔ)義理解和推理能力。 截止到去年,OpenAI發(fā)布的GPT-3模型達(dá)到了175B的大小,相比2018年94M的ELMo模型,三年的時(shí)間整整增大了

2021-10-11 16:46:05 2226

2226

人類(lèi)語(yǔ)言與蛋白質(zhì)有很多共同點(diǎn),至少在計(jì)算建模方面。這使得研究團(tuán)隊(duì)將自然語(yǔ)言處理(NLP)的新方法應(yīng)用于蛋白質(zhì)設(shè)計(jì)。其中,德國(guó)Bayreuth大學(xué)Birte H?cker的蛋白質(zhì)設(shè)計(jì)實(shí)驗(yàn)室,描述了基于OpenAI的GPT-2的語(yǔ)言模型ProtGPT2,以基于自然序列的原理生成新的蛋白質(zhì)序列。

2022-09-08 16:24:23 1407

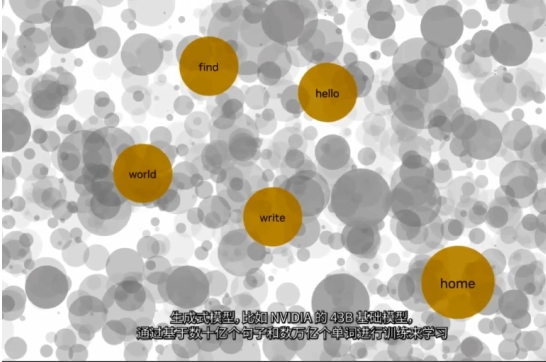

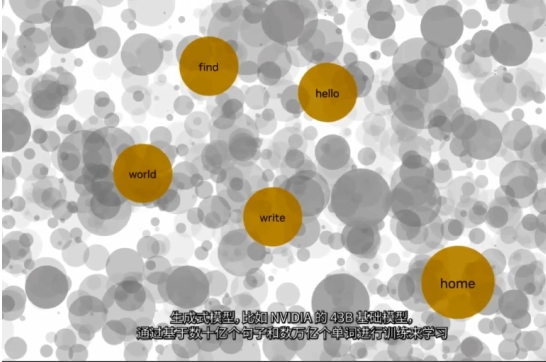

1407 諸如 NVIDIA Megatron LM 和 OpenAI GPT-2 和 GPT-3 等語(yǔ)言模型已被用于提高人類(lèi)生產(chǎn)力和創(chuàng)造力。具體而言,這些模型已被用作編寫(xiě)、編程和繪制的強(qiáng)大工具。相同的架構(gòu)

2022-10-11 09:32:28 683

683

隨著B(niǎo)ERT、GPT等預(yù)訓(xùn)練模型取得成功,預(yù)訓(xùn)-微調(diào)范式已經(jīng)被運(yùn)用在自然語(yǔ)言處理、計(jì)算機(jī)視覺(jué)、多模態(tài)語(yǔ)言模型等多種場(chǎng)景,越來(lái)越多的預(yù)訓(xùn)練模型取得了優(yōu)異的效果。

2022-11-08 09:57:19 3714

3714 GPT 是 Decooding 模型的一種變體,沒(méi)有 Encoder 模塊,沒(méi)有交叉多頭注意力模塊,使用 GeLU 作為激活函數(shù)。

2023-02-07 09:32:25 1985

1985 嵌入式 AI AI 簡(jiǎn)報(bào) 20230217 期 1. 超越GPT 3.5的小模型來(lái)了! 原文:https://mp.weixin.qq.com/s/gv_FJD0aIpDNbky54unj2Q 論文

2023-02-18 04:05:07 1795

1795 從 2018 年 OpenAI 開(kāi)發(fā)出 GPT-1 開(kāi)始,GPT 模型的智能化程度不斷提升,ChatGPT 是從 GPT3.5 系列中的模型進(jìn)行微調(diào)而誕生的,此前 OpenAI 還設(shè)計(jì)了GPT

2023-02-23 10:50:56 1861

1861 ChatGPT 是基于GPT-3.5(Generative Pre-trained Transformer 3.5)架構(gòu)開(kāi)發(fā)的對(duì)話AI模型,是InstructGPT 的兄弟模型。 ChatGPT很可能是OpenAI 在GPT-4 正式推出之前的演練,或用于收集大量對(duì)話數(shù)據(jù)。

2023-02-24 10:05:13 1421

1421 在預(yù)訓(xùn)練階段,GPT 選擇 transformer 的 decoder 部分作為模型的主要模塊,transformer 是 2017年 google 提出的一種特征抽取模型,GPT 以多層 transformer 堆疊的方式構(gòu)成了整個(gè)預(yù)訓(xùn)練模型結(jié)構(gòu)。

2023-03-03 11:14:37 3018

3018 模型選擇:ChatGPT 的開(kāi)發(fā)人員選擇了 GPT-3.5 系列中的預(yù)訓(xùn)練模型,而不是對(duì)原始 GPT-3 模型進(jìn)行調(diào)優(yōu)。使用的基線模型是最新版的 text-davinci-003(通過(guò)對(duì)程序代碼調(diào)優(yōu)的 GPT-3 模型)。

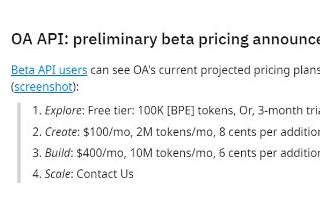

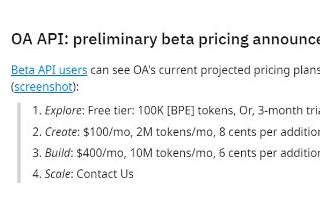

2023-03-08 09:28:00 352

352 -4 是 Generative Pre-trained Transformer 4 的縮寫(xiě),即生成型預(yù)訓(xùn)練變換模型 4,是一個(gè)多模態(tài)大型語(yǔ)言模型。根據(jù)OpenAI的描述,GPT-4 支持接受圖像并理解圖像

2023-03-15 18:15:58 2363

2363 而且 GPT-4 是多模態(tài)的,同時(shí)支持文本和圖像輸入功能。此外,GPT-4 比以前的版本“更大”,這意味著其已經(jīng)在更多的數(shù)據(jù)上進(jìn)行了訓(xùn)練,并且在模型文件中有更多的權(quán)重,這也使得它的運(yùn)行成本更高。

2023-03-17 10:31:07 2930

2930 NVIDIA Nemo用于構(gòu)建定制的語(yǔ)言文本轉(zhuǎn)文本,客戶(hù)可以引入自己的模型,或從Nemo涵蓋了GPT-8、GPT-43到GPT-530等數(shù)十億參數(shù)的從創(chuàng)建專(zhuān)有模型到運(yùn)營(yíng),NVIDIA AI專(zhuān)家將全程與您合作。

2023-03-22 11:22:25 497

497

北京時(shí)間3月15日凌晨,OpenAI發(fā)布了ChatGPT的最新“升級(jí)版本”——GPT4模型,OpenAI在官網(wǎng)表示,GPT4是一個(gè)能接受圖像和文本輸入,并輸出文本的多模態(tài)模型,是OpenAI在擴(kuò)展

2023-03-22 22:26:18 2511

2511 基礎(chǔ) LLM 基本信息表,GPT-style 表示 decoder-only 的自回歸語(yǔ)言模型,T5-style 表示 encoder-decoder 的語(yǔ)言模型,GLM-style 表示 GLM 特殊的模型結(jié)構(gòu),Multi-task 是指 ERNIE 3.0 的模型結(jié)構(gòu)

2023-04-20 11:25:44 1071

1071 GPT是基于Transformer架構(gòu)的大語(yǔ)言模型,近年迭代演進(jìn)迅速。構(gòu)建語(yǔ)言模型是自然語(yǔ)言處理中最基本和最重要的任務(wù)之一。GPT是基于Transformer架構(gòu)衍生出的生成式預(yù)訓(xùn)練的單向語(yǔ)言模型,通過(guò)對(duì)大 量語(yǔ)料數(shù)據(jù)進(jìn)行無(wú)監(jiān)督學(xué)習(xí)

2023-04-28 10:01:59 585

585

大型語(yǔ)言模型“福爾摩斯大模型”。這款模型以1760億個(gè)參數(shù)打造,能夠和OpenAI的GPT-3.5模型相媲美。 而實(shí)際上,華碩的AI工程團(tuán)隊(duì)早在2018年就與英偉達(dá)合作,參與杉二、三、四號(hào)超級(jí)計(jì)算機(jī)開(kāi)發(fā)工作,并于2021年投資成立臺(tái)智云,也成為亞洲地區(qū)唯一提供商用AI超算

2023-05-23 11:32:04 442

442 在針對(duì)英語(yǔ)、中文、法語(yǔ)、阿拉伯語(yǔ)、西班牙語(yǔ)、印度語(yǔ)這 6 種語(yǔ)言的評(píng)測(cè)中,GPT-4 的勝率為 54.75%,BLOOMChat 的勝率為 45.25%,稍弱于 GPT-4。但與其它 4 種主流的開(kāi)源聊天 LLM 相比

2023-05-25 11:14:40 681

681

你可以看到,Llama 的參數(shù)數(shù)量大概是 650 億。現(xiàn)在,盡管與 GPT3 的 1750 億個(gè)參數(shù)相比,Llama 只有 65 個(gè) B 參數(shù),但 Llama 是一個(gè)明顯更強(qiáng)大的模型,直觀地說(shuō),這是

2023-05-30 14:34:56 642

642

華為版ChatGPT將7月發(fā)布 或已接近GPT-3.5 在AI賽道華為即將披露大動(dòng)作。市場(chǎng)傳言華為ChatGPT將在7月份正式發(fā)布,具體發(fā)布時(shí)間或者在7月7日的發(fā)布會(huì)上,也就是7月7日的華為云開(kāi)發(fā)者

2023-06-06 12:47:02 2350

2350 最新、最強(qiáng)大的模型GPT-4將向美國(guó)政府機(jī)構(gòu)開(kāi)放 此前微軟已向其商業(yè)客戶(hù)提供了OpenAI模型,現(xiàn)在微軟宣布將向azure government云計(jì)算客戶(hù)開(kāi)放openai的人工智能模型。該客戶(hù)包括許多美國(guó)政府機(jī)構(gòu),他們可以接觸使用大型語(yǔ)言模型,如gpt-3和gpt-4。

2023-06-08 20:15:15 1183

1183 大型語(yǔ)言模型研究的發(fā)展有三條技術(shù)路線:Bert 模式、GPT 模式、混合模式。其中國(guó)內(nèi)大多采用混合模式, 多數(shù)主流大型語(yǔ)言模型走的是 GPT 技術(shù)路線,直到 2022 年底在 GPT-3.5 的基礎(chǔ)上產(chǎn)生了 ChatGPT。

2023-06-09 12:34:53 3162

3162

他預(yù)計(jì),深度學(xué)習(xí)和大型語(yǔ)言模型會(huì)繼續(xù)發(fā)展:這個(gè)領(lǐng)域的未來(lái)可能會(huì)有一小部分重大突破,加之許多細(xì)微改進(jìn),所有這些都將融入到一個(gè)龐大而復(fù)雜的工程體系。他還給出了一些有趣、可執(zhí)行的思想實(shí)驗(yàn)。

2023-06-12 16:38:48 262

262 本文旨在讓沒(méi)有計(jì)算機(jī)科學(xué)背景的人對(duì)ChatGPT和類(lèi)似的人工智能系統(tǒng)(GPT-3、GPT-4、Bing Chat、Bard等)的工作原理有一些了解。ChatGPT是一種基于*大語(yǔ)言模型(Large Language Model)* 的對(duì)話式AI聊天機(jī)器人。

2023-06-16 09:59:04 1036

1036

? 面試環(huán)節(jié)第一步——回答問(wèn)題,寫(xiě)軟件需求 面試環(huán)節(jié)第二步——上手寫(xiě)代碼 測(cè)試用例 ? 比 ChatGPT 背后 GPT-3.5 更為強(qiáng)大的模型 GPT-4,已正式對(duì)外發(fā)布。在 OpenAI 官方

2023-06-16 10:42:22 392

392

本文基于DeepSpeedExamples倉(cāng)庫(kù)中給出的Megatron相關(guān)例子探索一下訓(xùn)練GPT2模型的流程。主要包含3個(gè)部分,第一個(gè)部分是基于原始的Megatron如何訓(xùn)練GPT2模型,第二個(gè)部分

2023-06-19 14:45:13 1717

1717

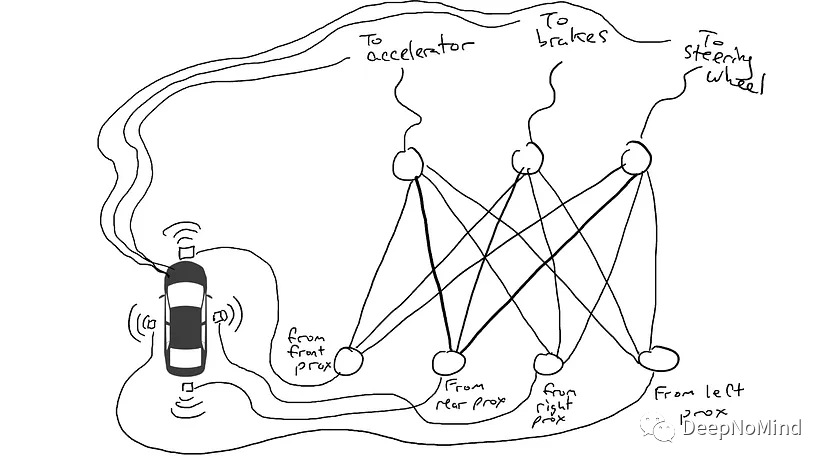

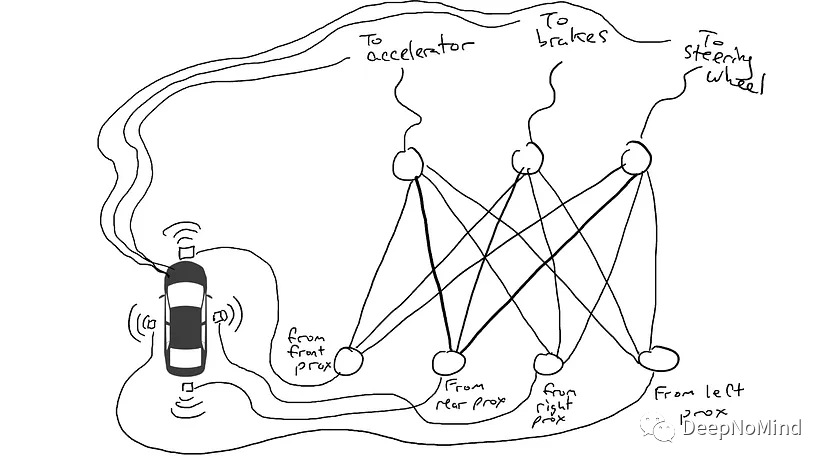

穿梭機(jī)上成功流片(tapeout)。 這項(xiàng)成就,堪稱(chēng)史無(wú)前例。 這意味著,在大語(yǔ)言模型的幫助下,芯片設(shè)計(jì)行

2023-06-20 11:51:12 548

548

都知道,AIGC大模型的入局門(mén)檻是很高的。玩AI的三大必備要素——算力、算法和數(shù)據(jù),每一個(gè)都意味著巨大的投入。 ? 以算力為例。ChatGPT的技術(shù)底座,是基于微調(diào)后的GPT3.5大模型,參數(shù)量多達(dá)1750億個(gè)。為了完成這個(gè)大模型的訓(xùn)練,微軟專(zhuān)門(mén)建設(shè)了一個(gè)AI超算系統(tǒng),

2023-06-27 11:28:42 1784

1784

GPT是一種基于Transformer的預(yù)訓(xùn)練語(yǔ)言模型,可以用于自然語(yǔ)言處理中的各種任務(wù)。在態(tài)勢(shì)感知中,GPT可以用來(lái)對(duì)文本進(jìn)行分類(lèi)和情感分析,從而幫助用戶(hù)了解當(dāng)前的輿情和社會(huì)熱點(diǎn)。例如,在某個(gè)

2023-07-07 11:23:29 323

323 日前,由微軟和湛廬合辦的以 GPT 將如何改變世界為主題的新書(shū)共讀會(huì)上,有關(guān)以 GPT 為代表的 大語(yǔ)言模型 提升社會(huì)生產(chǎn)力,打破傳統(tǒng)人機(jī)交互模式的話題引起了與會(huì)者的廣泛思考。 作為一種重要的推動(dòng)力

2023-07-12 00:10:01 382

382

簡(jiǎn)單來(lái)說(shuō),語(yǔ)言模型能夠以某種方式生成文本。它的應(yīng)用十分廣泛,例如,可以用語(yǔ)言模型進(jìn)行情感分析、標(biāo)記有害內(nèi)容、回答問(wèn)題、概述文檔等等。但理論上,語(yǔ)言模型的潛力遠(yuǎn)超以上常見(jiàn)任務(wù)。

2023-07-14 11:45:40 454

454

WormGPT 基于 2021 年開(kāi)源的 LLM GPT-J 模型開(kāi)發(fā),也是對(duì)話聊天機(jī)器人,可以處理人類(lèi)自然語(yǔ)言提出的要求,并輸出所需的任何內(nèi)容,并且不承擔(dān)相應(yīng)的法律義務(wù)。

2023-07-29 16:35:29 1184

1184

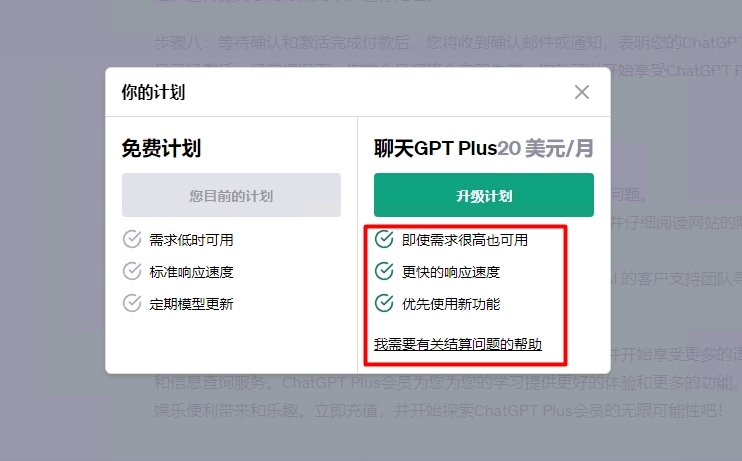

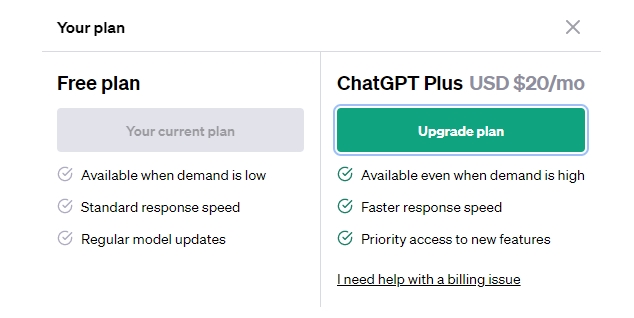

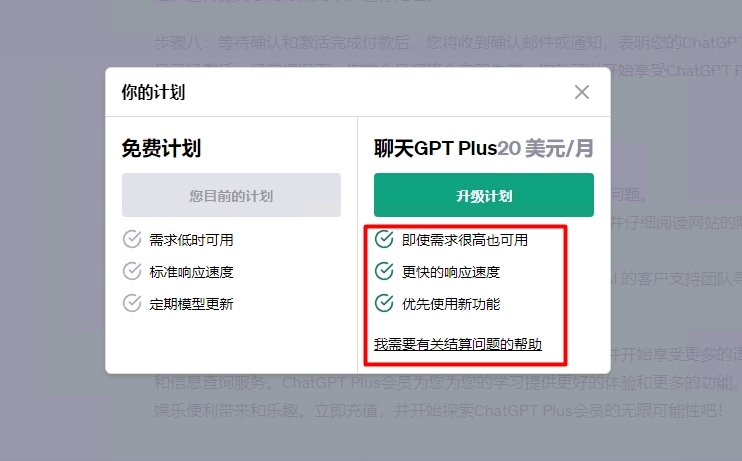

每月20美元)更智能、更準(zhǔn)確。 OpenAI將GPT-4描述為“比其前身GPT-3.5先進(jìn)10倍”。 自從OpenAI的大語(yǔ)言模型(LLM)GPT-4發(fā)布以來(lái),我一直在使用它的最新版本。通過(guò)

2023-08-02 12:09:35 2712

2712

OpenAI 此前曾在前幾代模型(例如 GPT-4 和 GPT-3.5)的商標(biāo)申請(qǐng)中,使用過(guò)同樣的“用于使用語(yǔ)言模型的可下載計(jì)算機(jī)軟件”這一描述。但很遺憾,最新申請(qǐng)文件中透露的唯一關(guān)鍵細(xì)節(jié)就只有“GPT-5”字樣,并不代表 OpenAI 會(huì)在今年年內(nèi)發(fā)布新版本。

2023-08-02 15:51:36 448

448

chatGPT和GPT4有什么區(qū)別 GPT(Generative Pre-trained Transformer)系列模型由OpenAI公司開(kāi)發(fā),是一組用于自然語(yǔ)言處理(NLP)任務(wù)的人工智能模型

2023-08-09 15:18:56 1603

1603 今年三月,OpenAI 重磅發(fā)布了 GPT-4 大模型,帶來(lái)了比 ChatGPT 背后 GPT-3.5 更強(qiáng)的推理、計(jì)算、邏輯能力,也引發(fā)了全民使用的熱潮。在各行各領(lǐng)域研究人員、開(kāi)發(fā)者、設(shè)計(jì)師的使用過(guò)程中,「GPT-4 是最為領(lǐng)先的大模型」似乎已成為了公認(rèn)的結(jié)果。

2023-08-11 14:20:37 634

634

OpenAI開(kāi)放大模型微調(diào)功能 GPT-3.5可以打造專(zhuān)屬ChatGPT OpenAI開(kāi)放大模型微調(diào)功能,這意味著GPT-3.5 Turbo支持自定義微調(diào);可以打造出專(zhuān)屬自己的ChatGPT。同時(shí)

2023-08-23 19:34:02 703

703 華為盤(pán)古大模型和GPT的區(qū)別? 隨著人工智能技術(shù)的不斷進(jìn)步,機(jī)器學(xué)習(xí)領(lǐng)域的研究也越來(lái)越深入。在這其中,以自然語(yǔ)言處理技術(shù)為主要研究方向的人工智能算法受到了廣泛關(guān)注。在這個(gè)領(lǐng)域中,華為盤(pán)古大模型

2023-08-30 17:38:05 3081

3081 幾個(gè)方面來(lái)探討盤(pán)古大模型和GPT-3的不同之處。 一、概念定義差異 盤(pán)古大模型,簡(jiǎn)稱(chēng)PGM,是中國(guó)科學(xué)院計(jì)算機(jī)網(wǎng)絡(luò)信息中心所研發(fā)的一種大規(guī)模中文自然語(yǔ)言處理預(yù)訓(xùn)練模型,它是以一種全新的方式來(lái)進(jìn)行中文自然語(yǔ)言處理的。它可以像英文NLP預(yù)訓(xùn)練模型

2023-08-30 18:28:32 1201

1201 ,大型語(yǔ)言模型(Large Language Models,LLM)徹底改變了自然語(yǔ)言處理領(lǐng)域,使機(jī)器能夠生成類(lèi)似人類(lèi)的文本并進(jìn)行有意義的對(duì)話。這些模型,例如OpenAI的GPT,擁有驚人的語(yǔ)言理解和生成能力。它們可以被用于廣泛的自然語(yǔ)言處理任務(wù),包括文本生成、翻譯、自動(dòng)摘要、情緒分析等

2023-09-04 16:55:25 345

345

騰訊發(fā)布混元大語(yǔ)言模型 騰訊全球數(shù)字生態(tài)大會(huì)上騰訊正式發(fā)布了混元大語(yǔ)言模型,參數(shù)規(guī)模超千億,預(yù)訓(xùn)練語(yǔ)料超2萬(wàn)億tokens。 作為騰訊自研的通用大語(yǔ)言模型,混元大語(yǔ)言模型具有中文創(chuàng)作能力、任務(wù)執(zhí)行

2023-09-07 10:23:54 815

815 語(yǔ)言大模型(如 GPT-3/4、LLaMA 和 PaLM)使用 token 作為基本單位進(jìn)行工作。它們接受文本作為輸入,將其轉(zhuǎn)換為 token(整數(shù)),然后預(yù)測(cè)接下來(lái)應(yīng)該出現(xiàn)哪些 token。 通過(guò)操作這些 token,可以更好地了解它們?cè)?b class="flag-6" style="color: red">語(yǔ)言模型內(nèi)部的工作原理。

2023-09-15 11:13:04 383

383

大語(yǔ)言模型涉及數(shù)據(jù)的通常有有多個(gè)階段(Aligning language models to follow instructions [1] ):pre-train、sft(supervised

2023-09-19 10:00:06 506

506

目前為止,OpenAI還沒(méi)有對(duì)爆料中的傳聞做出回應(yīng),但此前發(fā)布過(guò)多模態(tài)模型測(cè)試。CEO奧特曼在回應(yīng)有關(guān)GPT-5的傳聞時(shí),也暗示過(guò)GPT-4“正在增強(qiáng)”。

2023-09-20 17:34:41 799

799

管至少一個(gè)子集的大型語(yǔ)言模型(LLM)是有實(shí)際原因的,尤其是在大大改進(jìn)自然語(yǔ)言處理方面。與此同時(shí),這些模型通常與大型云平臺(tái)相關(guān)聯(lián),其龐大的規(guī)模給任何將 LLM 移至邊緣設(shè)備的嘗試帶來(lái)了挑戰(zhàn)。向移動(dòng) GPT 過(guò)渡需要一些重大創(chuàng)新。

2023-09-21 11:31:46 177

177 ,GPT-3.5 和 GPT-4 模型的答案是否明顯不同?OpenAI 的網(wǎng)站上寫(xiě)道:“GPT-4 擅長(zhǎng)于需要高級(jí)推理

2023-10-10 12:16:28 1324

1324

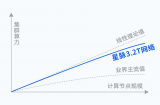

在過(guò)去的6個(gè)月里,通義千問(wèn)2.0與4月份推出的1.0版本相比,在復(fù)雜的命令理解、文學(xué)創(chuàng)作、通用數(shù)學(xué)、知識(shí)記憶、幻覺(jué)抵抗力等方面有了很大的提高。目前,通義千問(wèn)的千托綜合性能已經(jīng)超過(guò)gpt-3.5,正在快速趕上gpt-4。

2023-11-01 09:57:49 390

390 ChatGPT重磅更新 OpenAI發(fā)布GPT-4 Turbo模型價(jià)格大降2/3 目前OpenAI算是全球大模型的引領(lǐng)者,一舉一動(dòng)都牽動(dòng)著大家的關(guān)注,現(xiàn)在ChatGPT迎來(lái)重磅更新。 OpenAI

2023-11-07 18:20:03 2076

2076

本文基于亞馬遜云科技推出的大語(yǔ)言模型與生成式AI的全家桶:Bedrock對(duì)大語(yǔ)言模型進(jìn)行介紹。大語(yǔ)言模型指的是具有數(shù)十億參數(shù)(B+)的預(yù)訓(xùn)練語(yǔ)言模型(例如:GPT-3, Bloom, LLaMA)。這種模型可以用于各種自然語(yǔ)言處理任務(wù),如文本生成、機(jī)器翻譯和自然語(yǔ)言理解等。

2023-12-04 15:51:46 356

356 文本進(jìn)行訓(xùn)練。自 2018 年以來(lái),Google、OpenAI、Meta、百度、華為等公司和研究機(jī)構(gòu)都相繼發(fā)布了包括 BERT,GPT 等在內(nèi)多種模型,并在幾乎所有自然語(yǔ)言處理任務(wù)中都表現(xiàn)出色。2019

2023-12-07 11:40:43 1141

1141

從長(zhǎng)遠(yuǎn)來(lái)看,谷歌可以超越gpt-4。畢竟他是搜索出身,有數(shù)據(jù)優(yōu)勢(shì),有大量的知識(shí)積累和沉淀。如果將搜索和大模型相結(jié)合,大模型將變得更實(shí)時(shí)、更全面、更準(zhǔn)確,搜索本身也更智能。

2023-12-11 09:44:14 308

308 截止、擴(kuò)展的上下文窗口、預(yù)算友好的定價(jià)等。 什么是GPT-4 Turbo? GPT-4 Turbo是現(xiàn)有GPT-4大語(yǔ)言模型的更新。它帶來(lái)了一些改進(jìn),

2023-12-13 09:19:37 460

460

這個(gè)開(kāi)源模型盡管尺寸不大,小到足以在一臺(tái)內(nèi)存100GB以上的電腦上運(yùn)行,然而在某些基準(zhǔn)測(cè)試中卻能和GPT-3.5打平,因此迅速在開(kāi)發(fā)者中贏得了一片稱(chēng)贊。

2023-12-18 16:55:08 350

350

在科技飛速發(fā)展的當(dāng)今時(shí)代,人工智能技術(shù)成為社會(huì)進(jìn)步的關(guān)鍵推動(dòng)力之一。在廣泛關(guān)注的人工智能領(lǐng)域中,大語(yǔ)言模型以其引人注目的特性備受矚目。 大語(yǔ)言模型的定義及發(fā)展歷史 大語(yǔ)言模型是一類(lèi)基于深度學(xué)習(xí)技術(shù)

2023-12-21 17:53:59 555

555 在信息爆炸的時(shí)代,我們渴望更智能、更高效的語(yǔ)言處理工具。GPT-3.5等大語(yǔ)言模型的崛起為我們提供了前所未有的機(jī)會(huì)。這不僅是技術(shù)的進(jìn)步,更是人與機(jī)器共舞的一幕。本篇文章將帶你走進(jìn)這個(gè)奇妙的語(yǔ)言王國(guó)

2023-12-29 14:18:59 276

276 OPPO推出GPT大模型手機(jī)?是的,只能說(shuō)生成式 AI 實(shí)在是太爆火了,智能手機(jī)市場(chǎng)的競(jìng)爭(zhēng)都只能繼續(xù)卷。 今天OPPO推出 GPT 大模型手機(jī) Find X7 系列。Find X7 系列的外觀設(shè)計(jì)

2024-01-08 18:52:15 648

648 近日,科大訊飛舉辦了星火認(rèn)知大模型V3.5升級(jí)發(fā)布會(huì)。在發(fā)布會(huì)上,科大訊飛董事長(zhǎng)劉慶峰和研究院院長(zhǎng)劉聰共同宣布了基于首個(gè)全國(guó)產(chǎn)算力訓(xùn)練的訊飛星火V3.5的全新升級(jí)。

2024-01-31 17:28:05 855

855 近日,人工智能領(lǐng)域迎來(lái)了一場(chǎng)革命性的突破。Anthropic公司發(fā)布了全新的Claude 3系列模型,該系列模型在多模態(tài)和語(yǔ)言能力等關(guān)鍵指標(biāo)上展現(xiàn)出卓越性能,成功超越了此前被廣泛認(rèn)為是全球最強(qiáng)AI模型的GPT-4,樹(shù)立了新的行業(yè)標(biāo)桿。

2024-03-05 09:42:51 188

188 人工智能領(lǐng)域的領(lǐng)軍企業(yè)Anthropic宣布推出全新的Claude 3系列模型,包括Claude 3 Opus、Claude 3 Sonnet和Claude 3 Haiku。據(jù)該公司稱(chēng),這一系列模型不僅在速度上超越了之前的所有模型,更在功能上實(shí)現(xiàn)了重大突破,成為迄今為止最強(qiáng)大的人工智能模型。

2024-03-05 09:43:47 154

154 近日,AI領(lǐng)域的領(lǐng)軍企業(yè)Anthropic宣布推出全新的Claude 3系列模型,其中包括最強(qiáng)版Claude 3 Opus。據(jù)該公司稱(chēng),Claude 3系列在推理、數(shù)學(xué)、編碼、多語(yǔ)言理解和視覺(jué)方面全面超越了包括GPT-4在內(nèi)的所有大型模型,重新樹(shù)立了行業(yè)基準(zhǔn)。

2024-03-05 09:58:03 207

207 據(jù)悉,“朗讀”功能支持37種語(yǔ)言,且能夠自主識(shí)別文本類(lèi)型并對(duì)應(yīng)相應(yīng)的發(fā)音。值得關(guān)注的是,該功能對(duì)GPT-4以及GPT-3.5版本的ChatGPT均適用。此舉彰顯了OpenAI致力于“多模態(tài)交互”(multimodal capabilities)的方向

2024-03-05 15:48:33 195

195 中的表現(xiàn)超越了 GPT-4/3.5 和 Gemini 1.0 Ultra/Pro。 ? 目前Opus 和 Sonnet 已可通過(guò) claude網(wǎng)站和 Claude API 使用,而 Haiku 將在未來(lái)幾周內(nèi)推出。 Claude 3 的主要改進(jìn) 增強(qiáng)的多語(yǔ)種處理能力對(duì)西班牙語(yǔ)

2024-03-08 12:29:16 162

162 起初,Copilot作為Bing Chat AI助手推出,初期采用GPT-3.5模型,隨后升級(jí)至GPT-4取得顯著進(jìn)步,如今再次更新至性能卓越的GPT-4 Turbo模型,這無(wú)疑將使得Copilot功能再上新臺(tái)階。

2024-03-13 13:42:37 129

129 排隊(duì)申請(qǐng)內(nèi)測(cè)。 對(duì)于GPT-4的性能,很多國(guó)外網(wǎng)友的描述都是“GPT-4,起飛!” ? 多模態(tài)大型語(yǔ)言模型GPT-4 GPT-4被定義為OpenAI發(fā)展的另一里程碑,其相較于上一代產(chǎn)品GPT-3.5

2023-03-16 01:58:00 3977

3977

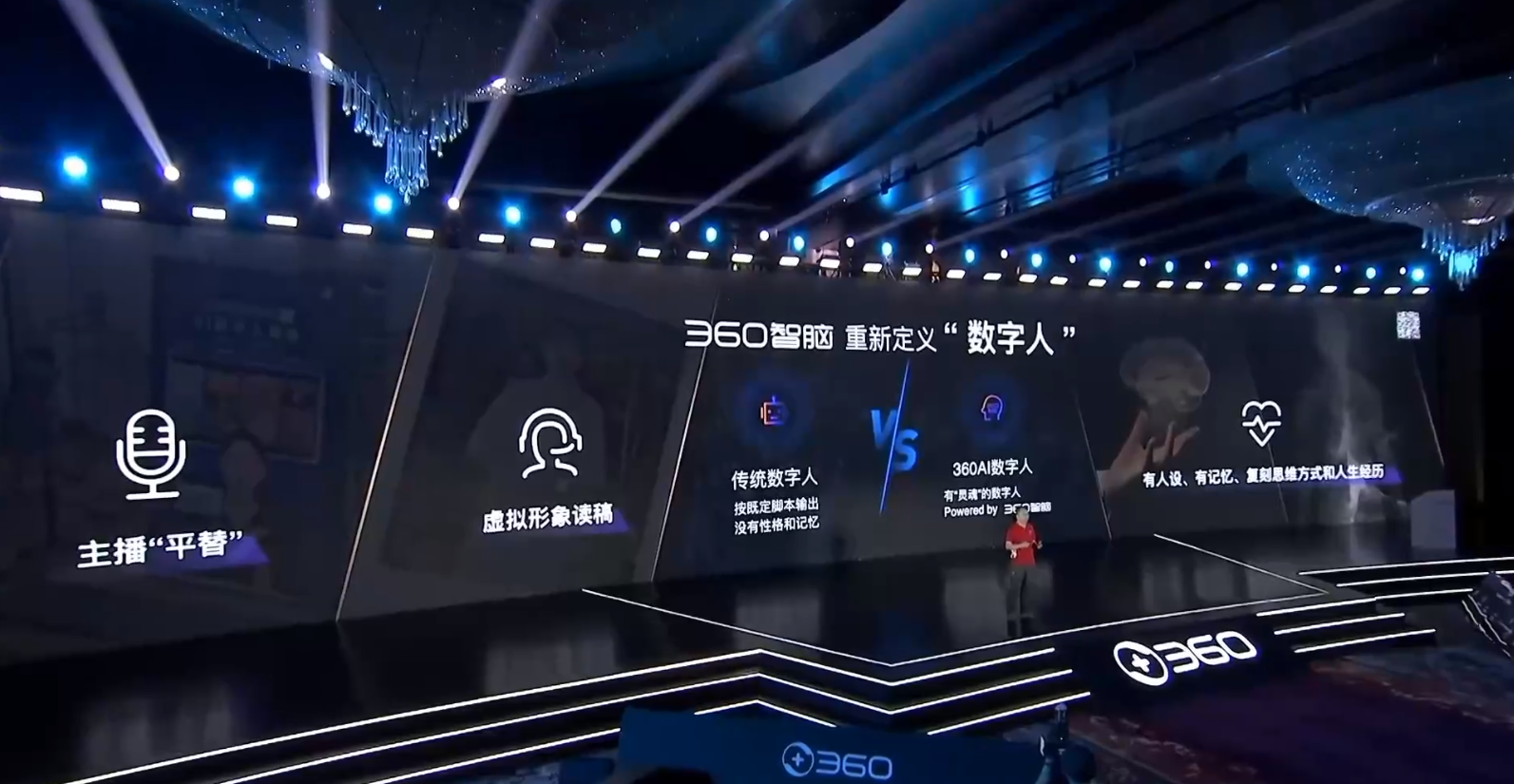

安全衛(wèi)士、360安全瀏覽器、360搜索。同時(shí),360AI數(shù)字人也正式發(fā)布。 ? 在發(fā)布會(huì)現(xiàn)場(chǎng),360創(chuàng)始人周鴻祎針表示,國(guó)產(chǎn)大模型在許多方面已經(jīng)趕上GPT3.5,追趕GPT4的速度遠(yuǎn)超想象。在他看來(lái),當(dāng)前國(guó)內(nèi)各家企業(yè)的大模型基礎(chǔ)能力相差不大,接下來(lái)真正比拼的將是應(yīng)用落地能力

2023-06-15 01:07:00 1975

1975

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論