雖然自動駕駛還沒有走向千家萬戶,但是自動駕駛芯片的大戰(zhàn)早已開始。

這里面有 Mobileye 這樣的行業(yè)先驅,有英偉達這樣的跨界巨頭,有特斯拉這樣的別樣車廠,還有地平線這樣的國內新銳企業(yè)。

然而,我們也不應該忽略一些原本在芯片領域赫赫有名的面孔,比如英特爾——雖然早在 2017 年就收購了Mobileye,但這并不影響英特爾工程師們對自動駕駛的獨特追求。

目前我們見到的自動駕駛芯片,本質上依然沒有脫離一臺計算機的基本結構,比如 CPU/GPU/DRAM 這些常見于你我桌上電腦、掌上手機的零件。而一臺計算機在面對自動駕駛計算的時候,它的工作模式和人類司機的大腦相比是很不一樣的。

舉個例子吧,特斯拉新一代 Autopilot 硬件的功耗,官方描述是 250W 每英里,也就是說自動駕駛硬件在開啟狀態(tài)下會一直處于全速運行。但是人類司機并不會一直燒腦式駕駛,在自己熟稔的、交通狀況良好的路段上,人類大腦的負擔會明顯更低。

所以,有沒有辦法讓自動駕駛也能像人類一樣,具有更高的能耗效率呢?

英特爾實驗室給出了他們的答案:用造芯片的方法造一個大腦就好了。

將芯片造成大腦模樣

上圖這一坨東西叫做 Pohoiki Beach,主板里面密密麻麻的芯片叫做Loihi(跟我用粵語讀一次,老嗨),來自于當?shù)貢r間 15 號在底特律舉行的2019 DARPA 電子復興計劃峰會。

注:DARPA,全稱DefenseAdvanced Research Projects Agency,即美國國防高級研究計劃局,是美國國防部屬下的一個行政機構,負責研發(fā)用于軍事用途的高新科技。成立于 1958 年的 DARPA,一開始主要是為了應對蘇聯(lián) 1957 年人造地球衛(wèi)星成功發(fā)射而設立的部門。

一塊 Pohoiki Beach 主板可以根據(jù)需求的不同搭載 8-32 塊芯片,兩塊主板與左下角那個 Arria 10 FPGA 開發(fā)模塊互聯(lián)之后,Pohoiki Beach 最多可以成為一個擁有 64 個 Loihi 芯片的 AI 深度學習計算系統(tǒng)。

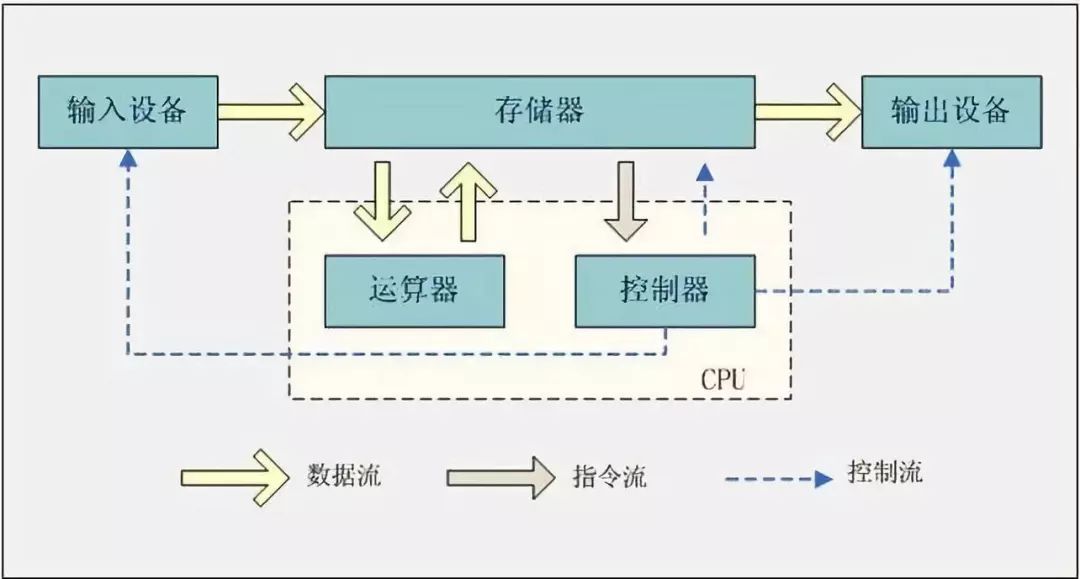

與這個世界上所有的硅芯片類似,Loihi 芯片的基本構成依然是晶體管。但是在 Loihi 里面,晶體管的工作形式并非傳統(tǒng)的邏輯門架構,Loihi 的計算原理也并非傳統(tǒng)計算機恪守數(shù)十年的馮諾依曼原理,而是以更接近人腦架構的神經(jīng)元方式計算。

注:馮·諾依曼教授提出過現(xiàn)代電子計算機的三大原理,分別是1. 計算機由控制器、運算器、存儲器、輸入設備、輸出設備五大部分組成;2.程序和數(shù)據(jù)以二進制代碼形式不加區(qū)別地存放在存儲器中,存放位置由地址確定;3. 控制器根據(jù)存放在存儲器中地指令序列(程序)進行工作,并由一個程序計數(shù)器控制指令地執(zhí)行。控制器具有判斷能力,能根據(jù)計算結果選擇不同的工作流程。

馮諾依曼架構雖然奠定了半個多世紀的電子計算機芯片基本框架,但這個架構也有其自身的瓶頸,那就是在處理器性能飛速發(fā)展的今天,緩存的讀寫速度出現(xiàn)了跟不上處理器運行速度的瓶頸——這個瓶頸就叫馮諾依曼瓶頸。

當然,我們無法真正的用硅元素「造」出一個神經(jīng)元,Loihi 芯片的基本組成形式依然是晶體管,只是 Loihi 芯片內置晶體管的工作方式更接近于大腦神經(jīng)元。64 個 Loihi 芯片一共包含了接近 1320 億個硅晶體管,與之相比,英偉達 RTX 2080Ti GPU 內置晶體管數(shù)量為 186 億個。

在 Pohoiki Beach 系統(tǒng)中,基于 14 納米工藝打造的每塊 Loihi 芯片可以模擬 13 萬個硅神經(jīng)元,以及 1.3 億個硅神經(jīng)突觸。64 個 Loihi 芯片互聯(lián)就是 830 萬個神經(jīng)元,已經(jīng)相當于一個小老鼠大腦內所含有的神經(jīng)元總量。

英特爾的目標遠不止于此,今年年底即將推出的 Pohoiki Spring 系統(tǒng)會將 Loihi 芯片的性能發(fā)揮到極致,最多可以疊加 768 顆芯片,也就是模擬 1 億個神經(jīng)元,相當于一只未成年小貓的大腦神經(jīng)元數(shù)量。

雖然 Pohoiki Beach 系統(tǒng)的神經(jīng)元總量和人腦的 860 億個神經(jīng)元比起來還有很大的一段距離,但這并不妨礙它成為目前人類神經(jīng)擬態(tài)計算的新里程碑。2015 年我國浙江大學研發(fā)的「達爾文」芯片是當時比較先進的神經(jīng)擬態(tài)計算芯片,內置的硅神經(jīng)元也才 2048 個。

在 2017 年 9 月份,Loihi 芯片剛發(fā)布的時候,英特爾專門為它打造了一個視頻宣傳片:

視頻里面充斥著英特爾對 Loihi,乃至神經(jīng)擬態(tài)芯片光輝未來的期望——可是為什么呢?

AI 的未來,就在我們的大腦里面嗎?

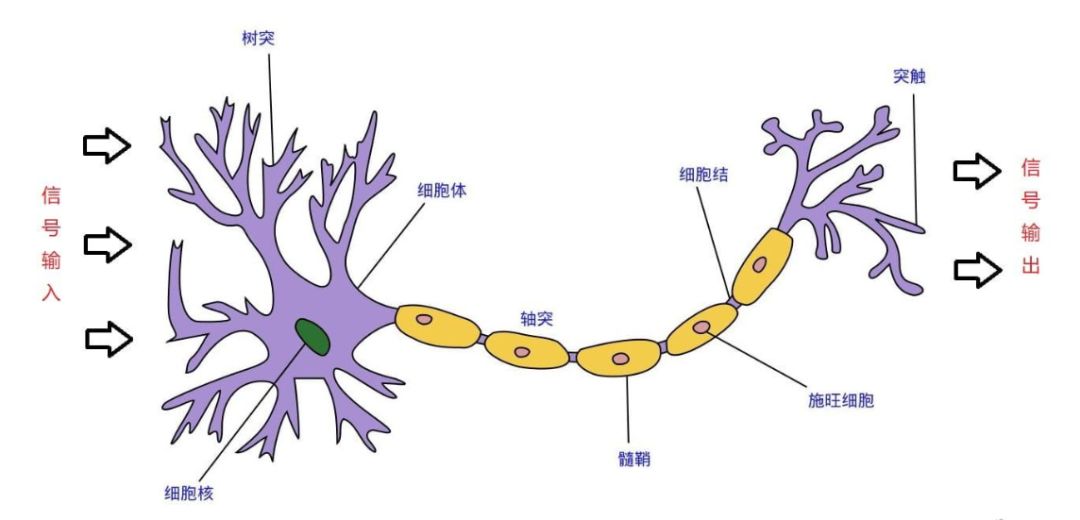

先來說說神經(jīng)元的工作原理。

當人腦的神經(jīng)元接收到信號的時候,神經(jīng)元樹突上的電位差會輕微升高,這個反應被稱為神經(jīng)元突觸的激發(fā)。如果對該神經(jīng)元的刺激達到一定閾值,就會產生動作電位(actional potential),產生動作電位的過程被稱為放電(discharge)。

我們大腦產生和傳遞信息的原理,就隱藏在神經(jīng)元之間的放電反應之中,比如放電的頻率,放電的持久時間,放電反應中不同的電壓等等。

與電子計算機芯片中使用的邏輯門不一樣,大腦神經(jīng)元只在接收到脈沖信號時才會產生動作電位并放射生物電脈沖。也就是說,大腦神經(jīng)元的計算方式,在處理任務的時候會明顯更高效。

最終的結果就是,大腦的功耗理論上會比同樣運算能力的電子計算機低得多——實際上,作為人類文明的基石,人腦的「功耗」僅為 20W。

注:我們一開始認為 20W 這個結論是以訛傳訛,然后我們在arXiv一篇探討深度學習功耗的論文(arXiv 編號 1602.04019)的一處引用中找到了這個數(shù)字的根本出處——德國海德堡大學(1386 年創(chuàng)立,德國最古老的大學)Karlheinz Meier 教授的一項研究。

注:arXiv 是目前世界上最大的免費自然科學論文及其預印本閱讀和交流平臺,始創(chuàng)于 1991 年,目前由康奈爾大學管理。

如果不是鐵證如山,相信很多人難以相信大腦的能耗如此之低——所以基于硅神經(jīng)元打造的類人腦神經(jīng)擬態(tài)芯片也能達到這樣高的能耗比嗎?

答案是可以的。

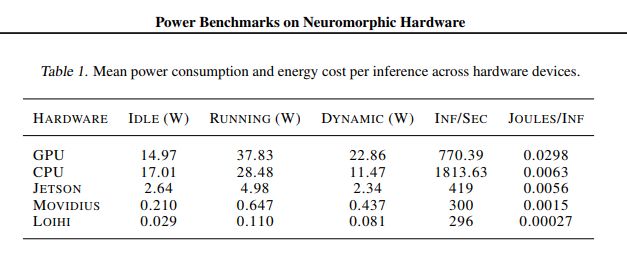

滑鐵盧大學從事人工智能研究的教授 Chris Eliasmith 是 Loihi 芯片和 Pohoiki Beach 的首批合作使用者。根據(jù) Chris 教授的實驗室數(shù)據(jù),同樣實時運行一個深度學習模型并保持相同運算速度的情況下,Loihi 芯片的綜合能耗水平僅為 GPU 的 109 分之一(相關研究成果在 arXiv 上可查論文,編號1812.01739),CPU 的 23.2 分之一。

注:滑鐵盧大學位于加拿大安大略省西南部滑鐵盧市,創(chuàng)建于 1957 年,計算機科學專業(yè)在 2017 年名列 USNEWS 世界大學排名第 18 位。

而當 Chris 教授將深度學習模型的規(guī)模擴大 50 倍之后,Poihiki Beach 在保持相同學習速度的基礎上,功耗只增加了 30%,而能保持速度的傳統(tǒng)智能芯片功耗增加了 5 倍。

考慮到上文提及的 64 核心 Poihiki Beach 系統(tǒng)一共內置了 1320 億個晶體管,這樣的功耗水平實在是低得恐怖。

也許這一章節(jié)硬核得有些過分,我們可以用非常生動形象的例子解釋一下。

我們算 1+1 和算 76x89 的時候,思考的速度是差不多的,因為這兩個算式的算法我們都知道(就像深度學習模型的訓練)——但你算 100 道 1+1 級別的算術題,和你算 100 道 76x89 級別的算術題之后,你肚子餓的程度和你精神疲憊的程度,不會相差太遠。

而神經(jīng)元擬態(tài)計算,乃至幾乎所有的神經(jīng)網(wǎng)絡計算,都是在特定的環(huán)境下運行的——這個環(huán)境叫矩陣運算。我們曾經(jīng)在4個月之前的文章里面討論過矩陣運算的基本原理,這里不詳細展開,感興趣的朋友可以在公眾號后臺回復「TPU」查看原文。

張量矩陣運算示意圖

針對神經(jīng)網(wǎng)絡優(yōu)化的芯片,絕大部分都是在矩陣運算方面有針對性優(yōu)化的,所以其他神經(jīng)網(wǎng)絡芯片,比如谷歌的 TPU ,在深度學習方面都會比傳統(tǒng)的CPU 和 GPU 能耗比更強——只是沒有 Loihi 芯片這么出眾而已。

而能耗比,恰好是車載智能硬件的一大硬傷。

舉個例子,車載電子元件的工作溫度要求一般在-40℃~55℃,更高的標準甚至會將上限設置在 110℃。也就是說,電子元件需要在極高的溫度范圍內保持正常的性能水平和質量水準,這就需要芯片廠商對每一代工藝做大量的優(yōu)化和試驗。

比如英偉達的 Drive PX 系列在改名為 AGX 系列的同時,也經(jīng)受了 ASIL-D 級別標準的認定。黃仁勛在 GTC 大會上面的原話是「這個過程大概要一年多」。

為了適應車載級別的溫度要求,功耗為 250W 的特斯拉 Autopilot 硬件 3.0 上面使用了復雜的水冷散熱,功耗達到 500W 的英偉達 Drive AGX Pegasus 甚至根本沒有車企敢用。

然而我們可以看一下在 Chris 教授論文里面,Loihi 芯片的功耗表現(xiàn):

最大的差距體現(xiàn)在 Running,也就是運行中的功耗比較里,Loihi 以0.11W的功耗就可以達到英偉達 Quadro K4000 專業(yè)級 GPU 在37.83W功耗下同樣的 AI 性能——0.11W 的功耗水平,意味著 Loihi 芯片根本不需要主動散熱(就像我們的腦殼子也沒有進化出一個風扇),省略了大量的結構成本。

可惜,目前 Loihi 芯片的成本和工藝依然是一個短板,14 納米工藝下,英特爾需要極大量的芯片疊加才足以構建不到人腦萬分之一的神經(jīng)元矩陣。所以 Loihi 芯片現(xiàn)階段的主要應用,還是在于智能義肢,或者是深度模型訓練。

但這并不影響英特爾成為目前最接近「人造人腦」這一目標的公司。

結語

1960 年,美國醫(yī)學博士 Jack E.Steele 根據(jù)古希臘語和拉丁文里面「生命」共同的詞根「bio」和表示性質的「nic」詞根,創(chuàng)造出「bionic」,也就是仿生學(仿生學這一中文詞匯來自于大陸 1963 年的翻譯)。

但人類應用仿生學的歷史早已有之。大禹治水時期,人們模仿魚類在水中自由游動的特性,在船尾造木槳,這就是世界上最早的櫓和舵。《韓非子》中記載的魯班以竹木作鳥「成而飛之,三日不下」,這是世界上最早的人造飛行器記錄。

人類的生產力在不斷提高,野心也在不斷提高,最終就是人越來越懶,什么都不希望自己干,甚至于思考本身,都希望找到代勞者。半個世紀以來的電子計算機,便是人類對終極仿生學追求的縮影——如果能造一個大腦就好了。

無論是你我手中的電腦,或者是 Model 3 里面裝著的 Autopilot 硬件,它們都只是以科技的手段實現(xiàn)了大腦的「運算」能力,而并未真正發(fā)揮大腦的優(yōu)勢。

依照大腦結構依葫蘆畫瓢的英特爾新芯片,會是自動駕駛領域尚未升起的朝陽嗎?由此延伸開去,它會是人類真正掌握「思考」這一命題的普羅米修斯嗎?

只有時間能給我們解答。

-

芯片

+關注

關注

456文章

51155瀏覽量

426325 -

AI

+關注

關注

87文章

31490瀏覽量

269915

原文標題:關注丨最像人腦的AI芯片來了,你的車子以后會有自己的想法?!

文章出處:【微信號:e700_org,微信公眾號:汽車工程師】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

盤點那些在我們生活的AI科技

【書籍評測活動NO.55】AI Agent應用與項目實戰(zhàn)

未來AI大模型的發(fā)展趨勢

AI for Science:人工智能驅動科學創(chuàng)新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創(chuàng)新》第二章AI for Science的技術支撐學習心得

匯川技術推出Finovision鳳麟AI云平臺

請回答OpenHarmony | 關于開源生態(tài)的未來想象,我們現(xiàn)場回答

嵌入式系統(tǒng)的未來趨勢有哪些?

超星未來與埃夫特達成戰(zhàn)略合作,攜手打造具身智能「通用大腦」

比爾·蓋茨展望AI未來:從AI顧問到深度智能體的演變

Imagination 引領邊緣計算和AI創(chuàng)新,擁抱AI未來發(fā)展

AI 的未來,就在我們的大腦里面嗎?

AI 的未來,就在我們的大腦里面嗎?

評論