人類(lèi)每天都在進(jìn)行不同層次的規(guī)劃活動(dòng),比如說(shuō)每天早上起床以后,你習(xí)慣性走到廚房喝一杯咖啡:你會(huì)先走下走廊,左轉(zhuǎn)進(jìn)入過(guò)道,然后進(jìn)入右邊的房間。

對(duì)于這些習(xí)慣成自然的流程,你無(wú)需思考,不會(huì)刻意去想你要使用哪一個(gè)肢體動(dòng)作。但對(duì)于機(jī)器人而言,這并非易事。

Facebook剛剛發(fā)布了主導(dǎo)研究的新系統(tǒng),讓機(jī)器人也可以通過(guò)觀看視頻,拆解動(dòng)作,并學(xué)習(xí)如何組合這些動(dòng)作形成自己的規(guī)劃。

層級(jí)抽象結(jié)構(gòu)(hierarchal abstractions)

已經(jīng)有越來(lái)越多的研究表明,層級(jí)抽象結(jié)構(gòu)(即視覺(jué)運(yùn)動(dòng)子程序)可以提高強(qiáng)化學(xué)習(xí)中的采樣效率,這是一種利用獎(jiǎng)勵(lì)驅(qū)動(dòng)智能體達(dá)到目標(biāo)的AI訓(xùn)練技術(shù)。

在過(guò)去,這些層次結(jié)構(gòu)必須通過(guò)端到端的訓(xùn)練來(lái)手動(dòng)編碼或獲取,而這需要大量的時(shí)間、注意力和長(zhǎng)久的耐心。

Facebook這次的新研究提出,刻意讓機(jī)器人通過(guò)觀看視頻學(xué)習(xí)導(dǎo)航,描述一個(gè)通過(guò)用逆向機(jī)器學(xué)習(xí)模型攝取視頻偽標(biāo)簽(在本文中,偽標(biāo)簽指智能體想象的行為),從而學(xué)習(xí)層次結(jié)構(gòu)的系統(tǒng)。

論文作者分別來(lái)自Facebook AI研究室,加州大學(xué)伯克利分校和伊利諾伊大學(xué)厄巴納—香檳分校。

這讓人想起去年Facebook開(kāi)源的一組模型——Talk the Walk。它只需要360°的全景圖像、自然語(yǔ)言以及一張有當(dāng)?shù)氐貥?biāo)(比如銀行和餐館)的地圖就可以通過(guò)問(wèn)路,實(shí)現(xiàn)在整個(gè)紐約市的街道導(dǎo)航。

具體實(shí)現(xiàn)方式

機(jī)器人通過(guò)觀看這些視頻,研究這些簡(jiǎn)單的視覺(jué)運(yùn)動(dòng)子程序是如何組合以達(dá)到高級(jí)的抽象層次,這些視覺(jué)運(yùn)動(dòng)子程序能夠解決一些已知問(wèn)題,即經(jīng)典的規(guī)劃中的高計(jì)算成本和強(qiáng)化學(xué)習(xí)中的樣本復(fù)雜性的問(wèn)題。

研究者提出的系統(tǒng)分為兩個(gè)階段,在第一階段,研究人員通過(guò)運(yùn)行在隨機(jī)探索數(shù)據(jù)上自我監(jiān)督的智能體模型生成偽標(biāo)簽。模型從分布在四個(gè)環(huán)境中的1500個(gè)不同位置學(xué)習(xí),在不同的位置隨機(jī)執(zhí)行30個(gè)不同步驟的動(dòng)作,從而產(chǎn)生45,000個(gè)交互樣本。

在系統(tǒng)的第二階段,大約217,000個(gè)偽標(biāo)記視頻被剪輯成220萬(wàn)個(gè)單獨(dú)的小視頻,再將其輸入預(yù)測(cè)參考視頻中相應(yīng)動(dòng)作的模型,同時(shí)再通過(guò)一個(gè)單獨(dú)的網(wǎng)絡(luò)檢查參考視頻中的動(dòng)作序列,并編碼其行為作為向量。另一個(gè)模型通過(guò)推斷第一幀的軌跡的編碼,來(lái)預(yù)測(cè)哪一個(gè)子程序可以調(diào)用給已有的視頻幀。

交互樣本從1000萬(wàn)減少到4.5萬(wàn)

在一個(gè)部署在辦公環(huán)境的真實(shí)世界中的機(jī)器人實(shí)驗(yàn)中,研究人員表明,相比單純交互的方法,至少應(yīng)用在之前從未見(jiàn)過(guò)的環(huán)境上,通過(guò)觀看視頻來(lái)學(xué)習(xí)技能(這里指采用最高效的方式前往目標(biāo)位置)的方式能達(dá)到更好的效果。

最令人印象深刻的是,訓(xùn)練有素的模型學(xué)會(huì)了自主地前進(jìn)導(dǎo)航并避開(kāi)障礙物,比通過(guò)單純交互方式要快4倍,這使得機(jī)器人能夠做到完全自主地長(zhǎng)距離行進(jìn)。

“特別引人注目的是,這些模型從總計(jì)45,000次的環(huán)境交互中學(xué)習(xí),”研究人員寫(xiě)道,“從第一視角的視頻中成功學(xué)習(xí),使得智能體能夠執(zhí)行連貫的軌跡,即使它只執(zhí)行過(guò)隨機(jī)動(dòng)作。此外,它優(yōu)于最先進(jìn)的技能學(xué)習(xí)技術(shù),該技術(shù)需要更大量的訓(xùn)練樣本,大致1000萬(wàn)個(gè)。”

-

機(jī)器人

+關(guān)注

關(guān)注

211文章

28632瀏覽量

208050 -

Facebook

+關(guān)注

關(guān)注

3文章

1429瀏覽量

54894

原文標(biāo)題:Facebook讓機(jī)器人“觀看”上萬(wàn)次視頻后,TA學(xué)會(huì)了自主繞道走路

文章出處:【微信號(hào):BigDataDigest,微信公眾號(hào):大數(shù)據(jù)文摘】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

構(gòu)建人形機(jī)器人學(xué)習(xí)的合成運(yùn)動(dòng)生成管線

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】2.具身智能機(jī)器人的基礎(chǔ)模塊

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】2.具身智能機(jī)器人大模型

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】1.初步理解具身智能

【「具身智能機(jī)器人系統(tǒng)」閱讀體驗(yàn)】+初品的體驗(yàn)

《具身智能機(jī)器人系統(tǒng)》第1-6章閱讀心得之具身智能機(jī)器人系統(tǒng)背景知識(shí)與基礎(chǔ)模塊

麻省理工學(xué)院推出新型機(jī)器人訓(xùn)練模型

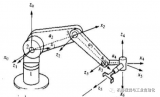

機(jī)器人的三大矩陣是什么及關(guān)系式

“卷不動(dòng)了”?OTA來(lái)救場(chǎng)!智能機(jī)器人“永葆青春”的秘訣

ROS讓機(jī)器人開(kāi)發(fā)更便捷,基于RK3568J+Debian系統(tǒng)發(fā)布!

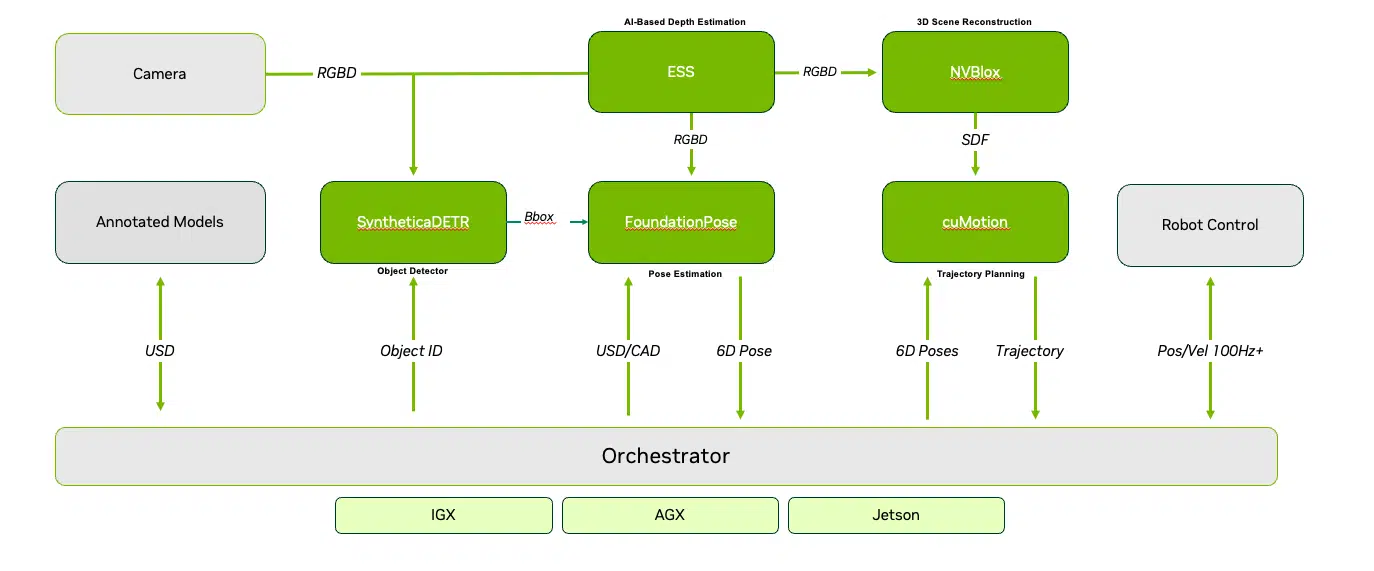

NVIDIA Isaac 機(jī)器人平臺(tái)利用最新的生成式 AI 和先進(jìn)的仿真技術(shù),加速 AI 機(jī)器人技術(shù)的發(fā)展

奧比中光攜手新加坡LionsBot,讓智能清潔機(jī)器人落地超過(guò)30個(gè)國(guó)家

NVIDIA Isaac機(jī)器人平臺(tái)升級(jí),加速AI機(jī)器人技術(shù)革新

機(jī)器人學(xué)習(xí)中主流智能抓取方案

自主移動(dòng)機(jī)器人(AMR)功能和特點(diǎn)

Facebook讓機(jī)器人學(xué)會(huì)了自主繞道走路

Facebook讓機(jī)器人學(xué)會(huì)了自主繞道走路

評(píng)論