卷積網絡的部署通常在固定資源的情況下進行,如果想要提高精度就需要更多的資源來部署更大、更深的網絡。實際應用中,人們可以把ResNet-18拓展到ResNet-200增加層數提高精度,谷歌近期提出的GPipe也利用提升規模的方法在ImageNet上實現了84.3%的top-1精度。

Gpipe模型與ResNet不同規模的模型

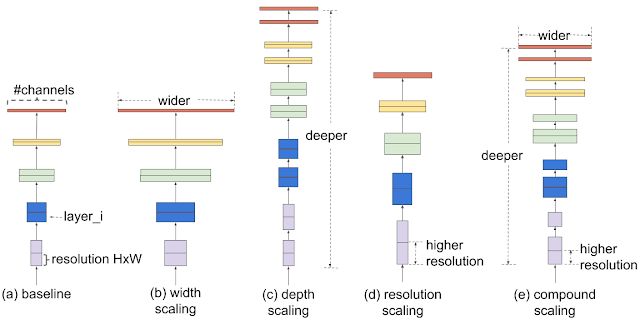

對于擴大模型的規模,通常的做法是增加卷積網絡的深度或寬度,或者利用更大的輸入分辨率來訓練和測評。雖然能夠大幅度提升精度,但需要復雜的手工調校來進行優化。

那么我們能不能找到一種更為通用的方法來使擴大CNNs的規模以得到更好的精度和速度呢?谷歌在今年的ICML會議上給出了一種可行的解決方案。研究中提出了一種名為EfficientNet,通過簡單高效地混合系數來結構化地擴大CNNs的規模。與先前提高網絡維度參數不同,這種新的方法不會去調整寬度、深度和分辨率,而是利用固定的規模系數集均勻化地對每個維度進行擴增。

基于這種規模化方法和自動機器學習,研究人員開發出了新的網絡家族EfficientNets,不僅在精度上超過了前輩,更在效率上有了10倍的提升。

混合模型規模化—擴大CNNs規模的好方法

研究人員首先系統地分析了不同維度上的規模化對于模型的影響。

在深度、寬度和分辨率等維度上記性擴充后的模型效果提升,但單個維度在達到80%后很快趨近于飽和。

分別對于不同的維度進行規模化后,研究人員發現對于網絡寬度、深度和圖像分辨率等所有維度的平衡下對于模型的表現提升最好。所以混合而不是單一的改變模型的規模是提升性能的較好選擇。混合規模化方法的第一步是進行柵格搜索,在固定資源限制的條件下尋找不同規模維度下的關系。這將為不同的維度尋找適宜的規模化系數來實現最好的效果。隨后利用這些搜索到的系數來對基準網絡進行擴充,在給定的計算資源和模型大小下實現目標模型。

上圖顯示了不同規模化的方法,與先前的方法不同,新提出的混合規模化方法在所有的維度上進行了規模化提升。

實驗表明這種混合規模化方法比mobileNet(+1.4%)和ResNet(+0.7%)都有提升。

EfficientNet架構

前述的模型在規模化的時候依然高度依賴于基礎網絡模型。所以為了更好的提高模型的表現,研究人員提出了新型基準網絡模型。利用自動機器學習框架來進行神經架構搜索,同時優化了精度和效率(FLOPS)。

最終的架構類似MobileNetV2和MnasNet,使用了移動反轉瓶頸卷積結構(mobile inverted bottleneck),但在規模上有些許擴大。基于這一基礎網絡,研究人員利用不同的擴充方式得到了規模化的網絡家族EfficientNets。

簡單的基準模型更容易擴展和規模化

EfficientNet的表現

為了測試模型的性能,研究人員在ImageNet上對現有的先進模型與EfficientNet進行了比較,結果表明EfficientNet在精度和效率上都超過了現有的模型,甚至在相同精度下將模型參數和操作減小了一個數量級。

在下圖中可以看到,在左上角的高精度區域,B7型EfficientNet在ImageNet上達到了84.4%的top-1精度和97.1%的top-5精度,但與先前的GPipe相比在CPU上的運行使用的參數減小了8.4倍同時速度提升了6.1倍。與廣泛使用的ResNet-50相比,相同參數的情況下提升了6.3%的top-1精度。

結果顯示了新的模型家族在精度與效率上的優勢。

此外,為了驗證模型的其他數據集上的表現,研究人員還將模型遷移到了CIFAR-100和Flowers上,EfficientNet在參數減少一個數量級(21x)的情況下在8個測試數據集中的5個上取得了最好的精度,證明了這一方法具有穩定的泛化能力。這種新的模型有望成為計算機視覺任務的新基準,研究人員開源了所有的代碼,同時可以看在這里找到基于TPU的加速實現

-

谷歌

+關注

關注

27文章

6211瀏覽量

106522 -

卷積網絡

+關注

關注

0文章

43瀏覽量

2305

原文標題:谷歌最新研究EfficientNet,通過AutoML和模型規模化提升精度與效率

文章出處:【微信號:thejiangmen,微信公眾號:將門創投】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

卷積網絡最新研究:通過AutoML和模型規模化提升精度與效率

卷積網絡最新研究:通過AutoML和模型規模化提升精度與效率

評論