北京時(shí)間 1 月 25 日凌晨 2 點(diǎn), DeepMind 直播了他們的 AI AlphaStar 和人類頂尖的職業(yè)電競選手對戰(zhàn)星際爭霸 2。根據(jù) DeepMind 介紹,AlphaStar 在 2018 年 12 月 10 日和 19 日先后以 5:0 全勝的戰(zhàn)績擊敗了 2 位國際頂級的人類選手,此次直播的過程中也播放了之前比賽的重放。雖然 AlphaStar 在最后一場現(xiàn)場直播的比賽中惜敗,但是仍然保持對人類 10 勝 1 敗的戰(zhàn)績。

星際在全球玩家眾多,是最流行的一款實(shí)時(shí)策略游戲之一,而 DeepMind 匯聚了全球最頂尖的人工智能科學(xué)家,似乎兩者出現(xiàn)在同一個(gè)場景里有些違和。大眾刻板印象里面,科學(xué)家一般都與實(shí)驗(yàn)科研為伍,怎么會對玩星際感興趣呢?

其實(shí)如果大家對于 DeepMind 這個(gè)公司有所了解的話,就會發(fā)現(xiàn)這個(gè)世界一流的人工智能團(tuán)隊(duì)實(shí)際就是一路打游戲過來的。DeepMind 的創(chuàng)始人 Demis Hassabis 自小酷愛國際象棋,13 歲就成為了國際象棋大師。之后他于 2010 年成立 DeepMind,專門開發(fā)能夠玩游戲的人工智能。這個(gè)時(shí)候人工智能領(lǐng)域大火,DeepMind 順勢推出了自己的深度強(qiáng)化學(xué)習(xí) (Deep Reinforcement Learning),并于 2014 年在 Atari 游戲里面超過了人類水平。2014 年之后 DeepMind 被 Google 收購,借助 Google 的資源優(yōu)勢繼續(xù)研發(fā),從此在游戲領(lǐng)域一騎絕塵。2016 年和 2017 年 DeepMind 的 AI 先后戰(zhàn)勝圍棋世界冠軍李世石和柯潔。接著 DeepMind 又推出了 AlphaZero,完全不借助人類棋譜,幾個(gè)小時(shí)之內(nèi)就在圍棋,國際象棋和日本將棋上超過了人類水平。

DeepMind 之所以對于游戲如此熱衷,除了創(chuàng)始人的游戲情節(jié)以外,最關(guān)鍵的還是游戲本身就是絕佳的人工智能測試環(huán)境。游戲就是人為創(chuàng)造的,用以幫助人來習(xí)得某個(gè)技能或者測試技能水平的工具。游戲通過提供明確的反饋,使人可以在短期內(nèi)不斷重復(fù)某些行為,從而習(xí)得技能。比如很多棋類游戲的設(shè)計(jì)初衷就是鍛煉分析決策能力。當(dāng)然也有專門用來讓人獲得愉悅的游戲,比如說許多網(wǎng)絡(luò)游戲。這些游戲一般會有很強(qiáng)獎勵(lì)(比如獲得金幣之類),獲得獎勵(lì)的速度也很快,這就是這類游戲容易讓人沉迷的原因。

回過頭來說星際本身。為什么 DeepMind 的科學(xué)家們看中了這么一款游戲呢?原因主要是星際爭霸有這樣兩個(gè)特點(diǎn):

第一星際爭霸的動作空間和策略非常復(fù)雜。圍棋雖然每次落子的變化也很多,但是每次畢竟只是需要根據(jù)盤面挑選落子地方,還算比較簡單。相對而言,星際爭霸里面的的動作空間就很復(fù)雜,玩家需要:

1)積累資源

2)建設(shè)工廠

3)組建軍隊(duì)

4)消滅對方的工事

每一個(gè)動作之間相互有影響,許多動作產(chǎn)生的后果是很長期的

第二玩家沒有全部的信息。基本上來說玩家只知道顯示在屏幕上面的一小部分區(qū)域的信息。而真正的地圖是很大。所以如果他們想要知道對手的信息,需要派出專門的偵查兵

為了這次的對戰(zhàn),DeepMind 其實(shí)已經(jīng)準(zhǔn)備已久。去年 DeepMind 和暴雪聯(lián)合推出了基于星際爭霸 2 的強(qiáng)化學(xué)習(xí)測試平臺并且發(fā)布了論文《StarCraft II: A New Challenge for Reinforcement Learning》。這次參與對戰(zhàn)的 AI 也是從這個(gè)平臺上訓(xùn)練得到的。這里主要解答一些大家可能關(guān)心的問題。AlphaStar 的視角能夠看到的是什么信息?它的操作和人是否一樣?有沒有作弊?

AlphaStar 到底是看到的什么呢?

我們都知道人類玩家在玩星際的時(shí)候看到的是計(jì)算機(jī)屏幕的信息(如果是團(tuán)戰(zhàn)可能還會有場下交流)。計(jì)算機(jī)屏幕上面的信息是標(biāo)準(zhǔn)的視頻流。人類玩家首先做的實(shí)際上是識別哪個(gè)士兵,哪個(gè)是工廠。在計(jì)算機(jī)視覺里面,這些被稱為物體識別和場景識別任務(wù)。值得一提的是識別這些人物本身很困難,但和策略的部分關(guān)系不大。所以 Deepmind 對問題進(jìn)行了一些簡化。 AlphaStar 以圖像的方式從游戲引擎里面讀取特征信息,這些圖像直接標(biāo)記了哪里是兵或者工廠。你可以想象,AlphaStar 有很多只眼睛,有的看到兵,有的看到所有的工廠。除了計(jì)算機(jī)屏幕上面的信息,AlphaStar 還可以看到一個(gè)粗略的全景地圖,可以另外知道一些全局的信息,比如當(dāng)前有多少資源,多少兵力等等。AlphaStar 看到的視角實(shí)際上長得像是下面這個(gè)樣子。

那么 AlphaStar 是怎么進(jìn)行操作呢?

人類玩家都知道玩星際很多時(shí)候是拼手速。操作速度快的人基本可以碾壓操作速度慢的人。人類一般一分鐘進(jìn)行 30 到 300 次操作。最厲害的人類選手大概是每分鐘 500 次操作。理論上計(jì)算機(jī)的操作速度遠(yuǎn)遠(yuǎn)超過人類,所以如果不限定操作速度的話,比較基本上沒有意義了。在 DeepMind 發(fā)布的工具包里面,操作速度被限制為每分鐘 180 次。除此以外,DeepMind 盡量讓 AlphaStar 的操作和人的操作是一樣的。人類玩家的正常操作一般來說是一個(gè)鼠標(biāo)鍵盤序列。比如說要移動兵的話,人一般會先按 m 代表進(jìn)入 move 操作,再按 shift 同時(shí)點(diǎn)擊要移動的兵。AlphaStar 的操作也會產(chǎn)生類似的序列。

根據(jù)上面的信息,我們知道 AlphaStar 的輸入和輸出其實(shí)和人類選手是差不多的,并沒有特殊作弊的行為。從這次的比賽視頻來看,AlphaStar 在選擇策略上如同職業(yè)選手般嫻熟,非常令人驚嘆。那么 Deepmind 大概是用了什么樣的方法來訓(xùn)練 AlphaStar 的呢?Deepmind 在賽后發(fā)布了一篇博客進(jìn)行了介紹。據(jù)說相應(yīng)的論文正在同行評議中,相信不久就會將看到細(xì)節(jié)。這里我結(jié)合博客內(nèi)容和我自己相關(guān)的經(jīng)驗(yàn)進(jìn)行下簡單介紹。

Deepmind AI 的深度網(wǎng)絡(luò)由多個(gè)模塊構(gòu)成,看起來主要的網(wǎng)絡(luò)是一個(gè)被稱為 Transformer 和 LSTM 的網(wǎng)絡(luò)結(jié)構(gòu)構(gòu)建。這類網(wǎng)絡(luò)最重要的特點(diǎn)就是有很長的記憶能力,可以在很長的序列里面自動找到數(shù)據(jù)中的關(guān)聯(lián),早期這類網(wǎng)絡(luò)是在自然語言處理里面成熟的。之所以這次使用這樣的網(wǎng)絡(luò)結(jié)構(gòu),我猜測主要是星際里面的很多動作的影響時(shí)間很長,比如說開始建一個(gè)工廠到真正這個(gè)工廠開始能夠提供物資需要過很久。訓(xùn)練的過程和初代版的 AlphaGo 類似,結(jié)合了有監(jiān)督學(xué)習(xí) (Supervised Learning) 和強(qiáng)化學(xué)習(xí) (Reinforcement Learning)。這兩種學(xué)習(xí)方法其實(shí)我們?nèi)祟愐渤S?— 有監(jiān)督學(xué)習(xí)相當(dāng)于從課本上面學(xué)習(xí),而強(qiáng)化學(xué)習(xí)像是從實(shí)踐中摸索。有監(jiān)督學(xué)習(xí)和強(qiáng)化學(xué)習(xí)并用,就相當(dāng)一個(gè)人先從課本上學(xué)習(xí)大概知識然后學(xué)以致用,在實(shí)踐中不斷改進(jìn)。

在 AlphaStar 中,第一步的訓(xùn)練是在暴雪提供的數(shù)據(jù)集上進(jìn)行的有監(jiān)督學(xué)習(xí)。據(jù) DeepMind 稱,經(jīng)過有監(jiān)督學(xué)習(xí),AlphaStar 對暴雪的內(nèi)置 AI 能保持 95% 上的勝率。接下來很多經(jīng)過有監(jiān)督學(xué)習(xí)的 AlphaStar 進(jìn)行聯(lián)賽 (League),相互對打,在這個(gè)過程中使用強(qiáng)化學(xué)習(xí)不斷提升能力。下面這個(gè)圖展示了這兩個(gè)階段水平的提升。

可以看出,有監(jiān)督學(xué)習(xí)使得 AlphaStar 達(dá)到人類中的金牌水平(Gold Level),在進(jìn)行了 8 天強(qiáng)化學(xué)習(xí)之后,AlphaStar 最終超過人類選手 TLO。14 天之后超過了人類選手 MaNa。值得一提的是,在 14 天的強(qiáng)化學(xué)習(xí)訓(xùn)練期間,每個(gè) AlphaStar 相當(dāng)于完成了 200 年的游戲試驗(yàn)。尤其是多個(gè) AlphaStar 相互對戰(zhàn),需要的計(jì)算量極其巨大。為了加快計(jì)算速度 DeepMind 使用了 Google's v3 TPU (向量計(jì)算單元)開發(fā)了一個(gè)分布式訓(xùn)練系統(tǒng)。TPU (Tensor processing unit) 是 Google 開發(fā)的專門用于人工智能的處理器,從 2016 年推出,至今已經(jīng)演進(jìn)到第三代。每一個(gè) AlphaStar 智能體使用了 16 塊 三代 TPU,這是相當(dāng)驚人的計(jì)算能力 — 要知道幾個(gè)小時(shí)滅掉 AlphaGo 的 AlphaZero 在對弈的時(shí)候也不過只用了 4 塊一代 TPU。

AlphaStar 之所以能夠使用 TPU 的強(qiáng)大算力,得益于從 16 年起 Deepmind 將主要研究平臺轉(zhuǎn)移到了 TensorFlow 上面。TensorFlow 是 Google 開發(fā)的開源機(jī)器學(xué)習(xí)平臺,如今也是最受歡迎機(jī)器學(xué)習(xí)系統(tǒng)之一。TPU 就是專門為 TensorFlow 開發(fā)的硬件。除了 DeepMind 以外,Google 大部分的人工智能系統(tǒng)也都是基于 TensorFlow。

芯片領(lǐng)域有一個(gè)摩爾定律,就是計(jì)算力隨著時(shí)間是指數(shù)增長的。其實(shí)人工智能領(lǐng)域也有著類似的規(guī)律,比如說 AlphaGo 對陣?yán)钍朗臅r(shí)候人類尚可一戰(zhàn),不久之后對戰(zhàn)柯潔人已經(jīng)完全不在 一個(gè)量級。相信隨著時(shí)間的前進(jìn),AlphaStar 也會不斷的強(qiáng)大,同時(shí)在更多的問題上人工智能也會超過人類。許多人因此擔(dān)憂人會隨著人工智能的發(fā)展人變得多余。其實(shí)我們大可不必?fù)?dān)憂,雖然如今人工智能在許多地方取得了不俗的成就,但其本質(zhì)仍然是人類的工具。人類歷史其實(shí)就是一個(gè)不斷的發(fā)明創(chuàng)造新的工具的歷史,從火的使用,到蒸汽機(jī),再到如今的人工智能,無一不是如此。在新的時(shí)代,新的人類必然會懂得如何去使用全新的工具。AlphaStar 的星際爭霸首秀,可能是這個(gè)新的時(shí)代的又一個(gè)序章。回到文初的問題,為什么科學(xué)家們會對星際爭霸如此癡迷 — 因?yàn)檫@不僅是游戲里的星際,更是人類的星辰大海。

-

人工智能

+關(guān)注

關(guān)注

1794文章

47642瀏覽量

239617 -

DeepMind

+關(guān)注

關(guān)注

0文章

131瀏覽量

10912

原文標(biāo)題:AlphaStar 星際首秀,人工智能走向星辰大海

文章出處:【微信號:tensorflowers,微信公眾號:Tensorflowers】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

NVIDIA RAPIDS cuDF如何賦能AI加速數(shù)據(jù)科學(xué)

深開鴻亮相“小小科學(xué)家”品牌發(fā)布暨科學(xué)探索研學(xué)營開營活動

西湖大學(xué):科學(xué)家+AI,科研新范式的樣本

AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第4章-AI與生命科學(xué)讀后感

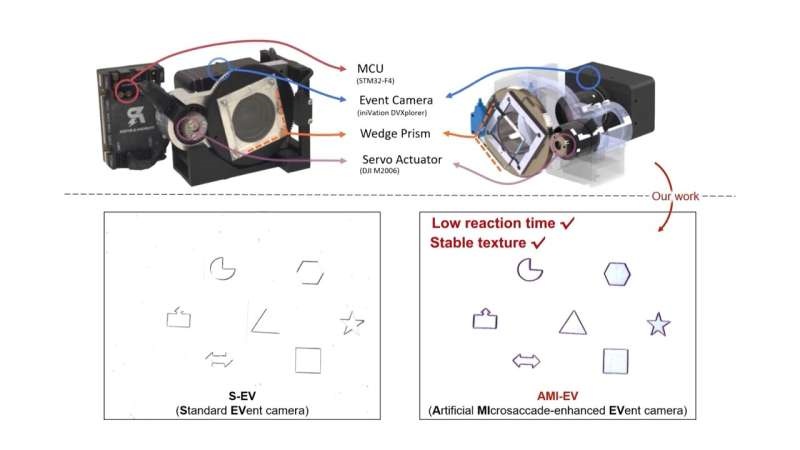

受人眼啟發(fā)!科學(xué)家開發(fā)出新型改良相機(jī)

中國科學(xué)家發(fā)現(xiàn)新型高溫超導(dǎo)體

天津大學(xué)科學(xué)家突破人類大腦器官成功驅(qū)動機(jī)器人

新華社:突破性成果!祝賀我國科學(xué)家成功研發(fā)這一傳感器!

前OpenAI首席科學(xué)家創(chuàng)辦新的AI公司

科學(xué)家研制出一款新型柔性X射線探測器

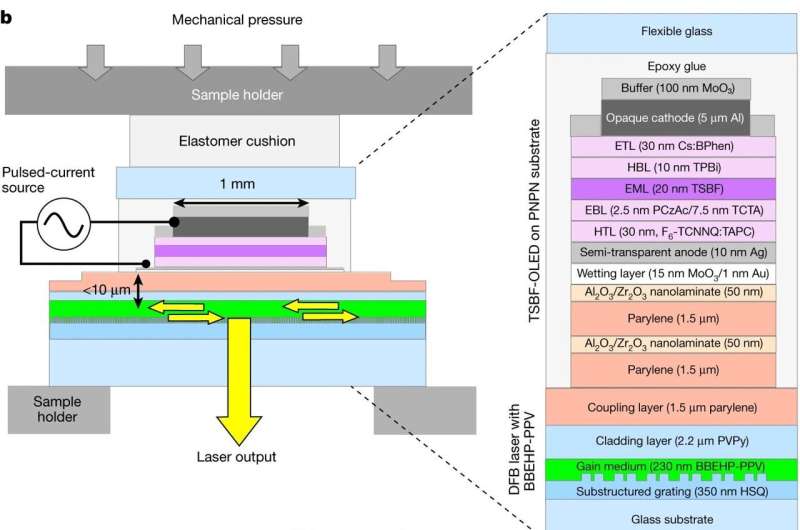

科學(xué)家開發(fā)電驅(qū)動有機(jī)半導(dǎo)體激光器

本源量子參與的國家重點(diǎn)研發(fā)計(jì)劃青年科學(xué)家項(xiàng)目啟動會順利召開

谷歌DeepMind推出新一代藥物研發(fā)AI模型AlphaFold 3

NVIDIA首席科學(xué)家Bill Dally:深度學(xué)習(xí)硬件趨勢

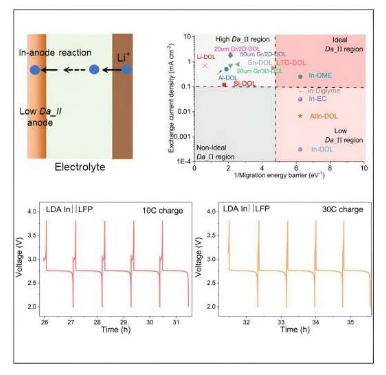

康奈爾大學(xué)科學(xué)家研制出5分鐘快速充電鋰電池

為什么DeepMind的科學(xué)家們對星際爭霸如此癡迷

為什么DeepMind的科學(xué)家們對星際爭霸如此癡迷

評論