UDP成為低延時流媒體關鍵 選SRT還是QUIC?

無論是SRT還是QUIC,UDP都成為實現低延遲視頻流傳輸的必選項。在剛剛結束的俄羅斯世界杯,以及即將到來的重大體育賽事中,SRT與QUIC還將有一番較量。LiveVideoStack對原文進行了摘譯。

英特爾QSV技術在FFmpeg中的實現與使用

本文來自英特爾資深軟件工程師張華在LiveVideoStackCon 2018講師熱身分享,并由LiveVideoStack整理而成。在分享中張華介紹了英特爾GPU硬件架構,并詳細解析了英特爾QSV技術在FFmpeg中的具體實現與使用。

日前,LiveVideoStack采訪了愛奇藝CTO劉文峰,他分享了自己的成長經歷,以及最近閱讀的書籍——《孵化皮克斯:從藝術烏托邦到創意帝國的非凡之旅》,他表示,作為愛奇藝的CTO,要幫助公司將科技創新與藝術創意結合,為用戶提供極致的體驗。

Uber的一鍵式聊天智能回復系統

通過機器學習和自然語言理解結束,Uber實現了一套智能的聊天系統,從而有效的提升司機和乘客之間的溝通效率,減少對司機的打擾。

張霖峰:AV1和VVC的格局將在2023年后明朗

本文是MSU評測解讀的系列文章之一。不過Ucodec CEO張霖峰還講述了Video Codec的機會,VVC與AV1的競爭格局,蘋果公司在Video Codec格局中扮演的重要角色等等。

Safari上使用WebRTC指南

盡管Apple在2017年的WWDC上宣布加入WebRTC支持,但仍然沒有看到Apple在支持WebRTC上更深入的舉動,尤其是其不只支持VP8更加強了這種擔憂。

CMAF將在2019年得到快速發展

按照JW Player技術高級副總裁John Luther的說法,CMAF將在2019年快速發展,盡管這項技術在國內還不怎么流行。蘋果、微軟以及Akamai都在支持CMAF。在下周舉行的LiveVideoStackCon 2018上,Akamai 首席架構師William Robert Law將會分享如何通過CMAF提供海量并發的低延遲流媒體服務的。

蘭華峰:商業模式驅動企業參與MSU評測

本文是MSU年度評測解讀的第四篇。LiveVideoStack采訪了Hulu技術總監蘭華峰,由于Hulu內部自成一套Codec評測方法和測試序列,他給出了如何正確使用MSU報告的建議。同時他表示,與傳統的Codec服務商不同,今年獲得前四的3家本土服務商,都提供的是視頻云服務,這也導致他們格外重視MSU的評測結果。

Netflix:通過可視化和統計學改進用戶QoE

本文來自Netflix的技術博客,文章介紹了如何通過統計學的方法來減少播放緩沖時間或減少碼率。LiveVideoStack對原文進行了摘譯。

音頻/視頻技術

為 janus-pp-rec 增加視頻旋正功能

Janus Gateway 支持 server 端錄制,保存的文件格式是對 RTP 報文的一種自定義封裝格式(MJR),音視頻數據單獨存儲,官方提供了一個 janus-pp-rec 的程序,可以把 MJR 格式的文件轉換為其他封裝格式的文件,然后我們可以利用 FFmpeg 把音視頻文件合并為一個文件。

定義和測量延遲

想要優化延遲,可Latency到底是多少?延遲始終是媒體內容傳輸的一個重要關注點,人們也在不斷嘗試用新的方法來優化延遲,本文參考AWS的一些新技術,介紹了延遲的定義,以及如何具體測量延遲,給出了延遲的量化概念。

FFmpeg:Android利用Filter進行音頻數據預處理

本文簡單介紹了移動端Android系統下利用FFmpeg的Filter進行音頻數據預處理的方法。按照慣例先上一份源碼 AndroidFFmpegFilter。

Android音視頻指南-媒體應用架構概述

本節將解釋如何將媒體播放器應用程序分離為媒體控制器(用于UI)和媒體會話(用于實際播放器)。它描述了兩種媒體應用程序架構:一種客戶端/服務器設計,適用于音頻應用程序,另一種是視頻播放器的單活動設計。它還展示了如何使媒體應用程序響應硬件控制并與使用音頻輸出流的其他應用程序合作。

視頻直播技術之iOS端推流

隨著網絡基礎建設的發展和資費的下降,在這個內容消費升級的時代,文字、圖片無法滿足人們對視覺的需求,因此視頻直播應運而生。承載了實時性Real-Time和交互性的直播云服務是直播覆蓋各行各業的新動力。本篇文章將向大家介紹iOS端的推流技術。

編解碼

宋利:許多高手并未參加MSU評測

眾多本土和華人公司積極的參與MSU視頻編碼大賽,上海交通大學教授宋利接受LiveVideoStack采訪時表示,華人在整個編解碼領域有舉足輕重的影響力。但也要看到,許多國外高手并未參與MSU評測,不能盲目樂觀。本文是解讀MSU評測的第二篇。

王豪:HW265到“HW266”

每年的MSU的視頻壓縮評比報告都是多媒體的熱點話題之一,在MSU 2018評比中,華為HW265在多項測試中排名第一。LiveVideoStack采訪了華為媒體技術院視頻編碼團隊負責人王豪,在參賽之前,HW265已經在多領域商用。未來華為將投入到VVC的研發,并看好AV1的下一代AV2。

H264、AAC、RTMP解析

H264碼流文件分為兩層:(1) VCL(Video Coding Layer)視頻編碼層:負責高效的視頻內容表示,VCL 數據即編碼處理的輸出,它表示被壓縮編碼后的視頻數據序列。(2) NAL(Network Abstraction Layer)網絡提取層:負責以網絡所要求的恰當的方式對數據進行打包和傳送,是傳輸層,不管是在本地播放還是在網絡播放的傳輸,都要通過這一層來傳輸。

AV1編碼持續優化

AV1比HEVC有30%以上的編碼效率提升,但編碼復雜度高的離譜。好在AOM聯盟不斷對AV1進行優化,預計今年內AV1的編碼復雜度將降到VP9的10倍以內。

FFmpeg 是如何實現多態的?

眾所周知,FFmpeg 在解碼的時候,無論輸入文件是 MP4 文件還是 FLV 文件,或者其它文件格式,都能正確解封裝、解碼,而代碼不需要針對不同的格式做出任何改變,這是面向對象中很常見的多態特性,但 FFmpeg 是用 C 語言編寫的,那么它是如何使用 C 語言實現了多態特性的呢?

AI智能

AI驅動智能媒體生產

本文總結了發表在IBC2018上的由日本NHK的Hiroyuki Kaneko等撰寫的“AI-DRIVEN SMART PRODUCTION”,介紹了NHK在智能媒體生產方面取得的成就以及今后的發展方向。

AI如何用于現場直播場景

與許多產業一樣,通過軟件和算法輔助,電視與視頻制作很可能被人工智能和機器學習所改造,而當前這些制作任務都是由人來執行。隨著現場直播報道涉及的范圍越來越廣,而相關專業人士的數量稀缺,基于AI的影視制作技術應運而生。

利用人工智能提升足球直播效果

人工智能技術代表著未來無限的可能性,已經在很多領域帶來巨大的沖擊。在足球直播這一領域,版權方需要提供更多更優質的內容以應對日益增長的多元化需求,因此急需提高運營效率的新方式。

在對抗中學習網絡結構——87頁PPT帶你學習Graph中的GAN

近期,圖卷積研究大神Petar Veli?kovi?在蒙特利爾作了一場關于Graph+GAN的報告,詳細講解了圖卷積網絡的基本概念以及最前沿的方法 GCN、GAT (Petar的代表作),以及基于圖的生成式方法,如何使用GAN進行基于圖的學習,并強調需要使用強化學習或Gumbel softmax來進行反向傳播,也指出盡管圖的生成式模型效果很好,但未來還需要在這個方面需要更多的研究者一起探索。

自動生成高效DNN,適用于邊緣設備的生成合成工具FermiNets

來自滑鐵盧大學滑鐵盧 AI 研究所和 DarwinAI 公司的研究者提出一種新思路:生成合成(generative synthesis),利用生成機器來自動生成具備高效網絡架構的深度神經網絡。

圖像

Metal圖像處理——顏色查找表(Color Lookup Table)

一張1024x1024的普通圖片,是由1024 * 1024=1048576個像素點組成,每個像素點包括RGBA共32bit,常見的圖像處理是對相鄰像素點顏色、像素點本身顏色做處理。在對像素點本身顏色做處理的情況下,需要把某個顏色映射成另外一個顏色。

-

英特爾

+關注

關注

61文章

10006瀏覽量

172137 -

機器學習

+關注

關注

66文章

8438瀏覽量

132912 -

Uber

+關注

關注

0文章

411瀏覽量

36292

原文標題:音視頻技術開發周刊 70期

文章出處:【微信號:livevideostack,微信公眾號:LiveVideoStack】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

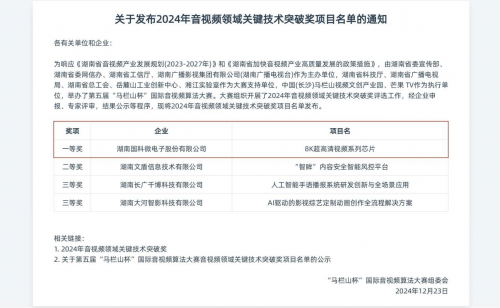

國科微榮獲音視頻領域關鍵技術突破一等獎

AMS-HE120系列:4K HDMI音視頻單網線延長器,引領傳輸技術新潮流

AMS-HE200:HDMI音視頻網絡延長器,開啟傳輸新時代

每周一期,縱覽音視頻技術領域的干貨和新聞投稿

每周一期,縱覽音視頻技術領域的干貨和新聞投稿

評論