編者按:入門深度學習的方法有很多,其中最便捷的是在線課程。但是,從做出這項選擇起,新手要面臨的就不僅是全新的知識體系,還有無數的陌生術語。在開始閱讀前,請自問自答:什么是Adam、ReLU、YOLO?什么是AdaGrad、Dropout、Xavier Initialization?如果發現這很困難,請跟隨Jan Zawadzki的腳步,有條理地去回顧自己的記憶碎片。

本文旨在解釋深度學習的一些常用術語,尤其是吳恩達在deeplearning.ai的Coursera課程中會頻繁提到的重要詞匯。每個詞條包含意義闡釋、圖片和相關鏈接(公眾號讀者請點擊原文查看),希望能對深度學習初學者和從業者有所幫助。

Activation Function(激活函數)

激活函數的作用是對輸入執行非線性變換,將輸入乘以權重并添加到偏置項中。目前最常用的激活函數有ReLU、tanh和sigmoid。

Adam Optimization?(Adam優化)

Adam優化可以代替隨機梯度下降,用來迭代調整網絡權重。根據論文Adam: A Method for Stochastic Optimization的說法,Adam在計算上是高效的,適用于大數據集,并且幾乎不需要超參數調整。它也沒有預定義的、固定的學習率,而是采用自適應學習率。在實際應用中,Adam現在是深度學習模型中的一種默認優化算法。

Adaptive Gradient Algorithm?(自適應梯度算法)

AdaGrad是一種梯度下降優化算法,它根據參數在訓練期間的更新頻率進行自適應調整,更新幅度小、頻率快。它在非常稀疏的數據集上表現良好,如用于在自然語言處理任務中調整詞嵌入。相關論文:Adaptive Subgradient Methods for Online Learning and Stochastic Optimization。

Average Pooling(平均池化)

平均池化指的是對卷積操作的結果計算平均值,并把這個值作為圖像區域池化后的值。它通常用于縮小輸入的大小,主要出現在比較老的卷積神經網絡體系結構中,在現在流行的CNN里,更常見的是maximum pooling(最大池化)。

AlexNet

AlexNet是一個流行的CNN架構,有八層,它比LeNet更廣泛,因此訓練用時也更長。2012年,AlexNet贏得了ImageNet圖像分類挑戰。相關論文:ImageNet Classification with Deep Convolutional Neural Networks。

Backpropagation(反向傳播)

反向傳播是一種用于調整網絡權重以最小化神經網絡損失函數的常用方法,它在神經網絡中從后向前計算,通過對每個激活函數進行梯度下降重新調整權重。

Batch Gradient Descent(BGD)

BGD是一種常規的梯度下降優化算法,它更新的是整個訓練集的參數。在更新參數前,它必須計算整個訓練集的梯度,因此如果數據集很大,BGD可能會很慢。

Batch Normalization

Batch Normalization指的是把神經網絡層中的值歸一化為0到1之間的值,方便更快訓練神經網絡。

Bias (偏差)

當模型在訓練集上精度欠佳時,它被稱為欠擬合。當模型具有高偏差時,它通常不會在測試集上又高準確率。

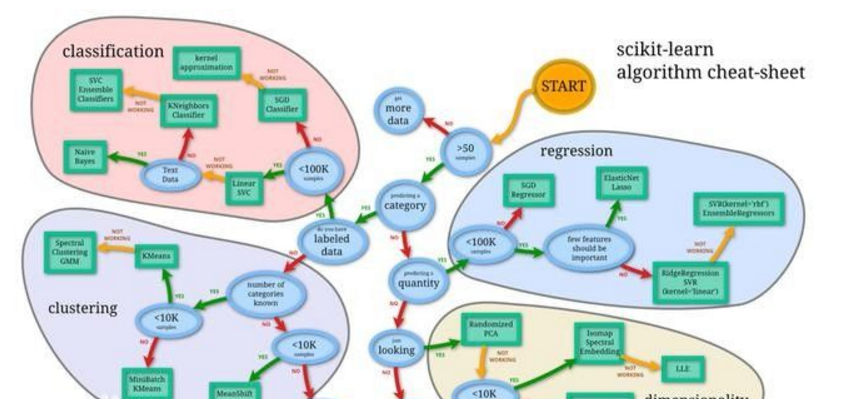

Classification?(分類)

分類指目標變量屬于不同的類,它們不是連續變量。常見的分類任務有圖像分類、欺詐檢測、自然語言處理的某些問題等。

Convolution?(卷積)

卷積指的是將輸入與filter相乘的操作。它是卷積神經網絡的基礎,在識別圖像中的邊緣和物體方面表現出色。

Cost Function?(損失函數)

損失函數又稱loss function,指的是模型的輸出與實際情況之間的差異,這是深度神經網絡學習的關鍵要素之一,因為它們構成了參數更新的基礎。通過將前向傳播的結果與真實結果相比較,神經網絡能相應地調整網絡權重以最小化損失函數,從而提高準確率。常用的損失函數有均方根誤差。

Deep Neural Network(深度神經網絡)

深度神經網絡是具有許多隱藏層(通常超過5層)的神經網絡,但具體以多少層為界,學界還沒有定義。這是機器學習算法的一種強大形式,它在自動駕駛、發現行星等任務中已有應用。

Derivative?(導數)

數是特定點處函數的斜率。計算導數的作用是用梯度下降算法將權重參數調整到局部最小值。

Dropout

Dropout是一種在深度神經網絡中隨機消除節點及其連接的正則化技術。它可以防止模型過擬合,同時加快深度神經網絡的訓練速度。每次更新參數時,Dropout會在訓練期間丟棄不同的節點,這就迫使相鄰節點之間避免過多依賴,并始終保持自身的正確表示。它已經在一些分類任務上明顯改善了模型精度,相關論文:Dropout: A Simple Way to Prevent Neural Networks from Overfitting。

End-to-End Learning?(端到端學習)

端到端學習指的是算法能夠自行解決整個任務,不需要額外的人為干預(如模型切換或新數據標記)。案例:NVIDIA前年發表了一篇論文End to End Learning for Self-Driving Cars,他們訓練了一個只需根據單個前置攝像頭的原始圖像就能讓自動駕駛汽車自行轉向的CNN。

Epoch

一個Epoch表示訓練集中的每個樣本都已經進行過一次完整的前向傳播和反向傳播。單個Epoch涉及每個訓練樣本的迭代。

Forward Propagation?(前向傳播)

前向傳播就是數據被輸入神經網絡后,經過隱藏層、激活函數,最后形成輸出的過程。當節點權重經過訓練后,前向傳播能預測輸入樣本的結果。

Fully-Connected layer?(全連接層)

全連接層指的是和上一層的節點完全連接的神經網絡層,它把上一層的輸出作為輸入,并用其權重轉換輸入,將結果傳遞給下一層。

Gated Recurrent Unit(GRU)

GRU是RNN的一種,主要用于自然語言處理任務,作用是對給定輸入進行多次變換。和LSTM一樣,GRU可以避免RNN中的梯度消失問題,不同的是它只有兩個門(沒有遺忘門),因此在實現類似性能時計算效率更高。相關論文:Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation。

Human-Level Performance

Human-Level Performance從字面上理解就是人類級別的表現,它表示一組人類專家的最佳表現。作為神經網絡性能的一種常用衡量標準,人類表現在改進神經網絡的過程中一直發揮著作用。

Hyperparameters?(超參數)

超參數決定的神經網絡的性能,常見的超參數有學習率、梯度下降迭代次數、隱藏層的數量和激活函數。不要將DNN自學的參數、權重和超參數混淆。

ImageNet

ImageNet是一個包含上千個圖像及其注釋的數據集,它是非常有用的圖像分類任務資源。

Iteration?(迭代)

迭代指的是神經網絡前向傳播和反向傳播的總次數。例如,假設你的訓練集有5個batch,一共訓練了2個epoch,那么你就一共進行了10次迭代。

Gradient Descent?(梯度下降)

梯度下降是一種幫助神經網絡決定如何調整參數以最小化損失函數的方法。我們可以用它重復調整參數,直到找到全局最小值。CSDN上翻譯了Sebastian Ruder的《梯度下降優化算法綜述》,非常值得閱讀。

Layer

Layer指的是一組轉換輸入的激活函數。如下圖所示,神經網絡通常會使用多個隱藏層來創建輸出,常見的有輸入層、隱藏層和輸出層。

Learning Rate Decay(學習率衰減)

學習率衰減指的是在訓練期間改變神經網絡的學習率,它反映了學習的靈活性。在深度學習實踐中,隨著訓練進行,學習率一般是逐漸衰減的。

Maximum Pooling(最大池化)

最大池化表示只選擇特定輸入區域的最大值,它通常用于CNN。以減小輸入的大小。

Long Short-Term Memory(LSTM)

LSTM是一種特殊的RNN,能夠學習輸入的上下文。當相應的輸入遠離彼此時,常規RNN會存在梯度消失問題,而LSTM可以學習這些長期依賴性。相關論文:LONG SHORT-TERM MEMORY。

Mini-Batch Gradient Descent

Mini-Batch Gradient Descent是一種優化算法,它先把訓練數據分成一系列子集,再在上面進行梯度下降。由于這個過程是可以并行的,各個worker可以同時分別迭代不同的mini batch,因此它計算效率更高、收斂更穩健,是batch和SGD的一種有效組合。

Momentum(動量)

Momentum也是一種梯度下降優化算法,用于平滑隨機梯度下降法的振蕩。它先計算先前采取的步驟的方向的平均方向,并在此方向上調整參數更新。這一術語來自經典物理學中的動量概念,當我們沿著一座小山坡向下扔球時,球在沿著山坡向下滾動的過程中收集動量,速度不斷增加。參數更新也是如此。

Neural Network(神經網絡)

神經網絡是一種轉換輸入的機器學習模型,最基礎的NN具有輸入層、隱藏層和輸出層,隨著技術的不斷發展,它現在已經成為查找數據中復雜模式的首選工具。

Non-Max Suppression(非極大抑制)

非極大抑制是物體檢測領域的一種常用算法,它也是YOLO的一部分。它能消除多余的框,找到最佳的物體檢測的位置。相關論文:Learning non-maximum suppression。

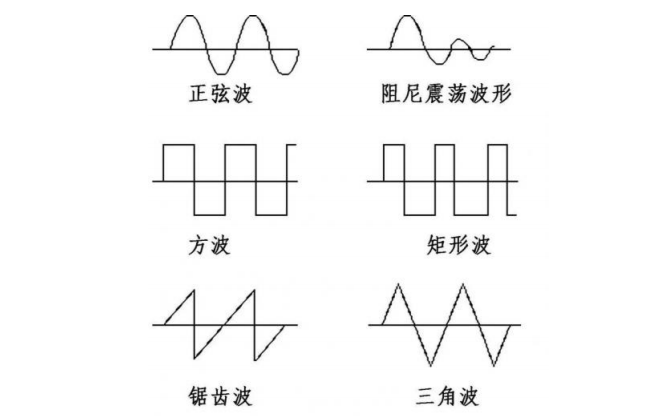

Recurrent Neural Networks?(RNN)

RNN允許神經網絡“理解”語音、文本和音樂的上下文。它通過讓信息循環通過網絡,從而在較早和較晚的層之間保持輸入的重要特征。

ReLU

ReLU是一個簡單的線性變換單元,如果輸入小于零,則輸出為零,否則輸出等于輸入。它通常是現在首選的激活函數,可以幫助更快地訓練。

Regression(回歸)

和分類相對應,回歸也是統計學習的一種形式,只不過它的輸出是連續的變量,而不是分類值。分類為輸入變量分配了一個類,但回歸為輸入變量分配的是無限多個可能的值,而且它通常是一個數字。常見的回歸任務有房價預測和客戶年齡預測。

Root Mean Squared Propagation(RMSProp)

RMSProp隨機梯度下降優化方法的擴展,它以每個參數的學習率為特征,根據參數在先前迭代中的變化速度來調整學習率。

Parameters?(參數)

參數即在應用激活函數之前轉換輸入的DNN的權重。神經網絡的每一層都有自己的一組參數。利用反向傳播算法,我們可以通過調整參數最小化損失函數。

Softmax

Softmax函數,或稱歸一化指數函數,是邏輯函數的一種推廣,常用于DNN的最后一層。它的本質就是將一個K維的任意實數向量壓縮(映射)成另一個K維的實數向量,其中向量中的每個元素取值都介于(0,1)之間。它非常適合有兩個以上輸出的分類任務。

Stochastic Gradient Descent?(隨機梯度下降)

隨機梯度下降法是梯度下降法在機器學習領域的一個變種,它通過抽樣的梯度來近似表示真實的梯度,從而避免大量的計算。

Supervised Learning(監督學習)

監督學習是機器學習的一種形式,其中每個輸入樣本都包含經注釋的標簽。這些標簽的作用是將DNN的輸出和真實結果做對比,并最小化損失函數。

Transfer Learning?(遷移學習)

遷移學習是一種將一個神經網絡的參數用于不同任務而無需重新訓練整個網絡的技術。它的具體方法是使用先前訓練過的網絡中的權重并刪除輸出層,然后用你自己的softmax或logistic圖層替換最后一層,再次訓練網絡。之所以有效,是因為較低的層通常會檢測到類似的邊緣,這些邊緣對其他圖像分類任務也是有效的。

Unsupervised Learning(無監督學習)

無監督學習也是機器學習的一種形式,但是它的輸出類是未知的。常見的無監督學習方法有GAN和VAE。

Validation Set(驗證集)

驗證集通常被用于尋找深度神經網絡的最佳超參數。訓練好DNN后,我們可以在驗證集上測試不同的超參數組合,然后選擇性能最好的組合在測試集上做最終預測。在使用過程中,注意平衡各集的數據占比,比如在有大量數據可用的情況下,訓練集的數據占比應該高達99%,而驗證集合測試集應該各占0.5%。

Vanishing Gradients(梯度消失)

梯度消失是神經網絡到達一定深度后會出現的問題。在反向傳播中,權重根據其梯度或衍生物進行調整,但在深度神經網絡中,較早層的梯度可能會變得非常小,以至于權重根本不會更新。避免這個問題的一種做法是使用ReLU激活函數。

Variance(方差)

當DNN過擬合訓練數據時,我們稱這之中存在方差。DNN無法將噪聲與模式區分開來,并對訓練數據中的每個方差進行建模,具有高方差的模型通常無法準確推廣到新數據。

VGG-16

VGG-16是一種CNN流行網絡架構,它簡化了AlexNet,總共有16層。一些研究已經證實,許多經預訓練的VGG模型可以通過遷移學習被用于其他新任務。

Xavier Initialization?(Xavier初始化)

Xavier初始化是我們在自編碼器中會使用到一種參數初始化方法,它在第一個隱藏層中分配起始權重,以便輸入信號深入神經網絡。之后,它再根據節點和輸出的數量來衡量權重,從而防止信號在網絡中變得太小或太大。

YOLO

YOLO是是目前比較流行的對象檢測算法,它把物體檢測問題處理成回歸問題,用一個卷積神經網絡結構就可以從輸入圖像直接預測bounding box和類別概率。相關論文:YOLO9000: Better, Faster, Stronger。

希望本文能幫助你更深入地理解深度學習世界中使用的術語,在學習Coursera課程時,有需要的讀者不妨把這篇文章放在一旁,更專業、更高效地掌握老師教授的內容。

-

算法

+關注

關注

23文章

4620瀏覽量

93046 -

數據集

+關注

關注

4文章

1208瀏覽量

24737 -

深度學習

+關注

關注

73文章

5507瀏覽量

121272

原文標題:什么是Adam/ReLU/YOLO?這里有一份深度學習(.ai)詞典

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

介紹一些常用的LDO相關術語

深度學習在醫學圖像分割與病變識別中的應用實戰

Allegro做padstack時的術語解釋

LED顯示屏常用術語解釋

半導體一些英文術語你了解嗎?半導體一些術語的中英文對照

基于深度學習的回歸方法YOLO系列簡介

混合信號系統的一些常用術語和接地資料下載

深度ReLU網絡的對應淺層網絡

什么是Adam、ReLU、YOLO?解釋深度學習的一些常用術語

什么是Adam、ReLU、YOLO?解釋深度學習的一些常用術語

評論