前言

當(dāng)下,各種大模型層出不窮,先有 openai 的 chatgpt,后有百度文心一言,再就是國(guó)內(nèi)大模型齊頭并進(jìn)的搶先發(fā)布。

讓普通的開(kāi)發(fā)者不必為不能體驗(yàn) chatgpt 而擔(dān)憂,國(guó)內(nèi)的大模型速度也很快。但是大家目前都是在體驗(yàn),能不能部署一下試試呢?

今天,我們就以華為云 Flexus 云服務(wù)器 X 實(shí)例來(lái)部署一下,順便測(cè)測(cè)其性能看看。

在華為云 828 B2B 企業(yè)節(jié)狂潮中,F(xiàn)lexus X 實(shí)例的限時(shí)大促銷震撼來(lái)襲,絕對(duì)是你不容錯(cuò)過(guò)的超級(jí)福利!對(duì)于那些追求極致算力、對(duì)自建 MySQL、Redis、Nginx 性能有著苛刻要求的技術(shù)極客們,這次活動(dòng)無(wú)疑是你們的專屬盛宴!趕緊抓住這個(gè)千載難逢的機(jī)會(huì),讓業(yè)務(wù)效能飛躍升級(jí)!!!

注意:本文為高端局,對(duì)于還不知道怎么使用 shell 工具,不知道云服務(wù)器為何物?不知道大模型為何物的讀者可以退出啦,本文不太適合

部署千問(wèn)大模型

之前一直就想搞個(gè)大模型玩玩了,奈何電腦配置不打夠,所以只能是可望而不可及,今天,就單獨(dú)用這款華為云 Flexus 云服務(wù)器 X 實(shí)例來(lái)試試。

本文我們基于 Ollama 部署和運(yùn)行大模型,那么,何為 Ollama?

不過(guò)官網(wǎng)上都是洋文,看著比較吃力。我搜了些資料,給大家現(xiàn)個(gè)丑:

Ollama 是一個(gè)強(qiáng)大的框架,設(shè)計(jì)用于在 Docker 容器中部署 LLM。Ollama 的主要功能是在 Docker 容器內(nèi)部署和管理 LLM 的促進(jìn)者,它使該過(guò)程變得非常簡(jiǎn)單。它幫助用戶快速在本地運(yùn)行大模型,通過(guò)簡(jiǎn)單的安裝指令,可以讓用戶執(zhí)行一條命令就在本地運(yùn)行開(kāi)源大型語(yǔ)言模型,例如 Llama 2。

下面,我們來(lái)開(kāi)始實(shí)操!

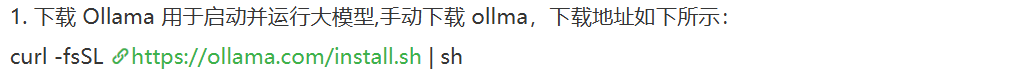

我們可以直接從瀏覽器中輸入,然后會(huì)自動(dòng)下載,當(dāng)然,我們也可以直接從 shell 工具中下載,不過(guò)就是有點(diǎn)慢,他這個(gè)東西還很大。

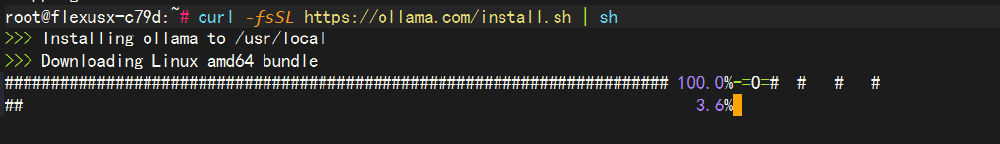

等待的過(guò)程挺漫長(zhǎng),可以先去找點(diǎn)別的事兒去做。

接著等待....

終于在漫長(zhǎng)的等待過(guò)程中,我們將 ollama 下載下來(lái)了啦,下面我們就可以開(kāi)始體驗(yàn)了!!!

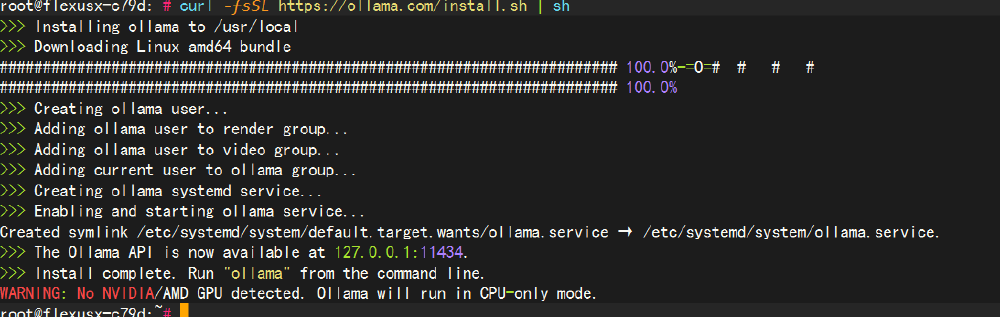

1.啟動(dòng) ollama 的服務(wù)

當(dāng)我們服務(wù)器中有了 ollama 的服務(wù)后,我們需要啟動(dòng)他!命令如下:

systemctl start ollama.service

然后我們?cè)趫?zhí)行一下下面的命令,看看服務(wù)是否已經(jīng)啟動(dòng):

systemctl status ollama.service

3. 設(shè)置服務(wù)開(kāi)機(jī)自啟動(dòng):

sudo systemctl enable ollama

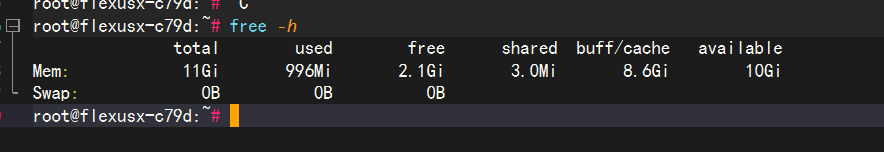

1.查看內(nèi)存占用情況。

兩個(gè)方法都可以查看,第一是從寶塔面板中查看,第二就是直接輸入命令:

free -h

大家可以看的出來(lái),used 這一列,表示的是已使用,目前來(lái)看,并不多。

1.運(yùn)行大模型

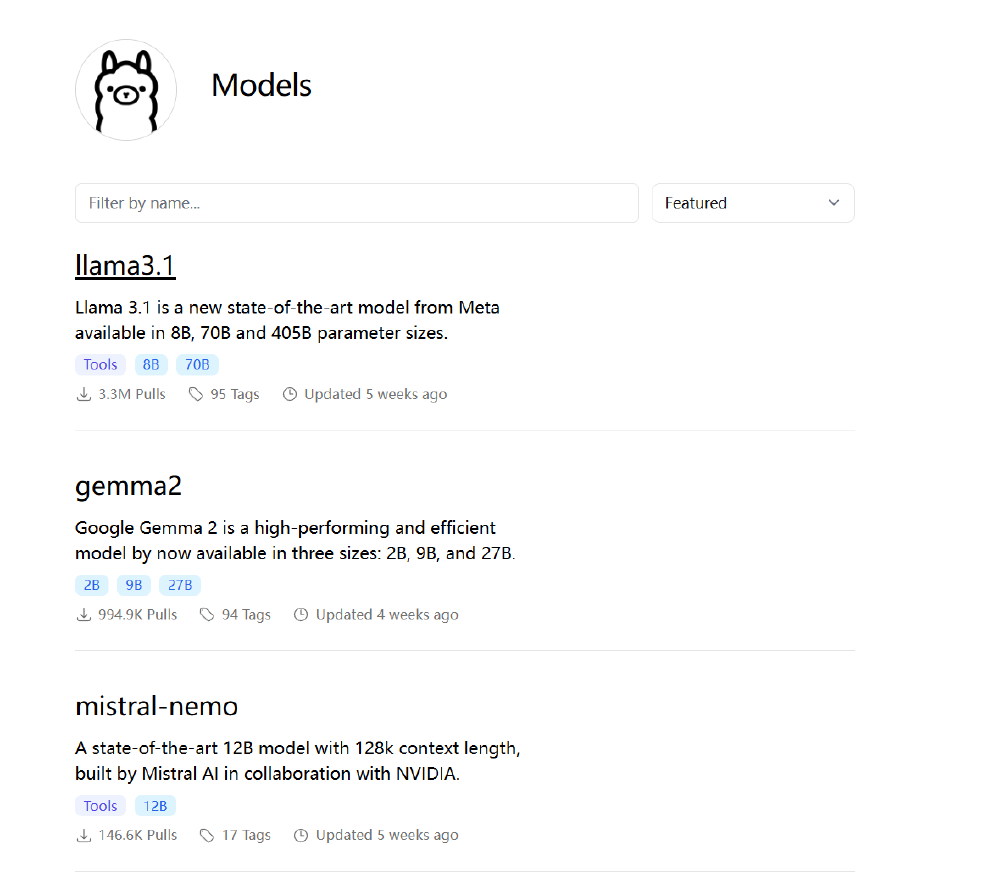

我們先來(lái)看看 ollama 支持的大模型有哪些?

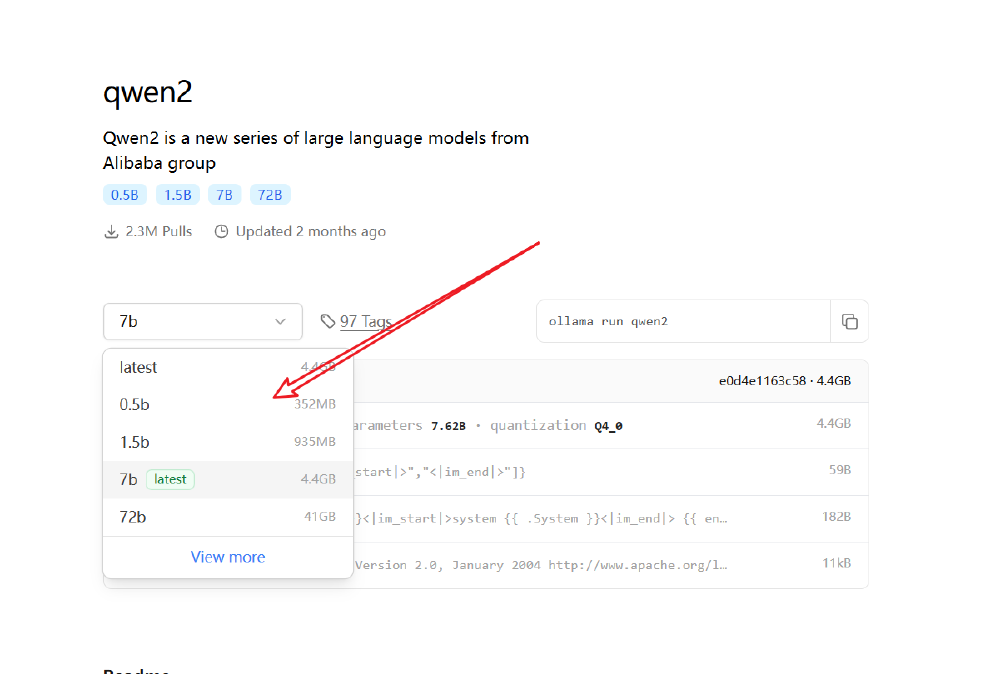

我們先跑個(gè)小點(diǎn)的千問(wèn)大模型吧,千問(wèn) 0.5B 的模型看看。

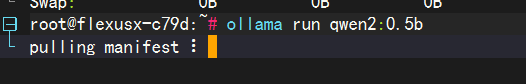

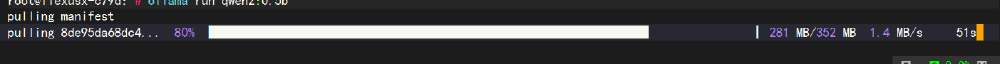

輸入命令:

ollama run qwen2:0.5b

還是繼續(xù)等待....等待的過(guò)程中,為了不浪費(fèi)時(shí)間,可以看看別的事兒。

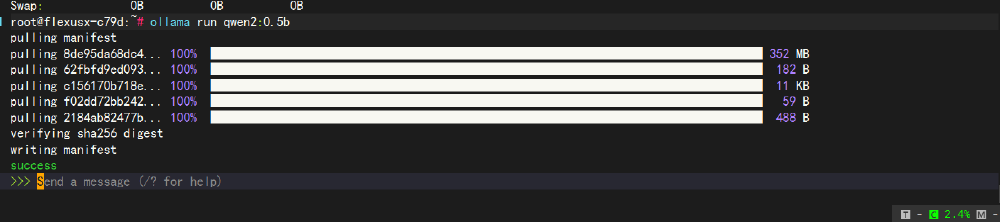

等待完成,下面我們就可以看到:Send a message 這句話了,表示我們可以直接使用大模型提問(wèn)啦

1.體驗(yàn)大模型

我們輸入個(gè)問(wèn)題試試看看:

[MISSING IMAGE: , ]不知道為啥,他非要說(shuō)自己是李政保,還說(shuō)的有鼻子有眼的,質(zhì)量的問(wèn)題我們不管,我們看性能和速度問(wèn)題。

簡(jiǎn)單的錄了個(gè)小視頻,這速度還是很快的。可見(jiàn)這服務(wù)器的性能還是不錯(cuò)的,感興趣的伙伴們,可以嘗試跑跑更大的模型試試。

總體來(lái)說(shuō),這次活動(dòng)的力度還是蠻大的,主要是服務(wù)器性能也確實(shí)可以,不用 GPU 也可以跑大模型了,本文就是我們單純的用 CPU 就行跑的,體驗(yàn)很好。

至此,本文 over。

審核編輯 黃宇

-

云服務(wù)器

+關(guān)注

關(guān)注

0文章

723瀏覽量

13399 -

華為云

+關(guān)注

關(guān)注

3文章

2682瀏覽量

17543 -

大模型

+關(guān)注

關(guān)注

2文章

2541瀏覽量

3012

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

華為云 Flexus 云服務(wù)器 X 實(shí)例部署 Mininote 輕量級(jí)筆記工具

Flexus 云服務(wù)器 X 實(shí)例實(shí)踐:部署 Alist 文件列表程序

Flexus 云服務(wù)器 X 實(shí)例部署 Docker 管理儀表板 DweebUI

Flexus 云服務(wù)器 X 實(shí)例實(shí)踐:安裝 flatnotes 筆記應(yīng)用程序

云服務(wù)器 Flexus X 實(shí)例:RAG 開(kāi)源項(xiàng)目 FastGPT 部署,玩轉(zhuǎn)大模型

基于華為云 Flexus 云服務(wù)器 X 實(shí)例快速搭建 Halo 博客平臺(tái)

華為云 Flexus 云服務(wù)器 X 實(shí)例之 openEuler 系統(tǒng)下部署 dufs 文件服務(wù)器

華為云 Flexus 云服務(wù)器 X 實(shí)例之 openEuler 系統(tǒng)下部署 Joplin 筆記工具

云服務(wù)器 Flexus X 實(shí)例:輕量級(jí) http 服務(wù)器 Tinyhttpd 部署

華為云 Flexus 云服務(wù)器 X 實(shí)例部署 Trilium Notes 知識(shí)庫(kù)工具

華為云 Flexus 云服務(wù)器 X 實(shí)例部署 Note Mark 筆記工具

華為云 Flexus 云服務(wù)器 X 實(shí)例之 Docker 環(huán)境下部署 JmalCloud 個(gè)人網(wǎng)盤

華為云 Flexus 云服務(wù)器 X 實(shí)例的使用教程

采用 Flexus 云服務(wù)器 X 實(shí)例搭建 RTSP 直播服務(wù)器

基于 Flexus 云服務(wù)器 X 實(shí)例體驗(yàn)大模型部署體驗(yàn)測(cè)評(píng)

基于 Flexus 云服務(wù)器 X 實(shí)例體驗(yàn)大模型部署體驗(yàn)測(cè)評(píng)

評(píng)論