遞歸神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,簡(jiǎn)稱(chēng)RNN)是一種具有循環(huán)結(jié)構(gòu)的神經(jīng)網(wǎng)絡(luò),其核心特點(diǎn)是能夠處理序列數(shù)據(jù),并且能夠記憶之前處理過(guò)的信息。RNN在自然語(yǔ)言處理、語(yǔ)音識(shí)別、時(shí)間序列預(yù)測(cè)等領(lǐng)域有著廣泛的應(yīng)用。本文將詳細(xì)介紹RNN的計(jì)算過(guò)程。

- 基本概念

1.1 神經(jīng)網(wǎng)絡(luò)

神經(jīng)網(wǎng)絡(luò)是一種受人腦神經(jīng)元結(jié)構(gòu)啟發(fā)的計(jì)算模型,由大量的神經(jīng)元(或稱(chēng)為節(jié)點(diǎn))組成,這些神經(jīng)元通過(guò)權(quán)重連接在一起。每個(gè)神經(jīng)元接收輸入信號(hào),通過(guò)激活函數(shù)處理信號(hào),并將處理后的信號(hào)傳遞給下一層神經(jīng)元。神經(jīng)網(wǎng)絡(luò)的目標(biāo)是通過(guò)調(diào)整權(quán)重,使得網(wǎng)絡(luò)能夠?qū)斎霐?shù)據(jù)進(jìn)行準(zhǔn)確的分類(lèi)或回歸。

1.2 序列數(shù)據(jù)

序列數(shù)據(jù)是一種具有時(shí)間或空間順序的數(shù)據(jù),例如自然語(yǔ)言、音頻信號(hào)、時(shí)間序列等。序列數(shù)據(jù)的一個(gè)重要特點(diǎn)是具有時(shí)間依賴(lài)性,即當(dāng)前時(shí)刻的數(shù)據(jù)可能受到之前時(shí)刻數(shù)據(jù)的影響。

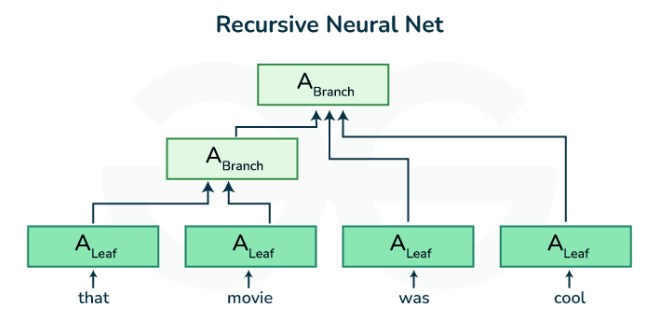

1.3 遞歸神經(jīng)網(wǎng)絡(luò)

遞歸神經(jīng)網(wǎng)絡(luò)是一種特殊的神經(jīng)網(wǎng)絡(luò),其核心特點(diǎn)是具有循環(huán)結(jié)構(gòu),能夠處理序列數(shù)據(jù),并能夠記憶之前處理過(guò)的信息。RNN通過(guò)將前一個(gè)時(shí)間步的輸出作為下一個(gè)時(shí)間步的輸入,實(shí)現(xiàn)了對(duì)序列數(shù)據(jù)的時(shí)間依賴(lài)性建模。

- 網(wǎng)絡(luò)結(jié)構(gòu)

2.1 基本結(jié)構(gòu)

RNN的基本結(jié)構(gòu)包括輸入層、隱藏層和輸出層。輸入層接收序列數(shù)據(jù)的當(dāng)前時(shí)刻的輸入,隱藏層負(fù)責(zé)處理輸入數(shù)據(jù)并記憶之前處理過(guò)的信息,輸出層生成序列數(shù)據(jù)的當(dāng)前時(shí)刻的輸出。

2.2 循環(huán)結(jié)構(gòu)

RNN的循環(huán)結(jié)構(gòu)是指隱藏層的神經(jīng)元在時(shí)間上具有循環(huán)連接。具體來(lái)說(shuō),當(dāng)前時(shí)刻的隱藏層神經(jīng)元不僅接收來(lái)自輸入層的信號(hào),還接收來(lái)自前一個(gè)時(shí)間步的隱藏層神經(jīng)元的信號(hào)。這種循環(huán)結(jié)構(gòu)使得RNN能夠記憶之前處理過(guò)的信息。

2.3 參數(shù)共享

在RNN中,隱藏層神經(jīng)元的權(quán)重在時(shí)間上是共享的,即在每個(gè)時(shí)間步中,隱藏層神經(jīng)元的權(quán)重都是相同的。這種參數(shù)共享策略大大減少了模型的參數(shù)數(shù)量,使得RNN能夠更高效地處理長(zhǎng)序列數(shù)據(jù)。

- 前向傳播

3.1 輸入層

在RNN的前向傳播過(guò)程中,輸入層首先接收序列數(shù)據(jù)的當(dāng)前時(shí)刻的輸入。假設(shè)輸入數(shù)據(jù)的維度為d,那么輸入層將接收一個(gè)維度為d的向量x(t)作為輸入。

3.2 隱藏層

隱藏層接收來(lái)自輸入層的信號(hào),并結(jié)合之前時(shí)刻的隱藏狀態(tài),通過(guò)激活函數(shù)生成當(dāng)前時(shí)刻的隱藏狀態(tài)。假設(shè)隱藏層的維度為h,權(quán)重矩陣為W,偏置向量為b,前一個(gè)時(shí)間步的隱藏狀態(tài)為h(t-1),則當(dāng)前時(shí)刻的隱藏狀態(tài)h(t)可以通過(guò)以下公式計(jì)算:

h(t) = f(W * [x(t), h(t-1)] + b)

其中,f表示激活函數(shù),[x(t), h(t-1)]表示將輸入向量x(t)和前一個(gè)時(shí)間步的隱藏狀態(tài)h(t-1)拼接在一起形成的向量。

3.3 輸出層

輸出層接收來(lái)自隱藏層的信號(hào),生成序列數(shù)據(jù)的當(dāng)前時(shí)刻的輸出。假設(shè)輸出數(shù)據(jù)的維度為o,權(quán)重矩陣為U,偏置向量為c,則當(dāng)前時(shí)刻的輸出y(t)可以通過(guò)以下公式計(jì)算:

y(t) = U * h(t) + c

- 反向傳播

4.1 損失函數(shù)

在訓(xùn)練RNN時(shí),需要定義一個(gè)損失函數(shù)來(lái)衡量模型的預(yù)測(cè)輸出與真實(shí)標(biāo)簽之間的差異。常見(jiàn)的損失函數(shù)包括均方誤差、交叉熵等。

4.2 誤差反向傳播

在RNN的反向傳播過(guò)程中,首先需要計(jì)算損失函數(shù)關(guān)于模型參數(shù)的梯度。然后,通過(guò)鏈?zhǔn)椒▌t將這些梯度從輸出層反向傳播到輸入層,以便更新模型的權(quán)重。

4.2.1 輸出層到隱藏層的梯度

首先,計(jì)算損失函數(shù)關(guān)于輸出層權(quán)重U和偏置c的梯度。然后,利用激活函數(shù)的導(dǎo)數(shù),將這些梯度反向傳播到隱藏層,得到損失函數(shù)關(guān)于隱藏層權(quán)重W和偏置b的梯度。

4.2.2 隱藏層到輸入層的梯度

接下來(lái),將損失函數(shù)關(guān)于隱藏層權(quán)重W和偏置b的梯度,通過(guò)時(shí)間反向傳播到輸入層。具體來(lái)說(shuō),從最后一個(gè)時(shí)間步開(kāi)始,利用激活函數(shù)的導(dǎo)數(shù),將梯度反向傳播到前一個(gè)時(shí)間步的隱藏狀態(tài),直到第一個(gè)時(shí)間步。

4.3 參數(shù)更新

在計(jì)算完所有梯度后,可以通過(guò)梯度下降或其他優(yōu)化算法更新模型的參數(shù),以減小損失函數(shù)的值。

-

語(yǔ)音識(shí)別

+關(guān)注

關(guān)注

38文章

1742瀏覽量

112823 -

神經(jīng)元

+關(guān)注

關(guān)注

1文章

363瀏覽量

18492 -

自然語(yǔ)言處理

+關(guān)注

關(guān)注

1文章

619瀏覽量

13616 -

遞歸神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

0文章

12瀏覽量

366

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

求助大神關(guān)于神經(jīng)網(wǎng)絡(luò)的問(wèn)題

AI知識(shí)科普 | 從無(wú)人相信到萬(wàn)人追捧的神經(jīng)網(wǎng)絡(luò)

如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?

遞歸神經(jīng)網(wǎng)絡(luò)(RNN)

基于遞歸神經(jīng)網(wǎng)絡(luò)和前饋神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)預(yù)測(cè)算法

PyTorch教程16.2之情感分析:使用遞歸神經(jīng)網(wǎng)絡(luò)

卷積神經(jīng)網(wǎng)絡(luò)計(jì)算過(guò)程和步驟

循環(huán)神經(jīng)網(wǎng)絡(luò)和遞歸神經(jīng)網(wǎng)絡(luò)的區(qū)別

遞歸神經(jīng)網(wǎng)絡(luò)是循環(huán)神經(jīng)網(wǎng)絡(luò)嗎

遞歸神經(jīng)網(wǎng)絡(luò)主要應(yīng)用于哪種類(lèi)型數(shù)據(jù)

遞歸神經(jīng)網(wǎng)絡(luò)與循環(huán)神經(jīng)網(wǎng)絡(luò)一樣嗎

遞歸神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)形式主要分為

rnn是遞歸神經(jīng)網(wǎng)絡(luò)還是循環(huán)神經(jīng)網(wǎng)絡(luò)

遞歸神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)方法

遞歸神經(jīng)網(wǎng)絡(luò)和循環(huán)神經(jīng)網(wǎng)絡(luò)的模型結(jié)構(gòu)

簡(jiǎn)述遞歸神經(jīng)網(wǎng)絡(luò)的計(jì)算過(guò)程

簡(jiǎn)述遞歸神經(jīng)網(wǎng)絡(luò)的計(jì)算過(guò)程

評(píng)論