四月十三日透露,OpenAI近期舉行數(shù)場(chǎng)推介會(huì),CEO山姆·阿爾特曼分別于舊金山、紐約及倫敦向財(cái)富五百?gòu)?qiáng)企業(yè)的高層決策者們承諾,OpenAI決不使用API所收集之客戶數(shù)據(jù)進(jìn)行大規(guī)模語(yǔ)言模型(LLM)訓(xùn)練。

此項(xiàng)活動(dòng)針對(duì)金融、醫(yī)療保健以及能源等行業(yè)的高層領(lǐng)導(dǎo)。阿爾特曼親自主持,聯(lián)合首席運(yùn)營(yíng)官Brad Lightcap等多名OpenAI高管共同介紹了ChatGPT Enterprise、文本轉(zhuǎn)視頻模型等多項(xiàng)產(chǎn)品。

阿爾特曼向參會(huì)者保證,通過(guò)ChatGPT Enterprise獲取的客戶數(shù)據(jù)將不會(huì)用于未來(lái)模型迭代。

IT之家補(bǔ)充道:微軟已通過(guò)Azure云平臺(tái)和Microsoft 365套件提供類似的人工智能工具。部分與會(huì)者因考慮到與微軟現(xiàn)有合作關(guān)系,對(duì)OpenAI是否有必要獨(dú)立推出產(chǎn)品提出疑問(wèn)。

-

API

+關(guān)注

關(guān)注

2文章

1510瀏覽量

62275 -

OpenAI

+關(guān)注

關(guān)注

9文章

1122瀏覽量

6633 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1566瀏覽量

7929

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

OpenAI GPT-5開發(fā)滯后:訓(xùn)練成本高昂

【「大模型啟示錄」閱讀體驗(yàn)】如何在客服領(lǐng)域應(yīng)用大模型

AI大模型的訓(xùn)練數(shù)據(jù)來(lái)源分析

大語(yǔ)言模型的預(yù)訓(xùn)練

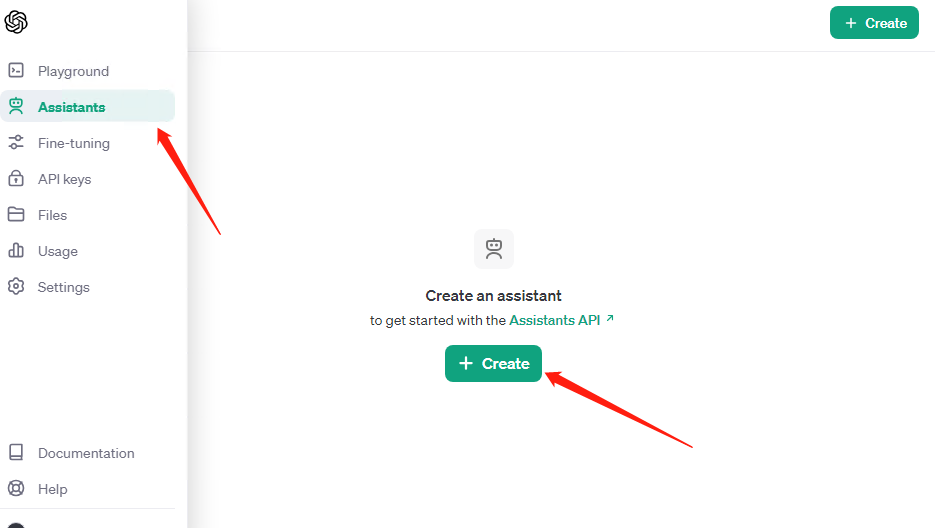

OpenAI API Key獲取:開發(fā)人員申請(qǐng)GPT-4 API Key教程

【大規(guī)模語(yǔ)言模型:從理論到實(shí)踐】- 閱讀體驗(yàn)

【大規(guī)模語(yǔ)言模型:從理論到實(shí)踐】- 每日進(jìn)步一點(diǎn)點(diǎn)

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來(lái)了

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的應(yīng)用

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的預(yù)訓(xùn)練

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的基礎(chǔ)技術(shù)

【大語(yǔ)言模型:原理與工程實(shí)踐】核心技術(shù)綜述

【大語(yǔ)言模型:原理與工程實(shí)踐】揭開大語(yǔ)言模型的面紗

OpenAI API Key獲取與充值教程:助開發(fā)者解鎖GPT-4.0 API

OpenAI確保不利用API獲取的客戶數(shù)據(jù)進(jìn)行大規(guī)模語(yǔ)言模型訓(xùn)練

OpenAI確保不利用API獲取的客戶數(shù)據(jù)進(jìn)行大規(guī)模語(yǔ)言模型訓(xùn)練

評(píng)論