關(guān)于 LLaMA 2 的全部資源,如何去測(cè)試、訓(xùn)練并部署它。

LLaMA 2 是一個(gè)由 Meta 開發(fā)的大型語言模型,是 LLaMA 1 的繼任者。LLaMA 2 可通過 AWS、Hugging Face 等提供商獲取,并免費(fèi)用于研究和商業(yè)用途。LLaMA 2 預(yù)訓(xùn)練模型在 2 萬億個(gè)標(biāo)記上進(jìn)行訓(xùn)練,相比 LLaMA 1 的上下文長(zhǎng)度增加了一倍。它的微調(diào)模型則在超過 100 萬個(gè)人工標(biāo)注數(shù)據(jù)下完成。

這篇博客包含了所有的相關(guān)資源,以幫助您快速入門。包括以下跳轉(zhuǎn):

LLaMA 2 是什么?

在 LLaMA 游樂場(chǎng)試玩

模型背后的研究工作

模型的性能有多好,基準(zhǔn)測(cè)試

如何正確地去提示聊天模型

如何使用 PEFT 訓(xùn)練模型

如何部署模型進(jìn)行推理

和其他資源

來自 Meta 官方的公告可以在這里找到: https://ai.meta.com/llama/

LLaMA 2 是什么?

Meta 發(fā)布的 LLaMA 2,是新的 sota 開源大型語言模型 (LLM)。LLaMA 2 代表著 LLaMA 的下一代版本,并且具有商業(yè)許可證。LLaMA 2 有 3 種不同的大小——7B、13B 和 70B 個(gè)可訓(xùn)練參數(shù)。與原版 LLaMA 相比,新的改進(jìn)包括:

在 2 萬億個(gè)標(biāo)記的文本數(shù)據(jù)上進(jìn)行訓(xùn)練

允許商業(yè)使用

默認(rèn)使用 4096 個(gè)前后文本視野 (可以被擴(kuò)展)

70B 模型采用了分組查詢注意力 (GQA)

可由此獲取 Hugging Face Hub

在 LLaMA 游樂場(chǎng)試玩

有幾個(gè)不同的游樂場(chǎng)供與 LLaMA 2 來測(cè)試聊天:

HuggingChat 允許你通過 Hugging Face 的對(duì)話界面與 LLaMA 2 70B 模型聊天。這提供了一個(gè)簡(jiǎn)潔的方法來了解聊天機(jī)器人的工作原理。

Hugging Face Spaces 有三種大小的 LLaMA 2 模型 7B、13B 和 70B 可供測(cè)試。交互式演示可以讓您比較不同的大小模型的區(qū)別。

Perplexity 他們的對(duì)話 AI 演示提供 7B 和 13B 的 LLaMA 2 模型。你可以與模型聊天并且反饋模型響應(yīng)的不足。

LLaMA 2 背后的研究工作

LLaMA 2 是一個(gè)基礎(chǔ)大語言模型,它由網(wǎng)絡(luò)上公開可獲取到的數(shù)據(jù)訓(xùn)練完成。另外 Meta 同時(shí)發(fā)布了它的 CHAT 版本。CHAT 模型的第一個(gè)版本是 SFT (有監(jiān)督調(diào)優(yōu)) 模型。在這之后,LLaMA-2-chat 逐步地經(jīng)過人類反饋強(qiáng)化學(xué)習(xí) (RLHF) 來進(jìn)化。RLHF 的過程使用了拒絕采樣與近端策略優(yōu)化 (PPO) 的技術(shù)來進(jìn)一步調(diào)優(yōu)聊天機(jī)器人。Meta 目前僅公布了模型最新的 RLHF(v5) 版本。若你對(duì)此過程背后的過程感興趣則請(qǐng)查看:

Llama 2: 開源并已微調(diào)的聊天模型

Llama 2: 一個(gè)超贊的開源大語言模型

Llama 2: 全面拆解

LLaMA 2 的性能有多好,基準(zhǔn)測(cè)試?

Meta 聲稱 “Llama 2 在眾多外部基準(zhǔn)測(cè)試中都優(yōu)于其他開源的語言模型,包括推理、編程、熟練程度與知識(shí)測(cè)驗(yàn)” 關(guān)于其性能你可以在這里找到更多信息:

Hugging Face 開源大語言模型排行榜

Meta 官方公告

如何提示 LLaMA 2 Chat

LLaMA 2 Chat 是一個(gè)開源對(duì)話模型。想要與 LLaMA 2 Chat 進(jìn)行高效地交互則需要你提供合適的提示詞、問題來得到合乎邏輯且有幫助的回復(fù)。Meta 并沒有選擇最簡(jiǎn)單的提示詞結(jié)構(gòu)。以下是單輪、多輪對(duì)話的提示詞模板。這個(gè)模板遵循模型的訓(xùn)練過程,在此詳細(xì)描述 LLaMA 2 論文. 你也可以看一看 LLaMA 2 提示詞模板.

單輪對(duì)話

[INST]<> {{system_prompt}} < > {{user_message}}[/INST]

多輪對(duì)話

[INST]<> {{system_prompt}} < > {{user_msg_1}}[/INST]{{model_answer_1}}[INST]{{user_msg_2}}[/INST]{{model_answer_2}}[INST]{{user_msg_3}}[/INST]

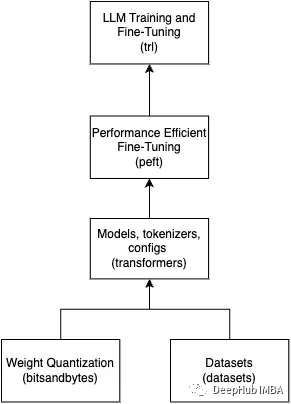

如何訓(xùn)練 LLaMA 2

因 LLaMA 2 為開源模型,使得可以輕易的通過微調(diào)技術(shù),比如 PEFT,來訓(xùn)練它。這是一些非日適合于訓(xùn)練你自己版本 LLaMA 2 的學(xué)習(xí)資源:

擴(kuò)展指引: 指令微調(diào) Llama 2

在 Amazon SageMaker 上微調(diào) LLaMA 2 (7-70B)

使用 PEFT 技術(shù)微調(diào)

Meta 提供的 Llama 模型示例以及方案

在本地機(jī)器上微調(diào) LLAMA-v2 最簡(jiǎn)單的方法 !

如何部屬 LLaMA 2

LLaMA 2 可以在本地環(huán)境中部署 (llama.cpp),使用這樣已管理好的服務(wù) Hugging Face Inference Endpoints 或通過 AWS, Google Cloud, and Microsoft Azure 這樣的服務(wù)器平臺(tái).

使用文本生成接口與推理終端來部署 LLama 2

使用 Amazon SageMaker 部署 LLaMA 2 70B (即將完成)

在你的 M1/M2 Mac 上通過 GPU 接口來本地部署 Llama-2-13B-chat

原文作者: Philschmid

譯者: Xu Haoran

審核編輯:黃飛

-

AI

+關(guān)注

關(guān)注

87文章

33141瀏覽量

273251 -

聊天機(jī)器人

+關(guān)注

關(guān)注

0文章

346瀏覽量

12578

原文標(biāo)題:LLaMA 2 - 你所需要的一切資源

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

基于Llama2和OpenVIN打造聊天機(jī)器人

【飛騰派4G版免費(fèi)試用】仙女姐姐的嵌入式實(shí)驗(yàn)室之五~LLaMA.cpp及3B“小模型”O(jiān)penBuddy-StableLM-3B

[技術(shù)] 【飛凌嵌入式OK3576-C開發(fā)板體驗(yàn)】llama2.c部署

Meta推出免費(fèi)大模型Llama 2,GPT要有危機(jī)感了

Llama2的技術(shù)細(xì)節(jié)探討分析

Llama 2性能如何

Llama 2 登陸 Azure 和 Windows,微軟與 Meta 拓展人工智能合作伙伴關(guān)系

Meta推出Llama 2 免費(fèi)開放商業(yè)和研究機(jī)構(gòu)使用

爆火Llama 2一周請(qǐng)求下載超15萬,有人開源了Rust實(shí)現(xiàn)版本

關(guān)于Llama 2的一切資源,我們都幫你整理好了

Meta發(fā)布一種Code Llama工具 用于生成新代碼和調(diào)試人工編寫工作

怎樣使用QLoRA對(duì)Llama 2進(jìn)行微調(diào)呢?

評(píng)論