近日,Meta推出了Llama 2,這是一個(gè)新的大型語言模型,參數(shù)高達(dá)700億。新的生成型人工智能系統(tǒng)代表了OpenAI的變化,但是幾乎沒有分享包括GPT-3/3.5和GPT-4在內(nèi)的大多數(shù)人工智能模型的細(xì)節(jié)。根據(jù)維基百科的數(shù)據(jù),Llama 2的發(fā)布包含了ChatGPT 3.5的40%的參數(shù),其中包括與微軟的重要合作。Redmond也不僅僅是一個(gè)名義上的合作伙伴,他最近宣布支持Azure和Windows中的Llama 2。與此同時(shí),高通公司現(xiàn)在表示,它將與Llama 2一起加入LLM競爭,并公布了將Llama 2帶入智能手機(jī)中的計(jì)劃。

Meta方面在微軟的Inspire合作伙伴大會(huì)上宣布,將與包括微軟在內(nèi)的主要云計(jì)算服務(wù)提供商合作,推出新一代開源大模型Llama 2,并將該模型免費(fèi)開放給商業(yè)和研究機(jī)構(gòu)使用。

這樣的發(fā)展意味著,無論來源如何,開源人工智能模型的能力和覆蓋范圍都將大幅擴(kuò)大。

Llama 2: Fine-tuned and Ready to Chat

Perplexity.ai提供了一個(gè)令人印象深刻的多個(gè)Llama 2模型的免費(fèi)在線演示。它的結(jié)果與包括ChatGPT和谷歌Bard在內(nèi)的當(dāng)今頂級聊天機(jī)器人具有競爭力。Llama 2快速生成干凈、自然的文本,盡管不太可能非常出彩,但易于閱讀和理解。Llama 2還可以生成通常理解的事實(shí)、生成代碼和求解數(shù)學(xué)方程。

與所有LLM一樣,Llama 2偶爾會(huì)產(chǎn)生不正確或不可用的答案,但Meta介紹Llama的論文聲稱,它在學(xué)術(shù)基準(zhǔn)方面與OpenAI的GPT 3.5不相上下,如MMLU(衡量LLM在57門STEM科目中的知識(shí))和GSM8K(衡量LLM對數(shù)學(xué)的理解)。

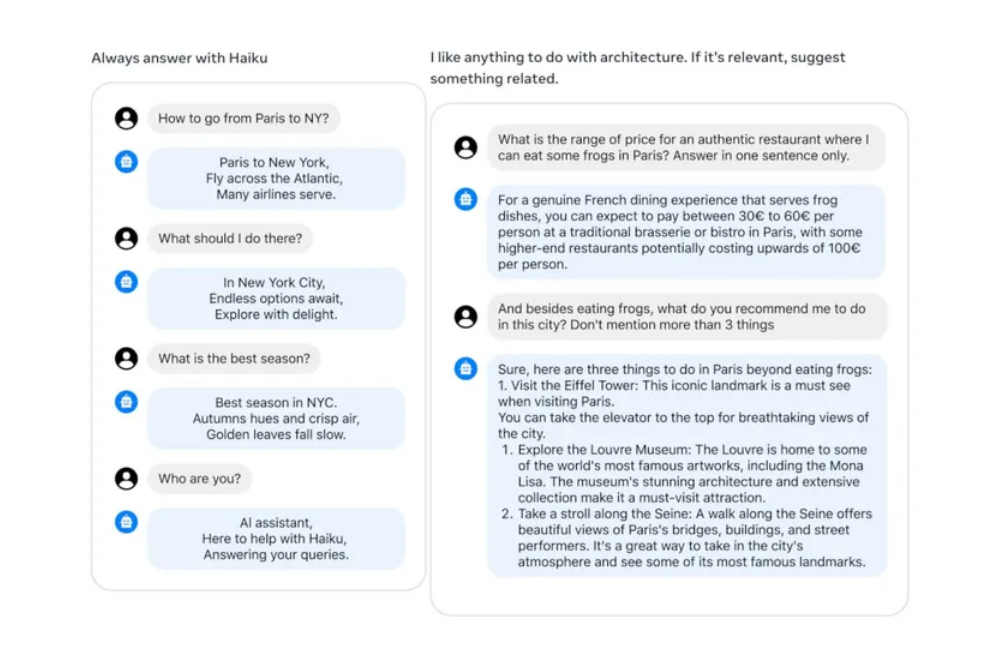

Meta的研究人員部分是通過純粹的模型大小實(shí)現(xiàn)的 —— 但這只是故事的一半。根據(jù)Meta的論文,Llama 2使用了有監(jiān)督的微調(diào)、帶有人類反饋的強(qiáng)化學(xué)習(xí)和一種名為Ghost Attention(GAtt)的新技術(shù),該技術(shù)“能夠在多個(gè)回合中進(jìn)行對話控制”。更簡單地說,GAtt幫助Llama在被要求在特定約束下工作時(shí)產(chǎn)生所需的結(jié)果,就像被要求“扮演”歷史人物時(shí)可能發(fā)生的那樣,或者在諸如架構(gòu)之類的特定主題的上下文中產(chǎn)生響應(yīng)。

META

這些技術(shù)有助于Llama 2提供各種型號,相對于其尺寸,具有可靠的基準(zhǔn)性能。最大的模型Llama 2 70B(有700億個(gè)參數(shù))在所有基準(zhǔn)測試中表現(xiàn)最好,但Meta也提供Llama 27 B和Llama 13 B。

參數(shù)較少的變體性能不如Llama 2 70B,但它們足夠緊湊,可以在功能較弱的設(shè)備(如智能手機(jī))上本地運(yùn)行。領(lǐng)先的智能手機(jī)片上系統(tǒng)(SoC)生產(chǎn)商高通公司宣布與Meta合作,“從2024年開始”讓Llama 2在高通公司支持的智能手機(jī)上本地運(yùn)行”。

高通公司營銷傳播專家Rodrigo Caruso Neves do Amaral表示:“我們能夠使用我們的軟件工具來編譯和優(yōu)化模型,特別是在我們的Hexagon處理器上運(yùn)行。無論是對運(yùn)行這些型號的公司,還是對有時(shí)必須為訪問這些應(yīng)用程序付費(fèi)的消費(fèi)者,在設(shè)備上運(yùn)行所節(jié)省的能量都會(huì)產(chǎn)生巨大影響。”

Open Source Fits Where Closed Models Can’t

在智能手機(jī)上離線運(yùn)行大型語言模型是封閉的人工智能模型(如OpenAI的GPT 3.5和谷歌的PaLM2)無法處理的。這不一定是由于技術(shù)限制(據(jù)推測,OpenAI和谷歌可以提供一種適合智能手機(jī)的模型),而是哲學(xué)上的分歧。OpenAI和谷歌提供LLM作為API。訪問API需要互聯(lián)網(wǎng)連接,客戶將根據(jù)使用情況收費(fèi)。

相比之下,Llama 2的發(fā)布表示允許無限、免費(fèi)的商業(yè)和學(xué)術(shù)使用。該許可并不符合開源計(jì)劃制定的所有標(biāo)準(zhǔn),因?yàn)樵撛S可包括一項(xiàng)條款,要求允許將Llama 2用于“月活躍用戶超過7億”的“產(chǎn)品或服務(wù)”。然而,該條款僅適用于Meta最大的競爭對手,如OpenAI和谷歌。Meta的Llama 2模型已經(jīng)出現(xiàn)在HuggingFace的Open LLM排行榜上,截至7月24日星期一收盤,“Llama-2-70b-chat-hf”的延遲和吞吐量基準(zhǔn)排名第三。(截至發(fā)稿時(shí),目前的頂級模型Stability AI的FreeWilly2實(shí)際上已經(jīng)基于Llama 2,但FreeWilly22使用不同的數(shù)據(jù)集對模型進(jìn)行了微調(diào)。)

Srinivas認(rèn)為Llama 2的開源許可證是一個(gè)力量倍增器,為開發(fā)者和研究人員提供了一個(gè)根據(jù)他們的特定需求調(diào)整模型的機(jī)會(huì)。“一個(gè)人可以啟動(dòng)Llama 2的分支,專注于量化,另一個(gè)人可以開啟另一個(gè)Llama的分支關(guān)注于低階微調(diào),……其他人則可以將更大的模型提煉成更小的模型,從而加速進(jìn)展。”

事實(shí)證明,這對瞄準(zhǔn)邊緣設(shè)備(如智能手機(jī))的開發(fā)人員來說尤其重要。考慮到型號的大小,Llama 2 70B表現(xiàn)出色并不令人驚訝。但Llama 2的較小型號相對于其型號大小也排名良好。在Open LLM排行榜上,大多數(shù)表現(xiàn)優(yōu)于Llama 2的小型模型本身都是基于Meta之前的模型Llama。這表明,隨著開源社區(qū)的開發(fā)人員將他們的才能應(yīng)用到Llama 2中,Llama 2將在排行榜上名列前茅。

Srinivas說:“我認(rèn)為Llama 2 7B和Llama 2 13B已經(jīng)很令人興奮了……這只是一個(gè)開始。Meta推出了它,現(xiàn)在人們可以改進(jìn)它。可以構(gòu)建其他框架和其他工程層,這賦予了每個(gè)人更多的權(quán)力。”

-

人工智能

+關(guān)注

關(guān)注

1792文章

47436瀏覽量

238978 -

模型

+關(guān)注

關(guān)注

1文章

3268瀏覽量

48924 -

OpenAI

+關(guān)注

關(guān)注

9文章

1100瀏覽量

6578

原文標(biāo)題:Meta推出Llama 2 免費(fèi)開放商業(yè)和研究機(jī)構(gòu)使用

文章出處:【微信號:IEEE_China,微信公眾號:IEEE電氣電子工程師】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

Meta推出Llama 2 免費(fèi)開放商業(yè)和研究機(jī)構(gòu)使用

Meta推出Llama 2 免費(fèi)開放商業(yè)和研究機(jī)構(gòu)使用

評論