來源:半導(dǎo)體芯科技編譯

隨著摩爾定律的放緩,芯片,尤其是用于人工智能和高性能計(jì)算(HPC)的芯片,逐漸變得炙手可熱。2023 年,隨著英偉達(dá)(Nvidia)GH200 超級芯片的到來,我們看到加速器的功率進(jìn)入了千瓦級。

我們早已知道這些芯片會很熱門--Nvidia 在兩年前就已經(jīng)開始預(yù)告這款 CPU-GPU 芯片。直到最近,我們才知道原始設(shè)備制造商和系統(tǒng)構(gòu)建商將如何應(yīng)對這種功率密集型部件。大多數(shù)系統(tǒng)會采用液體冷卻嗎?還是大多數(shù)會堅(jiān)持使用空氣冷卻?他們會在一個盒子里塞進(jìn)多少臺這樣的加速器,盒子又有多大?

現(xiàn)在,第一批基于 GH200 的系統(tǒng)已經(jīng)投放市場,很明顯,外形尺寸在很大程度上是由功率密度決定的。從根本上說,這取決于散熱的表面積有多大。

深入研究 Supermicro、Gigabyte、QCT、Pegatron、HPE 等公司目前提供的系統(tǒng),您很快就會注意到一個趨勢。每個機(jī)架單元 (RU) 高達(dá) 500 W – Supermicro 的 MGX ARS-111GL-NHR 為 1 kW – 這些系統(tǒng)主要采用風(fēng)冷。雖然溫度較高,但散熱負(fù)荷仍在可控范圍內(nèi),每個機(jī)架的功率約為 21-24 kW。這完全在現(xiàn)代數(shù)據(jù)中心的供電和熱管理能力范圍內(nèi),尤其是那些使用后門熱交換器的數(shù)據(jù)中心。

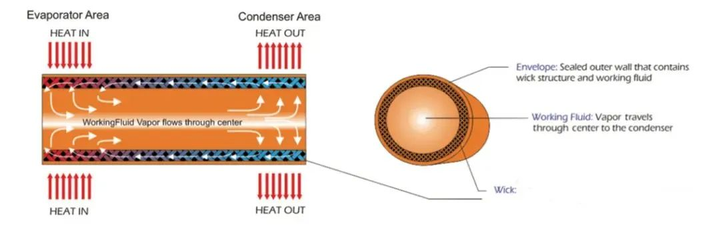

但是,當(dāng)系統(tǒng)制造商開始在每個機(jī)箱中安裝超過 1 kW的加速器時,情況就會發(fā)生變化。此時,我們看到的大多數(shù) OEM 系統(tǒng)都改用了直接液冷技術(shù)。例如,Gigabyte的 H263-V11 在一個 2U 機(jī)箱中最多可容納四個 GH200 節(jié)點(diǎn)。

也就是說,每個機(jī)架單元的功率為 2 kW。因此,雖然像 Nvidia 的風(fēng)冷 DGX H100 系統(tǒng)(配備 8 個 700 瓦 H100 和雙藍(lán)寶石 Rapids CPU)的 TDP 較高,為 10.2 千瓦,但其功率密度實(shí)際上較低,為 1.2 kW/RU。

除了能更有效地從這些密集的加速器中傳遞熱量外,液體冷卻還有幾個優(yōu)點(diǎn)。系統(tǒng)功率越高,從系統(tǒng)中帶走熱量所需的靜壓和氣流就越大。這就意味著要使用更熱、更快的風(fēng)扇,從而消耗更多的功率——在某些情況下可能高達(dá)系統(tǒng)功率的 20%。

當(dāng)每個機(jī)架單元的功率超過 500 W 時,大多數(shù)原始設(shè)備制造商和原始設(shè)計(jì)制造商似乎都會選擇液冷機(jī)箱,因?yàn)槔鋮s網(wǎng)卡、存儲和其他外設(shè)等低功耗組件所需的風(fēng)扇數(shù)量更少、速度更慢。

只要看看 HPE 的 Cray EX254n 刀片,就能知道液冷機(jī)箱的作用有多大。該平臺最多可支持四個 GH200。在 1U 的計(jì)算刀片中就有 4 千瓦,這還不算用于為芯片提供數(shù)據(jù)的網(wǎng)卡。

當(dāng)然,HPE 的 Cray 部門對超高密度計(jì)算組件的冷卻確實(shí)很有心得。不過,這確實(shí)說明了系統(tǒng)構(gòu)建商在服務(wù)器上花費(fèi)的心思,不僅在系統(tǒng)層面,而且在機(jī)架層面。

機(jī)架級起飛

正如我們之前在介紹 Nvidia DGX H100 系統(tǒng)時提到的那樣,為多千瓦服務(wù)器單獨(dú)散熱是原始設(shè)備制造商非常熟悉的事情。但是,一旦要在機(jī)架上安裝這些系統(tǒng),情況就會變得復(fù)雜起來,機(jī)架電源和設(shè)備冷卻等因素都會發(fā)揮作用。

在我們的同類出版物《下一代平臺》(The Next Platform)上,我們深入探討了像 Digital Reality 這樣的數(shù)據(jù)中心運(yùn)營商為支持此類系統(tǒng)的密集部署而必須克服的挑戰(zhàn)。

在許多情況下,主機(jī)托管服務(wù)提供商需要重新設(shè)計(jì)其電源和冷卻基礎(chǔ)設(shè)施,以支持在單個機(jī)架中安裝四個 DGX H100 系統(tǒng)所需的 40 多千瓦的功率和熱量。

但是,如果您的數(shù)據(jù)中心或主機(jī)托管服務(wù)提供商無法提供這種功率的機(jī)架,也無法承受這種熱量,那么在大部分機(jī)架都將空置的情況下,將這些系統(tǒng)的密度提高到這種程度就沒有多大意義了。

隨著 GH200 的推出,我們看到 Nvidia 不再關(guān)注單個系統(tǒng),而是更加關(guān)注機(jī)架規(guī)模的部署。在今年春季的 Computex 上,我們首次看到了 DGX GH200 集群。

該系統(tǒng)實(shí)際上由 256 個 2U 節(jié)點(diǎn)組成,每個節(jié)點(diǎn)都裝有一個 GH200 加速器,而不是一堆密集的 GPU 節(jié)點(diǎn)。組合起來,該系統(tǒng)能夠提供高達(dá) exaFLOPS 的 FP8 性能,但在設(shè)施層面的部署要容易得多。現(xiàn)在的功耗不再是 1.2 kW/RU,而是接近 500 W/RU,這與大多數(shù)原始設(shè)備制造商使用自己的風(fēng)冷系統(tǒng)時的情況差不多。

最近,我們看到 Nvidia 在今年秋季的 Re:Invent 大會上與 AWS 合作發(fā)布了 GH200-NVL32,將其縮小到單個機(jī)架。

該系統(tǒng)在一個機(jī)架上安裝了 16 個 1U 機(jī)箱,每個機(jī)箱配備兩個 GH200 節(jié)點(diǎn),并使用九個 NVLink 交換機(jī)托盤將它們連接在一起。不用說,這些計(jì)算能力為 2 千瓦/RU 的小系統(tǒng)密度很高,因此從一開始就被設(shè)計(jì)為液冷系統(tǒng)。

更熱的芯片即將上市

雖然我們一直在關(guān)注 Nvidia 的 Grace Hopper 超級芯片,但這家芯片制造商并不是唯一一家為追求性能和效率而將 TDP 推向新極限的廠商。

本月早些時候,AMD 公布了其最新的 AI 和 HPC GPU 和 APU,該公司的 Instinct 加速器的功耗從上一代的 560 W 躍升至 760 W。

更重要的是,AMD 首席技術(shù)官馬克-帕普馬斯特(Mark Papermaster)告訴《The Register》,未來幾年仍有足夠的空間將 TDP 推得更高。

至于這是否會最終促使芯片制造商強(qiáng)制要求其旗艦產(chǎn)品采用液冷技術(shù),目前還沒有答案。據(jù) Papermaster 稱,AMD 將在其平臺上支持空氣和液體冷卻。但正如我們在 AMD 新的 MI300A APU 上看到的那樣,繼續(xù)選擇風(fēng)冷幾乎肯定意味著性能上的讓步。

MI300A的額定功率為550瓦,遠(yuǎn)遠(yuǎn)低于我們所認(rèn)為的850瓦,但如果有足夠的冷卻,它的運(yùn)行溫度會更高。在HPC調(diào)整系統(tǒng)中,如HPE、Eviden(Atos)或聯(lián)想開發(fā)的系統(tǒng),芯片可以配置為760 W。

與此同時,英特爾正在探索使用兩相冷卻劑和珊瑚啟發(fā)設(shè)計(jì)的散熱片來冷卻 2 千瓦芯片的新方法,以促進(jìn)氣泡的形成。

這家芯片制造商還宣布與基礎(chǔ)設(shè)施和化學(xué)品供應(yīng)商建立廣泛的合作關(guān)系,以擴(kuò)大液體冷卻技術(shù)的使用范圍。該公司最新的合作旨在利用 Vertiv 的泵送兩相冷卻技術(shù)為英特爾即將推出的 Guadi3 AI 加速器開發(fā)冷卻解決方案。?

審核編輯 黃宇

-

芯片

+關(guān)注

關(guān)注

456文章

51154瀏覽量

426294 -

amd

+關(guān)注

關(guān)注

25文章

5490瀏覽量

134496 -

AI

+關(guān)注

關(guān)注

87文章

31490瀏覽量

269907

發(fā)布評論請先 登錄

相關(guān)推薦

汽車熱管理相關(guān)知識

經(jīng)緯恒潤熱管理系統(tǒng)研發(fā)服務(wù)全新升級

芯導(dǎo)科技GaN/SiC電源產(chǎn)品推薦

簡述智慧供熱管理服務(wù)平臺

聯(lián)發(fā)科攜手臺積電、新思科技邁向2nm芯片時代

soc設(shè)計(jì)中的熱管理技巧

1250千瓦變壓器承載多大電流

80的變壓器可以帶多少個千瓦

熱管理需求顯著增加!VC和熱管的優(yōu)勢在哪里?

同星智能即將亮相新能源汽車熱管理論壇、中國車聯(lián)網(wǎng)安全大會

18千瓦380V用多大電容補(bǔ)償器

18.5千瓦電機(jī)就地補(bǔ)償需要多大電容

千瓦芯片時代的熱管理變革

千瓦芯片時代的熱管理變革

評論