前段時間,Mistral AI 公布的 Mixtral 8x7B 模型爆火整個開源社區,其架構與 GPT-4 非常相似,很多人將其形容為 GPT-4 的「縮小版」。

▲圖源 https://mistral.ai/news/mixtral-of-experts/

▲圖源 https://mistral.ai/news/mixtral-of-experts/

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502 ?第三步是初始化 TextStreamer:

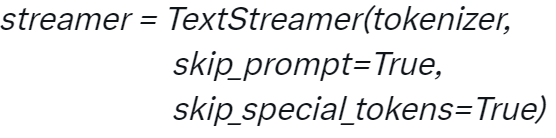

?第三步是初始化 TextStreamer:

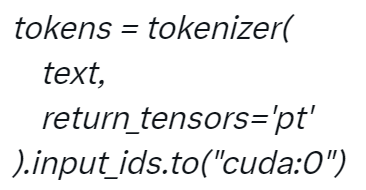

?第四步對輸入進行 Token 化:

?第四步對輸入進行 Token 化:

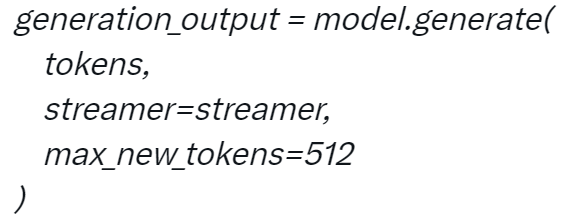

?第五步生成:

?第五步生成:

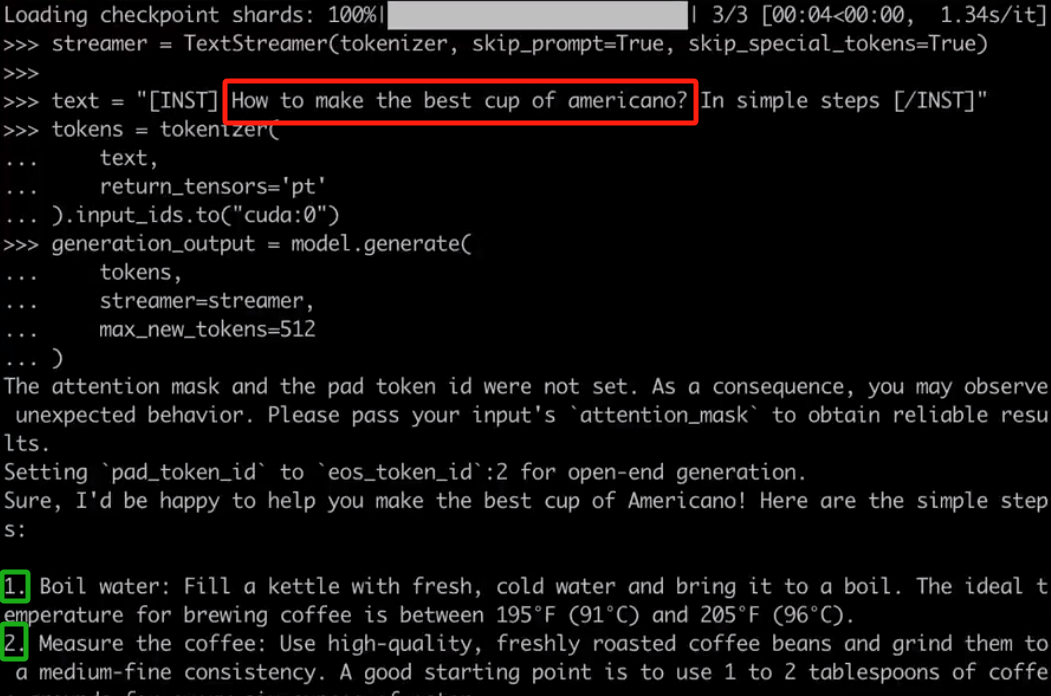

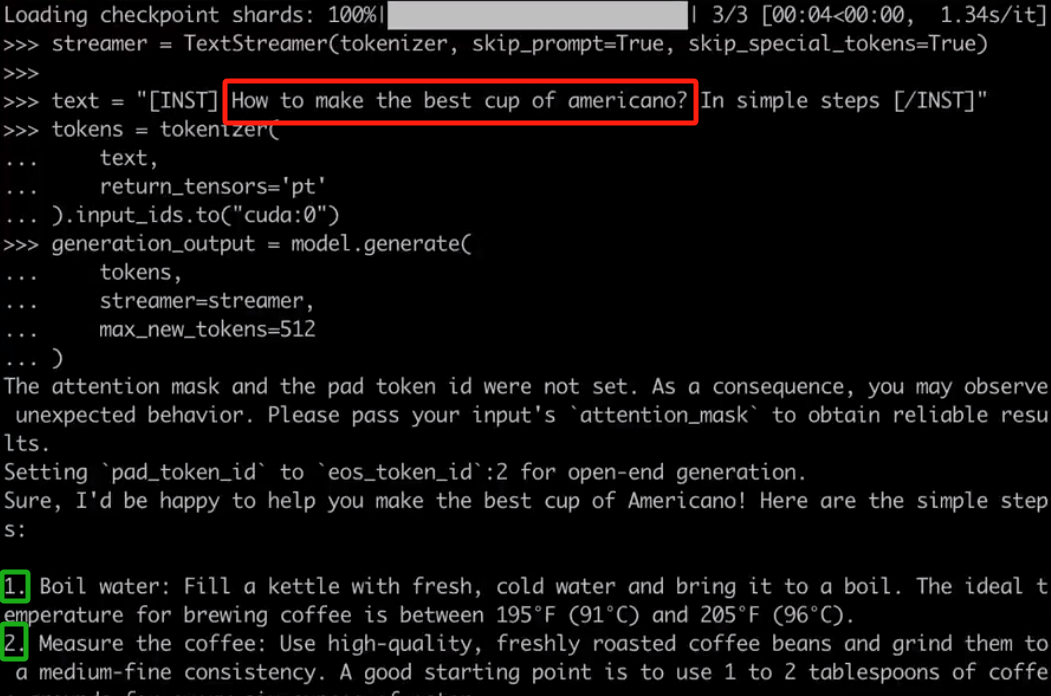

?當你配置好項目后,就可以與 Mixtral 進行對話,例如對于用戶要求「如何做出最好的美式咖啡?通過簡單的步驟完成」,Mixtral 會按照 1、2、3 等步驟進行回答。

?當你配置好項目后,就可以與 Mixtral 進行對話,例如對于用戶要求「如何做出最好的美式咖啡?通過簡單的步驟完成」,Mixtral 會按照 1、2、3 等步驟進行回答。

?

?

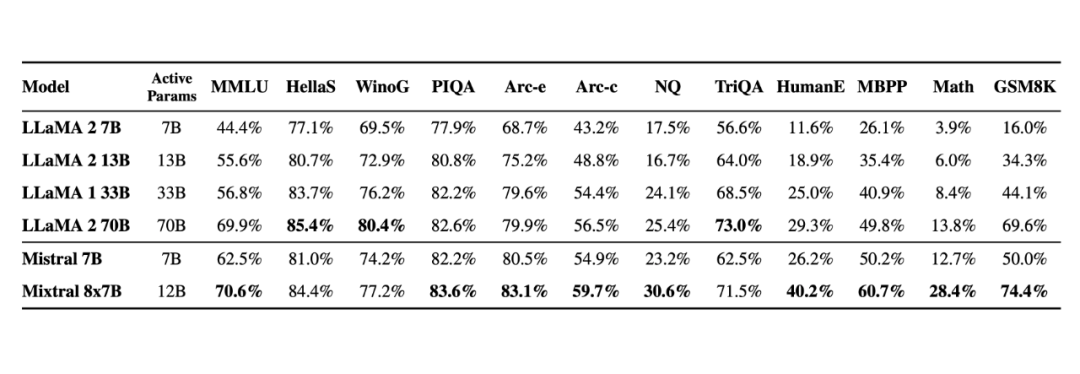

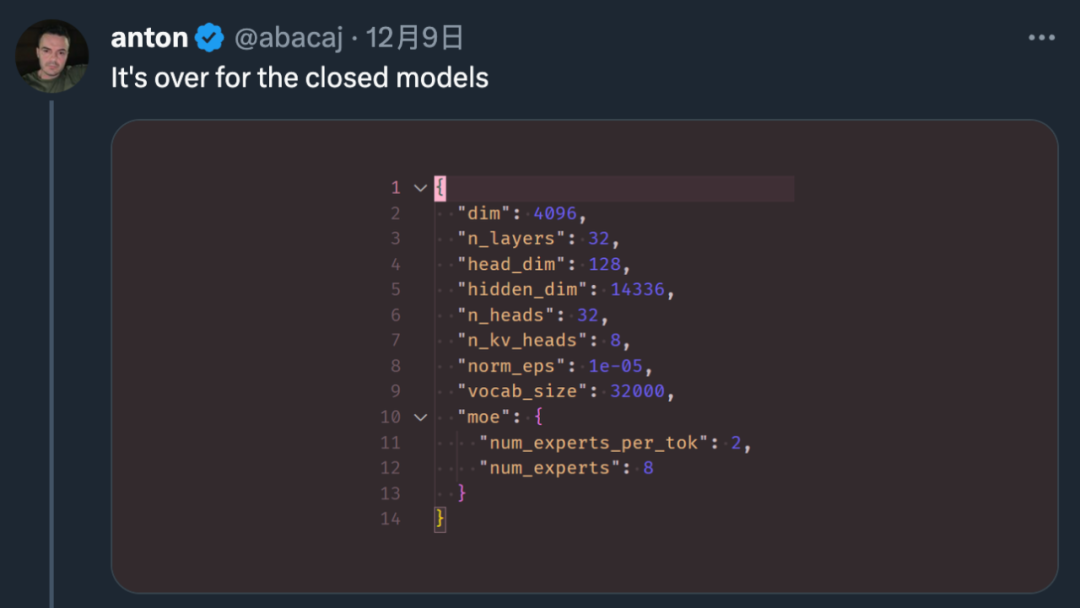

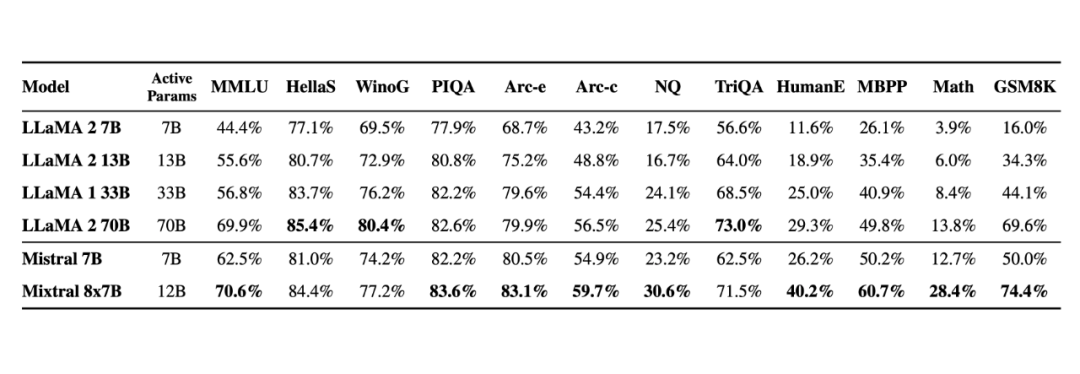

我們都知道,OpenAI 團隊一直對 GPT-4 的參數量和訓練細節守口如瓶。Mistral 8x7B 的放出,無疑給廣大開發者提供了一種「非常接近 GPT-4」的開源選項。

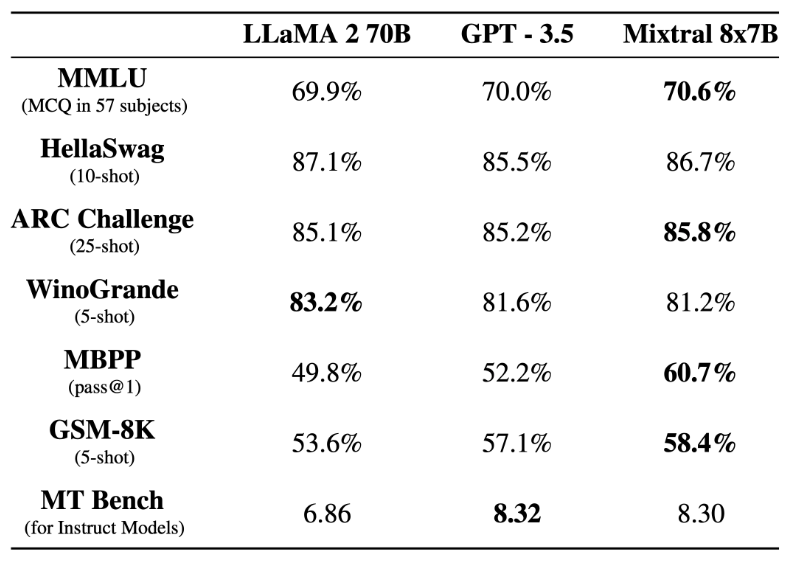

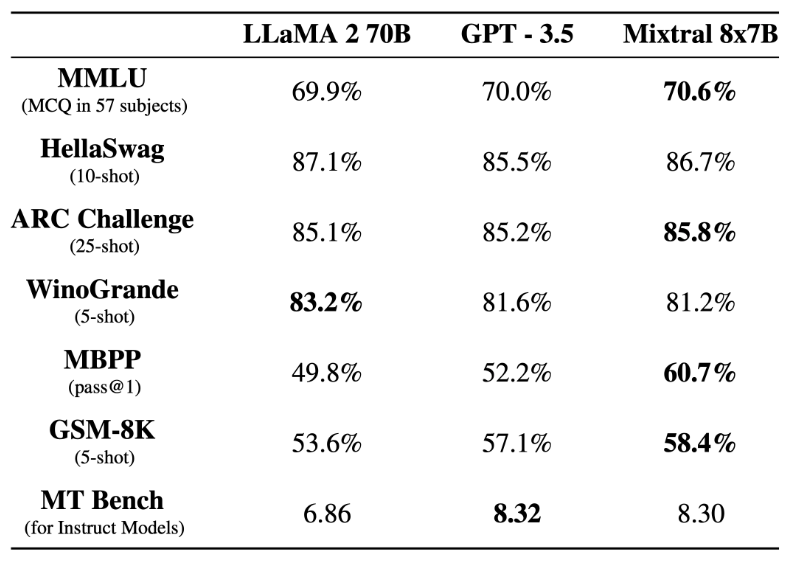

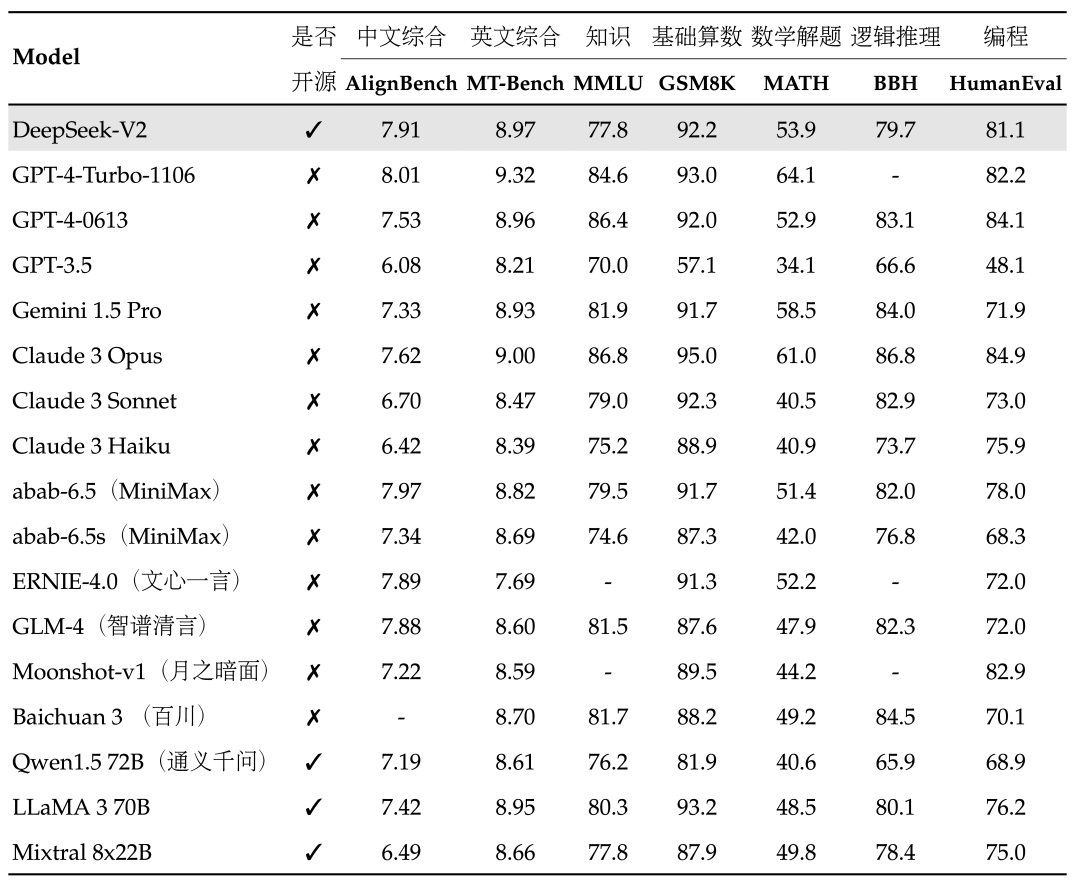

在基準測試中,Mistral 8x7B 的表現優于 Llama 2 70B,在大多數標準基準測試上與 GPT-3.5 不相上下,甚至略勝一籌。

▲圖源 https://mistral.ai/news/mixtral-of-experts/

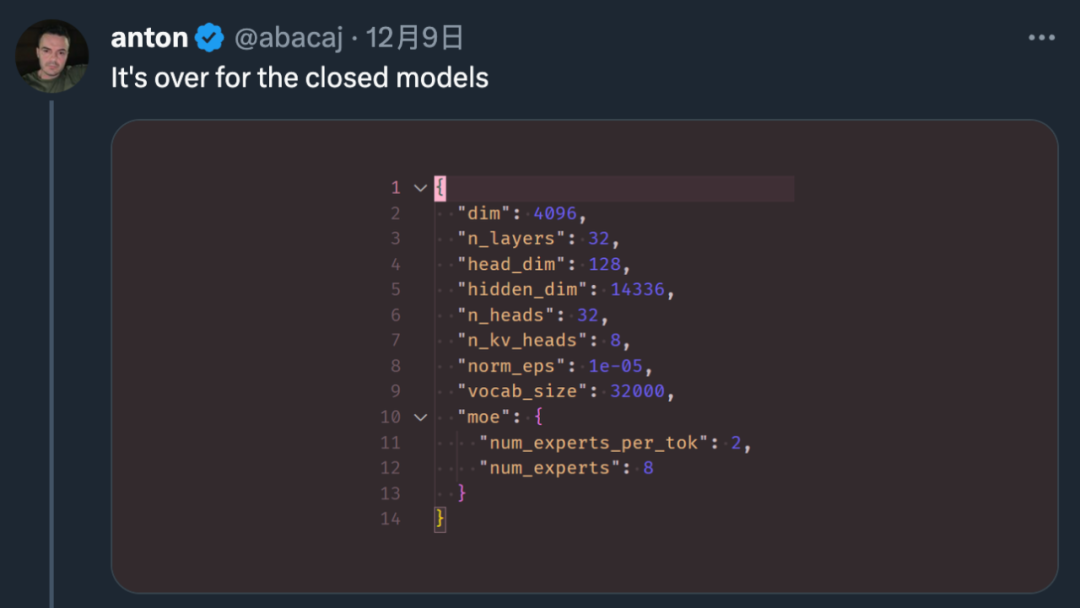

▲圖源 https://mistral.ai/news/mixtral-of-experts/隨著這項研究的出現,很多人表示:「閉源大模型已經走到了結局。」

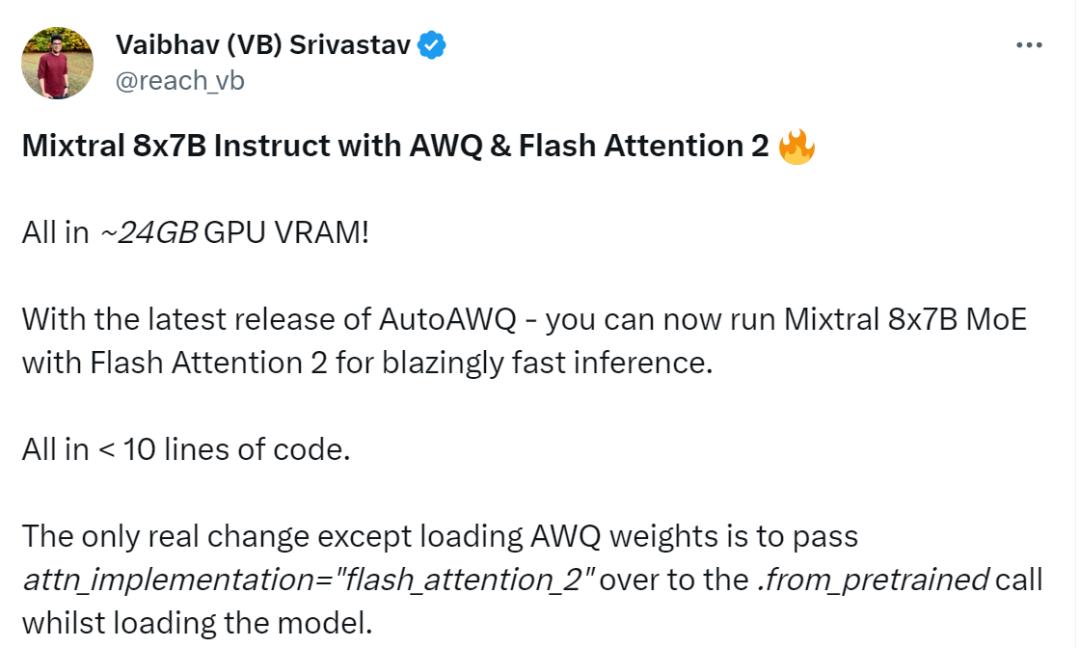

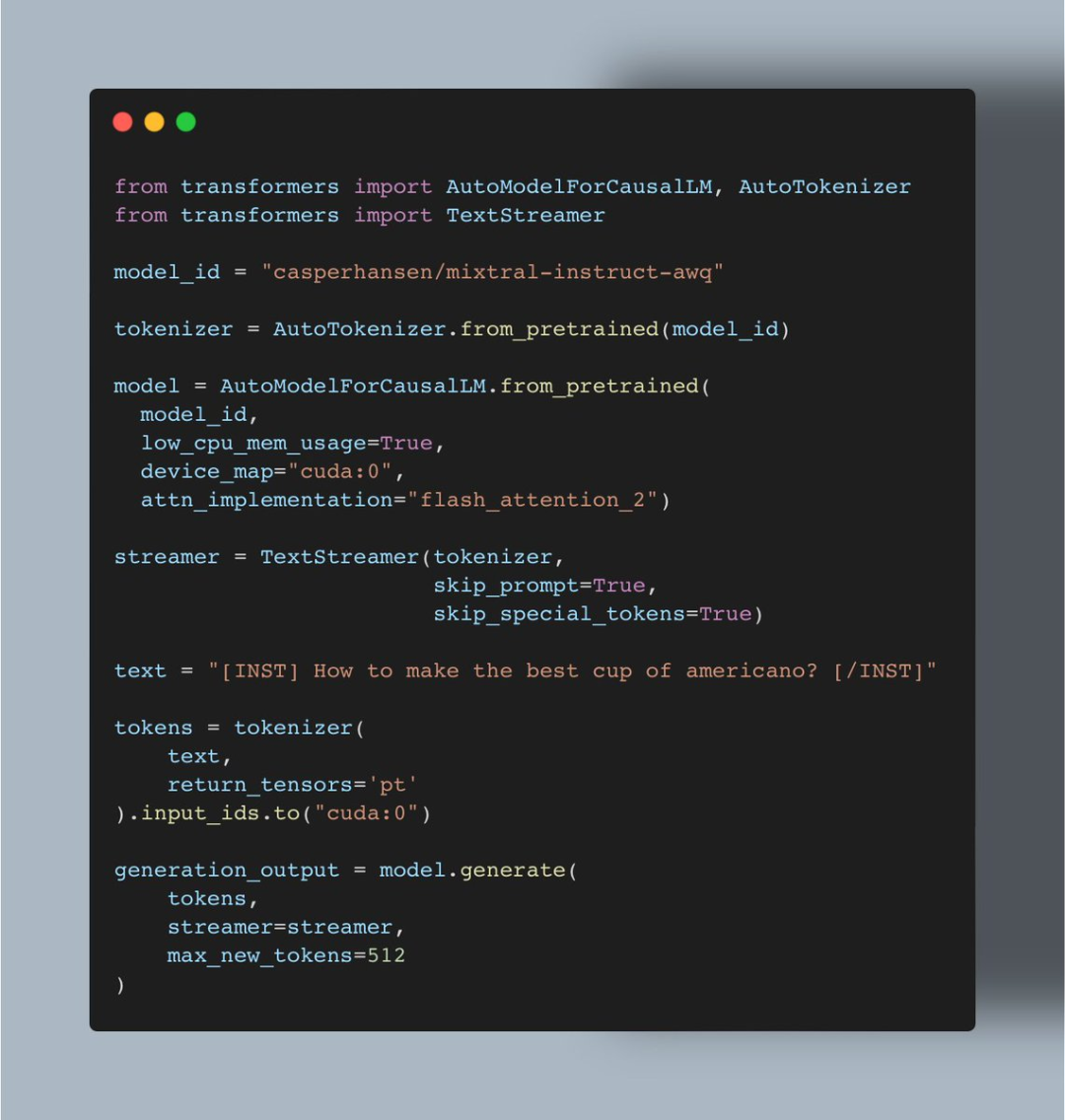

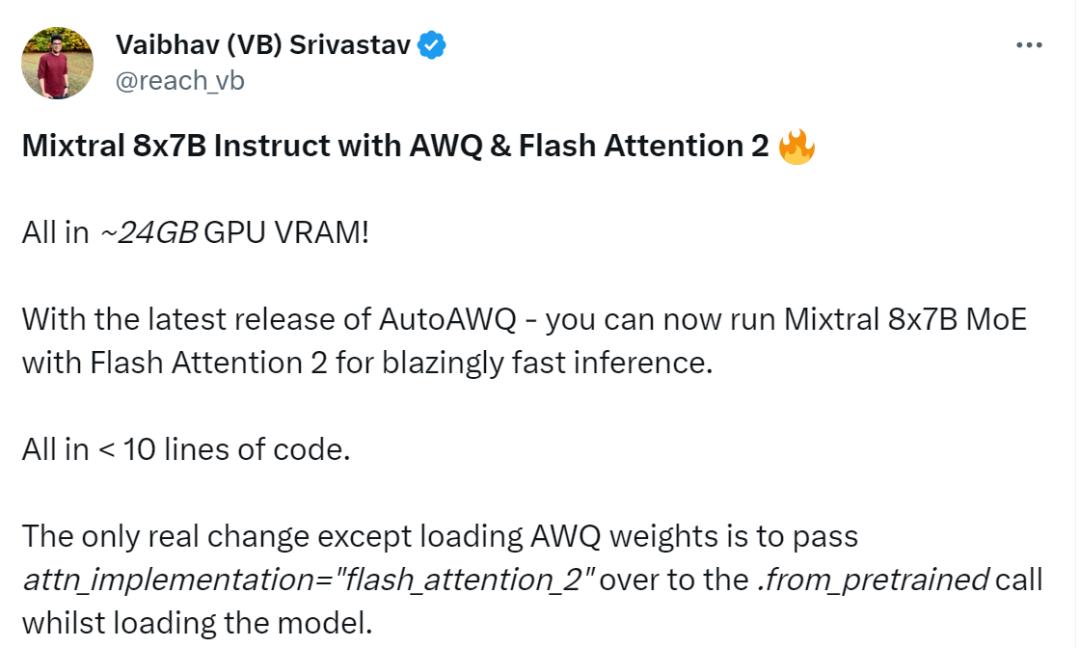

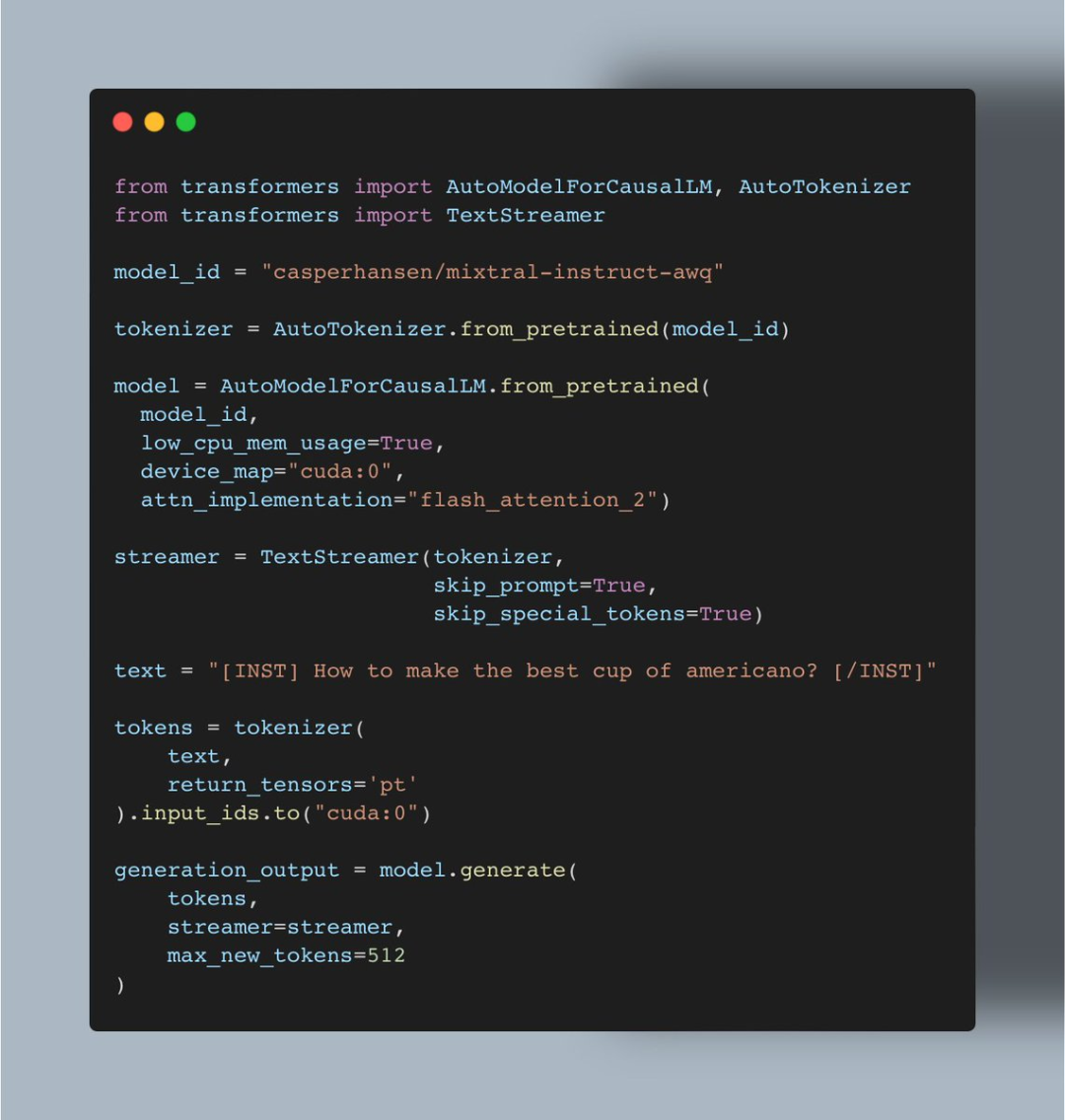

短短幾周的時間,機器學習愛好者 Vaibhav (VB) Srivastav 表示:隨著 AutoAWQ(支持 Mixtral、LLaVa 等模型的量化)最新版本的發布,現在用戶可以將 Mixtral 8x7B Instruct 與 Flash Attention 2 結合使用,達到快速推理的目的,實現這一功能大約只需 24GB GPU VRAM、不到十行代碼。

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502

AutoAWQ地址:

https://github.com/casper-hansen/AutoAWQ 操作過程是這樣的: 首先是安裝 AutoAWQ 以及 transformers:

pipinstallautoawqgit+https://github.com/huggingface/transformers.git

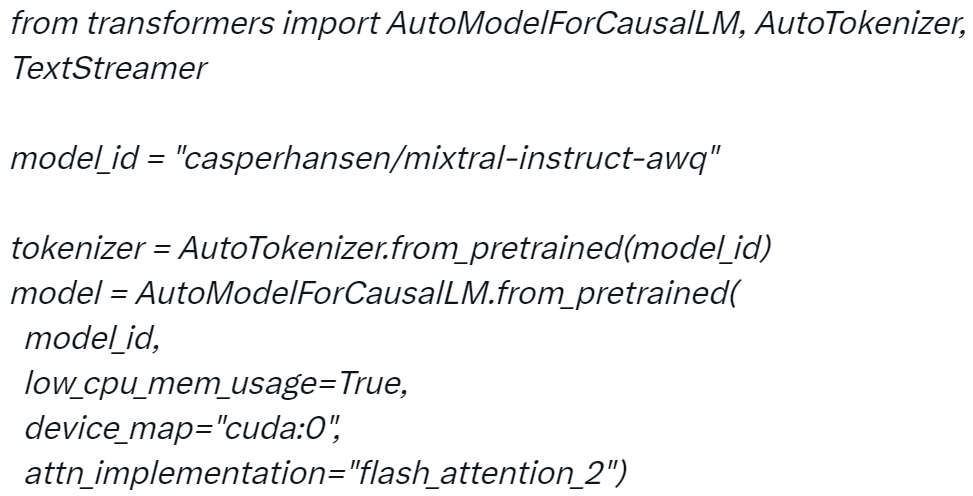

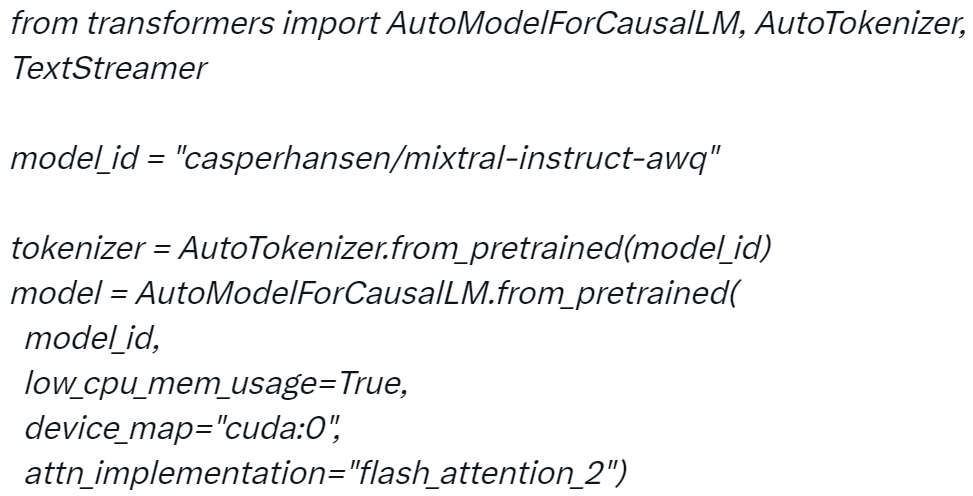

第二步是初始化 tokenizer 和模型:

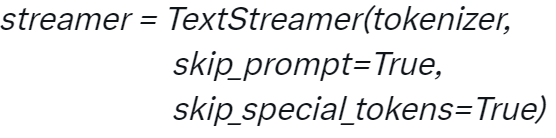

?第三步是初始化 TextStreamer:

?第三步是初始化 TextStreamer:

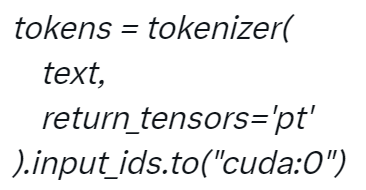

?第四步對輸入進行 Token 化:

?第四步對輸入進行 Token 化:

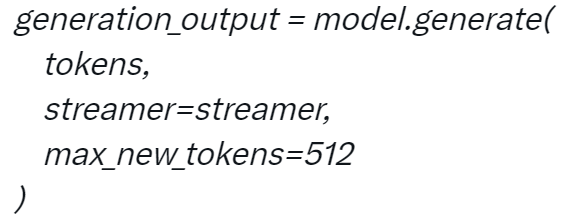

?第五步生成:

?第五步生成:

?當你配置好項目后,就可以與 Mixtral 進行對話,例如對于用戶要求「如何做出最好的美式咖啡?通過簡單的步驟完成」,Mixtral 會按照 1、2、3 等步驟進行回答。

?當你配置好項目后,就可以與 Mixtral 進行對話,例如對于用戶要求「如何做出最好的美式咖啡?通過簡單的步驟完成」,Mixtral 會按照 1、2、3 等步驟進行回答。

項目中使用的代碼:

Srivastav 表示上述實現也意味著用戶可以使用 AWQ 運行所有的 Mixtral 微調,并使用 Flash Attention 2 來提升它們。 看到這項研究后,網友不禁表示:真的很酷。

?

?

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

代碼

+關注

關注

30文章

4803瀏覽量

68752 -

GPT

+關注

關注

0文章

354瀏覽量

15438 -

OpenAI

+關注

關注

9文章

1100瀏覽量

6581

原文標題:8x7B MoE與Flash Attention 2結合,不到10行代碼實現快速推理

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Flexus X 實例 C#/.Net Core 結合(git 代碼管理、docker 自定義鏡像)快速發布部署 - 讓你的項目飛起來~

前言 ???云端部署新體驗,C# Web API 遇上 Git Docker,828 B2B 企業節特惠來襲!Flexus X 實例,為您的 C#應用提供強大支撐,結合 Git 版本控制

獵戶星空發布Orion-MoE 8×7B大模型及AI數據寶AirDS

近日,獵戶星空攜手聚云科技在北京共同舉辦了一場發布會。會上,獵戶星空正式揭曉了其自主研發的Orion-MoE 8×7B大模型,并與聚云科技聯合推出了基于該大模型的數據服務——AI數據寶AirDS

CC13x2x7和CC26x2x7 SimpleLink無線MCU技術參考手冊

電子發燒友網站提供《CC13x2x7和CC26x2x7 SimpleLink無線MCU技術參考手冊.pdf》資料免費下載

發表于 11-14 14:16

?0次下載

阿里Qwen2-Math系列震撼發布,數學推理能力領跑全球

阿里巴巴近期震撼發布了Qwen2-Math系列模型,這一系列模型基于其強大的Qwen2 LLM構建,專為數學解題而生,展現了前所未有的數學推理能力。Qwen2-Math家族包括1.5

PerfXCloud順利接入MOE大模型DeepSeek-V2

今日,在 PerfXCloud 重磅更新支持 llama 3.1 之后,其平臺再度實現重大升級!目前,已順利接入被譽為全球最強的 MOE 大模型 DeepSeek-V2 ,已在 PerfXCloud(澎峰云)官網的體驗中心對平臺

Verilog:【8】基于FPGA實現SD NAND FLASH的SPI協議讀寫

校驗 2Bytes

** 6 模塊代碼**

本代碼所實現的功能,是基于黑金AX301B,實現

發表于 06-21 17:58

ESP32-S2能否支持8位串行RGB?

看ESP32-S2手冊上寫的是支持8位串口RGB的。但是在編譯esp-idf master代碼時出錯。

我有一片LCD是8位串行RGB接口(

發表于 06-17 06:17

昆侖萬維開源2千億稀疏大模型Skywork-MoE

近日,昆侖萬維公司宣布開源一款名為Skywork-MoE的稀疏大模型,該模型擁有高達2千億參數,不僅性能強勁,而且推理成本更低,為人工智能領域帶來了新的突破。

STM32G0B1無法操作FLASH,解鎖FLASH失敗的原因?

使用STM32G0B1寫內部的Flash時出現問題,代碼:

#pragma arm section code = \"RAMCODE\"

uint32_t

發表于 04-02 07:45

8b10b編碼verilog實現

8b/10b編碼是一種用于減少數據線上的低效能時鐘信號傳輸的技術,通過在數據流中插入特殊的控制字符,來同步數據和時鐘。在Verilog中實現8b/1

發表于 03-26 07:55

基于NVIDIA Megatron Core的MOE LLM實現和訓練優化

本文將分享阿里云人工智能平臺 PAI 團隊與 NVIDIA Megatron-Core 團隊在 MoE (Mixture of Experts) 大語言模型(LLM)實現與訓練優化上的創新工作。

基于OpenCV DNN實現YOLOv8的模型部署與推理演示

基于OpenCV DNN實現YOLOv8推理的好處就是一套代碼就可以部署在Windows10系統、烏班圖系統、Jetson的Jetpack系

最佳開源模型刷新多項SOTA,首次超越Mixtral Instruct!「開源版GPT-4」家族迎來大爆發

Mixtral 8x7B模型開源后,AI社區再次迎來一大波微調實踐。來自Nous Research應用研究小組團隊微調出新一代大模型Nous-Hermes 2 Mixtral 8x7B,在主流基準測試中擊敗了Mixtral In

CYT2B7 flash分區的疑問求解

在看看 CYT2B7 的手冊時,對于 flash 分區有疑問。

為什么 Dual Bank 的分區中碼 flash和data flashdapping A和Mapping B?使用時單

發表于 01-22 07:30

混合專家模型 (MoE)核心組件和訓練方法介紹

隨著 Mixtral 8x7B (announcement, model card) 的推出,一種稱為混合專家模型 (Mixed Expert Models,簡稱 MoEs

8x7B MoE與Flash Attention 2結合,不到10行代碼實現快速推理

8x7B MoE與Flash Attention 2結合,不到10行代碼實現快速推理

評論