一、比賽背景

International Geoscience and Remote Sensing Symposium (IGARSS)是IEEE地球科學和遙感學會的旗艦會議。2023年7月16 ,第46屆IGARSS大會在美國帕薩迪納成功召開,發(fā)布了IEEE GRSS DFC 2023國際遙感數(shù)據(jù)融合大賽的結(jié)果和論文。來自中國、美國、瑞典、日本、印度、德國、比利時、泰國、土耳其等全球25個國家和地區(qū)的700余支隊伍,經(jīng)過為期三個月的初賽、決賽激烈角逐,航天宏圖PIESAT-AI團隊在“建筑物實例分割與屋頂細粒度分類”與“面向多任務(wù)學習的城市建筑物提取與高度估計”雙賽道,均獲得第一名的好成績。

在城市規(guī)劃與建筑設(shè)計領(lǐng)域,建筑屋頂類型和高度是非常重要的元素之一,影響到建筑外觀、功能、通風、采光、保溫、防水等多個方面。正確的提取建筑的基底、高度、以及屋頂類型(如坡頂、平頂、圓頂、尖頂?shù)?,有助于高效地完成實景三維重建,為土地利用、空間分析、數(shù)字孿生等方面提供重要的參考數(shù)據(jù),同時也可加強環(huán)境監(jiān)測和資源管理,促進城市可持續(xù)發(fā)展。此外,在城市災(zāi)害和救援中,這些信息的準確性也很關(guān)鍵。當城市遭受地震、洪水等自然災(zāi)害時,往往會造成建筑物屋頂?shù)钠茡p和崩塌,如果能通過衛(wèi)星影像快速地確定災(zāi)區(qū)的屋頂狀況,可以為救援行動提供重要的信息和指導。

傳統(tǒng)的建筑檢測、屋頂分類、高度估計方法往往依賴于地面實地勘測,因為受天氣、光照、時間等因素的影響,存在效率低、成本高、精度差等問題,已無法滿足現(xiàn)代需求。huang等人[1]驗證代表性的單階段 (SOLOv2)、兩階段 (Mask-RCNN、Cascade Mask RCNN) 和基于查詢 (QueryInst) 的方法,這些方法在類似賽道一的屋頂檢測分割數(shù)據(jù)集 UBC [1]中無法實現(xiàn)理想的性能。zheng[2]、xing[3]等人提出聯(lián)合語義信息提高單一高度估計任務(wù)的學習,但與高度信息完全匹配的語義標簽卻難以獲得,影響了高度估計的準確性。

基于光學遙感圖像的細粒度屋頂檢測、分類,高度估計技術(shù)主要面臨三個挑戰(zhàn):

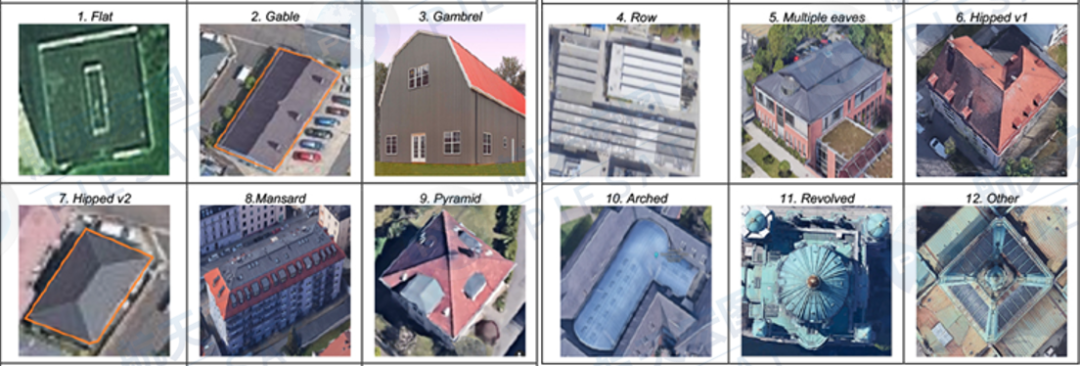

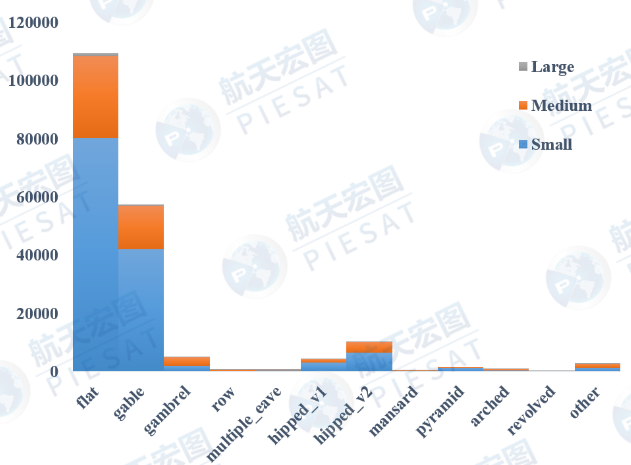

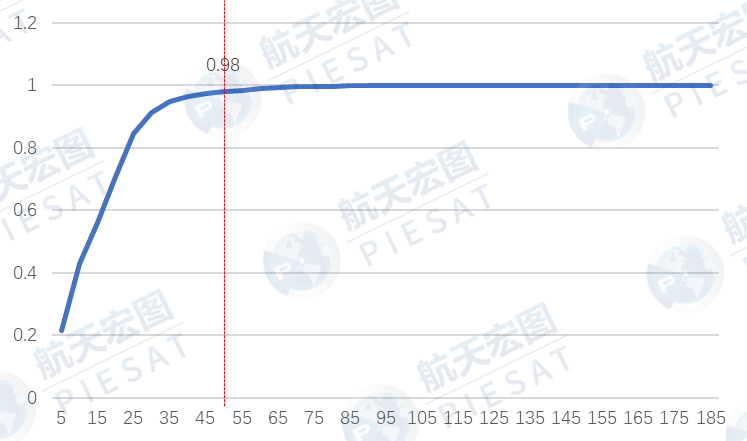

不同屋頂類型、建筑物高度(低,中,高)的樣本呈現(xiàn)不均勻的長尾分布,如圖1.1-1.3所示;

在遙感圖像中很多建筑屬于弱小目標不易分辨;

不同屋頂類別之間視覺特征模糊難以區(qū)分;

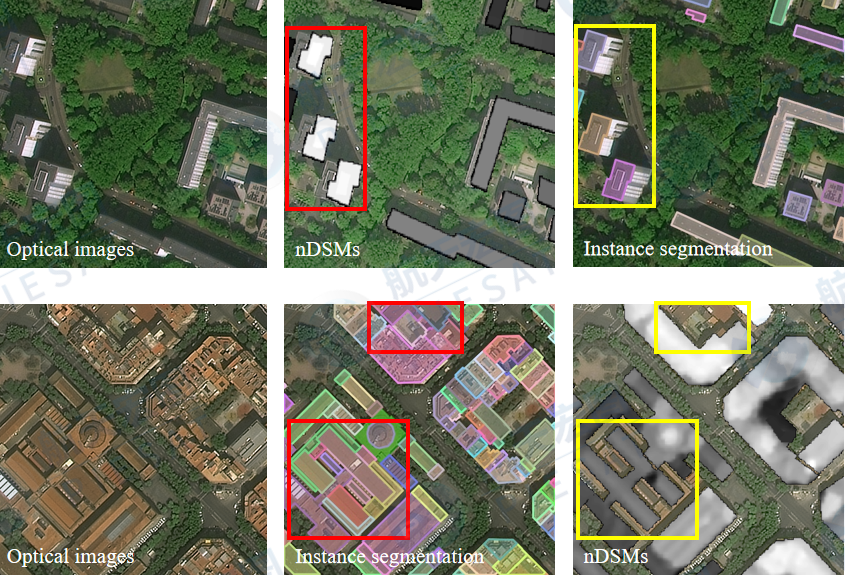

部分標注數(shù)據(jù)中,建筑輪廓和高度掩碼(nDSM大于0部分)不對齊,如圖1.4所示;

實際場景中的云霧干擾、建筑陰影、相互遮擋等,降低了識別精度。

SAR雷達影像因為波長更長,可以穿透云層、霧、灰塵、霾和煙,克服了遙感光學影像受天氣、光照、時間等干擾的不足。我們嘗試將遙感可見光影像和SAR雷達影像這兩種模態(tài)數(shù)據(jù)與深度學習算法相結(jié)合,研發(fā)全新的多模態(tài)建筑基底、屋頂類型、高度估計方法,實現(xiàn)更高精度的建筑屬性自動提取方法。

▲圖 1.1 IEEE GRSS DFC 2023數(shù)據(jù)集[4]的12種屋頂類型

▲圖1.2 IEEE DFC 2023數(shù)據(jù)集,各種屋頂類別實例分布。灰、橙和藍色分別代表大、中、小實例

▲圖1.3 IEEE GRSS DFC 2023數(shù)據(jù)集建筑高度分布情況,超過50m的約占2%

▲圖1.4 IEEE GRSS DFC 2023數(shù)據(jù)集,建筑物輪廓和nDSM圖像不對齊樣例

二、屋頂檢測分類方法

基于遙感多模態(tài)AI技術(shù),航天宏圖團隊使用自監(jiān)督預(yù)訓練、雙主干網(wǎng)絡(luò)多模態(tài)表征、Modified Copy-Paste數(shù)據(jù)增強、實例分割多模型融合,抗長尾損失函數(shù)SeesawLoss等方法來應(yīng)對上述挑戰(zhàn)并實現(xiàn)高精度的建筑屋頂檢測和分類的方法,在DFC 2023賽道一測試集以mAP50 50.6% 取得第一名成績。

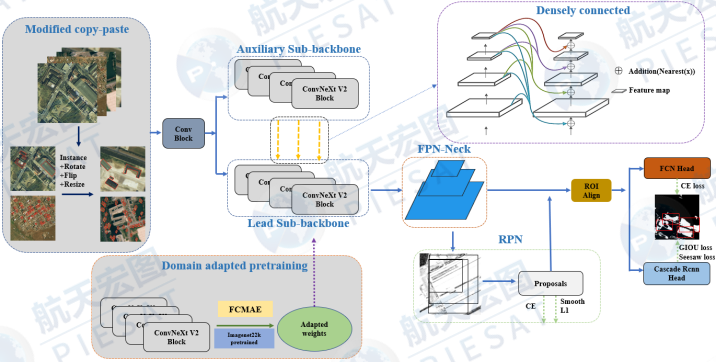

本賽道遙感圖像上的建筑屋頂具有目標特征微弱,不同屋頂間的特征邊界模糊、不同類別屋頂數(shù)量極度不平衡等特點。為了提高模型區(qū)分目標前景和背景的能力從而提高模型的召回率,系統(tǒng)架構(gòu)采用經(jīng)典的端到端two stage實例分割算法Cascade Mask-RCNN[5]作為基礎(chǔ)框架, 網(wǎng)絡(luò)結(jié)構(gòu)如圖2.1所示。相比于one stage的實例分割算法,two stage的RPN結(jié)構(gòu)幫助模型能夠更加細致的理解圖特征,獲得更多前景proposal從而更加有力的應(yīng)對微弱特征目標。同時為了進一步加強模型特征提取能力,我們基于CBnetV2首次提出將目前的SOTA算法ConvNeXtV2進行dual-ConvNeXtV2結(jié)構(gòu)的構(gòu)建。為了應(yīng)對訓練數(shù)據(jù)存在的長尾分布場景,我們將定位損失GIoULoss與分類損失SeesawLoss相結(jié)合,有效地緩解了訓練過程中占比較小類別的梯度會被頭部類別淹沒的問題。

“優(yōu)秀”的模型初始化策略在整個模型訓練優(yōu)化過程中占據(jù)了舉足輕重的地位,可以讓模型贏在起跑線。本次比賽為了進一步提高模型的收斂質(zhì)量,提供高模型最終的表現(xiàn),我們未使用以往的Imagenet22K預(yù)訓練模型,而是在訓練模型前對主干網(wǎng)絡(luò)進行了自監(jiān)督模型預(yù)訓練,自監(jiān)測預(yù)訓練策略選用與ConvNeXtV2較為契合的FCMAE。

本賽道用于訓練的數(shù)據(jù)集包含數(shù)據(jù)樣本數(shù)量為3000+,為了更好的提升模型的泛化能力,我們在數(shù)據(jù)增強策略上進行創(chuàng)新。基于實例分割提點利器Simple Copy-Paste基礎(chǔ)上,我們提出Modified Copy-Paste,從粘貼實例角度喜歡數(shù)據(jù)增強環(huán)節(jié),進一步增強數(shù)據(jù)增強能。并結(jié)合大尺度的圖像輸入,隨機翻轉(zhuǎn),隨機旋轉(zhuǎn)等數(shù)據(jù)策略大大提升模型泛化到其它場景能力。

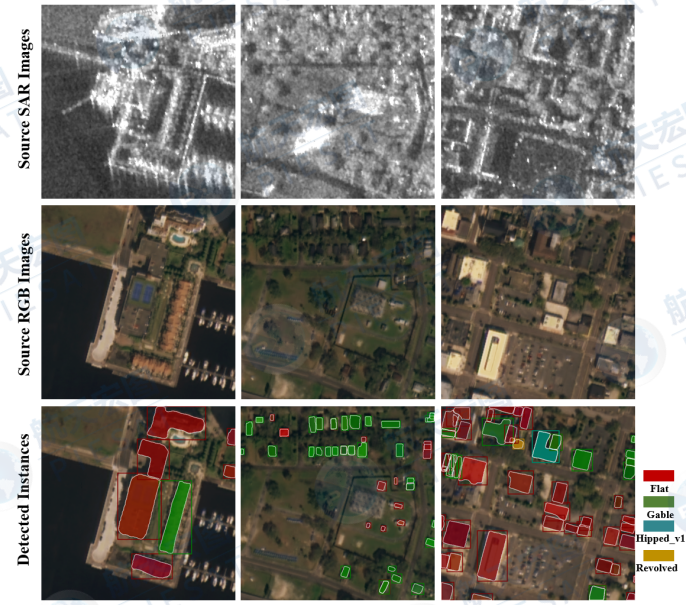

模型推理階段輸入光學影像模態(tài)和SAR模態(tài),輸出建筑物屋頂?shù)臋z測外接矩形框、屋頂類別及屋頂?shù)亩噙呅屋喞P途唧w表現(xiàn)如圖2.2所示。

▲圖2.1 多模態(tài)屋頂檢測識別網(wǎng)絡(luò)結(jié)構(gòu)圖

▲圖2.2 模型推理結(jié)果樣例

2.1. 具體方法

屋頂檢測與細粒度分類模型訓練流程如圖2.3所示。第一步進行ConvNeXtV2遙感影像域自適應(yīng)預(yù)訓練;第二步使用Modified copy-paste等數(shù)據(jù)加強進行檢測器模型訓練;第三步對模型進行去Modified copy-paste的微調(diào);第四步進行SWA訓練。接下來文章會根據(jù)訓練的每個Step為線索,對所涉及的技術(shù)細節(jié)及創(chuàng)新性方案進行詳細闡述。

▲圖2.3 屋頂檢測與細粒度分類模型流程

2.1.1 Step1: 自監(jiān)督預(yù)訓練

模型通過自監(jiān)督預(yù)訓練在訓練正式開始前快速的適應(yīng)場景數(shù)據(jù),為后面的訓練打下堅實的基礎(chǔ)。該部分主要技術(shù)點在ConvNeXtV2及FCMAE。

ConvNeXtV2[6]:該模型采用全卷積架構(gòu),模型通過全局特征聚合、特征標準化、特征校準等策略使得模型有著強悍的性能,一經(jīng)提出就成為CV領(lǐng)域各大競賽的寵兒。本次項目沿用ConvNeXtV2模型的整體架構(gòu),未作修改。

FCMAE[7]:該方法是對于全卷積架構(gòu)模型進行MIM預(yù)訓練的方式,該方法引入稀疏卷積實現(xiàn)讓卷積神經(jīng)網(wǎng)絡(luò)能夠通過圖像遮擋部位的圖像還原來對圖像數(shù)據(jù)進行建模,從而讓模型對遙感屋頂建筑該領(lǐng)域的數(shù)據(jù)進行訓練前的domain adaptation。從圖2.4中可以看出,模型對與masked部分能通過自己的理解進行一定的合理性還原。

▲圖2.4 FCMAE方法預(yù)訓練過程數(shù)據(jù)破壞及重建可視化,original:數(shù)據(jù)原圖,masked:被破壞后輸入模型的數(shù)據(jù)形態(tài),reconstruction:模型重建后的數(shù)據(jù)形態(tài)。

2.1.2 Step2: 模型訓練

模型的訓練過程采用豐富的數(shù)據(jù)增強策略對構(gòu)建起的檢測器進行訓練,我們使用的檢測器是經(jīng)典的Cacsace Mask Rcnn架構(gòu),并為了對抗長尾分布的訓練數(shù)據(jù)集采用seesaw loss對分類頭進行監(jiān)督。這一部分我們主要側(cè)重的技術(shù)點Dual-Backbone、Modified Copy-Paste及損失的使用。

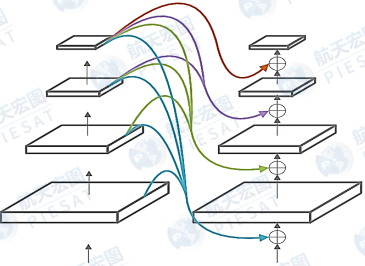

Dual-Backbone: 方案參考CBNet[8]網(wǎng)絡(luò)結(jié)構(gòu),設(shè)計出兩個稠密連接的Dual-ConvNeXtV2結(jié)構(gòu),如圖2.5所示。兩個子主干網(wǎng)絡(luò)均為ConvNeXtV2-base網(wǎng)絡(luò),二者通過稠密連接的方式增強高維度低維度信息的融合及兩個子主干網(wǎng)絡(luò)間特征信息的融合。

▲圖2.5. Dual-Backbone的網(wǎng)絡(luò)結(jié)構(gòu)

Modified Copy-Paste: 在檢測器訓練過程中,有效的數(shù)據(jù)增強策略能夠提高檢測器的魯棒性。Simple Copy-Paste[9]是實例分割檢測器的重要數(shù)據(jù)增強手段之一。Modified Copy-Paste對Simple Copy-Paste剪切下的實例進行旋轉(zhuǎn)、翻轉(zhuǎn)、縮放后再粘貼到目標圖片數(shù)據(jù)上合成新的數(shù)據(jù)。因為遙感數(shù)據(jù)的特殊性,俯視拍攝的數(shù)據(jù)不會因為實例的旋轉(zhuǎn)、翻轉(zhuǎn)而破壞整個場景數(shù)據(jù)的語義信息。合成數(shù)據(jù)可見圖2.6所示。

▲圖2.6 Modified Copy-Paste合成數(shù)據(jù)

SeesawLoss[10]: 降低檢測器在長尾分布數(shù)據(jù)上性能的一個關(guān)鍵原因是施加在尾部類別上的正負樣本梯度的比例是不均衡的,而 SeesawLoss 通過動態(tài)地抑制尾部類別上過量的負樣本梯度,同時補充對誤分類樣本的懲罰,顯著改進了尾部類別的分類準確率,進而提升檢測器在長尾數(shù)據(jù)集上的整體性能。

2.1.3 Step3: 模型微調(diào)

訓練過程中,豐富的數(shù)據(jù)增強策略是把雙刃劍,它不僅可以擴充數(shù)據(jù)集增強模型的泛化能力也可以從一定程度導致整體訓練數(shù)據(jù)的domain shift,從而影響模型最終的能力。為了最大程度利用數(shù)據(jù)增強策略,弱化其負面影響,我們在實驗中發(fā)現(xiàn),經(jīng)過多輪次訓練后的模型可以通過關(guān)閉數(shù)據(jù)增強并使用小學習率進行微調(diào)來達到進一步提高精度的效果,精度提升效果具體可見表2.1。

2.1.4 Step4: SWA訓練

SWA(Stochastic Weights Averaging)[11]:機器學習模型權(quán)重一般會收斂到一組最佳權(quán)重集合的邊緣部分,而使用隨機權(quán)重平均可以收斂到這個最佳權(quán)重集合的更中心位置,一般具有更好的平均表現(xiàn)和泛化水平。該策略可以對訓練好的模型進行穩(wěn)定,有助于比賽最終模型效果的穩(wěn)定。

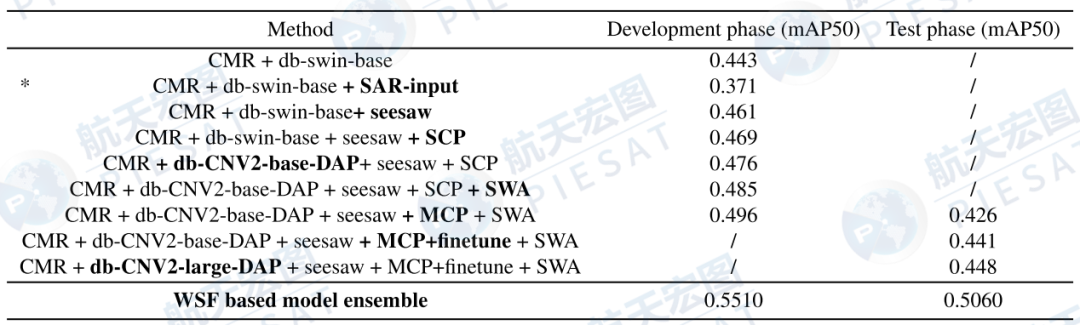

2.2. 實驗結(jié)果

表2.1 給出消融實驗結(jié)果。我們在DFC2023賽道1復(fù)賽成績 mAP50 50.6% 是通過不同超參數(shù)和骨干網(wǎng)下訓練的多個強大檢測器進行WSF 融合而獲得的。從實驗中,可以發(fā)現(xiàn)SeesawLoss帶來0.18的提升;SCP可以在此基礎(chǔ)上提點0.008;主干網(wǎng)絡(luò)變?yōu)镃onvNeXtV2并使用自監(jiān)督域自適應(yīng)預(yù)訓練又有0.007個點的提升;SWA和MCP的使用分別有0.009和0.02的提升。但是, SAR 數(shù)據(jù)并沒有增強模型性能,如表 2.1.* 所示,與單一光學模態(tài)輸入相比,精度下降0.072,主要原因是提供的SAR數(shù)據(jù)沒有與光學影像準確的對齊。

▲表2.1.消融實驗結(jié)果,其中CMR,SCP,MCP,db,DAP,CNV2分別是Cascade Mask-Rcnn,Simple Copy-Paste,Modified Copy-Paste,DUal-Backbone,Domain Adapted Pretraining,ConvNeXtV2, Weighted Segmentation Fusion的縮寫

三、建筑高度估計

基于單張衛(wèi)星影像的建筑提取和高度估計是基于規(guī)則大規(guī)模城市3D重建和空間分析的關(guān)鍵數(shù)據(jù)。PopNet[2]使用雙解碼器機制,同時 SCENet[3]引入了分離-合并機制和注意力機制,用于同時處理語義分割和高度估計的任務(wù)。但是這些方法都強依賴于對齊的語義標簽和高度標簽。

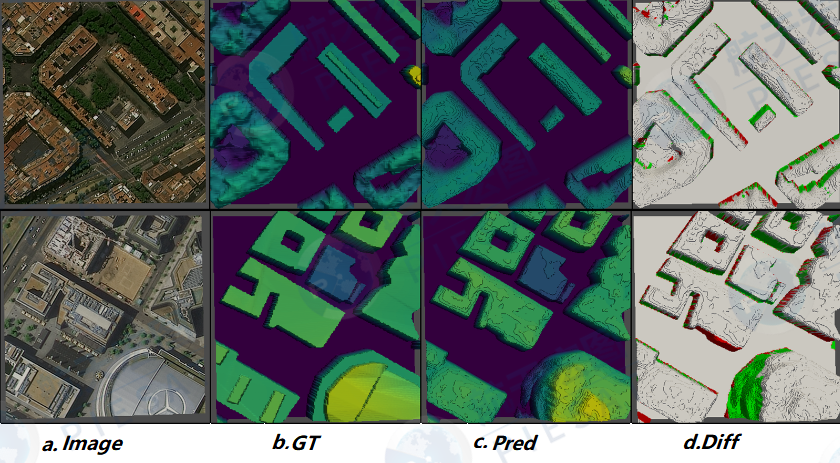

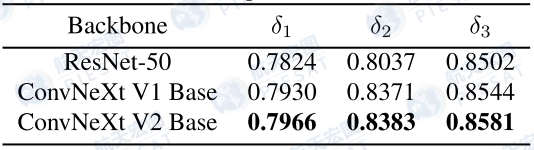

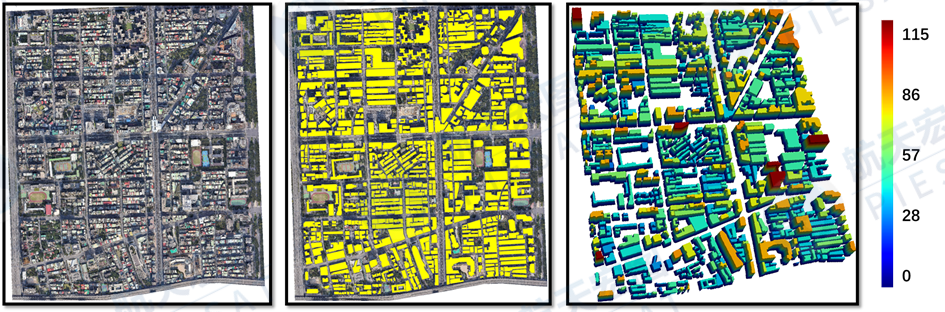

為了應(yīng)對前述挑戰(zhàn)部分標注數(shù)據(jù)建筑輪廓和高度掩碼不對齊的問題,以及建筑高度的長尾分布問題,我們提出了一種聯(lián)合建筑層級提取和高度估計的HGDNET方法。在DFC 2023賽道2數(shù)據(jù)集上的大量實驗和消融研究證明了該方法在建筑高度估計(δ1:0.8012)、實例提取(AP50:0.7730)方面的優(yōu)越性以及最終平均得分0.7871在測試階段排名第一, 部分效果如圖3.1所示。

▲圖3.1. 高度估計的效果圖,(a)是光學影像,(b)(c)分別是真值和模型預(yù)測結(jié)果,最后一列(d)diff=pred-gt,顏色越深差異越大,紅色和綠色分別表示相對真值,預(yù)測結(jié)果偏高和偏低

通過綜合調(diào)研與實驗對比,最后我們提出了一種新的雙解碼器高度估計模型(Height-hierarchy Guided Dual-decoder Network,HGDNet),集成了輔助分支-建筑物高度層級的分割分支,以緩解不同高度建筑物直接高度估計的困難,網(wǎng)絡(luò)結(jié)構(gòu)如圖3.2 所示。其中,高度估計的分支(左)直接通過像素級推理,逐像素回歸nDSM值;而輔助分支則進行離散的建筑高度層級分類,即通過對nDSM值進行聚類,將建筑分為不同高度層級,以生成新合成的建筑分割指導圖。高度估計分支和輔助分支(建筑高度層級分類)之間形成隱式約束,促進模型的訓練速度與最終模型對高度的估計的準確性。

▲圖3.2. 高度估計網(wǎng)絡(luò)HGDNet的結(jié)構(gòu)

3.1. 具體方法

基于高度層次引導的雙解碼高度估計網(wǎng)絡(luò)HGDNet的架構(gòu)如圖3.2所示。采用ConvNeXt V2-Base作為編碼器模塊提取遙感影像的主干特征,同時采用了雙解碼器的結(jié)構(gòu)分別進行高度估計與建筑數(shù)高度層級分割的聯(lián)合估計任務(wù),不同分支的解碼器對不同任務(wù)分別進行回歸學習。解碼器采用UperNet [12]的結(jié)構(gòu),通過上-下的通路和跳躍連接實現(xiàn)不同尺度的特征融合。兩個分支共享同樣的主干網(wǎng)絡(luò)權(quán)重進行特征提取,從而不同分支通過不同方向的損失進行權(quán)重的回歸迭代,共同約束模型學習,加速訓練速度,提高訓練精度。

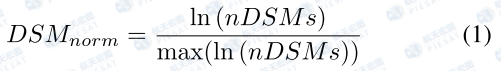

3.1.1 高度估計分支

由于建筑物高度分布不均勻,見圖1.2, 集中在0-50m,甚至0-10m。因此,我們對nDSM 使用對數(shù)函數(shù)進行處理,使其分布更接近正態(tài)。然后,執(zhí)行最大歸一化以促進更快的模型收斂。標準化 nDSM 計算如下:

采用UperNet 作為解碼器框架。通過低層、高層的神經(jīng)通路和橫向連接增強了主干的多尺度特征。所有增強的特征都被上采樣到一定的規(guī)模并隨后融合,作為高度估計的最終特征。此外,在高度分支的末尾添加了一個額外的 1 通道卷積層和一個 Sigmoid 層進行最后的激活。

3.1.2 輔助分支-建筑高度層級分割

為了提高高度估計的準確性,在網(wǎng)絡(luò)中加入了一個額外的高度分層分割分支。在此分支中,使用與高度估計分支相同的 UPerNet 解碼器。然而,融合特征只需要一個 n 通道卷積層,其中 n 等于高度層次的數(shù)量。我們將 nDSM 劃分為幾個離散的高度層級,而不是直接使用僅具有單個類的實例分割標簽,這有助于通過不同的高度層級加強模型的特征提取能力。通過分析nDSM的分布并使用聚類算法,將nDSM分為n類作為建筑高度層級的類別標簽, 這些離散的類別標簽用于指導建筑物高度的估計,解決了通用方法中與nDSM對齊的語義標簽不足的問題。

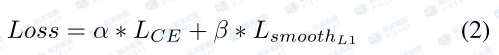

3.1.3 加權(quán)損失函數(shù)

建筑高度層級分割分支是一個n分類的學習,使用交叉熵(CE)損失,而高度分支是一個像素級的回歸分支,所以使用SmoothL1損失,由于兩個損失的量級不同,在兩個分支中應(yīng)用不同的損失權(quán)重。最終損失函數(shù)如下:

3.1.4 高度的校正過程

在訓練中,輔助分支由于與高度估計分支共享主干網(wǎng)絡(luò)、特征,二者通過隱式約束互相促進,但輔助分支作用不至于此。在推理過程,輔助分支還有額外的作用。輔助分支學習的是建筑高度層級的分類結(jié)果,這也就意味著輔助分支分類為0的地方即地面區(qū)域(無高度),于是,利用輔助分支結(jié)果對HGDNet估計的建筑高度進行后處理,將輔助預(yù)測為地面類型的且高度預(yù)測不到一定閾值的高度修正為0。

3.2 實驗結(jié)果

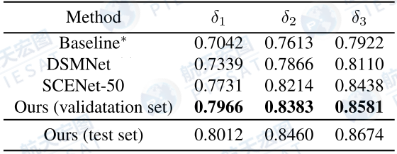

3.2.1 對比實驗

在HGDNet的高度層次分割分支中,建筑物根據(jù)高度分為地面、低、中、高4個層次類別。如表3.1所示,通過與其他模型的對比,在DFC中驗證集上,HGDNet取得了δ1=0.7966的最好結(jié)果,比次優(yōu)的SCENet高0.02。

▲表3.1 DFC 2023賽道2測試集上高度估計的結(jié)果,其中Baseline是官方發(fā)布的基于Deeplabv3的回歸結(jié)果

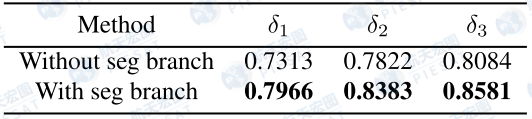

3.2.2 消融實驗

表3.2,3.3分別對HGDNet的分層分割結(jié)果分支和高度特征表征主干網(wǎng)絡(luò)進行了消融實驗,可以發(fā)現(xiàn)ConvNeXtV2 Base是相對最好的特征提取器,尤其是增加了建筑層級分割分支進一步提升了分割精度,同結(jié)構(gòu)下,沒有建筑層級分割分支的模型精度(δ1)要低6個百分點。

▲表3.2 HGDNet增加分層分割結(jié)果的對比實驗

▲表3.3 HGDNet的高度估計特征表征主干網(wǎng)絡(luò)對比實驗

總結(jié)與展望

經(jīng)過大量的實驗,我們利用光學衛(wèi)星圖像作為輸入,采用域自適應(yīng)預(yù)訓練和雙主干特征提取,構(gòu)建了一個魯棒的建筑屋頂實例分割模型。同時,我們提出了一種高度層次引導的雙解碼高度估計網(wǎng)絡(luò)HGDNet用于建筑高度屬性估計。此外,基于我們提出的兩類高性能算法模型,我們可以準確地提取得到建筑物輪廓、類別、高度、地理位置等多種屬性信息,來高效構(gòu)建建筑實體,實現(xiàn)大規(guī)模的城市級三維建模。我們基于單張影像的完成的三維城市規(guī)則化建模結(jié)果如圖4.1,4.2所示。該技術(shù)能夠在城市規(guī)劃、災(zāi)害防護、城市孿生等等多方面應(yīng)用中發(fā)揮重要作用,讓城市實景三維建設(shè)更高效、讓信息更直觀被人所理解。

▲圖4.1. 語義分析成果示意圖

(從左至右:光學衛(wèi)星影像、建筑輪廓、建筑高度估計)

▲圖4.2基于單張衛(wèi)星影像的快速建模video demo

航天宏圖“女媧星座”首發(fā)4顆InSAR衛(wèi)星于2023年3月30日成功發(fā)射。一期工程計劃于2023年至2025年共發(fā)射38顆業(yè)務(wù)星,包括28顆雷達衛(wèi)星組成的雷達遙感星座和10顆光學遙感衛(wèi)星,將提供更豐富、更高分辨率的衛(wèi)星數(shù)據(jù)。本次DFC2023比賽,光學影像與SAR影像之間的錯位和異構(gòu)性給多模數(shù)據(jù)融合帶來了困難。后續(xù),我們將結(jié)合航天宏圖衛(wèi)星數(shù)據(jù)進一步提升建筑屬性估計精度,利用光學影像和SAR數(shù)據(jù)進行多模態(tài)融合更多的探索。

審核編輯:彭菁

-

雷達

+關(guān)注

關(guān)注

50文章

2965瀏覽量

117870 -

遙感

+關(guān)注

關(guān)注

0文章

248瀏覽量

16863 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1209瀏覽量

24793 -

衛(wèi)星數(shù)據(jù)

+關(guān)注

關(guān)注

0文章

10瀏覽量

6858 -

航天宏圖

+關(guān)注

關(guān)注

0文章

101瀏覽量

8550

原文標題:航天宏圖榮獲IEEE 2023國際遙感數(shù)據(jù)融合大賽雙賽道冠軍 | 基于遙感影像的建筑屋頂檢測分類和高度估計

文章出處:【微信號:MzA3MjAyNTI5MQ==,微信公眾號:航天宏圖】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

航天宏圖衛(wèi)星數(shù)據(jù)進一步提升建筑屬性估計精度

航天宏圖衛(wèi)星數(shù)據(jù)進一步提升建筑屬性估計精度

評論