本文提出了 SAN 框架,用于開放詞匯語義分割。該框架成功地利用了凍結(jié)的 CLIP 模型的特征以及端到端的流程,并最大化地采用凍結(jié)的 CLIP 模型。

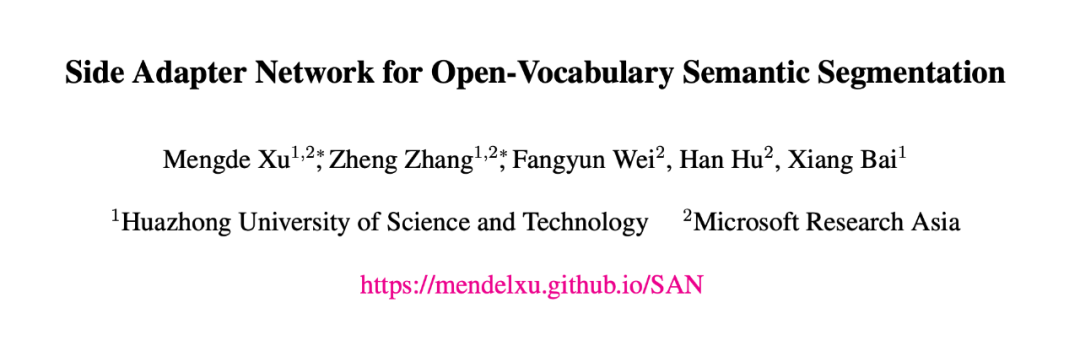

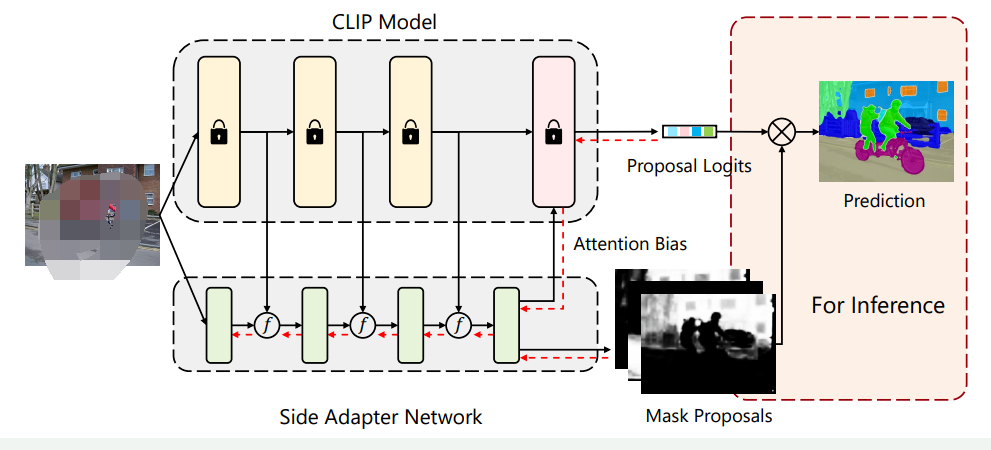

簡介本文介紹了一種名為Side Adapter Network (SAN)的新框架,用于基于預(yù)訓(xùn)練的視覺語言模型進(jìn)行開放式語義分割。該方法將語義分割任務(wù)建模為區(qū)域識別問題,并通過附加一個(gè)側(cè)面的可學(xué)習(xí)網(wǎng)絡(luò)來實(shí)現(xiàn)。該網(wǎng)絡(luò)可以重用CLIP(Contrastive Language-Image Pre-Training)模型的特征,從而使其非常輕便。整個(gè)網(wǎng)絡(luò)可以進(jìn)行端到端的訓(xùn)練,使側(cè)面網(wǎng)絡(luò)適應(yīng)凍結(jié)的CLIP模型,從而使預(yù)測的掩碼提案具有CLIP感知能力。作者在多個(gè)語義分割基準(zhǔn)測試上評估了該方法,并表明其速度快、準(zhǔn)確度高,只增加了少量可訓(xùn)練參數(shù),在一系列數(shù)據(jù)集上相較于之前的SOTA模型取得了大幅的性能提升(如下表所示)最后,作者希望該方法能夠成為一個(gè)baseline,并幫助未來的開放式語義分割研究。

論文鏈接:

https://arxiv.org/abs/2211.08073

?

? ?

?Introduction

作者首先討論了語義分割的概念和現(xiàn)代語義分割方法的限制,以及如何將大規(guī)模視覺語言模型應(yīng)用于開放式語義分割。現(xiàn)代語義分割方法通常依賴于大量標(biāo)記數(shù)據(jù),但數(shù)據(jù)集通常只包含數(shù)十到數(shù)百個(gè)類別,昂貴的數(shù)據(jù)收集和注釋限制了我們進(jìn)一步擴(kuò)展類別的可能性。最近,大規(guī)模視覺語言模型(如CLIP)的出現(xiàn)促進(jìn)了零樣本學(xué)習(xí)的發(fā)展,這也鼓勵(lì)我們探索其在語義分割中的應(yīng)用。然而,將CLIP模型應(yīng)用于開放式語義分割十分困難,因?yàn)镃LIP模型是通過圖像級對比學(xué)習(xí)訓(xùn)練的,其學(xué)習(xí)到的表示缺乏像素級別的識別能力,而這種能力在語義分割中是必需的。解決這個(gè)問題的一個(gè)方法是在分割數(shù)據(jù)集上微調(diào)模型,但是分割數(shù)據(jù)集的數(shù)據(jù)規(guī)模遠(yuǎn)遠(yuǎn)小于視覺語言預(yù)訓(xùn)練數(shù)據(jù)集,因此微調(diào)模型在開放式識別方面的能力通常會受到影響。

為了充分發(fā)揮視覺-語言預(yù)訓(xùn)練模型在開放詞匯語義分割中的能力。作者提出了一種名為Side Adapter Network(SAN)的新框架。由于端到端訓(xùn)練,SAN的掩膜預(yù)測和分類是基于CLIP輔助的。整個(gè)模型十分輕量化。SAN有兩個(gè)分支:一個(gè)用于預(yù)測掩膜,另一個(gè)用于預(yù)測應(yīng)用于CLIP的注意力偏好,以進(jìn)行掩膜類別識別。作者表明,這種分離的設(shè)計(jì)可以提高分割性能。此外,作者還提出了一種單向前設(shè)計(jì),以最小化CLIP的成本:將淺層CLIP塊的特征融合到SAN中,將其他更深層次的塊與注意偏置結(jié)合以進(jìn)行掩膜識別。由于訓(xùn)練是端到端的,SAN可以最大程度地適應(yīng)凍結(jié)的CLIP模型。作者的研究基于官方發(fā)布的ViT CLIP模型,采用Visual Transformer實(shí)現(xiàn)。準(zhǔn)確的語義分割需要高分辨率圖像,但發(fā)布的ViT CLIP模型設(shè)計(jì)用于低分辨率圖像(如),直接應(yīng)用于高分辨率圖像會導(dǎo)致性能下降。為了緩解輸入分辨率的沖突,作者在CLIP模型中使用低分辨率圖像,在SAN中使用高分辨率圖像。作者表明,這種不對稱的輸入分辨率非常有效。此外,作者還探討了僅微調(diào)ViT模型的位置嵌入,并取得了改進(jìn)。作者在各種基準(zhǔn)測試中評估了他們的方法。與之前的方法相比,作者的方法在所有基準(zhǔn)測試中都取得了最好的性能。作者的方法只有8.4M可訓(xùn)練參數(shù)和64.3 GFLOPs。

?Method

?Method

3.1 基礎(chǔ)架構(gòu)

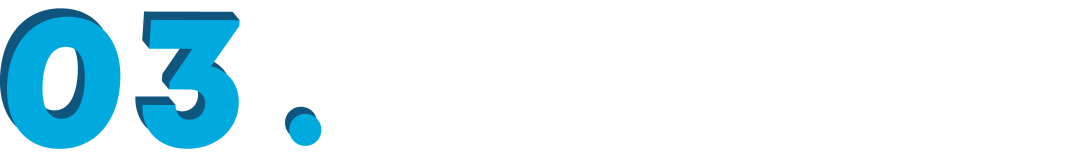

SAN的詳細(xì)架構(gòu)如下圖所示。輸入圖像被分成個(gè)patch。首先通過一個(gè)線性層將圖片轉(zhuǎn)化為Visual Tokens。這些Visual Tokens會與個(gè)可學(xué)習(xí)的Query Tokens拼接起來,并送到后續(xù)的Transformer Layer中。每個(gè)Transformer Layer的Visual Tokens和Query Tokens都添加了position embedding。 示例圖片SAN的輸出由兩部分構(gòu)成:掩膜提議(Mask Proposals)和注意力偏好(Attention Biases)。在掩膜提議中,Query Tokens和Visual Tokens首先通過兩個(gè)單獨(dú)的3層MLP,投影成256維,我們將投影的Query Tokens表示為,其中是Query Tokens的數(shù)量,投影的Visual Tokens表示為,其中和是輸入圖像的高度和寬度。然后,通過和的內(nèi)積生成掩膜:

其中。生成注意力偏好的過程類似于掩膜提議。Query Tokens和Visual Tokens也通過3層MLP進(jìn)行投影,表示為和,其中是CLIP模型的注意頭數(shù)。通過對和進(jìn)行內(nèi)積,我們得到注意力偏好:

其中。此外,如果需要,注意力偏好還將進(jìn)一步調(diào)整為,其中和是CLIP中注意力映射的高度和寬度。在實(shí)踐中,和可以共享,并且注意力偏好將應(yīng)用于CLIP的多個(gè)自注意層,即偏好將在不同的自注意層中使用。這樣的雙輸出設(shè)計(jì)的動機(jī)很直觀:作者認(rèn)為用于在CLIP中識別掩模的感興趣區(qū)域可能與掩模區(qū)域本身不同。作者在后文的對比實(shí)驗(yàn)中也證實(shí)了這個(gè)想法。

示例圖片SAN的輸出由兩部分構(gòu)成:掩膜提議(Mask Proposals)和注意力偏好(Attention Biases)。在掩膜提議中,Query Tokens和Visual Tokens首先通過兩個(gè)單獨(dú)的3層MLP,投影成256維,我們將投影的Query Tokens表示為,其中是Query Tokens的數(shù)量,投影的Visual Tokens表示為,其中和是輸入圖像的高度和寬度。然后,通過和的內(nèi)積生成掩膜:

其中。生成注意力偏好的過程類似于掩膜提議。Query Tokens和Visual Tokens也通過3層MLP進(jìn)行投影,表示為和,其中是CLIP模型的注意頭數(shù)。通過對和進(jìn)行內(nèi)積,我們得到注意力偏好:

其中。此外,如果需要,注意力偏好還將進(jìn)一步調(diào)整為,其中和是CLIP中注意力映射的高度和寬度。在實(shí)踐中,和可以共享,并且注意力偏好將應(yīng)用于CLIP的多個(gè)自注意層,即偏好將在不同的自注意層中使用。這樣的雙輸出設(shè)計(jì)的動機(jī)很直觀:作者認(rèn)為用于在CLIP中識別掩模的感興趣區(qū)域可能與掩模區(qū)域本身不同。作者在后文的對比實(shí)驗(yàn)中也證實(shí)了這個(gè)想法。3.2掩膜預(yù)測

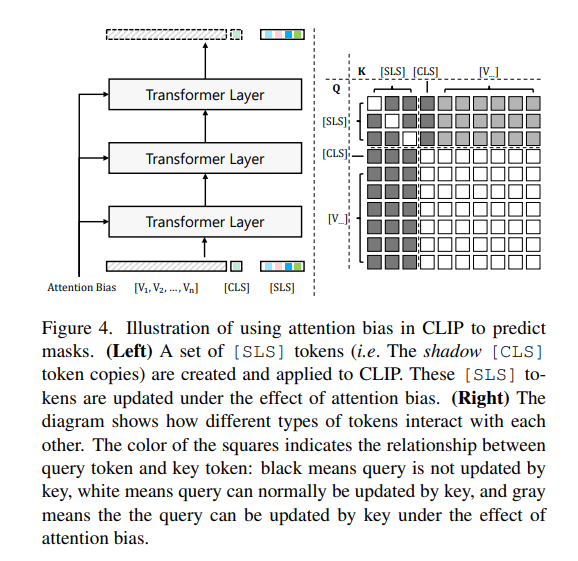

原始的CLIP模型只能通過標(biāo)記進(jìn)行圖像級別的識別。作者工作在不改變CLIP模型參數(shù)的情況下,嘗試通過指導(dǎo)標(biāo)記的注意力圖在感興趣區(qū)域上實(shí)現(xiàn)精確的掩膜識別。為了實(shí)現(xiàn)這個(gè)目標(biāo),作者創(chuàng)建了一組名為標(biāo)記(仿照Maskclip,如下圖)。 這些標(biāo)記單向地通過Visual Tokens進(jìn)行更新,但是Visual Tokens和標(biāo)記都不受的影響。在更新標(biāo)記時(shí),預(yù)測的注意力偏差被添加到注意力矩陣中:

其中表示層編號,表示第個(gè)注意力頭,和是的Query 和Key,是Visual Tokens 的Key。,和分別是Query、Key和Value的編碼權(quán)重。通過注意力偏好,標(biāo)記的特征逐漸演變以適應(yīng)掩膜預(yù)測,并且可以通過比較標(biāo)記和類名CLIP文本編碼之間的距離/相似性來輕松獲得掩膜的類別預(yù)測,表示為,其中是類別數(shù)。

這些標(biāo)記單向地通過Visual Tokens進(jìn)行更新,但是Visual Tokens和標(biāo)記都不受的影響。在更新標(biāo)記時(shí),預(yù)測的注意力偏差被添加到注意力矩陣中:

其中表示層編號,表示第個(gè)注意力頭,和是的Query 和Key,是Visual Tokens 的Key。,和分別是Query、Key和Value的編碼權(quán)重。通過注意力偏好,標(biāo)記的特征逐漸演變以適應(yīng)掩膜預(yù)測,并且可以通過比較標(biāo)記和類名CLIP文本編碼之間的距離/相似性來輕松獲得掩膜的類別預(yù)測,表示為,其中是類別數(shù)。3.3分割結(jié)果生成

使用上文提到的掩膜和類別預(yù)測,我們可以計(jì)算語義分割圖: 其中。這是標(biāo)準(zhǔn)的語義分割輸出,因此與主流的語義分割評估兼容。在訓(xùn)練,我們通過Dice Loss 和binary cross-entropy loss 來監(jiān)督掩膜生成,通過cross-entropy loss 來監(jiān)督掩膜識別。總損失為: 其中作者使用的損失權(quán)重,,分別為5.0,5.0和2.0。通過端到端的訓(xùn)練,SAN可以最大程度地適應(yīng)凍結(jié)的CLIP模型,并得到很好的結(jié)果。 ?

?討論

具體來說,作者提出了一種全新的端到端架構(gòu),以極小的參數(shù)量在多個(gè)數(shù)據(jù)集上取得了SOTA效果。SAN的主要特點(diǎn)如下:

-

SAN中沿用了MaskCLIP得出的結(jié)論:在下游數(shù)據(jù)集上微調(diào)會破壞CLIP優(yōu)秀的特征空間。因此在SAN的設(shè)計(jì)中,無需微調(diào)(fine-tune)CLIP模型,以便最大程度的保持CLIP模型的開放詞匯能力。

-

在凍結(jié)CLIP模型的同時(shí),引入了額外的可編碼網(wǎng)絡(luò),能夠根據(jù)下游任務(wù)數(shù)據(jù)集學(xué)習(xí)分割所需要的特征,彌補(bǔ)了CLIP模型對于位置信息的缺失。

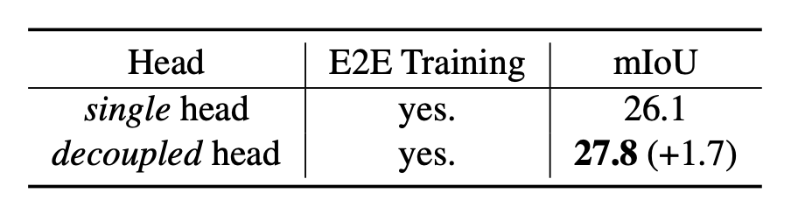

- 將語義分割任務(wù)分解為掩膜預(yù)測與類別預(yù)測兩個(gè)子任務(wù)。CLIP模型的開放識別能力不僅僅依賴于物體區(qū)域本身,也依賴于物體的上下文信息(Context Information)。這促使作者提出掩膜預(yù)測與類別預(yù)測解耦的雙輸出設(shè)計(jì),下表顯示該設(shè)計(jì)可以進(jìn)一步提升模型的預(yù)測精度。

?

?-

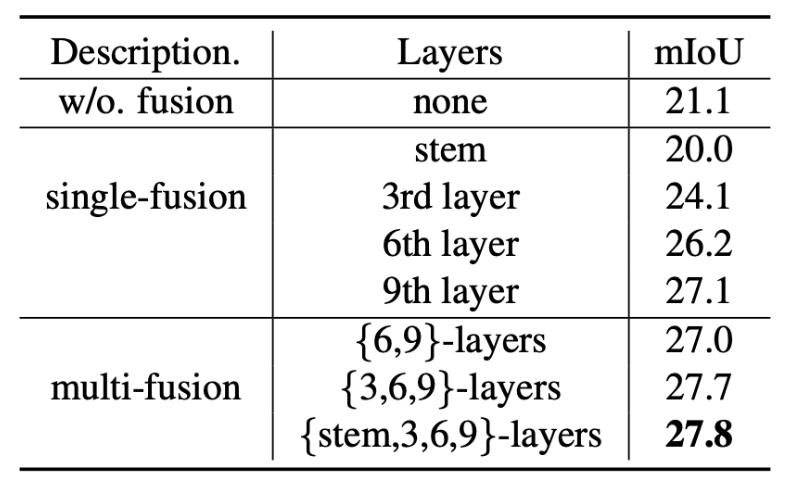

充分復(fù)用了CLIP模型的特征,大幅度降低所需的額外參數(shù)量的同時(shí)獲得最佳性能。下表展示了復(fù)用CLIP特征帶來的性能增益。

?

?

?

? ?結(jié)論作者在這項(xiàng)工作中提出了SAN框架,用于開放詞匯語義分割。該框架成功地利用了凍結(jié)的CLIP模型的特征以及端到端的流程,并最大化地采用凍結(jié)的CLIP模型。所提出的框架在五個(gè)語義分割基準(zhǔn)測試中顯著優(yōu)于以往的最先進(jìn)方法,而且具有更少的可訓(xùn)練參數(shù)和更少的計(jì)算成本。

·

?結(jié)論作者在這項(xiàng)工作中提出了SAN框架,用于開放詞匯語義分割。該框架成功地利用了凍結(jié)的CLIP模型的特征以及端到端的流程,并最大化地采用凍結(jié)的CLIP模型。所提出的框架在五個(gè)語義分割基準(zhǔn)測試中顯著優(yōu)于以往的最先進(jìn)方法,而且具有更少的可訓(xùn)練參數(shù)和更少的計(jì)算成本。

·

原文標(biāo)題:CVPR 2023 | 華科&MSRA新作:基于CLIP的輕量級開放詞匯語義分割架構(gòu)

文章出處:【微信公眾號:智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2916文章

45251瀏覽量

380404

原文標(biāo)題:CVPR 2023 | 華科&MSRA新作:基于CLIP的輕量級開放詞匯語義分割架構(gòu)

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

凌科電氣YU系列工業(yè)級連接器登場,解鎖USB&Type-C多模塊新體驗(yàn)!

新品 | 可拼接燈板矩陣 Puzzle Unit & 創(chuàng)意固定套件CLIP-A/CLIP-B

北美運(yùn)營商AT&amp;amp;T認(rèn)證的費(fèi)用受哪些因素影響

onsemi LV/MV MOSFET 產(chǎn)品介紹 &amp;amp; 行業(yè)應(yīng)用

輕量級多級菜單控制框架

國產(chǎn)芯上運(yùn)行TinyMaxi輕量級的神經(jīng)網(wǎng)絡(luò)推理庫-米爾基于芯馳D9國產(chǎn)商顯板

國產(chǎn)芯上運(yùn)行TinyMaxi輕量級的神經(jīng)網(wǎng)絡(luò)推理庫-米爾基于芯馳D9國產(chǎn)商顯板

圖像語義分割的實(shí)用性是什么

圖像分割和語義分割的區(qū)別與聯(lián)系

FS201資料(pcb &amp; DEMO &amp; 原理圖)

圖像分割與語義分割中的CNN模型綜述

解讀北美運(yùn)營商,AT&amp;amp;T的認(rèn)證分類與認(rèn)證內(nèi)容分享

未來輕量級深度學(xué)習(xí)技術(shù)探索

CVPR 2023 | 華科&MSRA新作:基于CLIP的輕量級開放詞匯語義分割架構(gòu)

CVPR 2023 | 華科&MSRA新作:基于CLIP的輕量級開放詞匯語義分割架構(gòu)

評論