1.

引言

由于構(gòu)建任務(wù)型對話數(shù)據(jù)集的成本較高,目前任務(wù)型對話的研究主要集中在少數(shù)流行語言上(如英語和中文)。為了降低新語言的數(shù)據(jù)采集成本,我們通過結(jié)合純?nèi)斯しg和人工編輯機(jī)器翻譯結(jié)果的方式創(chuàng)建了一個新的多語言基準(zhǔn)——X-RiSAWOZ,該數(shù)據(jù)集將中文RiSAWOZ翻譯成4種語言:英語、法語、印地語、韓語,以及1種語碼混合場景(印地語-英語混合)。X-RiSAWOZ中每種語言都有超過18,000個經(jīng)過人類驗(yàn)證的對話語句,與之前大多數(shù)多語言工作不同的是,它是一個端到端的數(shù)據(jù)集,可用于建立功能齊全的對話代理。除數(shù)據(jù)集外,我們還構(gòu)建了標(biāo)注和處理工具,使得向現(xiàn)有數(shù)據(jù)集中添加新語言變得更快、更經(jīng)濟(jì)。

2.

數(shù)據(jù)集介紹

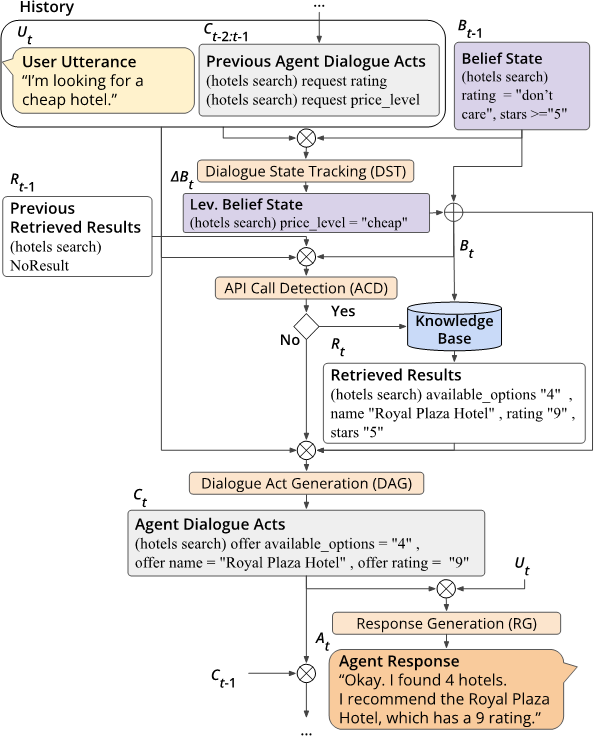

任務(wù)定義:端到端任務(wù)型對話通常被分解為若干子任務(wù),這些任務(wù)可以由流水線系統(tǒng)或單個神經(jīng)網(wǎng)絡(luò)執(zhí)行。下圖展示了這些子任務(wù)及其輸入和輸出:

圖1:端到端任務(wù)型對話流程

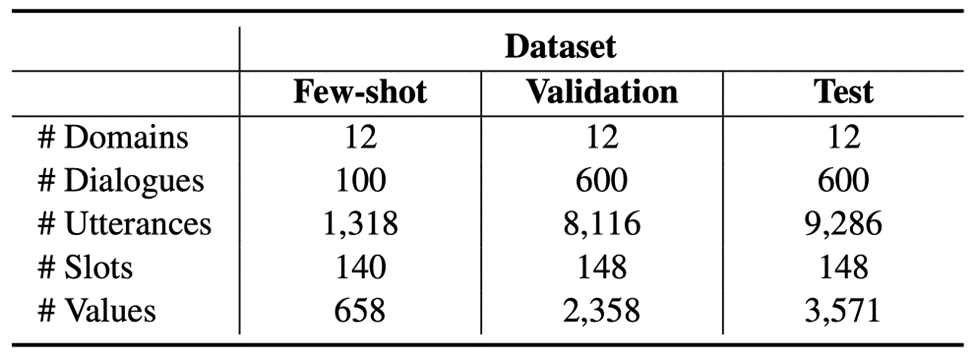

數(shù)據(jù)來源:我們翻譯了RiSAWOZ數(shù)據(jù)集的驗(yàn)證集與測試集,同時為了促進(jìn)少樣本對話系統(tǒng)的研究,我們還隨機(jī)選取了1%的訓(xùn)練集進(jìn)行翻譯,統(tǒng)計數(shù)據(jù)如下表所示:

圖2:X-RiSAWOZ數(shù)據(jù)集統(tǒng)計

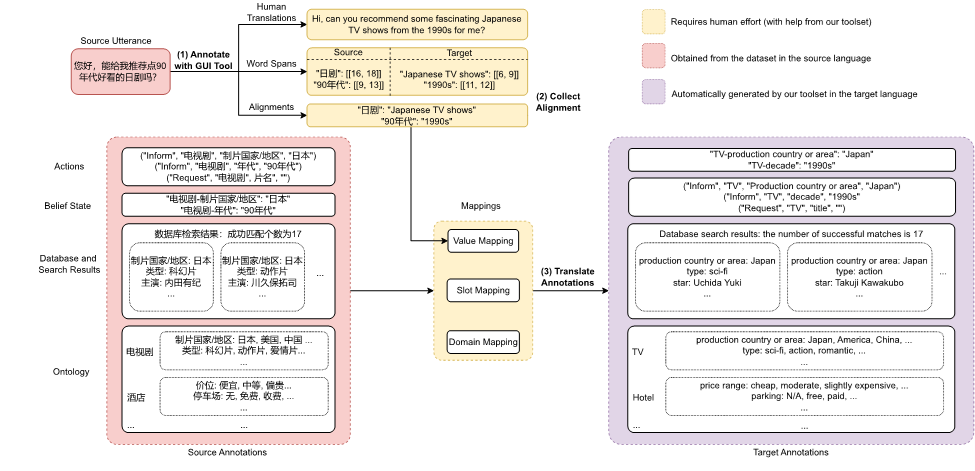

數(shù)據(jù)集構(gòu)建方案:為了實(shí)現(xiàn)低成本和高質(zhì)量的多語言端到端任務(wù)型對話數(shù)據(jù)構(gòu)建,我們使用以下幾種技術(shù)從源語言數(shù)據(jù)(中文RiSAWOZ數(shù)據(jù)集)創(chuàng)建目標(biāo)語言的訓(xùn)練數(shù)據(jù):

1. 翻譯:為了在質(zhì)量和成本之間取得平衡,我們使用純?nèi)斯しg從中文翻譯成英文,并使用機(jī)器翻譯和后期編輯將英語數(shù)據(jù)翻譯成其他語言,以盡可能避免兩次翻譯過程中可能的錯誤傳播。

2. 對齊:我們提出了一種混合對齊策略,以確保實(shí)體在話語和信念狀態(tài)中都能被替換為所需的翻譯。具體而言,我們首先嘗試使用基于實(shí)體標(biāo)注構(gòu)建的字典對齊,如果輸出中沒有匹配的翻譯,則退回到神經(jīng)對齊(即使用encoder-decoder cross-attention權(quán)重匹配源語言和目標(biāo)語言中相對應(yīng)的實(shí)體)。

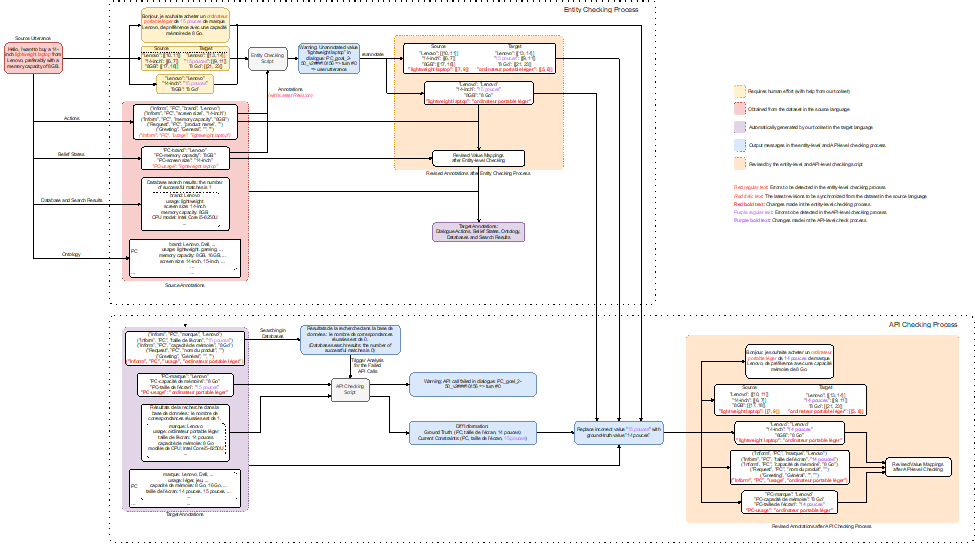

3. 自動標(biāo)注檢查:我們開發(fā)了一個標(biāo)注檢查器來自動標(biāo)記和糾正可能存在的錯誤,包括1)實(shí)體檢查階段——確保在實(shí)體的英語翻譯中所做的更改傳播到其他目標(biāo)語言的翻譯,以及2)API檢查階段——通過將翻譯后API調(diào)用的結(jié)果與提供的真實(shí)值進(jìn)行比較來檢查API的一致性。

數(shù)據(jù)構(gòu)建與檢查的流程如下圖所示:

圖3:數(shù)據(jù)集構(gòu)建流程(以漢語到英語為例)

圖4:數(shù)據(jù)集檢查流程(以漢語到法語為例)

3.

實(shí)驗(yàn)結(jié)果

我們使用了mBART和m2m100 (for Korean only) 進(jìn)行實(shí)驗(yàn)。對于零樣本實(shí)驗(yàn),我們不使用任何人工創(chuàng)建的目標(biāo)語言數(shù)據(jù),只使用基于機(jī)器翻譯自動創(chuàng)建訓(xùn)練數(shù)據(jù)。對于少樣本實(shí)驗(yàn),我們從零樣本模型開始,并在目標(biāo)語言的少樣本數(shù)據(jù)集上進(jìn)一步對其進(jìn)行微調(diào)。實(shí)驗(yàn)的評估方式有兩種:Turn by Turn Evaluation和Full Conversation Evaluation。

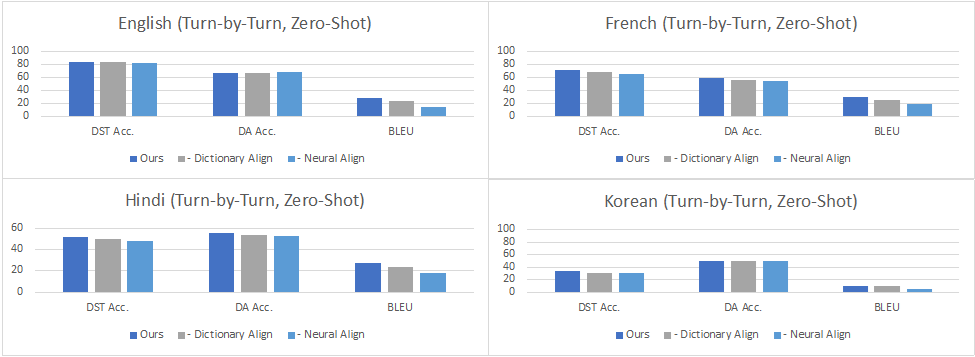

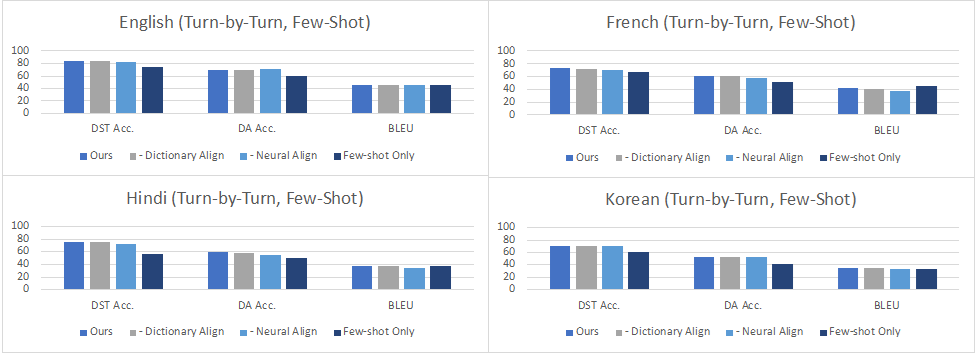

Turn by Turn Evaluation:在這種設(shè)定下,我們在評估中使用所有先前輪次和子任務(wù)的ground truth數(shù)據(jù)作為輸入。結(jié)果表明,在零樣本設(shè)置中,性能因添加的語言而異,各個語言在對話狀態(tài)追蹤 (DST)達(dá)到了34.6%-84.2%的準(zhǔn)確率,在對話動作生成 (DA)上達(dá)到了42.8%-67.3%的準(zhǔn)確率,而在回復(fù)生成 (RG)上達(dá)到10.2-29.9的BLEU值,這意味著零樣本任務(wù)型對話在低資源語言場景下仍然是極具挑戰(zhàn)的任務(wù)。在少樣本數(shù)據(jù)上進(jìn)行微調(diào)可以改善所有語言的所有指標(biāo),其中DST提高到60.7%-84.6%,DA提高到38.0%-70.5%,而BLEU則提高到了28.5-46.4。從下圖的數(shù)據(jù)中可以看到,在印地語、韓語和英語-印地語中,DST的改進(jìn)尤其明顯,因?yàn)樵谶@些語言中,機(jī)器翻譯的質(zhì)量可能不太好。盡管如此,將自動翻譯的數(shù)據(jù)添加到訓(xùn)練中也能夠大大提高這些語言上任務(wù)型對話系統(tǒng)的準(zhǔn)確性,超過了僅用少量人工構(gòu)建數(shù)據(jù)訓(xùn)練的效果。

圖5:零樣本Turn by Turn Evaluation的結(jié)果

圖6:少樣本Turn by Turn Evaluation的結(jié)果

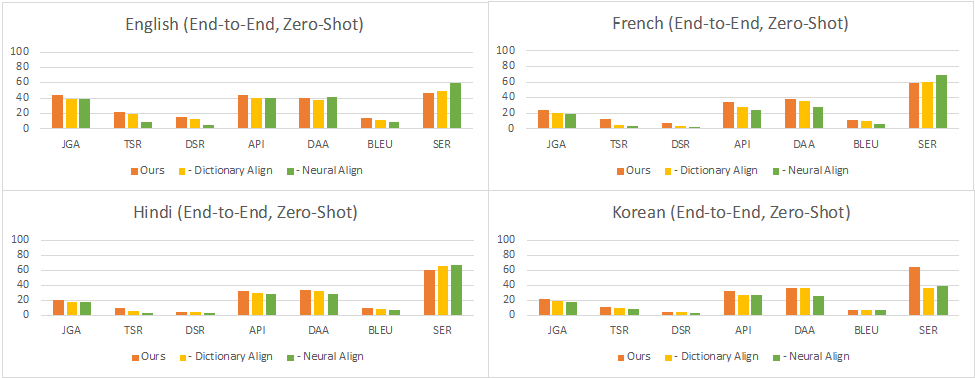

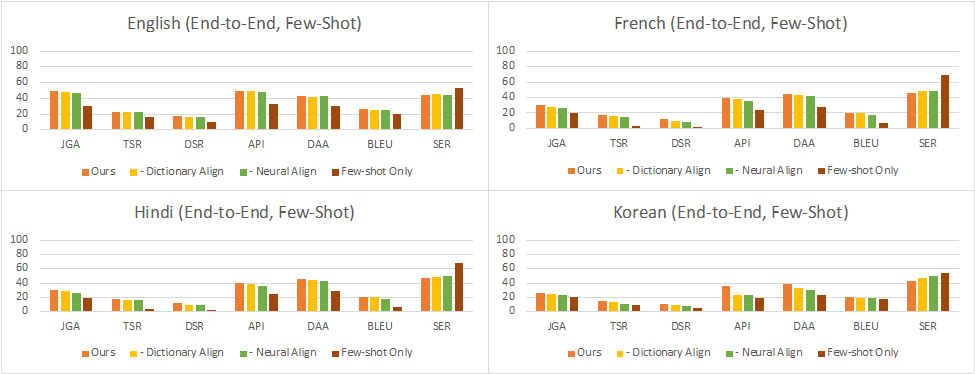

Full Conversation Evaluation:在這種設(shè)定下,對于每個輪次,模型從上一個子任務(wù)的輸出中獲取輸入,用于下一個子任務(wù)。這反映了與用戶進(jìn)行交互式對話時的實(shí)際情況。結(jié)果顯示,在零樣本設(shè)置中,性能同樣因語言而異,其中英語、法語、印地語、韓語和英語-印地語的對話成功率分別達(dá)到了使用完整數(shù)據(jù)訓(xùn)練的中文對話模型的35%、16%、9%、11%和4%。在少-shot設(shè)置中,這個比率提高到了38%、26%、25%、23%和5%。可以看到,最小和最大的改進(jìn)分別在英語和印地語數(shù)據(jù)集上。這表明,當(dāng)預(yù)訓(xùn)練數(shù)據(jù)的質(zhì)量較低時,少樣本數(shù)據(jù)的影響更大,這可能與中文和目標(biāo)語言之間的翻譯模型的質(zhì)量有關(guān)。

圖7:零樣本full conversation evaluation的結(jié)果

圖8:少樣本full conversation evaluation的結(jié)果

4.

結(jié)語

我們構(gòu)建了X-RiSAWOZ,這是一個新的端到端、高質(zhì)量、大規(guī)模的多領(lǐng)域多語種對話數(shù)據(jù)集,其涵蓋了5種不同的語言和1種語碼混合場景,以及一個工具包,以便將數(shù)據(jù)翻譯成其他語言。我們還為跨語言遷移的零/少樣本對話系統(tǒng)提供了強(qiáng)大的基線系統(tǒng)。總體而言,我們的工作為更高效、更具成本效益的多語言任務(wù)型對話系統(tǒng)的開發(fā)鋪平了道路。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101048 -

機(jī)器翻譯

+關(guān)注

關(guān)注

0文章

139瀏覽量

14922 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1209瀏覽量

24793

原文標(biāo)題:開源數(shù)據(jù) | X-RiSAWOZ: 高質(zhì)量端到端多語言任務(wù)型對話數(shù)據(jù)集

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

X-RiSAWOZ: 高質(zhì)量端到端多語言任務(wù)型對話數(shù)據(jù)集

X-RiSAWOZ: 高質(zhì)量端到端多語言任務(wù)型對話數(shù)據(jù)集

評論