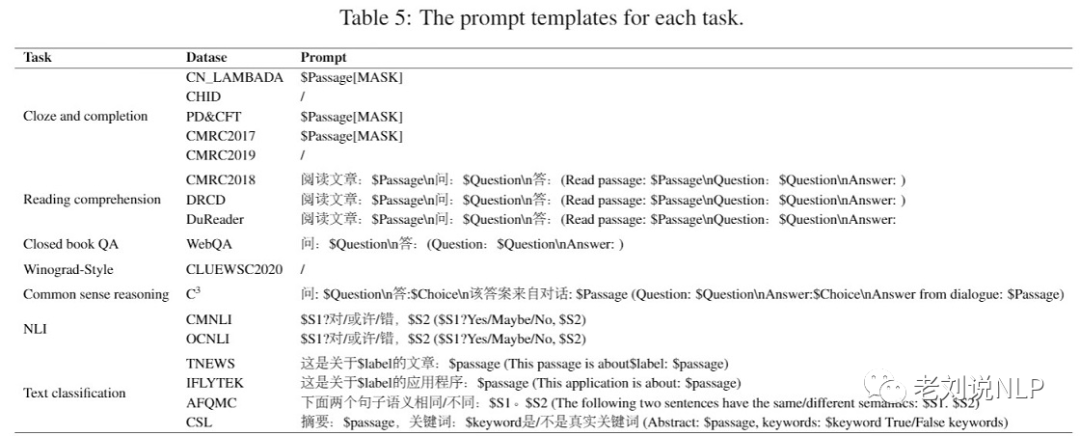

在大模型開發過程中,如何利用下游任務對已有模型進行反饋十分重要,這關系到小模型的快速迭代評估。例如,為了評估模型性能,鵬程·盤古α團隊收集了16個不同類型的中文下游任務,

本文主要介紹ZeroCLUE/FewCLUE數據集、中文長下文詞語預測 (Chinese WPLC)數據集幾個下游任務數據集,供大家參考。

一、ZeroCLUE/FewCLUE數據集

零樣本學習是AI識別方法之一。簡單來說就是識別從未見過的數據類別,即訓練的分類器不僅僅能夠識別出訓練集中已有的數據類別, 還可以對于來自未見過的類別的數據進行區分。小樣本學習(Few-shot Learning)是解決在極少數據情況下的機器學習問題展開的評測。

地址:https://github.com/CLUEbenchmark/ZeroCLUE 地址:https://github.com/CLUEbenchmark/FewCLUE

其中:

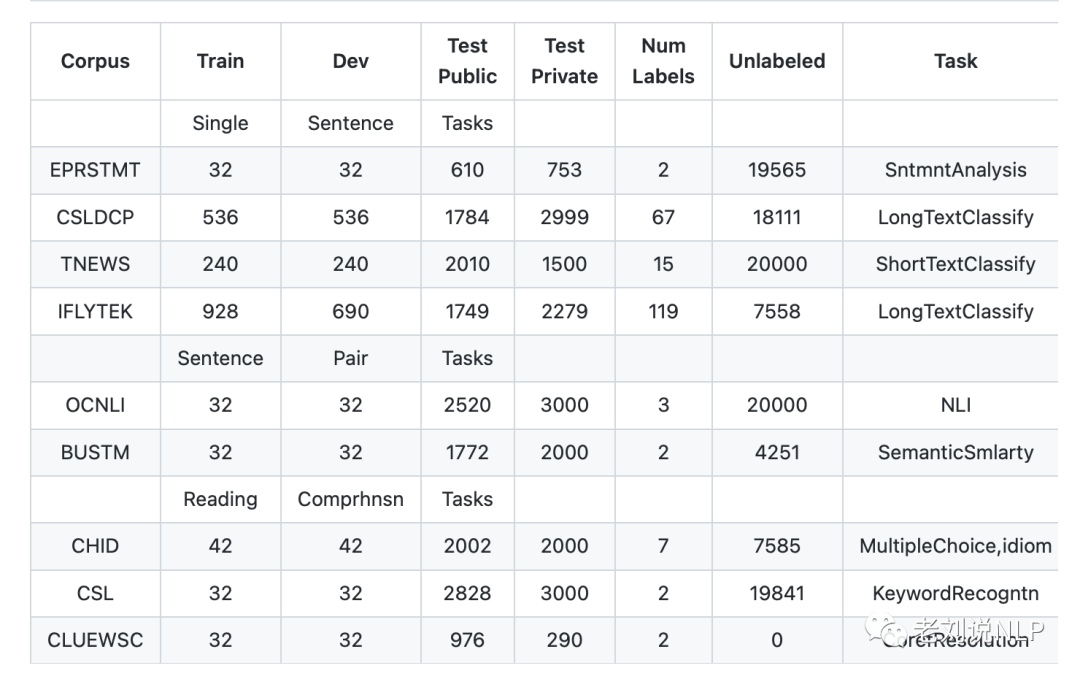

1、EPRSTMT:電商評論情感分析

數據量:訓練集(32),驗證集(32),公開測試集(610),測試集(753),無標簽語料(19565)

例子:

{"id":23,"sentence":"外包裝上有點磨損,試聽后感覺不錯","label":"Positive"}

每一條數據有三個屬性,從前往后分別是 id,sentence,label。其中label標簽,Positive 表示正向,Negative 表示負向。

2、CSLDCP:科學文獻學科分類

中文科學文獻學科分類數據集,包括67個類別的文獻類別,這些類別來自于分別歸屬于13個大類,范圍從社會科學到自然科學,文本為文獻的中文摘要。

數據量:訓練集(536),驗證集(536),公開測試集(1784),測試集(2999),無標簽語料(67)

例子:

{"content":"通過幾年的觀察和實踐,初步掌握了盆栽菊花的栽培技術及方法,并進行了總結,以滿足人們對花卉消費的需求,提高觀賞植物的商品價值,為企業化生產的盆菊提供技術指導。",

"label":"園藝學","id":1770}

{"content":"GPS衛星導航定位精度的高低很大程度上取決于站星距離(即偽距)的測量誤差.載波相位平滑偽距在保證環路參數滿足動態應力誤差要求的基礎上。。。本文詳細論述了載波相位平滑偽距的原理和工程實現方法,并進行了仿真驗證.",

"label":"航空宇航科學與技術","id":979}

每一條數據有三個屬性,從前往后分別是 id,sentence,label。其中label標簽,Positive 表示正向,Negative 表示負向。

3、TNEWS:新聞分類

該數據集來自今日頭條的新聞版塊,共提取了15個類別的新聞,包括旅游、教育、金融、軍事等。

例子:

{"label":"102","label_des":"news_entertainment","sentence":"江疏影甜甜圈自拍,迷之角度竟這么好看,美吸引一切事物"}

每一條數據有三個屬性,從前往后分別是分類ID,分類名稱,新聞字符串(僅含標題)。

4、IFLYTEK:APP應用描述主題分類

該數據集關于app應用描述的長文本標注數據,包含和日常生活相關的各類應用主題,共119個類別:"打車":0,"地圖導航":1,"免費WIFI":2,"租車":3,….,"女性":115,"經營":116,"收款":117,"其他":118(分別用0-118表示)。

例子:

{"label":"110","label_des":"社區超市","sentence":"樸樸快送超市創立于2016年,專注于打造移動端30分鐘即時配送一站式購物平臺,商品品類包含水果、蔬菜、肉禽蛋奶、海鮮水產、糧油調味、酒水飲料、休閑食品、日用品、外賣等。樸樸公司希望能以全新的商業模式,更高效快捷的倉儲配送模式,致力于成為更快、更好、更多、更省的在線零售平臺,帶給消費者更好的消費體驗,同時推動中國食品安全進程,成為一家讓社會尊敬的互聯網公司。,樸樸一下,又好又快,1.配送時間提示更加清晰友好2.保障用戶隱私的一些優化3.其他提高使用體驗的調整4.修復了一些已知bug"}

每一條數據有三個屬性,從前往后分別是類別ID,類別名稱,文本內容。

5、OCNLI: 自然語言推理

OCNLI,即原生中文自然語言推理數據集,是第一個非翻譯的、使用原生漢語的大型中文自然語言推理數據集。

數據量:訓練集(32),驗證集(32),公開測試集(2520),測試集(3000),無標簽語料(20000)

例子:

{

"level":"medium",

"sentence1":"身上裹一件工廠發的棉大衣,手插在袖筒里",

"sentence2":"身上至少一件衣服",

"label":"entailment","label0":"entailment","label1":"entailment","label2":"entailment","label3":"entailment","label4":"entailment",

"genre":"lit","prem_id":"lit_635","id":0

}

6、BUSTM: 對話短文本匹配

對話短文本語義匹配數據集,源于小布助手。它是OPPO為品牌手機和IoT設備自研的語音助手,為用戶提供便捷對話式服務。

意圖識別是對話系統中的一個核心任務,而對話短文本語義匹配是意圖識別的主流算法方案之一。要求根據短文本query-pair,預測它們是否屬于同一語義。

數據量:訓練集(32),驗證集(32),公開測試集(1772),測試集(2000),無標簽語料(4251)

例子:

{"id":5,"sentence1":"女孩子到底是不是你","sentence2":"你不是女孩子嗎","label":"1"}

{"id":18,"sentence1":"小影,你說話慢了","sentence2":"那你說慢一點","label":"0"}

7、CHID:成語閱讀理解

以成語完形填空形式實現,文中多處成語被mask,候選項中包含了近義的成語。https://arxiv.org/abs/1906.01265

數據量:訓練集(42),驗證集(42),公開測試集(2002),測試集(2000),無標簽語料(7585)

例子:

{"id":1421,"candidates":["巧言令色","措手不及","風流人物","八仙過海","平鋪直敘","草木皆兵","言行一致"],

"content":"當廣州憾負北控,郭士強黯然退場那一刻,CBA季后賽懸念仿佛一下就消失了,可萬萬沒想到,就在時隔1天后,北控外援約瑟夫-楊因個人裁決案(拖欠上一家經紀公司的費用),

導致被禁賽,打了馬布里一個#idiom#,加上郭士強帶領廣州神奇逆轉天津,讓...","answer":1}

8、CSL:摘要判斷關鍵詞判別

中文科技文獻數據集(CSL)取自中文論文摘要及其關鍵詞,論文選自部分中文社會科學和自然科學核心期刊,任務目標是根據摘要判斷關鍵詞是否全部為真實關鍵詞(真實為1,偽造為0)。

數據量:訓練集(32),驗證集(32),公開測試集(2828),測試集(3000),無標簽語料(19841)

例子:

{"id":1,"abst":"為解決傳統均勻FFT波束形成算法引起的3維聲吶成像分辨率降低的問題,該文提出分區域FFT波束形成算法.遠場條件下,

以保證成像分辨率為約束條件,以劃分數量最少為目標,采用遺傳算法作為優化手段將成像區域劃分為多個區域.在每個區域內選取一個波束方向,

獲得每一個接收陣元收到該方向回波時的解調輸出,以此為原始數據在該區域內進行傳統均勻FFT波束形成.對FFT計算過程進行優化,降低新算法的計算量,

使其滿足3維成像聲吶實時性的要求.仿真與實驗結果表明,采用分區域FFT波束形成算法的成像分辨率較傳統均勻FFT波束形成算法有顯著提高,且滿足實時性要求.",

"keyword":["水聲學","FFT","波束形成","3維成像聲吶"],"label":"1"}

每一條數據有四個屬性,從前往后分別是數據ID,論文摘要,關鍵詞,真假標簽。

9、CLUEWSC: 代詞消歧

Winograd Scheme Challenge(WSC)是一類代詞消歧的任務,即判斷句子中的代詞指代的是哪個名詞。題目以真假判別的方式出現,如:

句子:這時候放在[床]上[枕頭]旁邊的[手機]響了,我感到奇怪,因為欠費已被停機兩個月,現在[它]突然響了。需要判斷“它”指代的是“床”、“枕頭”,還是“手機”?

從中國現當代作家文學作品中抽取,再經語言專家人工挑選、標注。

數據量:訓練集(32),驗證集(32),公開測試集(976),測試集(290),無標簽語料(0)

例子:

{"target":

{"span2_index":37,

"span1_index":5,

"span1_text":"床",

"span2_text":"它"},

"idx":261,

"label":"false",

"text":"這時候放在床上枕頭旁邊的手機響了,我感到奇怪,因為欠費已被停機兩個月,現在它突然響了。"}

"true"表示代詞確實是指代span1_text中的名詞的,"false"代表不是。

二、中文長下文詞語預測 (Chinese WPLC)數據集

Chinese Word Prediction with Long Context (Chinese WPLC) 是天津大學聯合鵬城實驗室在小說上建立的依賴長上下文預測目標單詞的中文數據集,創建目的是為了評測模型建模長文本的能力。

數據集地址:https://openi.pcl.ac.cn/PCL-Platform.Intelligence/Chinese_WPLC

下面是文獻3網站對該數據集的描述:??

該數據集在給定前文的條件下,測試機器預測目標句子最后一個單詞的能力,選擇的上下文、目標句子及待預測單詞滿足以下條件:當給定完整語境時待預測單詞很容易被猜測出來,當只給最后一個句子時,難以被猜測出來。我們希望通過這個數據集檢測模型在長上下文上提取信息的能力。例如:

上下文:隨后他立即想到自己為什么如此氣憤——他之所以氣憤,是因為他害怕了。在他個人處于巨大危險的情況下,貝思拋棄了他。在海底深處只剩下他們三個人,他們互相需要——他們得互相依靠。

目標句:然而貝思不可信賴,這使他感到害怕,而且

目標詞:氣憤

在上述的例子中,目標詞 “氣憤“ 能夠通過上下文和目標句推測出來,而單靠目標句,很難被猜測出來。

1、數據采集與構建流程

Step1)數據收集

Chinese WPLC數據集來自網絡爬取的小說,涵蓋玄幻、言情、武俠、偵探、懸疑等類型,總量超過6萬部。將重復的小說、公開讀本(世界名著、文學名著、古典名著等)以及敏感詞比例超5%的小說過濾后,剩余小說按照2:1:1的比例隨機劃分為訓練集、測試集和驗證集。

Step2)段落抽取

使用pkuseg對分句后的測試集和驗證集小說段落進行分詞,以段落最后一句為終點句子,在終點句子之前,往前累計總詞數大于50的最少完整句子集合抽取出來作為上下文,并進一步將終點句子最后一個詞作為待預測單詞,終點句子剩余部分構成目標句子。上下文、目標句子、待預測單詞共同組成一個上下文段落。抽取上下文段落需滿足以下條件:

目標詞不是停用詞。

目標詞在訓練集語料中詞頻大于5。

pkuseg、jieba[2]、thulac[3]三種分詞工具切分出來的目標詞一致。

目標句子包含至少10個詞。

每本小說最多抽取200個上下文段落。

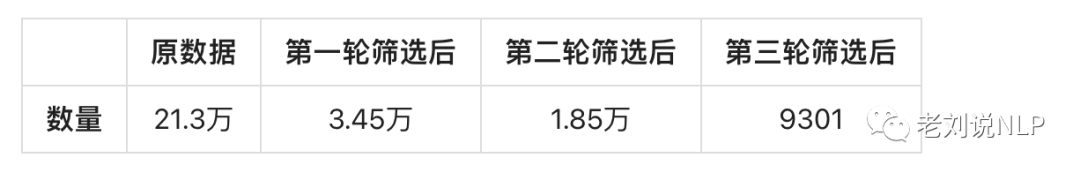

僅當條件1不滿足時,可將停用詞前一個詞作為目標詞進行上述2-5條件檢測,其余情況,將上下文段落拋棄。最終抽取出210萬個段落。

Step3)段落過濾

為減少數據集構建時間,需過濾掉相對簡單的段落。使用以下四種組合生成答案候選:

給定目標句子的預訓練NEZHA[4]。

給定目標句子的微調NEZHA。

給定上下文和目標句子的預訓練NEZHA。

給定上下文和目標句子的微調NEZHA。

當待預測單詞出現在任一束搜索策略生成的Top-5個答案候選中時,將該段落拋棄。

為進一步減少人工標注量,在構建數據集過程將待預測單詞困惑度在使用上下文和不使用上下文比值的對數作為指標。優先考慮指標大于1的段落,由此得到21萬個段落。

Step4)人工篩選

將Step3剩余段落經過隨機抽樣后通過100+標注人員進行三輪標注:

在給定完整段落(上下文+目標句)猜測目標詞,猜對后的上下文段落進入下一輪。

給不同標注人員重復第一輪。

給定目標句讓三個不同的標注人員最多猜9個詞,如果目標詞都沒有被猜到,則將該段落加入Chinese WPLC數據集。

第三輪標注中標注人員每人每個段落最多猜測3個詞,以最大限度確保待預測單詞需通過長上下文信息才能推斷出來,而不能通過單個句子進行推斷。雖然第三輪標注能夠確保待預測單詞不能通過局部信息推斷,但是由于標注人員知識存在差異,該流程不能確保第一輪標注段落能被猜對。第二輪標注進一步確保上下文段落可以被猜對。為減少人工標注時間,在標注過程中提示標注人員待預測詞的長度(字數)。

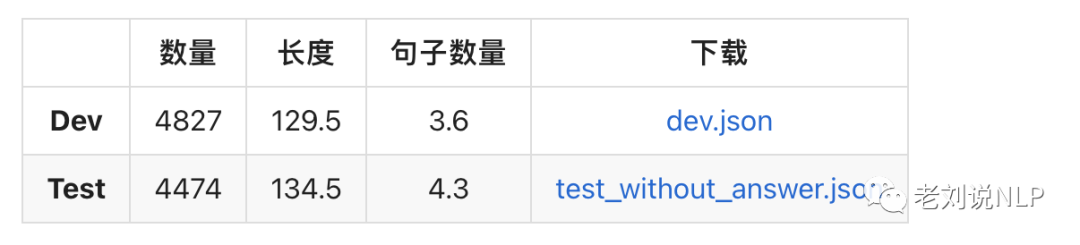

2、數據統計分析與樣例

經過第一輪后,只有14-17%的數據能進入下一輪,在第二輪中的數據中,有50%-60%的數據能進入第三輪。在第三輪標注中,只有60%的數據能夠構成最后的Chinese WPLC數據集。

1)數據統計

數據統計如表1所示:

Chinese WPLC數據集每個上下文段落平均由3-4個句子構成,平均長度為120個字,如表2所示:

2)數據樣例

數據格式可參考下面兩個樣本數據,每個樣本由2個字段組成,masked_text字段是上下文和目標句子,correct_word是位置上正確的詞,數量代表待預測單詞字數。

{

"masked_text":"隨后他立即想到自己為什么如此氣憤——他之所以氣憤,是因為他害怕了。在他個人處于巨大危險的情況下,貝思拋棄了他。在海底深處只剩下他們三個人,他們互相需要——他們得互相依靠。然而貝思不可信賴,這使他感到害怕,而且。"

{

"masked_text":"鐘將也不躲不閃,只是簡單的凝出一塊雷光盾,只是他的雷光盾卻不像楚毅峰的那樣包裹住整個身體,只有臉盆大小,但是他的雷光盾完全是一塊整體,沒有雷電閃爍,沒有電芒流轉。甚至連一點雷電的痕跡都看不到,就是一聲銀色的堅實!"

總結

本文主要介紹ZeroCLUE/FewCLUE數據集、中文長下文詞語預測 (Chinese WPLC)數據集幾個下游任務數據集,感興趣的可以查看參考文獻進一步處理。

審核編輯 :李倩

-

分類器

+關注

關注

0文章

152瀏覽量

13212 -

語言模型

+關注

關注

0文章

538瀏覽量

10315 -

數據集

+關注

關注

4文章

1209瀏覽量

24793

原文標題:語言模型性能評估必備下游數據集:ZeroCLUE/FewCLUE與Chinese_WPLC數據集

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

請問NanoEdge AI數據集該如何構建?

詳解ChatGPT數據集之謎

大語言模型(LLM)預訓練數據集調研分析

語言模型性能評估必備下游數據集:ZeroCLUE/FewCLUE與Chinese_WPLC數據集

語言模型性能評估必備下游數據集:ZeroCLUE/FewCLUE與Chinese_WPLC數據集

評論