在邊緣擴展堅固的任務關鍵型處理資源的范例正在迅速發展。分解處理現在正在通過高速以太網連接在邊緣實現低延遲、網絡連接的所有內容,從 GPU 服務器到 NVMe 結構存儲設備。

隨著技術的不斷創新,處理和存儲性能呈指數級增長,以滿足數字世界的需求,必須考慮新的計算架構。隨著邊緣環境限制功耗、占用空間和延遲的要求,分解計算資源正在成為構建邊緣處理的新方法。

對于國防和航空航天領域的邊緣計算應用,任務平臺通常需要保持活動時間遠遠超過底層處理組件。考慮到 CPU 制造商(如英特爾)每兩到三年發布一次新一代 x86 服務器級處理器。為了在給定平臺上保持最先進的計算能力,系統集成商采用的默認技術更新方法是使用最新的處理器重新指定新的服務器配置,這意味著每隔幾年更換一次設備機架。

每一代處理器都會推出新的創新,包括 PCIe 帶寬翻倍、更多 PCIe 通道以獲得更好的硬件支持、更快的內存速度和更新的安全功能。然而,每次新的處理刷新都會帶來越來越大的熱挑戰。例如,英特爾服務器級 CPU 的散熱設計功耗 (TDP) 等級在過去四代更新中翻了一番——從 Broadwell 處理器一代的 50 至 145 W 范圍到第三代至強可擴展處理器的當前 105 至 300 W 范圍。因此,將舊服務器與更新的替換服務器交換可能會與有限的功率預算發生沖突。

處理被推到邊緣

盡管存在這些挑戰,但高級計算資源繼續從數據中心轉移到部署的邊緣平臺,從而為雷達信號處理等應用提高效率和新功能。這種高性能邊緣系統必須能夠快速分配和重新分配并行處理資源,以通過各種類型的算法處理來自多個傳感器源的數據流,例如用于人工智能 (AI) 的深度學習/機器學習 (ML) 神經網絡。

為了優化架構,某些計算任務與其他硬件(如圖形處理單元 (GPU))一起分配給傳統 CPU,給定數學密集型任務,其中并行處理非常適合。值得注意的是,GPU已被證明在涉及推理和訓練的計算和數據密集型用例中超過了通用處理器的能力。

一個示例用例是認知雷達,它應用 AI 技術從接收到的返回信號中提取信息,然后使用該信息來改進發射參數,例如頻率、波形形狀和脈沖重復頻率。為了有效,認知雷達必須近乎實時地執行這些人工智能算法。反過來,這需要在處理鏈中使用強大的 GPU。在 NVIDIA 執行的 AI 推理基準測試中,A100 GPU 的性能比 CPU 高出 249 倍。通過將推理和訓練等任務卸載到 GPU,不再需要過度指定 CPU,這反過來又提供了降低 TDP 的機會。

使命需要跟上

將任務從 CPU 卸載到 GPU 所帶來的增量功耗改進加起來,但不足以跟上邊緣環境的需求。在 2022 年 NVIDIA GTC 活動中,洛克希德·馬丁公司副研究員本·盧克(Ben Luke)描述了邊緣功耗、延遲和傳感器數據的這個問題:“現代傳感器的一大挑戰是數據速率不斷提高。..。..還有強烈的愿望移動該處理。..更接近邊緣,這會導致尺寸、重量和功率限制,這些限制正在推動該架構。

盡管技術更新最初可能會由于 CPU 生命周期障礙而出現,但很明顯,通過更新到最新硬件可以獲得固有的優勢。每一代處理都有關鍵的改進,使系統能夠跟上傳感器數據的加速增長,并減輕對手的進步。與Ben Luke的評論直接相關的是硬件提供減少延遲和決策時間的能力。

在關于邊緣計算和人工智能未來的 datacenterHawk 播客中,NVIDIA 解決方案架構總監 Rama Darba 表示:“你不能通過實時在云中做出人工智能或計算決策;存在延遲問題,存在計算挑戰。非最新信息不再與做出明智決策相關。特別是在邊緣,通過以推理為中心的硬件做出實時決策,利用經過訓練的模型,在很大程度上依賴于對低延遲的需求。

分布式處理使能因素

邊緣堅固耐用的數據中心可以通過采用數據處理單元 (DPU) 等硬件立即從分解中受益。DPU,例如NVIDIA Bluefield,有時被描述為智能 NIC [網絡接口卡],具有額外的集成功能,例如 CPU 處理內核、高速數據包處理、內存和高速連接(例如,100 Gb/sec/200 Gb/s 以太網)。這些元素協同工作,使 DPU 能夠執行網絡數據路徑加速引擎的多種功能。

對邊緣應用非常重要的一項功能是能夠使用直接內存訪問 (DMA) 將網絡數據直接饋送到 GPU,而無需系統 CPU 參與。DPU 不僅僅是一個智能網卡,還可以用作獨立的嵌入式處理器,使用 PCIe 交換機架構作為 GPU、NVMe 存儲和其他 PCIe 設備的根或端點運行。這樣做可以改變系統架構:DPU 現在允許在最需要的地方共享 GPU 資源,而不是指定配備 GPU 和通用計算服務器的某種預定組合。

進入分解分布式處理范例

理解從現狀到新啟用的系統架構的范式轉變的一種功能性方法是將數據中心視為整個資源處理池,而不是服務器子集,每個服務器都有專用功能。換句話說,現狀是讓單獨的服務器執行任務 - 一些用于存儲,另一些用于并行處理,另一些用于一般服務。雖然此模型基本上是按功能分解的,但缺少的關鍵要素是這些功能在多個系統中的分布不足。

考慮分布式分解傳感器處理架構的框圖(圖 2)。傳感器數據等關鍵任務信息的并行處理在支持 GPU 的系統上發送和執行,通過高速網絡中繼到 DPU,并共享到任何聯網服務器以采取行動。

[圖2 |框圖顯示了平臺中數據處理單元的用例。

這種架構還可以保持從傳感器到 GPU 再到聯網服務器的端到端低延遲,無論服務器堆棧中的 CPU 代次如何。為了促進這種新架構,Mercury 堅固耐用的分布式處理 1U 服務器等產品分解 GPU 資源,并將見解直接分發到網絡上,而無需獨立的 x86 主機 CPU。(圖 3。

[圖3 |框圖顯示了Mercury堅固耐用的分布式處理服務器的構成。

通過跨網絡分布,可以使用大部分資源。與其在每個系統中指定 GPU 并使用每個 GPU 的一定百分比,可以使用更少的 GPU 并將其分發到更多數量的系統,從而緩解熱增加的趨勢。與使用更少的GPU有關,NVIDIA的Darba將降低成本確定為這種架構的另一個關鍵改進:“最大的優勢之一是,現在,因為你不在你知道你被鎖定的地方,必須在這臺服務器上運行這個應用程序,你實際上可以大大降低服務器成本和服務器大小。

DPU 用例不僅限于 GPU 和并行處理。例如,GPU卡可以是一個驅動器池,聯網并顯示為任何系統的本地存儲。無論是并行處理還是存儲,擁有可用于網絡的資源都可以實現未來的可擴展性,并更新到更新、功能更強大的硬件,而無需對現有系統進行徹底檢修或犧牲功率預算或低延遲。

硬件不僅可以進行分解,還可以實現資源分配,它提供了一個機會,通過創新的系統架構方法,使堅固的任務關鍵型平臺的需求與最新技術保持一致。

審核編輯:郭婷

-

cpu

+關注

關注

68文章

10901瀏覽量

212662 -

服務器

+關注

關注

12文章

9296瀏覽量

85857 -

數據中心

+關注

關注

16文章

4855瀏覽量

72298

發布評論請先 登錄

相關推薦

分布式云化數據庫有哪些類型

基于ptp的分布式系統設計

HarmonyOS Next 應用元服務開發-分布式數據對象遷移數據權限與基礎數據

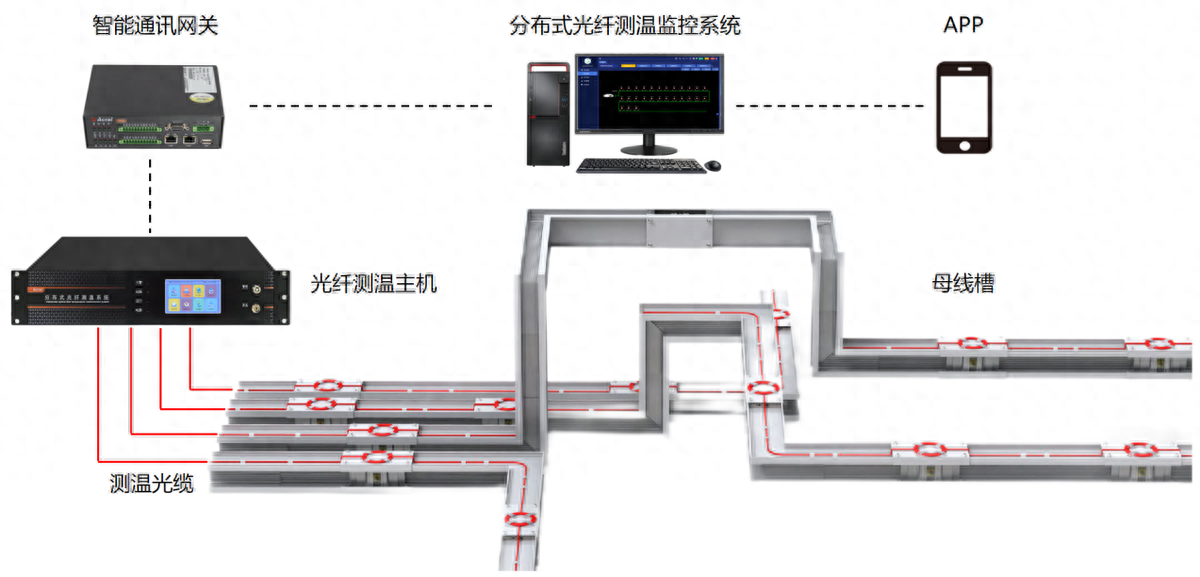

分布式光纖測溫是什么?應用領域是?

分布式輸電線路故障定位中的分布式是指什么

分布式工業物聯網平臺:引領智能制造的新篇章

安科瑞分布式光伏監控系統在鄂爾多斯5MW分布式光伏煤礦項目中的應用

安科瑞分布式光伏監控系統在鄂托克旗巴音烏蘇六保煤礦5MW分布式光伏項目中的應用

鴻蒙開發接口數據管理:【@ohos.data.distributedData (分布式數據管理)】

浪潮信息發布為大模型專門優化的分布式全閃存儲AS13000G7-N系列

分布式光伏監控系統解決方案

通過分布式分解優化邊緣

通過分布式分解優化邊緣

評論