人工智能算法無法以目前的速度保持增長(zhǎng)。像深度神經(jīng)網(wǎng)絡(luò)這樣的算法——它受到大腦的松散啟發(fā),多層人工神經(jīng)元通過稱為權(quán)重的數(shù)值相互連接——每年都在變大。但如今,硬件改進(jìn)已無法跟上運(yùn)行這些海量算法所需的大量?jī)?nèi)存和處理能力。很快,人工智能算法的規(guī)模可能會(huì)碰壁。

即使我們可以不斷擴(kuò)大硬件以滿足人工智能的需求,也存在另一個(gè)問題:在傳統(tǒng)計(jì)算機(jī)上運(yùn)行它們會(huì)浪費(fèi)大量能源。運(yùn)行大型人工智能算法產(chǎn)生的高碳排放已經(jīng)對(duì)環(huán)境有害,而且隨著算法變得越來越龐大,情況只會(huì)變得更糟。

一種稱為神經(jīng)形態(tài)計(jì)算的解決方案從生物大腦中汲取靈感來創(chuàng)建節(jié)能設(shè)計(jì)。不幸的是,雖然這些芯片在節(jié)能方面可以超過數(shù)字計(jì)算機(jī),但它們?nèi)狈\(yùn)行大型深度神經(jīng)網(wǎng)絡(luò)所需的計(jì)算能力。這讓人工智能研究人員很容易忽視它們。

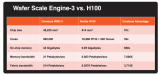

這在 8 月終于改變了,當(dāng)時(shí)Weier Wan , H.-S. Philip Wong、Gert Cauwenberghs和他們的同事展示了一種名為 NeuRRAM 的新型神經(jīng)形態(tài)芯片,其中包括 300 萬個(gè)存儲(chǔ)單元和數(shù)千個(gè)內(nèi)置于其硬件中的神經(jīng)元以運(yùn)行算法。它使用一種相對(duì)較新的內(nèi)存類型,稱為電阻式 RAM 或 RRAM。與以前的 RRAM 芯片不同,NeuRRAM 被編程為以模擬方式運(yùn)行,以節(jié)省更多的能源和空間。雖然數(shù)字存儲(chǔ)器是二進(jìn)制的——存儲(chǔ) 1 或 0——但 NeuRRAM 芯片中的模擬存儲(chǔ)單元可以在一個(gè)完全連續(xù)的范圍內(nèi)存儲(chǔ)多個(gè)值。這使得芯片可以在相同數(shù)量的芯片空間中存儲(chǔ)來自大量 AI 算法的更多信息。

因此,新芯片可以在圖像和語(yǔ)音識(shí)別等復(fù)雜的人工智能任務(wù)上與數(shù)字計(jì)算機(jī)一樣執(zhí)行,作者聲稱它的能效提高了 1000 倍,為微型芯片運(yùn)行越來越復(fù)雜的算法開辟了可能性在以前不適合人工智能的小型設(shè)備中,如智能手表和手機(jī)。

未參與這項(xiàng)工作的研究人員對(duì)結(jié)果印象深刻。“這篇論文非常獨(dú)特,”香港大學(xué)長(zhǎng)期 RRAM 研究員王中瑞說。“它在不同的層面做出了貢獻(xiàn)——在設(shè)備層面、電路架構(gòu)層面和算法層面。”

創(chuàng)造新的記憶

在數(shù)字計(jì)算機(jī)中,運(yùn)行 AI 算法時(shí)浪費(fèi)的大量能源是由一個(gè)簡(jiǎn)單且普遍存在的設(shè)計(jì)缺陷造成的,該缺陷使每一次計(jì)算都效率低下。通常,計(jì)算機(jī)的內(nèi)存——它保存計(jì)算過程中處理的數(shù)據(jù)和數(shù)值——放置在遠(yuǎn)離進(jìn)行計(jì)算的處理器的主板上。

對(duì)于通過處理器傳輸?shù)男畔ⅲ斑@有點(diǎn)像你在通勤上花了八個(gè)小時(shí),但你做了兩個(gè)小時(shí)的工作,”曾在斯坦福大學(xué)工作的計(jì)算機(jī)科學(xué)家萬說,他最近搬到了人工智能初創(chuàng)公司 Aizip。

將內(nèi)存和計(jì)算放在同一個(gè)地方的新型一體化芯片來解決這個(gè)問題似乎很簡(jiǎn)單。它也更接近于我們的大腦可能如何處理信息,因?yàn)樵S多神經(jīng)科學(xué)家認(rèn)為計(jì)算發(fā)生在神經(jīng)元群體中,而記憶是在神經(jīng)元之間的突觸加強(qiáng)或削弱它們的連接時(shí)形成的。但事實(shí)證明,制造這樣的設(shè)備很困難,因?yàn)槟壳暗膬?nèi)存形式與處理器中的技術(shù)不兼容。

幾十年前,計(jì)算機(jī)科學(xué)家開發(fā)了這些材料來制造新的芯片,這些芯片在存儲(chǔ)內(nèi)存的地方執(zhí)行計(jì)算——一種被稱為內(nèi)存計(jì)算的技術(shù)。但由于傳統(tǒng)的數(shù)字計(jì)算機(jī)表現(xiàn)如此出色,這些想法被忽視了幾十年。

“這項(xiàng)工作,就像大多數(shù)科學(xué)工作一樣,被遺忘了,”斯坦福大學(xué)教授 Wong 說。

事實(shí)上,第一個(gè)這樣的設(shè)備至少可以追溯到 1964 年,當(dāng)時(shí)斯坦福大學(xué)的電氣工程師發(fā)現(xiàn)他們可以操縱某些稱為金屬氧化物的材料來打開和關(guān)閉其導(dǎo)電能力。這很重要,因?yàn)椴牧显趦煞N狀態(tài)之間切換的能力為傳統(tǒng)內(nèi)存存儲(chǔ)提供了支柱。通常,在數(shù)字存儲(chǔ)器中,高電壓狀態(tài)對(duì)應(yīng)于 1,低電壓狀態(tài)對(duì)應(yīng)于 0。

為了讓 RRAM 設(shè)備切換狀態(tài),您需要在連接到金屬氧化物兩端的金屬電極上施加電壓。通常,金屬氧化物是絕緣體,這意味著它們不導(dǎo)電。但有了足夠的電壓,電流就會(huì)積聚起來,最終穿過材料的薄弱環(huán)節(jié),形成通往另一側(cè)電極的路徑。一旦電流突破,它就可以沿著該路徑自由流動(dòng)。

Wong 將這個(gè)過程比作閃電:當(dāng)云中積聚了足夠多的電荷時(shí),它會(huì)迅速找到一條低電阻路徑并發(fā)生雷擊。但與路徑消失的閃電不同,穿過金屬氧化物的路徑仍然存在,這意味著它可以無限期地保持導(dǎo)電。并且可以通過向材料施加另一個(gè)電壓來擦除導(dǎo)電路徑。因此研究人員可以在兩種狀態(tài)之間切換 RRAM,并使用它們來存儲(chǔ)數(shù)字存儲(chǔ)器。

世紀(jì)中葉的研究人員沒有認(rèn)識(shí)到節(jié)能計(jì)算的潛力,他們也不需要使用他們正在使用的更小的算法。直到 2000 年代初,隨著新金屬氧化物的發(fā)現(xiàn),研究人員才意識(shí)到這種可能性。

當(dāng)時(shí)在 IBM 工作的 Wong 回憶說,一位從事 RRAM 工作的獲獎(jiǎng)同事承認(rèn),他并不完全了解所涉及的物理原理。“如果他不理解,”Wong 回憶道,“也許我不應(yīng)該嘗試去理解它。”

但在 2004 年,三星電子的研究人員宣布他們已經(jīng)成功地將 RRAM 內(nèi)存集成在傳統(tǒng)計(jì)算芯片之上,這表明內(nèi)存計(jì)算芯片最終可能成為可能。王決定至少嘗試一下。

用于人工智能的內(nèi)存計(jì)算芯片

十多年來,像 Wong 這樣的研究人員一直致力于將 RRAM 技術(shù)構(gòu)建到能夠可靠地處理高性能計(jì)算任務(wù)的地步。大約在 2015 年左右,計(jì)算機(jī)科學(xué)家開始認(rèn)識(shí)到這些節(jié)能設(shè)備對(duì)于大型 AI 算法的巨大潛力,并開始起飛。那一年,加州大學(xué)圣巴巴拉分校的科學(xué)家表明,RRAM 設(shè)備可以做的不僅僅是以一種新的方式存儲(chǔ)內(nèi)存。他們可以自己執(zhí)行基本的計(jì)算任務(wù)——包括在神經(jīng)網(wǎng)絡(luò)的人工神經(jīng)元中發(fā)生的絕大多數(shù)計(jì)算,這些都是簡(jiǎn)單的矩陣乘法任務(wù)。

在 NeuRRAM 芯片中,硅神經(jīng)元內(nèi)置于硬件中,RRAM 存儲(chǔ)單元存儲(chǔ)權(quán)重——代表神經(jīng)元之間連接強(qiáng)度的值。由于 NeuRRAM 存儲(chǔ)單元是模擬的,它們存儲(chǔ)的權(quán)重代表了設(shè)備在低電阻狀態(tài)和高電阻狀態(tài)之間切換時(shí)出現(xiàn)的所有電阻狀態(tài)。這實(shí)現(xiàn)了比數(shù)字 RRAM 存儲(chǔ)器更高的能效,因?yàn)樵撔酒梢圆⑿羞\(yùn)行許多矩陣計(jì)算,而不是像數(shù)字處理版本那樣一個(gè)接一個(gè)地同步運(yùn)行。

但由于模擬處理仍落后于數(shù)字處理數(shù)十年,仍有許多問題需要解決。一是模擬 RRAM 芯片必須異常精確,因?yàn)槲锢硇酒系娜毕輹?huì)引入可變性和噪聲。(對(duì)于只有兩種狀態(tài)的傳統(tǒng)芯片,這些缺陷幾乎沒有那么重要。)這使得模擬 RRAM 設(shè)備運(yùn)行 AI 算法變得更加困難,因?yàn)樽R(shí)別圖像的準(zhǔn)確性會(huì)受到影響,如果RRAM 器件的導(dǎo)電狀態(tài)并非每次都完全相同。

“當(dāng)我們查看照明路徑時(shí),每次都不同,”Wong 說。“因此,RRAM 表現(xiàn)出一定程度的隨機(jī)性——每次對(duì)它們進(jìn)行編程都會(huì)略有不同。” Wong 和他的同事證明,如果對(duì)算法進(jìn)行訓(xùn)練以適應(yīng)芯片上遇到的噪音,RRAM 設(shè)備可以存儲(chǔ)連續(xù)的 AI 權(quán)重,并且仍然與數(shù)字計(jì)算機(jī)一樣準(zhǔn)確,這一進(jìn)步使他們能夠生產(chǎn) NeuRRAM 芯片。

他們必須解決的另一個(gè)主要問題涉及支持各種神經(jīng)網(wǎng)絡(luò)所需的靈活性。過去,芯片設(shè)計(jì)人員必須將微型 RRAM 器件排列在較大的硅神經(jīng)元旁邊的一個(gè)區(qū)域中。RRAM 設(shè)備和神經(jīng)元是硬連線的,沒有可編程性,因此只能在一個(gè)方向上執(zhí)行計(jì)算。為了支持具有雙向計(jì)算的神經(jīng)網(wǎng)絡(luò),需要額外的電線和電路,從而增加了能量和空間需求。

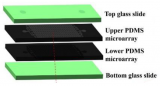

因此,Wong 的團(tuán)隊(duì)設(shè)計(jì)了一種新的芯片架構(gòu),其中 RRAM 存儲(chǔ)設(shè)備和硅神經(jīng)元混合在一起。這種對(duì)設(shè)計(jì)的微小改動(dòng)減少了總面積并節(jié)省了能源。

瑞士蘇黎世聯(lián)邦理工學(xué)院的神經(jīng)形態(tài)學(xué)研究員梅利卡·佩萬德說:“我認(rèn)為 [這種安排] 真的很漂亮。” “我絕對(duì)認(rèn)為這是一項(xiàng)開創(chuàng)性的工作。”

幾年來,Wong 的團(tuán)隊(duì)與合作者一起在 NeuRRAM 芯片上設(shè)計(jì)、制造、測(cè)試、校準(zhǔn)和運(yùn)行 AI 算法。他們確實(shí)考慮使用其他新興類型的內(nèi)存,這些內(nèi)存也可用于內(nèi)存計(jì)算芯片,但 RRAM 具有優(yōu)勢(shì),因?yàn)樗谀M編程方面具有優(yōu)勢(shì),并且相對(duì)容易與傳統(tǒng)計(jì)算材料集成。

他們最近的結(jié)果代表了第一個(gè)可以運(yùn)行如此龐大而復(fù)雜的 AI 算法的 RRAM 芯片——這一壯舉以前只能在理論模擬中實(shí)現(xiàn)。德雷塞爾大學(xué)的計(jì)算機(jī)科學(xué)家Anup Das說:“當(dāng)涉及到真正的硅時(shí),這種能力就缺失了。” “這項(xiàng)工作是第一次演示。”

“數(shù)字人工智能系統(tǒng)靈活而精確,但效率要低幾個(gè)數(shù)量級(jí),”Cauwenberghs 說。現(xiàn)在,Cauwenberghs 說,他們靈活、精確和節(jié)能的模擬 RRAM 芯片“首次彌合了差距”。

擴(kuò)大規(guī)模

該團(tuán)隊(duì)的設(shè)計(jì)使 NeuRRAM 芯片很小——只有指甲大小——同時(shí)壓縮了 300 萬個(gè)可用作模擬處理器的 RRAM 存儲(chǔ)設(shè)備。雖然它至少可以像數(shù)字計(jì)算機(jī)一樣運(yùn)行神經(jīng)網(wǎng)絡(luò),但該芯片也(并且是第一次)可以運(yùn)行在不同方向上執(zhí)行計(jì)算的算法。他們的芯片可以按照 RRAM 芯片的標(biāo)準(zhǔn)向 RRAM 陣列的行輸入電壓并從列讀取輸出,但它也可以從列到行反向執(zhí)行,因此它可以用于運(yùn)行的神經(jīng)網(wǎng)絡(luò)數(shù)據(jù)流向不同的方向。

與 RRAM 技術(shù)本身一樣,這早已成為可能,但沒有人想過這樣做。“為什么我們以前沒有考慮過這個(gè)?” 佩萬德問道。“事后看來,我不知道。”

“這實(shí)際上開辟了許多其他機(jī)會(huì),”達(dá)斯說。作為例子,他提到了一個(gè)簡(jiǎn)單的系統(tǒng)能夠運(yùn)行多維物理模擬或自動(dòng)駕駛汽車所需的大量算法。

然而尺寸是個(gè)問題。最大的神經(jīng)網(wǎng)絡(luò)現(xiàn)在包含數(shù)十億個(gè)權(quán)重,而不是新芯片中包含的數(shù)百萬個(gè)權(quán)重。Wong 計(jì)劃通過堆疊多個(gè) NeuRRAM 芯片來擴(kuò)大規(guī)模。

在未來的設(shè)備中保持較低的能源成本或進(jìn)一步縮小它們同樣重要。實(shí)現(xiàn)這一目標(biāo)的一種方法是更緊密地復(fù)制大腦,以采用真實(shí)神經(jīng)元之間使用的通信信號(hào):電脈沖。這是當(dāng)細(xì)胞內(nèi)外的電壓差達(dá)到臨界閾值時(shí),從一個(gè)神經(jīng)元向另一個(gè)神經(jīng)元發(fā)出的信號(hào)。

“那里面臨著巨大的挑戰(zhàn),”倫敦大學(xué)學(xué)院的納米技術(shù)研究員托尼·肯揚(yáng)說。“但我們可能仍想朝那個(gè)方向發(fā)展,因?yàn)椤绻褂梅浅O∈璧募夥澹赡軙?huì)獲得更高的能源效率。” 然而,Kenyon 指出,要在當(dāng)前的 NeuRRAM 芯片上運(yùn)行峰值算法可能需要完全不同的架構(gòu)。

目前,該團(tuán)隊(duì)在 NeuRRAM 芯片上運(yùn)行大型 AI 算法時(shí)實(shí)現(xiàn)的能源效率創(chuàng)造了新的希望,即內(nèi)存技術(shù)可能代表 AI 計(jì)算的未來。也許有一天,我們甚至能夠匹配人類大腦的 860 億個(gè)神經(jīng)元和連接它們的數(shù)萬億個(gè)突觸,而不會(huì)耗盡能量。

審核編輯 :李倩

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101032 -

人工智能

+關(guān)注

關(guān)注

1794文章

47630瀏覽量

239598 -

AI芯片

+關(guān)注

關(guān)注

17文章

1903瀏覽量

35159

原文標(biāo)題:一種新型模擬AI芯片,能效提升了1000倍

文章出處:【微信號(hào):芯長(zhǎng)征科技,微信公眾號(hào):芯長(zhǎng)征科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

端側(cè)AI浪潮已來!炬芯科技發(fā)布新一代端側(cè)AI音頻芯片,能效比和AI算力大幅度提升

NEO推出3D X-AI芯片,AI性能飆升百倍

安森美引領(lǐng)數(shù)據(jù)中心能效革命

PGA202 14號(hào)引腳怎么接?直接和模擬地相接一直處于1000倍放大狀態(tài)是怎么回事?

成都匯陽(yáng)投資關(guān)于跨越帶寬增長(zhǎng)極限,HBM 賦能AI新紀(jì)元

利用AI和加速計(jì)算提升天氣預(yù)報(bào)效率和能效

AMD披露高效數(shù)據(jù)中心策略,預(yù)計(jì)至2027年能效提升超百倍

進(jìn)一步解讀英偉達(dá) Blackwell 架構(gòu)、NVlink及GB200 超級(jí)芯片

龍芯:自主研發(fā)CPU提升性能,單核通用性能提高20倍

最強(qiáng)AI芯片發(fā)布,Cerebras推出性能翻倍的WSE-3 AI芯片

一種新型超級(jí)電容模組充電電源設(shè)計(jì)

英偉達(dá)新一代AI芯片預(yù)計(jì)2025年亮相

介紹一種用于絕對(duì)定量的微腔式數(shù)字PCR微流控芯片

一種新型模擬AI芯片,能效提升了1000倍

一種新型模擬AI芯片,能效提升了1000倍

評(píng)論