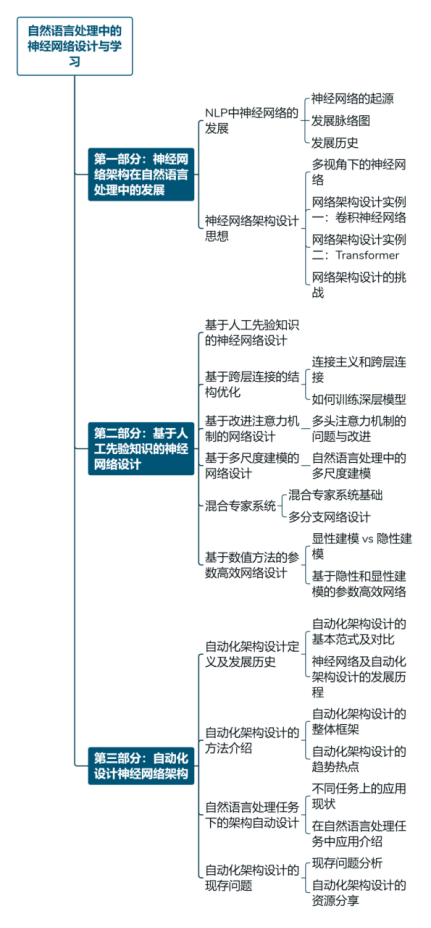

神經網絡技術是現代人工智能的關鍵技術,在自然語言處理、圖像處理等領域表現出優異效果。來自東北大學自然語言處理實驗室、小牛翻譯團隊的肖桐教授、博士生李垠橋、李北在CCMT 2022會議所進行的《自然語言處理中的神經網絡設計與學習》演講報告,從神經網絡架構在自然語言處理中的發展、人工神經網絡設計和自動化架構設計三個方面對該領域技術發展進行了全面梳理,同時也對方向的未來發展進行了分析和探討。

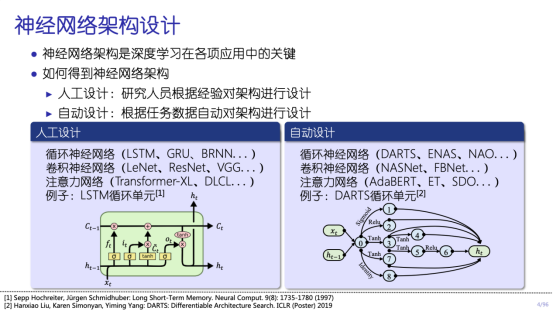

近些年來,人工神經網絡方法已經成為了自然語言處理中最重要的范式之一。但是,大量依賴人工設計的神經網絡結構,導致自然語言處理領域的發展很大程度依賴于神經網絡結構上的突破。由于神經網絡結構設計大多源自研究人員的靈感和大量經驗性嘗試,如何挖掘這些神經網絡結構背后的邏輯,如何系統化的思考不同神經網絡結構之間的內在聯系,是使用這類方法時所需要深入考慮并回答的問題。甚至,可以想象,讓計算機自動設計神經網絡架構,也可以成為進一步突破人類思維限制的方向之一。

在《自然語言處理中的神經網絡設計與學習》中,講者們根據自身研究經驗對上述問題進行了回答,對神經網絡架構的基本發展脈絡、常用的神經網絡架構的設計理念進行分析,同時對神經網絡架構的自動設計方法進行整理。這些內容可以為相關研究者供模型架構設計上的一些思路,以及實踐中的參考。同時,講者在分享中也呼吁研究者更多地以系統化的思考方式來看待神經網絡方法在自然語言處理中的應用,而非簡單像“黑盒”一樣使用它們。

第一部分:神經網絡架構在自然語言處理中的發展

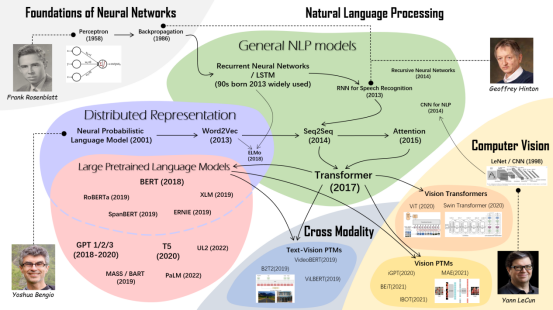

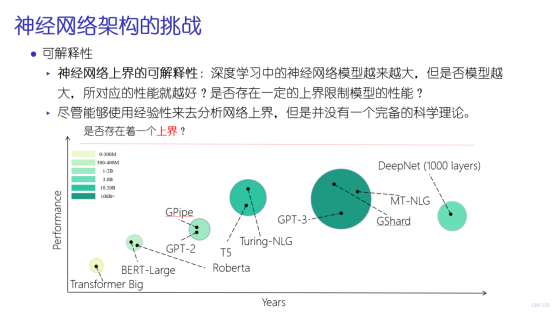

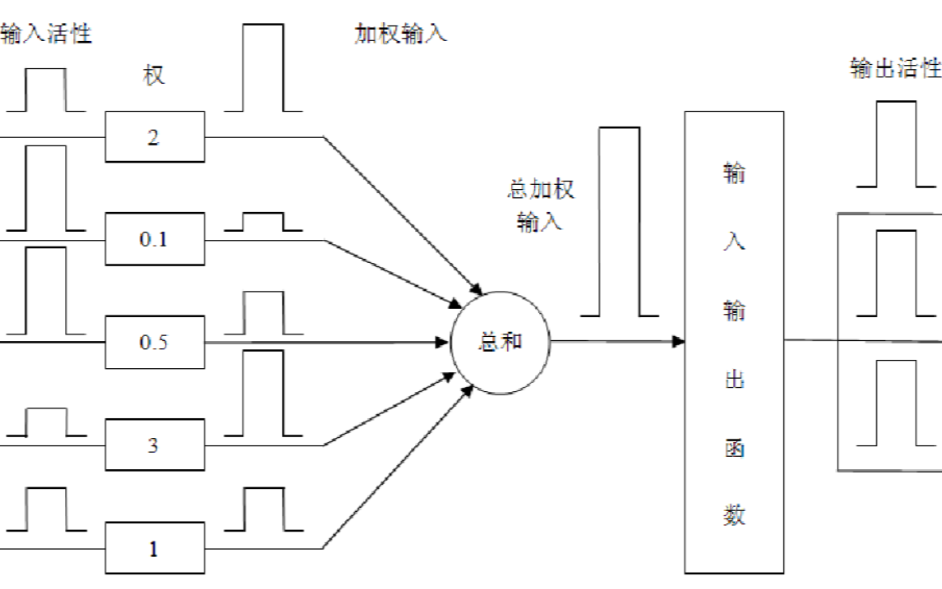

報告的第一部分內容由小牛翻譯聯合創始人、東北大學計算機學院博士生導師肖桐教授講述。首先回顧了自然語言處理中神經網絡的發展,從上世紀五十年代的感知機開始到如今的預訓練模型,為自然語言處理領域神經網絡的發展構建了一張脈絡圖。并以該圖為主線,梳理了自然語言處理領域里程碑級別的神經網絡模型及其影響,包括NNLM、Word2Vec、RNN、Seq2Seq、Attention、Transformer、預訓練模型等重要工作。接下來,以神經網絡架構設計思想為核心,介紹了從不同學科的視角看神經網絡,并以卷積神經網絡和Transformer作實例探討了隱藏在復雜模型背后的神經網絡設計靈感來源,包括卷積神經網絡與人類視覺系統感受野的關系、Transformer位置編碼和自注意力機制設計靈感來源。最后,列舉了設計神經網絡架構面臨的四個挑戰。

第二部分:基于人工先驗知識的神經網絡設計

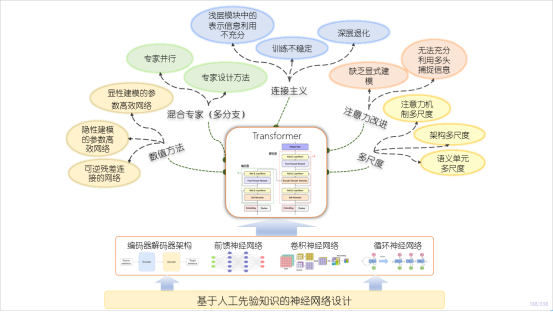

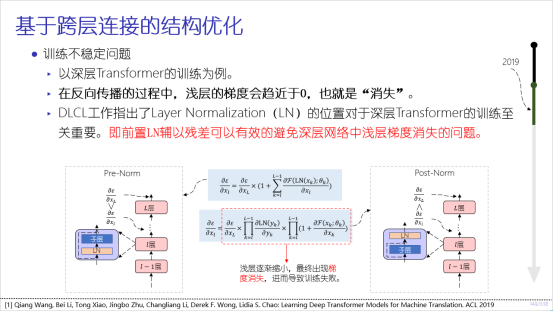

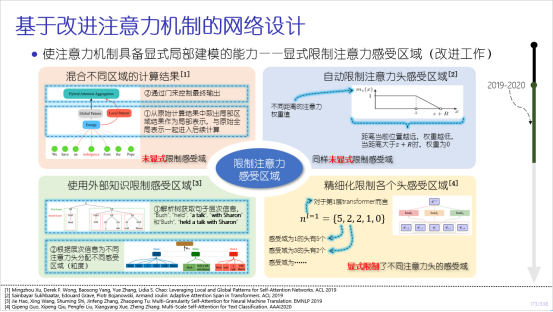

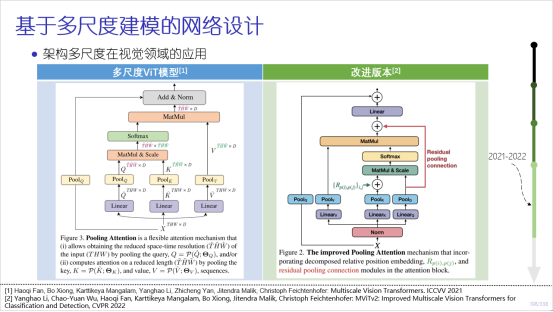

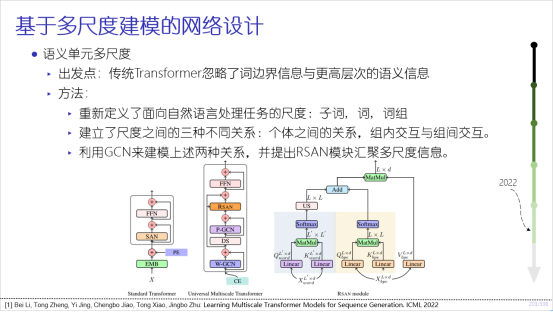

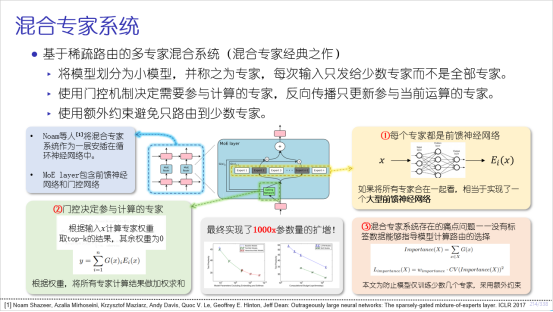

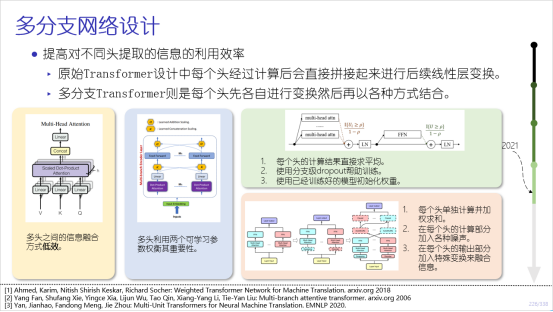

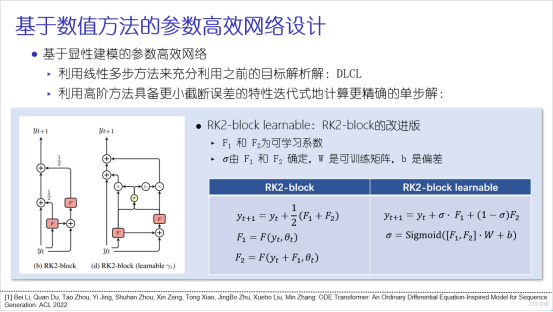

報告的第二部分由東北大學博士生李北講述。本部分主要關注基于人工先驗的神經網絡設計,內容圍繞基于Transformer模型的網絡結構改進工作展開,包括基于跨層連接的結構優化、注意力機制的改進、多尺度建模、混合專家系統及應用數值理論提高參數高效性五方面工作。在每個方面,講者從方法的早期靈感開始介紹,并介紹了方法的發展脈絡和隨后的改進工作,對近年來結構優化相關的工作實現了大規模的覆蓋。其中詳細討論了關于模型對淺層信息利用不充分,深層網絡的訓練穩定性,深層網絡的深度退化問題,注意力的局部建模,多頭注意力的增強,注意力、架構、語義單元多尺度網絡,多分支網絡設計,顯性建模和隱性建模等問題。

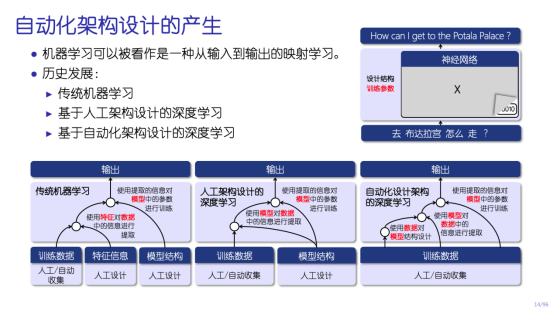

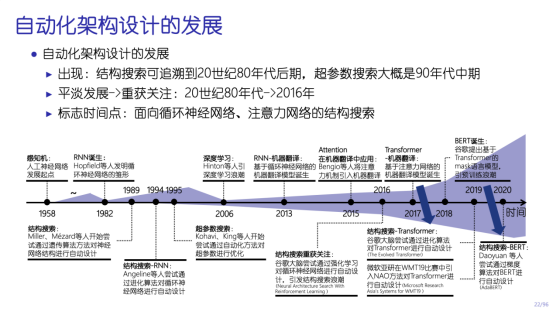

第三部分:自動化設計神經網絡架構

報告的第三部分由東北大學博士生李垠橋講述。主要圍繞如何通過自動化地方式對神經網絡架構進行設計而展開。在該部分中講者首先介紹了什么是神經網絡架構的自動設計,對比了機器學習中三種不同的范式的差異,然后通過對神經網絡技術發展的歷史回顧切入,對自動化架構設計在其中扮演的角色進行了梳理。在此之后講者對自動化架構設計的整體框架進行細致的介紹,包括搜索空間、搜索策略以及性能評估,讓大家對這類方法本身具備清楚的認知。再后講者以自然語言處理任務為例介紹了如何應用自動化機器學習的方式對結構進行優化和設計,對自動化架構搜索在自然語言處理領域中所要解決的問題進行分析。最終,還對目前自動化架構設計中依舊存在的重要問題進行了探討,希望對讀者有進一步的幫助和啟發。

部分slides如下:

審核編輯 :李倩

-

神經網絡

+關注

關注

42文章

4789瀏覽量

101876 -

自然語言處理

+關注

關注

1文章

624瀏覽量

13814 -

nlp

+關注

關注

1文章

489瀏覽量

22338

原文標題:CCMT講習班 | NLP中的神經網絡設計與學習|附338頁ppt與講解文章

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

神經網絡教程(李亞非)

【案例分享】基于BP算法的前饋神經網絡

【案例分享】ART神經網絡與SOM神經網絡

【AI學習】第3篇--人工神經網絡

如何構建神經網絡?

基于BP神經網絡的PID控制

卷積神經網絡模型發展及應用

卷積神經網絡簡介:什么是機器學習?

NLP多任務學習案例分享:一種層次增長的神經網絡結構

神經網絡與神經網絡控制的學習課件免費下載

評論