導語

epoll接口是為解決Linux內核處理大量文件描述符而提出的方案。該接口屬于Linux下多路I/O復用接口中select/poll的增強。其經常應用于Linux下高并發服務型程序,特別是在大量并發連接中只有少部分連接處于活躍下的情況 (通常是這種情況),在該情況下能顯著的提高程序的CPU利用率。本篇詳細解讀了epoll的用法,希望大家能有所收獲!

正文

設想一個場景:有100萬用戶同時與一個進程保持著TCP連接,而每一時刻只有幾十個或幾百個TCP連接是活躍的(接收TCP包),也就是說在每一時刻進程只需要處理這100萬連接中的一小部分連接。那么,如何才能高效的處理這種場景呢?進程是否在每次詢問操作系統收集有事件發生的TCP連接時,把這100萬個連接告訴操作系統,然后由操作系統找出其中有事件發生的幾百個連接呢?實際上,在 Linux2.4 版本以前,那時的select 或者 poll 事件驅動方式是這樣做的。

這里有個非常明顯的問題,即在某一時刻,進程收集有事件的連接時,其實這100萬連接中的大部分都是沒有事件發生的。因此如果每次收集事件時,都把100萬連接的套接字傳給操作系統(這首先是用戶態內存到內核態內存的大量復制),而由操作系統內核尋找這些連接上有沒有未處理的事件,將會是巨大的資源浪費,然后select和poll就是這樣做的,因此它們最多只能處理幾千個并發連接。而epoll不這樣做,它在Linux內核中申請了一個簡易的文件系統,把原先的一個select或poll調用分成了3部分:

intepoll_create(intsize); intepoll_ctl(intepfd,intop,intfd,structepoll_event*event); intepoll_wait(intepfd,structepoll_event*events,intmaxevents,inttimeout);

調用 epoll_create 建立一個 epoll 對象(在epoll文件系統中給這個句柄分配資源);

調用 epoll_ctl 向 epoll 對象中添加這100萬個連接的套接字;

調用 epoll_wait 收集發生事件的連接。

這樣只需要在進程啟動時建立 1 個 epoll 對象,并在需要的時候向它添加或刪除連接就可以了,因此,在實際收集事件時,epoll_wait 的效率就會非常高,因為調用 epoll_wait 時并沒有向它傳遞這100萬個連接,內核也不需要去遍歷全部的連接。

一、epoll原理詳解

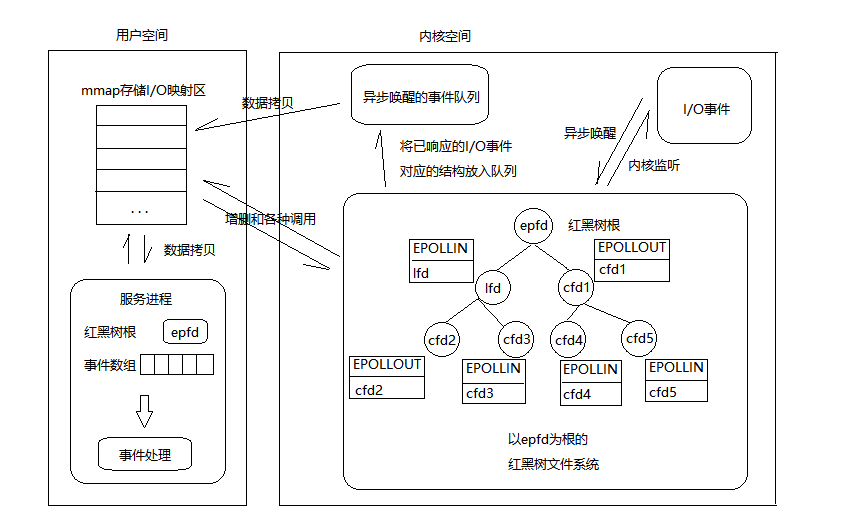

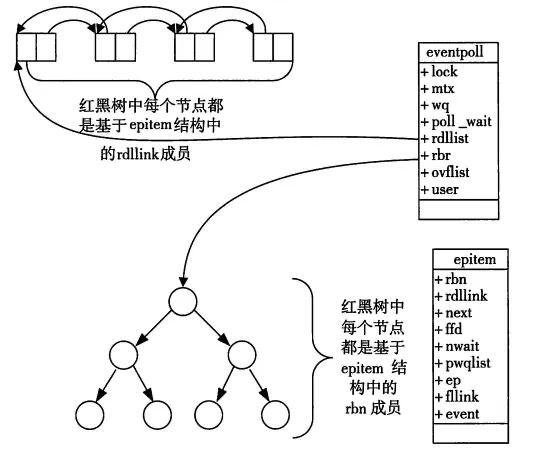

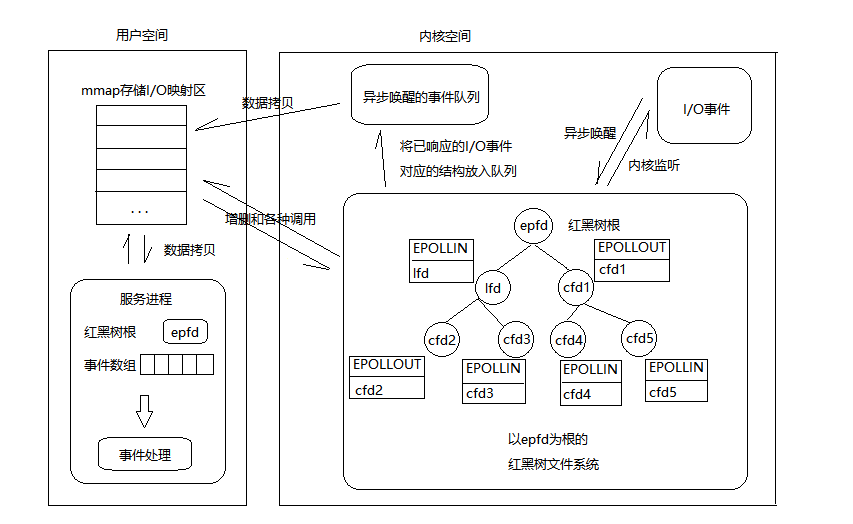

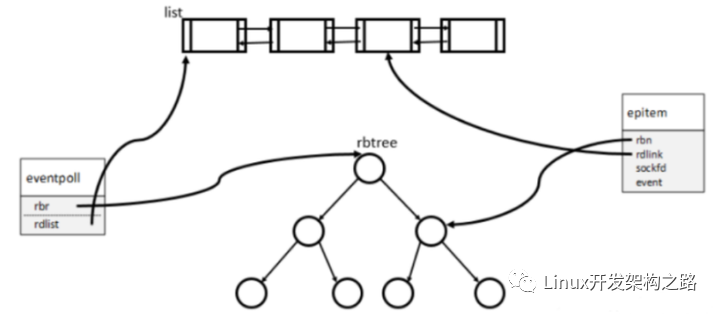

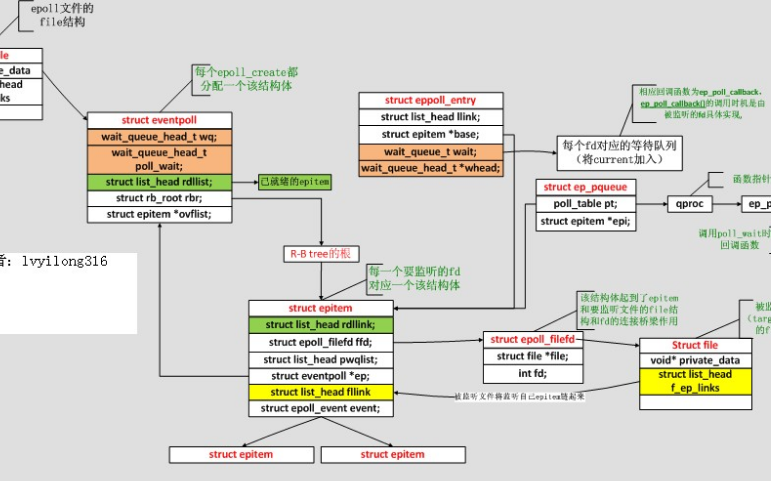

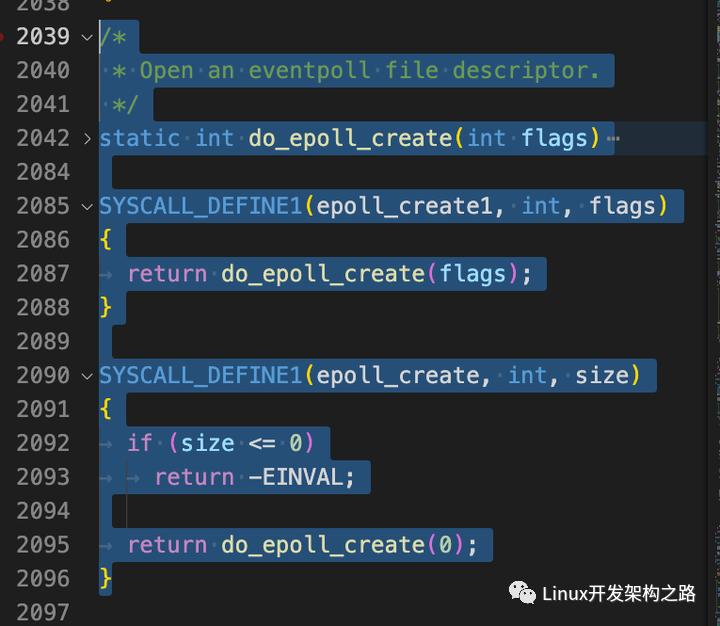

當某一進程調用 epoll_create 方法時,Linux 內核會創建一個 eventpoll 結構體,這個結構體中有兩個成員與epoll的使用方式密切相關,如下所示:

structeventpoll{

...

/*紅黑樹的根節點,這棵樹中存儲著所有添加到epoll中的事件,

也就是這個epoll監控的事件*/

structrb_rootrbr;

/*雙向鏈表rdllist保存著將要通過epoll_wait返回給用戶的、滿足條件的事件*/

structlist_headrdllist;

...

};

我們在調用 epoll_create 時,內核除了幫我們在 epoll 文件系統里建了個 file 結點,在內核 cache 里建了個紅黑樹用于存儲以后 epoll_ctl 傳來的 socket 外,還會再建立一個 rdllist 雙向鏈表,用于存儲準備就緒的事件,當 epoll_wait 調用時,僅僅觀察這個 rdllist 雙向鏈表里有沒有數據即可。有數據就返回,沒有數據就sleep,等到 timeout 時間到后即使鏈表沒數據也返回。所以epoll_wait 非常高效。

所有添加到epoll中的事件都會與設備(如網卡)驅動程序建立回調關系,也就是說相應事件的發生時會調用這里的回調方法。這個回調方法在內核中叫做ep_poll_callback,它會把這樣的事件放到上面的rdllist雙向鏈表中。

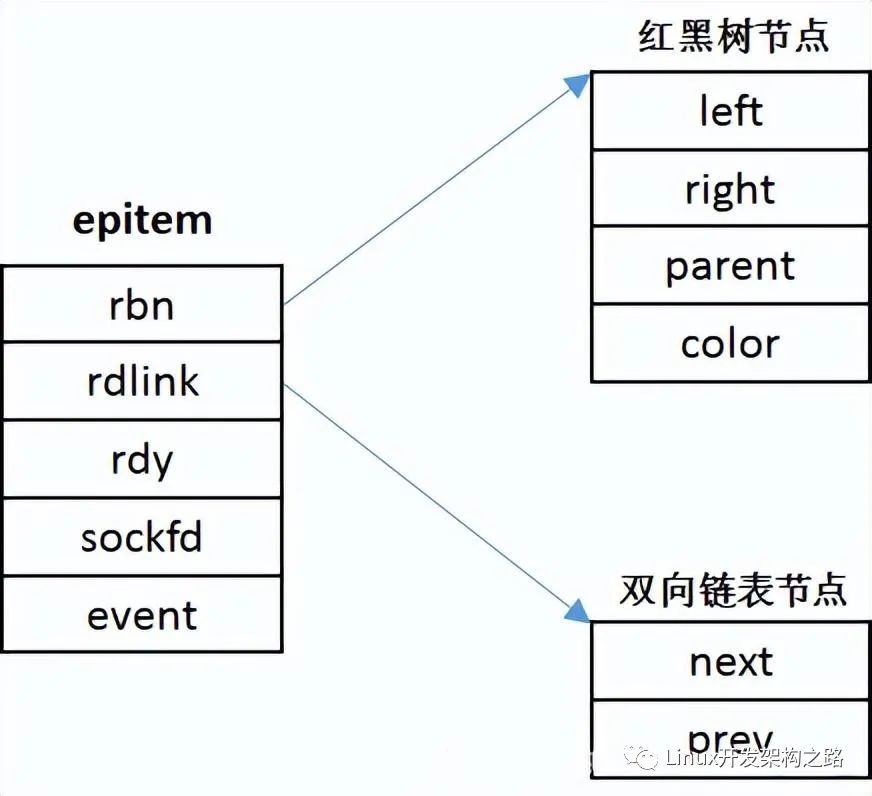

在epoll中對于每一個事件都會建立一個epitem結構體,如下所示:

structepitem{ ... //紅黑樹節點 structrb_noderbn; //雙向鏈表節點 structlist_headrdllink; //事件句柄等信息 structepoll_filefdffd; //指向其所屬的eventepoll對象 structeventpoll*ep; //期待的事件類型 structepoll_eventevent; ... };//這里包含每一個事件對應著的信息。

當調用 epoll_wait 檢查是否有發生事件的連接時,只是檢查eventpoll對象中的rdllist雙向鏈表是否有epitem元素而已,如果rdllist鏈表不為空,則這里的事件復制到用戶態內存(使用共享內存提高效率)中,同時將事件數量返回給用戶。因此epoll_waitx效率非常高。epoll_ctl在向epoll對象中添加、修改、刪除事件時,從rbr紅黑樹中查找事件也非常快,也就是說epoll是非常高效的,它可以輕易地處理百萬級別的并發連接。

【總結】:

一顆紅黑樹,一張準備就緒句柄鏈表,少量的內核cache,就幫我們解決了大并發下的socket處理問題.

執行epoll_create() 時,創建了紅黑樹和就緒鏈表;

執行 epoll_ctl() 時,如果增加 socket 句柄,則檢查在紅黑樹中是否存在,存在立即返回,不存在則添加到樹干上,然后向內核注冊回調函數,用于當中斷事件來臨時向準備就緒鏈表中插入數據;

執行 epoll_wait() 時立刻返回準備就緒鏈表里的數據即可。

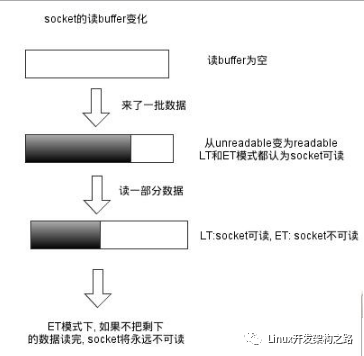

二、epoll 的兩種觸發模式

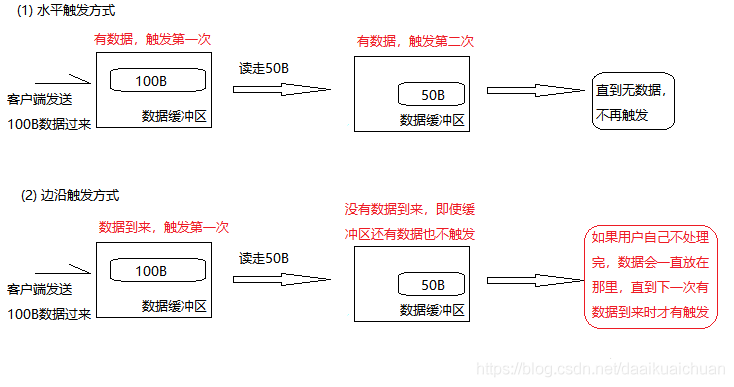

epoll有EPOLLLT和EPOLLET兩種觸發模式,LT是默認的模式,ET是“高速”模式。

LT(水平觸發)模式下,只要這個文件描述符還有數據可讀,每次 epoll_wait都會返回它的事件,提醒用戶程序去操作;

ET(邊緣觸發)模式下,在它檢測到有 I/O 事件時,通過 epoll_wait 調用會得到有事件通知的文件描述符,對于每一個被通知的文件描述符,如可讀,則必須將該文件描述符一直讀到空,讓 errno 返回 EAGAIN 為止,否則下次的 epoll_wait 不會返回余下的數據,會丟掉事件。

如果ET模式不是非阻塞的,那這個一直讀或一直寫勢必會在最后一次阻塞。

還有一個特點是,epoll使用“事件”的就緒通知方式,通過epoll_ctl注冊fd,一旦該fd就緒,內核就會采用類似callback的回調機制來激活該fd,epoll_wait便可以收到通知。

【epoll為什么要有ET觸發模式?】:

如果采用 EPOLLLT 模式的話,系統中一旦有大量你不需要讀寫的就緒文件描述符,它們每次調用epoll_wait都會返回,這樣會大大降低處理程序檢索自己關心的就緒文件描述符的效率.。而采用EPOLLET這種邊緣觸發模式的話,當被監控的文件描述符上有可讀寫事件發生時,epoll_wait()會通知處理程序去讀寫。如果這次沒有把數據全部讀寫完(如讀寫緩沖區太小),那么下次調用epoll_wait()時,它不會通知你,也就是它只會通知你一次,直到該文件描述符上出現第二次可讀寫事件才會通知你!!!這種模式比水平觸發效率高,系統不會充斥大量你不關心的就緒文件描述符。

【總結】:

ET模式(邊緣觸發)

只有數據到來才觸發,不管緩存區中是否還有數據,緩沖區剩余未讀盡的數據不會導致epoll_wait返回;

邊沿觸發模式很大程度上降低了同一個epoll事件被重復觸發的次數,所以效率更高;

對于讀寫的connfd,邊緣觸發模式下,必須使用非阻塞IO,并要一次性全部讀寫完數據。

ET的編程可以做到更加簡潔,某些場景下更加高效,但另一方面容易遺漏事件,容易產生bug;

LT 模式(水平觸發,默認)

只要有數據都會觸發,緩沖區剩余未讀盡的數據會導致epoll_wait返回;

LT比ET多了一個開關EPOLLOUT事件(系統調用消耗,上下文切換)的步驟;

對于監聽的sockfd,最好使用水平觸發模式(參考nginx),邊緣觸發模式會導致高并發情況下,有的客戶端會連接不上,LT適合處理緊急事件;

對于讀寫的connfd,水平觸發模式下,阻塞和非阻塞效果都一樣,不過為了防止特殊情況,還是建議設置非阻塞;

LT的編程與poll/select接近,符合一直以來的習慣,不易出錯;

總之,各有優缺點,需要根據業務場景選擇最合適的模式。

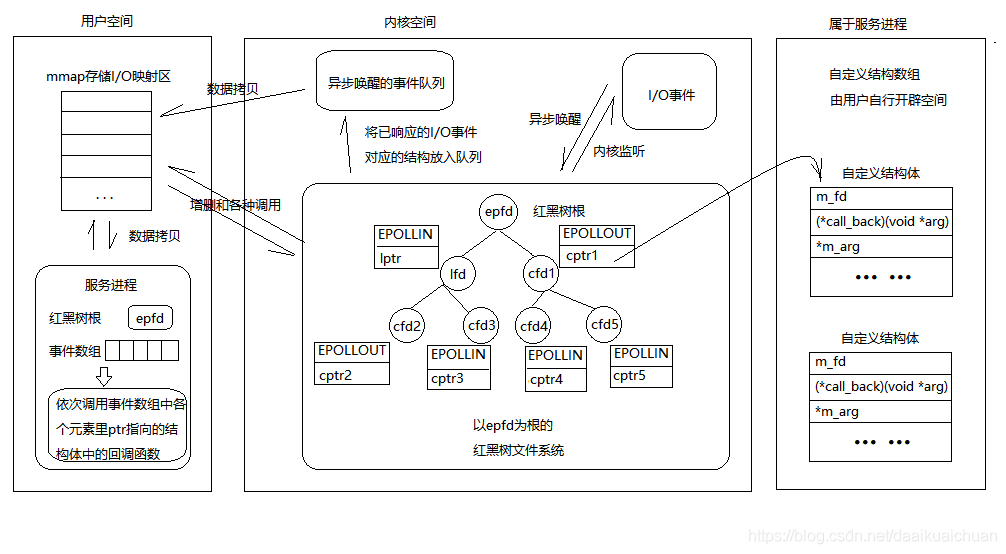

三、epoll反應堆模型

【epoll模型原來的流程】:

epoll_create();//創建監聽紅黑樹 epoll_ctl();//向書上添加監聽fd epoll_wait();//監聽 有監聽fd事件發送--->返回監聽滿足數組--->判斷返回數組元素---> lfd滿足accept--->返回cfd---->read()讀數據--->write()給客戶端回應。

【epoll反應堆模型的流程】:

epoll_create();//創建監聽紅黑樹 epoll_ctl();//向書上添加監聽fd epoll_wait();//監聽 有客戶端連接上來--->lfd調用acceptconn()--->將cfd掛載到紅黑樹上監聽其讀事件---> epoll_wait()返回cfd--->cfd回調recvdata()--->將cfd摘下來監聽寫事件---> epoll_wait()返回cfd--->cfd回調senddata()--->將cfd摘下來監聽讀事件--->...--->

【Demo】:

#include#include #include #include #include #include #include #include #include #include #defineMAX_EVENTS1024/*監聽上限*/ #defineBUFLEN4096/*緩存區大小*/ #defineSERV_PORT6666/*端口號*/ voidrecvdata(intfd,intevents,void*arg); voidsenddata(intfd,intevents,void*arg); /*描述就緒文件描述符的相關信息*/ structmyevent_s { intfd;//要監聽的文件描述符 intevents;//對應的監聽事件,EPOLLIN和EPLLOUT void*arg;//指向自己結構體指針 void(*call_back)(intfd,intevents,void*arg);//回調函數 intstatus;//是否在監聽:1->在紅黑樹上(監聽),0->不在(不監聽) charbuf[BUFLEN]; intlen; longlast_active;//記錄每次加入紅黑樹g_efd的時間值 }; intg_efd;//全局變量,作為紅黑樹根 structmyevent_sg_events[MAX_EVENTS+1];//自定義結構體類型數組.+1-->listenfd /* *封裝一個自定義事件,包括fd,這個fd的回調函數,還有一個額外的參數項 *注意:在封裝這個事件的時候,為這個事件指明了回調函數,一般來說,一個fd只對一個特定的事件 *感興趣,當這個事件發生的時候,就調用這個回調函數 */ voideventset(structmyevent_s*ev,intfd,void(*call_back)(intfd,intevents,void*arg),void*arg) { ev->fd=fd; ev->call_back=call_back; ev->events=0; ev->arg=arg; ev->status=0; if(ev->len<=?0) ????{ ????????memset(ev->buf,0,sizeof(ev->buf)); ev->len=0; } ev->last_active=time(NULL);//調用eventset函數的時間 return; } /*向epoll監聽的紅黑樹添加一個文件描述符*/ voideventadd(intefd,intevents,structmyevent_s*ev) { structepoll_eventepv={0,{0}}; intop=0; epv.data.ptr=ev;//ptr指向一個結構體(之前的epoll模型紅黑樹上掛載的是文件描述符cfd和lfd,現在是ptr指針) epv.events=ev->events=events;//EPOLLIN或EPOLLOUT if(ev->status==0)//status說明文件描述符是否在紅黑樹上0不在,1在 { op=EPOLL_CTL_ADD;//將其加入紅黑樹g_efd,并將status置1 ev->status=1; } if(epoll_ctl(efd,op,ev->fd,&epv)fd,events); else printf("eventaddOK[fd=%d],events[%0X] ",ev->fd,events); return; } /*從epoll監聽的紅黑樹中刪除一個文件描述符*/ voideventdel(intefd,structmyevent_s*ev) { structepoll_eventepv={0,{0}}; if(ev->status!=1)//如果fd沒有添加到監聽樹上,就不用刪除,直接返回 return; epv.data.ptr=NULL; ev->status=0; epoll_ctl(efd,EPOLL_CTL_DEL,ev->fd,&epv); return; } /*當有文件描述符就緒,epoll返回,調用該函數與客戶端建立鏈接*/ voidacceptconn(intlfd,intevents,void*arg) { structsockaddr_incin; socklen_tlen=sizeof(cin); intcfd,i; if((cfd=accept(lfd,(structsockaddr*)&cin,&len))==-1) { if(errno!=EAGAIN&&errno!=EINTR) { sleep(1); } printf("%s:accept,%s ",__func__,strerror(errno)); return; } do { for(i=0;ibuf,sizeof(ev->buf),0);//讀取客戶端發過來的數據 eventdel(g_efd,ev);//將該節點從紅黑樹上摘除 if(len>0) { ev->len=len; ev->buf[len]='?';//手動添加字符串結束標記 printf("C[%d]:%s ",fd,ev->buf); eventset(ev,fd,senddata,ev);//設置該fd對應的回調函數為senddata eventadd(g_efd,EPOLLOUT,ev);//將fd加入紅黑樹g_efd中,監聽其寫事件 } elseif(len==0) { close(ev->fd); /*ev-g_events地址相減得到偏移元素位置*/ printf("[fd=%d]pos[%ld],closed ",fd,ev-g_events); } else { close(ev->fd); printf("recv[fd=%d]error[%d]:%s ",fd,errno,strerror(errno)); } return; } /*發送給客戶端數據*/ voidsenddata(intfd,intevents,void*arg) { structmyevent_s*ev=(structmyevent_s*)arg; intlen; len=send(fd,ev->buf,ev->len,0);//直接將數據回射給客戶端 eventdel(g_efd,ev);//從紅黑樹g_efd中移除 if(len>0) { printf("send[fd=%d],[%d]%s ",fd,len,ev->buf); eventset(ev,fd,recvdata,ev);//將該fd的回調函數改為recvdata eventadd(g_efd,EPOLLIN,ev);//重新添加到紅黑樹上,設為監聽讀事件 } else { close(ev->fd);//關閉鏈接 printf("send[fd=%d]error%s ",fd,strerror(errno)); } return; } /*創建socket,初始化lfd*/ voidinitlistensocket(intefd,shortport) { structsockaddr_insin; intlfd=socket(AF_INET,SOCK_STREAM,0); fcntl(lfd,F_SETFL,O_NONBLOCK);//將socket設為非阻塞 memset(&sin,0,sizeof(sin));//bzero(&sin,sizeof(sin)) sin.sin_family=AF_INET; sin.sin_addr.s_addr=INADDR_ANY; sin.sin_port=htons(port); bind(lfd,(structsockaddr*)&sin,sizeof(sin)); listen(lfd,20); /*voideventset(structmyevent_s*ev,intfd,void(*call_back)(int,int,void*),void*arg);*/ eventset(&g_events[MAX_EVENTS],lfd,acceptconn,&g_events[MAX_EVENTS]); /*voideventadd(intefd,intevents,structmyevent_s*ev)*/ eventadd(efd,EPOLLIN,&g_events[MAX_EVENTS]);//將lfd添加到監聽樹上,監聽讀事件 return; } intmain() { intport=SERV_PORT; g_efd=epoll_create(MAX_EVENTS+1);//創建紅黑樹,返回給全局g_efd if(g_efd<=?0) ????????????printf("create?efd?in?%s?err?%s ",?__func__,?strerror(errno)); ????initlistensocket(g_efd,?port);?//初始化監聽socket ????struct?epoll_event?events[MAX_EVENTS?+?1];??//定義這個結構體數組,用來接收epoll_wait傳出的滿足監聽事件的fd結構體 ????printf("server?running:port[%d] ",?port); ????int?checkpos?=?0; ????int?i; ????while(1) ????{ ????/*????long?now?=?time(NULL); ????????for(i=0;?i?=60) { close(g_events[checkpos].fd); printf("[fd=%d]timeout ",g_events[checkpos].fd); eventdel(g_efd,&g_events[checkpos]); } }*/ //調用eppoll_wait等待接入的客戶端事件,epoll_wait傳出的是滿足監聽條件的那些fd的structepoll_event類型 intnfd=epoll_wait(g_efd,events,MAX_EVENTS+1,1000); if(nfdevents&EPOLLIN)) { ev->call_back(ev->fd,events[i].events,ev->arg); } //如果監聽的是寫事件,并返回的是寫事件 if((events[i].events&EPOLLOUT)&&(ev->events&EPOLLOUT)) { ev->call_back(ev->fd,events[i].events,ev->arg); } } } return0; }

最后學習epoll一些建議

需要深入理解epoll LT和ET方式下的讀寫差別,怎么優雅地處理各種錯誤;

需要關注多線程負載均衡,驚群效應等問題,要用 epoll 實現負載均衡并且避免數據競爭,必須掌握好 EPOLLONESHOT 和 EPOLLEXCLUSIVE 這兩個標志;

理解epoll不足之處:

定時的精度不夠,只到5ms級別,select可以到0.1ms;

當連接數少并且連接都十分活躍的情況下,select和poll的性能可能比epoll好;

epoll_ctrl每次只能夠修改一個fd(kevent可以一次改多個,每次修改,epoll需要一個系統調用,不能 batch 操作,可能會影響性能)。

可能會在定時到期之前返回,導致還需要下一個epoll_wait調用。

原文標題:揭秘Linux高性能服務epoll 的本質

文章出處:【微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

-

接口

+關注

關注

33文章

8691瀏覽量

151699 -

操作系統

+關注

關注

37文章

6889瀏覽量

123598 -

epoll

+關注

關注

0文章

28瀏覽量

2975

原文標題:揭秘Linux高性能服務epoll 的本質

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

epoll的使用

我讀過的最好的epoll講解

epoll_wait的事件返回的fd為錯誤是怎么回事?

揭示EPOLL一些原理性的東西

【米爾王牌產品MYD-Y6ULX-V2開發板試用體驗】socket通信和epoll

epoll和select的區別

一文詳解epoll的實現原理

epoll的基礎數據結構

epoll LT和ET方式下的讀寫差別

epoll LT和ET方式下的讀寫差別

評論