華盛頓大學(xué)和臉譜網(wǎng)的研究人員使用深度學(xué)習(xí)將靜止圖像轉(zhuǎn)換成逼真的動畫循環(huán)視頻。

他們的方法 將在即將召開的計算機(jī)視覺和模式識別會議( CVPR )上發(fā)布的這項技術(shù)模擬了連續(xù)的流體運(yùn)動,如流動的水、煙和云,將靜止圖像轉(zhuǎn)換成無縫循環(huán)的短視頻。

“我們的方法的特別之處在于它不需要任何用戶輸入或額外的信息,” Aleksander Ho?yński ,華盛頓大學(xué)計算機(jī)科學(xué)與工程博士生,項目負(fù)責(zé)人說。你只需要一張照片。它可以輸出一個高分辨率的無縫循環(huán)視頻,通常看起來像一個真實的視頻。”

團(tuán)隊創(chuàng)建了一種稱為“對稱飛濺”的方法從靜止圖像預(yù)測過去和未來的運(yùn)動,結(jié)合這些數(shù)據(jù)創(chuàng)建無縫動畫。

“當(dāng)我們看到瀑布時,我們知道水應(yīng)該如何運(yùn)動。火或煙也是如此。這些類型的運(yùn)動遵循同一套物理規(guī)律,圖像中通常有線索告訴我們物體應(yīng)該如何運(yùn)動? y ń斯奇說我們很樂意將我們的工作擴(kuò)展到更廣泛的對象上,比如為一個人在風(fēng)中吹拂的頭發(fā)設(shè)置動畫。我希望最終我們與朋友和家人分享的照片不會是靜態(tài)的。相反,它們都是動態(tài)動畫,就像我們的方法生成的動畫一樣。”

為了教他們的神經(jīng)網(wǎng)絡(luò)估計運(yùn)動,研究小組在 1000 多個流體運(yùn)動的視頻(如瀑布、河流和海洋)上訓(xùn)練了這個模型。如果只給出視頻的第一幀,系統(tǒng)將預(yù)測未來幀中應(yīng)該發(fā)生的事情,并將其預(yù)測結(jié)果與原始視頻進(jìn)行比較。這種比較有助于模型改進(jìn)對圖像中每個像素是否應(yīng)該移動以及如何移動的預(yù)測。

研究人員使用了 NVIDIA Pix2PixHD 用于運(yùn)動估計網(wǎng)絡(luò)訓(xùn)練的 GAN 模型,以及 FlowNet2 和 PWC-Net 。模型進(jìn)行訓(xùn)練和推理都采用 NVIDIA GPU。培訓(xùn)數(shù)據(jù)包括 1196 個獨(dú)特的視頻, 1096 個用于培訓(xùn), 50 個用于驗證, 50 個用于測試。

關(guān)于作者

Clarissa Garza 是 NVIDIA 在 2021 夏天的企業(yè)傳播實習(xí)生,她在波士頓大學(xué)新聞專業(yè)的第四年。在 NVIDIA ,她在 NVIDIA 的公司和開發(fā)者博客以及 AI 播客上工作。

審核編輯:郭婷

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5075瀏覽量

103560 -

gpu

+關(guān)注

關(guān)注

28文章

4768瀏覽量

129242

發(fā)布評論請先 登錄

相關(guān)推薦

嵌入式和人工智能究竟是什么關(guān)系?

《AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第6章人AI與能源科學(xué)讀后感

AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第4章-AI與生命科學(xué)讀后感

《AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第二章AI for Science的技術(shù)支撐學(xué)習(xí)心得

《AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新》第一章人工智能驅(qū)動的科學(xué)創(chuàng)新學(xué)習(xí)心得

risc-v在人工智能圖像處理應(yīng)用前景分析

人工智能ai4s試讀申請

名單公布!【書籍評測活動NO.44】AI for Science:人工智能驅(qū)動科學(xué)創(chuàng)新

FPGA在人工智能中的應(yīng)用有哪些?

圖像識別屬于人工智能嗎

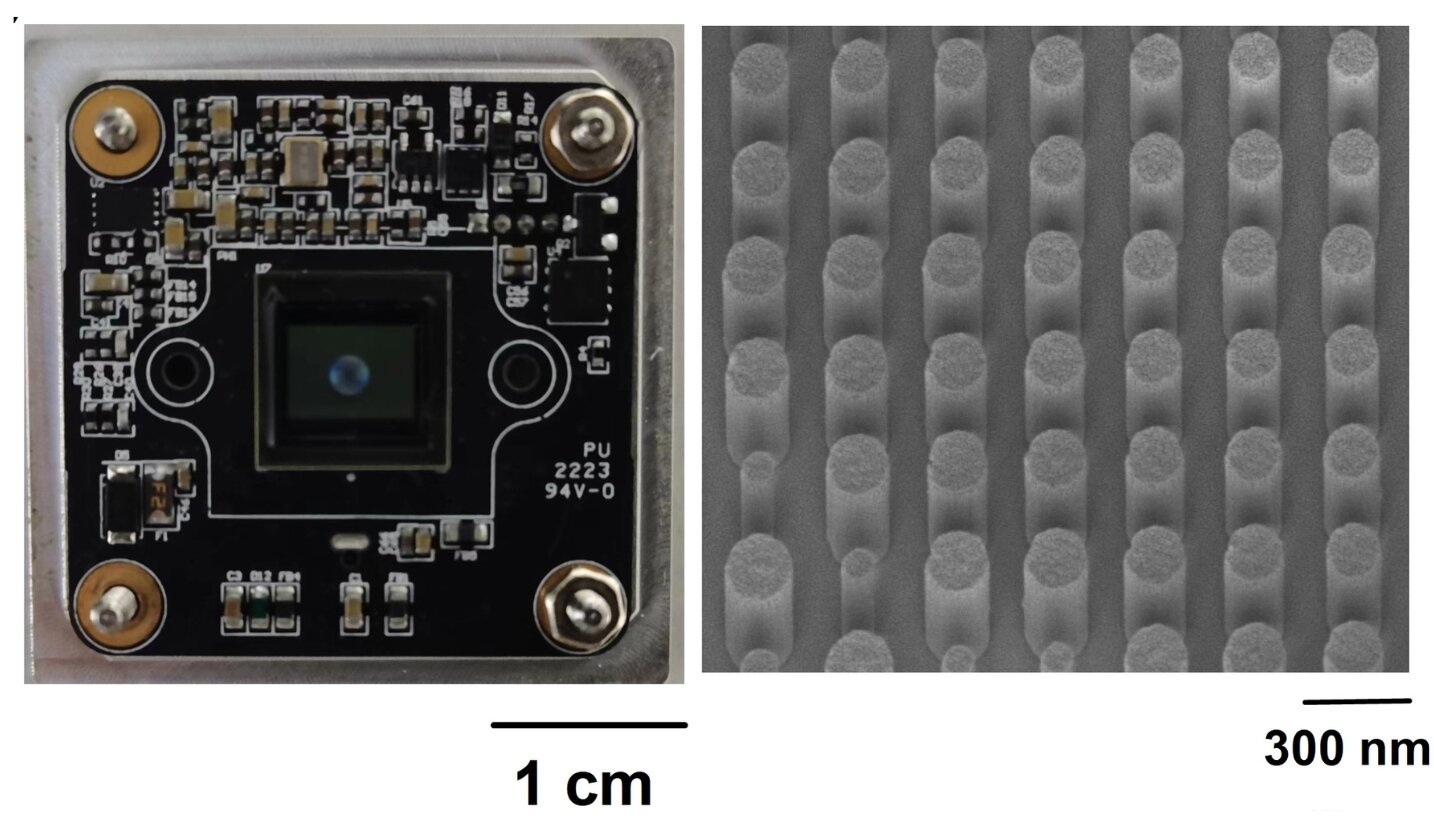

研究人員利用人工智能提升超透鏡相機(jī)的圖像質(zhì)量

人工智能研究人員利用靜止圖像創(chuàng)建循環(huán)視頻

人工智能研究人員利用靜止圖像創(chuàng)建循環(huán)視頻

評論