電子發(fā)燒友網(wǎng)報(bào)道(文/程文智)GTC大會(huì)自2020年開(kāi)始舉辦后,成為了AI開(kāi)發(fā)者非常關(guān)注的一個(gè)會(huì)議,每次會(huì)議,NVIDIA的CEO黃仁勛都會(huì)發(fā)布一個(gè)主題演講,會(huì)介紹NVIDIA最新的進(jìn)展,以及重磅新品。本次GTC 2022春季大會(huì)也不例外。

GTC2022依然是在線(xiàn)上舉辦,NVIDIA首席執(zhí)行官黃仁勛在數(shù)字孿生技術(shù)支持下的虛擬NVIDIA總部大樓里發(fā)表了主題演講。在他看來(lái),隨著AI技術(shù)的發(fā)展,AI的發(fā)展方向也在發(fā)生著改變,“第一波AI學(xué)習(xí)是感知和推理,比如圖像識(shí)別、語(yǔ)音理解、推薦視頻或商品;下一波AI的發(fā)展方向?qū)⑹?a href="http://m.1cnz.cn/soft/data/42-101/" target="_blank">機(jī)器人,也就是使用AI來(lái)規(guī)劃行動(dòng),數(shù)字機(jī)器人、虛擬形象和實(shí)體機(jī)器人將完成感知、規(guī)劃,并采取行動(dòng)。”

AI正在各個(gè)方向加速發(fā)展,包括新的架構(gòu)、新的學(xué)習(xí)策略、更大和更可靠的模型,同時(shí),AI也在很多新的科學(xué)、新的應(yīng)用、新的行業(yè)等方面加速發(fā)展。比如說(shuō),如今的AI不僅學(xué)習(xí)理解圖像、聲音和語(yǔ)言,還正在學(xué)習(xí)生物學(xué)、化學(xué),甚至是量子物理學(xué)等等。

“數(shù)據(jù)中心規(guī)模的加速計(jì)算于機(jī)器學(xué)習(xí)相結(jié)合,可以將計(jì)算速度提高百萬(wàn)倍。正式由于加速計(jì)算的推動(dòng),像Transfermer這樣的革命性AI模型和自監(jiān)督學(xué)習(xí)成為了可能。”黃仁勛特別指出,“各公司都在處理和完善自己的數(shù)據(jù)、開(kāi)發(fā)AI軟件,并使自己成為智能的生產(chǎn)商。他們 數(shù)據(jù)中心正在逐步演變?yōu)锳I工廠(chǎng)。”這也意味著AI工廠(chǎng)時(shí)代的來(lái)臨。

為了應(yīng)對(duì)AI工廠(chǎng)時(shí)代對(duì)AI的需求,NVIDIA帶來(lái)了全新的Hopper架構(gòu)H100 GPU芯片、Grace CPU超級(jí)芯片、DGX H100系統(tǒng)、DGX SuperPOD、融合加速器H100 CNX、AI 超級(jí)計(jì)算機(jī)NVIDIA Eos、Spectrum-4、Jetson AGX Orin開(kāi)發(fā)者套件等一系列新品。下面就讓我們來(lái)看一看這些新品都有什么特別之處。

H100 GPU:全新Hopper架構(gòu),800億個(gè)晶體管

NVIDIA H100 GPU集成了800億個(gè)晶體管,它也是NVIDIA發(fā)布的首款采用Hopper架構(gòu)的GPU。Hopper架構(gòu)是以美國(guó)計(jì)算機(jī)領(lǐng)域的先驅(qū)科學(xué)家Grace Hopper 的名字命名的,它將取代兩年前推出的 NVIDIA Ampere架構(gòu)。

據(jù)黃仁勛介紹,H100 是全球范圍內(nèi)最大的性能出眾的加速器,擁有革命性的 Transformer 引擎和高度可擴(kuò)展的 NVIDIA NVLink互連技術(shù)等突破性功能,可推動(dòng)龐大的 AI 語(yǔ)言模型、深度推薦系統(tǒng)、基因組學(xué)和復(fù)雜數(shù)字孿生的發(fā)展。

從技術(shù)角度來(lái)看,H100帶來(lái)了6項(xiàng)突破性創(chuàng)新:

強(qiáng)大的性能 —— H100 由 800 億個(gè)晶體管構(gòu)建而成,這些晶體管采用了專(zhuān)為 NVIDIA 加速計(jì)算需求設(shè)計(jì)的TSMC 4N工藝,因而能夠顯著提升AI、HPC、顯存帶寬、互連和通信的速度,并能夠?qū)崿F(xiàn)近 5TB/s 的外部互聯(lián)帶寬。H100 是首款支持 PCIe 5.0 的 GPU,也是首款采用 HBM3 的 GPU,可實(shí)現(xiàn) 3TB/s 的顯存帶寬。20個(gè) H100 GPU 便可承托相當(dāng)于全球互聯(lián)網(wǎng)的流量,使其能夠幫助客戶(hù)推出先進(jìn)的推薦系統(tǒng)以及實(shí)時(shí)運(yùn)行數(shù)據(jù)推理的大型語(yǔ)言模型。

新的 Transformer 引擎 —— Transformer 現(xiàn)在已成為自然語(yǔ)言處理的標(biāo)準(zhǔn)模型方案,也是深度學(xué)習(xí)模型領(lǐng)域最重要的模型之一。H100 加速器的 Transformer 引擎旨在不影響精度的情況下,將這些網(wǎng)絡(luò)的速度提升至上一代的六倍。

第二代安全多實(shí)例 GPU —— MIG 技術(shù)支持將單個(gè) GPU 分為七個(gè)更小且完全獨(dú)立的實(shí)例,以處理不同類(lèi)型的作業(yè)。與上一代產(chǎn)品相比,在云環(huán)境中 Hopper 架構(gòu)通過(guò)為每個(gè) GPU 實(shí)例提供安全的多租戶(hù)配置,將 MIG 的部分能力擴(kuò)展了 7 倍。

機(jī)密計(jì)算 —— H100 是全球首款具有機(jī)密計(jì)算功能的加速器,可保護(hù) AI 模型和正在處理的客戶(hù)數(shù)據(jù)。客戶(hù)還可以將機(jī)密計(jì)算應(yīng)用于醫(yī)療健康和金融服務(wù)等隱私敏感型行業(yè)的聯(lián)邦學(xué)習(xí),也可以應(yīng)用于共享云基礎(chǔ)設(shè)施。

第 4 代 NVIDIA NVLink —— 為加速大型 AI 模型,NVLink 結(jié)合全新的外接 NVLink Switch,可將 NVLink 擴(kuò)展為服務(wù)器間的互聯(lián)網(wǎng)絡(luò),最多可以連接多達(dá) 256 個(gè) H100 GPU,相較于上一代采用 NVIDIA HDR Quantum InfiniBand網(wǎng)絡(luò),帶寬高出9倍。

DPX 指令 —— 新的 DPX 指令可加速動(dòng)態(tài)規(guī)劃,適用于包括路徑優(yōu)化和基因組學(xué)在內(nèi)的一系列算法,與 CPU 和上一代 GPU 相比,其速度提升分別可達(dá) 40 倍和 7 倍。Floyd-Warshall 算法與 Smith-Waterman 算法也在其加速之列,前者可以在動(dòng)態(tài)倉(cāng)庫(kù)環(huán)境中為自主機(jī)器人車(chē)隊(duì)尋找最優(yōu)線(xiàn)路,而后者可用于 DNA 和蛋白質(zhì)分類(lèi)與折疊的序列比對(duì)。

具體來(lái)說(shuō),H100 將支持聊天機(jī)器人使用功能超強(qiáng)大的monolithic Transformer 語(yǔ)言模型 Megatron 530B,吞吐量比上一代產(chǎn)品高出 30 倍,同時(shí)滿(mǎn)足實(shí)時(shí)對(duì)話(huà)式 AI 所需的次秒級(jí)延遲。利用 H100,研究人員和開(kāi)發(fā)者能夠訓(xùn)練龐大的模型,如包含 3950 億個(gè)參數(shù)的混合專(zhuān)家模型,訓(xùn)練速度加速高達(dá)9倍,將訓(xùn)練時(shí)間從幾周縮短到幾天。

H100將提供SXM和PCIe兩種規(guī)格,可滿(mǎn)足各種服務(wù)器設(shè)計(jì)需求。NVIDIA H100 SXM 提供 4 GPU 和 8 GPU 配置的 HGX H100 服務(wù)器主板,主要用于高性能服務(wù)器,可助力企業(yè)將應(yīng)用擴(kuò)展至一臺(tái)服務(wù)器和多臺(tái)服務(wù)器中的多個(gè) GPU。H100 PCIe相對(duì)來(lái)說(shuō)更加實(shí)惠,用于主流服務(wù)器。與上一代相比,這兩種外形尺寸的功率要求都顯著提高。

NVIDIA為SXM版本的顯卡提供了700W TDP,比A100官方的400W TDP高出了75%。官方推薦的冷卻方式是風(fēng)冷和液冷兩種。但在如此功率下,估計(jì)液冷會(huì)更受用戶(hù)青睞,畢竟這個(gè)價(jià)格不菲,要是由于散熱問(wèn)題而導(dǎo)致出問(wèn)題就不劃算了。

同時(shí),H100 PCIe卡的TDP提高到了350W,冷卻方式也是風(fēng)冷和液冷兩種。當(dāng)然,如果像降低散熱壓力,也可以通過(guò)配置方式來(lái)降低顯卡的功耗,只是這么做就要犧牲一些性能了。

為了將Hopper的強(qiáng)大算力引入主流服務(wù)器,英偉達(dá)推出了全新的融合加速器H100 CNX。它將網(wǎng)絡(luò)與GPU直接相連,耦合H100 GPU與英偉達(dá)ConnectX-7 400Gb/s InfiniBand和以太網(wǎng)智能網(wǎng)卡,使網(wǎng)絡(luò)數(shù)據(jù)通過(guò)DMA以50GB/s的速度直接傳輸?shù)紿100,能夠避免帶寬瓶頸,為I/O密集型應(yīng)用提供更強(qiáng)勁的性能。

Grace CPU超級(jí)芯片:144個(gè)CPU核心

除了GPU產(chǎn)品,NVIDIA還發(fā)布了其第一款轉(zhuǎn)為數(shù)據(jù)中心設(shè)計(jì)的,基于Arm Neoverse的數(shù)據(jù)中心專(zhuān)屬CPU------ Grace CPU超級(jí)芯片,其可提供最高的性能,是當(dāng)今領(lǐng)先服務(wù)器芯片內(nèi)存帶寬和能效的兩倍。

NVIDIA Grace CPU超級(jí)芯片由兩個(gè)CPU芯片組成,它們之間通過(guò)NVLink-C2C互連在一起。NVLink-C2C 是一種新型的高速、低延遲、芯片到芯片的互連技術(shù)。

Grace CPU超級(jí)芯片是去年NVIDIA發(fā)布的首款由 CPU-GPU 集成的“Grace Hopper 超級(jí)芯片”的模塊,它將與基于 NVIDIA Hopper架構(gòu)的 GPU一同應(yīng)用于大型 HPC 和AI 應(yīng)用。這兩款超級(jí)芯片采用相同的底層 CPU 架構(gòu)及 NVLink-C2C 互連。

Grace CPU 超級(jí)芯片專(zhuān)為提供最高的性能而打造,能夠在單個(gè)插座(socket)中容納 144 個(gè) Arm 核心。NVIDIA宣稱(chēng),在SPECrate 2017_int_base基準(zhǔn)測(cè)試中,Grace CPU超級(jí)芯片的模擬性能得分為740,據(jù)NVIDIA實(shí)驗(yàn)室使用同類(lèi)編譯器估算,這一結(jié)果相比當(dāng)前DGX A100搭載的雙CPU高1.5倍以上。

Grace CPU 超級(jí)芯片依托帶有糾錯(cuò)碼的LPDDR5x 內(nèi)存組成的創(chuàng)新的內(nèi)存子系統(tǒng),可實(shí)現(xiàn)速度和功耗的最佳平衡。LPDDR5x 內(nèi)存子系統(tǒng)提供兩倍于傳統(tǒng)DDR5設(shè)計(jì)的帶寬,可達(dá)到每秒1 TB ,同時(shí)功耗也大幅降低 ,CPU加內(nèi)存整體功耗僅500瓦。

此外,Grace CPU 超級(jí)芯片基于最新的數(shù)據(jù)中心架構(gòu) Arm v9,具備最高的單線(xiàn)程核心性能,并支持 Arm 新一代矢量擴(kuò)展。

Grace CPU超級(jí)芯片可運(yùn)行所有的英偉達(dá)計(jì)算軟件棧,結(jié)合NVIDIA ConnectX-7網(wǎng)卡,能夠靈活地配置到服務(wù)器中,或作為獨(dú)立的純CPU系統(tǒng),或作為GPU加速服務(wù)器,可以搭配1塊、2塊、4塊或8塊基于Hopper的GPU。

也就是說(shuō),用戶(hù)只維護(hù)一套軟件棧,就能針對(duì)自身特定的工作負(fù)載做好性能優(yōu)化。

NVIDIA正在通過(guò) Grace CPU超級(jí)芯片擴(kuò)展其目標(biāo)市場(chǎng),現(xiàn)在涵蓋超大規(guī)模計(jì)算、云、數(shù)據(jù)分析、HPC 和 AI 工作負(fù)載,有效地瞄準(zhǔn)了通用服務(wù)器市場(chǎng)。Grace CPU超級(jí)芯片支持NVIDIA的整個(gè)CUDA 堆棧,并將運(yùn)行NVIDIA的所有應(yīng)用程序,包括NVIDIA RTX、NVIDIA AI、HPC 和 Omniverse。

關(guān)于出貨方面,Grace CPU超級(jí)芯片將于 2023 年上半年開(kāi)始出貨。

DGX H100系統(tǒng):企業(yè)級(jí)AI基礎(chǔ)設(shè)施

第四代 NVIDIA DGX系統(tǒng),是全球首個(gè)基于全新 NVIDIA H100 Tensor Core GPU的AI平臺(tái)。該系統(tǒng)能夠滿(mǎn)足大型語(yǔ)言模型、推薦系統(tǒng)、醫(yī)療健康研究和氣候科學(xué)的大規(guī)模計(jì)算需求。每個(gè) DGX H100 系統(tǒng)配備8塊 NVIDIA H100 GPU,并由 NVIDIA NVLink 連接,能夠在新的 FP8 精度下達(dá)到 32 Petaflop 的 AI 性能,比上一代系統(tǒng)性能高 6 倍。

DGX H100 系統(tǒng)是新一代 NVIDIA DGX POD 和 NVIDIA DGX SuperPOD AI 基礎(chǔ)設(shè)施平臺(tái)的構(gòu)建模塊。新的 DGX SuperPOD 架構(gòu)采用了一個(gè)全新的 NVIDIA NVLink Switch 系統(tǒng),通過(guò)這一系統(tǒng)最多可連接 32 個(gè)節(jié)點(diǎn),總計(jì) 256 塊 H100 GPU。 新一代 DGX SuperPOD 提供 1 Exaflops 的 FP8 AI 性能,比上一代產(chǎn)品性能高 6 倍,能夠運(yùn)行具有數(shù)萬(wàn)億參數(shù)的龐大 LLM 工作負(fù)載,從而推動(dòng) AI 的前沿發(fā)展。 NVIDIA 創(chuàng)始人兼首席執(zhí)行官黃仁勛表示:“AI 已經(jīng)從根本上改變了軟件的功能和產(chǎn)出方式。利用 AI 來(lái)革新自身所處行業(yè)的公司也意識(shí)到了自身 AI 基礎(chǔ)設(shè)施的重要性。NVIDIA 全新 DGX H100 系統(tǒng)將賦能企業(yè) AI 工廠(chǎng),助力其從數(shù)據(jù)中提煉出我們最具價(jià)值的資源,即‘智能’。"

除了8塊 H100 GPU 以及總計(jì) 6400 億個(gè)晶體管之外,每個(gè) DGX H100 系統(tǒng)還包含兩個(gè) NVIDIA BlueField-3 DPU,以用于卸載、加速和隔離高級(jí)網(wǎng)絡(luò)、存儲(chǔ)及安全服務(wù)。

8個(gè) NVIDIA ConnectX-7 Quantum-2 InfiniBand 網(wǎng)卡能夠提供 400 GB/s 的吞吐量,可用于連接計(jì)算和存儲(chǔ),這一速度比上一代系統(tǒng)提升了一倍。第四代 NVLink 與 NVSwitch相結(jié)合,能夠在每個(gè) DGX H100 系統(tǒng)中的各個(gè) GPU 之間實(shí)現(xiàn) 900 GB/s 的連接速度,是上一代系統(tǒng)的 1.5 倍。 DGX H100 系統(tǒng)使用雙 x86 CPU,能夠與 NVIDIA 網(wǎng)絡(luò)和 NVIDIA 合作伙伴提供的存儲(chǔ)設(shè)備相結(jié)合,使 DGX POD 能夠靈活用于各種規(guī)模的 AI 計(jì)算。 借助 DGX H100 系統(tǒng),DGX SuperPOD 可成為具有可擴(kuò)展性的卓越的企業(yè)級(jí) AI 中心。DGX SuperPOD 中的 DGX H100 節(jié)點(diǎn)和 H100 GPU 由 NVLink Switch 系統(tǒng)和 NVIDIA Quantum-2 InfiniBand 連接,帶寬速度可達(dá) 70 TB/s,比上一代產(chǎn)品高 11 倍。NVIDIA 合作伙伴提供的存儲(chǔ)設(shè)備將經(jīng)過(guò)測(cè)試和認(rèn)證,以滿(mǎn)足 DGX SuperPOD AI 計(jì)算的需求。

多個(gè) DGX SuperPOD 單元可組合使用,為汽車(chē)、醫(yī)療健康、制造、通信、零售等行業(yè)提供開(kāi)發(fā)大型模型所需的 AI 性能。

NVIDIA Eos:運(yùn)行速度最快的超計(jì)算機(jī)

NVIDIA 將使用突破性的新型 AI 架構(gòu)來(lái)構(gòu)建 DGX SuperPOD,賦能 NVIDIA 研究人員的研究工作,推動(dòng)氣候科學(xué)、數(shù)字生物學(xué)和 AI 未來(lái)的發(fā)展。 “Eos”超級(jí)計(jì)算機(jī)將于今年晚些時(shí)候開(kāi)始運(yùn)行,共配備 576 臺(tái) DGX H100 系統(tǒng),共計(jì) 4608 塊 DGX H100 GPU,有望成為全球運(yùn)行速度最快的 AI 系統(tǒng)。 NVIDIA Eos 預(yù)計(jì)將提供 18.4 Exaflops 的 AI 計(jì)算性能,比日本的 Fugaku 超級(jí)計(jì)算機(jī)快 4 倍,后者是目前運(yùn)行速度最快的系統(tǒng)。在傳統(tǒng)的科學(xué)計(jì)算方面,Eos 預(yù)計(jì)將提供 275 Petaflop 的性能。 對(duì)于 NVIDIA 及其 OEM 和云計(jì)算合作伙伴,Eos 將成為其先進(jìn) AI 基礎(chǔ)設(shè)施的藍(lán)圖。

其他新品

NVIDIA早已經(jīng)不是一個(gè)單純的芯片供應(yīng)商了,它們已經(jīng)轉(zhuǎn)型成了一個(gè)全棧公司,除了GPU之外,還提供CPU、DPU產(chǎn)品,甚至還會(huì)跟很多OEM等合作伙伴,把整個(gè)系統(tǒng)都做出來(lái),而且提供各種加速引擎,或者SDK,針對(duì)不同的領(lǐng)域提供不同的解決方案。比如醫(yī)療領(lǐng)域的Clara、智慧城市的Metropolis,自動(dòng)駕駛領(lǐng)域的Drive等等。

在本次GTC大會(huì)上,NVIDIA也介紹了相關(guān)行業(yè)的一些解決方案,比如Clara Holoscan MGX,這是一個(gè)可供醫(yī)療設(shè)備行業(yè)在邊緣開(kāi)發(fā)和部署實(shí)時(shí) AI 應(yīng)用的平臺(tái),專(zhuān)為滿(mǎn)足必要的監(jiān)管標(biāo)準(zhǔn)而設(shè)計(jì)。

Clara Holoscan MGX 能夠擴(kuò)展 Clara Holoscan 平臺(tái),提供一體化的醫(yī)療級(jí)參考架構(gòu)以及長(zhǎng)期軟件支持,以加速醫(yī)療設(shè)備行業(yè)的創(chuàng)新。它通過(guò)處理高吞吐量數(shù)據(jù)流來(lái)提供實(shí)時(shí)洞見(jiàn),將最新的傳感器創(chuàng)新帶到了邊緣計(jì)算。從機(jī)器人手術(shù)到研究生物學(xué)的新方法,外科醫(yī)生和科學(xué)家需要醫(yī)療設(shè)備逐步發(fā)展成為持續(xù)傳感系統(tǒng),進(jìn)而更好地推動(dòng)疾病的研究和治療。

Clara Holoscan MGX 將高性能 NVIDIA Jetson AGX Orin 工業(yè)級(jí)模塊、NVIDIA RTX A6000 GPU 和 NVIDIA ConnectX-7 智能網(wǎng)卡整合到一個(gè)可擴(kuò)展的 AI 平臺(tái)中,提供高達(dá)每秒 254-619 萬(wàn)億次運(yùn)算的 AI 性能。 對(duì)于高吞吐量設(shè)備,ConnectX-7 能夠提供高達(dá) 200 GbE 的帶寬以及用于 GPU 處理的 GPUDirect RDMA 路徑,有助于加快處理速度。它還集成了最新嵌入式安全模塊,該模塊包含負(fù)責(zé)監(jiān)控關(guān)鍵操作、提供遠(yuǎn)程軟件更新和系統(tǒng)恢復(fù)的控制器,以及可實(shí)現(xiàn)最先進(jìn)嵌入式安全的硬件信任根。 醫(yī)療設(shè)備制造商可以直接嵌入 Clara Holoscan MGX,或?qū)⑵溥B接到現(xiàn)有的醫(yī)療設(shè)備安裝平臺(tái),從而使開(kāi)發(fā)者能夠加速 AI 部署和監(jiān)管審批。 Clara Holoscan SDK 專(zhuān)為高性能流式數(shù)據(jù)應(yīng)用程序而設(shè)計(jì),用于構(gòu)建新一代軟件定義設(shè)備。它匯集了預(yù)訓(xùn)練模型和可擴(kuò)展微服務(wù)框架,允許在設(shè)備和邊緣數(shù)據(jù)中心管理和部署應(yīng)用程序,開(kāi)創(chuàng)了行業(yè)的軟件即服務(wù)業(yè)務(wù)模式。Clara Holoscan 開(kāi)發(fā)者套件現(xiàn)已開(kāi)始供貨。

此外,NVIDIA還發(fā)布了60多個(gè)針對(duì)CUDA-X的一系列庫(kù)、工具和技術(shù)的更新,以加速量子計(jì)算和6G研究、網(wǎng)絡(luò)安全、基因組學(xué)、藥物研發(fā)等領(lǐng)域的研究進(jìn)展。

來(lái)自NVIDIA、加州理工學(xué)院、伯克利實(shí)驗(yàn)室、普渡大學(xué)、密歇根大學(xué)和萊斯大學(xué)的研究人員,開(kāi)發(fā)了一個(gè)名為FourCastNet的天氣預(yù)報(bào)AI模型。FourCastNet是一種基于物理信息的深度學(xué)習(xí)模型,可以預(yù)測(cè)颶風(fēng),大氣河、以及極端降水等天氣事件。

FourCastNet以歐洲中期天氣預(yù)報(bào)中心長(zhǎng)達(dá)40年的模擬增強(qiáng)型真值數(shù)據(jù)為基礎(chǔ),學(xué)會(huì)了如何預(yù)測(cè)天氣。深度學(xué)習(xí)模型首次在降水預(yù)測(cè)方面達(dá)到了比先進(jìn)的數(shù)值模型更高的準(zhǔn)確率和技能,并使預(yù)測(cè)速度提高了4到5個(gè)數(shù)量級(jí)。也就是說(shuō)傳統(tǒng)的數(shù)值模擬需要一年的時(shí)間,而現(xiàn)在只需要幾分鐘。

大氣河是天空中巨大的水汽河流,每條河流的水量都比亞馬遜河的還要多。他們一方面為美國(guó)西部提供了關(guān)鍵的降水來(lái)源,但另一方面,這些巨大的強(qiáng)風(fēng)暴也會(huì)導(dǎo)致災(zāi)難性的洪災(zāi)和暴雪。

NVIDIA創(chuàng)建了Physics-ML模型,該模型可以模擬全球天氣模式的動(dòng)態(tài)變化。以超乎想象的速度和準(zhǔn)確性預(yù)測(cè)大氣河等極端天氣事件。此GPU加速的AI數(shù)字孿生模型名為FourCastNet,由傅里葉神經(jīng)算子提供動(dòng)力支持,基于10TB的氣球系統(tǒng)數(shù)據(jù)進(jìn)行訓(xùn)練,依托這些數(shù)據(jù),以及NVIDIA Modulus和Omniverse,我們能夠提前一周預(yù)測(cè)災(zāi)難性大氣河的精確路線(xiàn),在一個(gè)NVIDIA GPU的助力下,F(xiàn)ourCastNet只需要幾分之一秒即可完成預(yù)測(cè)。

在黃仁勛看來(lái),Transformer模型開(kāi)啟了自監(jiān)督學(xué)習(xí),并解除了人工標(biāo)記數(shù)據(jù)的需求。因此,我們可以使用龐大的訓(xùn)練集來(lái)訓(xùn)練Transformer模型,學(xué)習(xí)更充分且可靠的特征。

得益于Transformer,模型和數(shù)據(jù)的規(guī)模皆已擴(kuò)大增長(zhǎng),而模型技能和準(zhǔn)確性也因此快速提升。用于語(yǔ)言理解的Google BERT,用于藥物研發(fā)的NVIDIA MegaMolBart,以及DeepMind的AlphaFold,都是基于Transformer模型的突破性成果。

NVIDIA Triton是一款開(kāi)源的、超大規(guī)模的模型推理服務(wù)器,是AI部署的“中央車(chē)站”,Triton支持在每一代NVIDIA GPU、X86和Arm CPU上部署模型,并具備支持AWS Inferentia等加速器的接口。Triton支持各類(lèi)模型:CNN、RNN、Transformer、GNN、決策樹(shù),還支持各類(lèi)框架:TensorFlow、PyTorch、Python、ONNX、XGBoost;Triton支持各類(lèi)查詢(xún)類(lèi)型:實(shí)時(shí)、離線(xiàn)、批處理,或串流視頻和音頻。

Triton支持各類(lèi)機(jī)器學(xué)習(xí)平臺(tái):AWS、Azure、Google、阿里巴巴、VMWare、Domino Data Lab、OctoML等。

Triton可以在各個(gè)地方運(yùn)行,云、本地、邊緣或嵌入式設(shè)備。

Amazon Shopping正在使用Triton進(jìn)行實(shí)時(shí)拼寫(xiě)檢查,而微軟正藉由Triton為翻譯服務(wù)提供支持,Triton已經(jīng)被25000位客戶(hù)下載超過(guò)100萬(wàn)次。

NVIDIA Riva是一種先進(jìn)且基于深度學(xué)習(xí)的端到端語(yǔ)音AI,它可以自定義調(diào)整優(yōu)化。Riva已經(jīng)過(guò)預(yù)訓(xùn)練,具有世界一流的識(shí)別率,客戶(hù)可以使用定制數(shù)據(jù)調(diào)優(yōu)。使其學(xué)習(xí)行業(yè)、國(guó)家和地區(qū),或公司的特定話(huà)術(shù)。黃仁勛認(rèn)為,Riva是對(duì)話(huà)式AI服務(wù)的理想選擇。

Maxine是一個(gè)AI模型工具包,現(xiàn)已擁有30個(gè)先進(jìn)模型,可優(yōu)化實(shí)時(shí)視頻通信的視聽(tīng)效果。比如開(kāi)遠(yuǎn)程視頻會(huì)議時(shí),Maxine可實(shí)現(xiàn)說(shuō)話(huà)者與所有參會(huì)者保持眼神交流,并能將說(shuō)的語(yǔ)言實(shí)時(shí)切換成另一種語(yǔ)言,而且音色聽(tīng)起來(lái)不變。

還有面向推薦系統(tǒng)的AI框架Merlin的1.0版本,Merlin可幫助企業(yè)快速構(gòu)建、部署和擴(kuò)展先進(jìn)的AI推薦系統(tǒng)。比如,微信用Merlin將短視頻推薦延遲縮短為原來(lái)的1/4,并將吞吐量提升了10倍。從CPU遷移至GPU,騰訊在該業(yè)務(wù)上的成本減少了1/2。

以及Omniverse,在黃仁勛看來(lái),作為虛擬世界的仿真引擎,Omniverse平臺(tái)能遵循物理學(xué)定律,構(gòu)建一個(gè)趨真的數(shù)字世界,可以應(yīng)用于使用不同工具的設(shè)計(jì)師之間的遠(yuǎn)程協(xié)作,以及工業(yè)數(shù)字孿生。

用于構(gòu)建數(shù)字?jǐn)伾腘VIDIA Omniverse 軟件,以及全新數(shù)據(jù)中心NVIDIA OVX系統(tǒng),將成為“以行動(dòng)為導(dǎo)向的AI"的組成部分。

"Omniverse是我們機(jī)器人平臺(tái)的核心。像 NASA和亞馬遜一樣,我們和機(jī)器人以及工業(yè)自動(dòng)化領(lǐng)域的客戶(hù)都意識(shí)到了數(shù)字?jǐn)伾蚈mniverse 的重要性。"

黃仁勛解釋說(shuō),OVX將使用Omniverse數(shù)字?jǐn)伾M(jìn)行大規(guī)模模擬,使多個(gè)自主系統(tǒng)在同一時(shí)空運(yùn)行。

OVX 的骨干是其網(wǎng)絡(luò)編織架構(gòu),為此他發(fā)布了NVIDIA Spectrum-4高性能數(shù)據(jù)基礎(chǔ)架構(gòu)平臺(tái)。

全球首400Gbps端到端網(wǎng)絡(luò)平臺(tái)NVIDIA Spectrum -4由Spectrum-4 交換機(jī)系列、NVIDIA ConnectX-7 SmartNIC、NVIDIA BlueField-3 DPU 和 NVIDIA DOCA 數(shù)據(jù)中心基礎(chǔ)設(shè)施軟件組成。

為了讓更多的用戶(hù)能夠使用Omniverse, 黃仁勛發(fā)布了Omniverse Cloud。現(xiàn)在只需簡(jiǎn)單的點(diǎn)擊操作,協(xié)作者就可以通過(guò)云端Omniverse 進(jìn)行連接。

另外,黃仁勛認(rèn)為下一波AI浪潮是機(jī)器人,NVIDIA正在構(gòu)建多個(gè)機(jī)器人平臺(tái),包括用于自動(dòng)駕駛汽車(chē)的DRIVE、用于操縱和控制系統(tǒng)的Isaac、用于自主式基礎(chǔ)架構(gòu)的Metropolis、用于醫(yī)療設(shè)備的Holoscan等。

原文標(biāo)題:AI工廠(chǎng)時(shí)代來(lái)臨,黃教主帶來(lái)全新Hopper架構(gòu)GPU、超級(jí)計(jì)算機(jī)和軟件等新品

文章出處:【微信公眾號(hào):電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

審核編輯:湯梓紅

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5075瀏覽量

103553 -

gpu

+關(guān)注

關(guān)注

28文章

4768瀏覽量

129234 -

晶體管

+關(guān)注

關(guān)注

77文章

9744瀏覽量

138740 -

AI

+關(guān)注

關(guān)注

87文章

31490瀏覽量

269975 -

H100

+關(guān)注

關(guān)注

0文章

31瀏覽量

299

原文標(biāo)題:?AI工廠(chǎng)時(shí)代來(lái)臨,黃教主帶來(lái)全新Hopper架構(gòu)GPU、超級(jí)計(jì)算機(jī)和軟件等新品

文章出處:【微信號(hào):elecfans,微信公眾號(hào):電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

USB AOC線(xiàn)纜有哪些特別之處

東京裸機(jī)云大寬帶服務(wù)器的特別之處

《算力芯片 高性能 CPUGPUNPU 微架構(gòu)分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

英偉達(dá)H100芯片市場(chǎng)降溫

馬斯克自曝訓(xùn)練Grok 3用了10萬(wàn)塊NVIDIA H100

英偉達(dá)Blackwell架構(gòu),行業(yè)首選

進(jìn)一步解讀英偉達(dá) Blackwell 架構(gòu)、NVlink及GB200 超級(jí)芯片

NVIDIA推出兩款基于NVIDIA Ampere架構(gòu)的全新臺(tái)式機(jī)GPU

英特爾發(fā)布人工智能芯片新版,對(duì)標(biāo)Nvidia

英偉達(dá)發(fā)布超強(qiáng)AI加速卡,性能大幅提升,可支持1.8萬(wàn)億參數(shù)模的訓(xùn)練

英偉達(dá)H200和H100的比較

H100 GPU供應(yīng)改善,AI市場(chǎng)需求依舊強(qiáng)勁

NVIDIA H100 GPU交貨周期縮短,部分公司轉(zhuǎn)向銷(xiāo)售或減單

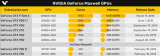

NVIDIA的Maxwell GPU架構(gòu)功耗不可思議

NVIDIA全新Hopper架構(gòu)H100 GPU芯片的特別之處

NVIDIA全新Hopper架構(gòu)H100 GPU芯片的特別之處

評(píng)論