隨著信息科技的進步,數據的收集變得十分便利。不同來源的信息與數據,通過數據挖掘技術,又可以進一步影響著我們的生活,并提升我們的生活品質。近日,在英特爾召開的主題為“顛覆性研究 開啟計算未來十年”的“2020英特爾研究院開放日”上,英特爾高級院士、副總裁、英特爾研究院院長Rich Uhlig率眾專家為我們分享了英特爾研究院在集成光電、神經擬態計算、量子計算、保密計算和機器編程五個領域所做的前沿研究及其科研成果。

Rich介紹說:“我們認為這五個領域能夠真正大規模釋放數據價值,并且變革人們與數據互動的方式。其實未來早已到來,只是分布不均。英特爾的目標是讓每個人都能獲得百億億次級計算。”英特爾正致力于多個數量級的提升,他們將其簡稱為“追求1000倍提升”(In pursuit of 1000X)”

集成光電 集成光電旨在將光科學與大規模芯片生產的成本效益相結合。眾所周知,光互連(optical)在長距離、遠程和地下傳輸中占主導地位,而電氣互連(electrical)在短距離、主板互連(board to board)和封裝互連(package to package)中占主導地位。

英特爾首席工程師、英特爾研究院PHY研究實驗室主任James Jaussi介紹說:“英特爾的愿景是將光互連引入到服務器中,為此他們開發出了硅光子技術,讓光互連具備硅的高產量、低成本等屬性。”借助集成光電技術,英特爾能夠將 I/O 數量從幾百萬個擴展到幾十億個,實現 1000 倍的提升。據介紹,未來的光鏈路將讓所有的I/O連接直接從英特爾的服務器封裝中發出,全面覆蓋整個數據中心。這項技術將徹底改變數據中心網絡架構,并釋放數據,顯著提高數據傳輸效率。

雖然這項技術已經取得了長足的進步,已經為客戶提供了超過 400 百萬個英特爾 100G 收發器產品。不過目前鑒于硅光子模塊和運行功率的成本和物理體積,光互連I/O還不適合短距離傳輸。這也是英特爾要跨越的下一個巨大障礙。此外,James預測說:“展望通信和數據中心性能的未來,光互連和電氣互連方法之間有一個明顯的拐點,主要原因有兩點:首先,我們正快速接近電氣性能的物理極限。

如果不進行根本性創新,高能效電路設計將存在諸多限制。第二是 I/O 功耗墻。計算的帶寬需求大約每三年翻一番。遺憾的是,電氣性能擴展跟不上帶寬需求的增長速度,導致了I/O“功耗墻”,即I/O 功耗會逐漸高于所有現有的插接電源,導致無法計算。”

光互連技術涉及六大技術要素:光產生、光放大、光檢測、光調制、CMOS 接口電路和封裝集成。最近,英特爾在其他五大技術構建模塊上實現了重大創新,這也加速實現其為集成光電構建的關鍵技術模塊的愿景。James認為,這些構建模塊將從根本上革新計算 I/O,并徹底改變未來的數據中心通信趨勢。

首先是光調制。傳統硅調制器體積巨大,占據過多空間,因此放置在 IC 封裝上的成本很高。英特爾實現的一個最新突破就是開發了微型微射線調制器。它們的體積縮小了 1000 倍,因此服務器封裝上可以放置幾百個這樣的器件。

第二項突破是光探測--全硅光電探測器(all-silicon photo detector)。幾十年來,業界一直認為硅幾乎不具備光探測能力。英特爾證明了事實并非如此。這項突破的一個主要優勢是降低了成本。

第三個是光放大。它和激光器一樣重要。如果要降低總功耗,那么集成半導體光學放大器將是不可或缺的技術。因此,如果沒有集成激光器,就不可能有這些放大器。

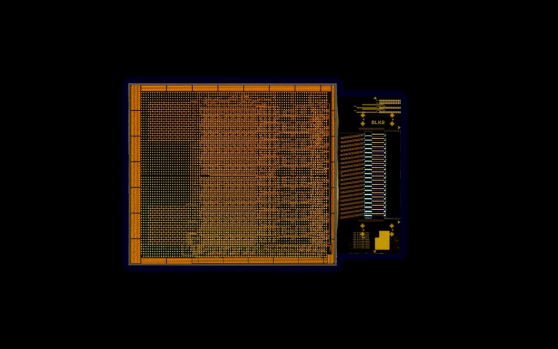

最后,英特爾通過協同集成將CMOS 電路和硅光子技術整合起來。今年二月,英特爾發布了 3D 堆疊 CMOS 電路,在該電路中兩個 IC 上下堆疊,與光子直連。截至目前,其他公司沒有展示過將集成激光器、半導體光學放大器、全硅光電探測器和微型環調制器集成在一個與CMOS硅緊密集成的單個技術平臺上。

神經擬態計算

近幾年,隨著深度學習的出現,人工智能領域取得了驚人的進展,但與此同時,進展的代價是人工智能系統功耗不斷增加。訓練一個現代人工神經網絡需要使用數千臺集群服務器,功耗高達數百萬瓦。它正逐漸變成人工智能不斷發展、以及廣泛普及的瓶頸。那么,如何才能將人工智能任務的能效提高 1000 倍呢?

英特爾試圖找到一種更通用的人工智能架構,能實時解決各種類型的問題,從規劃問題到優化問題并且能夠以比今天的常規方法快得多的速度,實現模式匹配和深度學習模型所能做到的,并且使用更加節能的解決方案。它是一種非常基本的、自下而上的角度,直接從神經科學中獲取靈感。目標是要開發出比現有的更通用的可編程架構。

2015年英特爾開始以現代神經科學理解作為靈感開發了一種新型計算機架構。相比傳統計算機架構,神經擬態架構完全模糊了內存和處理之間的界限。和大腦一樣,它利用的是數據連接、數據編碼和電路活動中所有形式的稀疏(sparsity)。處理就發生在信息到達時,二者同步進行。計算是數百萬個簡單處理單元之間動態交互的發展結果,就像大腦中的神經元一樣。

這種新型計算機架構旨在將能效、實時數據處理速度、學習數據的效率等提升多個數量級。英特爾高級首席工程師、英特爾研究院神經擬態計算實驗室主任Mike Davies 介紹說:“我們的目標是支持廣泛的工作負載,而不僅僅只有深度學習。因為大腦解決問題的范圍很大,所以我們認為這個目標是可以實現的。我們認為還可以將這種架構從邊緣擴展到數據中心,鑒于自然界中大腦容量的巨大差異,從螞蟻到鸚鵡,再到人類的大腦。”

2017 年英特爾發布了首款神經擬態研究芯片Loihi。該芯片采用英特爾主流的14 納米制程技術制造而成。相比其他神經擬態芯片,Loihi 具有前所未有的靈活性、集成性和速度。它還具有片上學習功能,遠遠超出了目前使用的所有芯片。Loihi 沒有深度學習硬件中普遍存在的浮點數和乘法累加器單元。

Loihi 沒有片外內存接口。和大腦一樣,所有計算都在芯片上進行,通過二進制脈沖信息和低精度信號。內存來源于芯片神經元之間的連接。Loihi 采用同質架構,將許多小神經擬態核實例化,每個核的大小只有針頭的一部分。通過將神經擬態結構從幾核擴展到幾百核,可以將小型的專用工作負載擴展至 CPU 或 GPU 大小的芯片。甚至還可以無縫排列這些芯片。

此外,英特爾特別成立了英特爾神經擬態研究社區,簡稱 INRC,借此與世界各地不同類型的學術界、政府實驗室和企業的研究人員交流合作。到截至目前,INRC 已經發表了40 多篇經過同行評審的論文,其中許多論文中都記錄了量化結果,證明這項技術能夠帶來有效的性能提升。部分機器人工作負載顯示,Loihi 的功耗比傳統解決方案低 40-100 倍。Mike表示:“盡管 Loihi 的基準評測結果令人驚嘆,但我們仍然缺乏統一的編程框架將這些示例整合到更大規模的功能系統中。這些問題代表著神經擬態研究的最前沿。”

據介紹,短期內,由于成本問題,該技術要么僅適用于邊緣設備、傳感器等小規模設備,要么僅適用于對成本不敏感的應用,如衛星、專用機器人。隨著時間的推移,英特爾預計內存技術的創新能夠降低成本,讓神經擬態解決方案擴大適用范圍,運用于各種需要實時處理數據但受限于體積、重量、功耗等因素的智能設備。今年是英特爾針對神經擬態計算研究的第五年,他們非常看好神經擬態計算的前景,并且堅信,神經擬態計算未來將幫助各種應用實現巨大突破。Mike分享說:“我們將在 2021 年第 1 季度發布下一代Lava軟件開發框架的開源版本,以此能夠觸及到更龐大的軟件開發人員社區。”

量子計算

量子計算是近年來一個非常活躍的研究領域,如果我們能夠解決相關的科學與工程問題以支持它們大規模運行,它們將變得非常強大。比如設計新藥物和改進藥物會對醫療健康產生重要影響,而這也是量子計算未來的一個潛在應用領域。其他應用領域包括設計新型材料和化學催化劑。在這些應用領域,很多材料都是經典計算機無法模擬的。

英特爾高級首席工程師、英特爾研究院量子應用與架構總監Anne Matsuura認為:“商用級量子計算機將支持模擬這些材料,方便將來設計具有獨特屬性的材料、化學用品和藥物。但目前僅僅有 100 個量子位甚至數千個量子位的量子計算系統,我們需要開發包含數百萬個量子位的全棧商用級量子計算系統,才能達到量子實用性來解決這類復雜問題。”據介紹,英特爾的量子研究主要集中在自旋量子位技術、低溫控制技術和全棧創新等關鍵領域。每一個領域都旨在解決通往量子計算可擴展性道路上的關鍵挑戰,英特爾正在系統地布局每一個領域,以實現量子擴展。

首先,擴展量子的最大挑戰,就是如何批量生產高質量量子位。重點其實并不只是量子位的數量。目前我們看到的小型量子計算系統中所使用的量子位,其質量對于商用級量子系統來說是遠遠不夠的。我們需要壽命足夠長、相互之間連接性足夠強的量子位,以便擴展至包含數百萬量子位的商用級量子計算機,能夠在實際的應用領域執行有效的量子程序或量子算法。自旋量子位與英特爾的晶體管技術非常相似,可提供最佳的發展路徑。英特爾量子研究的優勢在于,他們構建量子位的晶圓廠實際上同樣用于開發最新、最出色的制程節點。

量子計算面對的第二個挑戰是量子位控制。英特爾在這一領域取得了巨大進展。當前,量子位主要由許多機架(rack)的控制電路進行控制,這些電路通過復雜的布線連接至量子位,并且被放置在低溫冰箱中,以防止熱噪聲和電噪聲影響脆弱的量子位。對于商用級量子計算系統,需要將數百萬根導線引入量子位室(qubit chamber)。這樣不具備可擴展性。英特爾采用支持可擴展互連的低溫量子位控制芯片技術,以解決這一挑戰,并開發了世界一流的低溫控制芯片,該芯片基于 22 納米 FinFET 技術,可以在低溫冰箱內進行集成。

量子計算面對的第三個挑戰是糾錯。全面糾錯需要數十個量子位形成一個邏輯量子位。英特爾正在開發抗噪量子算法和錯誤抑制技術,幫助在目前的小型量子位系統上運行這些算法。

量子計算面對的第四個挑戰是,需要可擴展的全棧量子計算機。由于量子計算是一種全新的計算類型,運行程序的方式完全不同,因此需要開發量子專用的軟件、硬件和應用。這也意味著,從應用、編譯器、量子位控制處理器、控制電路,到量子位芯片器件,量子計算的整個堆棧都需要采用全新組件。英特爾正在開發整個量子計算堆棧的所有組件,并這些量子組件協同工作。

英特爾正在逐步實現商用級量子計算的愿景。Anne分享說:“英特爾發展量子計算的方法就是利用英特爾的優勢,特別是利用英特爾在芯片和電路制造工藝方面的專長。目標是達到數百萬個量子位的規模,并且我們相信,我們所選擇的自旋量子位技術在低溫測試和控制方面所取得的進步,集成光子以及所采用的全棧系統方法,將引領我們率先實現這一目標。”

保密計算

釋放數據潛力除了傳輸數據方面的挑戰外,保護數據隱私也是當前所面臨的障礙之一,尤其是在醫療、金融服務等許多領域,數據所有者可能需要遵循相關法規,最大的數據集往往都被限制在所謂的數據孤島中。然而,這些數據孤島對使用機器學習工具從數據中獲取重要洞察造成了巨大障礙。為了解決這些問題,英特爾一直在推動保密計算的發展。

本世紀初,英特爾研究院就開始研究如何隔離應用,結合硬件訪問控制技術和加密技術,以提供保密性和完整性保護。例如最新的英特爾軟件保護擴展(Software Guard Extensions )技術,它將保密性、完整性和認證功能整合在一起,確保使用中的數據安全無虞。英特爾研究院安全智能化項目組首席工程師Jason Martin介紹,當前加密解決方案主要用于保護在網絡中發送以及存儲的數據。但數據在使用過程中依然容易遭遇攻擊。保密計算旨在保護使用中的數據。為此,英特爾提供數據保密性以防止機密泄露,提供執行完整性以防止計算被篡改,并提供認證功能,以驗證軟硬件的真實性。此外,英特爾還在研究另一種不需要解密數據的方法,叫做同態加密(homomorphic encryption)。

據了解,完全同態加密是一種全新的加密系統,它允許應用在不暴露數據的情況下,直接對加密數據執行計算操作。該技術已逐漸成為委托計算中用于保護數據隱私的主要方法。例如,這些加密技術允許直接對加密數據進行云計算,不需要信任云基礎設施、云服務或其他使用者。傳統加密要求云服務器訪問密鑰,才能解鎖數據用于處理。同態加密允許云對密文或加密數據執行計算操作,然后將加密結果返回給數據所有者,從而簡化并保護了這一過程。結果表明,任何計算都可以由加法和乘法構成。Jason分享說:“在完全同態加密中,你可以用任意復雜度的算法對加密數據執行這些基本操作。之后解密數據時,這些操作適用于純文本。”

不過,Jason也表示,目前仍存在一些挑戰,阻礙了完全同態加密的采用。在傳輸和存儲數據時,傳統加密機制的開銷相對來說可以忽略不計,但在完全同態加密中,同態密文的篇幅比純數據大得多,有時候大 1,000-10,000 倍。數據激增將導致計算激增。密文的增加,要求處理能力隨之增加。處理開銷不僅會隨著數據的增加而增加,還會隨著計算復雜性的增加而增加。就是因為這些巨大的開銷,導致同態加密尚未得到廣泛使用。英特爾正在研究新的軟硬件方法,希望普及這項技術,并與生態系統和標準機構開展合作。

機器編程

編程目前出現了兩種對立的趨勢。首先,計算資源變得越來越異構化,因為我們對某些種類的工作負載進行了專業化處理。所以需要專家級的程序員,因為他們非常了解硬件以及如何最大限度地利用硬件。但與此同時,軟件開發人員越來越青睞于使用更抽象的語言,以提高工作效率。這反過來會導致硬件難以發揮出它本身的性能。并且這種差距正在擴大。為此。英特爾一直致力于引入新的方法教計算系統自己編程,即機器編程。

機器編程與機器學習有很大的不同,機器編程是教系統自己編程。它的核心原則是,人類向機器表達他(她)的意圖,機器會自動創建完成該意圖所需的所有軟件。自動生成軟件領域是機器編程的核心重點。機器編程實際上是構建系統,然后由系統自行構建自己的軟件系統。而硬件系統作為副產品,也隨之構建起來。英特爾致力于讓機器編程同時從兩個方向發力。首先,希望機器編程系統能夠提高編碼員和非編碼員的工作效率。第二,希望確保機器編程系統生成的是高質量、快速、安全的代碼。如果做不到這兩點,就不能真正地幫助到開發人員。

基于這兩個核心價值觀,英特爾首席科學家、英特爾研究院機器編程研究主任及創始人Justin Gottschlich認為,機器編程關鍵的第一步是改進軟件調試(Debug)。軟件Debug在本質上就是識別、分析和糾正軟件缺陷的過程。然而,Debug嚴重影響了程序員的工作效率。2017 年劍橋大學開展的一項調查顯示,美國程序員平均花費 50%的時間用在Debug上,這是很長的時間。除了提高魯棒性,英特爾還希望能夠減少Debug時間。

Justin介紹,機器編程有三大支柱,分別是意圖(intention)、創造(invention)和適應(adaptation)。這三大支柱,是英特爾創新方法的核心驅動力之,也是許多學術界和產業界合作伙伴的核心驅動力之一。Justin分享說,英特爾已經開發了兩個具體的系統,現在正在將它們集成到生產級系統中。

l 2019年,英特爾在NeurIPS 上發布第一個可以自動檢測性能漏洞的機器編程系統。這個系統實際上發明了用于檢測性能問題的測試。有了這個系統,人類不用編寫一行代碼。最重要的是,同一個系統可以自動將發明的測試應用于不同的硬件架構上。這就解決了硬件異構問題。

l 2020年,英特爾構建了第二個系統,并且已經在NeurIPS 2020上展示了這項研究。該系統也是嘗試查找漏洞,但它不僅限于查找性能漏洞,它可以在無人監督的情況下識別漏洞。在機器學習領域,這意味著它可以在沒有任何人類生成的數據標簽下學習。最近該系統剛剛突破了從超過 10 億行代碼中學習的極限。并且每次添加更多數據,它似乎都能學到以前沒有觀察到的新事物。

責任編輯:xj

原文標題:英特爾披露集成光電、神經擬態計算、量子計算等五大前沿最新進展

文章出處:【微信公眾號:MEMS】歡迎添加關注!文章轉載請注明出處。

-

英特爾

+關注

關注

61文章

10007瀏覽量

172152 -

量子計算

+關注

關注

4文章

1110瀏覽量

35014 -

神經計算

+關注

關注

0文章

12瀏覽量

4167

原文標題:英特爾披露集成光電、神經擬態計算、量子計算等五大前沿最新進展

文章出處:【微信號:MEMSensor,微信公眾號:MEMS】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

英特爾與火山引擎等合作,夯實AI應用智能底座

IC China 2024北京開幕:英特爾分享洞察,促智能計算應用落地

祝賀!億達科創榮獲高交會“優秀科研成果創新獎”

中科曙光鑄穩算力底座,賦能科研成果落地

海康微影DV式手持測溫熱像儀助力提升科研效率

芯海科技edge BMC首秀2024英特爾網絡與邊緣計算行業峰會

芯海科技edge BMC首秀2024英特爾網絡與邊緣計算行業峰會

【《計算》閱讀體驗】量子計算

英特爾推出集成光學計算互聯OCI Chiplet芯片

英特爾實現光學IO芯粒的完全集成

英特爾集成光電、量子計算等五大領域前沿研究及其科研成果

英特爾集成光電、量子計算等五大領域前沿研究及其科研成果

評論