導讀

國際表示學習大會(TheInternationalConference onLearningRepresentations)是致力于人工智能領域發展的國際知名學術會議之一。ICLR 2021 將在明年5月4日舉行,目前,本次大會投稿已經結束,最后共有3013篇論文提交。ICLR 采用公開評審機制,任何人都可以提前看到這些論文。

為了分析最新研究動向,我們精選了涵蓋自監督學習、Transformer、圖神經網絡、自然語言處理、模型壓縮等熱點領域,將分多期為大家帶來系列論文解讀。

本期的關注焦點是自監督學習與Transformer。

自監督學習

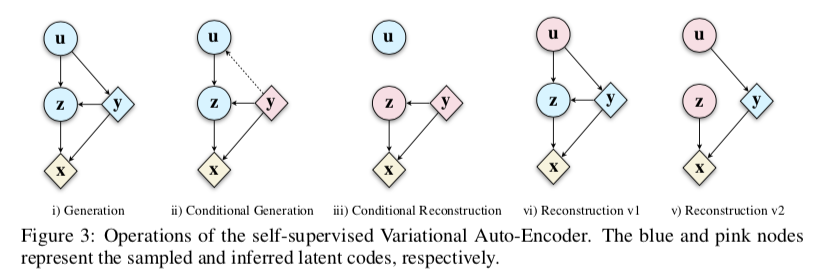

Self-Supervised Variational Auto-Encoders

變分自編碼器(VAE)往往通過假設先驗分布為高斯分布來簡化計算過程,實際上真實數據的分布往往較為復雜,該假設會導致模型的過正則化并影響模型對真實分布的擬合能力;本文通過利用多個簡單分布對復雜真實分布進行建模,并采用自監督方法對這些分布之間進行約束,進而提升VAE模型最終的效果。

論文鏈接:https://openreview.net/forum?id=zOGdf9K8aC

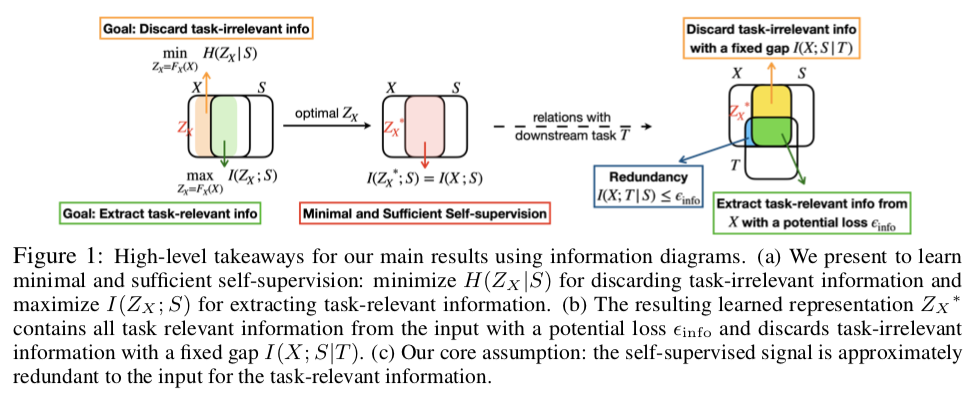

Self-Supervised Learning from a Multi-View Perspective

即使自監督學習已經取得了很好的效果,現有的方法依舊并不清楚自監督學習帶來增益的主要原因;本文基于信息空間的考慮,認為自監督學習通過減少不相關信息來幫助收斂;此外本文還提出將自監督任務的兩個經典方法——對比學習和預測學習任務進行合并,結合兩者優點以增強自監督學習的效果。

論文鏈接:https://openreview.net/forum?id=-bdp_8Itjwp

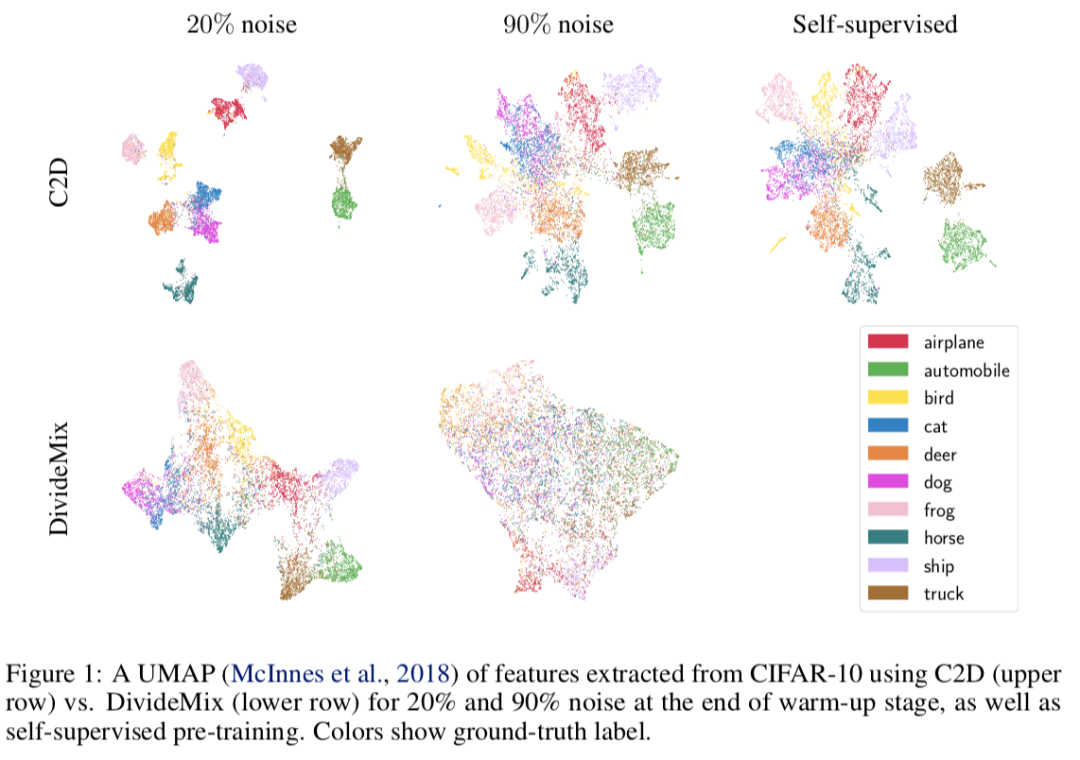

Contrast to Divide: Self-Supervised Pre-Training for Learning with Noisy Labels

現有的噪聲數據學習策略往往基于loss的噪聲識別與再過濾的框架,其需要模型在warm-up階段既能學習到足夠好的特征信息,同時不至于過分擬合噪聲數據的分布;改目的與對比學習任務非常契合,本文提出在warm-up階段采用對比學習幫助進行特征學習,并基于對比學習策略幫助區分噪聲數據。

論文鏈接:https://openreview.net/forum?id=uB5x7Y2qsFR

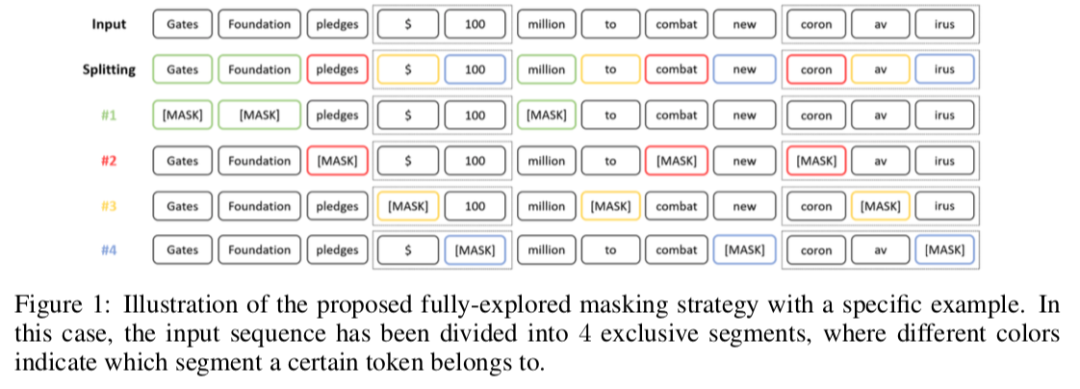

Improving Self-Supervised Pre-Training via a Fully-Explored Masked Language Model

現有的BERT等模型往往采用masked language model進行自監督學習,但是其往往采用隨機的方法確定mask的word或者span;本文提出不合適的mask會導致梯度方差變大,并影響模型的效果,并分析原因在于同時mask的word之間具有一定的相似度;故本文提出一種特殊的mask機制,其考慮增大被mask的word之間的差異,進而削弱梯度方差大帶來的影響。

論文鏈接:https://openreview.net/forum?id=cYr2OPNyTz7

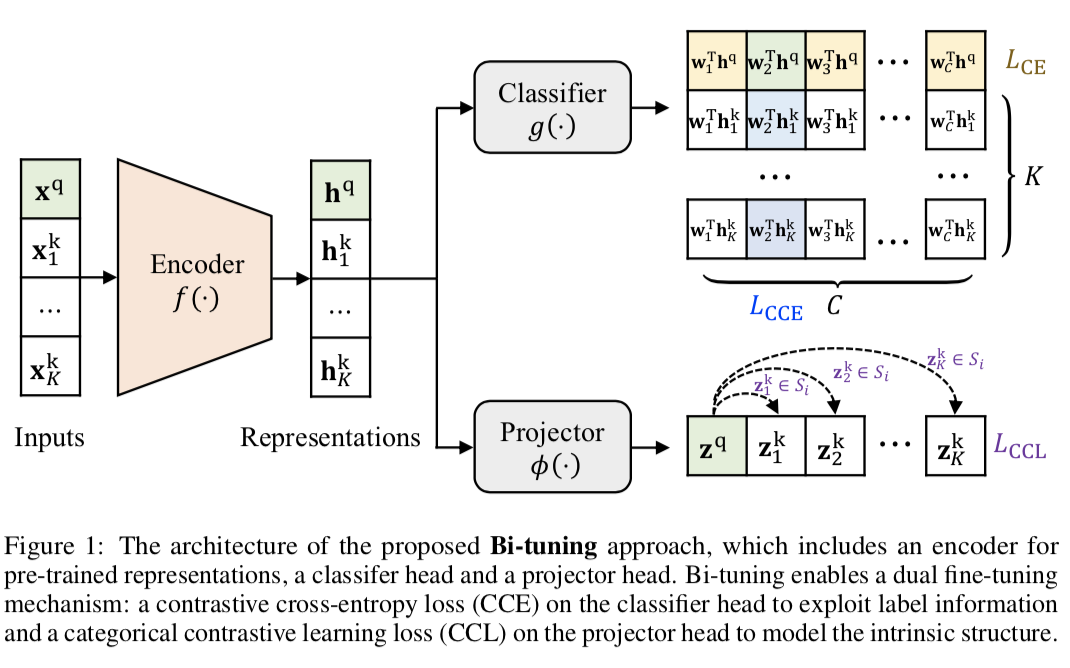

Bi-Tuning of Pre-Trained Representations

隨著預訓練模型的快速發展,現有方法主要關注于如何進行pre-train,但是很少關注如何進行fine-tune;本文認為在fine-tune時模型很容易忘記預訓練的信息并過擬合到當前任務,因此提出了一種特殊的Bi-tune策略,即利用對比學習作為正則項約束模型的收斂情況,進而幫助提升模型的效果。

論文鏈接:https://openreview.net/forum?id=3rRgu7OGgBI

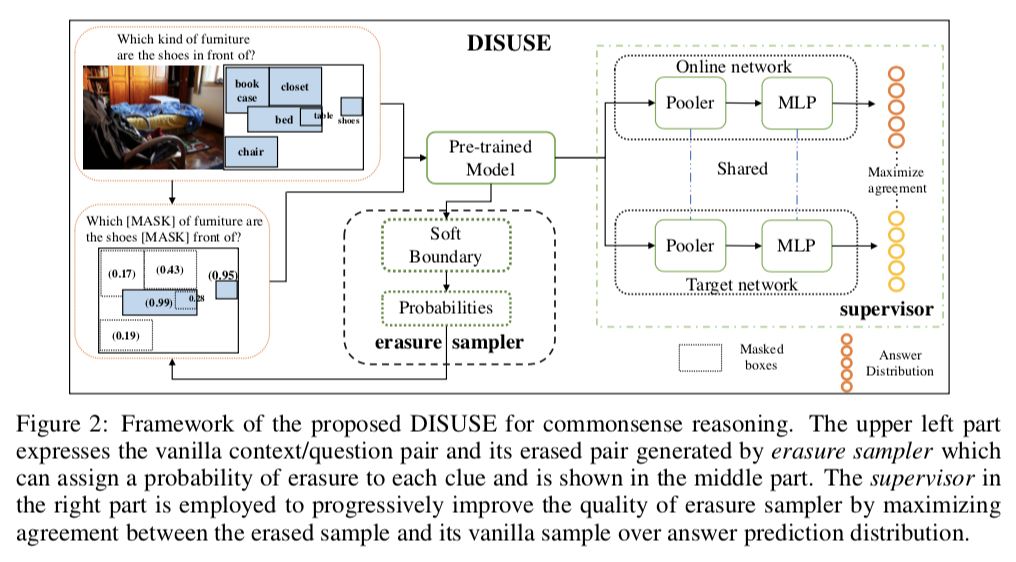

Erasure for Advancing: Dynamic Self-Supervised Learning for Commonsense Reasoning

為了解決預訓練模型很難學習到更精準的 question-clue pairs 問題,本文提出DynamIcSelf-sUperviSedErasure (DISUSE)。其中包含 erasure sampler 和 supervisor,分別用于擦出上下文和問題中的多余線索,以及使用 self-supervised manner 進行監督。

論文鏈接:https://openreview.net/forum?id=WfY0jNndSn3

Transformer

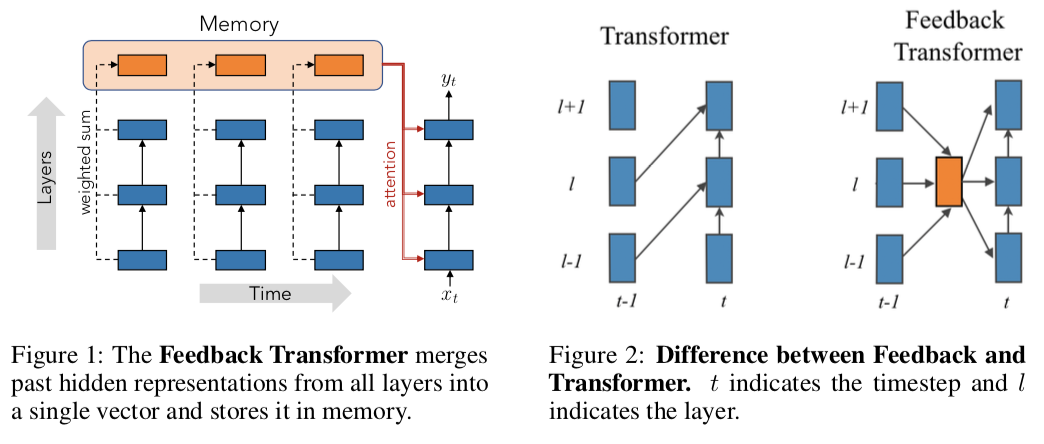

Addressing Some Limitations of Transformers with Feedback Memory

Transformer結構因其并行計算的特性有很高的計算效率,但是這種特性限制了Transformer發掘序列信息的能力,這體現在底層表示無法獲得高層表示信息。作者提出一種Feedback Memory結構,將所有歷史的底層和高層表示信息傳遞給未來表示。

論文鏈接:https://openreview.net/forum?id=OCm0rwa1lx1

Not All Memories are Created Equal: Learning to Expire

Attention機制往往需要長期的記憶,但是實際上并不是所有歷史信息都是重要的。因此,作者提出一種Expire-Span機制,動態地決定每一個時刻信息存活的時間長短,從而減少模型進行Attention操作耗費的空間開銷。

論文鏈接:https://openreview.net/forum?id=ZVBtN6B_6i7

Memformer: The Memory-Augmented Transformer

目前大部分Transformer變體模型在處理長序列時都會存在效率問題。作者提出一種利用Memory機制來編碼和保存歷史信息,使得時間復雜度下降到線性時間,空間復雜度變為常數。

論文鏈接:https://openreview.net/forum?id=_adSMszz_g9

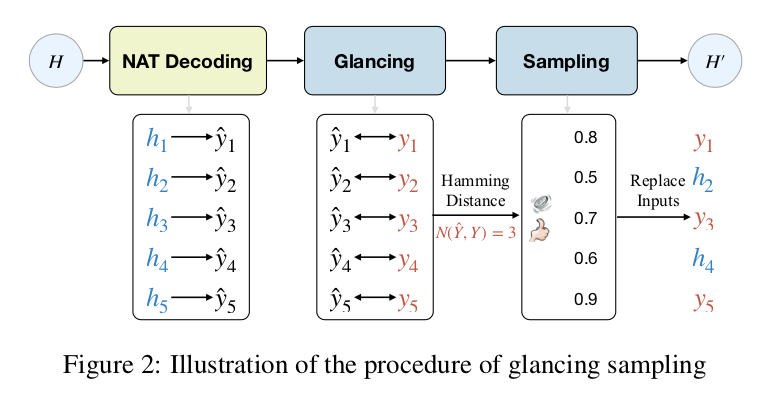

Non-iterative Parallel Text Generation via Glancing Transformer

本文提出了一種基于 glancing language model 的 Glancing Transformer,通過 one-iteration 的生成方式提升 NAT 的性能。其中 Glancing language model,可以通過兩次 decoding 來降低學習難度以及加快生成速度。另外這種方法同樣可以應用于其他基于 NAT 的任務。

論文鏈接:https://openreview.net/forum?id=ZaYZfu8pT_N

責任編輯:xj

原文標題:【ICLR2021必讀】 【自監督學習】 & 【Transformer】相關論文

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

人工智能

+關注

關注

1794文章

47642瀏覽量

239674 -

深度學習

+關注

關注

73文章

5512瀏覽量

121415 -

Transformer

+關注

關注

0文章

145瀏覽量

6034

原文標題:【ICLR2021必讀】 【自監督學習】 & 【Transformer】相關論文

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

港大提出SparX:強化Vision Mamba和Transformer的稀疏跳躍連接機制

時空引導下的時間序列自監督學習框架

【《大語言模型應用指南》閱讀體驗】+ 基礎知識學習

【《大語言模型應用指南》閱讀體驗】+ 基礎篇

Transformer能代替圖神經網絡嗎

神經網絡如何用無監督算法訓練

深度學習中的無監督學習方法綜述

Transformer模型在語音識別和語音生成中的應用優勢

使用PyTorch搭建Transformer模型

基于xLSTM和Transformer的模型評估:xLSTM在“語言能力”的表現

CVPR'24 Highlight!跟蹤3D空間中的一切!

機器學習基礎知識全攻略

OpenAI推出Sora:AI領域的革命性突破

一文詳解Transformer神經網絡模型

自監督學習與Transformer相關論文

自監督學習與Transformer相關論文

評論