基于 AI 目標檢測系統生成的對抗樣本可以使穿戴者面對攝像頭「隱身」。

由美國東北大學林雪研究組,MIT-IBM Watson AI Lab 和 MIT 聯合研發的這款基于對抗樣本設計的 T-shirt (adversarial T-shirt),讓大家對當下深度神經網絡的現實安全意義引發更深入的探討。目前該文章已經被 ECCV 2020 會議收錄為 spotlight paper(焦點文章)。

在人臉識別和目標檢測越來越普及的今天,如果說有一件衣服能讓你在 AI 檢測系統中「消失無形」,請不要感到驚訝。

熟悉Adversarial Machine Learning(對抗性機器學習)的朋友可能不會覺得陌生,早在 2013 年由 Christian Szegedy 等人就在論文 Intriguing properties of neural networks 中首次提出了 Adversarial Examples(對抗樣本)的概念。而下面這張將大熊貓變成長臂猿的示例圖也多次出現在多種深度學習課程中。

很顯然,人眼一般無法感知到對抗樣本的存在,但是對于基于深度學習的 AI 系統而言,這些微小的擾動卻是致命的。

隨著科研人員對神經網絡的研究,針對神經網絡的 Adversarial Attack(對抗攻擊)也越來越強大,然而大多數的研究還停留在數字領域層面。Jiajun Lu 等人也在 2017 年認為:現實世界中不需要擔心對抗樣本(NO Need to Worry about Adversarial Examples in Object Detection in Autonomous Vehicles)。

他們通過大量實驗證明,單純地將在數字世界里生成的對抗樣本通過打印再通過相機的捕捉,是無法對 AI 檢測系統造成影響的。這也證明了現實世界中的對抗樣本生成是較為困難的,主要原因歸于以下幾點:

像素變化過于細微,無法通過打印機表現出來:我們熟知的對抗樣本,通常對圖像修改的規模有一定的限制,例如限制修改像素的個數,或總體像素修改大小。而打印的過程往往無法對極小的像素值的改變做出響應,這使得很多對于對抗樣本非常有用的信息通過打印機的打印損失掉了。

通過相機的捕捉會再次改變對抗樣本:這也很好理解,因為相機自身成像的原理,以及對目標捕捉能力的限制,相機無法將數字領域通過打印得到的結果再次完美地還原回數字領域。

環境和目標本身發生變化:這一點是至關重要的。對抗樣本在生成階段可能只考慮了十分有限的環境及目標的多樣性,從而該樣本在現實中效果會大大降低。

近年來,Mahmood Sharif 等人(Accessorize to a crime: Real and stealthy attacks on state-of-the-art face recognition.)首次在現實世界中,通過一個精心設計的眼鏡框,可以人臉檢測系統對佩戴者做出錯誤的判斷。但這項研究對佩戴者的角度和離攝像頭的距離都有嚴格的要求。之后 Kevin Eykholt 等人(Robust Physical-World Attacks on Deep Learning Visual Classification)對 stop sign(交通停止符號)進行了攻擊。通過給 stop sign 上面貼上生成的對抗樣本,可以使得 stop sign 被目標檢測或分類系統識別成限速 80 的標志!這也使得社會和媒體對神經網絡的安全性引發了很大的探討。

然而,這些研究都還沒有觸及到柔性物體的對抗樣本生成。可以很容易地想象到,鏡框或者 stop sign 都是典型的剛性物體,不易發生形變且這個類別本身沒有很大的變化性,但是 T 恤不同,人類自身的姿態,動作都會影響它的形態,這對攻擊目標檢測系統的人類類別產生了很大的困擾。

最近的一些工作例如 Simen Thys 等人(Fooling automated surveillance cameras: adversarial patches to attack person detection)通過將對抗樣本打印到一個紙板上掛在人身前也可以成功在特定環境下攻擊目標檢測器,但是卻沒有 T 恤上的圖案顯得自然且對對抗樣本的形變和運動中的目標沒有進行研究。

來自美國東北大學,MIT-IBM Watson AI Lab 和 MIT 聯合研發的這款 Adversarial T-shirt 試圖解決上述問題,并在對抗 YOLOV2 和 Faster R-CNN(兩種非常普及的目標檢測系統)中取得了較好的效果。通過采集實驗者穿上這件 Adversarial T-shirt 進行多個場景和姿態的視頻采集,在 YOLOV2 中,可以達到 57% 的攻擊成功率,相較而言,YOLOV2 對沒有穿 Adversarial T-shirt 的人類目標的檢測成功率為 97%。

設計原理

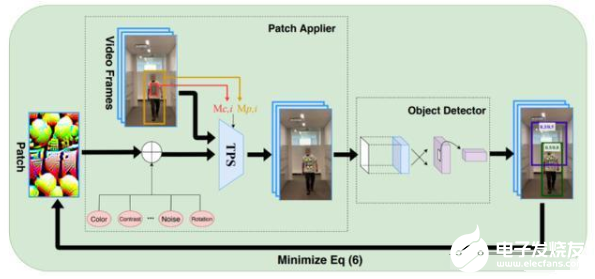

從多個已有的成功的攻擊算法中得到啟發,研究者們通過一種叫 EOT (Expectation over Transformation) 的算法,將可能發生在現實世界中的多種 Transformation(轉換)通過模擬和求期望來擬合現實。這些轉換一般包括:縮放、旋轉、模糊、光線變化和隨機噪聲等。利用 EOT,我們可以對剛性物體進行對抗樣本的生成。

但是當研究者們僅僅使用 EOT,將得到的對抗樣本打印到一件 T 恤上時,僅僅只能達到 19% 的攻擊成功率。這其中的主要原因就是文章上述提到的,人類的姿態會使對抗樣本產生褶皺,而這種褶皺是無法通過已有的 EOT 進行模擬的。而對抗樣本自身也是非常脆弱的,一旦部分信息丟失往往會導致整個樣本失去效力。

基于以上觀察,研究者們利用一種叫做 thin plate spline (TPS) 的變化來模擬衣服的褶皺規律。這種變化需要記錄一些 anchor points(錨點)數據來擬合變化。于是研究者將一個棋盤格樣式的圖案打印到 T 恤上來記錄棋盤格中的每個方塊角的坐標信息,如下圖所示:

這些錨點的坐標可以通過特定的算法自動得到無需手動標記。這樣一個人工構建的 TPS 變化被加入了傳統的 EOT 算法。這使得生成的對抗樣本具備抗褶皺擾動的能力。

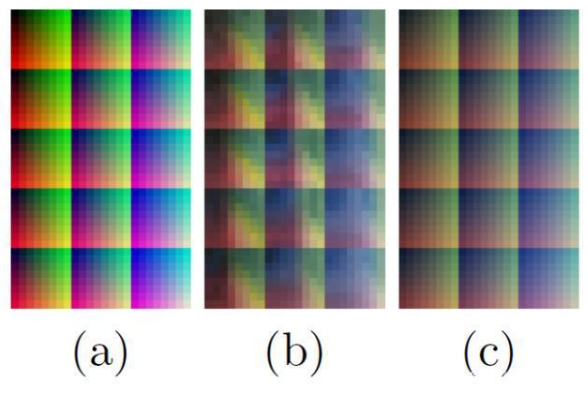

除此之外,研究者們還針對光線和攝像頭可能引起的潛在變化利用一種色譜圖進行的模擬,如下圖所示:(a)數字領域中的色譜圖;(b)該圖通過打印機打印到 T 恤只會在通過相機捕捉到的結果;(c)通過映射 a-b 學到的一種色彩變換。

基于學習出的色彩變化系統,使得生成的對抗樣本能最大限度的接近現實。最終該方法的整體框架如下:

通過增強的 EOT 和顏色轉換系統,最小化 YOLOV2 的檢測置信度,最終得到一個對抗樣本。

除此之外,研究者們也第一次嘗試了 ensemble attack (多模型攻擊)。利用一張對抗樣本同時攻擊兩個目標檢測系統 YOLOV2 和 Faster R-CNN。結果顯示不同于傳統的加權平均的攻擊方,利用魯棒優化技術可以提高對兩個目標檢測系統的平均攻擊成功率。

實驗結果

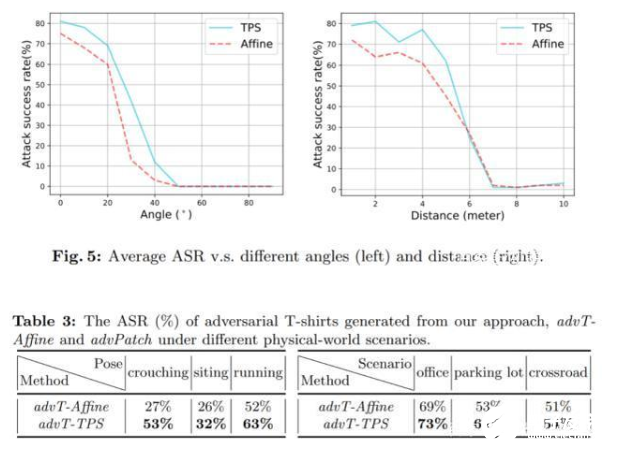

首先,研究者們在數字領域做了基礎的比較試驗,結果發現相較于非剛性變化—仿射變換,TPS 變化可以將攻擊成功率在 YOLOV2 上從 48% 提升到 74%,在 Faster R-CNN 上由 34% 提升到 61%!這證明了對于柔性物體,加入 TPS 變化的必要性。

之后研究人員將這些對抗樣本打印到白色 T 恤上,讓穿戴者在不同場合以各種姿態移動并對其錄制視頻。最后將采集到的所有視頻送入目標檢測系統進行檢測,統計攻擊成功率。

如下面的動圖所示:

最終,在現實世界中,該方法利用 TPS 生成的樣本對抗 YOLOV2 可以達到 57% 的攻擊成功率,相較而言,僅使用仿射變換只能達到 37% 攻擊成功率。

除此之外,研究者們還做了非常詳盡的 ablation study:針對不同場景,距離,角度,穿戴者姿勢進行研究。

結果顯示,提出的方法對距離的遠近和角度變化較為敏感,對不同的穿戴者和背景環境變化表現出的差異不大。

關于 AI 安全的更多討論

生成對抗樣本其實和深度神經網絡的訓練是同根同源的。通過大量樣本學習得到的深度神經網絡幾乎是必然的存在大量的對抗樣本。就像無數從事 Adversarial Machine Learning(對抗性機器學習)的研究者一樣,大家充分意識到了神經網絡的脆弱性和易攻擊性。但是這并沒有阻礙我們對深度學習的進一步研究和思考,因為這種特殊且奇妙的現象來源于神經網絡本身,且形成原因至今沒有明確的定論。而如何構建更加魯棒的神經網絡也是目前該領域的 open issue。

該研究旨在通過指出這種特性,以及它有可能造成的社會潛在危害從而讓更多的人意識到神經網絡的安全問題,最終目的是幫助 AI 領域構建更加魯棒的神經網絡從而可以對這些對抗樣本不再如此敏感。

-

檢測系統

+關注

關注

3文章

966瀏覽量

43489 -

AI

+關注

關注

87文章

33056瀏覽量

273031 -

隱身技術

+關注

關注

1文章

10瀏覽量

7926

發布評論請先 登錄

相關推薦

軒轅智駕紅外目標檢測算法在汽車領域的應用

睿創微納推出新一代目標檢測算法

AI Cube進行yolov8n模型訓練,創建項目目標檢測時顯示數據集目錄下存在除標注和圖片外的其他目錄如何處理?

在目標檢測中大物體的重要性

圖像分割與目標檢測的區別是什么

目標檢測與識別技術的關系是什么

目標檢測識別主要應用于哪些方面

慧視小目標識別算法 解決目標檢測中的老大難問題

評論