基于Ampere架構的GPU計算加速器,專為高性能計算、人工智能和機器學習等領域而設計。它擁有高達6912個CUDA核心(在32GB版本中),是目前最強大的數據中心GPU之一。A100支持更快的訓練速度和更大的模型容量,適用于需要進行大規模并行計算的應用程序。 H100是英偉達公司的InfiniBand適

2023-08-09 17:31:33 32566

32566 A100采用了NVIDIA Ampere架構的突破性設計,該設計為NVIDIA第八代GPU提供了迄今為止最大的性能飛躍,集AI訓練和推理于一身,并且其性能相比于前代產品提升了高達20倍。

2020-05-15 11:48:18 2488

2488 最新發布的NVIDIA A100 PCIe版本以及NVIDIA A100 80GB GPU也迅速成為了包括新華三、浪潮、聯想、寧暢等在內的中國領先系統制造商的首選。

2020-12-15 13:39:18 3020

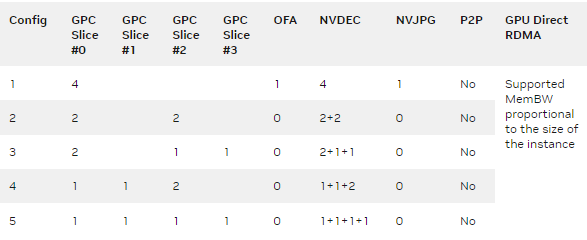

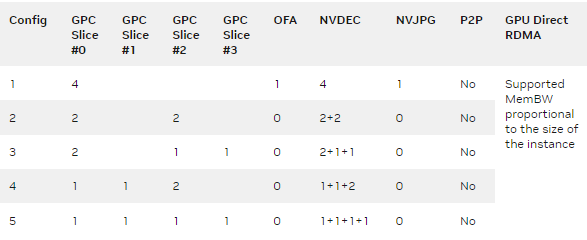

3020 A100 GPU 的新 MIG 功能可以將每個 A100 劃分為多達七個 GPU 加速器以實現最佳利用率,有效提高了 GPU 資源利用率和 GPU 訪問更多用戶和 GPU 加速應用程序。

2022-04-06 09:54:45 7605

7605

、快速傅立葉轉換、光線追蹤和圖像處理。利用ATI的X800XT和Nvidia的GeForce 6800 Ultra型GPU,在相同高速緩存、SSE匯編優化Pentium 4執行條件下,許多此類應用的速度

2016-01-16 08:59:11

大家好,我目前正在為使用XenServer 7.2和NVIDIA M10卡的客戶開發新的XenApp 7.14.1解決方案。在目前階段,我試圖通過分配給每個XenApp服務器的M10-8A vGPU

2018-09-12 16:24:19

安裝顯卡:GPU的用途:做大量復雜的科學運算(暴力破解)NVIDIA 顯卡驅動安裝 apt-get update apt-get dis-upgrade apt-get install -y linux-headers-$(uname -r) apt-get ins tall nvidia-ke...

2021-12-29 06:02:03

TEGRA K1 — 全球的移動處理器[size=13.3333px][size=13.3333px]創新的全新 Tegra K1 處理器包含 NVIDIA Kepler? 架構 GPU,與全球強

2016-05-09 15:44:19

:4577 Gigaflops(每顆 GPU 2288 Gflops)專用存儲器總容量:8 GB(每顆 GPU 4GB)功耗:225W熱設計功耗 被動散熱Nvidia Tesla K20C GPU

2014-08-21 11:18:27

GPU 4GB) 功耗:225W熱設計功耗 被動散熱 15000 一年質保 工業包裝 Nvidia Tesla K10 GPU 的數量和類型:2 Kepler GK104s CUDA核心

2014-08-03 18:09:13

GPU 4GB) 功耗:225W熱設計功耗 被動散熱 15000 一年質保 工業包裝 Nvidia Tesla K10 GPU 的數量和類型:2 Kepler GK104s CUDA核心

2014-08-26 16:36:28

):1.33 Tflops專用存儲器總容量:6GB GDDR5功耗:250W熱設計功耗 被動散熱9000三年質保工業包裝現貨Nvidia TeslaK10GPU 的數量和類型:2 Kepler

2014-09-15 16:15:00

):1.33 Tflops專用存儲器總容量:6GB GDDR5功耗:250W熱設計功耗 被動散熱9000三年質保工業包裝現貨Nvidia TeslaK10GPU 的數量和類型:2 Kepler

2014-09-11 12:48:26

Nvidia GRID K2GPU 的數量和類型:2*Kepler CUDA核心數量:3072 專用存儲器總容量:8GB DDR5用于虛擬化功耗:225W熱設計功耗 被動散熱 21000三年質保工業包裝現貨

2015-02-05 16:14:28

) 專用存儲器總容量:8 GB(每顆 GPU 4GB) 功耗:225W熱設計功耗 被動散熱 " 19000 三年質保 工業包裝 訂貨1周 Nvidia TeslaK20C

2014-09-02 21:17:41

GRID K1GPU 的數量和類型:4*Kepler CUDA核心數量:768 專用存儲器總容量:16GB DDR3用于虛擬化功耗:139W熱設計功耗 被動散熱15000三年質保工業包裝現貨Nvidia

2015-01-19 16:53:59

GRID K1GPU 的數量和類型:4*Kepler CUDA核心數量:768 專用存儲器總容量:16GB DDR3用于虛擬化功耗:139W熱設計功耗 被動散熱15000三年質保工業包裝現貨Nvidia

2015-01-19 16:54:53

GRID K1GPU 的數量和類型:4*Kepler CUDA核心數量:768 專用存儲器總容量:16GB DDR3用于虛擬化功耗:139W熱設計功耗 被動散熱15000三年質保工業包裝現貨Nvidia

2015-01-19 16:59:48

allocated by a VM or is this dynamic? p40 has 24GB gpu ramso let's take following profile

2018-09-25 17:27:50

我們已經將esxi主機升級到6.5并將VIB升級到從Nvidia網站下載的受支持的NVIDIA-kepler-vSphere-6.5-367.64-369.71,但基本機器將無法啟動GPU(PCI

2018-09-20 11:41:24

nvidia-smi可執行文件位于虛擬機管理程序上。如果在同一部署中您選擇在GPU上使用作為傳遞,那么GPU正在尋找訪客上的NVIDIA驅動程序,因此nvidia-smi位于訪客上。以上來自于谷歌翻譯以下為原文

2018-09-04 15:18:02

這邊是NVIDIA HR Allen, 我們目前在上海招聘GPU高性能計算架構師(功能驗證)的崗位,有意向的朋友歡迎發送簡歷到 allelin@nvidia

2017-09-01 17:22:28

they blamed it on the nvidia gpu but they dont know if its a driver or hardware issue.Can a ticket be open

2018-10-10 16:15:55

問題最近在Ubuntu上使用Nvidia GPU訓練模型的時候,如果機器鎖屏一段時間再打開的時候鼠標非常卡頓,或者說顯示界面非常卡頓,使用nvidia-smi查看發現,訓練模型的GPU沒有問題,但是

2021-12-30 06:44:30

云計算服務異構加速平臺,為人工智能產業提供多場景化的全球加速能力。2017年11月,阿里云發布了國內首個支持 NVIDIA ?Tesla ?V100 GPU 的實例GN6,可帶來數倍的深度學習性能提升

2018-04-04 14:39:24

嗨團隊,我剛剛購買了GRID K2,當我將它插入我的服務器時。我發現每個物理GPU的內存容量只有3,5GB,我無法啟動這張卡上的VM。我在同一臺服務器上有另一張K2卡,完全沒有任何問題。我還附上

2018-09-06 10:09:16

|| ------------------------------- + ----------------- ----- + ---------------------- +| GPU名稱持久性-M | Bus-Id Disp.A |揮發性的Uncorr。 ECC || Fan Temp Perf Pwr:用法/上限|內存使用| GPU-Util Compute

2018-10-08 14:23:23

我有一臺帶有ESXi 6.0 Build 4192238的服務器,帶有一個帶驅動程序367.64的M10。當我運行nvidia-smi時,它只顯示2個GPU,只允許我運行一半的預期用戶。有任何想法

2018-09-11 16:29:01

|| ------------------------------- + ----------------- ----- + ---------------------- +| GPU名稱持久性-M | Bus-Id Disp.A |揮發性的Uncorr。 ECC

2018-09-05 09:59:19

會講到Intel GVT-g 方案的致命傷和痛點。而AMD繼續研發全球首款SRIOV GPU。當其他人都在玩技術的時候,Nvidia已經開始了產業布局。同年發布了AWS上和VMware合作

2018-04-16 10:51:32

Netapp存儲。我們希望在其上運行視頻流SW WOWZA構建新的2個VM,這將使用NVIDIA M6的GPU功能(具有NVENC視頻編解碼器支持)。我們知道必須使用HP WS460s刀片,因為從技術上講

2018-09-30 10:43:20

問題最近在Ubuntu上使用Nvidia GPU訓練模型的時候,沒有問題,過一會再訓練出現非常卡頓,使用nvidia-smi查看發現,顯示GPU的風扇和電源報錯:解決方案自動風扇控制在nvidia

2022-01-03 08:24:09

我在xenserver 6.2 SP1上的傳遞模式中有K2,我正在嘗試確定我的應用程序如何強調GPU。我添加了nvidia WMI包,但是對于我關心的所有GPU值,例如內存和%GPU,windows

2018-10-10 16:17:40

High-Performance Remote Graphics with NVIDIA GRID Virtual GPU” which includes a section on Tuning vGPU

2018-09-29 14:18:41

我在三臺Cisco UCS主機上安裝了3個Tesla M10 GPU。它們被用于Horizo??n 7中的一個池中,覆蓋80多個獨立的VM。我的任務是看看GPU的使用量。當我運行nvidia

2018-09-30 10:43:36

1、探求 NVIDIA GPU 極限性能的利器 在通常的 CUDA 編程中,用戶主要通過 CUDA C/C++ 或 python 語言實現 CUDA 功能的調用。在 NVIDIA 對 CUDA C

2022-10-11 14:35:28

變種的GPU直通?以上來自于谷歌翻譯以下為原文Hello,We've got 4x Tesla V100-SXM2-32GB in a Supermicro Chassis (https

2018-09-12 16:25:32

來自于谷歌翻譯以下為原文I have a customer that is wanting to test a newer NVIDIA GPU with the GRID software

2018-09-20 11:30:38

在 8 月 14 日的 SIGGRAPH 2018 大會上,英偉達 CEO 黃仁勛正式發布了新一代 GPU 架構 Turing(圖靈),以及一系列基于圖靈架構的 GPU,包括全球首批支持即時光線追蹤

2018-08-15 10:59:45

當前環境;戴爾R730,E5-2695 v3 2.3ghz 14核x 2,768GB內存,2 x 10GB NICSXenServer 7.0,Windows 2012 R2和XenApp

2018-09-12 16:27:29

的發展前景,AMD-ATI、NVIDIA現在的產品都支持OPEN CL.NVIDIA公司在1999年發布GeForce 256圖形處理芯片時首先提出GPU的概念。從此NV顯卡的芯就用這個新名字GPU來稱呼

2015-11-04 10:04:53

。Nvidia的NV 24核,224 GB RAM,1.4 GB臨時存儲。這是相當昂貴的(每月費用超過3,400美元),除非我承諾1年或3年的承諾,略有減少。我認為如果我購買GPU服務器,從長遠來看可能會更便

2018-09-26 15:30:46

-vgx-xenserver-6.2-331.59.01.i386.rpm,NVIDIA-vgx-xenserver-6.2-331.59.i386.rpm我向所有建議開放。謝謝,ELOM以上來自于谷歌翻譯以下為原文Hi All,I am deploying a VDI to be used

2018-09-25 18:10:54

深圳市港禾科技有限公司所上傳的產品圖片均為實物拍攝。A100 40GB 80GB 由于電子元器件價格因市場浮動,網站展示價格僅為參考價,不能作為最后成交價格,具體價格請與業務

2022-11-26 17:03:09

NVIDIA創始人黃仁勛表示TITAN V GPU擁有210億個晶體管,基于Volta 架構設計,110 TFLOP 的深度學習運算能力是上一代的9 倍,可以說是全球最強的PC級GPU。

2017-12-15 13:38:38 1751

1751 英偉達(NVIDIA)又在“GPU歷史長廊”上留下濃重的一筆——全球首款支持實時光線追蹤(ray tracing)的GPU“Quadro RTX”問世,更搭載著以計算機之父艾倫·圖靈為命名的“圖靈(Turing)”架構。

2018-08-16 10:45:24 3163

3163 達新一代GPU架構安培,并帶來了基于安培架構GPU A100的DGX-A100 AI系統和面向邊緣AI計算的EGX A100。

2020-05-15 14:48:00 7763

7763 在近日的GTC上,Nvidia發布了最新的安培架構,以及基于安培架構的A100 GPU。A100 GPU使用臺積電7nm工藝實現,包含了542億個晶體管,據官方消息可以實現比起上一代V100高7倍的性能。

2020-05-20 10:17:50 2317

2317 同時,也發布了全球最先進的AI系統—— NVIDIA DGX A100系統,單節點AI算力達到創紀錄的5 PFLOPS,5個DGX A100系統組成的一個機架,算力可媲美一個AI數據中心。以及發布

2020-06-02 17:11:45 3709

3709 在5月14日的GTC演講中,NVIDIA CEO黃仁勛正式宣布了新一代GPU——Ampere安培,它使用了7nm工藝,號稱性能是上代Voltra的20倍。日前NVIDIA CFO Colette Kress表示這是他們三年來的杰作,是NVDIA有史以來最強大的GPU。

2020-06-05 11:42:19 3058

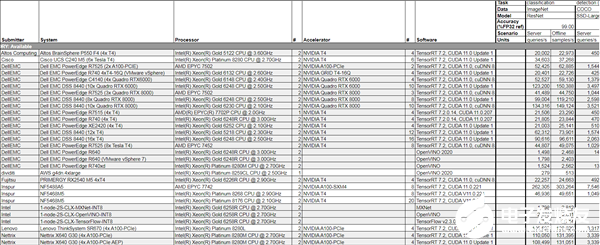

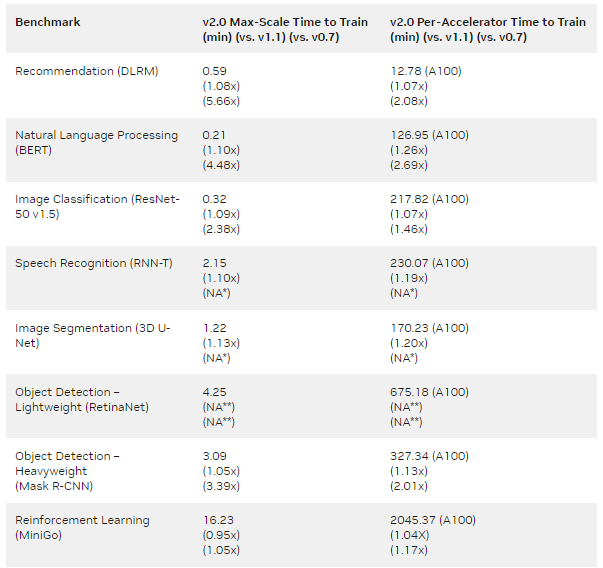

3058 NVIDIA和多家全球領先的服務器制造商于今日發布多款內置NVIDIA A100的系統。這些系統具有多種不同的設計和配置,可應對AI、數據科學和科學計算領域最復雜的挑戰。

2020-06-24 16:04:33 2585

2585 NVIDIA發布重磅最新軟件應用、硬件系統以及與寶馬集團合作 NVIDIA提出了下一代計算的愿景,該愿景將全球信息經濟的重心從服務器轉移到了新型的強大且靈活的數據中心。 NVIDIA創始人

2020-10-08 00:56:00 4871

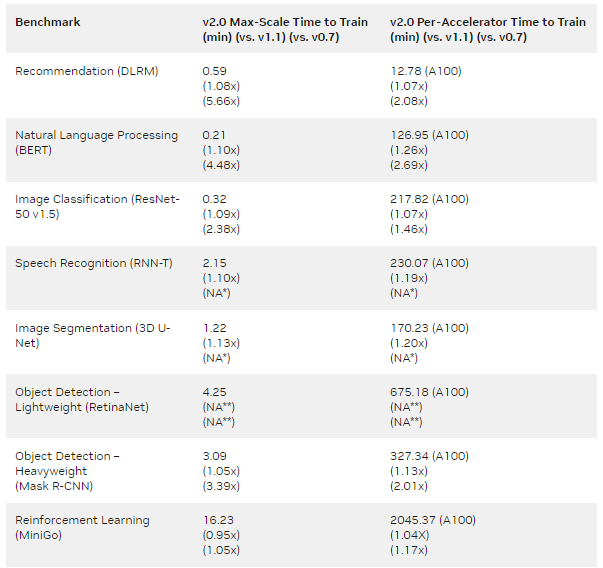

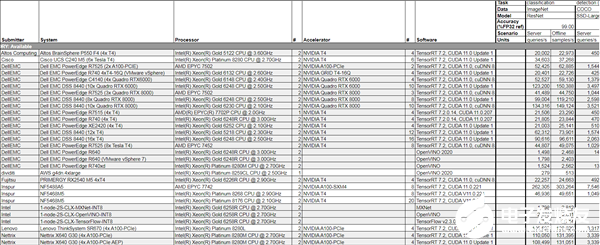

4871 )的12個提交者增加了近一倍。 結果顯示,今年5月NVIDIA(Nvidia)發布的安培(Ampere)架構A100 Tensor Core GPU,在云端推理的基準測試性能是最先進Intel CPU

2020-10-23 17:40:02 3929

3929

采用最新 NVIDIA A100 Tensor Core GPU,開啟了加速計算的下一個十年。 全新的 P4d 實例,為機器學習訓練和高性能計算應用提供 AWS 上性能與成本效益最高的 GPU 平臺。與

2021-02-24 12:08:02 1606

1606 根據英偉達官方的消息,在 AWS 運行 NVIDIA GPU 十周年之際,AWS 發布了采用全新 A100 的 Amazon EC2 P4d 實例。 IT之家了解到,現在已全面上市的全新 AWS

2020-11-04 15:34:55 2907

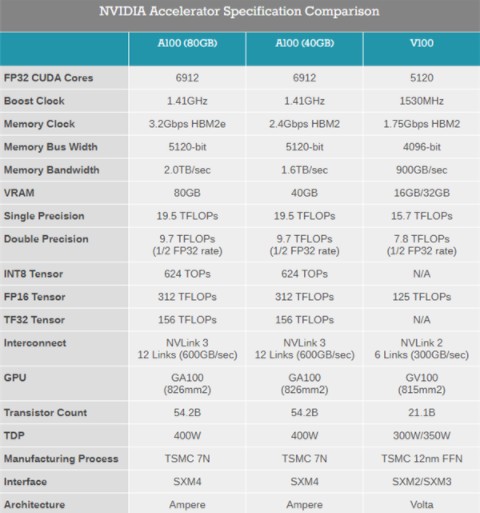

2907 11月16日消息,在SC20(Supercomputing Conference)超級計算大會上,NVIDIA在加速計算領域、HPC、網絡三大領域分別發布了新一代A100 80GB GPU處理器

2020-11-17 09:58:56 1661

1661 NVIDIA于今日發布NVIDIA A100 80GB GPU,這一創新將支持NVIDIA HGX AI超級計算平臺。該GPU內存比上一代提升一倍,能夠為研究人員和工程師們提供空前的速度和性能,助力實現新一輪AI和科學技術突破。

2020-11-17 09:59:52 2211

2211 昨晚AMD剛剛發布了7nm CDNA架構的MI100加速卡,NVIDIA這邊就推出了A100 80GB加速卡。雖然AMD把性能奪回去了,但是A100 80GB的HBM2e顯存也是史無前例

2020-11-17 10:15:41 2041

2041 今晚AMD剛剛發布了7nm CDNA架構的MI100加速卡,NVIDIA這邊就推出了A100 80GB加速卡。雖然AMD把性能奪回去了,但是A100 80GB的HBM2e顯存也是史無前例了。

2020-11-17 10:23:53 2169

2169

在發布A100 80GB加速卡之后,NVIDIA也更新了自家的DGX A100產品線,最多可達640GB HBM2e顯存了。此外,還有全新的DGX Station A100工作站,配備了4個A100 80GB顯存,還上了壓縮機制冷。

2020-11-17 10:26:19 3900

3900 AMD發布了7nm CDNA架構的MI100加速卡,NVIDIA這邊就推出了A100 80GB加速卡。雖然AMD把性能奪回去了,但是A100 80GB的HBM2e顯存也是史無前例了。NVIDIA今年

2020-11-17 15:38:58 1741

1741 英偉達現已發布 A100 80GB GPU,適用于 NVIDIA HGX AI 超級計算平臺,相比上一款產品顯存翻倍。 英偉達表示,A100 80GB 的顯存是其前身的兩倍,為研究人員和工程師提供

2020-11-17 16:04:05 2104

2104 北京2020年11月17日 /美通社/ -- 美國當地時間11月16日,SC20大會期間,浪潮宣布支持NVIDIA最新的A100 80G GPU的AI服務器NF5488M5-D和NF5488A5全球

2020-11-18 15:27:58 2669

2669 美國當地時間11月16日,SC20大會期間,浪潮宣布支持NVIDIA最新的A100 80G GPU的AI服務器NF5488M5-D和NF5488A5全球量產供貨。 浪潮NF5488A5

2020-11-18 17:50:20 2265

2265 A100 GPU也嚴重供應不足,無法滿足高性能計算客戶的需求,而且預計要幾個月才能達到供需平衡。 事實上,眼下無論是NVIDIA還是AMD,都將產能優先分配給高價格、高利潤的數據中心計算GPU,但即便如此都要缺貨這么久,消費級游戲卡更是可想而知…… NVIDIA A100加速卡是今年

2020-12-09 10:00:58 1976

1976 NVIDIA今天在GTC大會上宣布,多家中國頂級云服務提供商、系統制造商都部署了NVIDIA A100 Tensor Core GPU、NVIDIA技術,為各種AI應用提速。

2020-12-16 10:21:17 2913

2913 近日 Microsoft Azure 宣布正式推出 ND A100 v4 VM 系列,這是適用于超級計算級 AI 和 HPC 負載的強大虛擬機,由 NVIDIA A100 Tensor Core

2021-06-11 16:53:54 2083

2083 今日凌晨,NVIDIA(英偉達)發布了基于最新Hopper架構的H100系列GPU和Grace CPU超級芯片!

2022-03-26 09:07:05 2380

2380 搭載NVIDIA A100 Tensor Core 80GB GPU,寧暢X640 G40 在Closed(封閉)賽段所有已發布的產品中,獲得10項Datacenter組總體性能第一成績,也是本次測試中的全場第一。

2022-04-07 11:13:19 5948

5948 在NVIDIA A100 Tensor Core GPU和NVIDIA TensorRT強大的AI算力推動下,知識視覺極大的縮短了算法研發時間。

2022-04-21 14:18:24 814

814 基于以上挑戰,百圖生科采用了 NVIDIA DGX A100 80GB,將深度學習訓練、推理和分析整合至一個易于部署的統一 AI 基礎架構中,擁有一個更簡單快捷的解決人工智能的方法。

2022-05-20 15:07:09 969

969 5月24日,在全球科技盛會“Computex 2022”期間,NVIDIA正式推出A100 80GB PCIe液冷式GPU。作為NVIDIA的重要合作伙伴,紫光股份旗下新華三集團H3C

2022-05-25 10:34:58 1344

1344 今年的 GTC22 上 NVIDIA 發布其首款基于 Hopper 架構的 GPU —NVIDIA H100。

2022-07-18 10:35:23 1300

1300 NVIDIA MLPerf v2.0 提交基于經驗證的 A100 Tensor Core GPU 、 NVIDIA DGX A100 系統 以及 NVIDIA DGX SuperPOD 參考架構。許多合作伙伴還使用 A100 Tensor Core GPU 提交了結果。

2022-08-15 16:43:18 1056

1056

在行業標準 AI 推理測試中,NVIDIA H100 GPU 創造多項世界紀錄、A100 GPU 在主流性能方面展現領先優勢、Jetson AGX Orin 在邊緣計算方面處于領先地位。

2022-09-13 15:29:19 2354

2354 多實例 GPU ( MIG )是 NVIDIA H100 , A100 和 A30 張量核 GPU ,因為它可以將 GPU 劃分為多個實例。每個實例都有自己的計算核心、高帶寬內存、二級緩存、 DRAM 帶寬和解碼器等媒體引擎。

2022-10-11 10:07:37 2486

2486

,不能通過編程超過限制的性能。 今年8月的最后一天,英偉達發布公告稱,公司收到美國政府通知,要求對中國大陸以及中國香港、俄羅斯的客戶出口的高端GPU芯片,需要申請出口許可證,其中覆蓋到A100和H100等幾款GPU,同時未來性能等于或高于A100的產品都會受

2022-11-09 07:15:01 7434

7434 從OpenAI發布GPT-4,到百度發布文心一言;AI開始了爆走模式,現在我們來看看 NVIDIA GTC 2023 。 手握GPU算力的NVIDIA是AI的必需品。 圖源? NVIDIA官網直播

2023-03-22 15:23:28 2900

2900

架構。 英偉達A100是一款基于最新的NVIDIA Ampere架構設計的數據中心GPU,擁有更多的CUDA核心、更高的時鐘頻率和更大的存儲

2023-08-07 17:32:59 10422

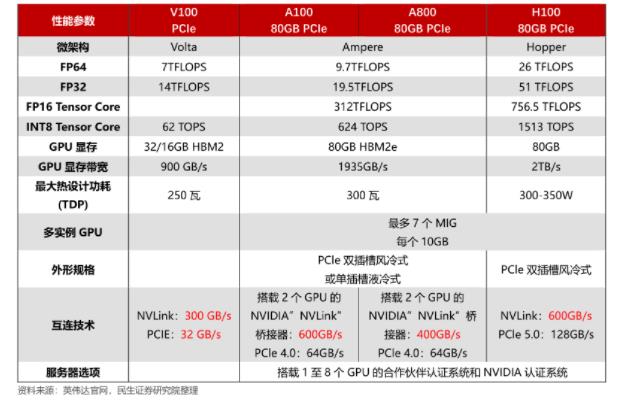

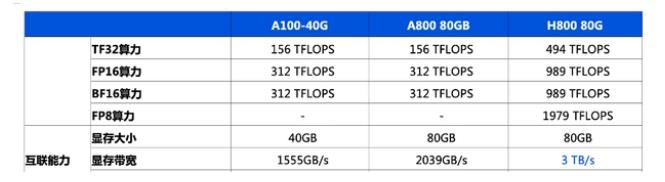

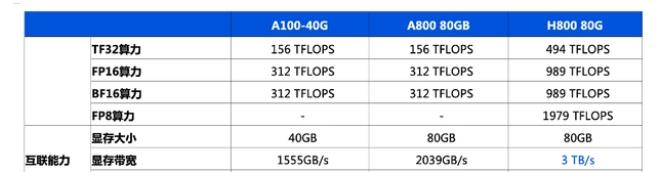

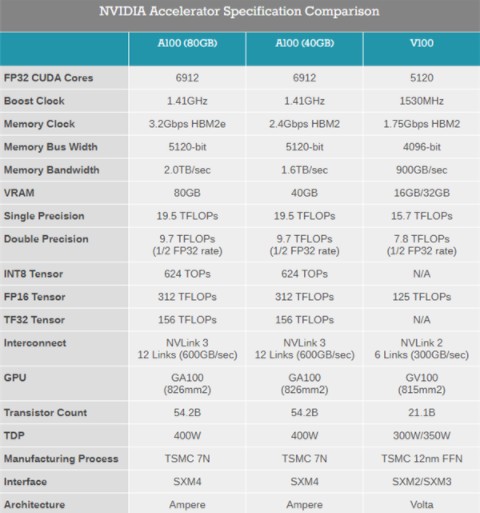

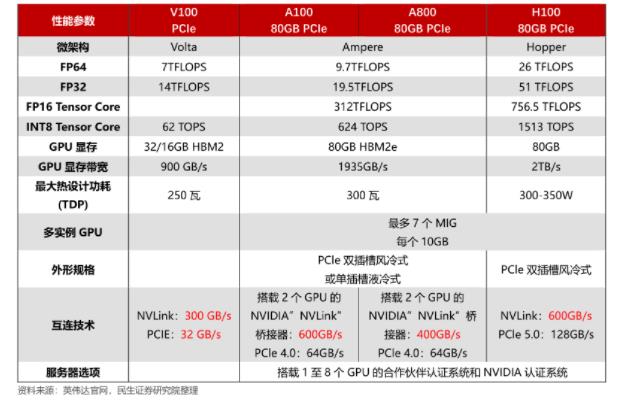

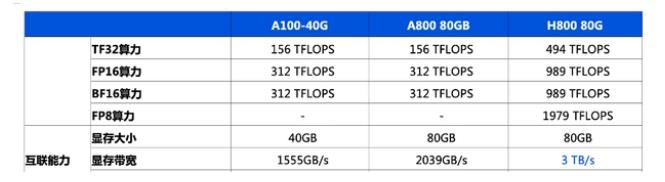

10422 的浮點性能為19.5 TFLOPS,而A800為10.6 TFLOPS。 3. 存儲容量不同:A100的顯存最大為80 GB,而A800為48 GB。 4. AI加速器不同:A100配備Tensor

2023-08-07 17:57:02 29592

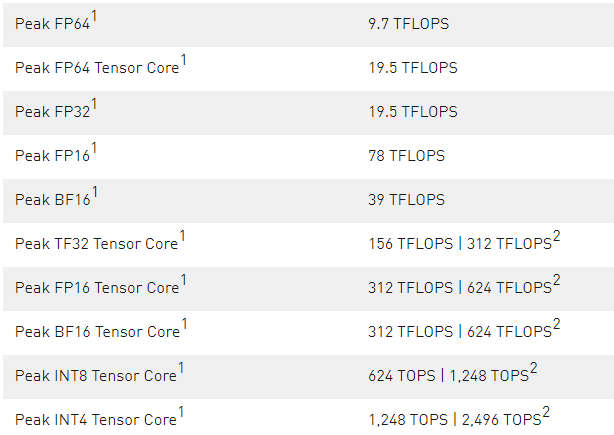

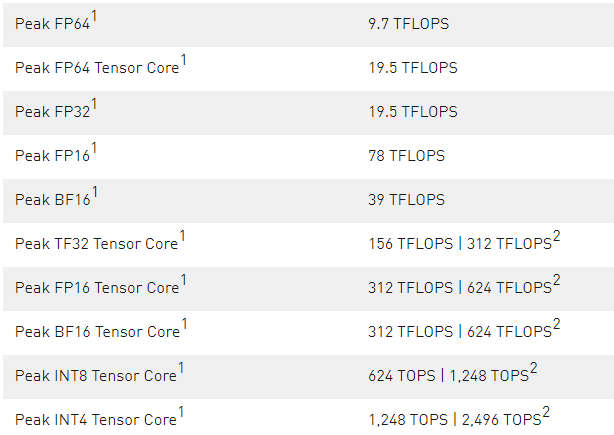

29592 核心,可以實現高達19.5 TFLOPS的FP32浮點性能和156 TFLOPS的深度學習性能。此外,它還支持NVIDIA GPU Boost技術和32GB HBM2顯存,能夠提供卓越的計算性能和內存

2023-08-08 11:54:02 8181

8181

為7.8FP32/3.9FP64 exaFLOPS。 4. 存儲:英偉達4090有1TB的高速HBM2存儲,英偉達A100則有40GB -80GB HBM2存儲,但A100也可以配置為另一種版本,即帶有320GB GDDR6存儲的A100 PC

2023-08-08 11:59:22 22962

22962 英偉達A100和A40的對比 A100是英偉達推出的一款強大的數據中心GPU,采用全新的Ampere架構。它擁有高達6,912個CUDA核心和40GB的高速HBM2顯存。可以實現高達19.5

2023-08-08 15:08:34 11432

11432 英偉達A100是什么系列? 全球都在關注生成式人工智能;特別是OpenAI發布ChatGPT以來,生成式人工智能技術一下就被拔高。在大模型訓練中,A100是非常強大的GPU。英偉達的AI芯片這個時候

2023-08-08 15:13:48 2011

2011 英偉達A100的簡介 A100都是非常強大的GPU。英偉達A100、A800、H100、V100也在大模型訓練中廣受歡迎。特別是OpenAI發布ChatGPT以來,全球都在關注生成式人工智能。 英偉

2023-08-08 15:17:16 7312

7312 英偉達A100的優勢分析 在大模型訓練中,A100是非常強大的GPU。A100是英偉達推出的一款強大的數據中心GPU,采用全新的Ampere架構。擁有高達6,912個CUDA核心和40GB的高速

2023-08-08 15:25:22 2544

2544 英偉達h800和a100參數對比 NVIDIA H800和A100是兩款高端的GPU產品,下面是它們的參數對比: 1.架構: H800采用的是Volta架構,而A100則是NVIDIA

2023-08-08 15:53:57 23334

23334

英偉達h800和a100的區別 NVIDIA H800和A100是NVIDIA的兩種不同類型的GPU,具有不同的架構和特點。以下是它們之間的區別: 1. 架構:H800使用NVIDIA Volta

2023-08-08 16:05:01 12848

12848

雖然目前尚未確定gpu的準確配置,但nvidia h100 80gb hbm2e運算卡gpu (14592 cuda core, 26 fp64 tflops, 1513 fp16 tflops

2023-08-17 10:22:48 241

241 目前,用于高端推理的 GPU 主要有三種:NVIDIA A100、NVIDIA H100 和新的 NVIDIA L40S。我們將跳過NVIDIA L4 24GB,因為它更像是低端推理卡。

2023-11-13 16:13:31 573

573

NVIDIA NVLink采用全網狀拓撲,如下所示,(雙向)GPU-to-GPU 最大帶寬可達到400GB/s (需要注意的是,下方展示的是8*A100模塊時的600GB/s速率,8*A800也是類似的全網狀拓撲);

2023-12-27 16:49:32 776

776

NVIDIA AI GPU無疑是當下的硬通貨,從科技巨頭到小型企業都在搶。

2024-01-29 09:58:32 489

489

,不能通過編程超過限制的性能。 ? 今年8月的最后一天,英偉達發布公告稱,公司收到美國政府通知,要求對中國大陸以及中國香港、俄羅斯的客戶出口的高端GPU芯片,需要申請出口許可證,其中覆蓋到A100和H100等幾款GPU,同時未來性能等于或高于A100的產品都會

2022-11-09 09:23:59 6692

6692

電子發燒友App

電子發燒友App

評論