看點:AI被騙?解密神奇貼紙背后的算法,如何讓人類躲過智能監控。

智東西4月24日消息,攝像頭用AI識別圖像和視頻中的人臉和身體正變得越來越常見,小到超市、辦公室,大到自動駕駛、智慧城市,能夠快速抓取人體、識別人臉的智能攝像頭正變得無處不在。

不過,最近,一組研究團隊設計了一張特別的彩色圖案,只要你將這塊40cmx40cm的神奇貼紙掛在身上,就可以避開AI攝像頭的監控。

這個團隊來自比利時魯汶大學(Katholieke Universiteit Leuven),他們發表了一篇論文,名為《欺騙自動監控攝像頭:針對攻擊人類監控的對抗補丁(Fooling automated surveillance cameras: adversarial patches to attack person detection)》。

論文上署名的三位研究人員Simen Thys、Wiebe Van Ranst和Toon Goedeme使用了流行的YOLOv2開源對象識別探測器進行了演示,他們通過用一些技巧成功騙過了探測器。

論文鏈接:https://arxiv.org/pdf/1904.08653.pdf

他們已經在論文中公布了源代碼:

https://gitlab.com/EAVISE/adversarial-yolo。

宛如“隱形斗篷”的神器貼紙

我們先來看看這個研究小組究竟做了個什么東西。

如圖,右邊的人身上掛了一塊彩色貼紙,這張貼紙成功欺騙了AI系統,使他即便正面攝像頭,也沒有像左邊的人那樣被AI系統檢測出來(粉色框)。

右邊的人將貼紙反轉過來,立即被檢測出。

等右邊的人將貼紙交給左邊的人后,AI瞬間就檢測不出左邊的人。

研究人員指出,該技術可用于“惡意繞過監視系統”,允許入侵者“通過在他們的身體前面拿著一塊小紙板朝向監控攝像頭做些偷偷摸摸的行為(而不被發現)”。

據外媒報道,論文作者之一Van Ranst透露,采用現成的視頻監控系統來解決這個問題應該不會太難。“目前我們還需要知道哪個探測器正在使用中。我們今后想要做的是生成一個同時適用于多個探測器的補丁”,“如果這樣有效,那么補丁也可能對監控系統中使用的探測器起作用。”

▲貼片的角度和位置對AI檢測人的能力有所不同

該小組現在正計劃將補丁應用于服裝。

好比著名的威廉·吉布森(William Gibson)科幻小說《零歷史(Zero History)》所描述的情節,研究人員寫道:“我們相信,如果我們將這種技術與精致的服裝模擬結合起來,我們就可以設計出一種T恤印花,可以讓一個人對自動監控相機幾乎不可見。”

未來他們的工作將側重于使補丁更加健壯和可遷移,因為它們不能很好地適用于不同的檢測架構,如Faster R-CNN 。

“對抗補丁”是怎樣煉成的?

這項研究的核心目的是創造一個系統,能夠生成可打印的對抗補丁,用于“愚弄”人類探測器。

研究人員寫道:“我們通過優化圖像來實現這一目標,以最大限度地減少與探測器輸出中人物外觀相關的不同概率。在我們的實驗中,我們比較了不同的方法,發現最小化對象丟失創造了最有效的補丁。”

然后他們打印出經過優化的補丁,并通過拍攝持有他們的人來測試它們。

研究人員發現,只要定位正確,補丁就能很好地工作。

“根據我們的結果,我們可以看到我們的系統能夠顯著降低人體探測器的準確性……在大多數情況下,我們的補丁能夠成功地將人員隱藏在探測器之外。在不是這種情況下,補丁與人的中心不對齊。”研究人員說。

優化器的目標就是最小化總損失函數L。具體優化目標包括三個損失函數:Lnps(非可打印性得分)、Ltv(圖像總變化)、Lobj(圖像中的最大對象分數)。

Lnps代表貼紙中的顏色在多大程度上可由普通打印機打印出來;

Ltv確保優化器支持平滑顏色過渡的圖像并防止圖像噪聲;

Lobj用于對探測器輸出的目標或類別分數實現最小化。

上述三個損失函數相加即可得到總損失函數:

YOLOv2探測器輸出一個單元網格,每個單元格包含一系列錨點,每個錨點包含邊界框的位置、對象概率和類別得分。

為了讓探測器忽略圖像中的人,研究人員使用MS COCO數據集進行訓練,嘗試了三種不同的方法:最小化類人的分類得分(圖4d),最小化對象得分(圖4c),或兩者的組合(圖4b和4a)。

其中,第一種方法可能致使生成的補丁被檢測成COCO數據集的另一個類,第二種方法不存在這一問題,但生成貼紙針對某個類的特定性比其他方法低。

通過對各類“補丁”做實驗,最后研究人員發現,經過多次圖像處理的隨機物體的照片效果最好,他們嘗試了多種隨機轉換,包括圖像旋轉、隨機放大和縮小、隨機添加隨機噪聲、隨機修改正確率和對比度等處理。

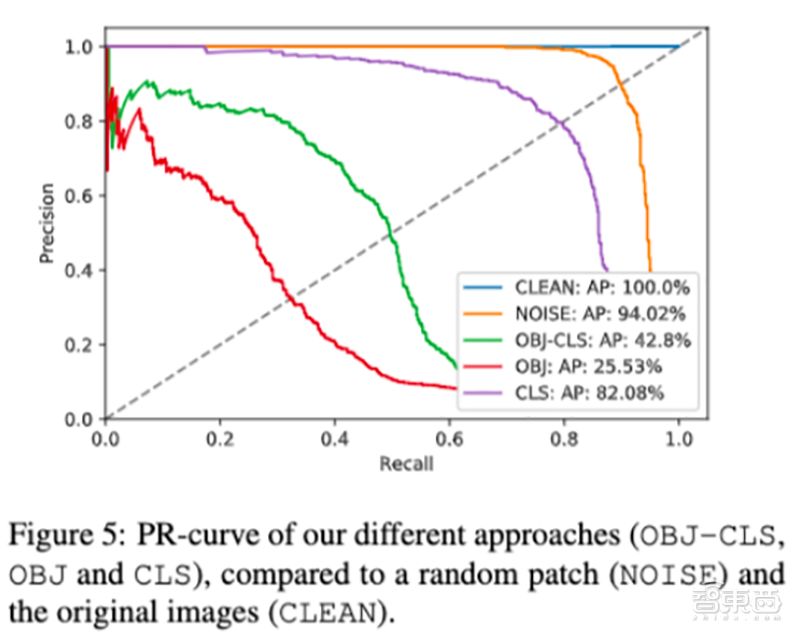

最終,研究人員將獲得的幾個補丁和NOISE(隨機添加噪聲)、CLEAN(無補丁baseline)一起放在Inria測試集上做評估,重點評估這些補丁能避開多少監控系統產生的警報。

結果表明,OBJ補丁觸發的警報數量最低(25.53%)。

不同補丁的測試效果對比如下:

第1行沒有補丁,第2行使用隨機補丁,第3行使用最佳補丁,效果很明顯,最佳補丁在多數情況下能成功讓人類躲過AI的檢測。

不過,這個補丁并不是完美的,效果不好時可能是因為它沒和人對齊。

對抗攻擊并非新鮮事

隨著AI的快速發展,視頻監控、自動駕駛、無人機和機器人、語音識別、文本篩查等多個AI細分領域都涉及到了越來越多的安全問題。

精確度日益增長的深度學習網絡,被發現極容易受到對抗攻擊的影響。

比如向原圖像添加一點精心設計的干擾,就有可能會使得一個分類模型做出錯誤的判斷,致使它將被修改后的圖像標注為完全不同的其他物體。

基于這一背景,越來越多的研究人員正在對真實世界的對抗攻擊感興趣。

2016年11月,來自卡內基梅隆大學和北卡羅來納大學的研究人員展示了如何使用一對打印的眼鏡架來擊敗面部識別系統。

研究人員稱:“當它的圖像提供給一個國家的最先進的面部識別算法的攻擊者戴,眼鏡讓她逃避被認可或假冒他人”。

據稱,戴上鏡框后識別錯誤率高達100%,壞人可以利用這種識別漏洞躲過軟件的檢測,進而輕易偽裝成他人,成功用面部識別完成設備解鎖。

▲上面為真人,下面為系統識別出的人

2017年10月,日本九州大學的Su Jiawei等人提出了黑箱DNN攻擊,通過使用差分進化(differential evolution)擾亂少數像素(1024個像素中只擾亂1、3、5個像素)的方式,只需修改圖片中的幾個像素,即可讓深度神經網絡完全判斷錯誤。

2018年,伯克利人工智能研究實驗室(BAIR))演示了針對 YOLO 檢測器的實體對抗樣本,同樣采用貼紙擾動的形式,在“STOP”路標上粘貼了一些精心設計過的貼紙。

結果YOLO 網絡在幾乎所有幀中都無法感知識別出「停止」標志。同樣,其為 YOLO 檢測器生成的實體對抗樣本也可以騙過標準的 Faster-RCNN。

我們可以想象一下,假使一輛在道路上行駛的自動駕駛汽車,看見被貼了這樣貼紙的路標,一旦它被貼紙誤導,沒看懂路標,就有可能發生難以挽回的交通慘案。

結語:最優防御策略還在探索中

長期以來,對抗攻擊一直是機器學習領域有趣又非常重要的課題。

如今AI逐漸大面積應用于日常監控攝像頭和軟件中,出現在零售、工作空間、社區、交通等諸多場景。

而對抗樣本有可能會鉆神經網絡的漏洞,比如使得一些小偷可以避開監控攝像頭在無人商店自由偷東西,或者使得入侵者成功進入某棟建筑。

當前,研究人員們還遠未找到針對這些對抗樣本的最優防御策略,我們不妨期待對這一激動人心的研究領域會在不久之后出現突破性的進展。

本賬號系網易新聞·網易號“各有態度”簽約帳號

-

攝像頭

+關注

關注

60文章

4880瀏覽量

96729 -

AI

+關注

關注

87文章

32376瀏覽量

271531 -

智能監控

+關注

關注

5文章

250瀏覽量

31950

原文標題:神奇貼紙騙過AI!人類被“隱形”,智能監控的危機來了?

文章出處:【微信號:CAAI-1981,微信公眾號:中國人工智能學會】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

了解AI人工智能背后的科學?

騰訊叮當聯手Alavening發布智能鬧鐘“阿拉的神奇小鬧鬧”

AI芯片談算法不談智能,談實現不談芯片!

『深思考』打造人工智能機器大腦,讓AI更懂你!

機器能超越真正的人類嗎?人工智能未來發展如何?

【技術雜談】動畫演示各大算法,助力 AI 小白順利入門

人工智能能否取代人類?

【免費直播】AI芯片專家陳小柏博士,帶你解析AI算法及其芯片操作系統。

【免費直播】讓AI芯片擁有最強大腦—AI芯片的操作系統設計介紹.

《移動終端人工智能技術與應用開發》人工智能的發展與AI技術的進步

AI 人工智能的未來在哪?

一南京女子疑遇AI換臉被騙錢

AI 新騙局:某科技公司老板 10 分鐘被騙 430 萬!

中偉視界:解密AI智能攝像機算法,讓傳送帶跑偏檢測更高效!

評論