在格物匯之前的文章中,我們討論了特征抽取的經典算法——主成分分析PCA與線性判別分析LDA的原理與應用場景。PCA是一種無監督的降維方法,尋找的是讓數據方差最大的一種映射;LDA是一種有監督的降維方法,尋找的是讓數據分類效果最好的一種映射。但是它們仍然有應用的局限性,今天我們就一起來了解下。

PCA的局限性

我們先來回顧一下PCA的降維原理:PCA試圖通過旋轉找到新的正交基,滿足這樣的兩條性質:

1、最近重構性:樣本點到新映射的正交基距離足夠接近。

2、最大可分性:樣本點在新正交基上方差最大。

最后我們推導得到:

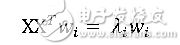

我們只需要對協方差矩陣XX^T 進行特征值分解,得到的特征值和特征向量即是變換矩陣w的解和改主成分所解釋的方差量。這樣的降維方法是線性的降維方法,即從高維空間到低維空間的函數映射是線性的。然而在不少應用場景中,線性映射可能不能得到想要的結果,例如如下的例子:S型曲線的本真二維結構是其低維空間的原本形狀,通過線性降維后得到的結果明顯并不是我們所期望的。

核方法

我們介紹SVM的時候所介紹的核方法是一種可以進行升維來生成一些非線性的映射。這個方法我們可以同樣使用在PCA降維分析中。

假設我們有一個樣本集:

x1,x2?xn

假設映射函數為,那么映射到高維以后,數據變成:

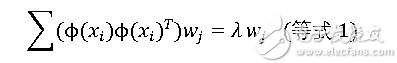

類似于PCA的求解方法, XX^T經過高維映射后得到

,

,

故:

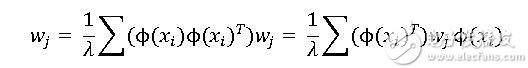

我們把λ 移動到等號左邊得到:

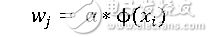

我們令:

做一個簡單的替換,得到:

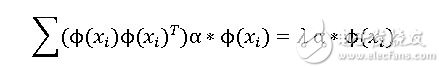

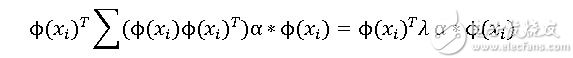

代入等式1,得到:

我們在左右兩邊同時乘上

得到:

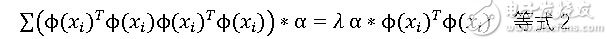

做一下簡單的改變:

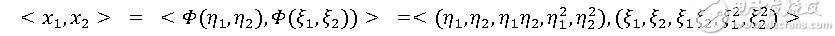

非常幸運的是,我們設計出了

是否還記得我們在SVM的核函數中曾經驗證過,在低維空間計算(

的結果相似,只是系數略有不同。因此我們也可以在此應用核方法來計算。我們在此定義核函數矩陣:

代入上面等式2,便可得到:

即

很明顯,這又回到了特征值分解的問題,取K最大的d個特征值所對應的特征向量即可。

小結

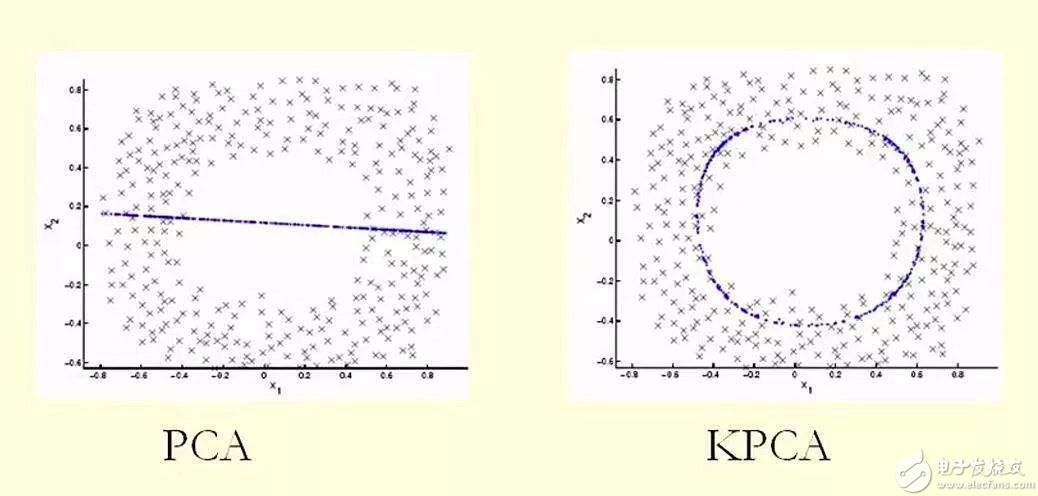

我們通過將數據映射到高維以后,巧妙的構建出了

目的是為了通過在低維空間上應用核函數,計算得到跟高維空間上差不多的效果。PCA所做的是對坐標軸線性變換,即變換后的新基還是一條直線。而KPCA對坐標軸做了非線性變換,數據所映射的新基就不再是一條直線了,而是一條曲線或者曲面,如下圖所示:

通過上面這個圖,大家應該了解了KPCA和PCA的區別了吧?好了,本期格物匯的內容就到這里,我們下期再見。

本文作者:格創東智OT團隊(轉載請注明作者及來源)

-

PCA

+關注

關注

0文章

91瀏覽量

29964 -

KPCA

+關注

關注

0文章

9瀏覽量

9194 -

LDA

+關注

關注

0文章

29瀏覽量

10737 -

智能制造

+關注

關注

48文章

5760瀏覽量

77272 -

工業互聯網

+關注

關注

28文章

4348瀏覽量

94704

發布評論請先 登錄

相關推薦

為什么聊自動駕駛的越來越多,聊無人駕駛的越來越少?

最大才1.45V,現在不清楚為啥那么大的電壓?

碲化鉍和碲鋅鎘別傻傻分不清

模擬信號、數字信號、ADC與DAC傻傻分不清楚?一文了解,收藏再看

PLC多種通訊方式匯總學習~

如果在不清楚適配器的是否支持QC3.0的情況下,嘗試切換至QC3.0協議,該如何判斷是否成功切換至QC3.0協議?

menucofig在win11下指令無法被識別是什么原因?

頻段、信道、帶寬和傳輸速率,還傻傻分不清楚?

LDO和DCDC還傻傻分不清?快來搞懂它

一文介紹:UWB-AOA產品特點及其應用

評論