谷歌在其AI博客上介紹了一款基于AI和深度學習的圖像標注方式“流體標注”,可作為人工標注者的有力輔助工具,將標記數據集的生成速度提升至現在的3倍,有望緩解目前機器學習研究中,高質量的訓練數據獲取難的瓶頸。

基于深度學習的現代計算機視覺模型(比如由TensorFlow對象檢測API實現的模型)的性能取決于是否可以使用規模越來越大的標記訓練數據集(如公開的圖像)進行訓練。

然而,如何獲得高質量的訓練數據,正迅速成為計算機視覺領域的主要瓶頸。這對于自動駕駛、機器人和圖像搜索等應用中使用的語義分段的像素預測任務而言尤其如此。

實際上,傳統的手動數據標記工具,需要標記者仔細點擊圖象邊界,來劃定圖像中的每個對象,這很乏味:在COCO + Stuff數據集中,標記一個圖像需要19分鐘,而標記整個數據集需要53000小時!

COCO數據集中的圖像示例(左)及其逐像素語義標記(右)。圖片來源:Florida Memory

本文中的內容將在2018年ACM多媒體會議“勇敢新理念”環節中展示,谷歌的研究人員研究了一種機器學習驅動的界面,可用于標注分類數據,劃定圖像中每個目標的輪廓和背景,讓標記數據集的生成速度提高至原來的3倍。

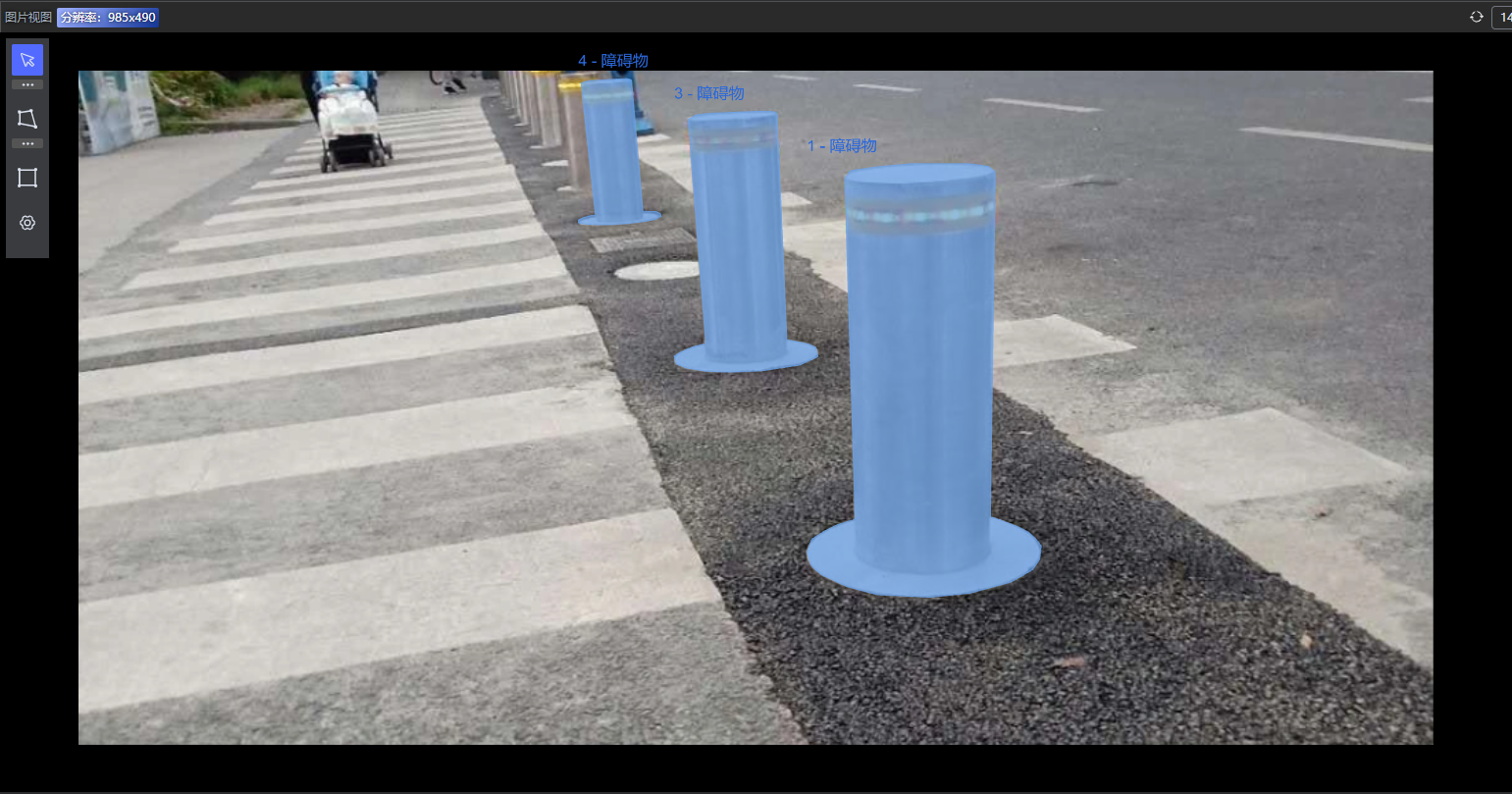

該工具名為流體標注(Fluid Annotation),從強語義分割模型的輸出開始,人工標記者可以使用自然用戶界面,通過機器輔助編輯操作進行修改。谷歌此次開發的界面可以讓標記者選擇要修改的內容和順序,使他們能夠高效地將精力集中在機器尚不了解的內容上。

對COCO數據集中圖像使用流體標注界面的可視化。圖片來源:gamene

更確切地說,為了對圖像進行標記,我們首先通過預訓練的語義分割模型(Mask-RCNN)來處理圖像。這會生成約1000個圖像片段及其分類標簽和置信度分數。置信度分數最高的片段用于對標簽的初始化,呈現給標記者。

然后,標記者就可以:(1)從機器生成的候選標簽中為當前片段選擇標簽。(2)對機器未覆蓋到的對象添加分割段。機器會識別出最可能的預生成段,標記者可以從中選擇質量最高的一個。(3)刪除現有段。(4)改變重疊段的深度順序。(Demo鏈接在此:https://fluidann.appspot.com/,僅限桌面平臺)

使用傳統手動標記(中列)和流體標注(右)在COCO數據集的三張圖像上進行標記的比較。雖然使用手動標記工具時,目標的邊界一般更準確,但標記差異的最大原因是人類標記者通常對某一確切的對象分類有不同意見。來源:sneaka(上),Dan Hurt(中),Melodie Mesiano(下)。

流體標注是讓圖像標注變得更快、更容易的第一步探索。未來的目標是改進對目標邊界的標記,進一步利用機器智能提升界面的速度,最終實現對界面的擴展,能夠處理以前無法識別的分類,實現最高效、需求最大的數據收集。

而實際上,關于這款工具的論文的預印本早在近一個月前就發在了arxiv上。

-

谷歌

+關注

關注

27文章

6173瀏覽量

105639 -

AI

+關注

關注

87文章

31155瀏覽量

269488 -

深度學習

+關注

關注

73文章

5507瀏覽量

121298

原文標題:谷歌推出“流體標注”AI輔助工具,圖像標注速度提升3倍!(附論文)

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AI自動圖像標注工具SpeedDP將是數據標注行業發展的重要引擎

標貝數據標注在智能駕駛訓練中的落地案例

標貝數據標注案例分享:車載語音系統數據標注

SCB后備保護器的選型標注及行業應用解決方案

螞蟻數科發布AI賦能新一代數據標注產品

SpeedDP! 超便利AI自動圖像標注工具 功能豐富、省時省力

標貝數據采集標注在自動駕駛場景中落地應用實例

谷歌推出一款基于AI和深度學習的圖像標注方式“流體標注”

谷歌推出一款基于AI和深度學習的圖像標注方式“流體標注”

評論